前言

自从 DeepSeek 大模型火了以来,网络上出现了许多关于本地部署的教程和方法。然而,要真正深入了解其功能和应用,还是需要自己动手进行一次本地部署。

DeepSeek 作为一个高效的自然语言处理模型,其本地部署能力为大家提供了灵活的应用场景。不管是开发私有化的 AI 应用,还是集成到现有的系统中,DeepSeek 都能提供强大的支持。

本文将详细介绍如何快速部署 DeepSeek 模型,并通过 C# 调用其 API 接口,从而搭建高效的私有 AI 服务。我们将从环境准备、本地部署、API 客户端配置到实际调用接口,完成整个过程。

搭建基础环境

Ollama 是一个轻量级AI模型运行框架,支持 macOS、Linux 和 Windows 跨平台运行,并兼容包括 Llama 3.3、DeepSeek-R1、Phi-4 和 Gemma 2 在内的 54 种主流开源模型。

它简化了模型的下载、安装和使用过程,提供了统一的操作界面,能够方便地在本地环境中运行和测试不同的语言模型,简单的说就是相当于一个容器。

1、安装 Ollama

首先先下载 Ollama,进入官网,根据大家当前的操作系统选择安装包(Windows/Linux/macOS)。

官网下载地址:https://ollama.com/download

如上图所示点击 Download 下载安装包,然后直接安装就可以。

注意:Ollama默认安装是在C盘的以及下载的大模型数据包也是默认在C盘,所以一定要注意自己C盘的存储空间够用,

当然我们也有方式改变他的安装路径的。如果不想折腾的可以直接点击安装就可以了。

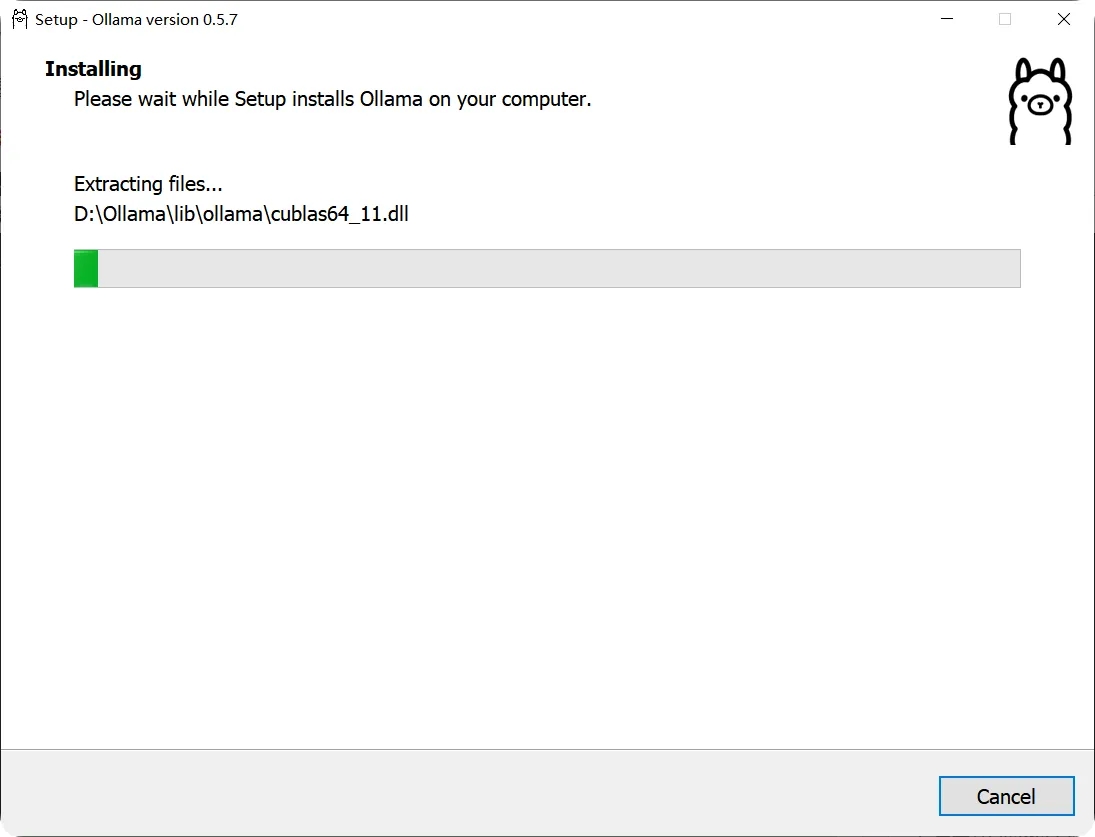

本文示例是修改了安装路径,具体步骤如下:

首先在目标路径(如 D:\Ollaman)创建一个新文件夹并放置 Ollama 安装包

然后在该路径下打开命令窗口并输入 OllamaSetup.exe /DIR=D:\Ollama,接着在安装界面点击 "Install",即可将 Ollama 安装到指定目录,大模型数据包也会默认下载到该目录中。

Ollama 安装好了就会自动启动。

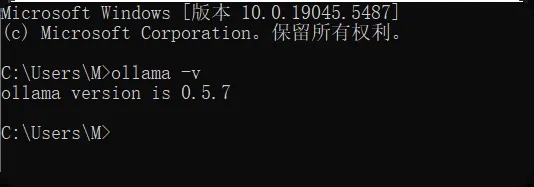

查看是否安装成功 Windows+R,输入CMD进入命令窗口,输入:ollama -v有版本号就说明安装好了,在任务栏右下角有个羊驼的图标。

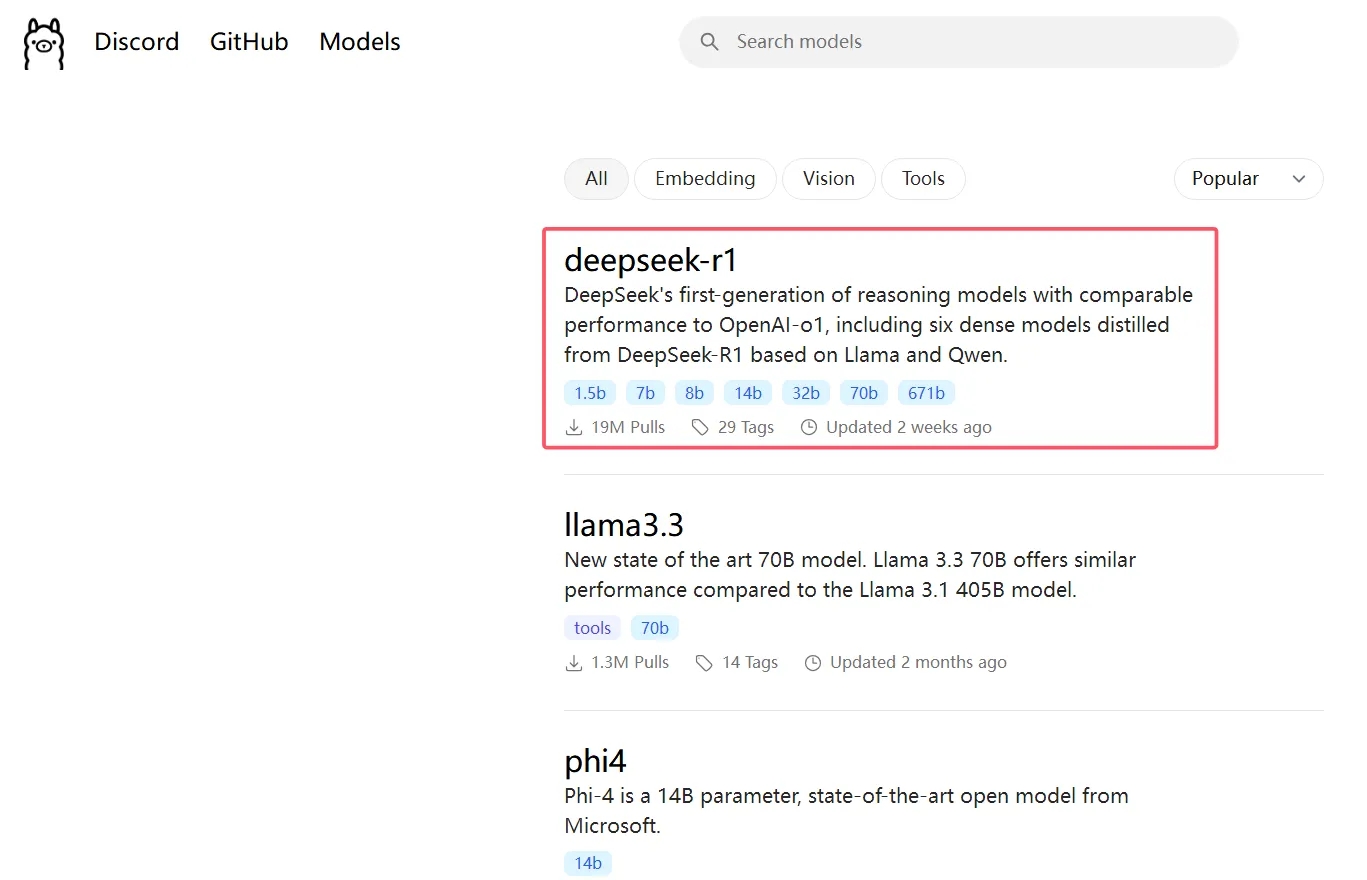

2、下载 DeepSeek R1 模型

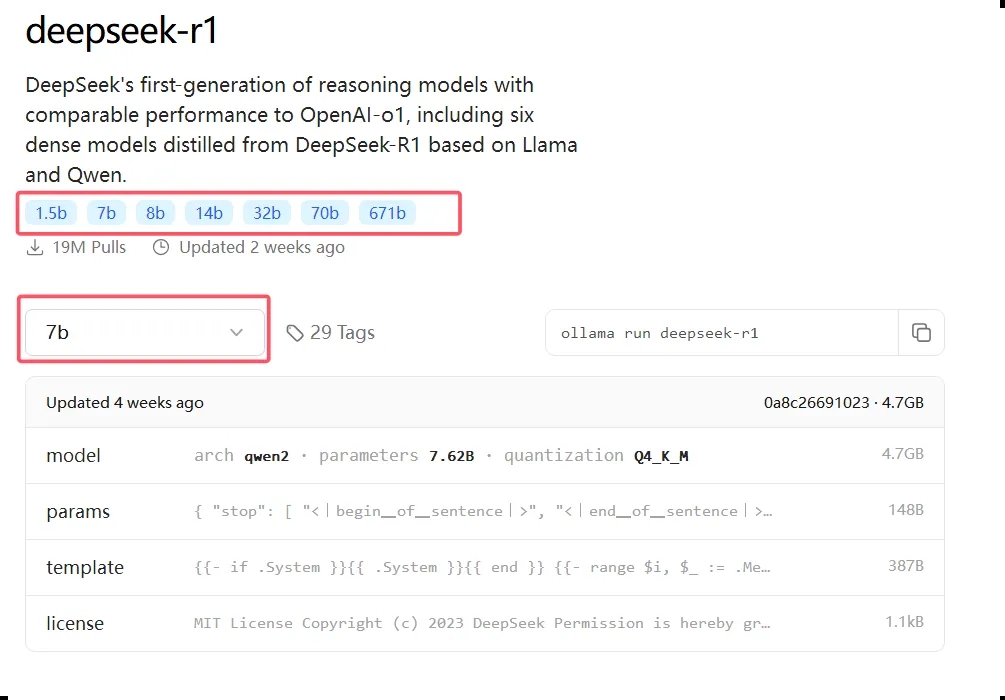

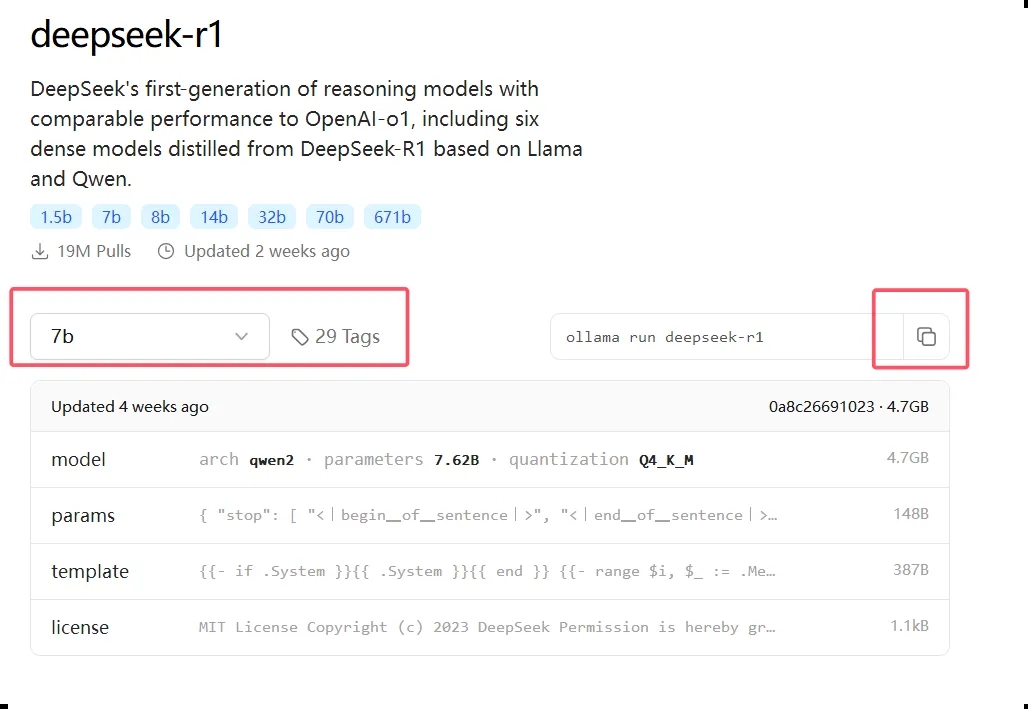

在 Ollama 官网点击 Models,选择deepseek-r1

选择对应的模型,可以看到模型的相信介绍、各种参数的模型。

普通用户:选择 8B 版本,适合日常对话、写作等

高性能显卡用户(显存 16GB 以上):可选 16B 版本,体验更强大性能

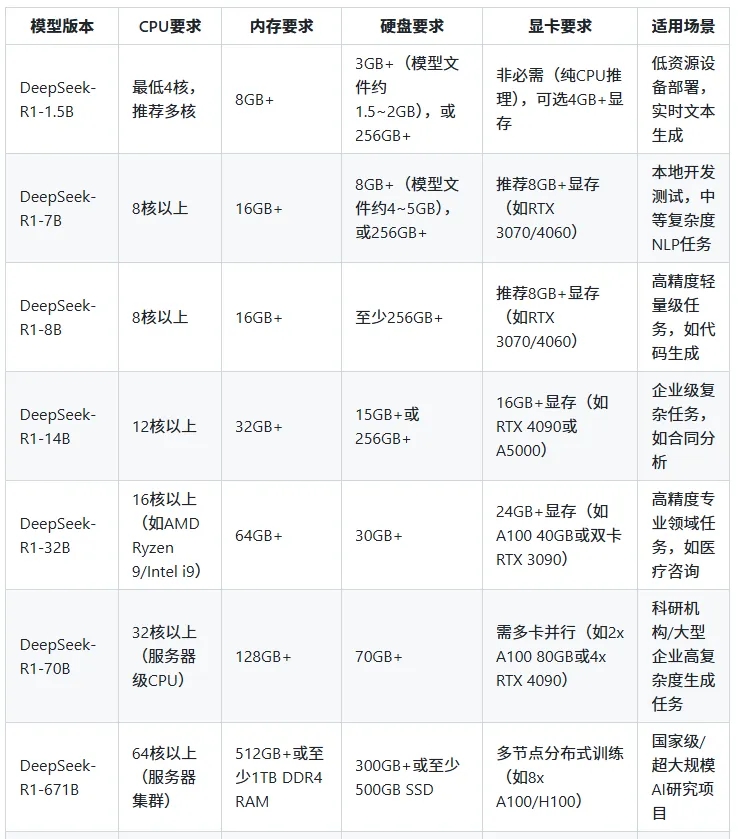

各个版本模型对硬件要求,官方没有明确的说明,根据网友分享的大概整理如下,大家可以根据自己的电脑配置选择模型。

选择要下载的模型,复制指令。

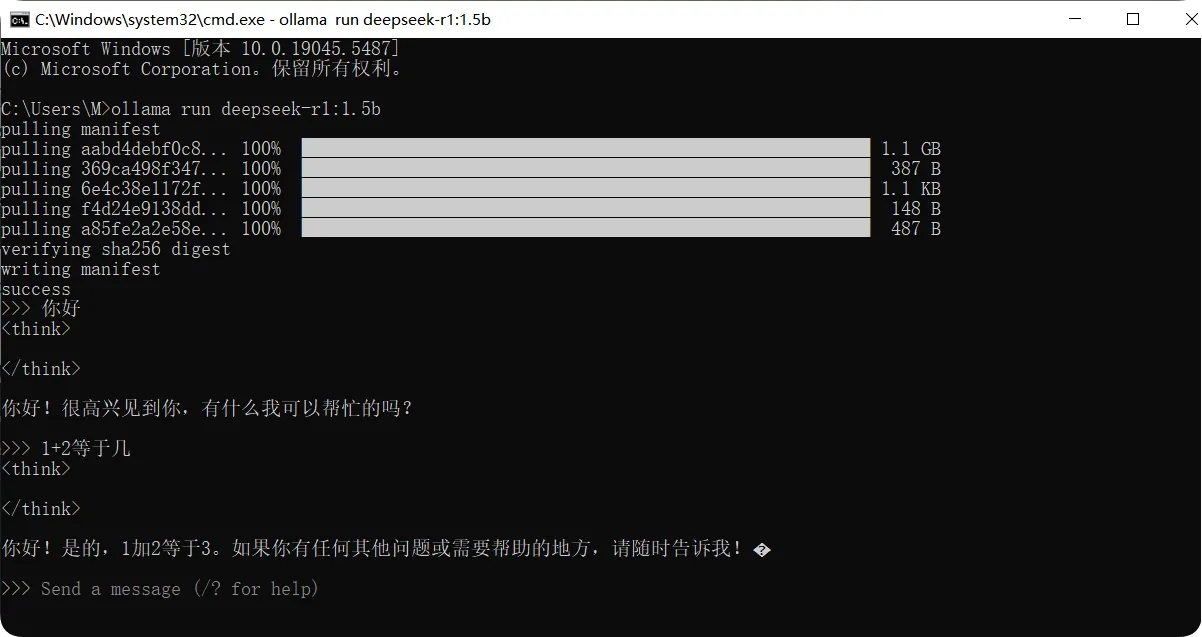

打开命令窗口,粘贴运行指令。等待下载完成。下载过程中,会显示下载进度和速度等信息。由于模型文件较大,下载时间可能会较长,需要耐心等待。

至此,已经可以与DeepSeek进行会话。

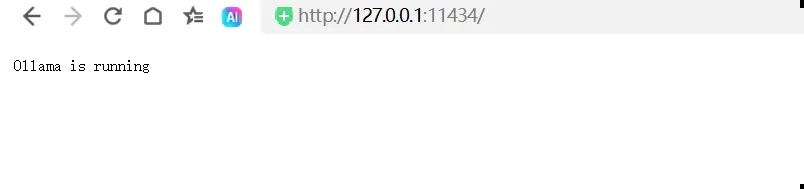

同时在浏览器访问:http://127.0.0.1:11434,有如下提示也代表启动成功了。

客户端 ChatBox AI接入 DeepSeek

Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。

1、下载 ChatBox AI

浏览器中访问 Chatbox AI的官方网站(https://chatboxai.app/zh),下载安装。

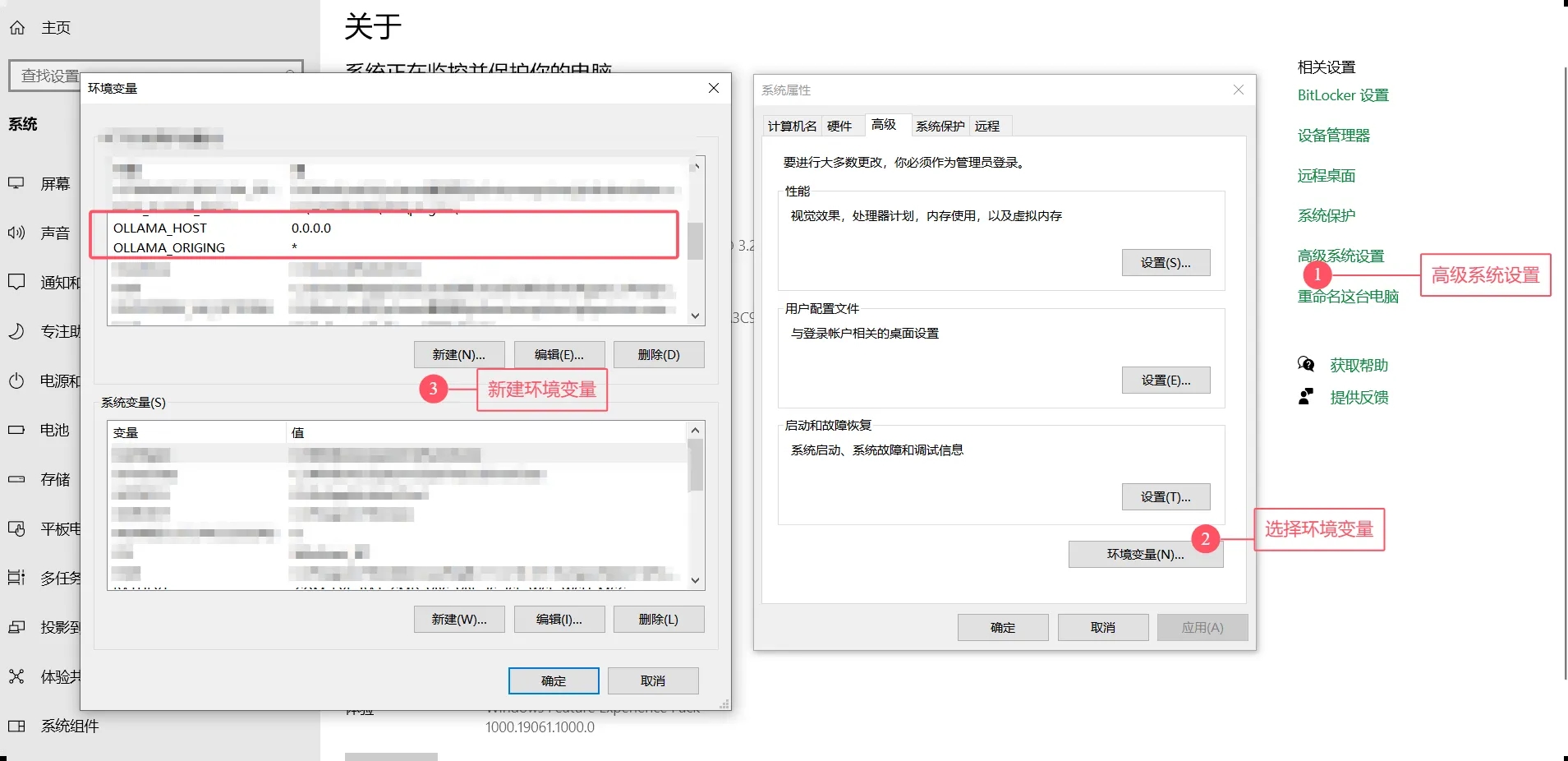

2、配置环境变量

添加两个环境变量,允许外部访问,填写:0.0.0.0,代表允许任何电脑访问。

OLLAMA_HOST:0.0.0.0

OLLAMA_ORIGING:*点击我的电脑,右键属性->高级系统设置->环境变量。

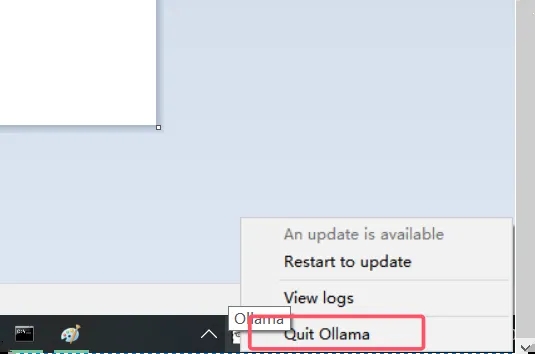

注意:设置完环境变量后退出一下 Ollama,然后重新启动下Ollama。

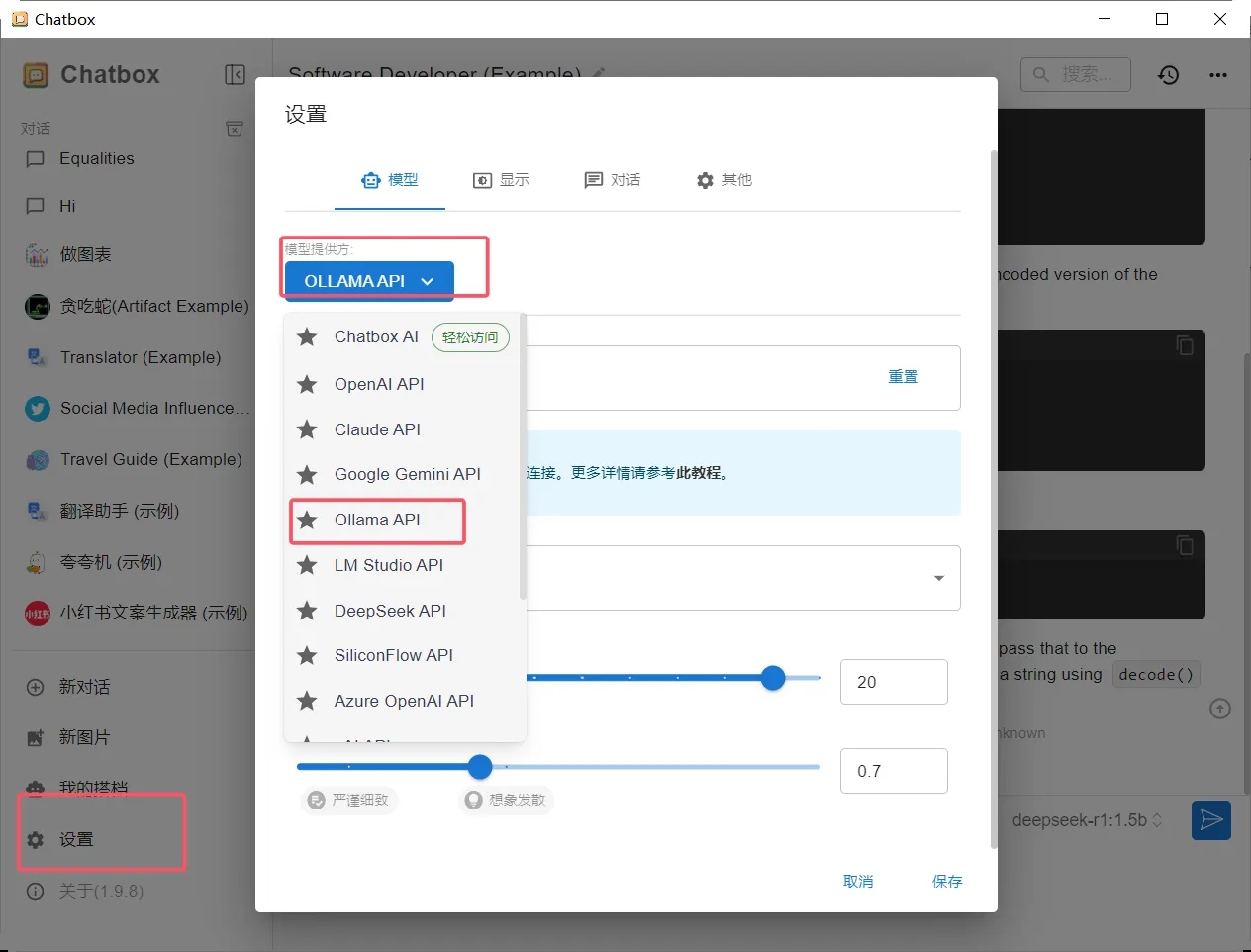

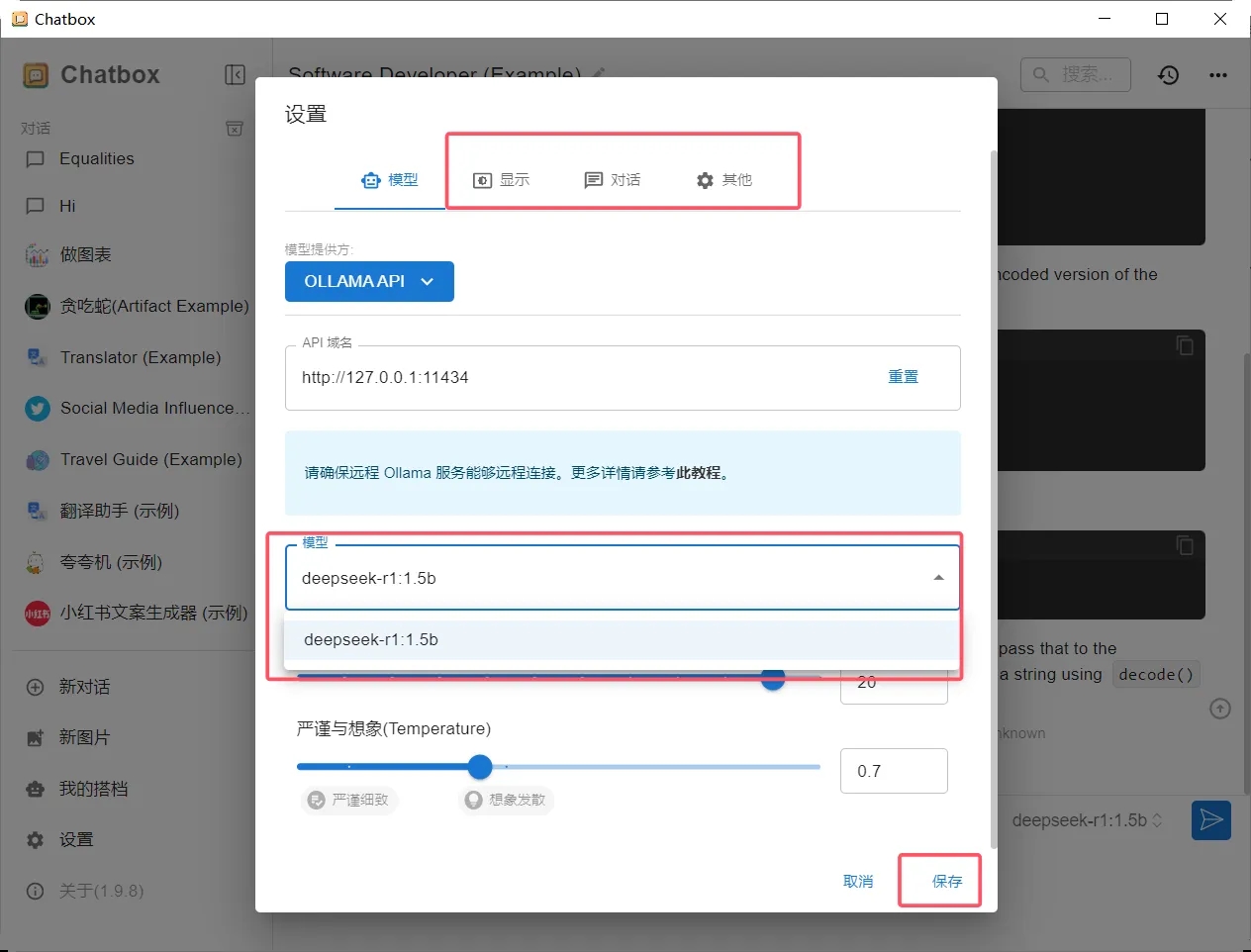

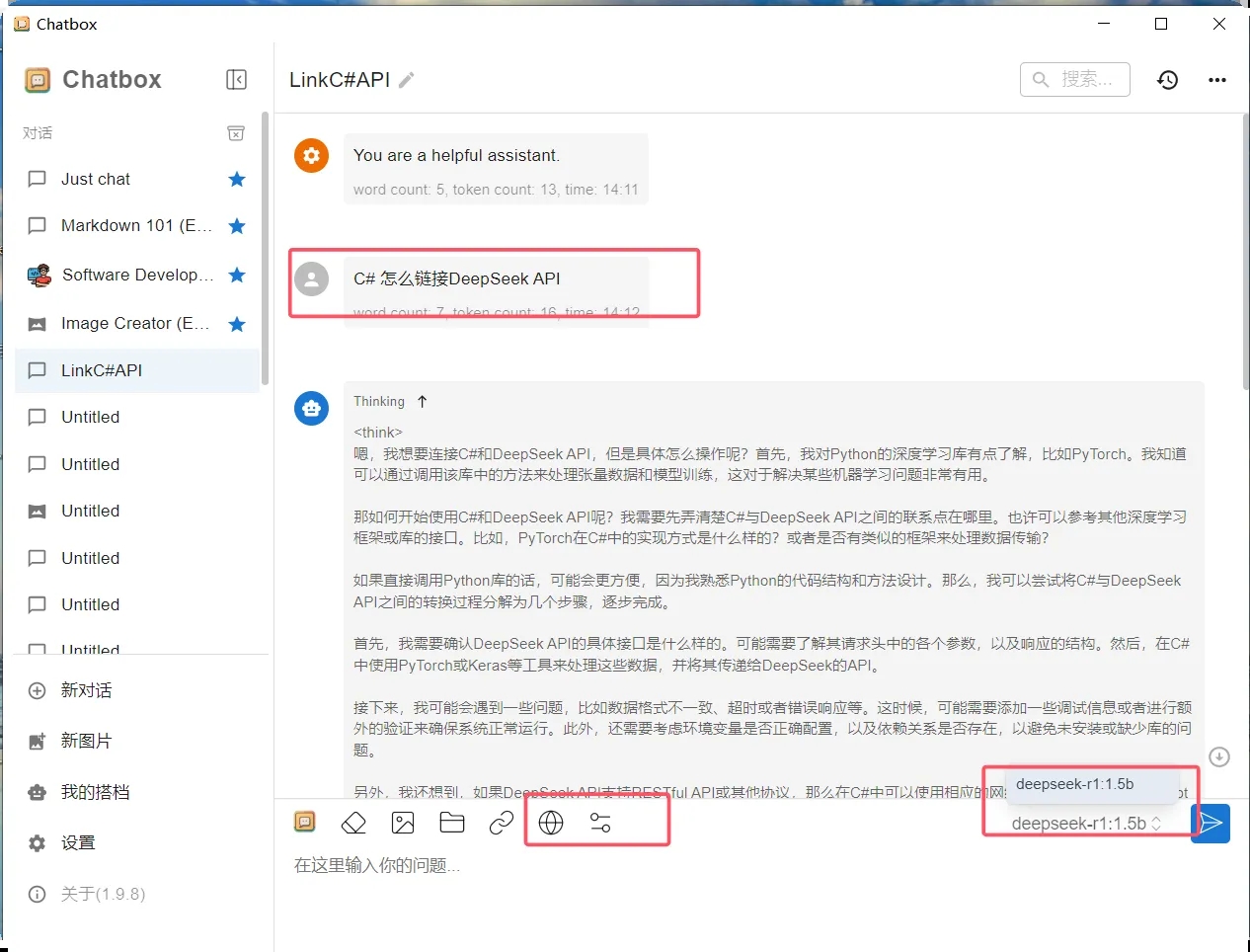

3、Chatbox AI 连接本地模型

启动 Chatbox AI 软件,选择 Ollama API后,然后选择下载的 DeepSeek模型,如果大家还有其他模型也可以选择对应的模型。

模型设置

选择API类型:Ollama API

模型名称:deepseek-r1:8b

点击检查连接,如果状态正常,可以开始使用了。

以上设置完成。我们就可以在客户端使用AI聊天了,

C# 调用 DeepSeek API

Ollama 还提供了 API 接口功能,使得自定义客户端开发或集成到应用系统变得非常方便。

其相关生态系统也非常完善,使用 C# 版本的 Ollama SDK(如 OllamaSharp)可以快速进行开发。

下面通过一个简单的例子来演示如何使用 Ollama:

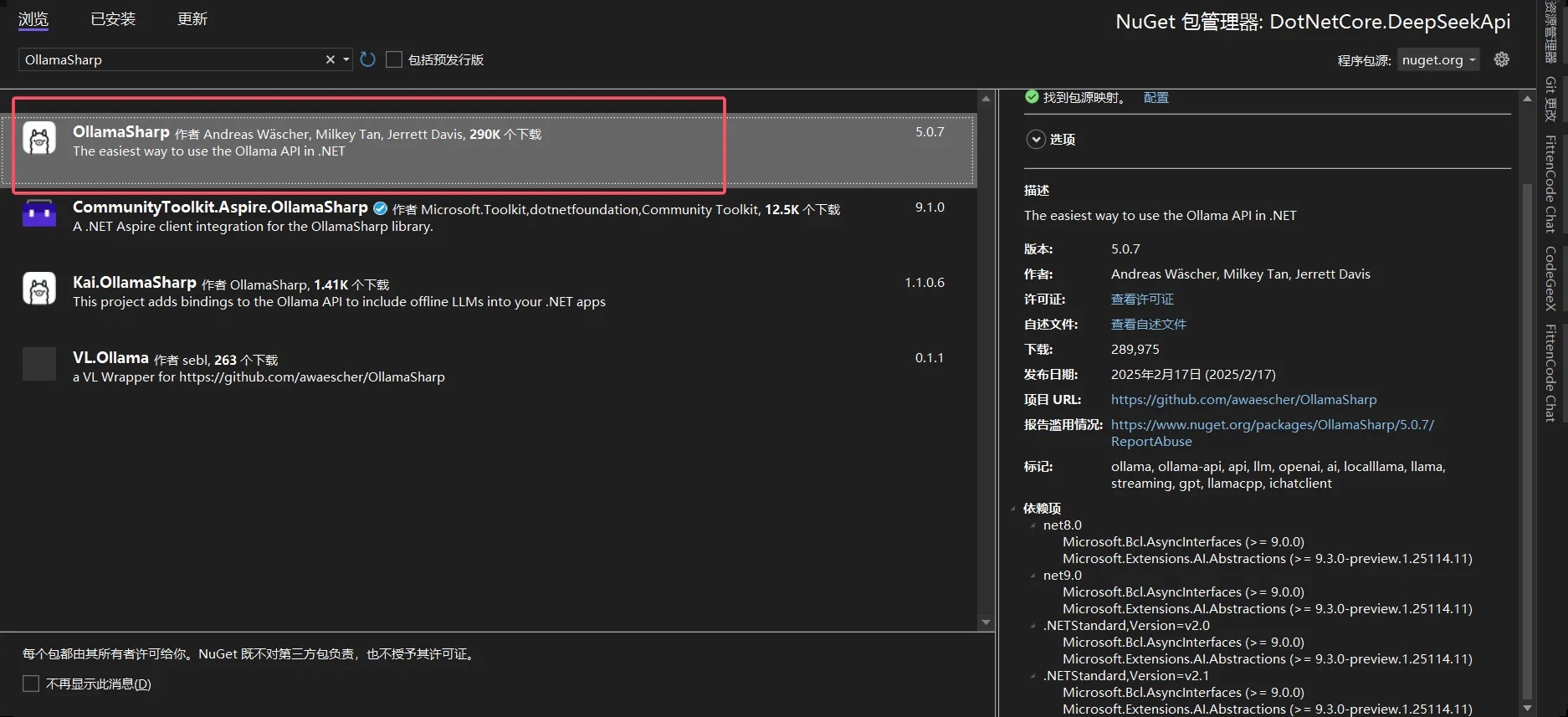

1、安装依赖包

首先,安装 OllamaSharp 依赖包:

2、示例代码

新建一个 OllamaApiExampleController控制器,添加如下代码:

using Microsoft.AspNetCore.Mvc;

using Microsoft.Extensions.AI;

using OllamaSharp;

namespace DotNetCore.DeepSeekApi.Controllers

{

/// <summary>

/// OllamaApi示例控制器

/// </summary>

[ApiController]

[Route("api/[controller]")]

public class OllamaApiExampleController : ControllerBase

{

private readonly Uri _modelEndpoint = new Uri("http://localhost:11434");

private readonly string _modelName = "deepseek-r1:1.5b";

/// <summary>

/// 初始化

/// </summary>

/// <param name="httpClient"></param>

/// <param name="configuration"></param>

public OllamaApiExampleController(){}

/// <summary>

/// 提问接口

/// </summary>

/// <param name="request"></param>

/// <returns></returns>

[HttpPost("ask")]

public async Task<IActionResult> AskQuestion([FromBody] AskRequest request)

{

var chatClient = new OllamaApiClient(_modelEndpoint, _modelName);

var question = request.Question;

if (string.IsNullOrEmpty(question))

{

return BadRequest("请输入您的问题?");

}

// 使用 await foreach 遍历每个 ChatResponseUpdate

var responseBuilder = new List<string>();

await foreach (var update in chatClient.GetStreamingResponseAsync(question))

{

responseBuilder.Add(update.ToString());

}

var response = string.Join("", responseBuilder);

return Ok(new { Response = response });

}

}

/// <summary>

/// 实体类

/// </summary>

public class AskRequest

{

/// <summary>

/// 问题

/// </summary>

public string Question { get; set; }

}

}3、运行结果

Ollama 相关的API接口,可以查看官方文档。

https://github.com/ollama/ollama/blob/main/docs/api.md

总结

通过本文简单的学习实现了DeepSeek 的本地部署和本地调用API接口。

能够掌握 DeepSeek 的本地部署方法,还能学会如何在 C# 项目中集成并调用 DeepSeek 提供的强大功能。

希望这些内容能够帮助大家在实际项目中顺利应用 DeepSeek,提升开发效率和项目质量。

最后

如果你觉得这篇文章对你有帮助,不妨点个赞支持一下!你的支持是我继续分享知识的动力。如果有任何疑问或需要进一步的帮助,欢迎随时留言。

也可以加入微信公众号**[DotNet技术匠]** 社区,与其他热爱技术的同行一起交流心得,共同成长!优秀是一种习惯,欢迎大家留言学习!