论文地址:[2404.09146] Fusion-Mamba for Cross-modality Object Detection

暂未开源

摘要

跨模态融合通过有效整合来自不同模态的互补信息,显著提升了目标检测的性能,使其在更广泛的应用场景中更加实用和鲁棒。现有的融合策略通常通过精心设计的神经网络模块将不同类型的图像进行组合,或者将不同骨干网络的特征进行合并。

然而,这些方法忽视了模态差异对跨模态融合性能的影响,因为具有不同相机焦距、位置和角度的模态难以有效融合。

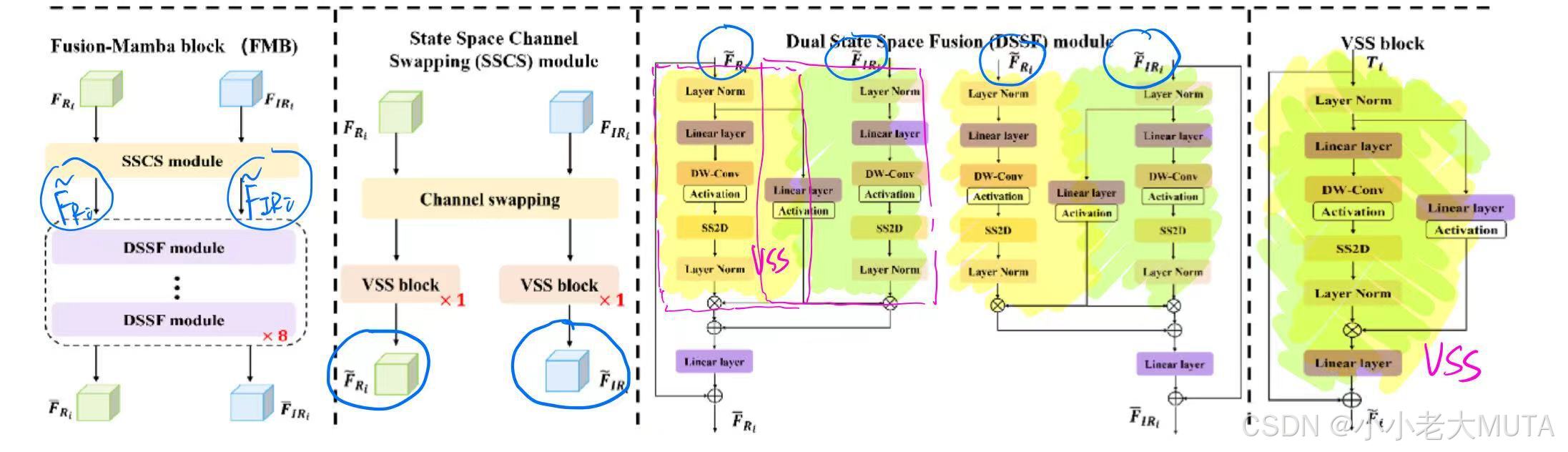

本文通过基于改进的Mamba(带有门控机制) 在隐藏状态空间中 关联跨模态特征 ,研究了跨模态融合问题。我们设计了一个融合Mamba模块(Fusion-Mamba Block, FMB),将跨模态特征映射到隐藏状态空间中进行交互,从而减少跨模态特征之间的差异,并增强融合特征的表征一致性。

FMB包含两个模块:

- 状态空间通道交换模块(State Space Channel Swapping, SSCS)用于促进浅层特征融合;

- 而双状态空间融合模块(Dual State Space Fusion, DSSF)则用于在隐藏状态空间中进行深层融合。

通过在公开数据集上的大量实验,我们提出的方法在mAP指标上分别比最先进的方法提高了5.9%(在M3FD数据集上)和4.9%(在FLIR-Aligned数据集上),展示了卓越的目标检测性能。据我们所知,这是首次探索Mamba在跨模态融合中的潜力,并为跨模态目标检测建立了新的基准。

一、引言

随着多模态传感器技术的快速发展,多模态图像已在许多不同领域中得到广泛应用。其中,成对的红外(IR)和可见光图像因其互补信息而被广泛使用。例如,红外图像能够清晰地显示物体的热结构而不受光照条件的影响,但缺乏目标的纹理细节。相比之下,可见光图像能够捕捉丰富的物体纹理和场景信息,但光照条件会严重影响图像质量。因此,许多研究专注于红外和可见光特征融合,以提高下游高级图像和场景理解任务(如目标检测和图像分割)的感知能力和鲁棒性。

现有的多光谱融合方法通常采用深度卷积神经网络(CNNs)[10, 27, 29]或Transformer[5, 32]来融合跨模态特征。例如,引入了一种中间融合方法,将RGB和IR图像的双分支中层特征进行整合,用于多光谱行人检测[19]。GFDSSD[46]使用门控融合单元构建了一个双流中间融合检测器,其性能优于单一模态。基于此,YOLO-MS引入了两个基于CNN的融合模块,用于融合YOLOv5骨干网络中的相邻分支,以实现实时目标检测[35]。尽管基于局部感受野的CNN在跨模态融合中取得了巨大成功,但基于Transformer[5, 32]的方法被提出来有效学习跨模态特征融合中的长程依赖关系。CFT[6]是首个探索使用Transformer进行中层特征融合的研究,能够提升YOLOv5的性能。ICAFusion[26]通过双交叉注意力Transformer成功建模全局特征并捕捉模态间的互补信息。

然而,这些跨模态融合方法未能考虑模态差异,这对跨模态特征融合产生了不利影响。

如图1(e)(f)(g)所示,YOLO-Ms、ICAFusion和CFT融合特征的热力图表明,它们++无法有效融合来自不同模态的特征++ ,也++无法建模跨模态对象之间的相关性++,因为它们的模态表示存在明显差异。

这促使我们重新思考:能否构建一个有效的跨模态交互空间,以减少模态差异,从而实现一致的表征,从而受益于跨模态关系以增强特征?

此外,基++于Transformer的跨模态融合计算密集,具有二次时间和空间复杂度++。

本文提出了一种Fusion-Mamba方法,旨在在隐藏状态空间中融合特征,这可能为跨模态特征融合开辟新的范式。

我们受到Mamba[8, 21, 47]的启发,利用其线性复杂度构建了一个隐藏状态空间,并通过门控机制进一步改进,以实现更深层次和更复杂的融合。

我们的Fusion-Mamba方法的核心在于创新的Fusion-Mamba块(FMB),如图2所示。

在FMB中,我们设计了一个状态空间通道交换模块(State Space Channel Swapping, SSCS)用于浅层特征融合,以增强跨模态特征的交互能力;以及一个双状态空间融合模块(Dual State Space Fusion, DSSF),用于构建隐藏状态空间以实现跨模态特征的关联和互补。这两个模块有助于减少融合过程中的模态差异,如图1(h)所示。热力图显示,我们的方法能够更有效地融合特征,并使检测器更专注于目标。

本文的主要贡献如下:

1)提出的Fusion-Mamba方法探索了Mamba在跨模态融合中的潜力,增强了融合特征的表征一致性。我们基于改进的Mamba通过门控机制构建了一个隐藏状态空间,用于跨模态交互以减少跨模态特征之间的差异。

2)我们设计了一个Fusion-Mamba块,包含两个模块:状态空间通道交换模块(SSCS)用于促进浅层特征融合,双状态空间融合模块(DSSF)用于在隐藏状态空间中进行深层融合。

3)在三个公开的RGB-IR目标检测数据集上的大量实验表明,我们的方法实现了最先进的性能,为跨模态目标检测方法提供了新的基准。

二、相关工作

多模态目标检测

随着单模态检测器(如YOLO系列模型[23]和Transformer[carion2020end, liu2021swin, guo2022cmt])的快速发展,多模态目标检测器应运而生,以充分利用来自不同模态的图像。迄今为止,多模态目标检测的研究主要集中在两个方向:像素级融合和特征级融合。

像素级融合将多模态输入图像进行合并,并将融合后的图像输入检测器。这些方法侧重于利用多模态输入图像信息重建融合图像[li2018densefuse, ma2019fusiongan, creswell2018generative]。

特征级融合则在检测器的某一阶段(如骨干网络提取的早期和后期特征[早期和中期融合[2, 33]])或检测输出(后期融合[4, 16])进行融合。特征级融合可以将融合操作集成到检测网络中,形成一个统一的端到端CNN或Transformer框架[2, 6, 26, 33, 35]。这些融合方法能够有效提升单模态目标检测的性能,但在建模模态差异和融合复杂性方面仍存在局限性。

Mamba

自Mamba[8]被提出用于自然语言处理(NLP)领域的线性时间序列建模以来,它迅速扩展到各种计算机视觉任务中的应用。Vmamba[21]基于图像特性引入了四向扫描算法,并构建了一个基于Mamba的视觉骨干网络,在目标检测、目标分割和目标跟踪任务中表现优于Swin Transformer。VM-UNet[25]在医学分割领域表现出色,基于UNet框架和Mamba模块。此后,许多基于Mamba的深度网络[22, 34, 41]被提出,用于在医学图像中进行精确分割。Video Mamba[3]将原始的2D扫描扩展到不同的双向3D扫描,并设计了一个Mamba框架,用于视频理解领域。与以往方法不同,我们的工作首次利用Mamba进行多模态特征融合。我们引入了一个精心设计的基于Mamba的结构,在隐藏状态空间中整合跨模态特征。

三、方法

3.1 预备知识

状态空间模型

状态空间模型(State Space Models, SSMs)常用于表示线性时不变系统,它通过将一维输入序列传递到中间隐状态

,从而生成输出

。在数学上,SSMs 通常表示为线性常微分方程(ODEs):

其中,系统的行为由一组参数定义,包括状态转移矩阵、投影参数

以及跳跃连接

。为了简化,可以通过设置

来移除

。

离散化

公式 (1) 中 SSMs 的连续时间特性在深度学习场景中带来了显著挑战。为了解决这一问题,需要通过离散化过程将 ODEs 转换为离散函数。这一过程对于确保模型与输入数据中底层信号的采样率对齐至关重要,从而促进高效的计算操作。

考虑输入 作为长度为 L 的信号流中的采样向量,引入时间尺度参数 Δ,可以根据零阶保持(ZOH)原则将连续参数 A 和 B 转换为离散对应参数

和

。因此,公式 (1) 被离散化为:

其中 ,I是单位矩阵。

离散化后,SSMs 通过全局卷积与结构化卷积核 进行计算:

基于公式 (2) 和 (3),Mamba设计了一种简单的选择机制,根据输入 x 对 SSM 参数 Δ、A、B 和 C 进行参数化,从而在 1D 语言序列建模中沿序列长度维度选择性地传播或遗忘信息。

2D 选择性扫描机制

2D 视觉数据与 1D 语言序列之间的不兼容性使得直接将 Mamba 应用于视觉任务并不合适。例如,2D 空间信息在视觉相关任务中起着至关重要的作用,但在 1D 序列建模中则处于次要地位。这种差异导致有限的感受野,无法捕捉与未探索区域之间的潜在相关性。为

了解决这一挑战,VMamba引入了2D 选择性扫描(SS2D)机制。SS2D 的概述如图 3 所示。

SS2D 首先将图像块沿四个不同方向展开,生成四个独立的序列。这种四向扫描方法确保特征图中的每个元素都能从各个方向的所有位置中获取信息,从而在不显著增加计算复杂度的情况下建立全面的全局感受野。随后,每个特征序列使用选择性扫描状态空间序列模型(S6)进行处理。最后,特征序列被聚合以重建 2D 特征图。

SS2D 是视觉状态空间(VSS)块的核心组件,如图 2 所示,它将用于构建隐藏状态空间以实现跨模态特征融合。

3.2 Fusion Mamba

3.2.1 架构

我们的模型架构如图 2 所示。

其++检测骨干网络++ 由双流特征提取网络和三个 Fusion-Mamba 块(FMB )组成,而++检测网络++则包含用于跨模态目标检测的 Neck 和 Head 部分。

特征提取网络用于从 RGB 和红外(IR)图像中提取局部特征,分别记为 和

。

随后,我们将这两个特征输入 FMB,通过在隐藏状态空间中关联跨模态特征,减少跨模态特征之间的差异,并增强融合特征的表征一致性。

具体来说,这两个局部特征首先通过状态空间通道交换模块(SSCS) 进行浅层特征融合,得到交互特征和

。然后,我们将这些交互特征输入双状态空间融合模块(DSSF) ,在隐藏状态空间中进行深层特征融合,生成相应的互补特征

和

。通过将原始特征

和

分别与互补特征

和

相加,局部特征被增强为

和

。接着,增强后的特征

和

直接相加生成融合特征

。在本文中,FMB 仅添加到最后三个阶段,生成融合特征 P3、P4 和 P5(如未特别说明),这些特征作为 Yolov8 的 Neck 和 Head 的输入,生成最终的检测结果(如图 4 所示)。

3.2.2 关键组件

给定输入 RGB 图像和红外图像

,我们将其输入一系列卷积块中以提取局部特征:

其中,ϕi和 φi 分别表示第 i 阶段 RGB 和 IR 分支的卷积块。

为了实现跨模态特征融合,现有方法 [6, 9, 26] 主要强调空间特征的整合,但未能充分考虑模态之间的特征差异。因此,融合模型无法有效建模不同模态目标之间的相关性,降低了模型的表征能力。受 Mamba 在状态空间上强大的序列建模能力的启发,我们设计了 Fusion-Mamba 块(FMB),以构建隐藏状态空间用于跨模态特征交互和关联。

FMB 的有效性在于两个关键模块:状态空间通道交换模块(SSCS)和双状态空间融合模块(DSSF),它们可以减少跨模态特征之间的差异,从而增强融合特征的表征一致性。

算法 1 提供了 SSCS 和 DSSF 模块的计算过程。

SSCS模块

该模块旨在通过通道交换操作 和 VSS 块增强跨模态特征交互,实现浅层特征融合。通过整合来自不同通道的信息,构建跨模态特征相关性,从而丰富通道特征的多样性,提升融合性能。

首先,我们使用通道交换操作生成新的局部 RGB 特征 和 IR 特征

,其公式为:

其中,CS(⋅,⋅)是通道交换操作,通过通道分割和拼接实现。

- 首先,将局部特征

和

沿通道维度分为四个相等的部分。

- 然后,从

中选择第一和第三部分,从

中选择第二和第四部分,通过按顺序拼接生成新的局部 RGB 特征

。相应地,生成新的局部 IR 特征

。

- 之后,对

和

应用一个 VSS 块,从浅层特征中增强跨模态交互:

其中,VSS(⋅)表示图 2 中描述的 VSS 块。和

分别是 RGB 和 IR 模态的浅层融合特征输出。

DSSF 模块

为了进一步减少模态差异,我们构建了一个隐藏状态空间用于跨模态特征关联和互补。DSSF 旨在建模跨模态目标相关性,以促进特征融合。具体来说,我们通过 VSS 块将两个模态的特征投影到隐藏状态空间中,并利用门控机制构建双重隐藏状态转换,以实现跨模态深层特征融合。

形式上,在获得浅层融合特征

和

后,我们首先通过无门控的 VSS 块将其投影到隐藏状态空间:

其中,

表示将特征投影到隐藏状态空间的操作。详细实现见算法 1 的第 13-17 行。

和

表示隐藏状态特征。

我们还将和

投影以获得门控参数

和

:

其中,

和

分别表示双流中具有参数

和

的门控操作。

之后,我们使用公式 (8) 中的门控输出和

来调制

和

,并实现隐藏状态特征融合:

其中,

和

分别表示特征交互后的 RGB 和 IR 隐藏状态特征,⋅ 表示逐元素乘积。

实际上,公式 (9) 和 (10) 基于门控机制在隐藏状态空间中构建了跨模态融合,并充分利用双重注意力实现跨分支信息互补。

随后,我们将和

投影回原始空间,并通过残差连接获得互补特征

和

:

其中,

表示具有线性变换的投影操作。

在实践中,我们堆叠多个 DSSF 模块(即公式 (7) 到 (11))以实现更深层次的特征融合,从而获得更好的结果。然而,DSSF 模块的数量会在某个值上达到饱和,这将在我们的实验中进一步评估。最后,我们通过加法操作将互补特征与局部特征合并,以增强特征表示:

3.2.3 损失函数

在 FMB 之后,RGB 和 IR 的增强特征(即公式 (12) 中的和

)进一步相加生成融合特征

,作为 Neck 的输入以提升检测性能。根据 [12, 13],总损失函数可以构建为:

其中,λcoord是一个超参数,用于调整定位损失 Lcoord的权重,Lconf是置信度损失,Lclass是分类损失。

3.3 与基于 Transformer 的融合方法的比较

现有的基于 Transformer 的跨模态融合方法 [6, 26] 通过卷积将特征展平并拼接,生成中间融合特征,然后通过多头交叉注意力进一步融合,生成最终的融合特征。这些方法仅通过空间交互 难以有效减少模态差异,因为难以建模跨模态特征之间的目标相关性。

我们的 FMB 块可以沿四个方向扫描特征,获得四组图像块,并有效保留特征的局部信息。此外,这些图像块被映射到隐藏空间中进行特征融合。这种基于映射的深层特征融合方法通过双向门控注意力有效减少了空间差异,进一步抑制了冗余特征并捕捉了模态间的互补信息。

因此,所提出的 FMB 减少了跨模态特征之间的差异,并增强了融合特征的表征一致性。此外,Transformer 的全局注意力时间复杂度为 O(N^2),而 Mamba 的时间复杂度仅为 O(N),其中 N 是序列长度。从实验角度来看,使用相同的检测模型架构,将基于 Transformer 的融合模块替换为 Fusion-Mamba 块,可以在处理一对图像时节省 7-19 毫秒的推理时间。更多细节将在我们的实验中讨论。

四、实验

4.1 实验设置

数据集

我们的 Fusion-Mamba 方法在三个广泛使用的可见光-红外基准数据集上进行了评估,分别是 LLVIP [11]、M3FD [20] 和 FLIR [7]。

LLVIP 是一个在低光环境下收集的对齐可见光和红外(IR)数据集,用于行人检测,包含 15,488 对 RGB-IR 图像。根据官方标准,我们使用 12,025 对进行训练,3,463 对进行测试。

M3FD 包含 4,200 对 RGB 和 IR 对齐图像,收集于不同环境(如光照、季节和天气场景)。它包含六类通常在自动驾驶和道路监控中出现的目标。由于没有官方数据集划分方法,我们使用 [18] 提供的训练/测试划分。

FLIR 收集于白天和夜间场景,包含五类目标:人、汽车、自行车、狗和其他车辆。根据 [38],我们使用 FLIR-Aligned 数据集,其中 4,129 对用于训练,1,013 对用于测试。

评估指标

我们使用最常见的评估指标 mAP 和 mAP50。mAP50 表示在 IoU 为 0.50 时的平均精度,mAP 表示在 IoU 从 0.50 到 0.95 范围内的平均精度,步长为 0.05 [43]。这两个指标的测试值越大,模型性能越好。我们还报告了在 A800 GPU 上对输入尺寸为 640×640 的图像进行 5 次运行的平均推理时间。

实现细节

所有实验均在双流框架 [6] 中实现,使用单块 A800 GPU。我们的 Fusion-Mamba 的骨干网络、Neck 和 Head 结构与 YOLOv5-l 或 YOLOv8-l 默认相同。训练时,批量大小设置为 4,SGD 优化器的动量为 0.9,权重衰减为 0.001。所有三个数据集的输入图像尺寸为 640×640,训练轮数为 150,初始学习率为 0.01。FMB 中的 SSCS 和 DSSF 模块数量默认分别设置为 1 和 8。λcoord设置为 7.5。其他训练超参数与 YOLOv8 相同。

4.2 与 SOTA 方法的比较

为了验证我们的 Fusion-Mamba 方法的有效性,我们基于 YOLOv5 和 YOLOv8 两种骨干网络与 SOTA 方法进行了公平比较。

LLVIP 数据集

表 1 总结了不同方法在 LLVIP 上的结果。我们使用两种不同骨干网络的 Fusion-Mamba 方法与 6 种 SOTA 多光谱目标检测方法和 5 种单模态检测方法进行了比较。

对于单模态检测,**仅使用 IR 图像的检测性能优于仅使用 RGB 图像,这是由于低光条件的影响。**通过 RGB 和 IR 特征融合,基于 ResNet 骨干网络的 mAP 性能有所提升,优于仅使用 IR 模态的检测。例如,基于 ResNet50 骨干网络的 RSDet 比仅使用 IR 模态的 Cascade R-CNN 高出 4.5% mAP。值得注意的是,它在 YOLOv5 骨干网络上未能有效融合,例如,仅使用 IR 模态输入的简单 YOLOv5 检测框架实现了 61.9% mAP,显著优于融合方法 DIVFusion 的 9.9% mAP。在相同的 YOLOv5 骨干网络下,我们的 Fusion-Mamba 方法比仅使用 IR 的 YOLOv5 检测框架提高了 0.9% mAP,并且比之前的最佳融合方法 RSDet 高出 1.5% mAP。这是因为我们的 SSCS 和 DSSF 有效减少了模态差异,提高了融合特征的表征一致性。我们的方法在 YOLOv8 骨干网络上也表现出色,实现了 97.0% mAP50 和 64.3% mAP 的 SOTA 性能。

M3FD 数据集

我们基于 YOLOv5 和 YOLOv7 的 7 种 SOTA 检测器与我们的方法进行了比较。如表 2 所示,我们的 Fusion-Mamba 在相同 YOLOv5 骨干网络下在所有类别上均表现最佳,而基于 YOLOv8 骨干网络的方法在 People、Bus、Motorcycle 和 Truck 类别上实现了新的 SOTA 结果,mAP50 和 mAP 分别提高了 3% 和 4.4%。此外,基于 YOLOv5 骨干网络的方法也优于基于 YOLOv7 的 SuperFusion,尽管 YOLOv5 的特征表示能力低于 YOLOv7。这是因为我们的 FMB 有效提高了跨模态特征的互补性。

FLIR-Aligned 数据集

如表 3 所示,Fusion-Mamba 在 FLIR-Aligned 数据集上也表现最佳。与基于双流 YOLOv5 骨干网络的 CrossFormer 相比,我们基于 YOLOv8 和 YOLOv5 的方法分别高出 5.6% 和 5% mAP50,以及 4.9% 和 2.3% mAP。我们还比 RSDet 高出 3.8% mAP50 和 5.6% mAP。在速度方面,基于 YOLOv5 的方法最快,与基于 Transformer 的 CFT 和 CrossFormer 方法相比,每对图像的检测时间分别节省了 7ms 和 19ms。在参数量方面,基于 YOLOv5 的方法比 CrossFormer 方法节省了约 100M 参数。尽管基于 YOLOv8 的方法比 YOLOv5 增加了约 40M 参数,但 mAP 显著提高了 2.6%。这表明基于隐藏空间建模的方法更好地整合了不同模态之间的特征,抑制了模态差异,以最佳的性能与计算成本权衡增强了融合特征的表征能力。

热力图可视化

为了直观展示我们模型的高性能,我们从三个实验数据集中随机选择一对图像,可视化 P5 热力图,并与其他融合方法进行比较。如图 5 所示,与其他方法相比,我们的模型更专注于目标,而不是分散或关注无关部分。更多示例见补充材料。我们还在补充材料中可视化了目标检测结果,以评估我们方法的有效性。

4.3 消融实验

我们使用 FLIR-Aligned 数据集进行消融实验,分别验证 SSCS 和 DSSF 模块的有效性,并进一步探讨 DSSF 模块数量和位置的影响。特别是,我们还评估了 DSSF 模块双重注意力的效果。所有实验均基于 YOLOv8 骨干网络进行。

SSCS 和 DSSF 模块的效果

表 4 总结了移除 SSCS 和 DSSF 模块的结果。移除 SSCS 模块(表 4 第二行)后,检测器性能在 mAP50 和 mAP 上分别下降了 2% 和 1.1%。这是因为没有两种模态特征的初始交换和浅层映射融合,后续深层融合中的特征差异未能有效减少。同时,移除 DSSF 模块(表 4 第三行)后,仅通过浅层融合交互无法有效抑制冗余特征并激活有效特征,导致检测器性能在 mAP50 和 mAP 上分别下降了 2.5% 和 2.4%。当同时移除 SSCS 和 DSSF 模块(表 4 第四行)时,融合特征仅通过两种局部模态特征的加法获得,性能在 mAP50 和 mAP 上分别显著下降了 4.8% 和 7.6%。这些结果表明,FMB 的这两个组件对跨模态目标检测是有效的。

FMB 位置的影响

根据 [6, 14] 的工作,我们设置了三个 FMB 进行特征融合。这里,我们进一步探讨 FMB 位置的影响,即在哪些阶段应添加 FMB。我们选择了三组多级特征:{P2, P3, P5}、{P2, P4, P5} 和 {P3, P4, P5} 进行消融实验,其中 Pi 是使用 FMB 在第 i 阶段生成的融合特征。如表 5 所示,位置 {P3, P4, P5} 在性能和计算复杂度之间实现了最佳权衡。因此,我们默认选择此位置进行实验。

DSSF 模块数量的影响

我们在表 4 中验证了 DSSF 的有效性。这里,我们进一步评估 DSSF 模块数量的影响,结果总结在表 6 中。我们选择了四种 DSSF 数量(即 2、4、8、16),并保持其他模型设置与上述实验一致。可以看到,当模块数量设置为 8 时,性能最佳。8 个 DSSF 模块会达到饱和,增加此数量会导致互补特征的漂移,从而降低融合性能。

DSSF 模块双重注意力的效果

为了进一步探索我们门控机制的有效性,我们分别移除了 RGB 分支中的 IR 注意力(即公式 (9) 中的 )、IR 分支中的 RGB 注意力(即公式 (10) 中的

)以及双重注意力。结果如表 7 所示。移除 IR 注意力或 RGB 注意力后,mAP50 分别下降了 1.6% 或 1.1%,因为减少了两种特征之间的注意力交互。当同时移除双重注意力时,DSSF 模块变为 VSS 块的堆叠,mAP50 下降了 2%。值得注意的是,IR 和 RGB 注意力分支与其他分支共享权重,与移除双重注意力相比,仅增加了激活函数和特征加法操作。因此,双重注意力的使用对模型参数和运行时间没有显著影响,但显著提高了检测性能。

5. 结论

本文提出了一种新颖的 Fusion-Mamba 方法,通过精心设计的 SSCS 模块和 DSSF 模块实现多模态特征融合。特别是,SSCS 交换红外和可见光通道特征以实现浅层特征融合。随后,DSSF 基于 Mamba 在隐藏状态空间中进行更深层次的多模态特征交互,并使用门控注意力抑制冗余特征以增强特征融合的有效性。在三个公开的 RGB-IR 数据集上进行的大量实验表明,我们的方法在推理效率上优于 Transformer,并实现了新的 SOTA 性能。我们的工作证实了 Mamba 在跨模态融合中的潜力,我们相信这项工作可以激发更多关于 Mamba 在跨模态任务中应用的研究。