噪声修正线性单元(Noisy ReLU)详解

1. 引言

在深度学习中,修正线性单元(ReLU, Rectified Linear Unit) 是一种常见的激活函数,具有计算简单、梯度稳定等优点。然而,ReLU 也有一些缺点,比如对输入较小的数据(尤其是接近 0 的输入)较为敏感,容易导致神经元"死亡"(即梯度消失,神经元权重无法更新)。

为了解决这个问题,研究者们提出了噪声修正线性单元(Noisy ReLU) ,它在 ReLU 的基础上添加了高斯噪声,以增强模型的鲁棒性和泛化能力。本文将深入探讨 Noisy ReLU 的数学定义、工作原理、优缺点以及应用场景。

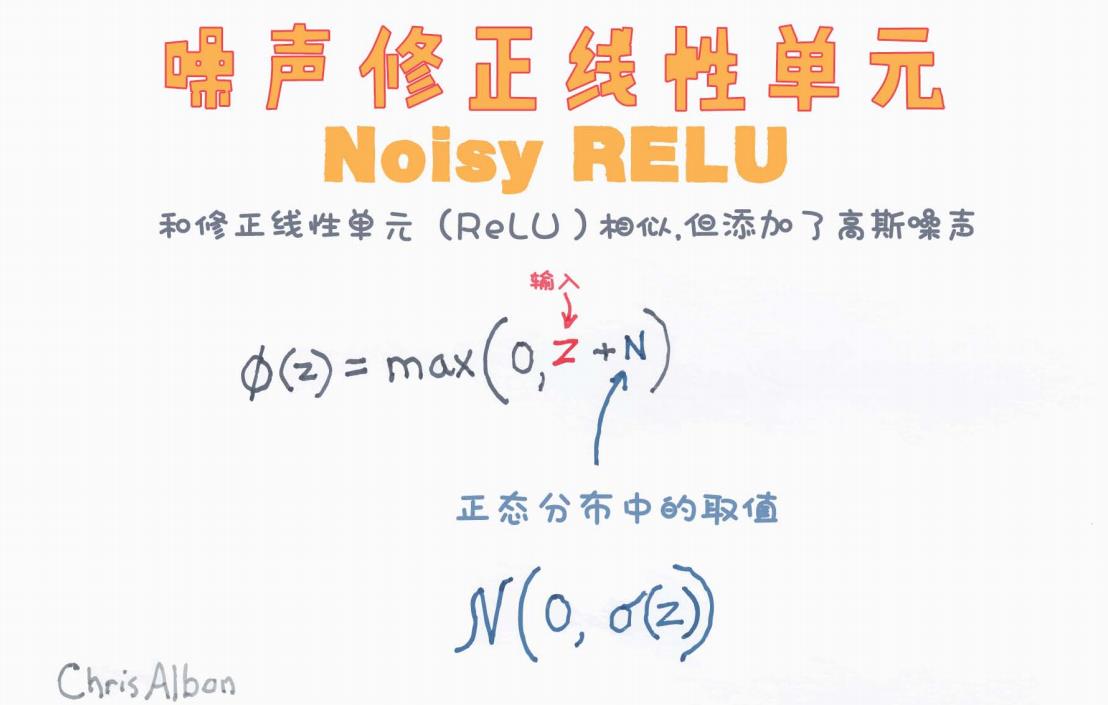

2. Noisy ReLU 的定义

Noisy ReLU 的数学表达式如下:

其中:

-

z 是输入数据;

-

N 是从正态分布

中采样的随机噪声,均值为 0,标准差与输入相关;

-

σ(z) 是一个标准差函数,用于决定噪声的大小。

2.1 直观理解

Noisy ReLU 的核心思想是在 ReLU 的基础上引入高斯噪声,使得每个神经元的激活值变得不那么确定,从而提升模型的泛化能力。

-

传统的 ReLU 计算方式是 max(0,z),即当 z < 0 时,输出 0,当 z > 0 时,输出 z。

-

Noisy ReLU 在计算时加入了噪声,使得即使 z 本来小于 0,在某些情况下仍然可能被激活,从而避免 ReLU 死亡神经元问题。

这种噪声可以被视为一种随机扰动,使得网络在训练过程中更加鲁棒,避免陷入局部最优解,并能够更好地适应多样化的数据。

3. 为什么需要 Noisy ReLU?

3.1 传统 ReLU 的问题

ReLU 作为一种非线性激活函数,在深度学习中广泛应用。然而,它有几个主要问题:

-

死亡神经元(Dead Neurons)

-

当输入 z < 0 时,ReLU 输出 0,导致该神经元的梯度为 0,权重无法更新,从而失去学习能力。

-

一旦某个神经元进入这种状态,它可能永远不会被激活。

-

-

梯度消失问题

- 在深层网络中,ReLU 层的梯度可能会逐层衰减,导致梯度消失,影响模型训练。

-

对数据分布的敏感性

- 由于 ReLU 在输入接近 0 时会出现大幅度变化,可能导致网络训练不稳定。

3.2 Noisy ReLU 如何改进?

Noisy ReLU 在 ReLU 的基础上加入了随机噪声,带来的好处包括:

缓解死亡神经元问题

-

由于噪声的加入,即使 z 本来是负数,在某些情况下仍然可能大于 0,从而被激活。

-

这样,网络中的神经元不容易彻底"死亡",仍然有机会更新权重。

增加泛化能力

-

噪声可以被视为一种正则化手段,使得神经元的激活值不会完全依赖于单一输入,而是具有一定的随机性。

-

这有助于防止模型过拟合,提高泛化能力。

改进梯度流

- 由于 Noisy ReLU 允许更多神经元保持活跃,梯度流的传播更加稳定,梯度消失的问题得到缓解。

4. Noisy ReLU 的数学推导

4.1 期望值计算

对于标准的 ReLU,输出的期望值是:

而对于 Noisy ReLU,我们需要计算:

其中 。如果 z 足够大,则 Noisy ReLU 近似于 ReLU;如果 z 过小,由于高斯噪声的影响,Noisy ReLU 仍然可能大于 0,从而激活神经元。

5. Noisy ReLU 在深度学习中的应用

由于 Noisy ReLU 具有更好的稳定性和泛化能力,它被广泛用于以下任务:

5.1 计算机视觉(CV)

在图像分类、目标检测、图像分割等任务中,Noisy ReLU 可用于增强 CNN(卷积神经网络)的鲁棒性,使其在不同数据分布下的表现更加稳定。

5.2 自然语言处理(NLP)

在 Transformer 结构中,虽然常见的激活函数是 GELU(高斯误差线性单元),但 Noisy ReLU 也可用于提高注意力机制的稳定性,避免某些神经元被彻底抑制。

5.3 生成对抗网络(GAN)

在 GAN 的生成器和判别器中,激活函数的选择对训练稳定性至关重要。Noisy ReLU 通过引入噪声,能帮助 GAN 逃离局部最优,提高生成样本的多样性。

6. Noisy ReLU 的缺点

尽管 Noisy ReLU 具有诸多优点,但它也有一些不足之处:

计算复杂度增加

- 由于每个激活值都需要加入随机噪声,计算量相比 ReLU 略有增加。

超参数选择问题

- 噪声的标准差 σ(z) 需要合理选择,若过大可能导致训练不稳定,过小则可能无法发挥作用。

可能影响收敛速度

- 由于噪声的存在,梯度更新变得更加随机,可能导致训练过程收敛速度变慢。

7. 结论

Noisy ReLU 是一种在 ReLU 基础上引入随机噪声的激活函数,它有效缓解了 ReLU 的死亡神经元问题,提高了模型的泛化能力,尤其适用于深度神经网络中的高维复杂任务。然而,它也带来了一定的计算开销,因此在实际应用中,需要根据具体任务权衡利弊。

总结:

-

Noisy ReLU = ReLU + 高斯噪声

-

避免死亡神经元,提高泛化能力

-

适用于 CNN、NLP、GAN 等任务

-

需要适当选择噪声标准差,以平衡计算开销和效果

Noisy ReLU 作为一种激活函数的变体,为深度学习提供了新的可能性,未来可能会在更多任务中发挥重要作用!