文章目录

- 前言

- 一、IDEA安装continue

- 二、continue部署本地大模型

- [三、continue聊天窗口使用deepseek R1](#三、continue聊天窗口使用deepseek R1)

- 四、continue批量接入硅基流动的模型API

前言

亲爱的家人们,创作很不容易,若对您有帮助的话,请点赞收藏加关注哦,您的关注是我持续创作的动力,谢谢大家!有问题请私信或联系邮箱:fn_kobe@163.com

前置条件 :本地或者私有服务器上的的ollama已经部署有deepseek、llama大模型 。若没有部署,参考我之前的博客(Ollama本地部署deepseek)

一、IDEA安装continue

步骤1 :file→setting→plugins→检索continue(可能存在IDEA版本太低检索不到continue插件的问题,更新IDEA版本即可 ),然后安装continue插件(默认安装的是最新版本,笔者当时安装最新版本是1.0.13 ,在IDEA的模型选择UI适配有问题,更换后的版本是0.0.83,具体的更换步骤如步骤3所示)。

步骤2 :出现continue图标表示安装成功。

步骤3 :更换continue版本解决IDEA中模型选择UI适配的问题

1、进入continue插件版本适配IDEA的网址,选择如图所示的插件版本点击download下载,文件格式为zip。

2、打开IDEA:依次点击 file→setting→plugins→检索continue→设置图标

继续install plugins from desk

选择刚才下载的continue-intellij-extension-0.0.83.zip文件,然后IDEA会自动安装,再重启IDEA。

二、continue部署本地大模型

步骤:4 :点击+,选择add chat model

步骤5 :按图1234所示操作,然后点击connect。

本地deepseek、llama3模型成功连接如图所示。

三、continue聊天窗口使用deepseek R1

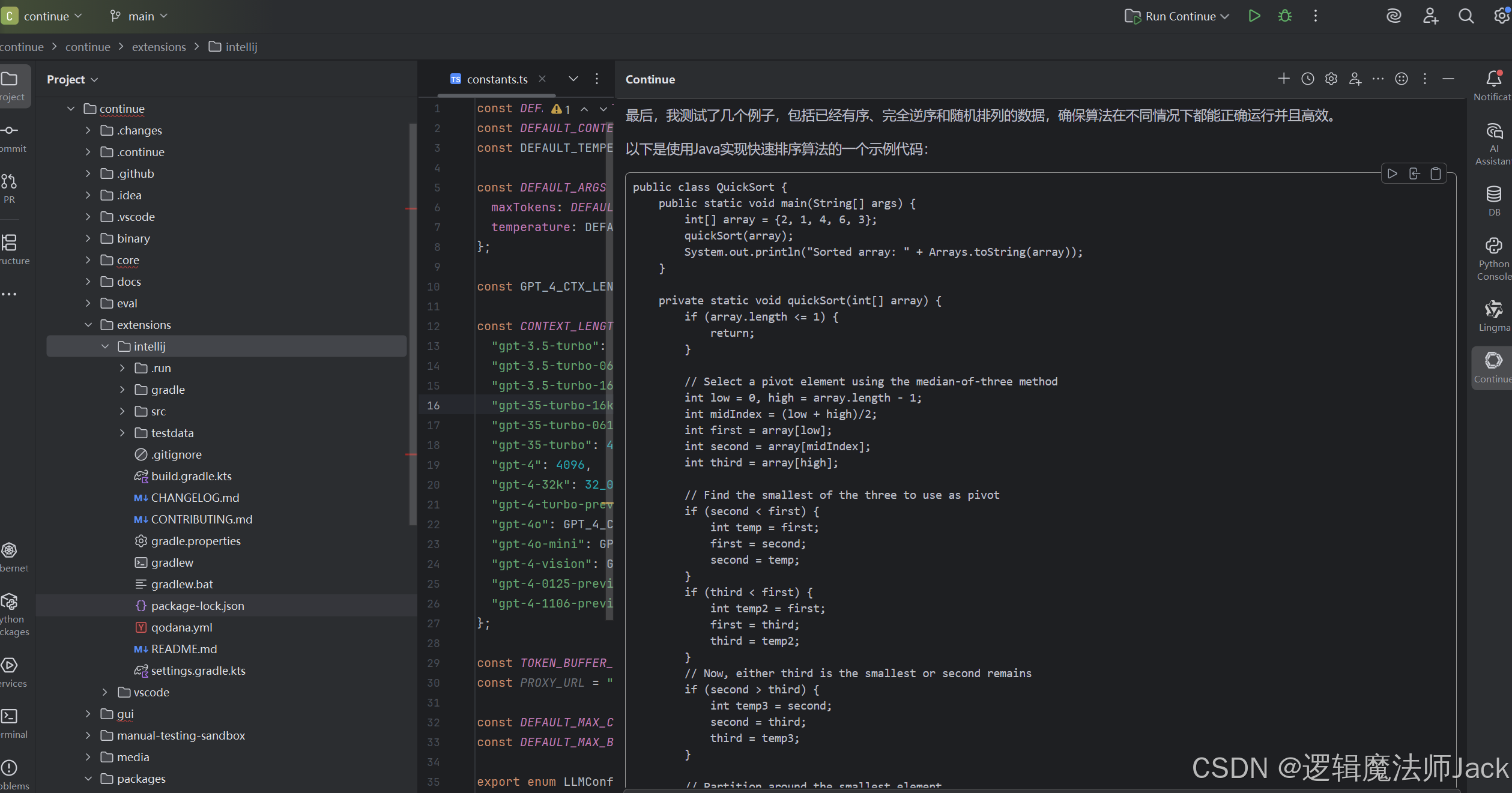

写一个Java排序算法

具体效果如下:

四、continue批量接入硅基流动的模型API

硅基流动网址(如何申请API的过程有不懂同学私聊),另外config.json文件中的model名称要和硅基流动网址的模型广场的名称一致(特别注意)。