一、适用场景

1、企业内部知识管理

(1)快速查询政策与流程文档:

员工通过自然语言提问,MaxKB 能迅速定位相关文档并给出准确答案,减少人工检索成本,提升企业内部知识获取的效率。

(2)业务部门轻量级需求落地:

业务部门可直接上传文档、配置问答策略,无需依赖开发团队,快速搭建基于 RAG 技术的智能客服、内部知识检索系统,满足轻量级知识管理需求。

2、智能客服

(1)自动化解答客户常见问题:

集成到客服系统中,当客户询问商品信息、物流进度等常见问题时,MaxKB 能快速响应,准确解答,有效减轻客服人员的工作负担,同时提高客户满意度。

(2)嵌入第三方业务系统:

支持零编码快速嵌入到企业微信、钉钉等第三方业务系统,让已有系统快速拥有智能问答能力,提升用户体验。

3、教育与研究

(1)基于学术文献构建问答系统:辅助知识梳理与教学,帮助学生和研究人员快速获取所需信息,提高学习和研究效率。

(2)校园生活与行政服务:用于校园生活服务、行政服务、科研支持、课程管理等场景,为师生提供便捷的信息查询和咨询服务。

4、智能决策:

将MaxKB应用于 AI智能决策系统,研发人员使用"Ollama + MaxKB"实现本地 DeepSeek 大模型部署与知识库搭建,使大模型能快速调取相关数据和知识库信息,为用户提供了一个更全面、更精准的答复和解决方案,极大地提高了工作的效率和服务质量。

5、政府服务

(1)智能客服与工单受理:

能够全天候响应客户在线咨询需求,打破传统人工客服人力和时间的限制,让群众可以随时随地获得及时有效帮助,极大提高了服务便捷性和有效性。

(2)条例查询与公文写作:

帮政府工作人员快速查询相关条例法规,提供公文写作辅助,提高工作效率和服务质量。

6、医疗行业

医院 AI 助手:基于"DeepSeek + MaxKB"构建 AI 助手,通过 MaxKB 工具完成本地知识库构建,并且利用 iframe 标签将 MaxKB 生成的 UI 页面嵌入到第三方应用程序中,为医护人员和患者提供便捷的服务。

7、个人知识管理

(1)搭建个人知识库:

个人可以将读书笔记、工作资料等上传到 MaxKB,构建个人知识库,可随时查询和回顾。

(2)智能问答与知识梳理:

通过智能问答交互,帮助个人梳理和巩固知识,提高学习和工作效率。

二、说明

1、Ollama是一个开源的、可以在本地运行大型语言模型的工具。它允许用户在自己的设备上部署和运行语言模型,而不必完全依赖云端服务。这在数据隐私等方面有诸多优势,比如用户担心数据发送到云端会产生安全风险,使用Ollama就可以在本地处理数据。

2、MaxKB 是一个基于大语言模型(LLM)和检索增强生成(RAG)技术的开源知识库问答系统,支持多种格式的文档上传(如 PDF、Word、Excel、Markdown 等)。MaxKB 是一个功能强大的知识库问答系统,适用于企业知识管理、智能客服、教育研究、公共事业等多种场景。它通过结合大语言模型和检索增强生成技术,提供了高效、精准的问答能力,同时支持灵活的部署和扩展,满足不同用户的需求。

3、本例部署环境

(1)ESXi 6.7的环境部署本例不赘述,请参考:

https://blog.csdn.net/weixin_43075093/article/details/123985235

(2)为提高安全性,ESXi 6.7 U3升级部署本例不赘述,请参考:

https://blog.csdn.net/weixin_43075093/article/details/135002138

4、MaxKB 需要开通的访问端口说明如下:

三、部署win10 + ollama:

(一)win10中安装ollama

1、 Ollama 的下载

官网地址:https://ollama.com/

下载地址:https://ollama.com/download

本教程选择 Ollama Windows 版本下载。

2、 Ollama 的安装

(1)下载完成后直接点击 OllamaSetup.exe 进行安装。

(2)安装完成后,cmd 打开命令行窗口,输入 "ollama -v" 测试,显示 ollama 的版本为 "0.5.12",表明安装成功。

3、配置环境变量:

(1)新建用户的环境变量后,注意大写与名称,重启,如下图:

配置OLLAMA_HOST环境变量的作用是让虚拟机里的maxKB能够访问到本机上的Ollama,因为这里maxKB要通过CentOS部署,默认情况下ollama只能允许本机访问的。默认情况下Ollama监听的是localhost:11434。通过设置成0.0.0.0,这样Ollama就可以监听到本机所有的ip,这样虚拟机就可以访问到本机上的Ollama了。

ollama默认安装地址是 "C:\Users%username%.ollama\models"。此处配置环境变量是让ollama指令可以在重启,任何提示符路径下执行deepseek-r1:1.5b模型。

(2)重启系统后,使用set命令查看设置的环境变量是否生效:

4、 Ollama 的运行

Ollama 没有用户界面,在后台会自动运行,重启电脑也会自动启动。

打开浏览器,输入 :

显示 "Ollama is running"。说明ollama已经在运行了。

(二) deepseek-r1 模型安装

1、Ollama 安装运行 deepseek-r1 模型

2、deepseek-r1 提供多个版本,参数量越大,模型的性能越强大,但也需要更多的存储和计算资源。

(1)1.5b 模型参数为15亿/1.1GB,

(2)7b 模型参数约为 70亿/4.7GB,

(3)14b 模型参数约为 140亿/9GB。

3、deepseek-r1 不同版本模型的执行命令不同:

(1)1.5b 的命令为:"ollama run deepseek-r1:1.5b"

(2)7b 的命令为:"ollama run deepseek-r1:7b"

(3)14b 的命令为:"ollama run deepseek-r1:14b"

推荐大家先下载较小的 1.5b 模型,把本教程的安装程序跑通,再根据自己的硬件配置和需求安装适当的版本。

(4)本教程选择选择 1.5b 模型,在命令行窗口运行安装命令:

ollama run deepseek-r1:1.5b,程序会自动下载和安装运行,如下图:

(5)下载安装deepseek-r1:1.5b的过程中,如下图:

(6)安装完成后显示 "success",表明安装成功,如下图:

(三)运行使用 deepseek-r1:1.5b 模型

1、在命令行窗口运行命令 "ollama run deepseek-r1:1.5b",就可以在提示行输入,与 deepseek-r1 进行聊天。

2、输入 "/?",可以获得帮助。

通过本地命令行窗口就可以使用基于ollama的模型 deepseek-r1:1.5b了,但这黑屏状态让人回到了 DOS 年代,交互体验感很差。接下来我们安装maxKB。

(四)更新升级ollama版本

1、查看当前运行的ollama版本,执行ollama --v命令查看版本,如下图:

2、升级ollama

(1)在任务栏当图标出现蓝色圆点时,说明有更新,出现的小对话框提示有活动的更新版本,版本号是0.6.5,如下图:

(2)点击图标,从弹出的菜单中执行restart to update项,开始重启ollama完成更新

(3)更新安装的过程,如下图:

3、查看升级后的版本

四、部署CentOS中安装maxKB

1、CentOS的安装本例不赘述,请参考:

https://blog.csdn.net/weixin_43075093/article/details/124055072

2、为提升CentOS的安全性,内核版本升级不赘述,请参考:

https://blog.csdn.net/weixin_43075093/article/details/139586013

3、maxKB安装包下载

打开飞致云开源社区 MaxKB 社区版下载链接:

https://community.fit2cloud.com/#/products/maxkb/information

页面下载最新版本安装包,并上传至部署服务器(本例以 v1.10.2版本为例说明安装部署过程)。

4、使用winscp工具将下载的maxKB-v1.10.2-lts-offline.tar.gz上传到CentOS8中的/home/maxKB下

(1)在CentOS8中查看当前服务器网卡的ip地址,如下图:

(2)在CentOS8中查看磁盘的使用状态,找一个磁盘容量稍大的挂载,本例可以看出是/home的空间容量大,如下图:

(3)使用winscp工具登录到CentOS8服务器中,设置,如下图

(4)因SFTP是安全连接,需要添加密钥,如下图:

(5)登录成功后,在CentOS的/home挂载下新建一个目录maxKB,再把左侧下载好的maxKB安装文件maxkb-v1.10.2-lts-offline.tar.gz,拖到右侧的CentOS路径 /home/maxKb中,完成上传,如下图:

(6)回到CentOS8服务器的命令窗口,通过cd命令和ll命令查看上传完成的maxKB安装压缩文件,如下图:

(7)在CentOS8服务器的命令窗口,解压maxkb-v1.10.2-lts-offline.tar.gz这个安装包,如下图:

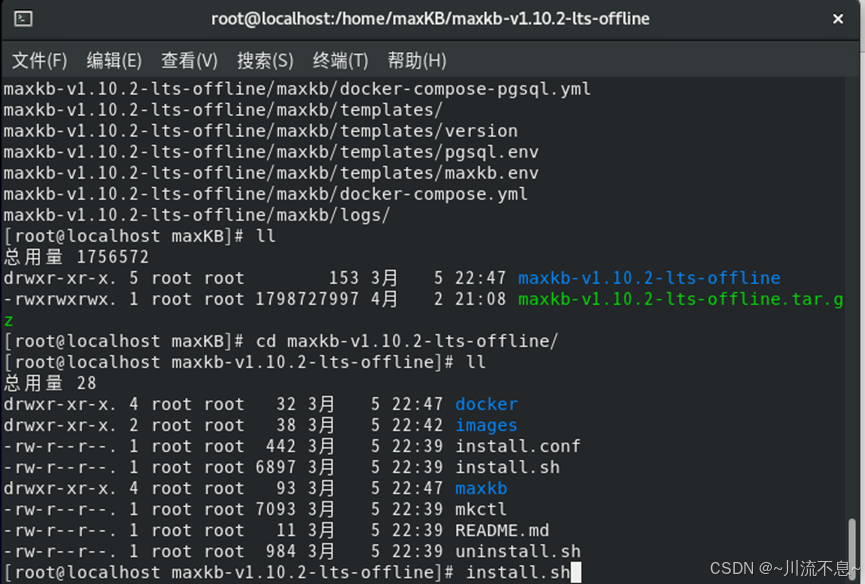

(8)解压完成后,查看,即生成了一个目录,通过cd命令将当前目录切换,再使用ll命令,可以看到解压后的文件,如下图:

(9)执行./install.sh命令开始安装maxKB,此时提示权限不够,所以我们使用chmod --R 777 *.*命令对解压后的文件含子目录中的文件赋予完全访问权限,如下图:

(10)再次执行命令./install.sh开始安装过程,正常,如下图:

(11)安装完成后,它会自动启动maxKb相关的服务,如下图:

(12)当服务成功启动后,会有安全完成的提示,并给出了访问的方式,http://localhost_ip:8080如下图:

五、登录并配置maxKB系统

1、查看并测试CentOS8的8080端口是否正常开启:

(1)在CentOS8的命令窗口执行firewall-cmd --list-ports命令,可以看出TCP协议的8080端口已经开启,如下图:

(2)回到win10客户端,通过cmd命令窗口执行命令telnet,测试与服务器之间的tcp/8080端口连接,执行命令如下图:

(3)若连接成功,窗口的左上角会有一光标闪烁,显示如下图:

2、在客户端打开浏览器,输入http://Centos服务器ip地址:8080端口号的格式,打开界面后,出现登录窗口,如下图

3、使用默认的官方管理用户登录,登录后修改密码,登录成功后的界面如下图:

用户名:admin

默认密码:MaxKB@123...

典型的 MaxKB 的操作流程一般可分为四步:添加模型、创建知识库、创建应用、发布应用。在高级编排应用中还可以通过函数库的功能,实现数据处理、逻辑判断、信息提取等功能,提供更加强大、灵活的能力。

4、创建应用(本例为把API key提前复制,应用到模型当中,所以顺序稍作了调整)

(1)给出应用的名称

(2)指定语言,本文指定为简体中文,如下图:

(3)创建应用完成后,如下图:

5、点开应用,概览,复制API Key

说明:看到我把ip地址部分涂红,证明这个maxKB是可用于公网的。

6、系统配置,模型设置,添加win10中安装的ollama模型deepseek-r1:1.5b,把API Key粘贴到这,如下图:

7、创建知识库,给出知识库的名称,概述、向量模型,如下图:

8、在应用中,关联创建的知识库,如下图:

9、上传知识库文件,如下图:

10、等待自动解析完成

11、点击打开应用后,点击演示,如下图:

12、点演示后,会出现新建的对话,在下方输入自己想咨询的问题,如下图:

六、使用部署好的Win10 + ollama的Deepseek + CentOS+ maxKB

1、采用模型优化回答

2、采用直接回答

从上面的2个相同问题,使用不同的ai知识模型时,回答的结果可以看出是不一样的,当然不同的企业或单位在应用时,为什么要建立企业的知识库,原因就在这里了。

综上所述,本例采用的Win10 + ollama的Deepseek + CentOS+ maxKB部署完成,虽然使用的是2套操作系统,运行的效果还是挺不错的。值得推荐!