千呼万唤,Qwen3 终于来了!

一口气上新 8 大模型,通通开源。

旗舰模型 Qwen3-235B-A22B 全方位超越 R1、o1、o3-mini,最大杯稠密模型也以 32B 参数量达到了可观水平。

小尺寸模型的表现也同样亮眼,Qwen3-4B 在数学、代码能力上 "以小博大",和比自身大 10 倍模型水平相当。

本系列一共包括 2 个 MoE 模型和 6 个稠密模型。

-

小 MoE 模型 Qwen3-30B-A3B

-

MoE 模型 Qwen3-235B-A22B

-

Qwen3-32B

-

Qwen3-14B

-

Qwen3-8B

-

Qwen3-4B

-

Qwen3-1.7B

-

Qwen3-0.6B

它们均在 Apache 2.0 许可下开源。

经过后训练的模型,例如 Qwen3-30B-A3B,以及它们的预训练基座模型(如 Qwen3-30B-A3B-Base),现已在 Hugging Face、ModelScope 和 Kaggle 等平台上开放使用。

对于部署,Qwen 团队推荐使用 SGLang 和 vLLM 等框架;而对于本地使用,则推荐 Ollama、LMStudio、MLX、llama.cpp 和 KTransformers 等。

网友:让开源再次伟大!

现在,在 Qwen Chat(网页版)和通义 APP 中均能试用 Qwen3。

值得一提的是,Qwen3 还增强了对 MCP 的支持,具备更强的与环境交互的能力。

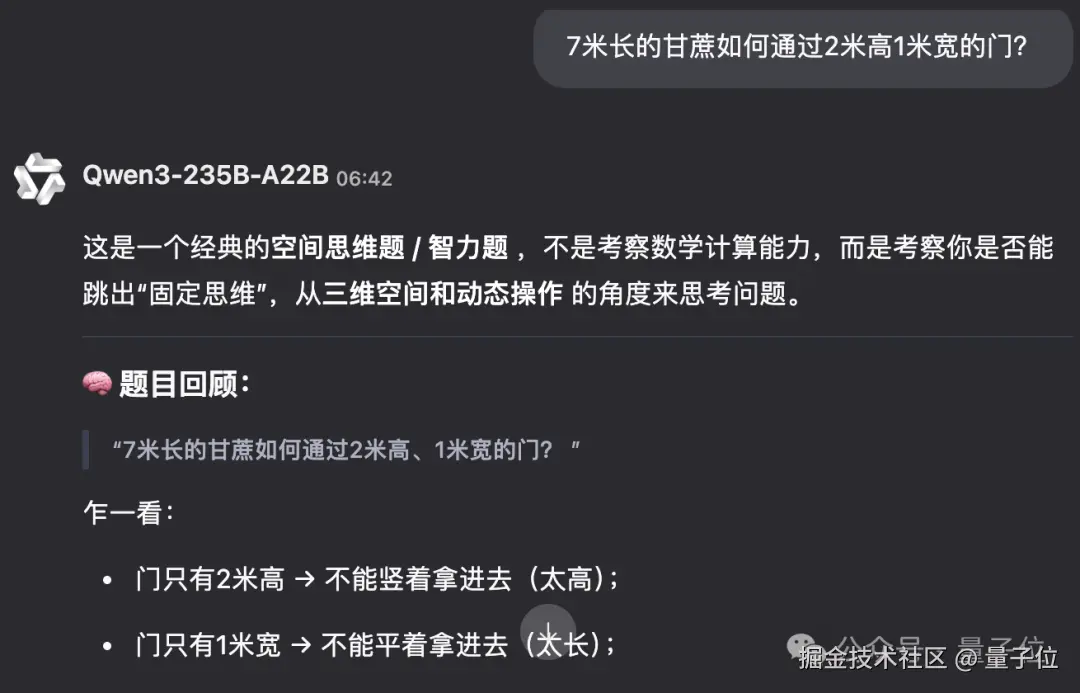

轻松破解 7 米甘蔗过 2 米门

Qwen3 系列的亮点包括代码、数学能力,并提出了思考 / 非思考模式切换,提供更具性价比的模型体验。

思考模式下,模型会逐步推理;非思考模式提供更快速、近乎即时的响应。

比如 "7 米长的甘蔗如何通过 2 米高 1 米宽的门?" 的问题,Qwen3-235B-A22B 知道可以通过倾斜一定角度让甘蔗过门。

非思考模式等待了 2 秒左右即开始作答,思考模式则消耗了 38912 个 token 进行逐步推理。

36 万亿 token 预训练

所以 Qwen3 如何而来?

首先在数据上,Qwen3 预训练使用的数据约是 Qwen2.5 的 2 倍,达到 36 万亿 token,涵盖 119 种语言和方言。

并使用 Qwen2.5 处理数据。用 Qwen2.5-VL 提取 PDF 中的文本,在用 Qwen2.5 改进质量。数学和代码方面,则利用 Qwen2.5-Math 和 Qwen2.5-Coder 来合成包括教科书、问答对以及代码片段等多种形式的数据。

其次在预训练方面,共分为 3 个阶段。

在第一阶段(S1),模型在超过 30 万亿个 token 上进行了预训练,上下文长度为 4Ktoken。这一阶段为模型提供了基本的语言技能和通用知识。

在第二阶段(S2),通过增加知识密集型数据(如 STEM、编程和推理任务)的比例来改进数据集,随后模型又在额外的 5 万亿个 token 上进行了预训练。

在最后阶段,使用高质量的长上下文数据将上下文长度扩展到 32K token,确保模型能够有效地处理更长的输入。

由于模型架构的改进、训练数据的增加以及更有效的训练方法,Qwen3 Dense 基础模型的整体性能与参数更多的 Qwen2.5 基础模型相当。

例如,Qwen3-1.7B/4B/8B/14B/32B-Base 分别与 Qwen2.5-3B/7B/14B/32B/72B-Base 表现相当。特别是在 STEM、编码和推理等领域,Qwen3 Dense 基础模型的表现甚至超过了更大规模的 Qwen2.5 模型。

对于 Qwen3 MoE 基础模型,它们在仅使用 10% 激活参数的情况下达到了与 Qwen2.5 Dense 基础模型相似的性能。这带来了训练和推理成本的显著节省。

最后在后训练方面。共分为 4 个阶段:

(1)长思维链冷启动

(2)长思维链强化学习

(3)思维模式融合

(4)通用强化学习

第一阶段使用长思维链数据对模型进行微调,涵盖了数学、代码、逻辑推理和 STEM 问题等多种任务和领域,增强模型基本推理能力。

第二阶段进行大规模强化学习,利用基于规则的奖励来增强模型的探索和钻研能力。

第三阶段在一份包括长思维链数据和常用的指令微调数据的组合数据上对模型进行微调,将非思考模式整合到思考模型中。

第四阶段则在包括指令遵循、格式遵循和 Agent 能力等在内的 20 多个通用领域的任务上应用了强化学习,以进一步增强模型的通用能力并纠正不良行为。

在博客中,Qwen 团队表示,Qwen3 的发布和开源将极大地推动大型基础模型的研究与开发。

我们的目标是为全球的研究人员、开发者和组织赋能,帮助他们利用这些前沿模型构建创新解决方案。

更多细节可查看:

1\]Blog: [qwenlm.github.io/blog/qwen3/...](https://link.juejin.cn?target=https%3A%2F%2Fqwenlm.github.io%2Fblog%2Fqwen3%2F%25C2%25A0 "https://qwenlm.github.io/blog/qwen3/%C2%A0") \[2\]GitHub: [github.com/QwenLM/Qwen...](https://link.juejin.cn?target=https%3A%2F%2Fgithub.com%2FQwenLM%2FQwen3%25C2%25A0 "https://github.com/QwenLM/Qwen3%C2%A0") \[3\]Hugging Face: [huggingface.co/collections...](https://link.juejin.cn?target=https%3A%2F%2Fhuggingface.co%2Fcollections%2FQwen%2Fqwen3-67dd247413f0e2e4f653967f%25C2%25A0 "https://huggingface.co/collections/Qwen/qwen3-67dd247413f0e2e4f653967f%C2%A0") \[4\]ModelScope: [modelscope.cn/collections...](https://link.juejin.cn?target=https%3A%2F%2Fmodelscope.cn%2Fcollections%2FQwen3-9743180bdc6b48 "https://modelscope.cn/collections/Qwen3-9743180bdc6b48") 体验方式:点击下方链接或打开通义 APP [chat.qwen.ai/](https://link.juejin.cn?target=https%3A%2F%2Fchat.qwen.ai%2F "https://chat.qwen.ai/") **欢迎在评论区留下你的想法!** --- **完** ---