本文系统介绍 RNN 结构的常见扩展与改进方案。涵盖 简单循环神经网络(SRN)、双向循环神经网络(BRNN)、深度循环神经网络(Deep RNN) 等多种变体,解析其核心架构、技术特点及应用场景,展现 RNN 在处理序列数据时的灵活性与适应性,为相关领域研究与应用提供技术参考。

关键词 :

循环神经网络 RNN 变体 双向循环网络 深度循环网络 回声状态网络 时钟频率驱动网络 时间间隔网络

一、简单循环神经网络(SRN)

简单循环神经网络(Simple Recurrent Network, SRN) 是 RNN 的基础扩展结构,其网络架构如图 1 所示。SRN 在传统三层神经网络的隐含层中引入上下文单元,通过固定连接权重实现对序列历史信息的记忆。

核心特点:

- 上下文单元机制:隐含层的上下文单元(图中 u 节点)负责存储上一时刻隐含层的输出,使当前时刻隐含层输入同时包含输入层信息与历史状态信息。

- 固定连接权重:上下文单元与隐含层节点的连接权重固定,简化网络训练复杂度的同时,保留序列数据的时序依赖关系。

- 序列预测能力 :通过前向反馈传播与学习算法,SRN 能够处理标准多层感知机(MLP)难以解决的序列预测问题,如时间序列趋势分析。

二、双向循环神经网络(BRNN)

双向循环神经网络(Bidirectional RNN, BRNN) 通过叠加两层方向相反的 RNN,使模型能够同时捕捉序列数据的前后文信息,其结构如图 2 所示。

技术优势:

- 双向信息融合 :前向 RNN 处理序列正向信息,后向 RNN 处理反向信息,当前时刻输出由双向隐含层状态共同决定。例如在语句缺失词语预测任务中,BRNN 可利用前后文语义关联提升预测准确性。

- 上下文敏感特性:适用于需要全局语义理解的场景,如自然语言处理中的情感分析、命名实体识别等。

三、深度循环神经网络(Deep RNN)

深度循环神经网络(Deep RNN) 通过多层 RNN 模块的垂直堆叠,构建具有更强表达能力的深度序列模型,结构如图 3 所示。

架构特点:

- 多层特征提取 :每一层 RNN 模块对序列数据进行不同层次的特征抽象,底层模块捕捉局部时序模式,高层模块学习全局语义特征。

- 训练复杂度与数据需求:深度结构提升模型学习能力的同时,也增加了参数规模与训练难度,需依赖大规模标注数据支撑。

- 应用场景:适用于复杂序列数据建模,如长文本生成、视频动作识别等。

四、回声状态网络(ESN)

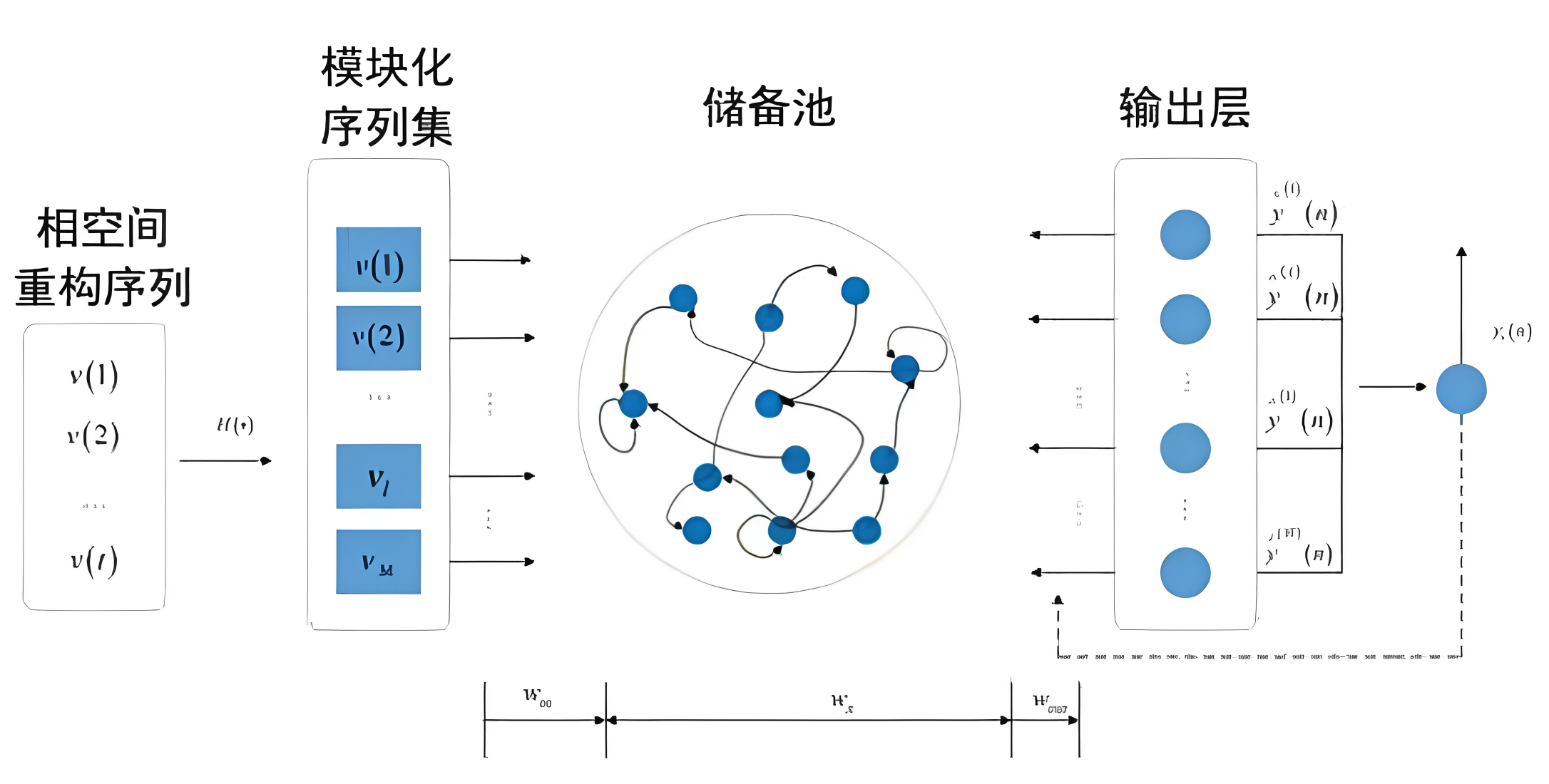

回声状态网络(Echo State Network, ESN) 是一种基于储备池计算的新型 RNN 变体,其核心思想是通过随机生成的稀疏循环网络(储备池)实现对序列数据的动态映射。

关键技术:

- 储备池结构:由大规模随机稀疏连接的神经元构成(稀疏程度通常为 1%~5%),无需训练即可保持固定连接权重。

- 输出层训练简化:仅需调整储备池到输出层的权重矩阵,通过简单线性回归即可完成网络训练,大幅降低计算成本。

- 参数体系:包括储备池内部连接权重矩阵 (W)、输入层到储备池权重矩阵 (w_{in})、输出层反馈权重矩阵 (W_{back}) 等,各矩阵协同作用实现序列信息的高效处理。

结构示意图 :如图 4 所示,ESN 通过模块化设计实现序列数据的相空间重构,适用于时间序列预测、混沌系统建模等领域。

五、时钟频率驱动 RNN(CW - RNN)

时钟频率驱动 RNN(Clockwork RNN, CW - RNN) 通过引入时钟周期机制,将隐含层划分为不同频率的模块组,实现对长时依赖问题的有效建模。

工作原理:

- 分层时钟机制:隐含层神经元分组后,每组分配唯一时钟周期 (T_g),周期较大的模块组处理低频信息(如长期依赖关系),周期较小的模块组处理高频信息(如短期时序变化)。

- 有向连接约束:仅允许周期较大的模块组连接到周期较小的模块组,避免高频信息对低频处理的干扰,如图 5 所示。

- 训练效率优化 :由于各组神经元无需在每一步同时工作,CW - RNN 可显著减少计算量,加速网络训练进程。

参数配置示例:若隐含层包含 256 个节点,分为 4 组且周期分别为 [1,2,4,8],则每组包含 64 个节点,组间连接矩阵维度随周期差异递增,如第 4 组(周期 8)到第 1 组(周期 1)的连接矩阵为 64×256。

六、包含时间间隔的 RNN

在医疗数据、推荐系统等场景中,序列数据的时间间隔信息对建模至关重要。为此,研究者提出多种包含时间间隔的 RNN 变体,以下为典型案例:

(一)Time - LSTM

Time - LSTM 通过扩展 LSTM 结构,引入与时间间隔相关的门控机制,如图 6 所示。在推荐系统中,用户行为的时间间隔可通过三种时间门方式建模:

- Time - LSTM1:将时间间隔作为输入门的额外输入,调节新信息的写入强度。

- Time - LSTM2:通过时间间隔门控制遗忘门的输出,实现对历史信息的动态遗忘。

- Time - LSTM3:结合时间间隔与输出门,优化隐含层状态的输出决策。

(二)医疗图像时间间隔 LSTM

在医疗图像分析中,患者多次检查的时间间隔对临床诊断具有重要价值。该变体直接将时间间隔作为输入特征融入 LSTM 细胞状态更新过程,如图 7 所示,避免引入额外门控结构的同时,保留时间间隔的连续信息。

总结与展望

RNN 结构的扩展与改进始终围绕序列数据的时序依赖建模展开。从 SRN 的上下文记忆到 BRNN 的双向信息融合,从 Deep RNN 的深度特征学习到 ESN 的储备池计算,再到 CW - RNN 的时钟驱动机制与时间间隔 RNN 的场景适配,每种变体均针对特定问题提供了创新解决方案。