一、前言

2025 年的 GTC 大会上,理想汽车的分享了其最新一代的辅助驾驶方案MindVLA(视觉-语言-动作端到端大模型)的相关技术方案,此模型结合了 V-Spatial Intelligen、L--Linguistic Intelligence、A-Action Policy 这 3 种先进技术,包含了当时国际上最先进的模型和概念,比如 LLM、VLM、VLA、Diffusion model、Reinforcement Learning 等等。

本帖将结合演讲内容和相关学术论文,对理想汽车的智驾方案演进路线进行介绍。

二、端到端+VLM 方案

众所周知,中国的道路因素复杂得令人发指,懂得都懂,且行业标杆 Tesla 也处理不好这种场景这里就不一一罗列了。因此,大模型技术应该是目前可以解决这种复杂场景最好的办法,理想汽车根据自己的理解提出了端到端+VLM 方案。

2.1 快慢思考系统

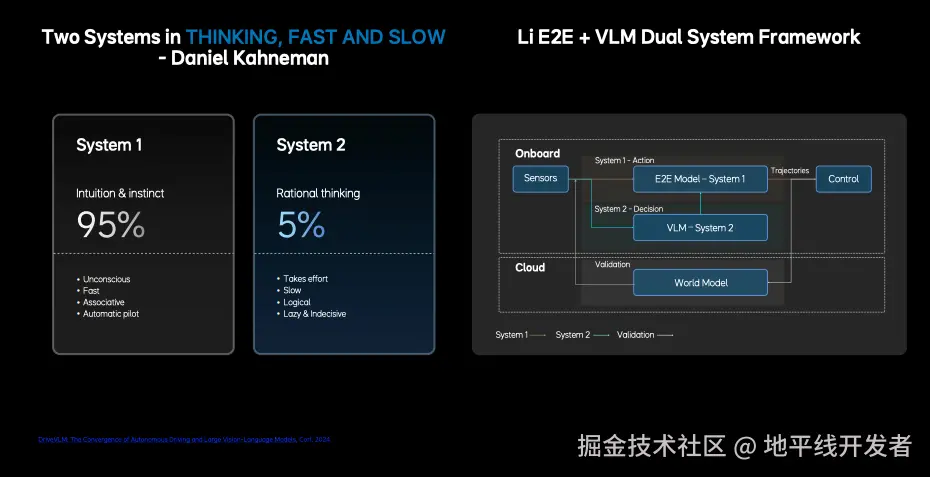

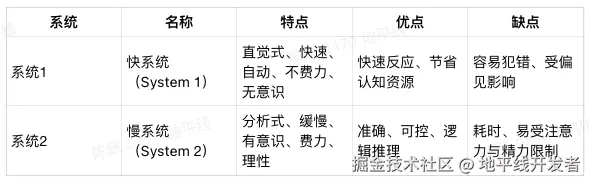

理想的端到端+VLM 方案充分借鉴了心理学家丹尼尔·卡尼曼(Daniel Kahneman)提出的快慢思考系统,其核心看法是人类的思维系统由快-慢两个系统组成,详细的介绍如下表所示:

那么在快慢思考系统思想的启发下,理想汽车的端到端+VLM 设计方案可以总结为:

system1-action: 快系统,部署 E2E 端到端模型系统在一颗 ORIN X 芯片上,只需要输入传感器数据,不需要高精地图等先验知识,端到端模型会根据车载传感器数据直接输出轨迹信息,模型完全由数据进行驱动。

system2-decision: 慢系统,部署 VLM 大模型在另一颗 ORIN X 芯片上,VLM 为具有 22 亿参数量的 LLM 基座模型,具备全局理解与推理能力,实现多模态数据理解和逻辑推理,VLM 通过思维链 CoT 做复杂的逻辑分析,并将结果反馈给智驾决策快系统。

2.2 端到端+VLM 方案介绍

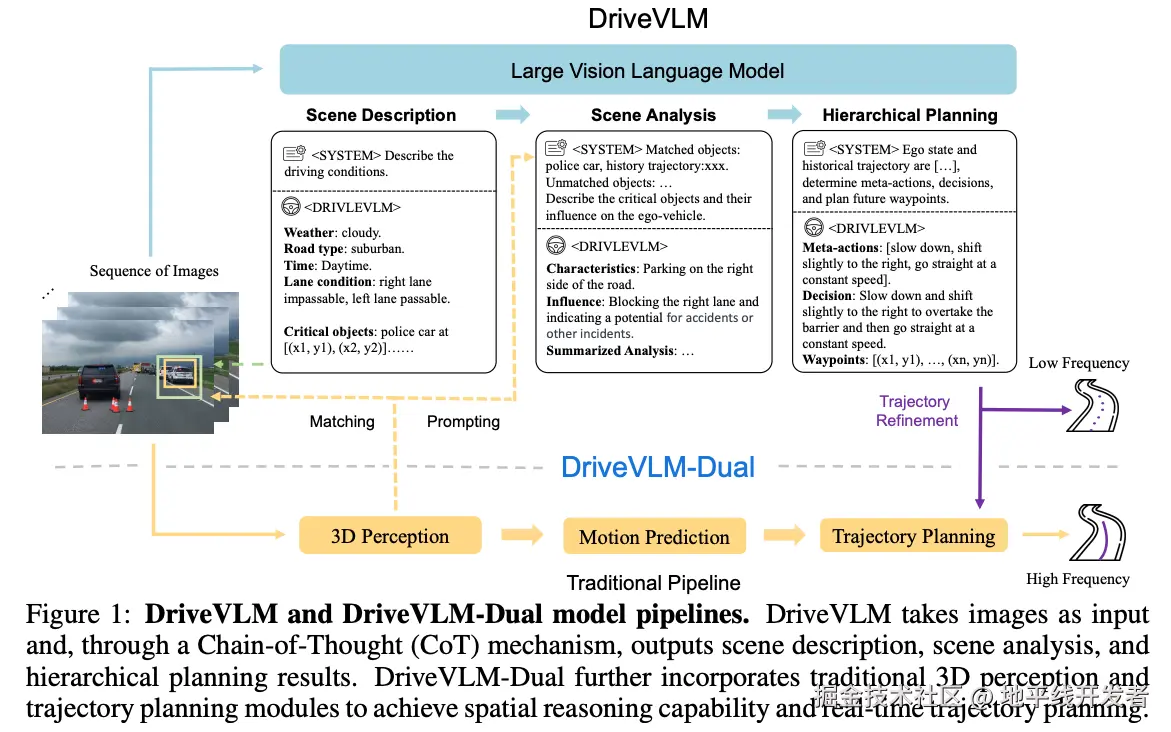

DriveVLM 基于 大型视觉语言模型(VLM)设计,通过图像输入 → 链式推理(Chain-of-Thought, CoT)→ 输出驾驶计划的过程; DriveVLM-Dual 将 DriveVLM 生成的结果与传统自动驾驶 pipeline(感知、预测、规划)融合,提升精度与实时性。

2.2.1 DriveVLM

DriveVLM 输出 Scene Description(场景描述)、Scene Analysis(场景分析)和 Hierarchical Planning(层级规划),这 3 个部分的作用分别是:

Scene Description(场景描述)

任务:语言描述当前驾驶环境。

示例输出:

Weather: cloudy

Road type: suburban

Time: daytime

Lane condition: right lane impassable, left lane passable

Critical objects: e.g., police car at bounding box

Scene Analysis(场景分析)

任务:分析关键目标对自车的影响。

示例输出:

Characteristics: "police car 停在右侧"

Influence: "阻挡右车道,存在事故风险"

Hierarchical Planning(层级规划)

任务:生成具体驾驶计划,逐步输出:

Meta-actions(元动作):如减速、右偏等操作单元

Decision:对元动作的组合解释

Waypoints:一系列(x, y)点构成的未来轨迹

这些输出频率较低,因推理复杂,称为"Low Frequency"。

2.2.2 DriveVLM-Dual

DriveVLM-Dual 将 DriveVLM 结果作为提示或指导,结合传统的三维感知、运动预测、轨迹规划模块,这 3 个模块的作用分别是:

3D Perception:将图像中识别的关键目标,与 3D 检测器匹配,提升空间定位精度。

Motion Prediction:传统模块预测周围目标未来动作。

Trajectory Planning:结合 VLM 给出的参考轨迹(如 Waypoints),进行高频实时细化。

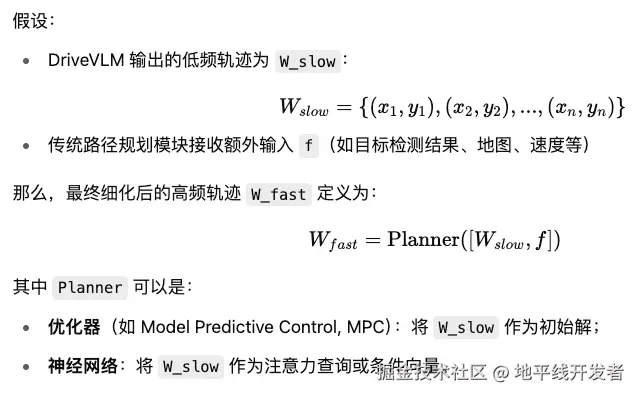

2.2.3 Trajectory Refinement

视觉语言模型(VLM)虽然擅长理解复杂场景,但存在两大弱点:

推理慢:不能实时运行(比如每秒几次);

空间精度不高:输出轨迹点是基于语言生成的,易产生偏差。

而传统路径规划模块(如基于优化或神经网络)虽然推理快,但缺乏全局语义理解能力。因此,需要一种"慢→快"的协同机制来连接两者,Trajectory Refinement 就是这个桥梁。

Trajectory Refinement 是 DriveVLM-Dual 系统中的一个关键环节,用于提升路径规划的精度与实时性,其本质是使用 DriveVLM(慢系统)输出的粗略轨迹作为参考,引导传统自动驾驶模块(快系统)进行高频率、实时的精细轨迹生成。

Trajectory Refinement 的流程可以用以下公式描述:

2.3 端到端+VLM 在量产中的不足

虽然 DriveVLM-Dual 系统解决了部分问题,但是在实际量产中发现了诸多不足,如下所示:

虽然可以通过 异步联合训练让端到端和 VLM 协同工作,但是由于他们是两个独立的模型且运行频率不同,所以在做联合训练和优化是非常困难的;

其次,VLM 模型是基于开源的 LLM 大语言模型,使用了海量的互联网二级图文数据做预训练,导致其在 3D 空间理解和驾驶知识方面是有所不足。尽管可以通过一些后训练手段进行弥补,但是它的上限仍然不是很高;

自动驾驶芯片如 Orin-X 和 Thor-U 的内存带宽和算力是不及 GPU 服务器的,如何进一步提升模型的参数量和能力,同时还能实现在高效的推理,这是个巨大的挑战;

目前驾驶行为的学习更多依赖于 transformer 进行回归建模,但是这种方法难以处理人类驾驶行为的多模态性,这里的多模态性是指在相同的场景下,不同人的选择是不同的,同样一个人在不同精神状态下的驾驶行为也是不同的。