强化学习在软件工程中的全景扫描:从应用到未来

A Survey of Reinforcement Learning for Software Engineering

arXiv:2507.12483

A Survey of Reinforcement Learning for Software Engineering

Dong Wang, Hanmo You, Lingwei Zhu, Kaiwei Lin, Zheng Chen, Chen Yang, Junji Yu, Zan Wang, Junjie Chen

Subjects: Software Engineering (cs.SE)

一段话总结:

这是首篇系统综述强化学习(RL)在软件工程(SE)中应用 的研究,分析了2015年(深度强化学习出现)至2025年5月发表在22个顶级SE期刊和会议上的115篇论文。综述涵盖RL在软件开发生命周期各阶段(设计、开发、质量保证、维护等)的应用,分类了SE任务(生成任务占74%)和RL算法(以模型无关的价值基方法为主,占52%),探讨了数据集使用、模型设计与评估等关键因素,指出当前研究存在过度集中于软件质量保证(72%)、实证验证不足等挑战,并提出未来研究方向(如结合大语言模型、扩展应用范围等)。

研究背景:当"智能决策者"遇上复杂软件系统

想象一下,你是一位软件工程师,每天要面对成百上千行代码的调试、无数测试用例的设计,还要在系统出问题时快速定位bug------这些工作就像在一个不断变化的迷宫里找出口,既耗时间又容易出错。而强化学习(RL),这个能让AI在游戏中打败人类、让机器人自主导航的"智能决策者",似乎天生适合解决这类需要不断试错、优化决策的问题。

2015年,DeepMind将深度学习与强化学习结合,开发出能玩Atari游戏的Deep Q-Network(DQN),让强化学习进入"深度强化学习"时代。从那以后,RL开始在机器人、自动驾驶等领域大放异彩。与此同时,软件工程领域也在呼唤更智能的自动化工具:软件系统越来越复杂,传统的人工或简单算法已经难以应对设计、测试、维护等全生命周期的挑战。

比如,在测试环节,如何自动生成能发现更多bug的测试用例?在代码开发时,如何让AI更智能地补全代码?在系统维护时,如何快速定位并修复bug?这些问题都需要像RL这样能通过"试错-学习-优化"不断进步的技术来解决。

但一直以来,RL在软件工程中的应用就像散落的珍珠------研究者们做了很多尝试,却没有一篇系统的综述把这些成果串起来。之前的综述要么只关注机器学习在软件工程的泛化应用,要么只盯着软件测试这一个小领域,没人全面梳理过RL在软件工程全生命周期的应用。这就导致研究者和实践者想入门时,得在海量文献里"大海捞针"。于是,这篇论文的作者们决定做一次"全景扫描",填补这个空白。

主要作者及单位信息

本文由来自中、日多所高校的研究者合作完成,核心团队包括:

- 王东(天津大学智能与计算学部)

- 游瀚墨(天津大学智能与计算学部,共同一作)

- 朱凌玮(东京大学)

- 林楷威(天津大学智能与计算学部)

- 陈铮(大阪大学SANKEN研究所)

- 杨晨、于俊吉、王赞、陈俊杰(均来自天津大学智能与计算学部,其中陈俊杰为通讯作者)

创新点:这篇综述"新"在哪里?

作为首篇系统研究强化学习在软件工程中应用的综述,它的独特之处体现在三个方面:

- 全面性:首次覆盖软件工程全生命周期(从设计、开发到质量保证、维护),而不是局限于某个子领域(比如之前的综述多聚焦测试)。

- 时效性:分析了2015年(深度强化学习诞生)至2025年5月的最新研究,包含115篇顶级会议和期刊论文,捕捉到了2022年后的爆发式增长趋势。

- 深度:不仅分类了应用场景,还深入分析了RL算法选择、数据集使用、模型设计与评估等关键细节,甚至指出了当前研究的"短板"(如41%的研究不可复现)。

研究方法:如何完成这场"全景扫描"?

作者们用"系统化文献综述"的方法,分四步完成了这项工作,就像给RL在软件工程的应用"拍CT":

- 确定研究问题:提出5个核心问题,比如"RL在软件工程中有哪些应用趋势?""常用的RL算法有哪些?""当前面临什么挑战?",确保分析有明确方向。

- 筛选高质量论文:从22个顶级软件工程venue(12个会议如ICSE、ASE,10个期刊如TSE、TOSEM)中,用关键词("reinforcement""Q-learning"等)筛选出169篇论文,再经严格审核(如排除非英文、篇幅不足8页的),最终保留115篇。

- 提取关键信息:对每篇论文,提取发表时间、应用场景、使用的RL算法、数据集来源、评估方法等信息,就像给每篇论文"贴标签"。

- 分析与总结:对提取的信息分类统计,比如统计不同软件工程任务中RL的应用占比、不同RL算法的使用频率,最后归纳出趋势、挑战和未来方向。

主要贡献:这篇综述到底有什么用?

它就像一本"RL+软件工程"的"百科全书",给研究者和实践者提供了三大核心价值:

- 摸清现状:让读者快速知道RL在软件工程中"哪里火、哪里冷"------比如72%的研究集中在软件质量保证(尤其是测试生成),而需求工程、项目管理几乎没人碰;中国研究者贡献了41%的论文,是这个领域的主力。

- 指明工具:清晰列出不同软件工程任务适合用什么RL算法------比如测试生成常用Q-learning和DQN,代码生成可尝试PPO和actor-critic方法。

- 点亮前路:指出当前研究的"坑"(如过度依赖基础RL算法、数据集中工业数据仅占7.8%)和"机会"(如结合大语言模型、扩展到需求工程),帮后来者少走弯路。

总结:一篇综述,打通"RL"与"软件工程"的任督二脉

这篇论文是首篇全面系统梳理强化学习(RL)在软件工程(SE)中应用的综述,通过分析2015-2025年的115篇顶级论文,回答了五个核心问题:

- RL在SE中的应用呈爆发式增长,2022年后发表的论文占74%;

- 应用集中在软件质量保证(72%),尤其是测试生成,生成类任务占比最高(74%);

- 最常用的RL算法是价值基方法(如Q-learning、DQN),但actor-critic等高级算法近年增长明显;

- 研究依赖构造和开源数据集,可复现性差(41%不可复现),评估侧重效果忽视效率;

- 当前面临实证不足、应用范围窄等挑战,未来可结合大语言模型、扩展SE全生命周期应用。

它的核心成果是:首次绘制了RL在SE中的"应用地图",为研究者提供了清晰的研究脉络,为实践者提供了算法选择指南,推动这个领域从"零散探索"走向"系统发展"。

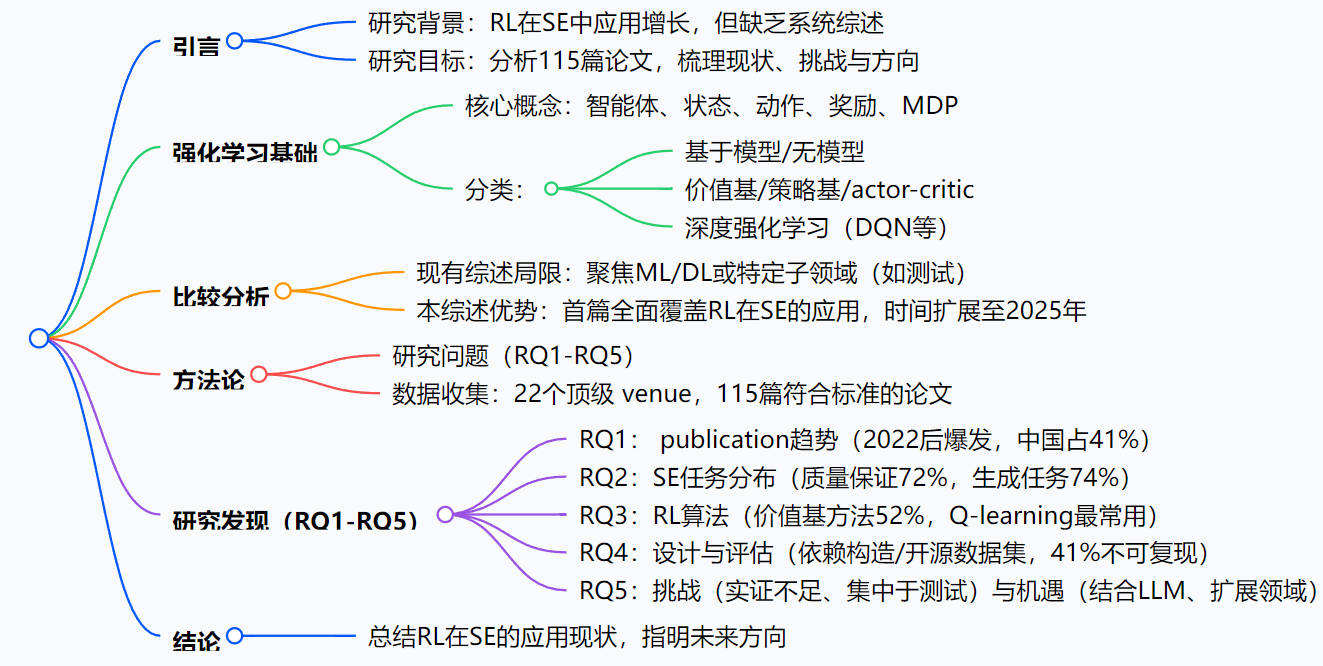

思维导图:

详细总结:

1. 研究背景与目标

- 强化学习(RL),尤其是深度强化学习(DRL)自2015年以来在多个领域快速发展,同时大语言模型(LLMs)与RL的结合进一步推动了智能系统发展。

- 软件工程(SE)中,系统复杂性和自动化需求促使研究者将RL应用于设计、开发、质量保证等多个任务,但缺乏全面系统的综述。

- 本研究为首篇系统综述,目标是通过分析2015年至2025年5月的115篇同行评审论文,梳理RL在SE中的应用现状、挑战及未来方向。

2. 研究方法

- 数据来源:选取22个顶级SE venue(12个会议、10个期刊),通过关键词搜索("reinforcement""Q-learning"等)收集论文,经筛选后保留115篇。

- 研究问题:围绕5个核心问题(RQ1-RQ5)展开,涵盖 publication趋势、SE任务类型、RL算法应用、模型设计与评估、挑战与机遇。

3. 关键发现

| 研究问题 | 核心发现 | 关键数据 |

|---|---|---|

| RQ1:RL-for-SE研究趋势 | 论文数量呈上升趋势,2022年后爆发;会议为主要发表渠道;中国贡献41% | 2024年达33篇;85篇(74%)发表于2022年后;中国47篇,美国16篇 |

| RQ2:SE任务分布 | 集中于软件质量保证(72%),尤其是测试生成(49篇);生成任务占74% | 质量保证83篇,开发13篇,维护12篇;生成任务85篇,排名21篇 |

| RQ3:RL算法应用 | 以模型无关的价值基方法为主(52%),Q-learning(27篇)和DQN(22篇)最常用;actor-critic方法近年增长 | 价值基60篇,策略基32篇,actor-critic34篇;PPO(17篇)、A2C(11篇)为重要算法 |

| RQ4:设计与评估 | 依赖构造(39.1%)和开源(36.5%)数据集;41%的研究不可复现;评估侧重有效性(49%),忽视效率 | 工业数据集仅占7.8%;期刊论文46%不可复现 |

| RQ5:挑战与机遇 | 挑战:实证比较缺乏、集中于测试生成、算法滞后;机遇:结合LLM、扩展SE领域、统一基准 | 88%研究为新技术,仅8篇实证研究;10篇探索RL与LLM结合 |

4. 挑战与未来方向

- 挑战:实证验证不足、过度集中于软件质量保证(尤其是测试)、依赖基础RL算法、数据与可复现性瓶颈。

- 机遇:加强实证基准与人类中心设计、扩展RL在SE全生命周期的应用、结合LLM与RL、构建统一开源数据与评估基准。

关键问题:

-

问题 :本综述与现有相关综述相比,独特性体现在哪些方面?

答案:现有综述多聚焦于机器学习/深度学习在SE的应用,或仅局限于软件测试子领域;本综述是首篇全面覆盖RL在整个SE领域的系统研究,时间范围扩展至2025年,涵盖115篇论文,分析了RL在SE全生命周期的应用,并深入探讨了算法、数据集、评估等关键因素,填补了现有研究空白。 -

问题 :强化学习在软件工程中最主要的应用领域和任务类型是什么?

答案:最主要的应用领域是软件质量保证(占72%),其中测试生成是核心任务(49篇论文);从任务类型看,生成任务占比最高(74%),包括测试用例生成、代码补全、注释生成等,反映出RL在自动生成软件制品方面的优势。 -

问题 :当前强化学习在软件工程应用中面临的主要挑战是什么,有哪些潜在的解决方向?

答案:主要挑战包括:实证比较与用户验证不足、研究过度集中于测试生成、依赖基础RL算法、数据与可复现性瓶颈。潜在解决方向包括:加强实证基准与人类中心设计、扩展RL在SE全生命周期的应用(如需求工程、管理)、结合LLM与RL(如RLHF)、构建统一的开源数据与评估基准。