在 Spring AI Alibaba 程序中,我们可以直接使用本地程序调用百炼平台的云知识库,实现知识库文档解析、分块、向量化存储等一条龙服务。

这样,开发者就不用本地部署搭建向量数据库、不用进行复杂的文档处理,以及开发文档管理等业务功能了,可以大大提升开发效率,非常哇塞。

那问题来了,如何对接百炼平台的云知识库呢?

本文我们基于最新版正式版 Spring AI Alibaba 和百炼平台带着大家一起操作一下。

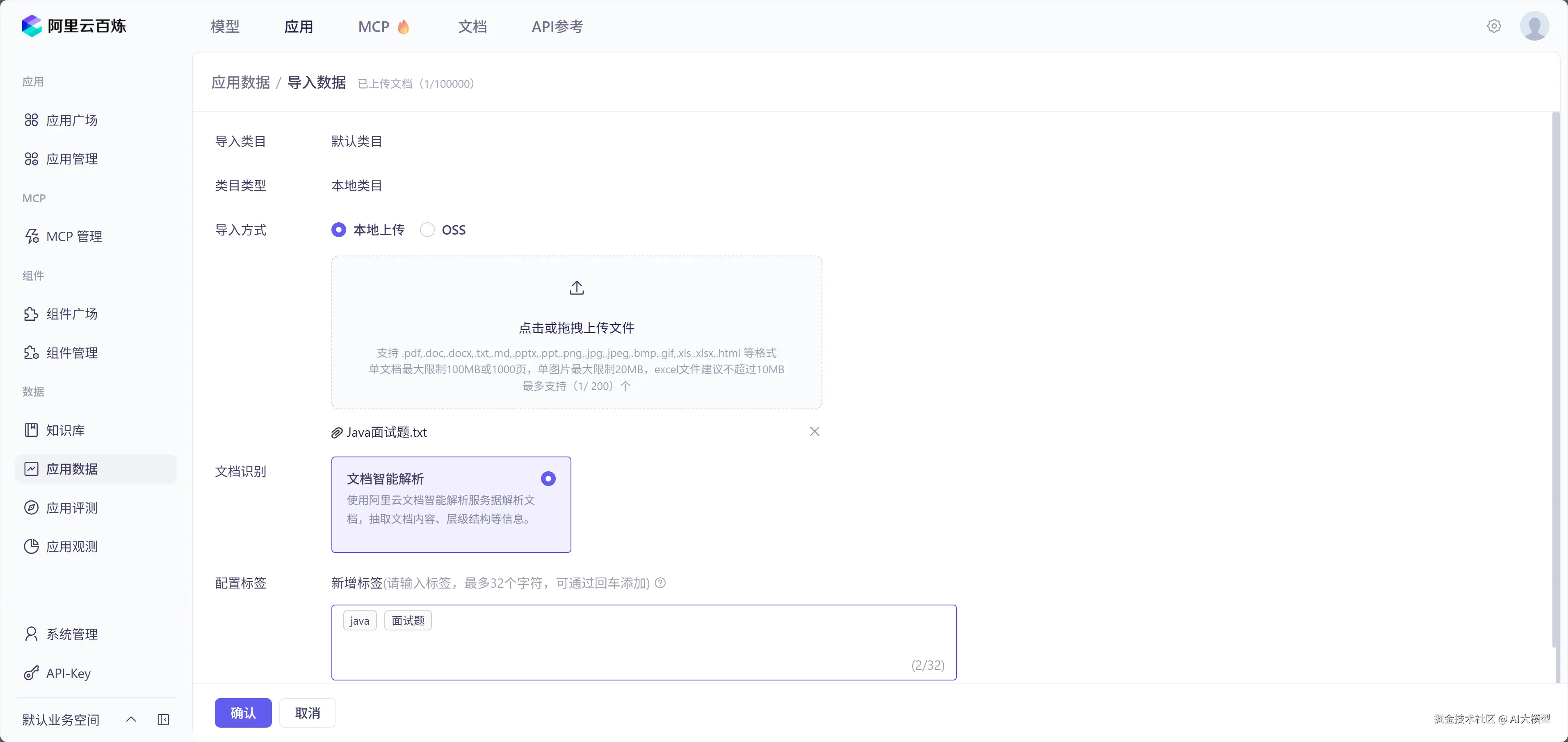

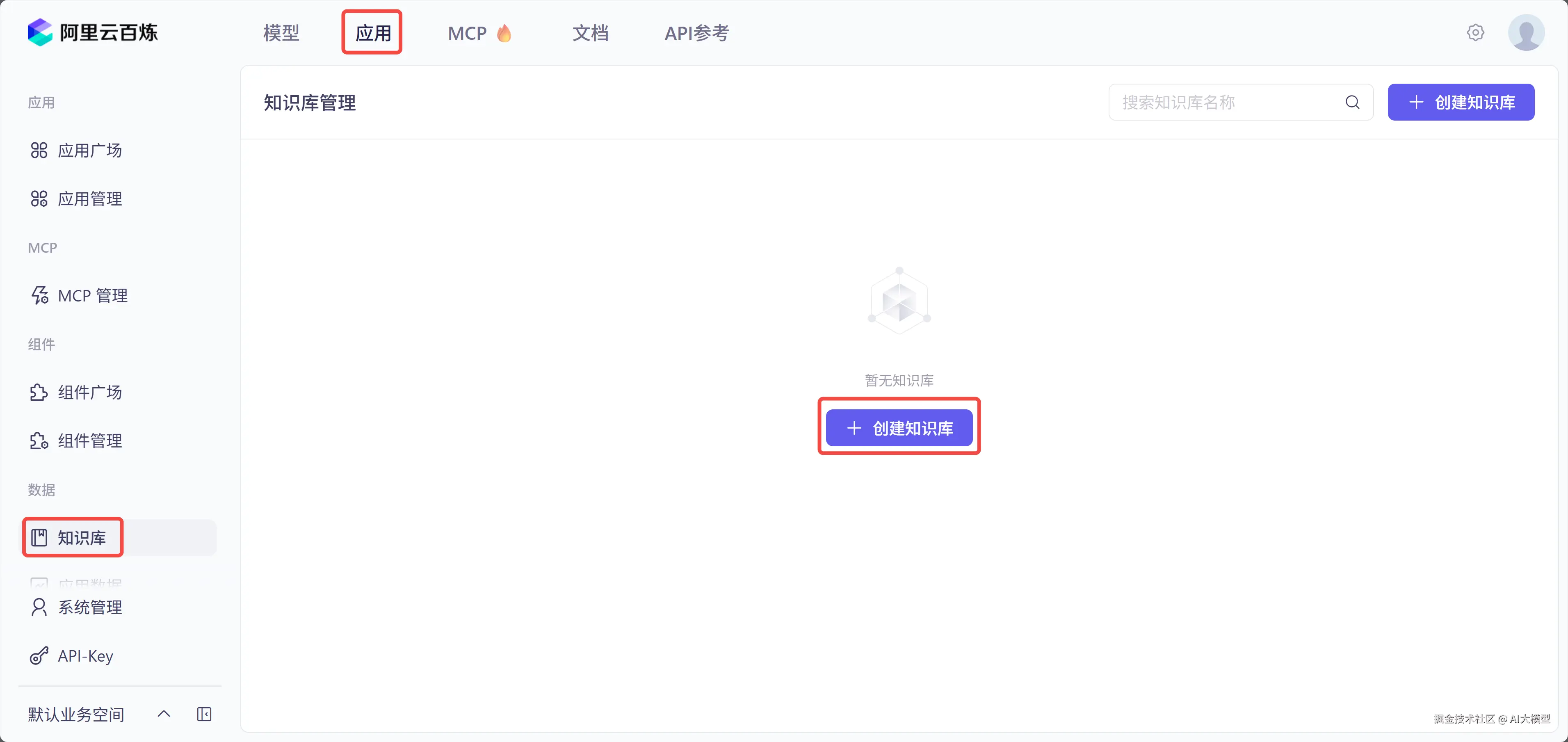

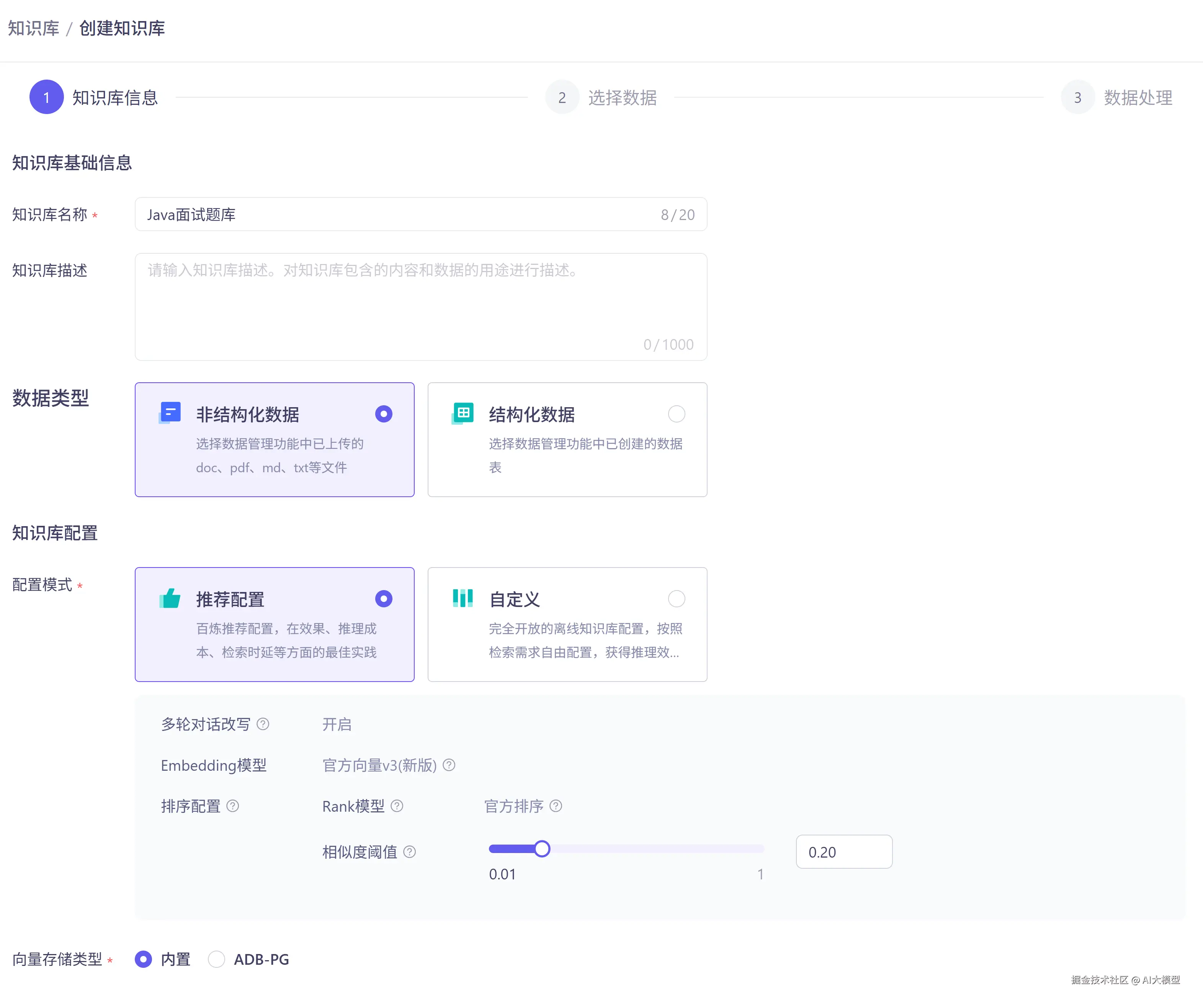

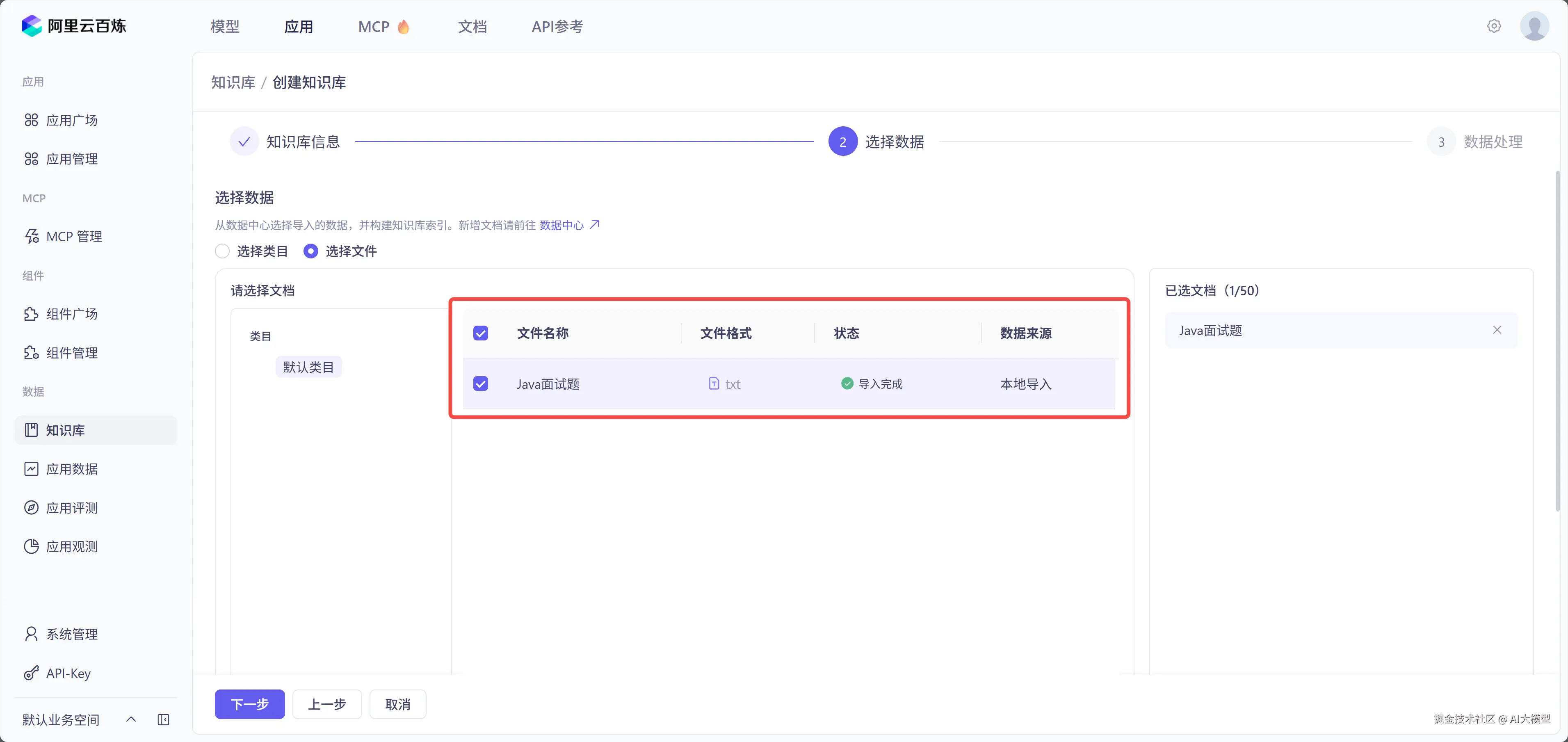

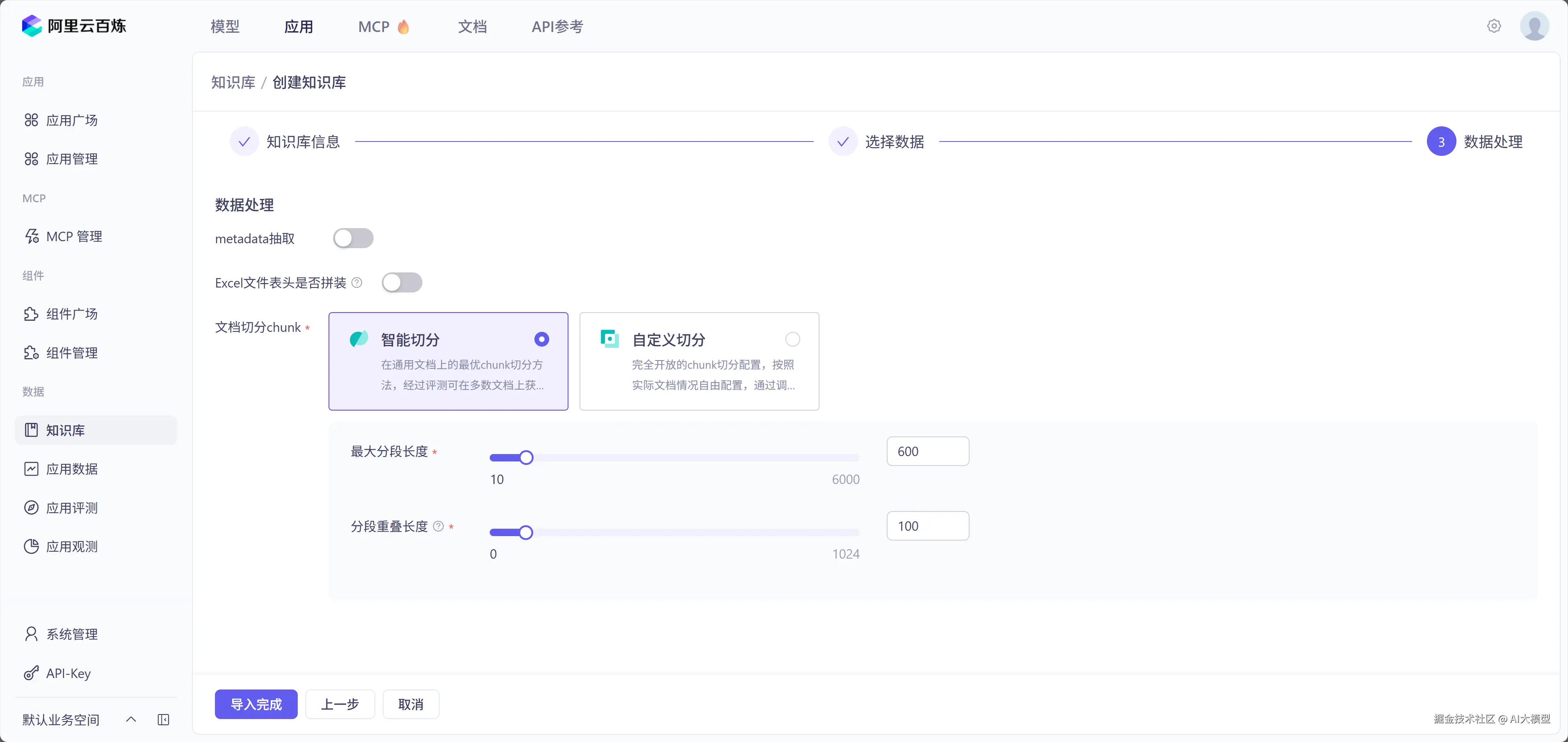

1.百炼添加数据和知识库

2.编写代码调用云知识库

编写代码操作云知识库

less

@RequestMapping("/rag")

public Flux<String> rag(@RequestParam String msg) {

DocumentRetriever retriever = new DashScopeDocumentRetriever(dashScopeApi,

DashScopeDocumentRetrieverOptions.builder().withIndexName(indexName).build());

return chatClient.prompt()

.system("你是一个Java助手,基于知识库的内容进行回答,知识库查询不到的信息,返回暂无信息")

.user(msg)

.advisors(new DocumentRetrievalAdvisor(retriever))

.stream().content();

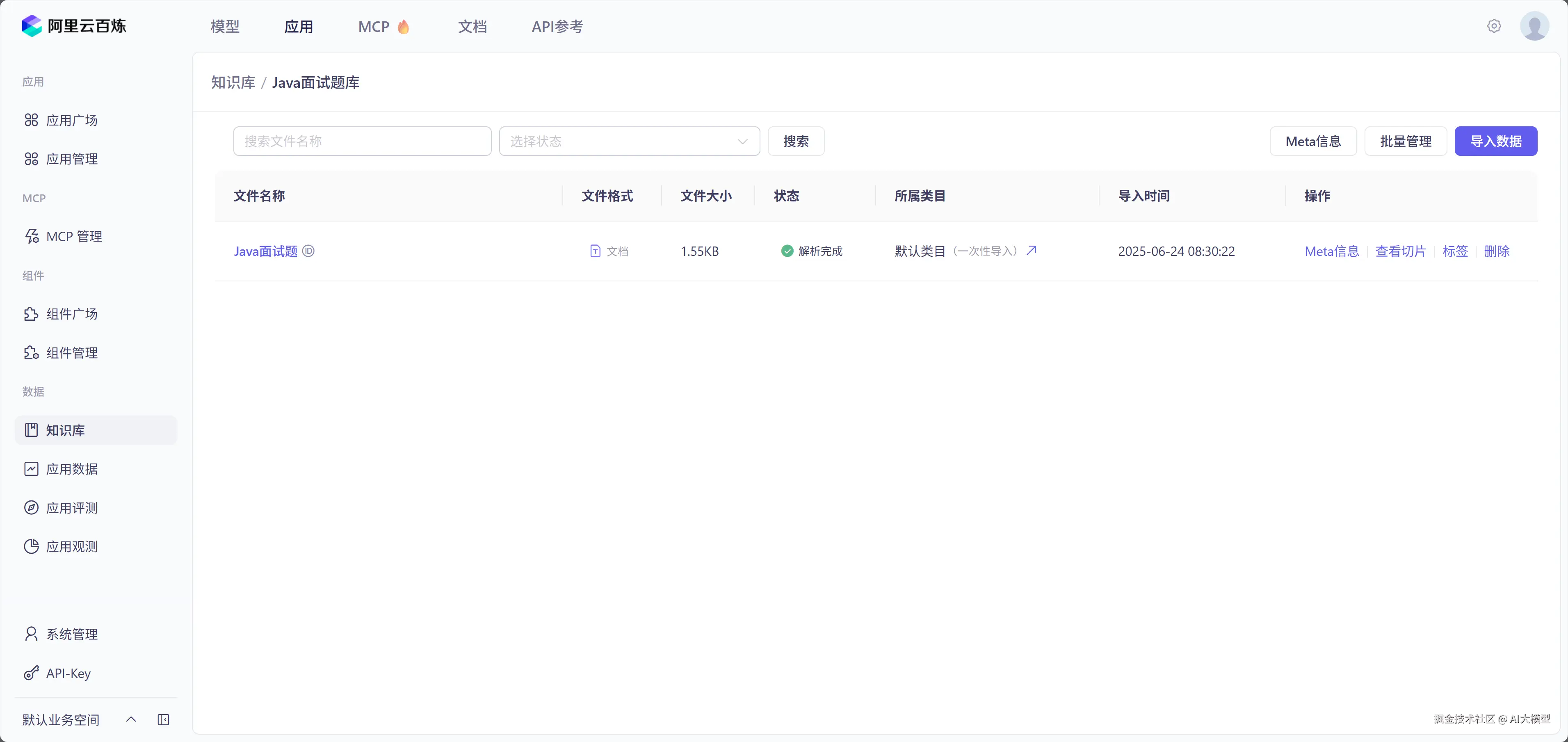

}其中 indexName 为知识库的名字,如下图所示:

小结

本地 Spring AI Alibaba 程序可以直接调用百炼平台的云知识库,实现知识库文档解析、分块、向量化存储等一条龙服务,大大提升 RAG 开发的效率,但同时也会带来数据隐私问题,所以我们需要根据自己的业务选择合适的方案。

我们该怎样系统的去转行学习大模型 ?

很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是, 基于此,我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习门槛,降到了最低!

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,现在将这份 LLM大模型资料 拿出来: 😝有需要的小伙伴,可以 在这 🆓**↓↓↓**

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

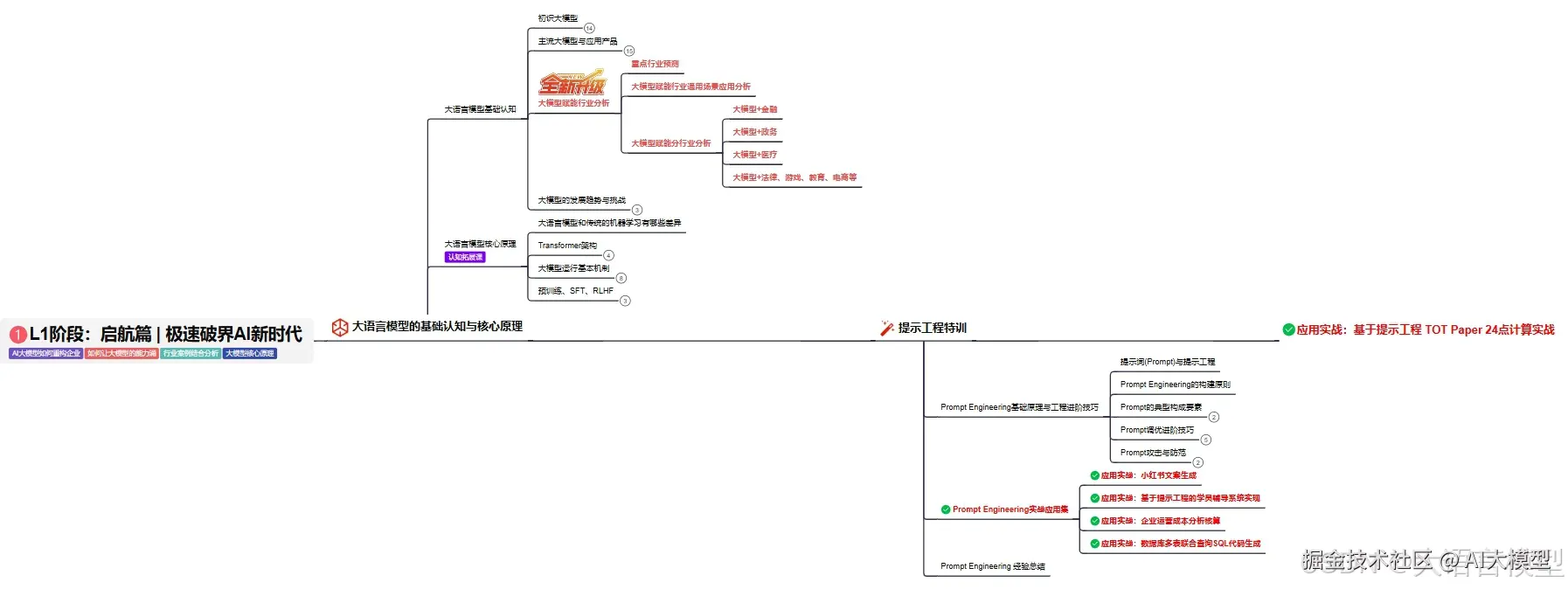

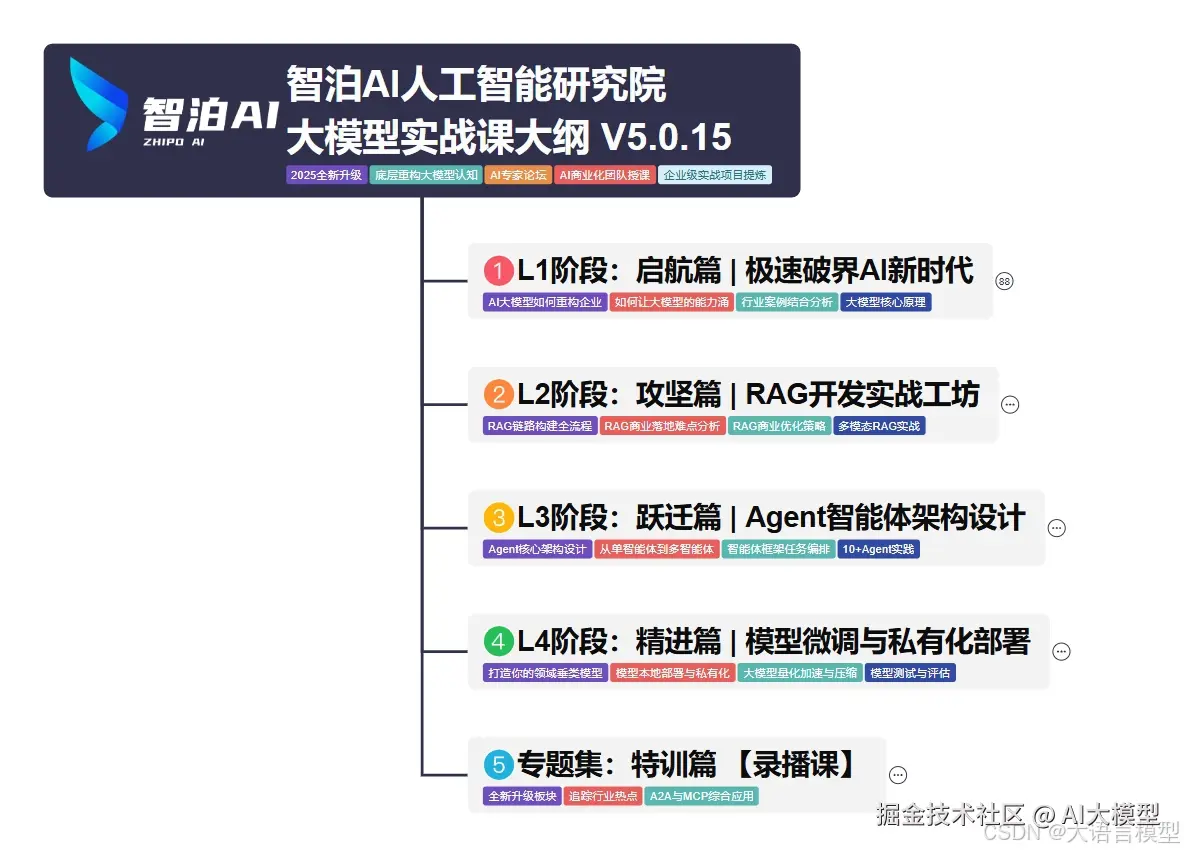

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理、关键技术以及大模型应用场景。

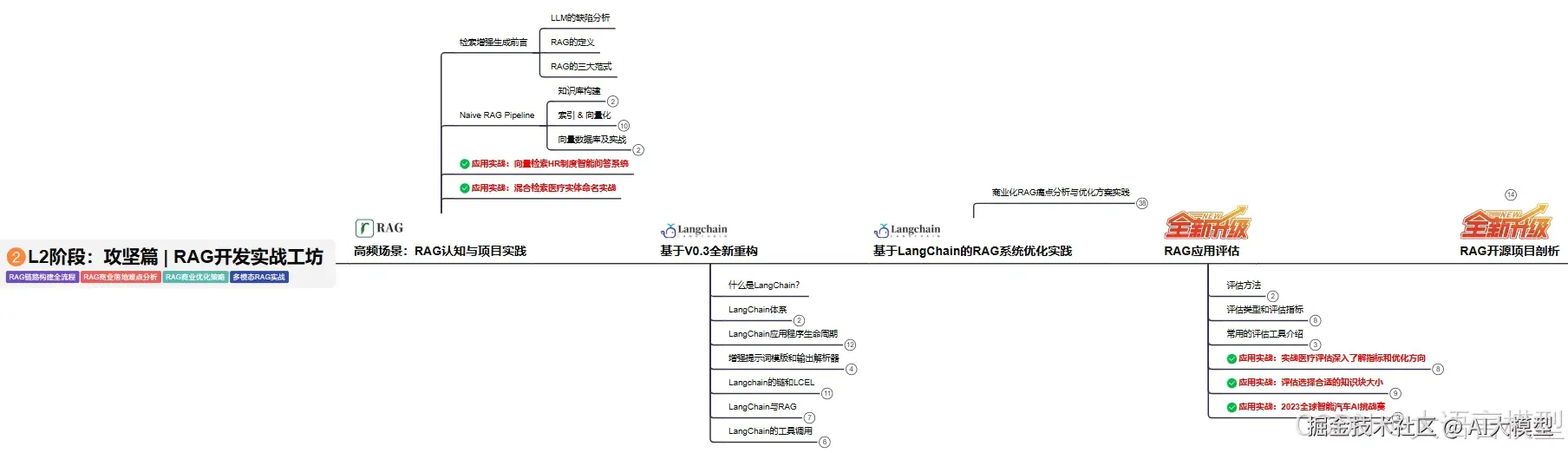

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

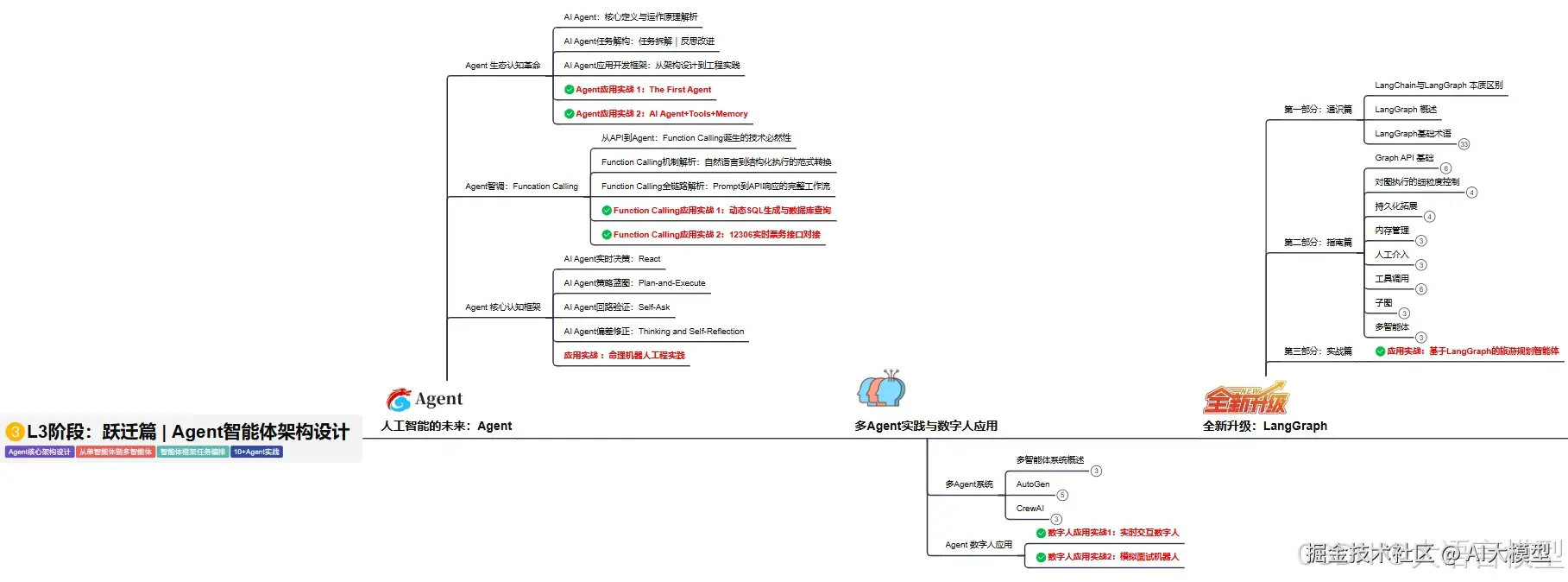

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体。

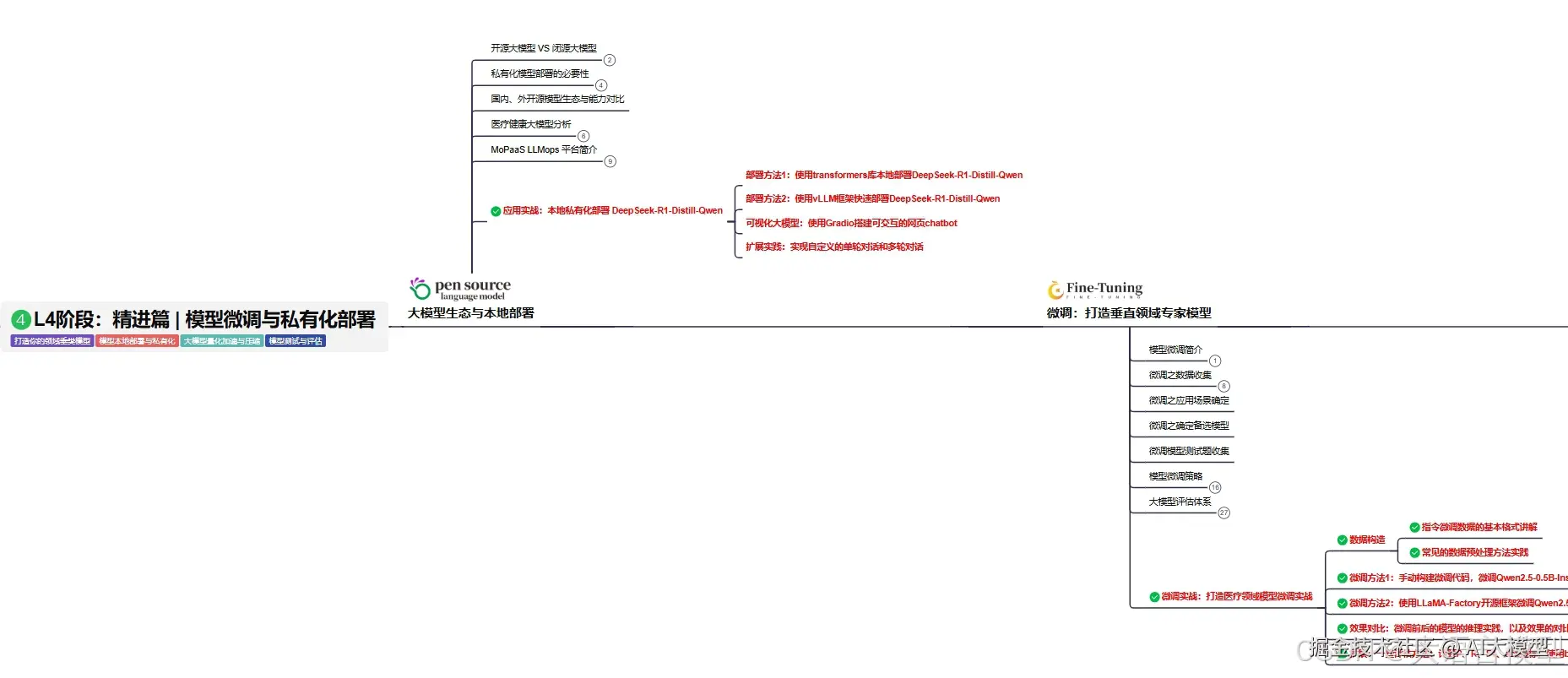

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调。

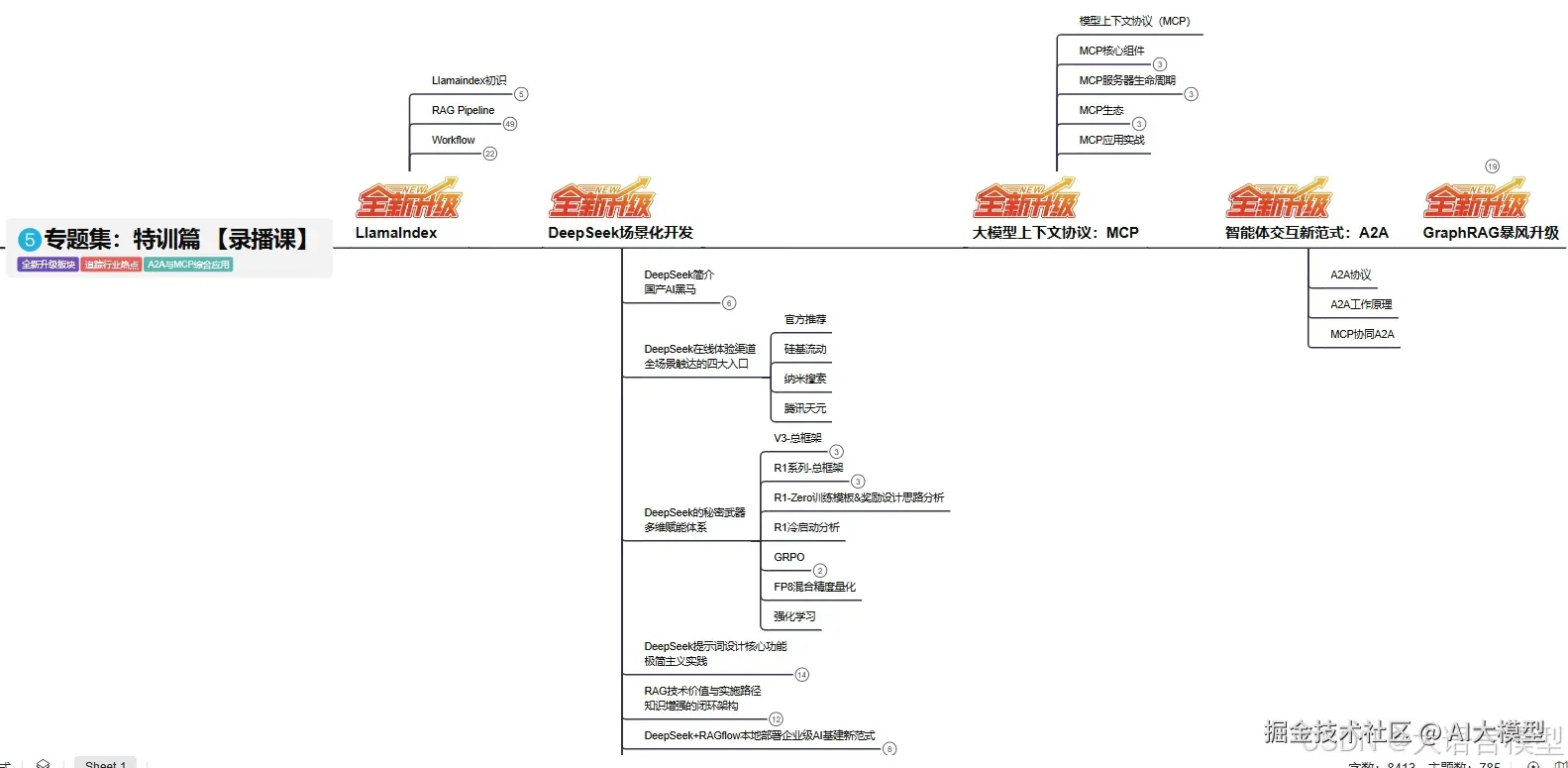

L5阶段:专题集丨特训篇 【录播课】

现在将这份 LLM大模型资料 拿出来: 😝有需要的小伙伴,可以 在这 🆓**↓↓↓**

原文地址:https://www.cnblogs.com/vipstone/p/18945667