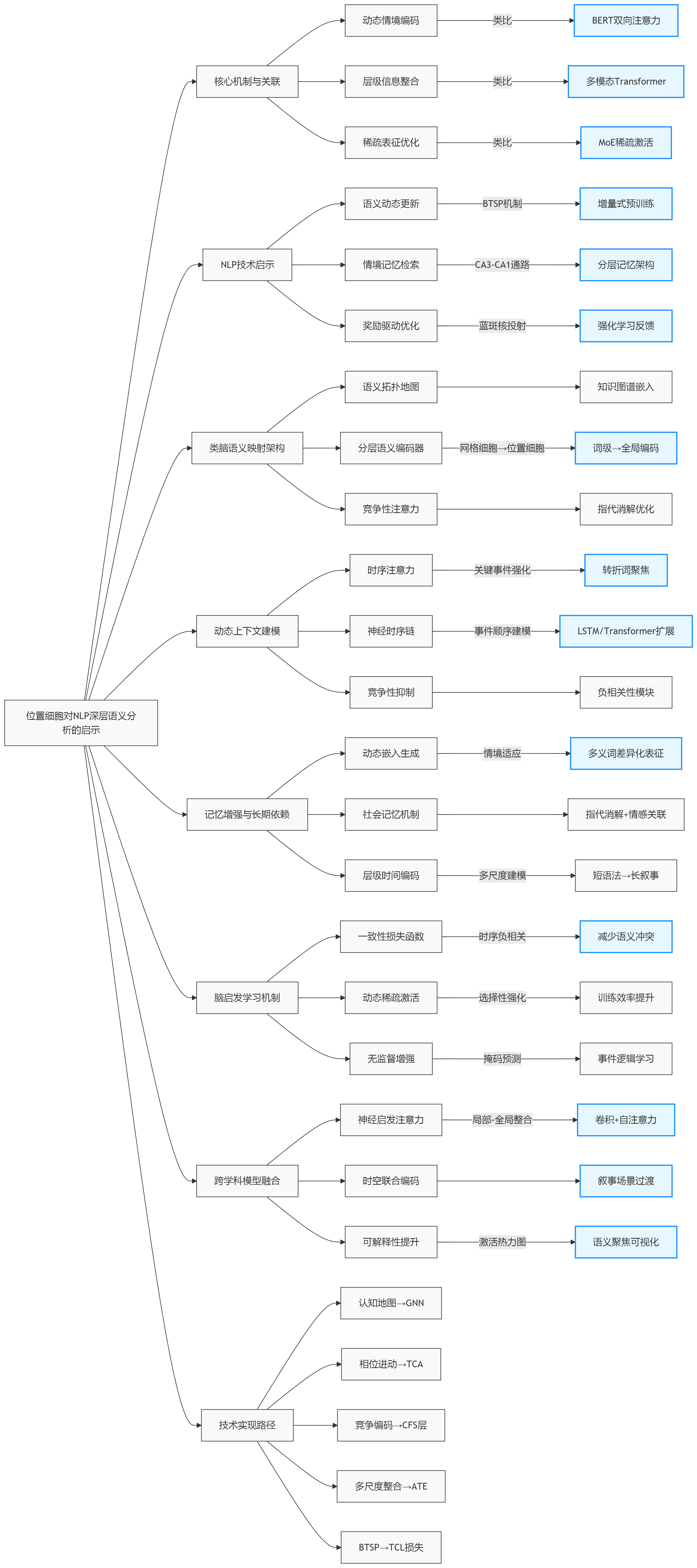

海马体背侧CA1区(dCA1)的位置细胞(place cells)通过其独特的神经编码机制(构建空间认知地图、编码序列信息以及整合多模态输入等),为自然语言处理(NLP)的深层语义分析提供了重要的神经科学启示。以下是其核心影响及技术实现路径:

一、位置细胞的核心机制及其与语义分析的关联

1. 动态情境编码与语义上下文建模

- 位置细胞通过重映射(Remapping) 在不同环境中形成独立的空间地图。例如,同一物理空间在奖励位置改变时,dCA1神经元会重组其活动模式,增强对关键区域的响应。

- 启示 :深层语义分析需捕捉词汇在不同语境下的动态含义(如多义词消歧)。位置细胞的动态编码机制可类比为NLP中的上下文感知表征(如BERT的双向注意力机制),通过调整权重聚焦关键语义区域。

2. 层级信息整合与非空间特征融合

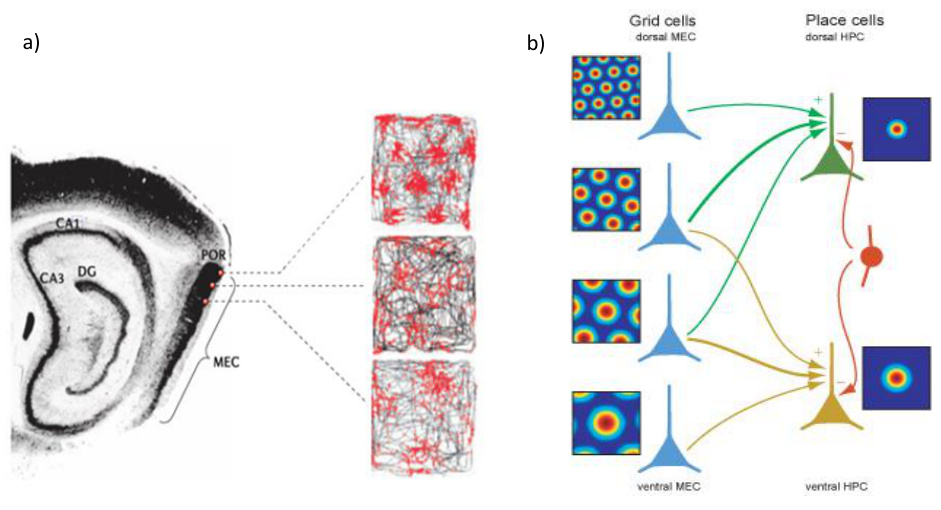

dCA1沿横轴存在功能分化:近端CA1 (靠近CA3)编码精确空间位置,远端CA1 (靠近下托)整合物体、气味等非空间信息。内侧内嗅皮层(MEC)的网格细胞输入提供空间框架,而外侧内嗅皮层(LEC)输入补充物体特征。

启示 :语义分析需同时处理语法结构(空间框架)和语义内容(物体信息)。这类似于多模态Transformer,通过不同注意力头分别捕捉句法结构和实体关系。

3. 局部回路调控与稀疏表征优化

- dCA1的抑制性神经元通过平衡兴奋性输入,稳定位置场的形成。例如,PV+中间神经元限制激活的神经元数量,实现稀疏编码。

- 启示 :深层语义模型可引入动态稀疏激活机制(如Mixture of Experts),抑制无关特征并强化关键语义单元,提升模型效率。

二、位置细胞对NLP核心技术的具体启示

1. 语义表征的动态更新机制

- 位置细胞通过 行为时间尺度突触可塑性(BTSP) 实时更新空间表征,无需传统赫布学习。

- NLP应用 :借鉴BTSP开发增量式预训练,使模型在任务微调时快速适应新语义(如医疗文本中的专业术语),避免灾难性遗忘。

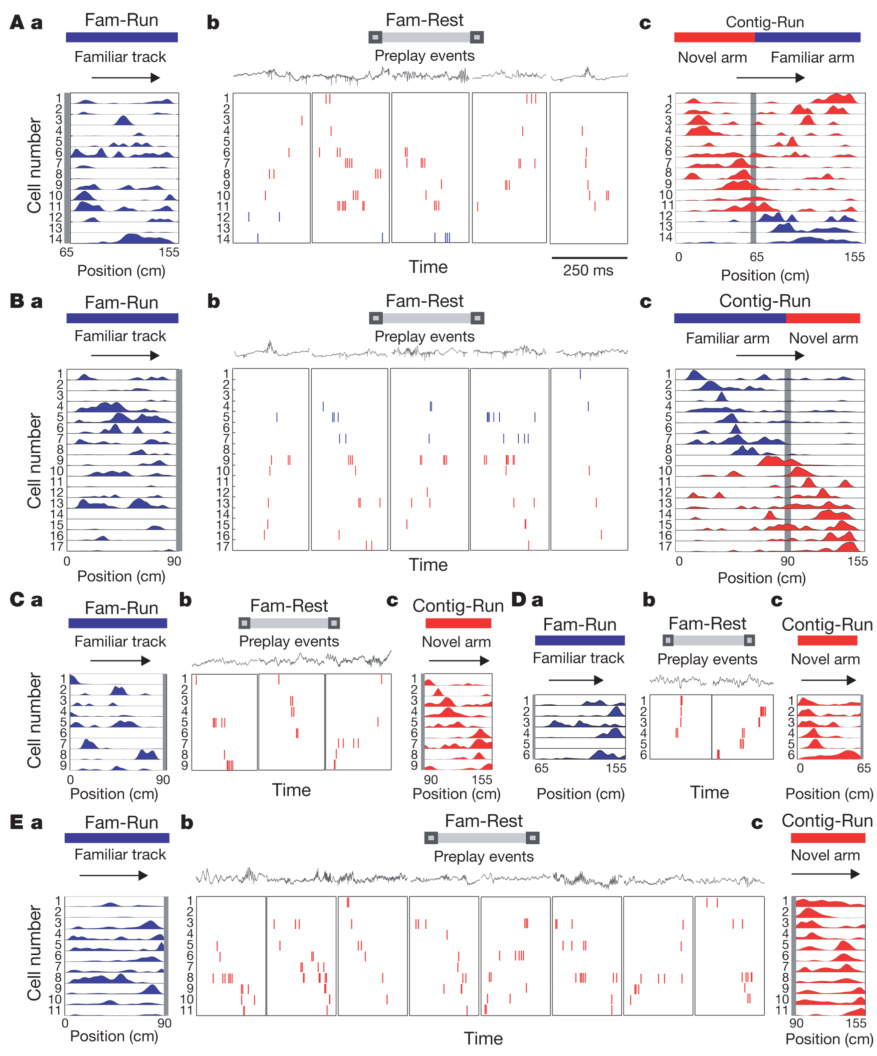

2. 情境依赖的记忆检索

- CA3-CA1通路支持 模式完成(Pattern Completion) :CA3稳定存储核心记忆,CA1根据情境(如环境线索)检索细节。

- NLP应用 :构建分层记忆架构:底层(类似CA3)存储通用知识图谱,顶层(类似CA1)结合当前上下文生成查询相关语义。

3. 奖励驱动的语义优化

- 蓝斑核(LC)投射至dCA1,在奖励学习时重组位置细胞表征。

- NLP应用 :在语义解析中引入强化学习信号(如用户反馈),动态调整注意力权重,优化目标导向的语义生成(如对话系统的意图识别)。

三、类脑语义映射架构:从空间地图到语义空间

-

认知地图与语义拓扑结构

- 位置细胞通过"位置野 "形成环境的空间表征(认知地图) 。类比到NLP,可构建语义拓扑地图 ,将词(实体、概念)嵌入高维向量空间,通过几何关系(如距离、方向)建模语义关联(如"医院-医生"的空间邻近性对应语义相关性)。

- 技术启示 :设计分层语义编码器 ,底层网络处理词级位置关系(类似网格细胞路径积分),高层网络整合上下文形成全局语义地图(类似位置细胞整合空间信息)。

-

动态实体关系建模: 位置细胞与网格细胞协同实现动态路径整合,启发了NLP中实体关系动态更新机制。例如:

- 在指代消解 任务中,通过竞争性注意力模块 (模拟位置细胞与头朝向细胞的竞争性编码)动态分配实体权重(如"他"优先指向最近提及的主体)。

- 知识图谱 嵌入时引入时空约束损失函数,强制相关实体在向量空间中邻近分布。

四、动态上下文建模机制:时序编码与竞争性整合

-

时序事件链式编码: 位置细胞的相位进动(phase precession)和θ(theta)序列将空间轨迹压缩至神经振荡周期内,解决了NLP中的长距离依赖问题:

- 时序注意力机制:在Transformer中引入动态时间权重,强化关键事件节点(如转折词、因果连词)的注意力分布,模拟位置细胞对关键位置的响应。

- 神经时序链模块 :在LSTM/Transformer中嵌入链式激活层,显式建模事件顺序(如"起床→刷牙→上班"),提升叙事连贯性。

-

特征动态竞争机制: 位置细胞编码时空信息时存在负相关竞争(如时间延长则空间表征偏移),可转化为NLP中的动态特征选择:

- 竞争性抑制层 :在多头注意力中增设负相关性模块,抑制冗余特征(如"昨天开会"侧重时间,"北京开会"侧重地点)。

- 多模态融合:参考CA3-CA1回路,设计分离-整合网络:时间模块处理事件序列(动词时态),实体模块解析名词关系,最终通过海马类似架构(如CA1整合层)输出融合语义。

-

位置细胞重映射 vs Transformer上下文适应:

| 特性 | 位置细胞重映射 | Transformer上下文适应 |

|---|---|---|

| 触发条件 | 环境/情境变化 | 输入序列上下文动态 |

| 机制 | 突触可塑性调整 | 自注意力权重更新+位置编码调整 |

| 功能目标 | 独立记忆存储与情境区分 | 语境相关语义嵌入生成 |

五、记忆增强与长期依赖:情景化与多尺度编码

-

情景化语义记忆: dCA1位置细胞根据任务情景动态调整编码策略(如探索意图神经元),启发了语境自适应模型:

- 动态嵌入生成器 :根据对话状态实时更新词向量(如"bank"在金融/地理语境中的差异化表征)。

- 社会记忆机制 :CA1神经元编码个体身份与社交价值,可用于NLP的指代消解与情感关联 (如"小明帮助过她"隐含正向价值,影响后续指代预测)。

-

多尺度时间表征: 位置细胞与内嗅皮层协同支持秒级至小时级的时间编码,对应NLP的事件粒度分层解析:

- 层级时间编码器:底层捕捉词序(短时语法),高层建模事件阶段(长时叙事),例如在摘要任务中压缩长文档为关键事件序列。

- 可扩展时序模块 :自适应调整时间窗口(新闻摘要需分钟级压缩,小说分析需天级跨度)。

六、脑启发的学习机制:可塑性优化与无监督增强

-

突触可塑性驱动记忆巩固: dCA1位置细胞通过行为时间尺度突触可塑性(BTSP)逐步稳定记忆表征,可转化为NLP模型的渐进式学习机制:

- 一致性损失函数(Temporal Coherence Loss):强制模型学习事件顺序的负相关竞争,减少语义冲突。

- 动态稀疏激活:仅更新任务相关神经元(类似稳定位置细胞选择性强化),提升训练效率。

-

**无监督时序重构:**海马体在睡眠中重组时间记忆,启发了预训练任务设计:

- 掩码事件序列预测:无监督学习事件逻辑(如预测"下雨→取消郊游"的隐含因果)。

- 几何结构知识蒸馏:将神经活动空间的低维流形(如位置细胞编码的抽象变量几何结构)迁移至NLP模型,提升泛化性。

七、跨学科模型融合的实践方向

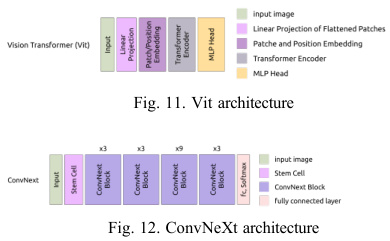

1. 神经启发的注意力机制

- 位置细胞的局部-全局整合 (网格细胞→位置细胞)可转化为层级注意力 :

- 底层:卷积层捕捉局部语法模式(类似网格细胞的周期性响应)

- 顶层:自注意力层构建全局语义地图(类似位置场的形成)

2. 时空联合编码的语义模型

-

位置细胞与时间细胞 协同编码时空序列,支持轨迹预测。

-

NLP应用 :在文本生成中融合时空位置编码,增强叙事连贯性(如故事生成中的场景过渡)。

3. 可解释性提升

- 位置场的可视化直接反映神经编码逻辑。

- NLP应用 :开发语义激活热力图,可视化模型对关键词的聚焦程度(类似位置场热力图),提升可解释性。

八、技术实现路径与未来方向

| 神经机制 | NLP应用 | 技术模块 |

|---|---|---|

| 认知地图拓扑 | 语义空间构建 | 分层图神经网络 (GNN) |

| 相位进动与时序压缩 | 长文本事件建模 | 时序链式注意力 (TCA) |

| 时空竞争编码 | 动态语境适应 | 竞争性特征抑制层 (CFS) |

| 多尺度时间整合 | 事件粒度解析 | 自适应时间编码器 (ATE) |

| BTSP记忆巩固 | 渐进式语义稳定 | 一致性损失函数 (TCL) |

未来方向:

- 神经符号融合:将位置细胞的几何编码与符号逻辑结合,提升可解释性(如可视化语义关系路径)。

- 多模态联合训练:整合视觉/语言输入,模拟海马体时空-实体分离通路,构建具身语义理解模型。

- 脑电信号迁移:利用海马theta振荡特性优化Transformer位置编码,增强时序感知。

九、总结:生物机制到计算框架的转化路径

| 位置细胞特性 | NLP启示 | 现有技术对照 |

|---|---|---|

| 动态重映射 | 上下文自适应语义表征 | BERT动态嵌入 |

| 近-远端信息整合 | 多模态语义融合 | ViLT多模态模型 |

| 抑制性回路调控 | 稀疏注意力机制 | Sparse Transformer |

| 蓝斑核驱动的奖励重组 | 强化学习优化语义生成 | RLHF微调 |

通过模拟位置细胞的动态编码 、层级整合 和情境依赖优化,可推动深层语义分析向更高效、自适应、可解释的方向演进。未来工作可聚焦神经科学理论与Transformer架构的深度融合(如神经调制增强的注意力模块),进一步缩小生物智能与机器语义理解间的差距。

十、结论

dCA1位置细胞的核心价值在于其动态时空编码、竞争性特征整合及多尺度记忆机制,为NLP深层语义分析提供了生物验证的计算范式。通过构建类脑的时空分离-整合架构、时序链式注意力及渐进式记忆模块,可显著提升语义连贯性、上下文建模及长期依赖处理能力。未来需进一步融合神经回路细节(如CA2-CA1特异性环路)与深度学习模型,推动语义理解向类脑智能演进。