- 卷积神经网络实际上就是避免过拟合,就是"特征"神经网络。这个特征和卷积核相关。卷积和相关类似,有点是本质属性和输出属性的感觉。

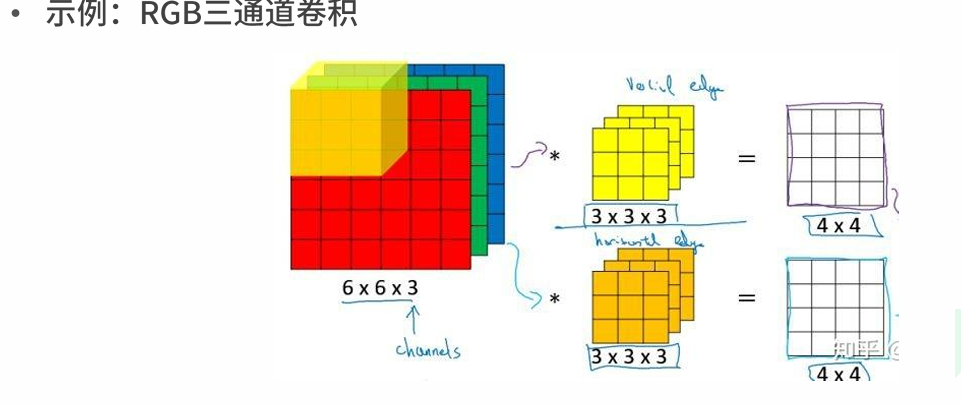

着重注意三通道卷积

padding 上下左右、前后都要加边

padding 上下左右、前后都要加边

池化就是解决特征过多问题,缩小1倍较多。均值池化,最大池化。

卷积是线性的,叠加激活函数解决非线性神经网络问题。

池化层和卷积层反向传播问题,对于池化层,使用最大池化可以使大多数神经元置零,减少反向传播神经元参数。

欠拟合的原因主要是网络深度不够,一般采用扩大网络规模和深度,或改进方法。

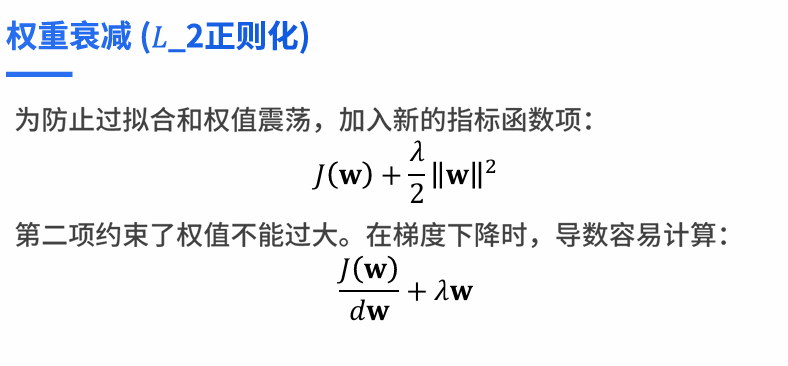

过拟合就是训练误差低,测试误差高,结果泛化及处理未知数据能力不强。调整训练算法。权重衰减及LR正则化方法。

DropOut,工厂干活时10个人一定出现分化,反映到神经网络,某些神经元会不停调正权值,非常积极,会产生振荡,还有神经元不被激活,不参与任何训练。如何改变这种情况。针对10个人,可以分成2班,形成均匀分配。每一天都随机选择5个人上班,因为人多,工作时间长,所以被选中国内的概率都是一致的,每一个神经元都会随机参与。在全连接层一般会使用暂退法则。

DropOut,工厂干活时10个人一定出现分化,反映到神经网络,某些神经元会不停调正权值,非常积极,会产生振荡,还有神经元不被激活,不参与任何训练。如何改变这种情况。针对10个人,可以分成2班,形成均匀分配。每一天都随机选择5个人上班,因为人多,工作时间长,所以被选中国内的概率都是一致的,每一个神经元都会随机参与。在全连接层一般会使用暂退法则。

- 框架

嵌入式Tensorflow稍多,但是方向为Pytorch

tensorflow2.0 版本以上和Pytorch类似。同一个网络同一组参数最后的结果是不一样的。

pytorch 张量 一切都是 tensor 张量。神经网络就是图,图可以获得偏导。图神经网络 GNN