大家好,我是袁庭新。

为什么要将大模型部署到本地呢?如果特别注重数据安全与资源可控性,可以将DeepSeek部署在本地,实现数据闭环管理,有效避免敏感信息外泄,这样的要求在金融、医疗等高合规性要求行业中普遍存在。

此外,对个人来说,如果希望基于模型进行深度研究,也要进行本地化部署。今天,给大家介绍3种大模型本地化部署方式。

Ollama + Cherry Studio本地部署大模型

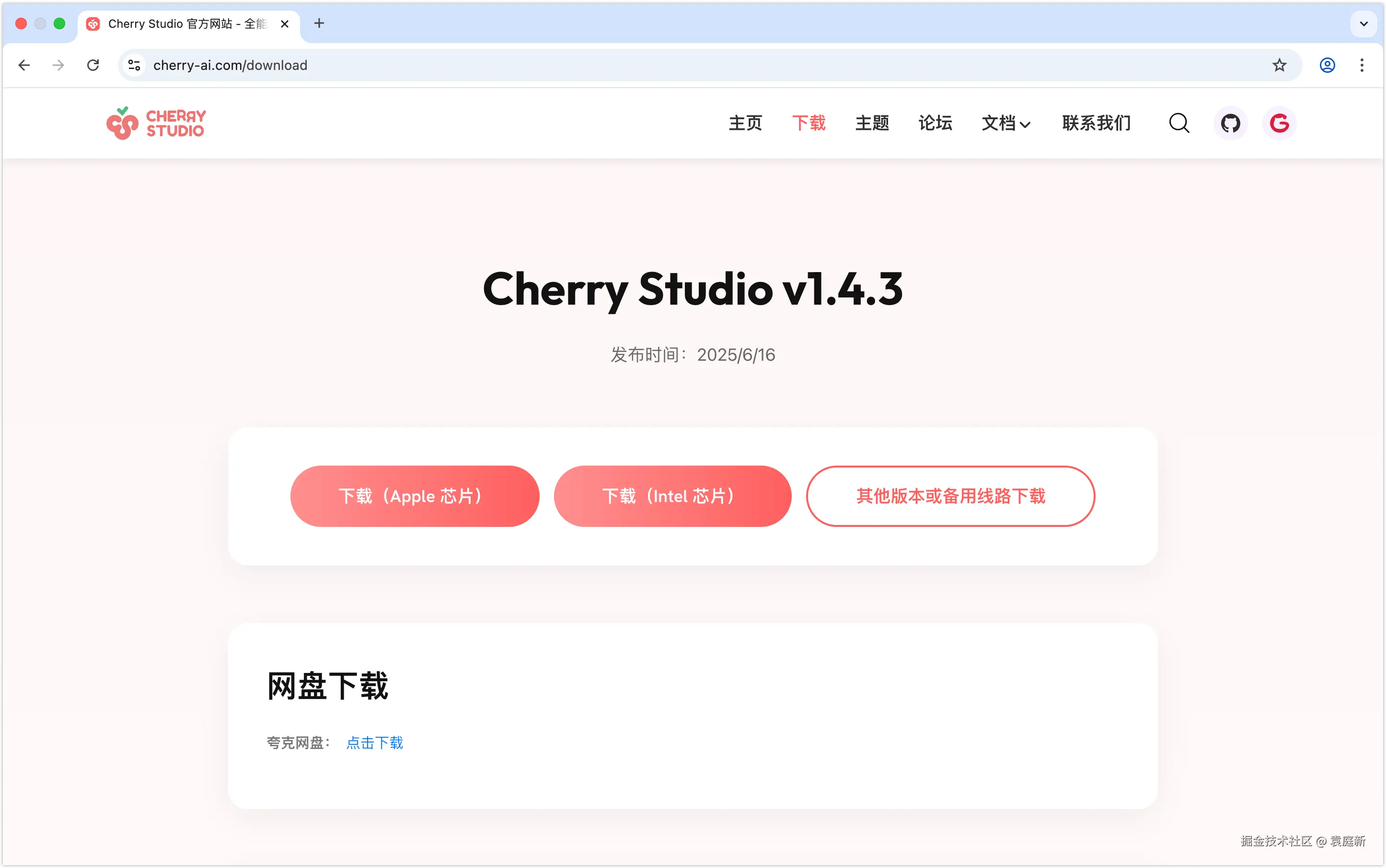

打开Cherry Studio官网(cherry-ai.com),在Cherry Studio的主页点击右上角的「下载」选项,将会打开如下图所示的下载界面。

根据自己的操作系统版本,选择下载对应的Cherry Studio安装包;安装包下载完成后,双击安装包文件,完成Cherry Studio软件安装。

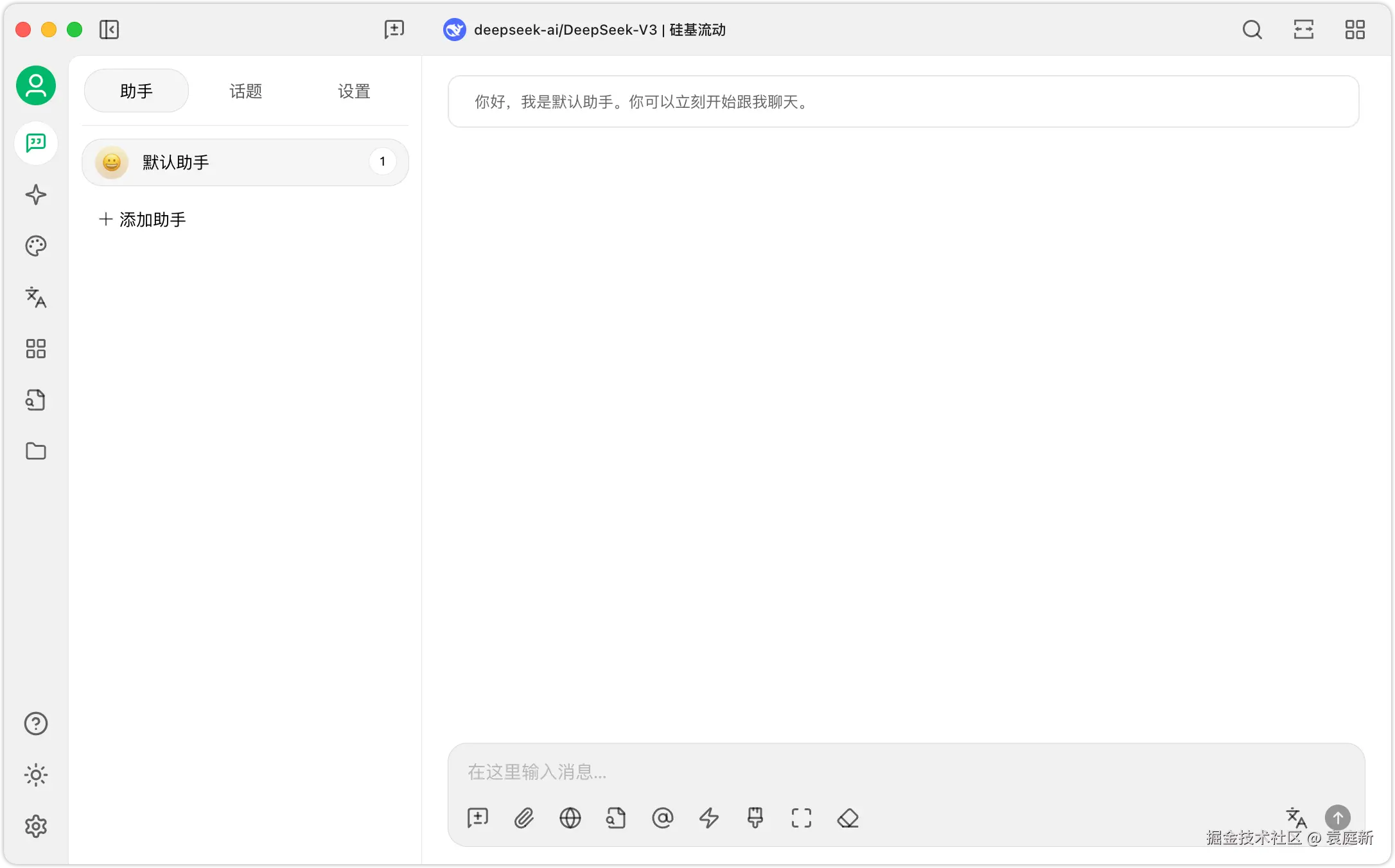

然后到启动台(或桌面)中寻找Cherry Studio图标并点击,能打开Cherry Studio主界面则安装成功。

下载Ollama。访问Ollama官网(ollama.com),进入网站后,如下图所示。

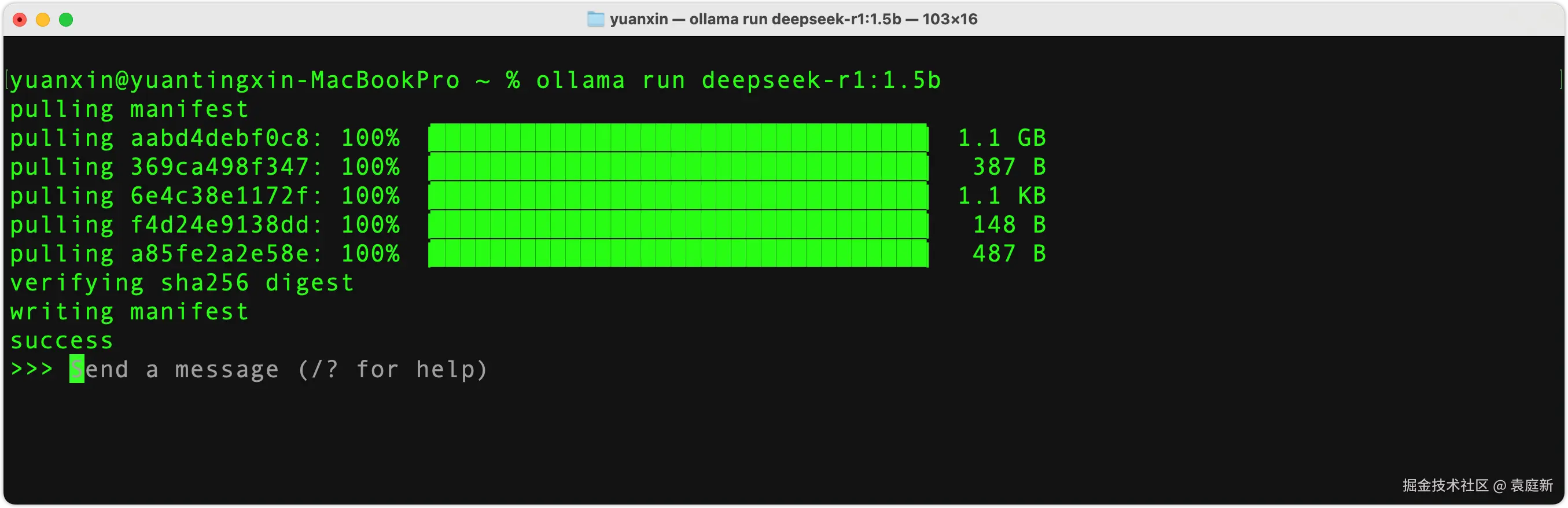

例如,要下载DeepSeek-R1-Distill-Qwen-1.5B模型,可以运行以下命令。

arduino

ollama run deepseek-r1:1.5b运行上述命令后,Ollama会自动下载并运行该模型,模型安装完成后如下图所示。

使用LM Studio本地部署大模型

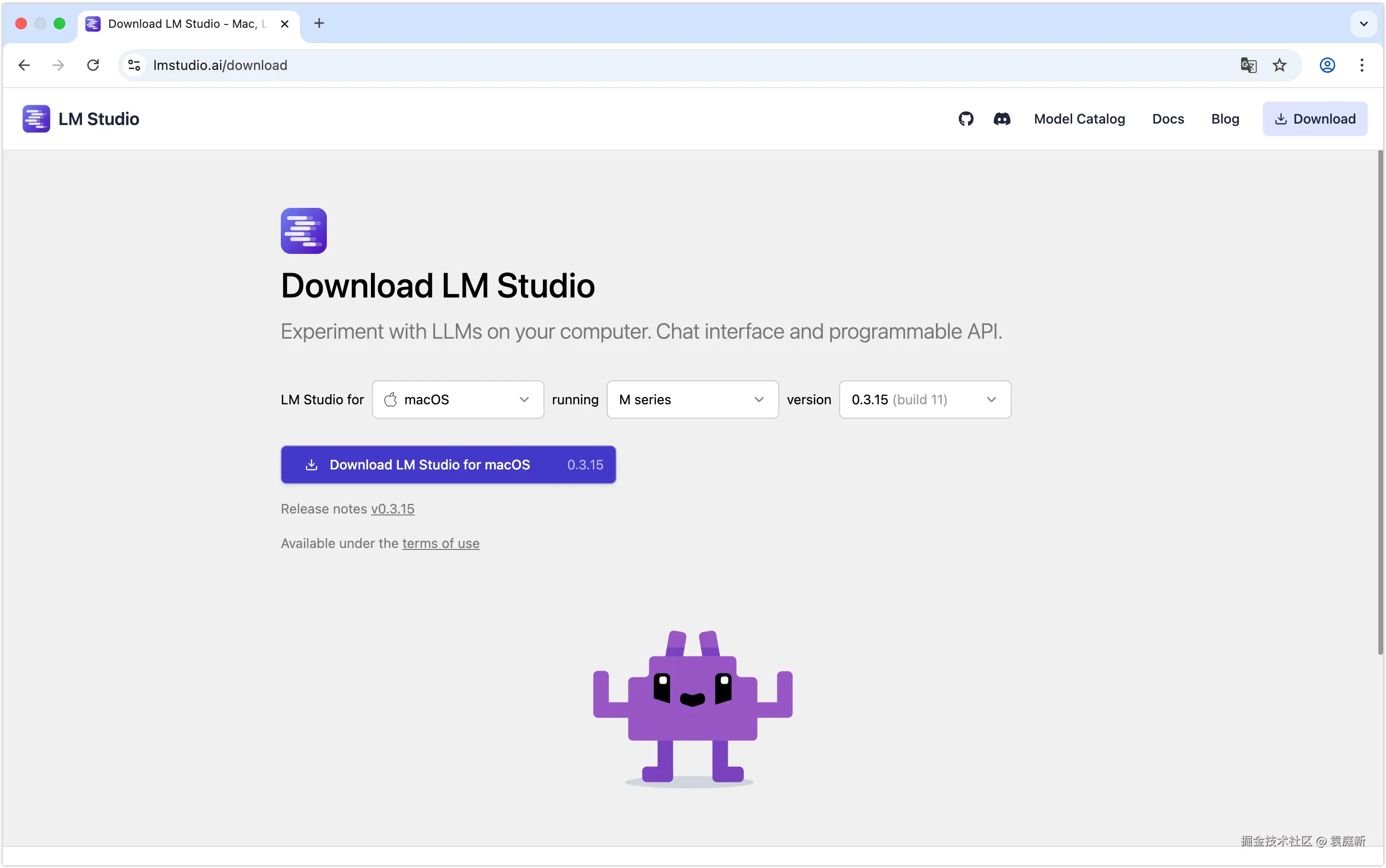

访问LM Studio下载页面(lmstudio.ai/download),根据你的操作系统版本下载一个安装程序。

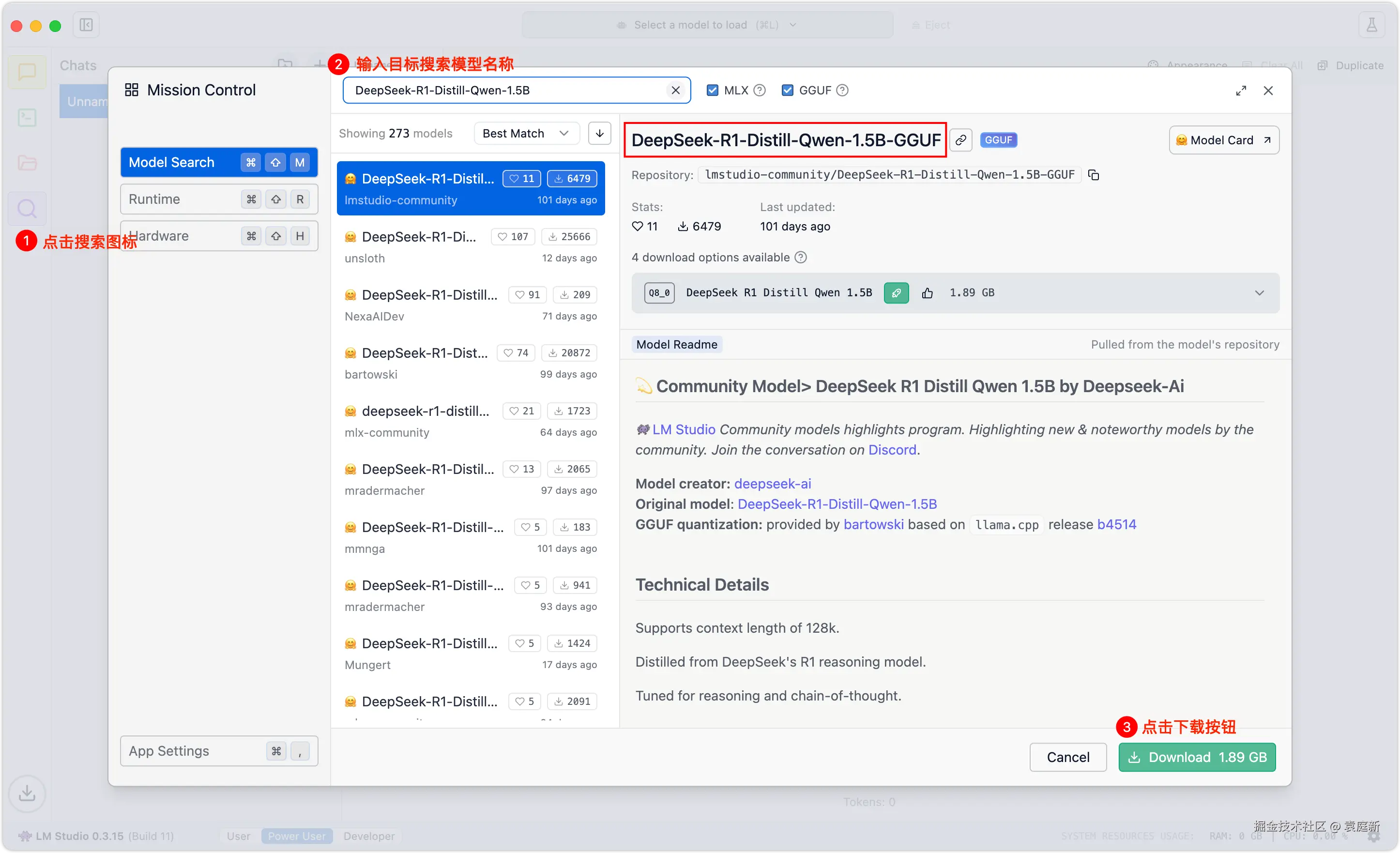

打开LM Studio,点击发现按钮(放大镜按钮)然后在右侧界面里搜索DeepSeek-R1-Distill-Qwen-1.5B对应的模型,如下图所示。

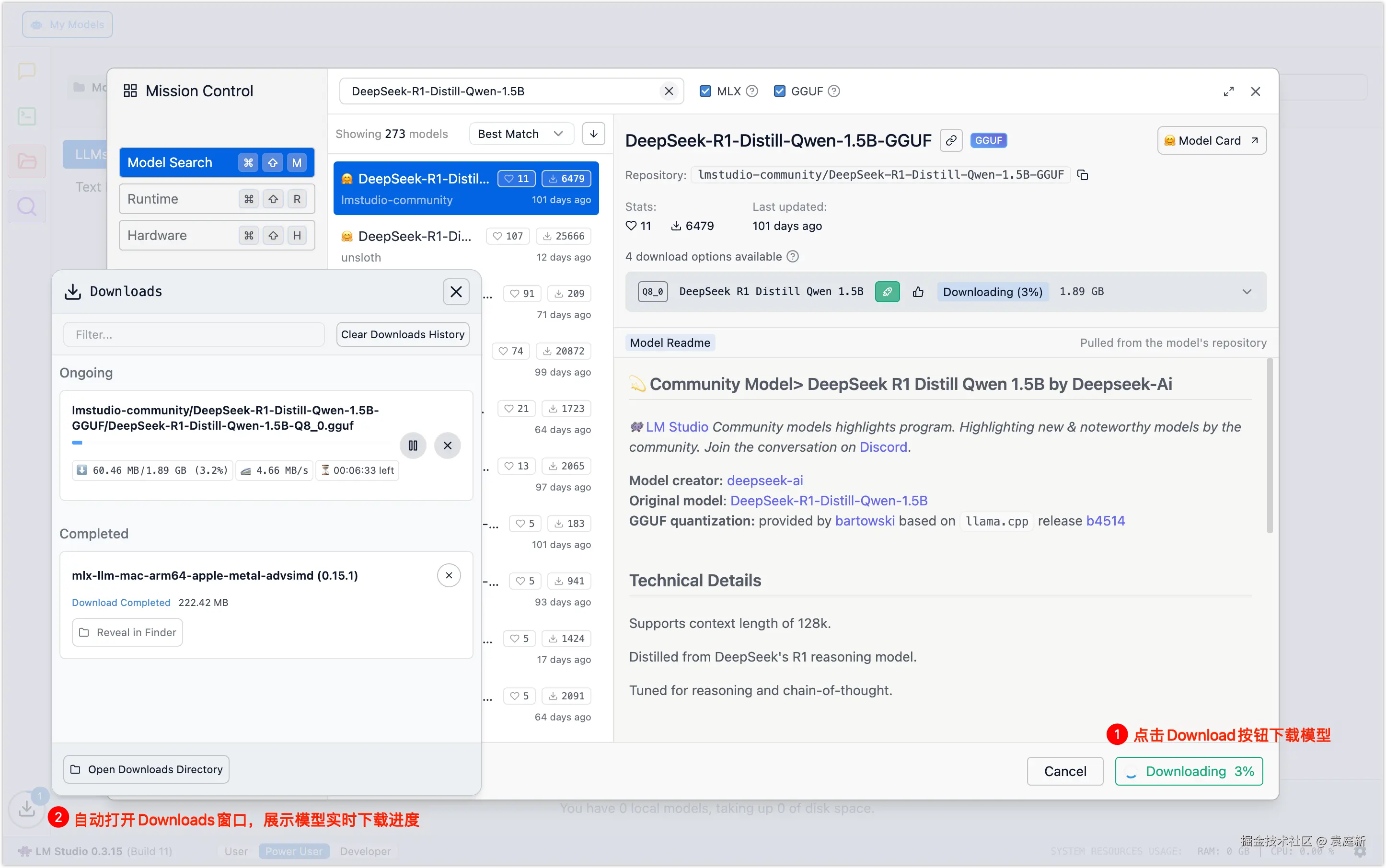

这里,我们以DeepSeek-R1-Distill-Qwen-1.5B模型为例,演示如何进行下载,如下图所示。

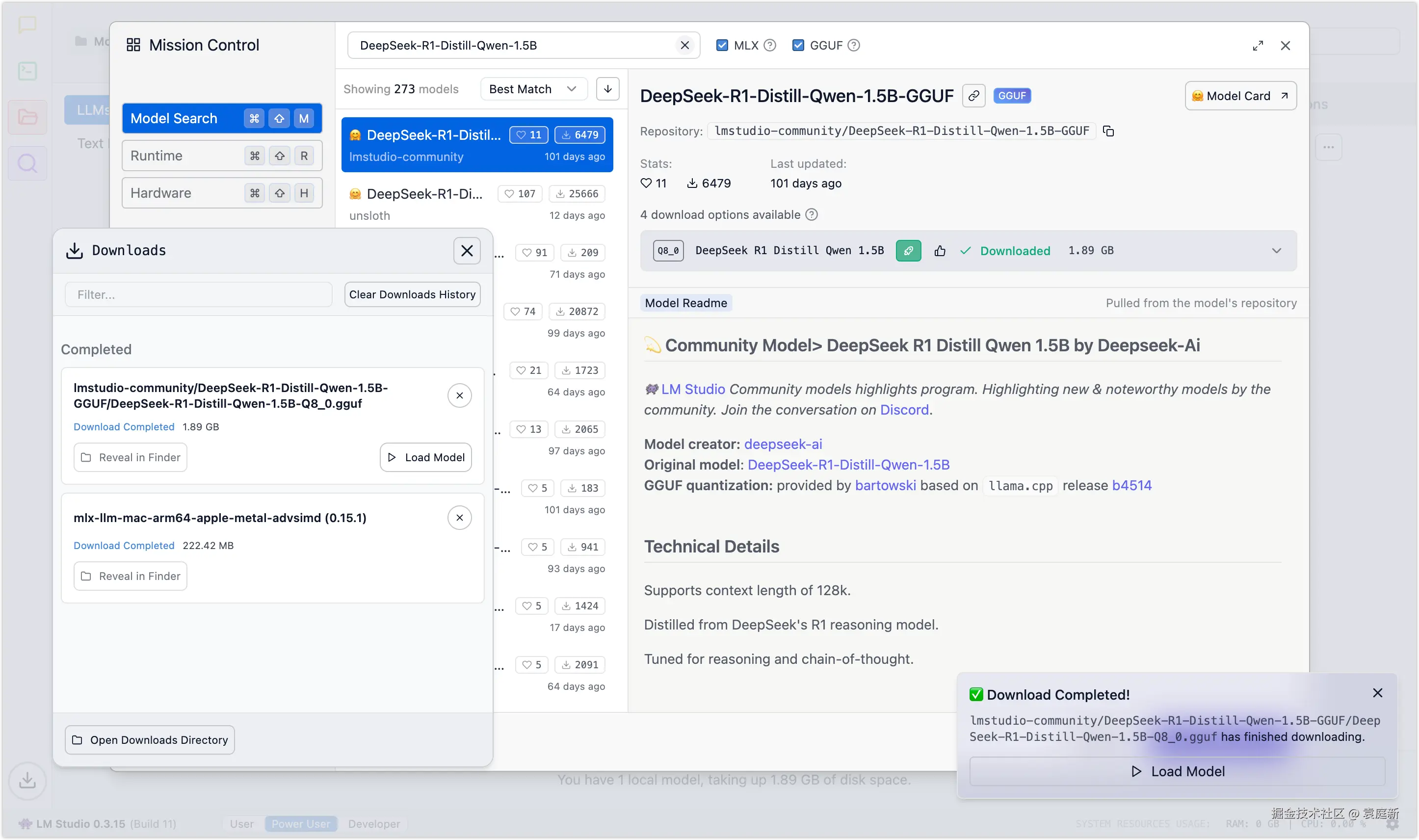

模型下载完成后,LM Studio的右下角会弹出「Download Completed」窗口,表示指定模型下载完成。

使用Ollama + Chatbox AI本地部署大模型

打开Chatbox AI网站,网址为chatboxai.app/zh。进入网站后,单击"免费下载"按钮,如下图所示,将Chatbox AI安装包下载到本地。

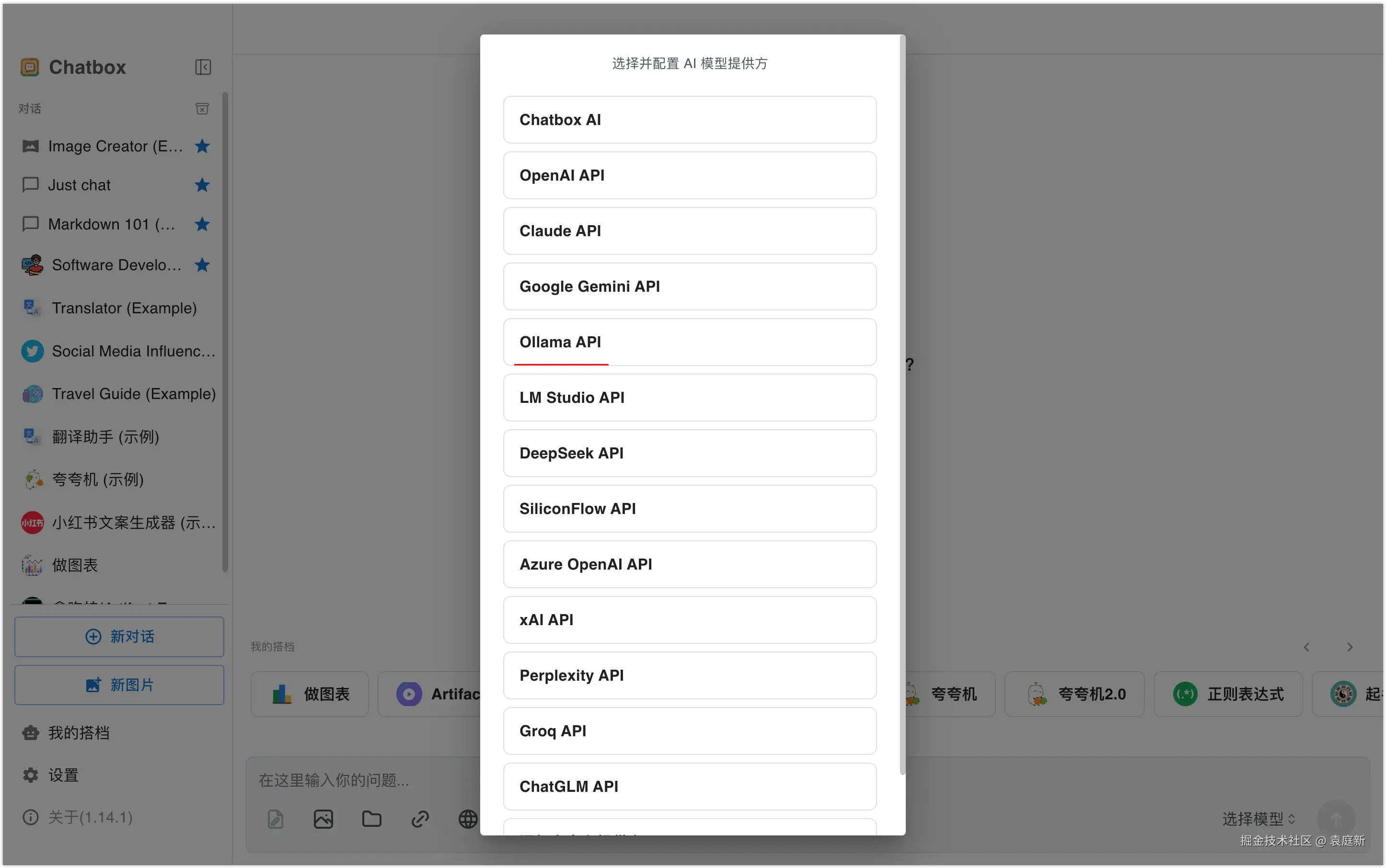

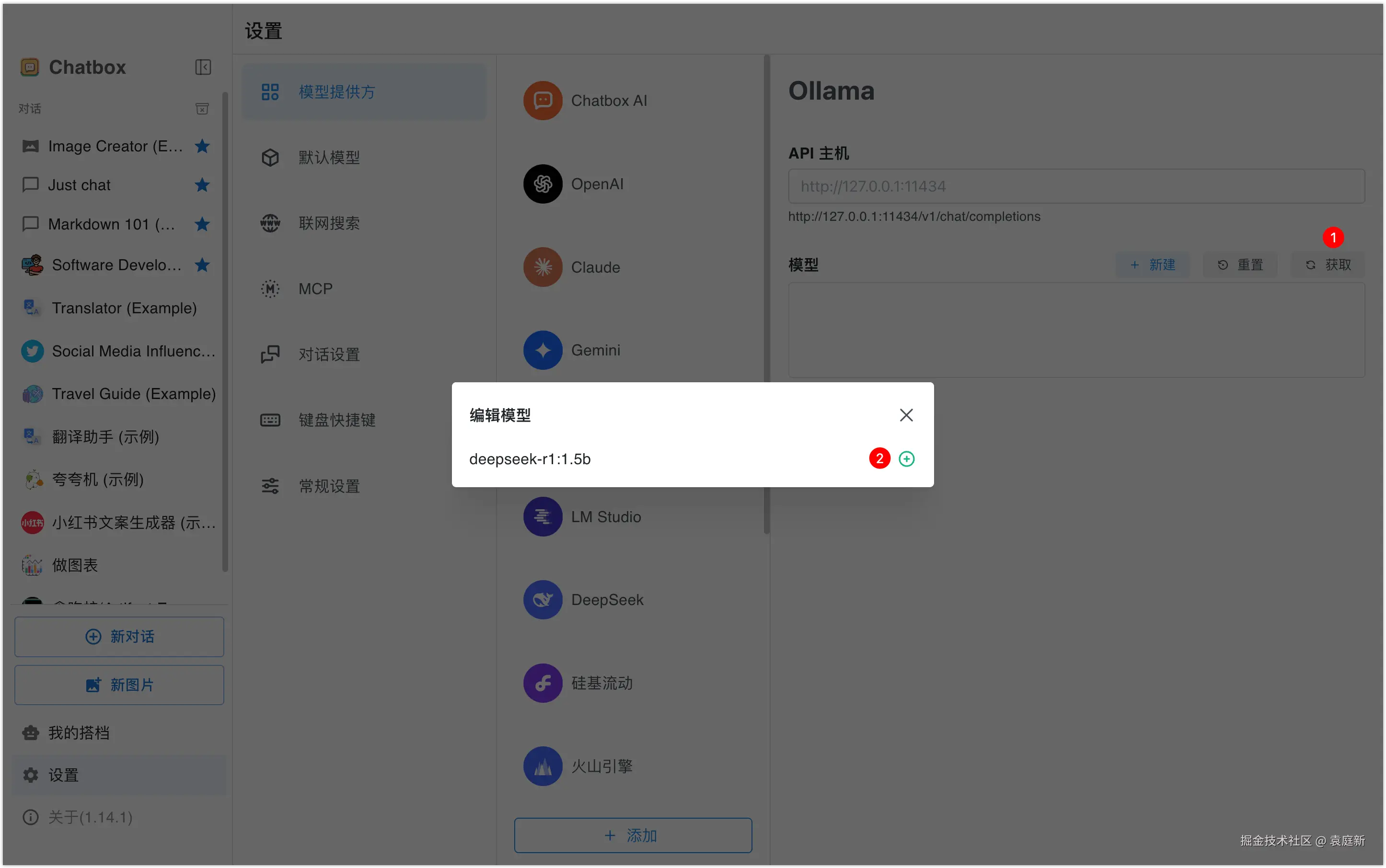

在软件弹出的窗口中单击"使用自己的API Key或本地模型"按钮,在"选择并配置AI模型提供方"页面选择【Ollama API】选项,如下图所示。

在打开的模型提供方设置窗口中,点击右侧的"获取"按钮,在弹出的"编辑模型"窗口中,点击deepseek-r1:1.5b模型后的"+"按钮添加模型,如下图所示。

对于一些对数据安全性、隐私性或定制化要求较高的用户,本地部署是一种理想的选择。DeepSeek支持多种本地部署方式,以上的内容就是给大家详细介绍的如何在本地部署DeepSeek的方法。

教程发布

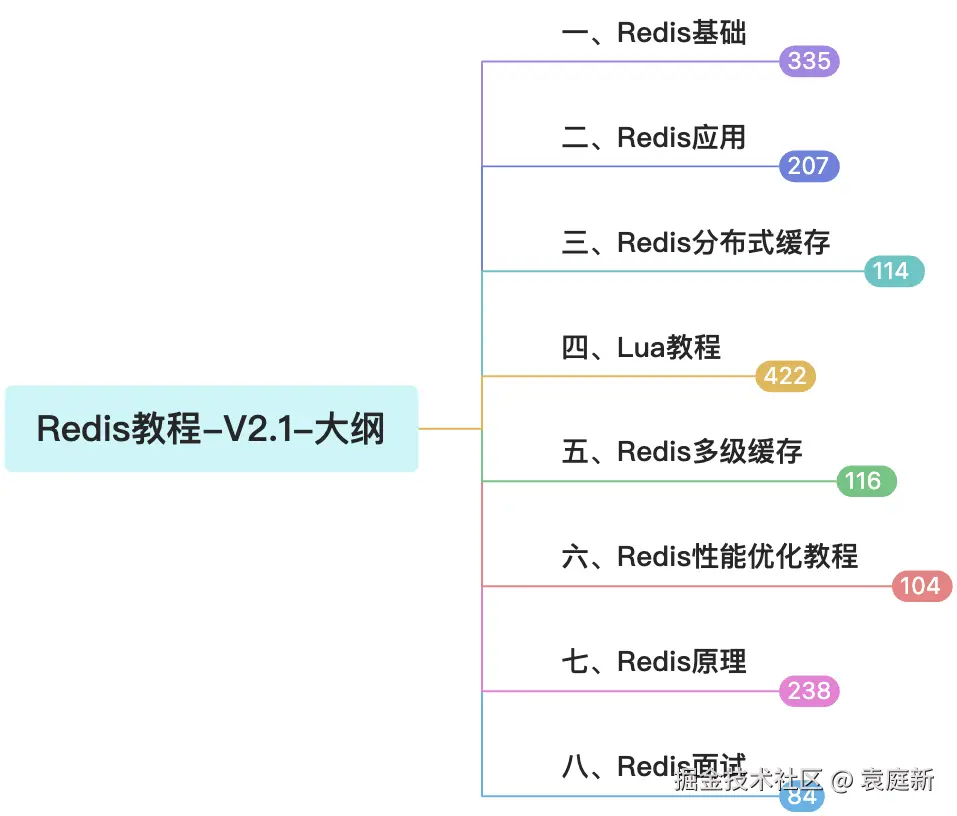

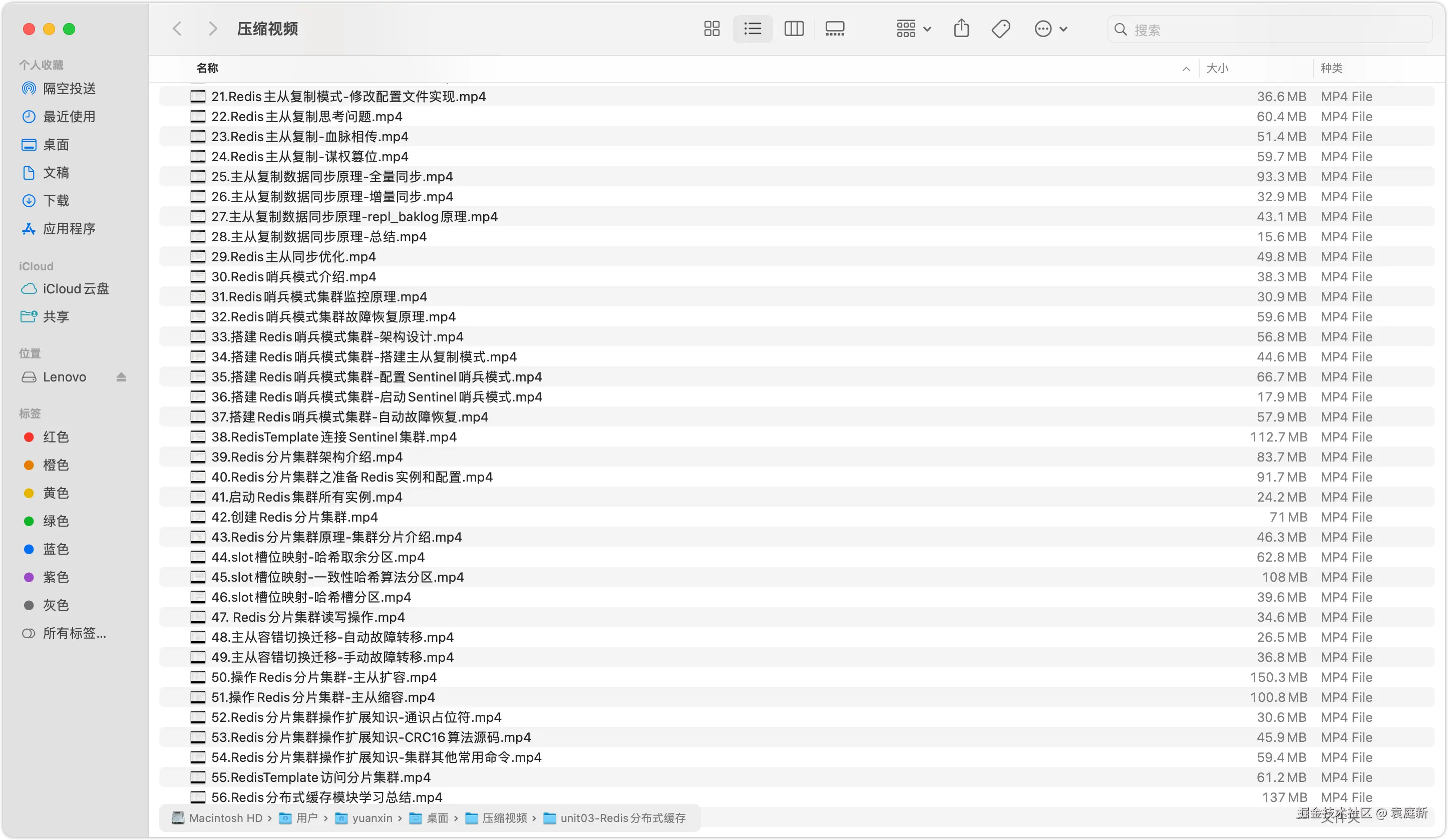

我的新《Redis 7高性能缓存与分布式架构实战》教程发布~这套教程总计涵盖了8大知识板块,共404节的内容。

先给大家概要下,本套教程共包含8大板块:Redis 基础入门与实践、Redis应用与缓存开发实战、Redis 高可用与分布式集群、Lua编程实战开发、多级缓存架构设计、精通Redis性能优化、Redis原理深度解析、Redis大厂高频面试问题。

教程《Redis 7高性能缓存与分布式架构实战》现已发布,通过访问下方地址开展学习(WChat H5):

bash

https://h5.htknow.com/#/pages/courseInfo/bigSeriesDetail/bigSeriesDetail?id=7662335希望这套教程对你有帮助,旨在帮助学员全面掌握Redis 7的高性能缓存及分布式架构实战技巧。