一.神经网络

1.卷积神经CNN:适合处理图像,计算机视觉领域

2.循环神经RNN:存储序列数据,记住过去的信息应用到当前处理过程中,序列不能太长

3.长短时记忆网络LSTM:特殊的RNN,RNN的改进版本,能够更好捕捉长距离依赖关系

4.transformer

(1)并行计算

(2)捕捉长距离依赖

(3)可扩展性

(4)灵活性和效果

二.transformer工作原理

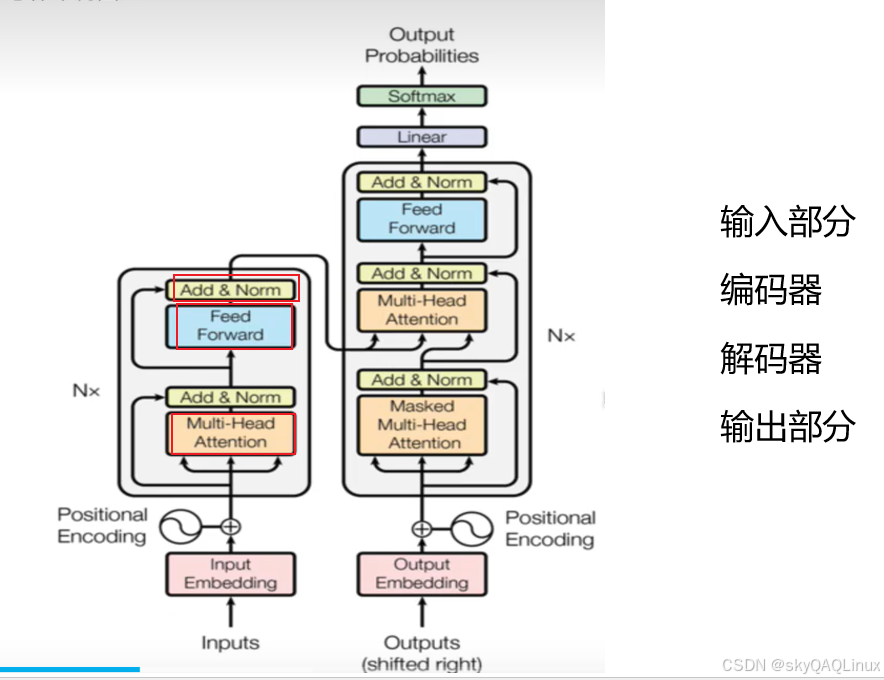

1.原理图

2.Transformer模型的生成过程可以分为以下4****个步骤:

(1)分词(Tokenization):token大模型中的最基本的处理单元

1)把汉字拆成积木(从前 / 国王 / 女儿)

(2)词嵌入(Embedding):矩阵计算

(3)注意力机制(Attention Mechanism):捕捉词之间的关联程度

1) 编码器处理:分析问题,用注意力划重点(国王和女儿的关系等)

2) 解码器处理:边编故事边查表,用注意力确保连贯

(4)最终的内容生成(Content Generation):输出结果