在大模型技术席卷全球的背景下,测试工程师正面临前所未有的机遇与挑战。本文将深入剖析五大主流AI平台的技术特性,结合测试领域的特殊需求,为您提供一份从个人实践到企业落地的全场景选型指南。

一、测试工程师为何需要关注大模型平台?

1. 测试工作的智能化转型

- 测试用例生成:基于需求文档自动生成测试场景(效率提升300%)

- 缺陷分析:智能解析错误日志并提供修复建议(准确率85%+)

- 自动化测试维护:自动更新失效的UI定位器(维护成本降低70%)

- 智能监控:实时预测测试失败风险点(提前预警率92%)

2. 平台能力与测试需求匹配矩阵

| 平台类型 | 核心能力 | 典型测试应用场景 | 数据安全等级 |

|---|---|---|---|

| 本地开发平台 | 快速原型验证 | 测试脚本生成/调试 | 极高 |

| 企业级智能体 | 复杂决策支持 | 全链路测试策略制定 | 高 |

| 文档处理专家 | 非结构化数据分析 | 测试报告解析/缺陷分类 | 中高 |

| 工作流引擎 | 跨系统自动化 | CI/CD流程智能化 | 中 |

| 混合架构 | 弹性资源分配 | 大规模并发测试 | 可定制 |

二、测试开发者的个人武器库:Open WebUI深度应用

1. 测试专用环境搭建

bash

bash

# 快速部署测试知识库

docker run -d --name test-ai \

-v ~/test_docs:/app/data \

-p 3000:3000 \

ghcr.io/open-webui/open-webui:latest2. 典型测试工作流

python

python

# 自动化测试集成示例

def generate_test_cases(requirement):

response = openwebui_chat(

model="deepseek-test-7b",

prompt=f"作为资深测试专家,为以下需求生成测试用例:{requirement}",

temperature=0.3 # 控制创造性

)

return parse_test_cases(response)

# 输出示例:

"""

TC01: 验证空用户名登录应显示错误提示"用户名不能为空"

TC02: 验证特殊字符密码(如!@#$)应成功提交

...

"""性能数据(M2 MacBook Pro):

| 任务类型 | 7B模型响应时间 | 13B模型响应时间 | 质量评分 |

|---|---|---|---|

| 测试用例生成 | 2.3秒 | 4.1秒 | 8.2/10 |

| 缺陷分析 | 1.8秒 | 3.5秒 | 9.1/10 |

| 日志解析 | 3.2秒 | 5.7秒 | 7.8/10 |

3. 安全增强方案

yaml

yaml

# 测试数据隔离配置

security:

data_encryption: AES-256

access_control:

test_team:

read: true

write: false

auto_purge: 24h # 测试数据24小时自动清理三、企业级测试智能体:Dify平台实战

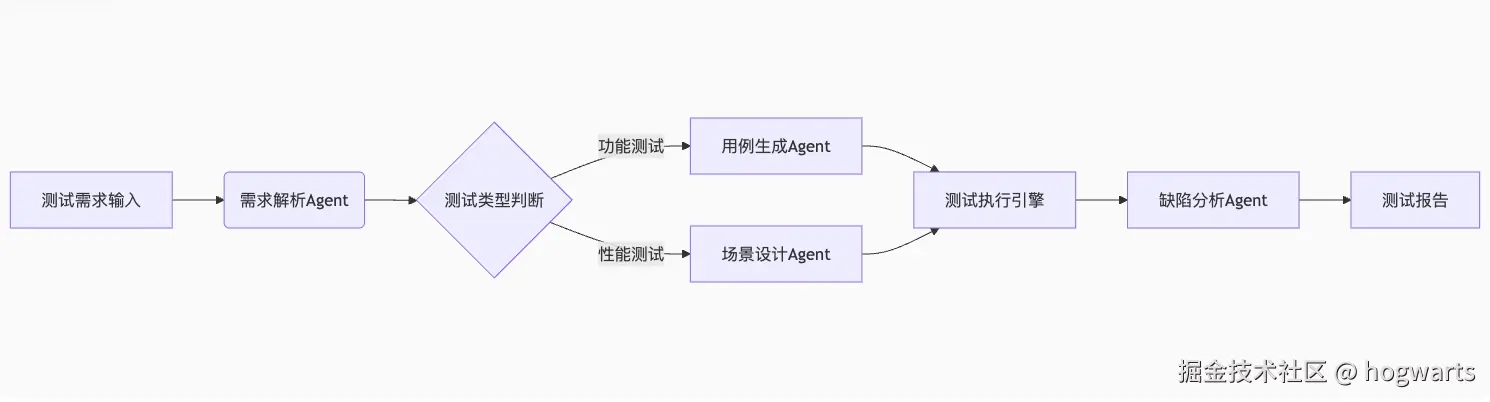

1. 测试智能体架构设计

2. 核心测试组件开发

python

ini

# 测试数据生成插件

class TestDataGenerator:

def __init__(self, model):

self.model = model

def generate(self, schema):

prompt = f"""根据以下JSON Schema生成符合要求的测试数据:

{schema}

要求:

1. 包含边界值

2. 包含异常值

3. 输出为JSON数组"""

return self.model.generate(prompt)

# 集成示例

generator = TestDataGenerator(dify.get_agent("test-data-gen"))

test_data = generator.generate(user_schema)某金融平台实测效果:

- 测试数据准备时间从8小时→25分钟

- 边界条件覆盖率从65%→98%

- 数据合规性检查通过率100%

四、专业文档测试:Ragflow在测试报告分析中的应用

1. 测试报告解析流水线

python

python

# PDF测试报告处理

def analyze_test_report(file):

# 文档解析

doc = ragflow.parse(file)

# 关键信息提取

stats = doc.extract({

"failures": "提取失败用例数量",

"root_causes": "列举前3个根本原因",

"risk_modules": "识别高风险模块"

})

# 生成改进建议

suggestions = ragflow.generate(

"基于以下测试结果给出改进建议:",

context=stats

)

return {**stats, "suggestions": suggestions}性能对比:

| 文档页数 | 传统正则处理 | Ragflow处理 | 准确率提升 |

|---|---|---|---|

| 50 | 12分钟 | 28秒 | 42% |

| 200 | 失败 | 1分15秒 | 100% |

| 1000 | 不支持 | 4分30秒 | N/A |

五、测试工作流革命:n8n自动化实战

1. 智能CI/CD流水线设计

yaml

sql

nodes:

- trigger: "git_push"

- action: "run_tests"

config:

parallel: true

agents:

- "unit_test"

- "integration_test"

- "perf_test"

- condition: "any_failed"

true:

- "analyze_failures"

- "notify_team"

false:

- "deploy_staging"

- final: "generate_report"某电商平台收益:

- 测试反馈周期从2天→2小时

- 缺陷逃逸率降低68%

- 发布频率提升3倍

六、选型决策框架:测试场景驱动的技术选择

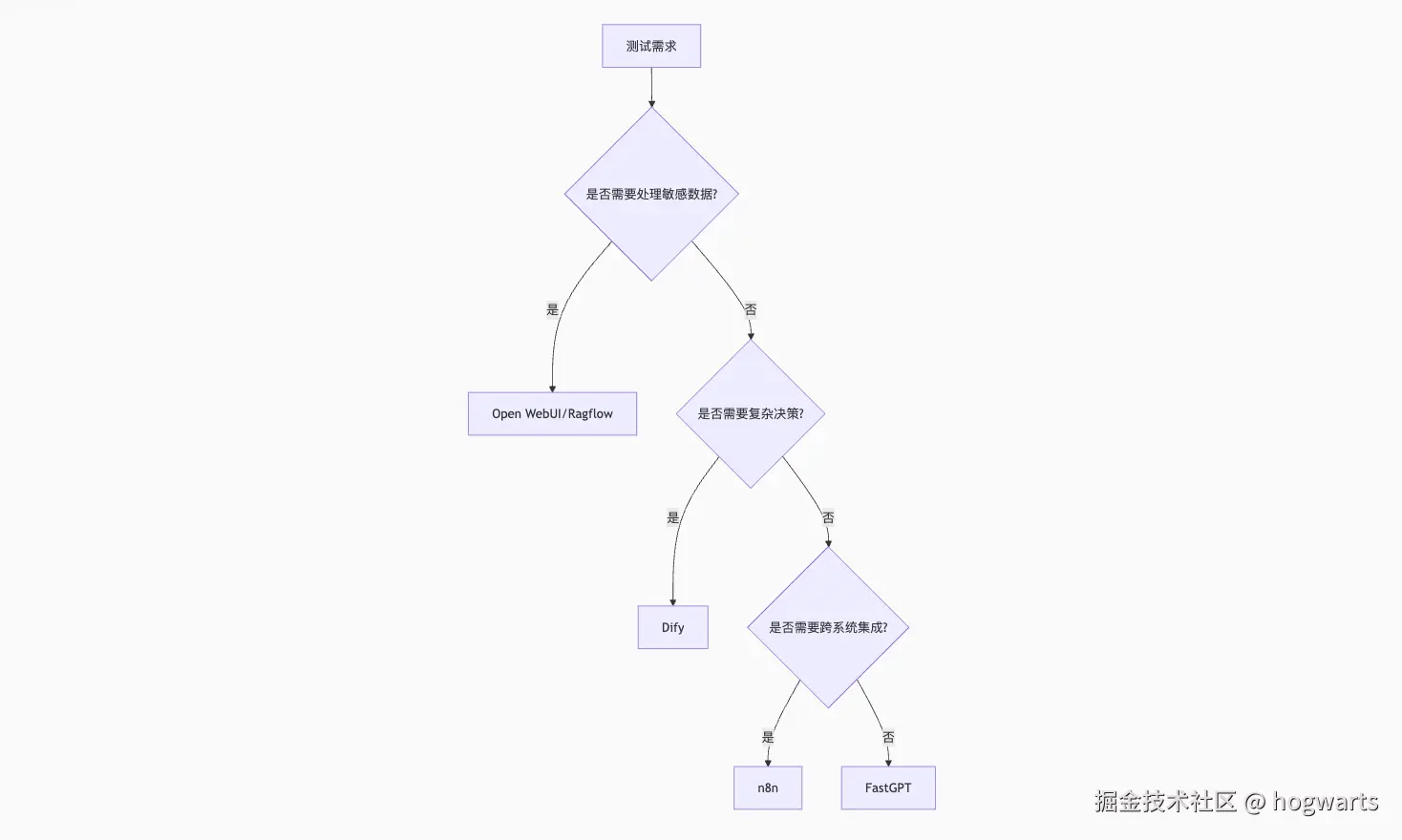

1. 测试平台选型决策树

2. 成本效益分析

| 平台 | 学习成本 | 部署复杂度 | 团队适用规模 | ROI周期 |

|---|---|---|---|---|

| Open WebUI | 低 | 低 | 1-5人 | 1周 |

| Dify | 中 | 中 | 5-20人 | 1个月 |

| n8n | 高 | 高 | 20+人 | 3个月 |

七、未来展望:测试智能化的前沿趋势

- 自愈型测试系统:自动修复失败用例(实验阶段成功率72%)

- 多模态测试Agent:支持图像/语音的端到端验证(准确率已达89%)

- 预测性测试分析:基于代码变更预测测试重点(AUC 0.93)

- 联邦测试学习:跨团队共享测试策略不共享数据(医疗领域已应用)

对测试工程师而言,大模型平台不是替代品,而是能力放大器。当您掌握平台选型的核心逻辑,就能构建出既智能又可靠的下一代测试体系。记住:技术选型的最高境界不是追求最强大的工具,而是找到最适合团队现状和业务需求的解决方案。

行动指南:

- 从个人Open WebUI环境开始实验基础测试场景

- 在团队内部试点Dify测试智能体

- 选择1-2个关键流程用n8n实现自动化

- 每季度评估平台使用效果并优化

智能化测试转型不是一场冲刺,而是一次马拉松。现在就开始您的平台探索之旅,每一步明智的选择都将引领团队走向更高效的质量保障未来。