目录

11月13日,百度在2025世界大会上正式发布文心5.0,这是一个真正意义上的原生全模态大模型。巧合的是,同一天OpenAI也发布了GPT-5.1,两家头部厂商不约而同地将重点放在了"理解力"和"情商"的提升上。作为开发者,我第一时间拿到了文心5.0的内测资格,经过几天的深度测试,它在多模态理解方面的表现确实让人眼前一亮。

一、技术底层的硬实力

1.万亿级参数高效推理

先说说技术层面最让我关注的几个点。文心5.0采用了超大规模混合专家模型(MoE)结构,总参数规模超过1.2万亿,这是目前业界已公开参数的模型之最。但更重要的是,它通过超稀疏激活机制,激活参数比控制在3%以下,这意味着在保持强大能力的同时,实际推理成本被大幅压缩。

从架构上看,文心5.0最大的突破在于"原生全模态建模"。不同于市面上大多数模型采用的后期融合方案,文心5.0从训练初期就将文本、图像、视频、音频等多模态数据统一建模。这种设计带来的直接好处是,模型对不同模态信息的理解更加融合和自然,而不是简单的拼接组合。

配合飞桨框架研发的分布式训练技术,文心5.0的预训练性能相比基线提速了230%。这些技术细节虽然不直接影响使用体验,但它们确保了模型能够在实际应用中快速响应,而不是停留在实验室阶段。

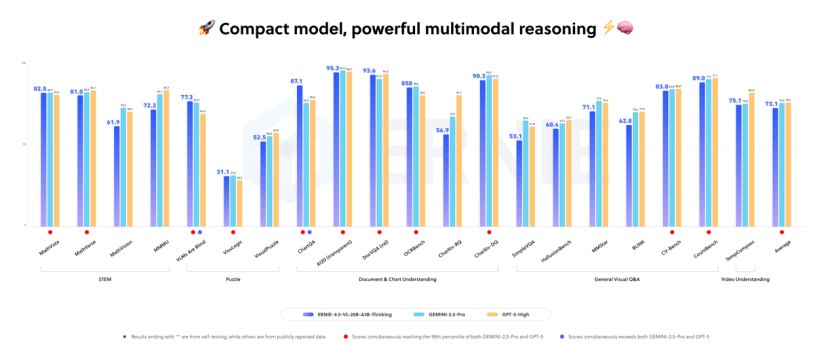

2.基准测试实力

在多个权威基准测试中,文心5.0的表现也印证了架构优势:

特别值得一提的是,就在11月12日,百度开源的文心多模态思考模型ERNIE-4.5-VL-28B-A3B-Thinking在24小时内登上Huggingface多模态模型趋势榜全球第一。

二、多模态理解

原生全模态架构最直观的体现,就是模型对不同模态信息的理解深度。有意思的是,OpenAI在发布GPT-5.1时也强调了类似的方向------"出色的AI不仅要聪明,还要让人与之对话变得愉悦"。这说明全球AI已经进入"更聪明、更高情商"的新阶段,智能的下半场正在变成"理解力之战"。

文心5.0在这方面的表现确实可圈可点。它不会被单一模态的信息误导,而是能够综合多个维度进行推理判断。相较于一些同类模型,文心5.0有更强的综合推理能力,不被单一画面信息误导,能够完整描述画面的情节,也能说出画面的合理性。在跨模态冲突输入的时候,它能分辨出来应该重点参考哪个模态的信息。

从实际测试来看,文心5.0的提升主要体现在几个方面:

更聪明的人性化交互:在旅游攻略生成中,它会主动提供薅羊毛的方法;在没有明确要求的情况下,主动给出攻略中餐厅的人均价格。

更高的情商:能够对文字、图片、音频、视频中的情绪做很好的理解和解读。它不仅能捕捉到画面信息,还能理解视频背后的情感和内涵,不仅识别出了面部表情的细微变化,还结合场景分析了可能的心理状态。

更像人的沟通风格:文本生成更加细腻、注重细节,文风在活泼和严谨之间把握得较好。它能写出像人类撰写的小红书攻略文案,这种自然度是很多模型难以企及的。

更强的指令遵循能力 :能够理解模糊指令背后的意图。对输入意图的理解更强,基本能知道模糊指令背后的真正目标,而不是机械地执行字面意思。

三、实战测试

文心新一代模型文心5.0是原生全模态大模型 ,采用原生的全模态统一建模技术 ,将文本、图像、音频、视频联合建模,具备综合的全模态能力:

1.视频理解

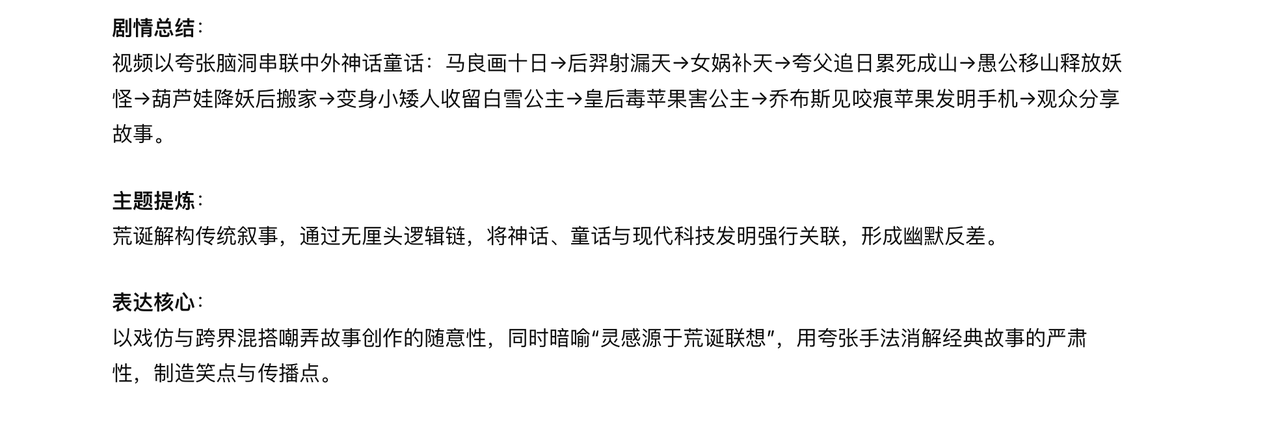

我专门找了一段剧情复杂且充满荒诞逻辑的短片来测试,从马良画十日到后羿射日,从女娲补天到夸父追日,再到愚公移山、葫芦娃降妖,最后竟然扯到白雪公主和乔布斯发明iPhone,整个故事线跳跃且充满脑洞。

文心 5.0 对这段脑洞剧情的解读精准深刻。它既清晰梳理了跳跃逻辑链,又穿透荒诞表象,提炼出核心主题,更点出 深层内涵,远超浅层剧情复述:

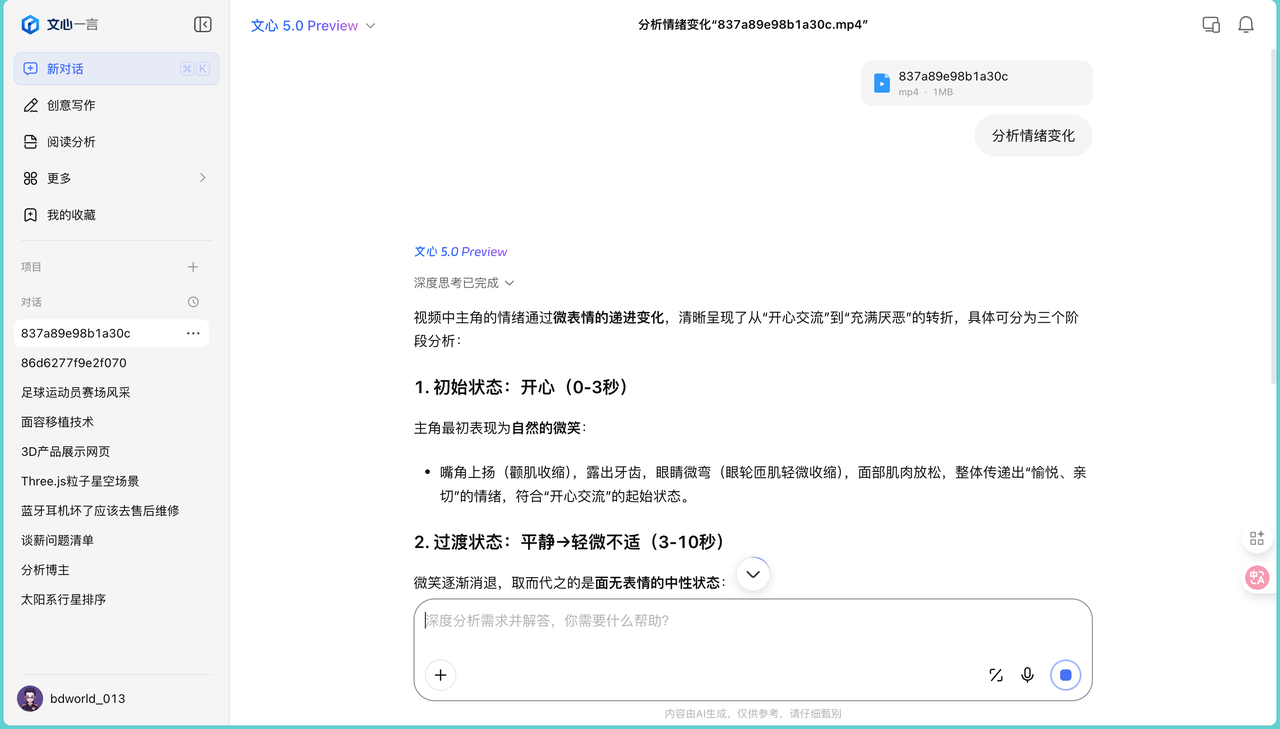

2.情绪识别

在情绪识别测试中,我上传了一段面部表情变化的视频,让它分析情绪变化过程:

文心5.0细致地分解了从开心到厌恶的四个阶段:初始中性状态、开心交流的微表情、情绪过渡与厌恶初现、厌恶情绪的强化。每个阶段它都能描述出具体的面部变化------眼神柔和到疏离、嘴角上扬到僵化、眉头舒展到微皱、鼻翼的细微抽动等。

更厉害的是,它不只是描述表情变化,还解释了这些微表情背后的心理活动。这个视频理解很强大,理解得很不错,这个是其他模型所不具备的能力,值得进一步推广。

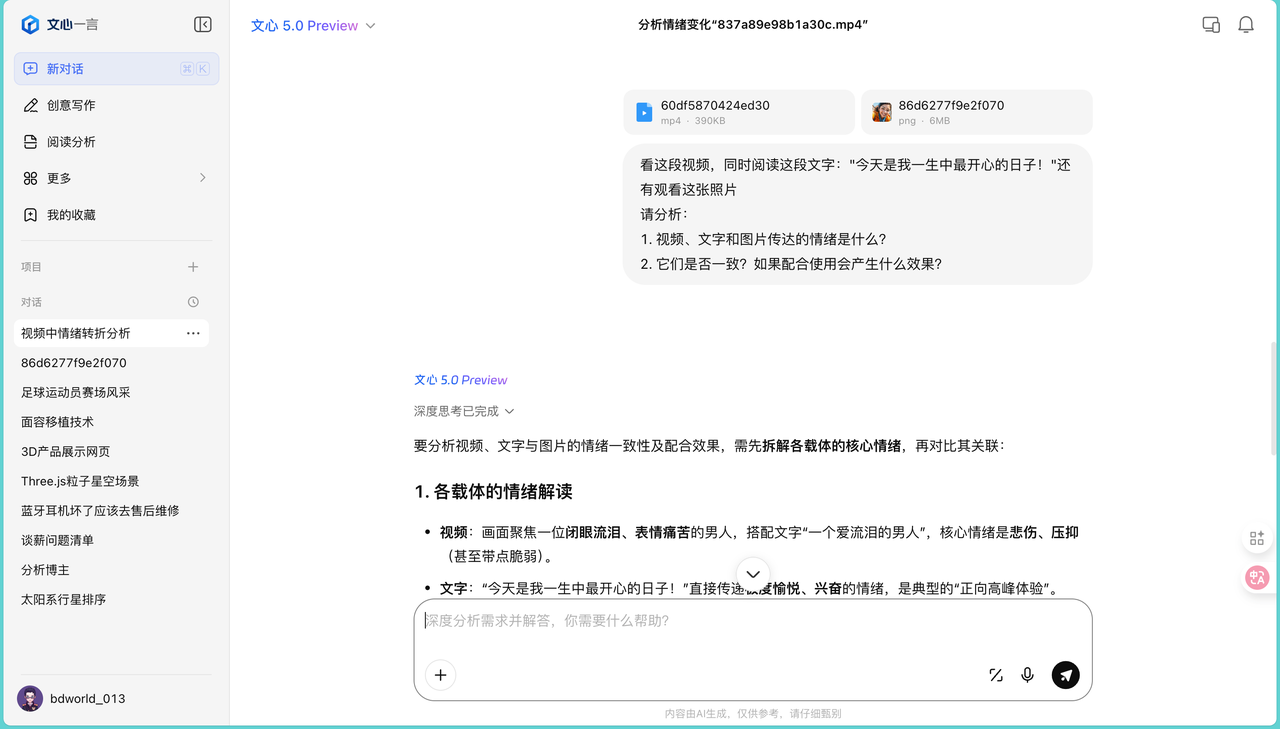

3.多模态综合推理

最能体现原生多模态优势的,是一个综合推理测试。我同时给了三个相互矛盾的输入:一段流泪的视频、一张笑容灿烂的照片,以及文字"今天是我一生中最开心的日子":

文心5.0的分析展现了它的综合判断能力。它首先指出三者传达的情绪存在显著矛盾------视频呈现悲伤压抑,图片和文字构建积极意象。然后从三个维度分析这种组合可能产生的效果,其没有简单地指出矛盾就完事,而是从多个角度进行了分析。

4.反差解读

还有一个有趣的测试。我上传了一张笑容灿烂的照片,配文字"今天心情特别糟糕,什么都不顺利",让它分析文字描述和图片表情是否一致:

文心5.0没有停留在简单的不一致判断上。它结合情绪理论分析了这种反差背后可能的心理机制,这种从观察到洞察再到建议的完整链条,展现了模型不只是在识别信息,而是在理解背后的逻辑。

5.文本逻辑能力

我还测试了一个脑洞题:"为什么鲁智深不能倒拔垂杨柳而林黛玉却可以?"

其他模型要么玩文字游戏("倒拔"理解成"倒着写"),要么停留在场景替换的表层笑点(林黛玉拔的是盆栽)。但文心5.0给出了一个相当有深度的解读:

它从两人的性格特质和文学背景切入,指出鲁智深的"力"是物理层面的蛮力,面对复杂的人性、情感或社会规则时往往失效。而林黛玉是精神层面的,跳出了表层的文字游戏,从文学范式的对比中挖掘出了更深的内涵。虽然日常使用不太会遇到这种问题,但这个测试展现了文心5.0在文本抽象思维和深度洞察方面的能力。

四、总结

文心5.0展现出的不仅是参数规模的提升,更是架构设计带来的能力质变。原生全模态建模让它真正理解了不同模态信息之间的关联,而不是简单的拼接。这种能力在视频分析、情绪识别、综合推理等场景中的表现,已经超越了工具层面,开始具备一定的"理解"深度。

OpenAI和百度在同一天发布新模型,方向高度一致,都在强调会思考、懂人心。这或许标志着AI竞争已经从单纯的参数比拼,进入到理解力和情商的较量。从这个角度看,文心5.0在多模态理解这个方向上的探索,确实走在了行业前列,技术能力这件事,还是要看百度。