1.k8s用途

kubernetes的本质是一组服务器集群,它可以在集群的每个节点上运行特定的程序,来对节点中的容器 进行管理。目的是实现资源管理的自动化,主要提供了如下的主要功能:

自我修复:一旦某一个容器崩溃,能够在1秒中左右迅速启动新的容器

弹性伸缩:可以根据需要,自动对集群中正在运行的容器数量进行调整

服务发现:服务可以通过自动发现的形式找到它所依赖的服务

负载均衡:如果一个服务起动了多个容器,能够自动实现请求的负载均衡

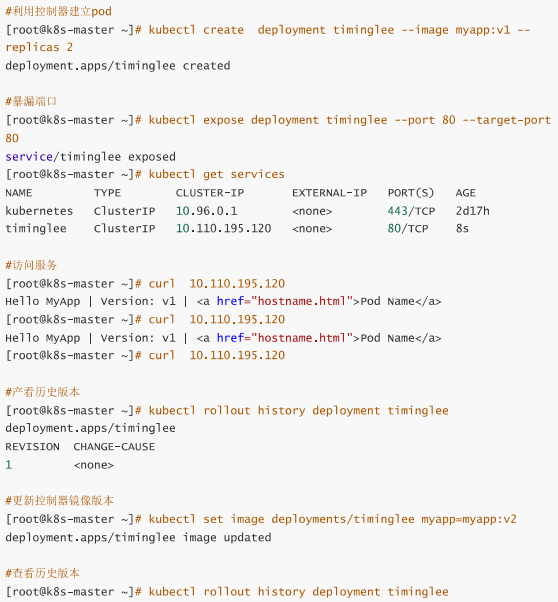

版本回退:如果发现新发布的程序版本有问题,可以立即回退到原来的版本

存储编排:可以根据容器自身的需求自动创建存储

2.k8s节点

一个kubernetes集群主要是由控制节点(master)、工作节点(node)构成,每个节点上都会安装不同的组件

1.master:集群的控制平面,负责集群的决策

ApiServer : 资源操作的唯一入口,接收用户输入的命令,提供认证、授权、API注册和发现等机制 Scheduler : 负责集群资源调度,按照预定的调度策略将Pod调度到相应的node节点上 ControllerManager : 负责维护集群的状态,比如程序部署安排、故障检测、自动扩展、滚动更新 等

Etcd :负责存储集群中各种资源对象的信息

2.node:集群的数据平面,负责为容器提供运行环境

kubelet:负责维护容器的生命周期,同时也负责Volume(CVI)和网络(CNI)的管理

Container runtime:负责镜像管理以及Pod和容器的真正运行(CRI)

kube-proxy:负责为Service提供cluster内部的服务发现和负载均衡

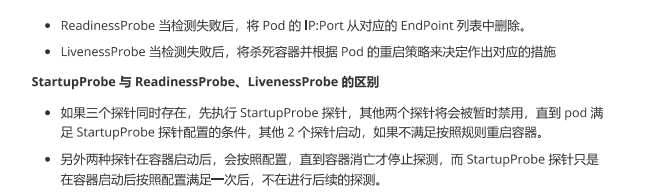

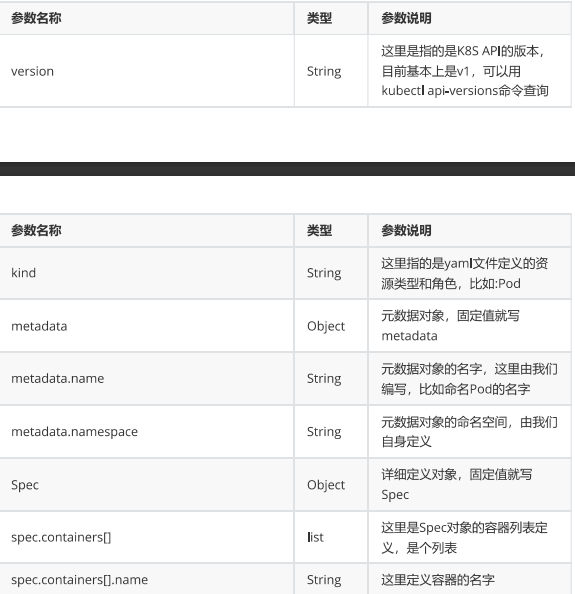

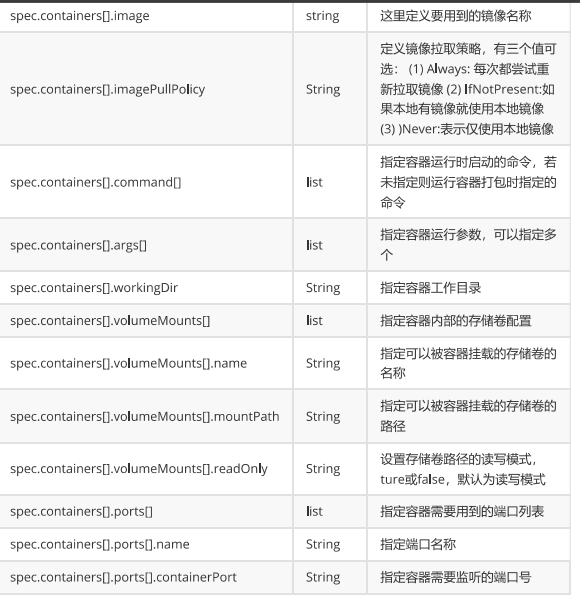

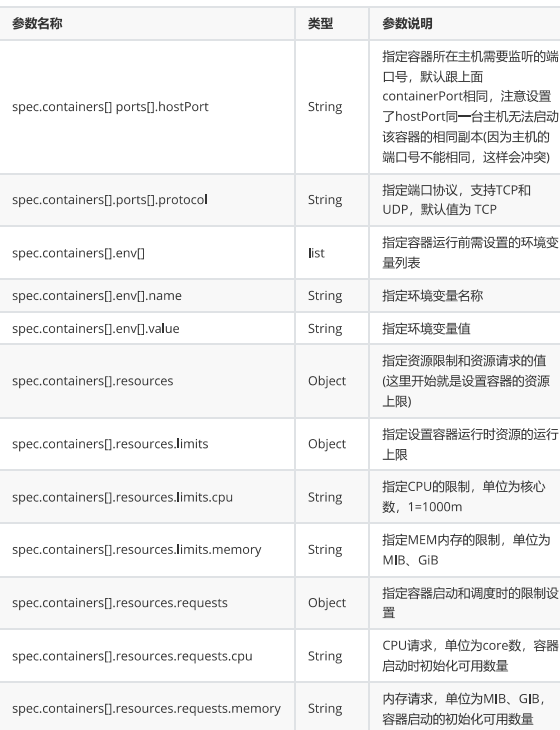

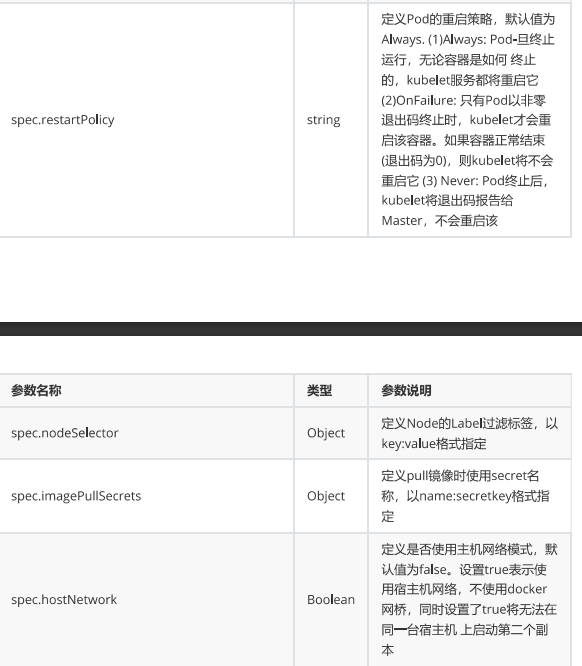

3.K8S 的 常用名词感念

4.k8s环境部署

k8s有多种部署方式,主流的有kubeadm minikube 二进制包

① minikube:一个用于快速搭建单节点的kubernetes工具。

●② kubeadm:一个用于快速搭建kubernetes集群的工具。

●③ 二进制包:从官网上下载每个组件的二进制包,依次去安装,此方式对于理解kubernetes组件更加有效。

本次环境搭建需要三台CentOS服务器(一主二从),然后在每台服务器中分别安装Docker(18.06.3)、kubeadm(1.18.0)、kubectl(1.18.0)和kubelet(1.18.0)。

master 192.168.83.201 node1 192.168.83.170 node2 192.168.83.180

4.1环境初始化

1.cat /etc/redhat-release #检查操作系统的版本 要求操作系统版本必须在7.5以上

所有节点都需要执行的操作:

2.#关闭火墙和关闭火墙开机启动

systemctl stop firewalld

systemctl disable firewalld

3.#做地址解析

cat /etc/hosts

192.168.83.201 master

192.168.83.170 node1

192.168.83.180 node2

4.#做时间同步

vi /etc/chorny.conf

server 192.168.83.201 iburst

server 192.168.83.170 iburst

server 192.168.83.180 iburst

5.#关闭selinux

getenforce #查看是否开启

setenforce 0 #临时关闭

sed -i 's/^SELINUX=enforcing/SELINUX=disabled/' /etc/selinux/config #永久关闭但是需要reboot

6.#禁用swap分区

systemctl mask swap.target

swapoff -a #临时关闭swap分区

sed -ri 's/.*swap.*/#&/' /etc/fstab #永久关闭分区 但是需要重启

7.将桥接的IPv4流量传递到iptables的链(每个节点都得进行)

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

vm.swappiness = 0

EOF

加载br_netfilter模块

modprobe br_netfilter

生效 sysctl --system

8.开启ipvs

在kubernetes中service有两种代理模型,一种是基于iptables,另一种是基于ipvs的。ipvs的性能要高于iptables的,但是如果要使用它,需要手动载入ipvs模块。

●在每个节点安装ipset和ipvsadm:

yum -y install ipset ipvsadm

在所有节点执行如下脚本:

cat > /etc/sysconfig/modules/ipvs.modules <<EOF

#!/bin/bash

modprobe -- ip_vs

modprobe -- ip_vs_rr

modprobe -- ip_vs_wrr

modprobe -- ip_vs_sh

modprobe -- nf_conntrack_ipv4

EOF

授权、运行、检查是否加载:

chmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules && lsmod | grep -e ip_vs -e nf_conntrack_ipv4

检查是否加载:

lsmod | grep -e ipvs -e nf_conntrack_ipv4

9.每个节点安装Docker、kubeadm、kubelet和kubectl

安装Docker:

wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repo

yum -y install docker-ce-18.06.3.ce-3.el7

systemctl enable docker && systemctl start docker

docker version #查看docker版本

然后可以在/etc/docker/daemon.json 配置docker镜像加速器 方便拉取镜像

sudo systemctl daemon-reload

sudo systemctl restart docker

添加阿里云的YUM软件源

由于kubernetes的镜像源在国外,非常慢,这里切换成国内的阿里云镜像源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

kubernetes

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

安装kubeadm、kubelet和kubectl

yum install -y kubelet-1.18.0 kubeadm-1.18.0 kubectl-1.18.0

为了实现Docker使用的cgroup drvier和kubelet使用的cgroup drver一致,建议修改"/etc/sysconfig/kubelet"文件的内容:

vim /etc/sysconfig/kubelet

修改 KUBELET_EXTRA_ARGS="--cgroup-driver=systemd"

KUBE_PROXY_MODE="ipvs"

systemctl enable kubelet # 设置开机自启动

部署master节点

由于默认拉取镜像地址k8s.gcr.io国内无法访问,这里需要指定阿里云镜像仓库地址

kubeadm init \

--apiserver-advertise-address=192.168.18.100 \ #master节点 ip

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.18.0 \

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16

根据提示消息,在Master节点上使用kubectl工具:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown (id -u):(id -g) $HOME/.kube/config

部署k8s的Node节点

根据提示,在node节点服务器添加类似如下信息:

kubeadm join 192.168.18.100:6443 --token jv039y.bh8yetcpo6zeqfyj \

--discovery-token-ca-cert-hash sha256:3c81e535fd4f8ff1752617d7a2d56c3b23779cf9545e530828c0ff6b507e0e26

在master 节点执行生成 token 加入节点

kubeadm token create --print-join-command

10部署网络CNI插件

据提示,在Master节点上使用kubectl工具查看节点状态:

kubectl get nodes

kubernetes支持多种网络插件,比如flannel、calico、canal等,

我这是是提前下载好的flannel.yaml文件

直接执行 kubectl apply -f flannel.yaml

kubectl命令自动补全设置

yum install -y bash-completion

source /usr/share/bash-completion/bash_completion

source <(kubectl completion bash)

echo "source <(kubectl completion bash)" >> ~/.bashrc

vim /root/.bashrc

source /usr/share/bash-completion/bash_completion

source <(kubectl completion bash)

5.k8s资源管理

在Kubernetes中,所有的内容都抽象为资源,用户需要通过操作资源来管理Kubernetes。

Kubernetes的本质就是一个集群系统,用户可以在集群中部署各种服务。所谓的部署服务,其实就是在Kubernetes集群中运行一个个的容器,并将指定的程序跑在容器中。

●Kubernetes的最小管理单元是Pod而不是容器,所以只能将容器放在Pod中,而Kubernetes一般也不会直接管理Pod,而是通过Pod控制器来管理Pod的。

●Pod提供服务之后,就需要考虑如何访问Pod中的服务,Kubernetes提供了Service资源实现这个功能。

●当然,如果Pod中程序的数据需要持久化,Kubernetes还提供了各种存储系统

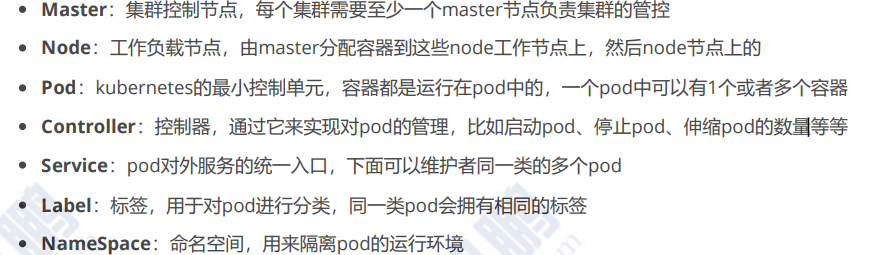

5.1资源管理方式

k8s资源管理方式有三种:

命令式对象管理:直接使用命令去操作kubernetes的资源。

kubectl run nginx-pod --image=nginx:1.17.1 --port=80 #直接创建一个pod并指定运行nginx容器

命令式对象配置:通过命令配置和配置文件去操作kubernetes的资源。

kubectl create/patch -f nginx-pod.yaml

声明式对象配置:通过apply命令和配置文件去操作kubernetes的资源。

kubectl apply -f nginx-pod.yaml

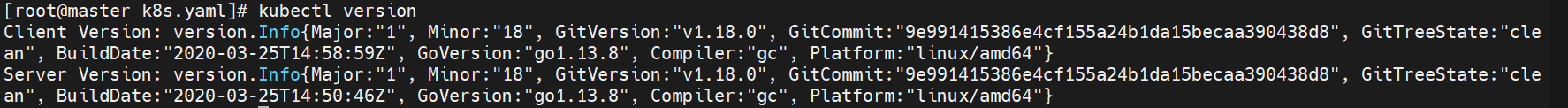

5.2基本命令式例

kubectl version #显示集群版本信息

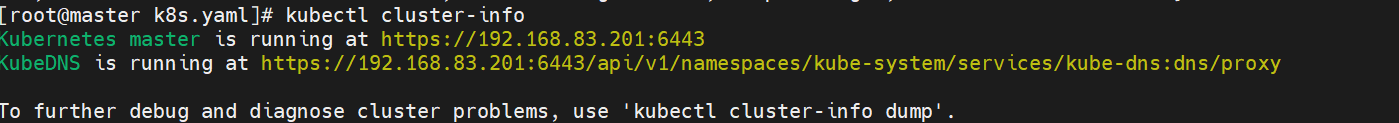

kubectl cluster-info #显示集群信息

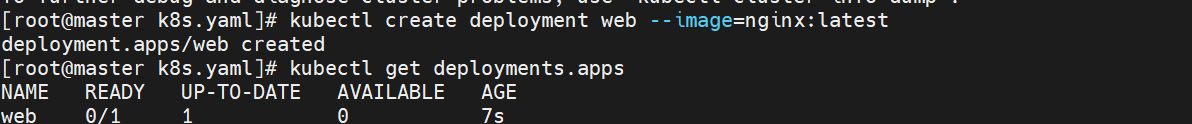

kubectl create deployment web --image=nginx:latest #创建一个web控制器

更高k8s版本可以通过 --replicas 2 来指定控制器中的pod数量

kubectl get deployments.apps #查看控制器信息

kubectl explanin deployment # 查看资源帮助

kubectl explain deployment.spec #查看控制器参数帮助

kubectl edit deployments.apps web -o yaml 以yaml的形式输出deployment的信息

kubectl edit deployment.apps web 修改yaml

#端口暴露:先启动pod 然后再暴露端口

kubectl run testpod --image reg.timinglee.org/pod/nginx

kubectl expose pod testpod --port 80 --target-port 80 通过暴露端口可以实现对外访问

kubectl logs pods/testpod 查看这个端口的日志

kubectl run -it testpod --image busybox #运行交互pod

kubectl run nginx --image nginx # 运行非交互pod

kubectl attach pods/testpod -it # 进入已经运行的容器 且容器有交互环境

5.3高级命令示例

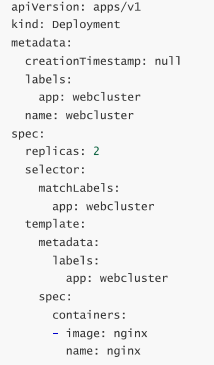

使用命令生成yaml 模板文件

kubectl create deploment --image nginx webcluster --dry-run=client -o yaml > webcluster.yaml

kubcectl apply -f webcluster.yaml

kubectl delete -f webcluster.yaml

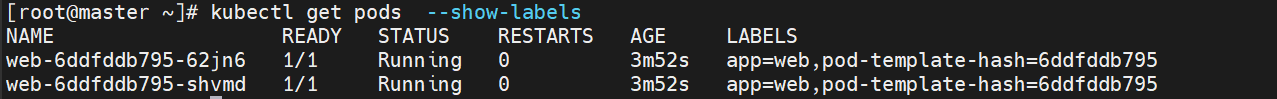

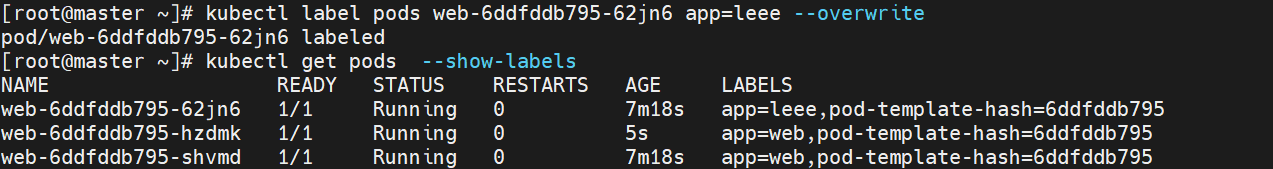

###控制器会通过pod的标签去弹性伸缩pod数量

如图pod labels为web

kubectl label pods web-6ddfddb795-62jn6 app=lee --overwrite #改一个pod标签为

由于指定了replicas此时deploment控制器会发现 少一个副本数量

于是会添加一个pods服务于web

6.k8s中的pod

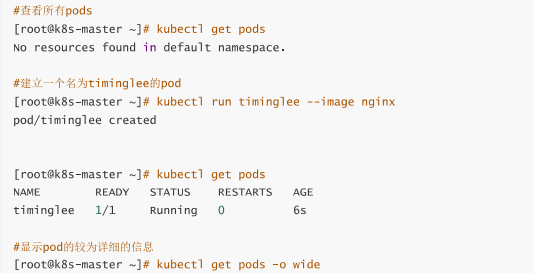

k8s最小控制单元pod

一个pod代表着集群中运行的一个进程,每一个pod都有唯一的一个ip

一个pod类似一个豌豆荚,包含一个或多个容器

多个容器共享ipc,Network和UTC namesoace

6.1创建自主式pod(不推荐)

6.2利用控制器管理pod(推荐)

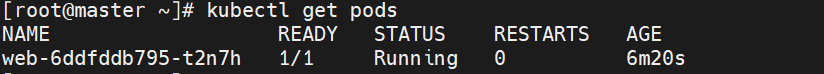

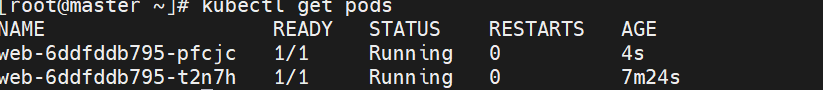

6.2.1 扩缩容

kubectl create deploment web ---image nginx

#给web扩容

kubectl scale deployment web --replicas 2

给web缩容

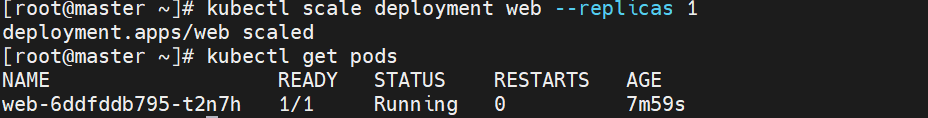

6.2.2应用版本更新

6.3利用yaml文件部署应用

kubectl explain pod.spec.containers #查看资源帮助

6.4 pod的生命周期

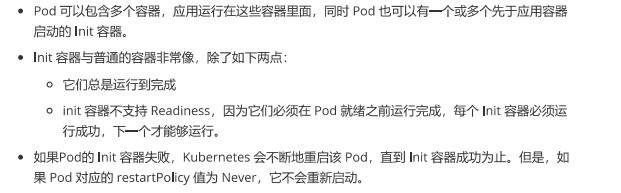

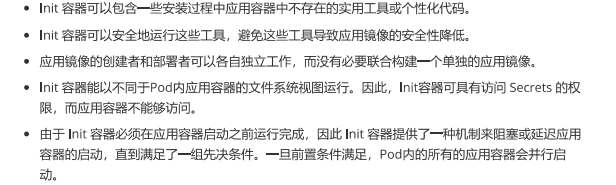

Init容器: 主要功能在启动pod前先执行init容器 作为一个判断条件 当条件满足时候才能启动pod

或者作为运行pod环境里需要的一些东西

(通俗易懂的讲就是说initpod执行起来才会执行pod容器

init容器的功能

执行该pod先执行initContainers 等该模块符合条件了 才会执行containers启动这个pod

执行该pod先执行initContainers 等该模块符合条件了 才会执行containers启动这个pod

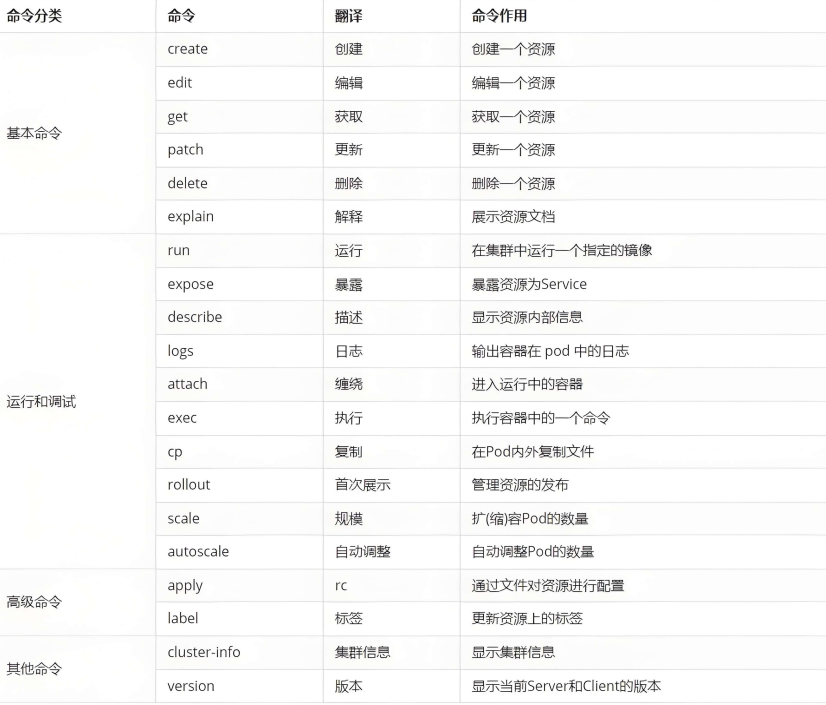

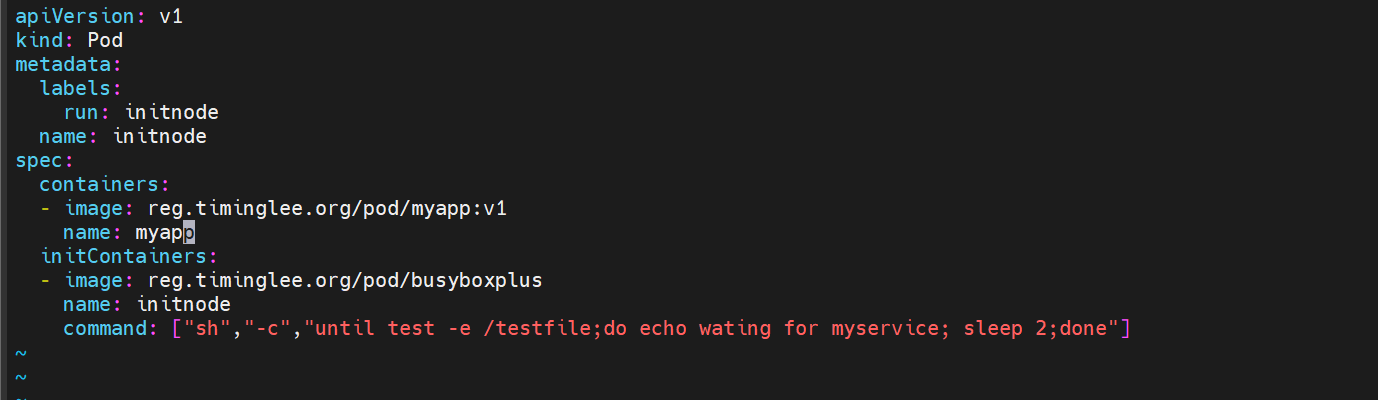

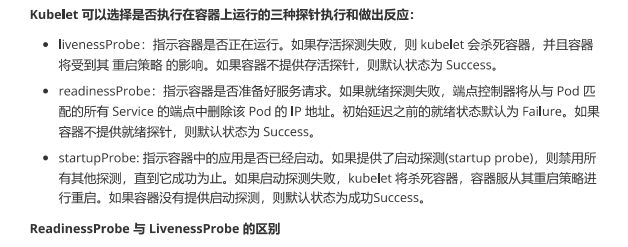

6.5pod的探针

检测pod运行情况是怎么样的

7.k8s中控制器

控制器也是管理pod的一种手段

-

自主式pod:pod退出或意外关闭后不会被重新创建

-

控制器管理的 Pod:在控制器的生命周期里,始终要维持 Pod 的副本数目

Pod控制器是管理pod的中间层,使用Pod控制器之后,只需要告诉Pod控制器,想要多少个什么样的Pod就可以了,它会创建出满足条件的Pod并确保每一个Pod资源处于用户期望的目标状态。如果Pod资源在运行中出现故障,它会基于指定策略重新编排Pod

当建立控制器后,会把期望值写入etcd,k8s中的apiserver检索etcd中我们保存的期望状态,并对比pod的当前状态,如果出现差异代码自驱动立即恢复

| 控制器名称 | 控制器用途 |

|---|---|

| Replication Controller | 比较原始的pod控制器,已经被废弃,由ReplicaSet替代 |

| ReplicaSet | ReplicaSet 确保任何时间都有指定数量的 Pod 副本在运行 |

| Deployment | 一个 Deployment 为 Pod 和 ReplicaSet 提供声明式的更新能力 |

| DaemonSet | DaemonSet 确保全指定节点上运行一个 Pod 的副本 |

| StatefulSet | StatefulSet 是用来管理有状态应用的工作负载 API 对象。 |

| Job | 执行批处理任务,仅执行一次任务,保证任务的一个或多个Pod成功结束 |

| CronJob | Cron Job 创建基于时间调度的 Jobs。 |

| HPA全称Horizontal Pod Autoscaler | 根据资源利用率自动调整service中Pod数量,实现Pod水平自动缩放 |

无状态pod 每重启一次 都换一个id

有状态pod 被记录着 始终是保持一个id

7.1replicaset控制器

-

ReplicaSet 是下一代的 Replication Controller,官方推荐使用ReplicaSet

-

ReplicaSet和Replication Controller的唯一区别是选择器的支持,ReplicaSet支持新的基于集合的选择器需求

-

ReplicaSet 确保任何时间都有指定数量的 Pod 副本在运行

-

虽然 ReplicaSets 可以独立使用,但今天它主要被Deployments 用作协调 Pod 创建、删除和更新的机制

| 参数名称 | 字段类型 | 参数说明 |

|---|---|---|

| spec | Object | 详细定义对象,固定值就写Spec |

| spec.replicas | integer | 指定维护pod数量 |

| spec.selector | Object | Selector是对pod的标签查询,与pod数量匹配 |

| spec.selector.matchLabels | string | 指定Selector查询标签的名称和值,以key:value方式指定 |

| spec.template | Object | 指定对pod的描述信息,比如lab标签,运行容器的信息等 |

| spec.template.metadata | Object | 指定pod属性 |

| spec.template.metadata.labels | string | 指定pod标签 |

| spec.template.spec | Object | 详细定义对象 |

| spec.template.spec.containers | list | Spec对象的容器列表定义 |

| spec.template.spec.containers.name | string | 指定容器名称 |

| spec.template.spec.containers.image | string | 指定容器镜像 |

replicaset 时刻保持pod按照replicas在运行

实质是deployment 的一个分支版本 是通过labels去控制pod数量

#生成yml文件

root@k8s-master \~\]# kubectl create**deployment replicaset** --image myapp:v1 --dry-run=client -o yaml \> replicaset.yml

\[root@k8s-master \~\]# vim replicaset.yml

apiVersion: apps/v1

**kind: ReplicaSet #yaml文件创建出来要更改此处类型**

metadata:

name: replicaset #指定pod名称,一定小写,如果出现大写报错

spec:

replicas: 2 #指定维护pod数量为2

selector: #指定检测匹配方式

matchLabels: #指定匹配方式为匹配标签

app: myapp #指定匹配的标签为app=myapp

template: #模板,当副本数量不足时,会根据下面的模板创建pod副本

metadata:

labels:

app: myapp

spec:

containers:

- image: myapp:v1

name: myapp

\[root@k8s-master \~\]# kubectl apply -f replicaset.yml

replicaset.apps/replicaset created

#replicaset是通过标签匹配pod

\[root@k8s-master \~\]# kubectl label pod replicaset-l4xnr app=timinglee --overwrite

pod/replicaset-l4xnr labeled

\[root@k8s-master \~\]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

replicaset-gd5fh 1/1 Running 0 2s app=myapp #新开启的pod

replicaset-l4xnr 1/1 Running 0 3m19s app=timinglee

replicaset-t2s5p 1/1 Running 0 3m19s app=myapp

#恢复标签后

\[root@k8s2 pod\]# kubectl label pod replicaset-example-q2sq9 app-

\[root@k8s2 pod\]# kubectl get pod --show-labels

NAME READY STATUS RESTARTS AGE LABELS

replicaset-example-q2sq9 1/1 Running 0 3m14s app=nginx

replicaset-example-th24v 1/1 Running 0 3m14s app=nginx

replicaset-example-w7zpw 1/1 Running 0 3m14s app=nginx

##### 7.2deploment控制器

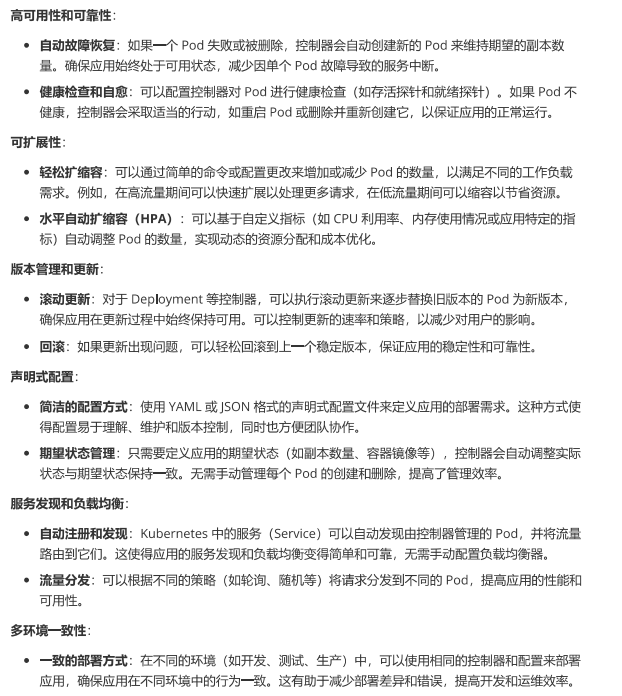

* 为了更好的解决服务编排的问题,kubernetes在V1.2版本开始,引入了Deployment控制器。

* Deployment控制器并不直接管理pod,而是通过管理ReplicaSet来间接管理Pod

* Deployment管理ReplicaSet,ReplicaSet管理Pod

* Deployment 为 Pod 和 ReplicaSet 提供了一个申明式的定义方法

* 在Deployment中ReplicaSet相当于一个版本

* **典型的应用场景:**

* 用来创建Pod和ReplicaSet

* 滚动更新和回滚

* 扩容和缩容

* 暂停与恢复

例子:

###### 7.2.1版本更新

\[root@k8s-master \~\]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

deployment-5d886954d4-2ckqw 1/1 Running 0 2m40s 10.244.2.14 k8s-node2 \