引言:当人形机器人接入毫秒级视觉神经元

2024--2025 年,人形机器人正经历一场由"原型验证"向"规模化应用"的关键跨越。无论是特斯拉 Optimus、Figure 02、Unitree H1,还是国内多家新锐厂商的多自由度人形机器人,已经从单纯展示步态和动作,进化到融合全身 30+ 自由度控制、立体视觉与深度感知、多模态 AI 决策的综合智能体。

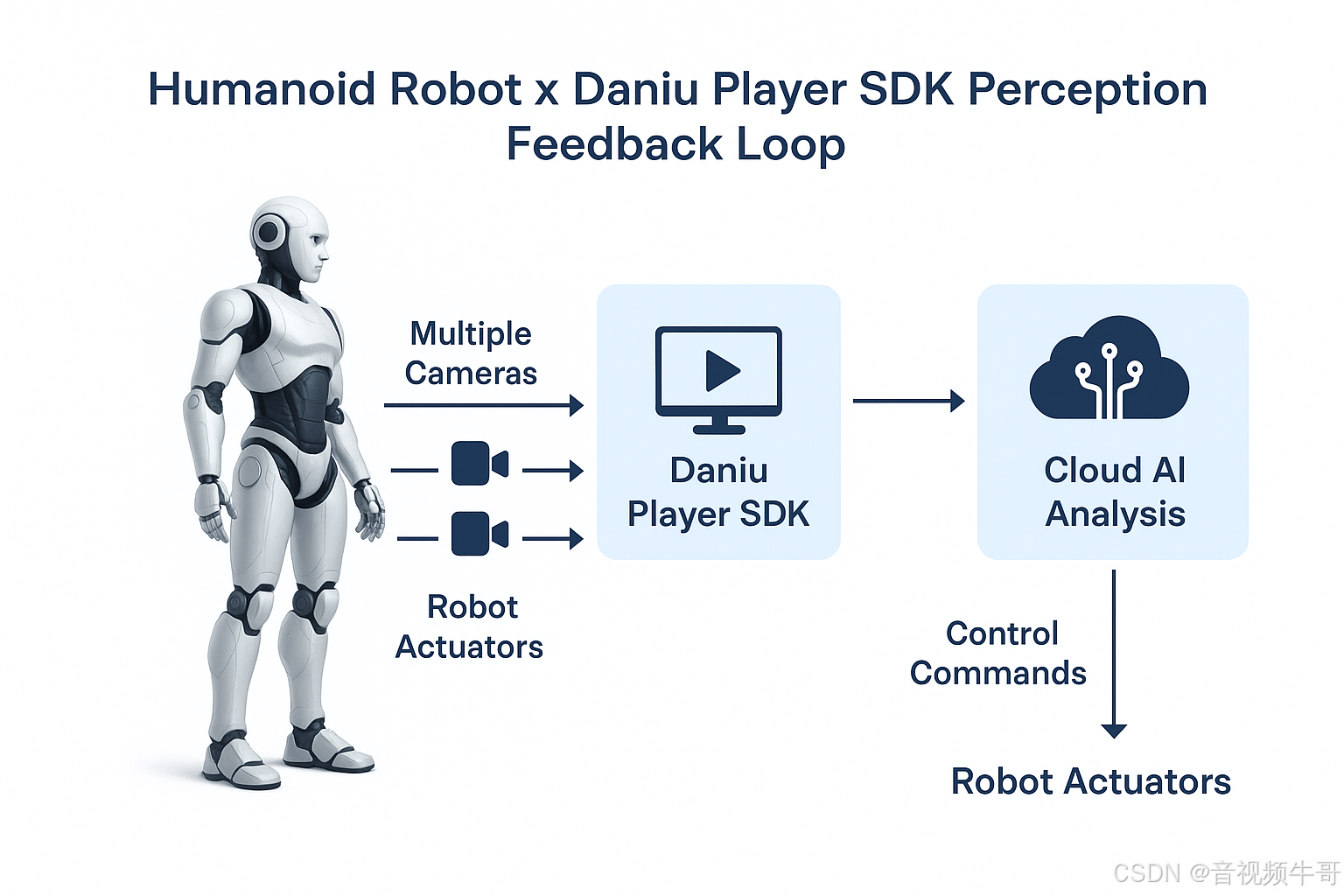

在这一演进中,机器人的感知与执行不再是孤立环节,而是需要通过低延迟、稳定、可编排的视频链路,与云端计算、远程控制、AI 推理形成闭环。尤其是在工业巡检、应急救援、智慧物流等场景中,延迟哪怕增加 200ms,都可能导致抓取失败、路径规划失效,甚至引发安全风险。

这正是大牛直播SDK 与人形机器人结合的切入点------其跨平台、毫秒级延迟、弱网自适应的 RTSP / RTMP / GB28181 实时视频传输能力,能够让机器人接入**"毫秒级视觉神经元"**:

-

将机器人端多路摄像头(双目、全景、关节端)的视频流稳定传送至控制端或云端 AI 模块;

-

在弱网、抖动、码率变化等恶劣条件下保持画面不断流;

-

支撑感知→分析→决策→执行的全链路闭环控制,让机器人不止会"动",更会"感知与应变"。

2. 当下人形机器人的优势与局限

在过去两年里,人形机器人经历了从"动作演示"到"任务执行"的跃迁,背后是机械、控制、感知、AI 四大技术体系的协同进化。然而,从工程落地的角度看,它们的技术特性既有令人振奋的突破,也有亟需补齐的短板。

2.1 技术优势

-

类人形态的环境适应性

-

两足步行与类人关节结构,使其可直接使用现有的楼梯、门、工具等人类设计环境,不必像轮式或履带式机器人那样大幅改造场地。

-

对需要"人类替身"执行的任务(如工厂巡检、物料搬运、应急救援)有天然的形态优势。

-

-

多模态感知与融合

-

搭载立体视觉、全景摄像头、深度相机、激光雷达、IMU 等传感器,形成多维度环境认知。

-

融合语音、图像、触觉等输入,可与大规模视觉-语言模型(VLM)结合,实现自然语言驱动的任务指令解析。

-

-

AI 驱动的自适应控制

-

借助深度强化学习、模仿学习和模型预测控制(MPC),实现动作优化、姿态平衡与任务切换。

-

能在非结构化环境中根据实时感知数据动态调整行为策略。

-

-

云-边协同算力模式

- 在边缘端执行基础动作与安全检测,复杂识别、路径规划等高算力任务可交由云端 AI 完成,提升整体性能。

2.2 现实局限

-

实时感知延迟瓶颈

-

当多路高清视频(1080p/4K)需要上传至云端处理时,如果链路延迟超过 300ms,就可能导致抓取偏差、避障失败等问题。

-

延迟受限于编码效率、网络抖动、服务器转发性能等多因素。

-

-

弱网与环境适应性不足

-

工厂厂房、地下管廊、灾害现场常伴随信号盲区与干扰,视频链路易卡顿或中断。

-

切换 5G/Wi-Fi/专网时,链路恢复速度和画面完整性仍是挑战。

-

-

能耗与散热限制

-

高功耗视觉计算与视频编码会加重机器人续航压力,限制连续作业时间。

-

部分平台在长时间高负载推流时,会出现热降频影响性能。

-

-

多模态时序对齐复杂

- 视频、音频、IMU、力矩传感器等数据在时间戳对齐与同步传输上存在工程难点,尤其是在跨网络传输的分布式系统中。

3. 大牛直播SDK如何赋能人形机器人

在前一部分中,我们看到,人形机器人的应用潜力正在快速释放,但要真正落地到工业、安防、医疗等高价值场景,必须跨越实时感知延迟、弱网稳定性、多模态时序对齐等技术门槛。大牛直播SDK的核心优势,正好与这些痛点形成互补。

Windows平台 RTSP vs RTMP播放器延迟大比拼

安卓轻量级RTSP服务采集摄像头,PC端到安卓拉取RTSP流

3.1 能力映射表

| 人形机器人挑战 | 大牛直播SDK技术能力 | 解决效果 |

|---|---|---|

| 实时感知延迟高 | 毫秒级低延迟传输(RTSP / RTMP / GB28181) | 将视频链路延迟稳定控制在 100--200ms 内,支撑云端控制与AI推理闭环 |

| 弱网易中断 | 自适应码率、断线重连、GOP优化 | 在工厂、隧道、灾害现场等弱网环境下画面不断流 |

| 多路摄像头同步难 | 多路流推送与时间戳同步 | 前视、全景、关节等多源视频统一管理并时序对齐 |

| 算力分配冲突 | 高效硬件编解码(CPU/GPU) | 减轻端侧编码压力,保留更多算力给本地AI推理 |

| 跨平台接入复杂 | 全平台SDK(Linux / Android / Windows / iOS / Unity) | 适配机器人主板与控制端,减少二次开发成本 |

3.2 核心赋能路径

-

多路视频推流与云端AI协作

-

在机器人端,将双目、全景、关节摄像头的视频通过SDK推流到云端。

-

云端AI可实时进行目标检测、姿态估计、环境建模等运算,并下发控制指令。

-

-

跨网络环境下的稳定传输

-

支持5G / Wi-Fi / 专网的动态切换,保证链路快速恢复。

-

对突发丢包和码率抖动进行自适应优化,确保画面与控制信息同步。

-

-

感知与控制的闭环集成

-

视频流 → 云端推理 → 控制指令 → SDK回传 → 机器人执行,实现毫秒级闭环。

-

在远程遥操作和AI辅助自主控制中,延迟与抖动均可控。

-

-

与现有系统的无缝融合

- GB28181 协议支持,可直接接入已有安防监控与调度系统,实现机器人与摄像头网络的统一调度。

4. 典型落地场景组合

4.1 工厂巡检:从"人工点检"到"智能连续巡航"

场景需求

-

高温、噪音、粉尘等不适合长时间人工作业的工业环境

-

大型设备的运行状态需要周期性检查,且位置分散

-

异常需要第一时间定位与上报

技术链路

-

机器人端

-

配备前视双目与红外热成像摄像头

-

大牛直播SDK推流模块将视频实时编码并发往云端巡检平台

-

-

云端AI

-

视频流经云端AI进行热异常检测、设备状态OCR识别

-

异常事件触发即时告警

-

-

控制端

-

告警信息通过SDK回传至机器人,触发二次检查动作

-

可远程手动接管,实现精确复核

-

价值实现

-

巡检效率提升 3--5 倍

-

异常响应时间缩短至秒级

-

巡检全程可溯源(视频存档 + AI 分析日志)

4.2 应急救援:第一视角感知的"生命通道"

场景需求

-

火灾、地震、化工泄漏等高危环境需要快速搜救

-

需要第一手现场视频与传感器数据

-

人类救援人员无法立即进入或长时间停留

技术链路

-

机器人端

-

搭载可见光与热成像双路摄像机,环境气体传感器

-

SDK 将视频和传感数据低延迟推流至指挥中心

-

-

指挥中心

-

多通道视频实时拼接,云端AI执行烟雾识别、人体检测

-

根据环境数据实时调整救援路径

-

-

闭环控制

-

指挥中心下发路径优化或机械臂操作指令

-

SDK保证指令与视频链路的时序同步,避免延迟导致的误操作

-

价值实现

-

实现救援任务中"秒级决策"

-

提升恶劣环境下机器人操作的安全性与精准度

-

多路数据融合辅助整体指挥

4.3 医疗辅助:跨空间的实时康复与诊疗协作

场景需求

-

隔离病区或远程康复中心需要跨地域医疗支持

-

医生需要看到患者的实时动作状态并进行纠正

-

高精度康复训练器具需要与机器人协作

技术链路

-

机器人端

-

安装高清摄像头、深度摄像头捕捉病患动作

-

SDK 推流至医生端,实现毫秒级实时画面

-

-

医生端 / 云端AI

-

云端AI进行动作姿态分析,并与康复计划进行比对

-

医生在视频流上直接标注指导

-

-

执行闭环

-

指令回传至机器人执行单元(如机械臂、步态辅助器)

-

即时反馈纠正病患动作

-

价值实现

-

提供无延迟的远程康复指导

-

提升隔离环境下的医疗效率

-

数据可长期留存,用于疗效跟踪与AI再训练

5. 落地实施的关键技术要点

人形机器人与大牛直播SDK的结合,如果要真正实现"即插即用"的毫秒级感知闭环,不仅要依赖协议和接口层面的对接,还必须在网络架构、延迟控制、弱网优化、多模态数据同步等方面完成全链路工程优化。

5.1 网络架构设计

目标:保证端到端链路的稳定性与可扩展性

-

端侧推流节点

-

在机器人主控板(Linux/Android)直接运行 SDK 推流服务,减少中转节点

-

使用硬件编码减轻CPU负担

-

-

边缘/云中转节点

-

边缘节点(MEC)部署 SDK 转发或协议转换(RTSP ↔ RTMP ↔ GB28181),缩短传输距离

-

云端节点可同时向多终端分发,并对接 AI 推理服务

-

-

控制回路

-

建立视频下行(机器人→控制端)与指令上行(控制端→机器人)的双向独立通道

-

确保指令通道优先级高于视频通道,避免拥塞导致的动作延迟

-

5.2 延迟控制策略

目标:将端到端延迟稳定控制在 100--200ms

-

编码优化

- 使用低延迟模式,GOP 长度控制在 1-2秒之间

-

传输优化

-

采用 UDP 优先传输(RTSP/RTP over UDP)

-

在网络抖动较大时开启自适应抖动缓冲区,缓冲时间 < 50ms

-

5.3 多模态数据同步

目标:确保视频、音频、IMU、力矩传感器等数据在毫秒级内对齐

-

同步传输机制

-

在多路推流时使用多轨同步(multi-track sync)或扩展SEI投递数据,保证不同模态间的帧对齐

-

在控制端播放或AI推理时根据时间戳进行回放/分析

-

-

数据融合层

- 在云端或边缘节点构建数据融合模块,将多模态数据打包成统一结构体,供上层AI与控制逻辑直接调用

6. 结语与未来展望

人形机器人的价值,并不止于"形似人类",而在于它能在复杂、动态、多风险的环境中,像人一样去感知、理解、决策、执行------甚至比人更快、更稳、更安全。要让这一能力真正落地,必须依托一条稳定、低延迟、可编排的视频与数据链路,将机器人端的多模态感知与云端/远端的智能决策实时连接起来。

大牛直播SDK在这一链路中扮演着"视觉神经元传导系统"的角色:

-

在毫秒级延迟下,将机器人捕获的第一视角画面、多源传感数据稳定送达AI推理与控制端;

-

在弱网与动态网络环境中,保持画面与指令的同步性与连续性;

-

在跨平台环境下,实现从机器人端(Linux/Android)到控制端(Windows/iOS/Unity)的无缝互通。

从行业趋势看,这种**"实时感知 × 云端智能 × 动作执行"**的闭环将成为未来人形机器人普及的标配架构:

-

多模态AI原生化

- 视频、音频、IMU、力矩、环境传感数据统一接入AI推理链路,摆脱单一视觉依赖。

-

边缘-云协同演进

- 边缘节点完成基础推理与安全防护,云端进行高精度计算与多任务调度。

-

更低延迟的传输技术

- 在现有RTSP/RTMP/GB28181之外,将延迟稳定至 100--200ms 级别,满足远程精细操控需求。

-

开放式生态对接

- SDK能力模块化,使其可与工业MES、安防VMS、医疗HIS等系统直接互通,形成跨领域的智能协作网络。

未来,当人形机器人能够像人一样感知环境,并依托大牛直播SDK 这样稳定高效的链路与云端AI进行"秒级思考",它们将不再只是机械替代,而是全行业智能化升级的加速器。从工厂到医院,从救援到家庭,人形机器人将与实时视频技术一道,构建一个可感知、可理解、可协作的新型智能社会。

📎 CSDN官方博客:音视频牛哥-CSDN博客****