ollama 上周更新了 1.8 版本,终于有了自己的界面。点击小羊驼,就能直接开始聊天了。

有界面需求的,从此不再需要另外部署一套 ui 了,再次降低了门槛。

不熟悉命令行操作的,也可以愉快地使用它了~

界面走简约风格,仅支持简单对话,上传文件、多模态肯定是不支持的。联网搜索也仅限于 gpt 的两款模型。

模型列表中有下载好可用的模型,和以前下载过的模型(右侧有个下载提示),对于已下载的模型,还有升级提示。

下载无法查看速度,也没法停止。但是首推最新的 gpt-oss 模型,没有下载提示,聊天就会触发直接下载。如果你家网络不好,可能要卡住你半天。

另外,查询功能有 bug,模糊查询没做好,比如查询 glm 没有内容,但是 glm4 就有内容。如果找不到模型,需要去官网确认一下具体的模型名字。

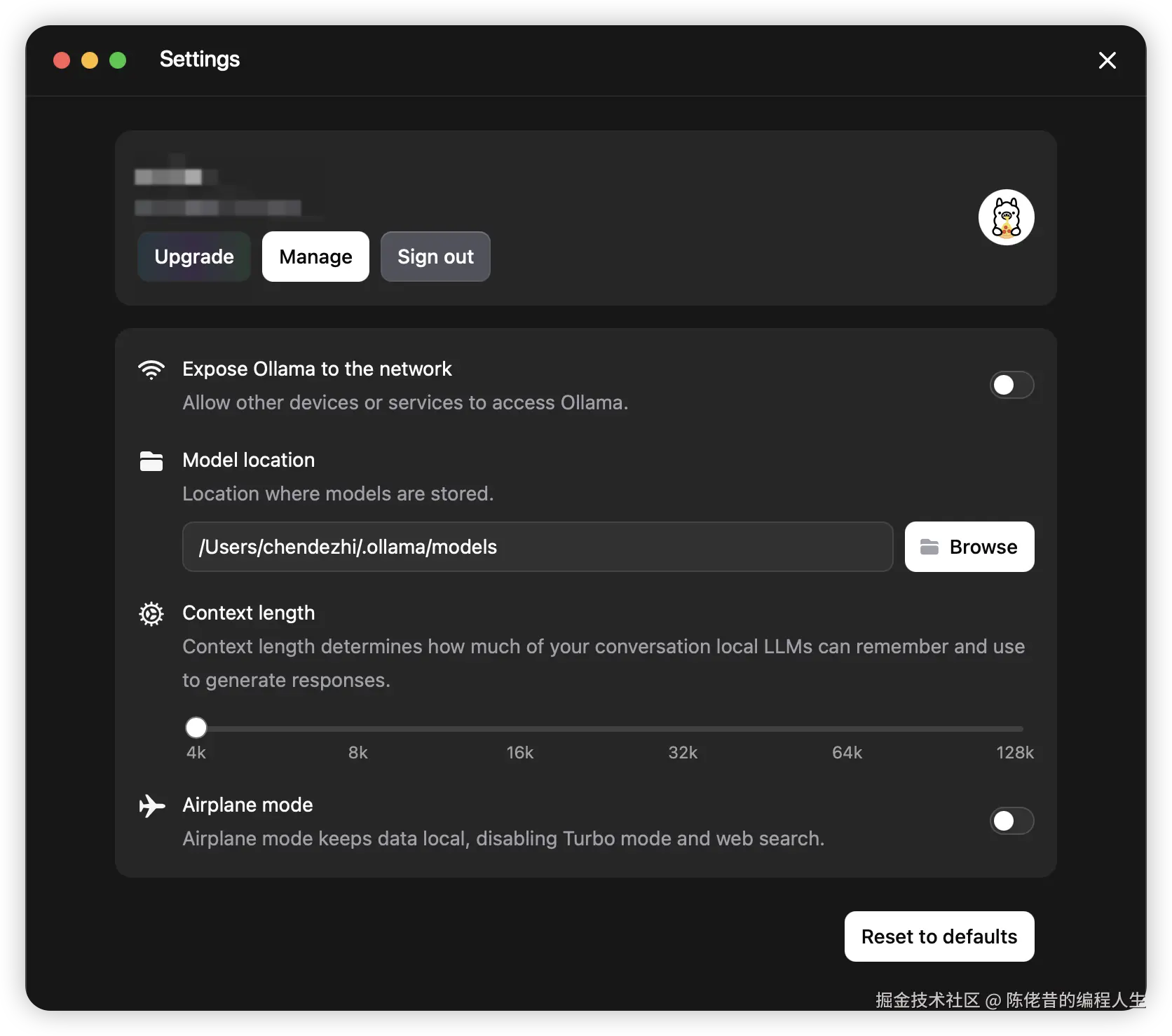

设置界面提供了常用的几个功能。

- Expose Ollama to the network,即提供 api 访问提供;

- Model location 为模型更改地址;

- Context length 为上下文长度;

- Airplane mode 保留数据在本地,更好地保护隐私。

官方推出了 Turbo套餐,登录后,可以购买会员服务。主要是提供可直接使用的线上大模型,服务月费为 20 美元。

Ollama "Turbo" 适用场景:

- 本地显卡显存不足,无法加载 120B 级别模型;

- 需要快速原型验证、批量推理或高并发调用;

- 希望保持本地环境简洁,同时获得接近数据中心的性能。

这波 AI 浪潮进入下半场后,各家开始忙商业化变现了,Ollama也不例外。

但 Ollama 这次更新,整体惊喜不大。也许这与 Ollama 本身的定位相关,简单易用,门槛更低,对小白用户更友好。

但,Ollama 平台好像开始被开发者抛弃了。

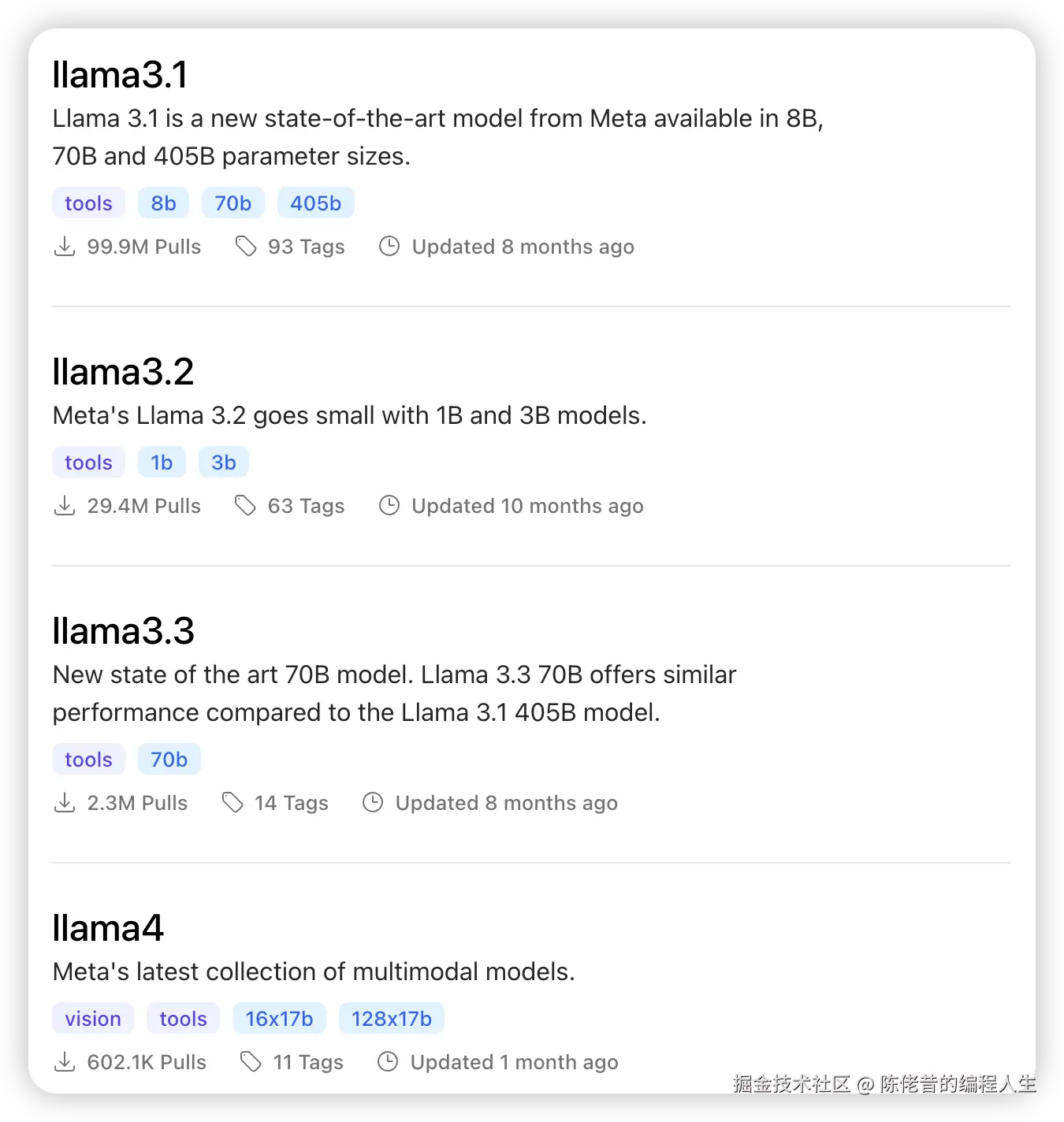

首先 Meta 自己的开源模型比较落后。从下载量来看,llama 每升级一次下载量就少一个0。llama4 推出后高分低能的表现,让大众嘘声一片。这次首推的是非自家的 Gpt 的开源模型也就不难理解了。

之前部分模型更新,没选择在 Ollama 发布(首发),作为开发者的我感受不强。

但这次的 Qwen3-coder 模型在其他平台一片欢呼雀跃,各大视频网站天天刷,唯独 Ollama 这没法享受到一丝一毫。也令我开始考虑换平台了。

另外,随着开发的深入,用 Ollama 开发受到的限制越来越多。比如没法关闭思考模式,在本地机器资源有限的情况下,用一个模型处理多种任务就难以实现了。

有什么平台好,如果有熟悉的小伙伴,可以在评论区指引一二。

谢谢!

目前在试用 LM Studio,整体感觉还不错~