【导读】

本文提出 DC-AE 1.5 框架,通过引入结构化隐空间和增强扩散训练 两大关键技术,在保持高生成质量的同时,大幅加快扩散模型收敛速度,并显著提升高分辨率生成效率。 实验表明,该方法在 ImageNet 等数据集上实现了更快训练吞吐率与更优图像质量的双重突破。>>更多资讯可加入CV技术群获取了解哦

无人机技术已深刻变革野生动物监测、精准农业、搜救行动等众多领域。这些应用常需检测动物、害虫、失踪人员等小目标,而无人机独特的空中视角使其成为不可替代的作业平台。目标检测能力------尤其是小目标检测------直接决定无人机系统的自主性与作业效能。

当前主流检测方法分为两类:以R-CNN为代表的两阶段检测首先生成候选区域再分类,计算复杂度较高;而YOLO等单阶段方法通过单次推理直接预测目标框与类别,更符合无人机实时性需求。但YOLO存在固有缺陷:对小目标或密集目标的检测精度不足,固定网格结构难以捕捉细节特征,预定义锚框机制在复杂无人机场景中适应性有限。

本文提出的SOD-YOLO算法针对上述问题作出三项改进:

- 在颈部网络引入ASF注意力融合机制,增强模型对尺寸变化和复杂背景的适应能力;

- 新增P2高分辨率检测头,显著提升小目标检测精度;

- 采用Soft-NMS优化置信评分,有效保留真实目标。

在VisDrone2019-DET数据集上的实验表明,该方案使mAP50:95提升36.1%,mAP50提升20.6%。

论文标题:

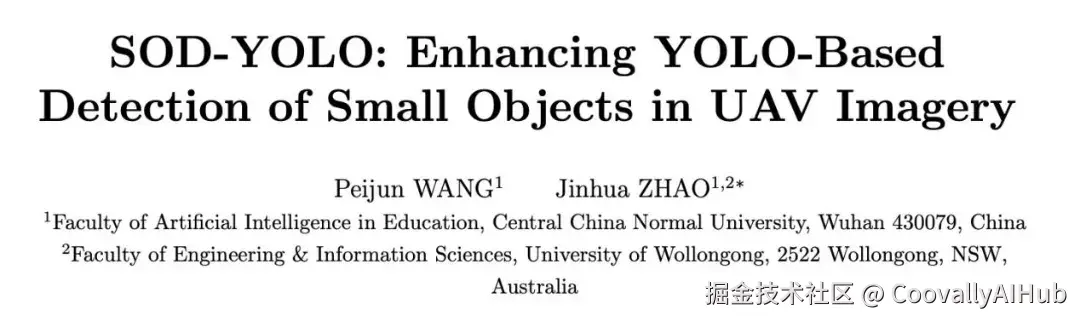

SOD-YOLO: Enhancing YOLO-Based Detection of Small Objects in UAV Imagery

论文 链接 :

研究方法

- ASF机制集成

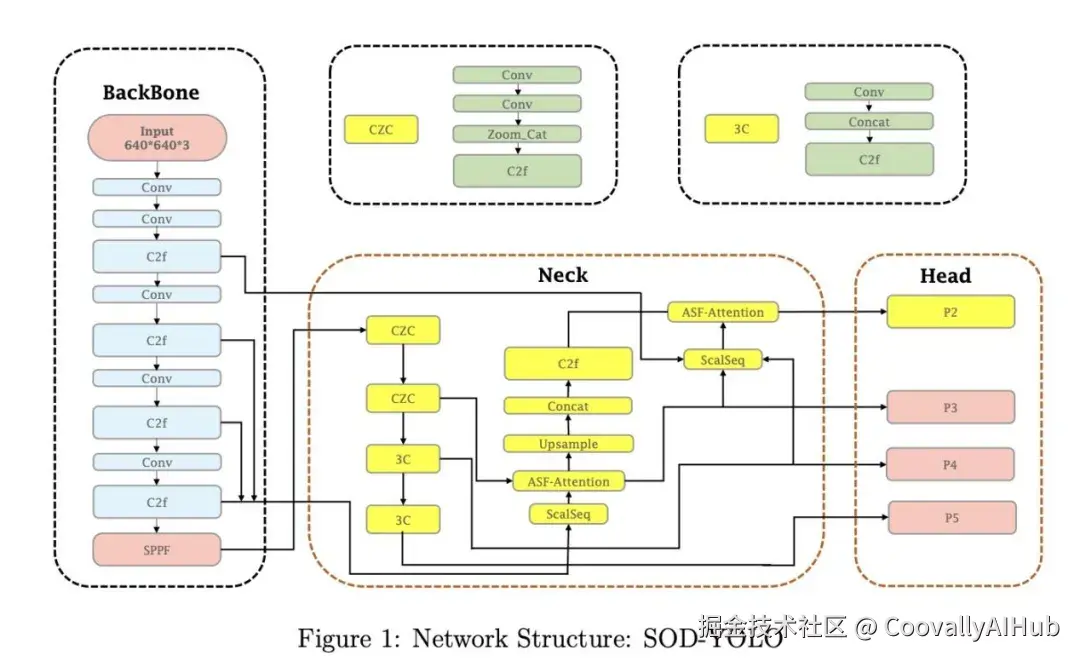

标准YOLOv8架构采用顺序式颈部设计,通过卷积层(Conv)、增强残差块(C2f)和空间金字塔池化融合层(SPPF)逐步下采样并丰富特征图。其检测头通过拼接多尺度特征(P3、P4、P5)并经检测层处理实现目标预测。

针对无人机视角的小目标检测,我们创新性地将自适应尺度融合(ASF)机制 ------最初为细胞实例分割开发------集成至YOLOv8框架(如图1所示)。改进主要集中于新型尺度序列(ScalSeq)特征融合模块和基于ASF的注意力优化块。

- 小目标检测层

为增强无人机图像中小目标检测能力,在网络P2层级新增检测头 (图1所示)。与P3/P4/P5等基于深层低分辨率抽象特征的检测头不同,P2层处理来自骨干网络早期的高分辨率特征图。这些浅层特征保留了更多物体边界、纹理等细粒度空间信息,对航拍场景中的小尺度目标检测至关重要。

引入P2检测层的理论基础在于:高空无人机图像中的小目标通常仅占极少像素,易在深层下采样过程中被稀释。虽然P3已具备中等分辨率,但步长卷积仍可能导致局部细节丢失。相比之下,P2保留更精细的空间粒度,能更好捕获适用于小目标识别的底层视觉特征,尤其在复杂背景和遮挡情况下。

- Soft-NMS集成

非极大值抑制(NMS)是目标检测模型的关键后处理技术,用于去除冗余重叠检测框。传统NMS算法在当前检测框与最高分框的IoU超过阈值时,会将该检测框分数置零。这种方法可能导致显著重叠的真实目标被误删,造成小目标召回率下降。

为解决可能误删有效检测框的问题,本研究采用soft-NMS算法。与传统NMS不同,soft-NMS通过加权函数调整当前检测框分数: 与最高分框重叠越大,分数衰减越快。这种方法既避免了目标框被移除,又防止了对同一目标的重复检测。本研究所用soft-NMS算法考虑了检测框间的重叠关系,相比传统NMS降低了漏检概率,从而提升了小目标检测的准确性与可靠性。

实验

- 实验设置概述

为验证SOD-YOLO模型在无人机图像小目标检测中的有效性与鲁棒性,我们在多种场景下开展全面实验。实验设置遵循以下目标:

- 评估目标: 检验模型在复杂航拍场景中对密集小目标的检测能力,验证其相对基线模型YOLOv8-m的改进效果

- 评估指标: 主要报告IoU阈值为0.5时的平均精度(mAP@0.5)及0.5:0.95区间平均精度(mAP@0.5:0.95),并采用数据集定义的小目标检测专项指标

- 对比基线: 在相同训练/评估设置下,将SOD-YOLO与YOLOv8-m及其他先进方法进行对比

- 数据集

VisDrone2019-DET: 采用该广泛使用的无人机目标检测基准数据集,包含中国多个城市拍摄的10,209张静态图像和288段视频中的261,908帧数据,涵盖城乡多样场景、多尺度目标及不同密度分布。静态图像集划分为6,471训练集、548验证集和1,610测试集。

数据集定义10类目标: 行人、人群、自行车、轿车、厢式车、卡车、三轮车、带篷三轮车、巴士、摩托车。值得注意的是,75%以上标注目标占图像面积小于0.1%,凸显小目标的主导地位。目标分布呈现明显中心聚集特征,这为采用中心增强策略提供了依据。

为加速无人机视觉算法研发,Coovally 算法平台已无缝集成 VisDrone2019-DET 等主流开源数据集。开发者通过 Coovally 可便捷完成数据集管理、预处理、标注及模型训练全流程,显著提升如 SOD-YOLO 等无人机视觉算法的开发效率。

!!点击下方链接,立即体验Coovally!!

平台链接: www.coovally.com

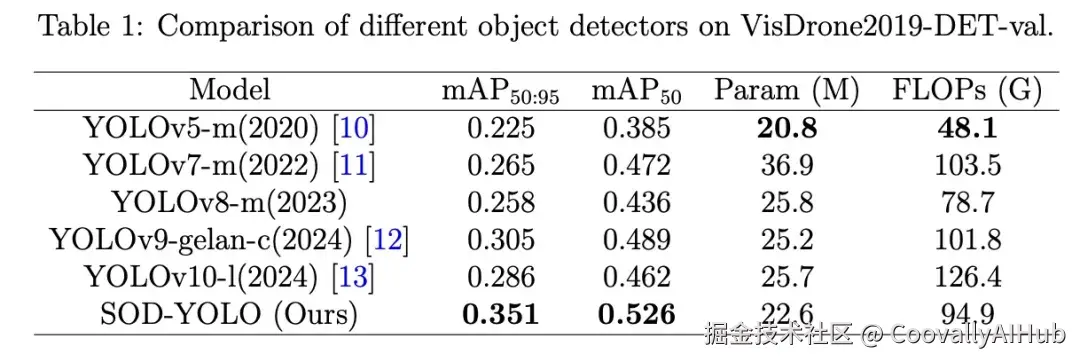

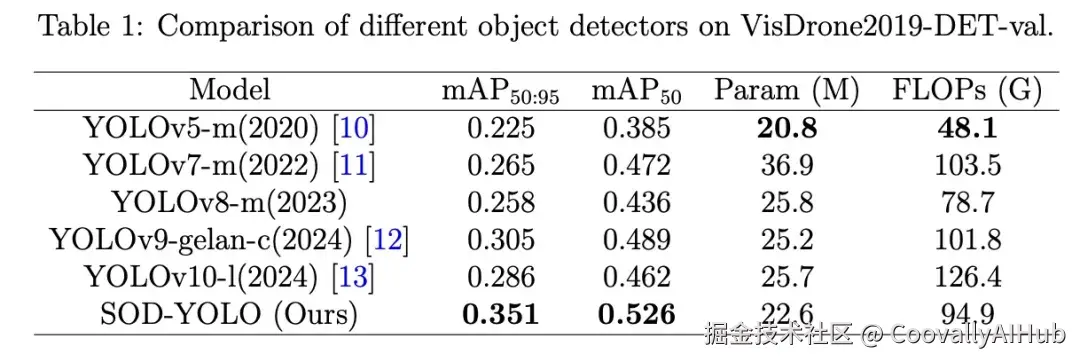

- 结果对比

以YOLOv8-m为基线,在VisDrone2019-DET-val数据集上的对比结果如表1所示。SOD-YOLO的mAP50:95达到0.351(较基线0.258提升0.093),mAP50达0.526(较基线0.436提升0.09),显著提升小目标检测性能。

与其他先进模型对比:

• 相较参数量相近的YOLOv9-gelan-c,SOD-YOLO在mAP50:95(0.351 vs 0.305)和mAP50(0.526 vs 0.489)上均占优

• 保持较低计算成本(22.6M参数/94.9G FLOPs),优于YOLOv7-m(36.9M参数/103.5G FLOPs)等模型

图2展示城市航拍图像的检测对比:

• SOD-YOLO成功检测到YOLOv8-m漏检的左侧道路行人(包括斑马线附近行人及路缘儿童);

• 对远端车辆/摩托车的检测置信度更高,修正了YOLOv8-m的低置信度框或漏检;

• 在卡车/厢式车/轿车的分类精度上表现更优。

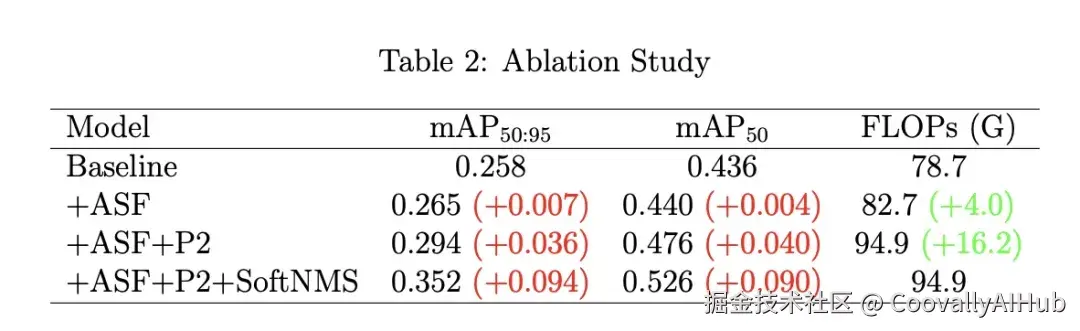

- 消融实验

如表2所示,各模块贡献度分析:

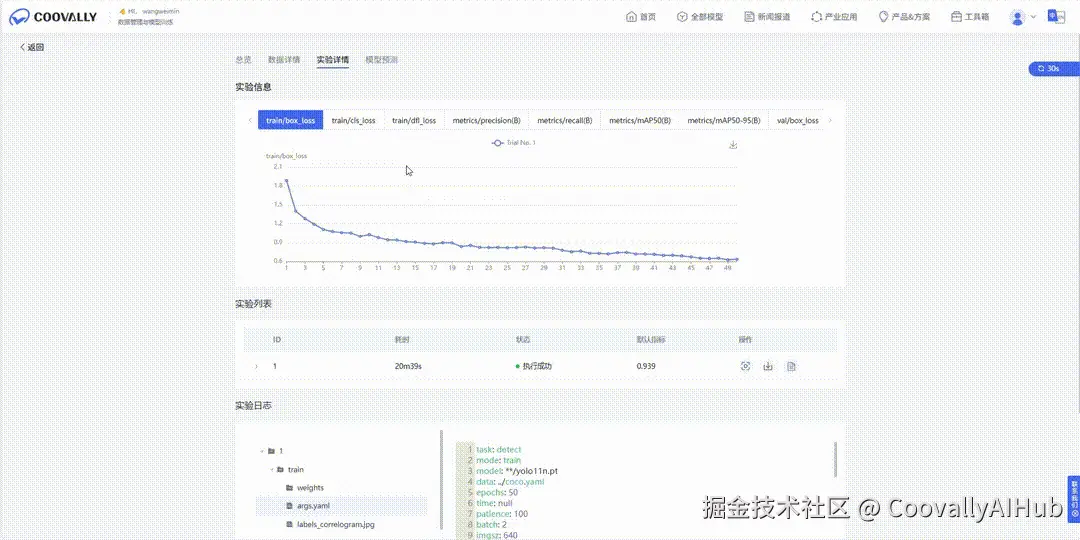

Coovally平台还可以直接查看"实验日志" 。在每一个实验详情页中,用户都可以实时查看训练日志、输出信息或报错内容,无需额外配置、无缝集成于工作流中!

不论是模型调参、错误排查,还是过程复现,这项新功能都将大幅提升你的实验效率。

结论

本文提出了一种改进的YOLOv8算法SOD-YOLO,专门用于无人机图像中的小目标检测。我们通过集成ASF机制、引入专用的P2检测层以及实现Soft-NMS等改进措施,显著提升了检测性能。ASF机制通过聚焦关键区域增强了空间特征提取能力,使模型能更好地检测小而密集的目标;新增的P2检测层在较低特征尺度上捕获更精细的细节,改善了小目标检测效果;而Soft-NMS通过软性惩罚重叠框而非直接删除,有效减少了误检。在VisDrone2019-DET数据集上的实验表明,相较于基准YOLOv8模型,我们的方法在mAP50:95指标上提升了36.1%,在mAP50指标上提升了20.6%,充分证明了该方法在处理复杂无人机场景中小目标的有效性。

尽管取得了显著改进,我们的工作仍存在一些局限性。首先,虽然ASF机制和P2检测层有效提高了小目标检测精度,但模型计算复杂度的增加影响了其实时性能。这一局限可能会制约模型在计算资源有限场景下的部署。因此,未来的工作可以聚焦于通过轻量化设计来优化模型的计算效率,以确保其在实时应用中的性能表现。