使用GAN生成音频隐写术的隐写载体

本文为个人阅读

GAN音频隐写论文,部分内容注解,由于原文篇幅较长这里就不再一一粘贴,仅对原文部分内容做注解,仅供参考详情参考原文链接

原文链接:https://ieeexplore.ieee.org/abstract/document/9459771希望对你有帮助

文章目录

- 使用GAN生成音频隐写术的隐写载体

- GAN生成音频隐写术的隐写载体-Method精简阅读

- GAN生成音频隐写术的隐写载体【精读注解】

-

- 摘要(Abstract)

- [I. 引言(INTRODUCTION)](#I. 引言(INTRODUCTION))

- [II. 相关工作(RELATED WORK)](#II. 相关工作(RELATED WORK))

-

- [A. 生成对抗网络(GENERATIVE ADVERSARIAL NETWORK)](#A. 生成对抗网络(GENERATIVE ADVERSARIAL NETWORK))

- [B. 基于GAN的隐写术方法(GAN-BASED STEGANOGRAPHY APPROACHES)](#B. 基于GAN的隐写术方法(GAN-BASED STEGANOGRAPHY APPROACHES))

- [III. 使用GAN生成隐写载体音频(GENERATING STEGANOGRAPHIC COVER AUDIO USING GAN)](#III. 使用GAN生成隐写载体音频(GENERATING STEGANOGRAPHIC COVER AUDIO USING GAN))

-

- [A. 总体框架(OVERALL FRAMEWORK)](#A. 总体框架(OVERALL FRAMEWORK))

- [B. 生成器架构(GENERATOR ARCHITECTURE)](#B. 生成器架构(GENERATOR ARCHITECTURE))

- [C. 判别器架构(DISCRIMINATOR ARCHITECTURE)](#C. 判别器架构(DISCRIMINATOR ARCHITECTURE))

- [D. 损失函数(LOSS FUNCTION)](#D. 损失函数(LOSS FUNCTION))

- [E. 训练策略(TRAINING STRATEGY)](#E. 训练策略(TRAINING STRATEGY))

- [IV. 实验结果(EXPERIMENTAL RESULTS)](#IV. 实验结果(EXPERIMENTAL RESULTS))

-

- [A. 实验设置(EXPERIMENTAL SETUP)](#A. 实验设置(EXPERIMENTAL SETUP))

- [B. 隐写载体音频的感知质量(PERCEPTION QUALITY OF STEGANOGRAPHIC COVER AUDIO)](#B. 隐写载体音频的感知质量(PERCEPTION QUALITY OF STEGANOGRAPHIC COVER AUDIO))

- [C. 与现有方法的比较(COMPARISON WITH EXISTING METHODS)](#C. 与现有方法的比较(COMPARISON WITH EXISTING METHODS))

- [D. 消融实验(ABLATION EXPERIMENT)](#D. 消融实验(ABLATION EXPERIMENT))

- [V. 结论(CONCLUSION)](#V. 结论(CONCLUSION))

GAN生成音频隐写术的隐写载体-Method精简阅读

精简阅读:GAN隐写音频精简阅读

核心方法总结

这是一个基于生成对抗网络(GAN) 的音频隐写术方法,通过三方对抗训练自动生成适合消息嵌入的隐写载体音频,有效对抗深度学习检测器。

核心创新 :引入隐写分析器作为第三方参与对抗训练,使生成器学会产生能够"愚弄"检测器的载体音频。

整体架构流程

Shape流程:

- 输入:

[batch_size, 1, 16384](原始音频片段) - 生成器输出:

[batch_size, 1, 16384](隐写载体音频) - 最终输出:

[batch_size, 1, 16384](隐写音频)

三方对抗训练机制

参与方:

- 生成器G:生成隐写载体音频

- 判别器D:区分真假音频

- 隐写分析器S:检测隐写音频(参数固定)

通俗理解:就像三个人在玩游戏 - 生成器是"造假者",判别器是"真假鉴定师",隐写分析器是"隐写检测专家"。生成器要同时骗过这两个专家。

学术理解:通过引入预训练的隐写分析器作为额外约束,生成器在传统GAN对抗基础上,还需要对抗专门的隐写检测器,从而学会生成更难被检测的载体音频。

核心损失函数

阶段1:基础GAN训练

L s t a g e 1 = L D + L G 1 = L D + E x [ log ( 1 − D ( G ( x ) ) ) ] L_{stage1} = L_D + L_{G1} = L_D + E_x[\log(1 - D(G(x)))] Lstage1=LD+LG1=LD+Ex[log(1−D(G(x)))]

通俗理解:生成器和判别器先进行基础的"真假对抗",建立生成高质量音频的能力。

阶段2:加入隐写分析器

L s t a g e 2 = α L G A N + β L S i m L_{stage2} = \alpha L_{GAN} + \beta L_{Sim} Lstage2=αLGAN+βLSim

其中关键的生成器损失:

L G 2 = E x [ log ( 1 − D ( G ( x ) ) ) ] + E x [ log ( 1 − S ( F ( G ( x ) ) ) ) ] L_{G2} = E_x[\log(1 - D(G(x)))] + E_x[\log(1 - S(F(G(x))))] LG2=Ex[log(1−D(G(x)))]+Ex[log(1−S(F(G(x))))]

相似性约束:

L S i m = E x [ ∥ G ( x ) − x ∥ 1 ] + E x [ ∥ F ( G ( x ) ) − x ∥ 1 ] L_{Sim} = E_x[\|G(x) - x\|_1] + E_x[\|F(G(x)) - x\|_1] LSim=Ex[∥G(x)−x∥1]+Ex[∥F(G(x))−x∥1]

通俗理解:生成器现在要完成三个目标:

- 骗过判别器(生成逼真音频)

- 骗过隐写分析器(生成抗检测载体)

- 保持与原音频相似(感知质量)

学术理解 :损失函数巧妙地将传统隐写术的嵌入过程 F ( ⋅ ) F(\cdot) F(⋅)纳入GAN训练,通过 S ( F ( G ( x ) ) ) S(F(G(x))) S(F(G(x)))项实现端到端的反检测优化。

网络架构特点

生成器 :采用U-Net架构

- 8个卷积层 + 8个反卷积层

- 跳跃连接保持细节信息

- 卷积核:

1×32,步长:2

判别器 :采用谱归一化技术

- 9个卷积层 + 1个全连接层

- 所有权重参数通过谱范数归一化

- 稳定训练过程

通俗理解:生成器像个"音频修复师",用U-Net确保生成的音频保持原有细节;判别器像个"严格评委",用谱归一化保持判断的稳定性。

实验效果

感知质量 :PESQ分数4.4235,SNR为83.275dB

检测抗性:相比传统方法,检测准确率显著降低

- 0.5bps下:本方法63.25% vs LSBM 75.24%

- 0.1bps下:接近随机猜测(50%)

通俗理解:生成的隐写音频听起来和原音频几乎一样,但能更好地躲过AI检测器的发现。

学术理解:在保持高感知质量(PESQ>4.4)的同时,实现了对最先进深度学习隐写分析器的有效对抗,检测准确率接近随机猜测水平。

GAN生成音频隐写术的隐写载体【精读注解】

摘要(Abstract)

音频隐写术(Audio Steganography) 旨在利用人类听觉冗余性将秘密消息嵌入载体音频中,而不会在听取时引起怀疑。然而,最近的研究表明,现有的音频隐写术可以通过基于深度学习的隐写分析器(Steganalyzers) 轻易暴露,这些分析器通过提取隐写音频(Stego Audio) 的高维特征进行分类。现有基于生成对抗网络(GAN) 的隐写术方法主要研究图像载体,在音频载体方面的工作较少。此外,虽然已经提出了一些基于GAN 的音频隐写术方法,但它们在感知质量(Perceptual Quality) 和不可检测性(Undetectability) 方面仍有改进空间。

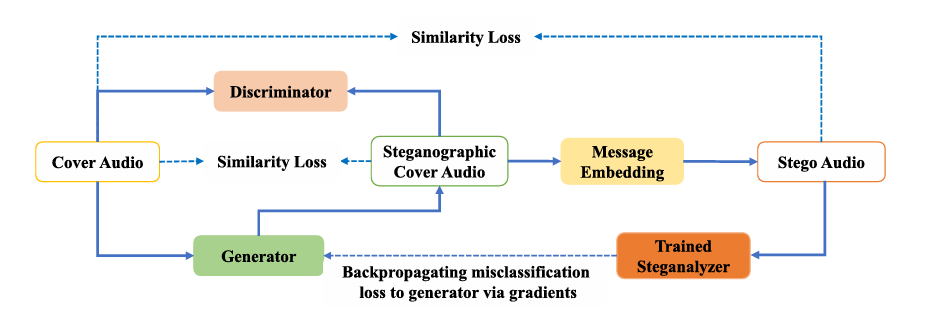

在这项工作中,我们提出了一个音频隐写术框架,该框架可以自动学习生成优秀的隐写载体音频(Steganographic Cover Audio) 用于消息嵌入。具体而言,所提出框架的训练框架由三个组件组成,即生成器(Generator) 、判别器(Discriminator) 和训练好的基于深度学习的隐写分析器 。然后采用传统的消息嵌入算法LSBM 将秘密消息嵌入到隐写载体音频中以获得隐写音频,将其传递给训练好的隐写分析器以将其误分类为载体音频。一旦这三方之间的对抗训练(Adversarial Training) 完成,就可以获得训练良好的生成器,该生成器可以生成隐写载体音频用于后续的消息嵌入。

在我们提出的方法实践中,隐写音频是通过使用传统隐写术方法将秘密消息嵌入到隐写载体音频中产生的。实验结果表明,我们提出的音频隐写术可以产生保持相当高感知质量的隐写载体音频用于消息嵌入。我们将检测准确性与现有的音频隐写术方案进行了比较,如我们的实验所示,所提出的方法在各种嵌入率(Embedding Rates) 下,对最先进的基于深度学习的隐写分析器表现出更低的检测准确性。代码可在 https://github.com/Chenlang2018/Audio-Steganography-using-GAN 公开获取。

索引术语(INDEX TERMS) :音频隐写术,基于深度学习的隐写分析,生成对抗网络(GAN)。

基于这篇关于音频隐写术的研究论文,我来拆分总结主要要点:

研究背景与问题

音频隐写术的定义与挑战

- 音频隐写术利用人类听觉冗余性将秘密消息嵌入载体音频中,目标是不被察觉

- 现有方法容易被基于深度学习的隐写分析器检测出来

- 分析器通过提取隐写音频的高维特征进行分类检测

现有方法的局限性

- 基于GAN的隐写术主要集中在图像载体,音频领域研究较少

- 已有的GAN音频隐写方法在感知质量和不可检测性方面仍需改进

提出的解决方案

核心创新框架

- 提出能够自动学习生成优秀隐写载体音频的框架

- 框架专门用于消息嵌入,提高整体隐写效果

三组件训练架构

- 生成器(Generator) :生成隐写载体音频

- 判别器(Discriminator) :辨别真假音频

- 隐写分析器:训练好的深度学习检测器

工作流程

- 使用传统LSBM算法将秘密消息嵌入隐写载体音频

- 生成的隐写音频被送入分析器,训练其误分类为载体音频

- 通过三方对抗训练获得最优生成器

实验成果与优势

感知质量表现

- 生成的隐写载体音频保持相当高的感知质量

- 在听觉上不易被人类察觉

检测抗性提升

- 与现有音频隐写术方案相比,检测准确性显著降低

- 在各种嵌入率下都表现出更强的抗检测能力

- 对最先进的基于深度学习的隐写分析器更具欺骗性

开源贡献

- 研究代码已在GitHub公开:https://github.com/Chenlang2018/Audio-Steganography-using-GAN

- 促进了该领域的进一步研究和发展

技术意义

这项研究在音频隐写术领域具有重要突破,通过GAN技术有效提升了隐写音频的不可检测性,为信息安全和隐私保护提供了新的技术路径。

I. 引言(INTRODUCTION)

隐写术(Steganography) 是一种利用人类感知冗余性将秘密消息嵌入载体(如视频、图像和音频)的技术。带有嵌入数据的载体,即隐写体(Stego) ,可以绕过对抗监控并实现隐蔽通信。隐写术已被应用于许多多媒体安全场景,例如隐私保护 [1] 。

根据不同的嵌入策略,隐写术可以分为**非自适应隐写术(Non-adaptive Steganography)** 和自适应隐写术(Adaptive Steganography) 。一般而言,非自适应隐写术方法通常以不加区别的方式修改载体的所有元素。沿着这条路线的代表性工作是LSB [2] 和LSB匹配(LSBM)[3] 。相反,自适应隐写术方法选择性地在不太可能被暴露的区域嵌入秘密消息。著名的自适应隐写术算法包括WOW [4] 、HUGO [5] 、HILL [6] 、S-UNIWARD [7] 。这些方法都基于校验子网格码(Syndrome-Trellis Codes,STC)[8] 。在自适应隐写术框架中,定义载体中每个嵌入位置的失真代价函数来表征隐写体的失真程度。然后在假设所有嵌入操作彼此独立的情况下最小化总失真。需要注意的是,自适应隐写术可以很容易地被空间富模型(Spatial Rich Model,SRM)[9] 隐写分析方法检测到。这种方法使用多个高通滤波器预处理隐写体以放大隐写信号。

最近,深度学习在许多领域取得了重大突破,例如计算机视觉、自然语言处理和语音识别,并且在过去几年中一直在改变信息隐藏研究。由于基于深度学习的隐写分析方法 [10],[11] 在检测传统隐写术算法方面显著超越了传统隐写分析方法 [12],[13] ,这可能给隐写术的发展带来挑战。因此研究人员开始提出基于深度学习的图像隐写术方法。

Volkhonskiy等人[14] 首次提出了隐写生成对抗网络(Steganographic GAN,SNGAN) 来实现载体修改隐写术。与SGAN 不同,Hayes和Danezisv [15] 提出使用秘密消息和载体图像来生成隐写图像。Zhang等人[16] 提出了一种称为"通过采样的生成式隐写术(Generative Steganography by Sampling,GSS) "的新颖数据驱动信息隐藏方案,其中隐写图像由生成器直接采样而不使用载体。Tang等人[17] 将GAN 与自适应隐写术结合,提出了自动隐写失真学习框架(Automatic Steganographic Distortion Learning Framework,ASDL-GAN) ,其中GAN 组件应该学习嵌入变化概率图。

除了基于GAN 的隐写术方法外,研究人员还提出了受对抗样本(Adversarial Examples) 启发的隐写术方法。Zhang等人[18] 采用快速梯度符号方法(Fast Gradient Sign Method,FGSM)[19] 设计了一个隐写术模型,其核心思想是在载体图像上添加随机噪声来模拟嵌入操作,生成带噪声的"隐写图像",然后对基于深度学习的隐写分析网络进行对抗攻击以获取扰动。最后,使用自适应隐写术算法嵌入秘密消息。报告的结果表明,所提出的方法在抵抗基于深度学习的隐写分析方法方面取得了优越的性能。而Tang等人[20] 从隐写术的角度彻底研究了对抗样本。他们建议对抗样本可以有效地用于调整隐写失真代价。

现有的传统音频隐写术无法抵抗基于深度学习的隐写分析方法。Lin等人[21] 和Chen等人[22] 是两种最先进的基于深度学习的音频隐写分析方法,在检测传统音频隐写术算法方面取得了出色的分类性能。此外,基于深度学习的新兴隐写术算法主要集中在图像域,而基于深度学习的音频隐写术算法关注较少,仍有改进空间。

因此,本文致力于探索音频域的隐写术。所提出的训练框架由三个组件组成:生成器、判别器和训练好的基于深度学习的隐写分析器。将原始载体音频作为生成器的输入,用于生成无法区分的隐写载体音频。然后采用传统的消息嵌入算法LSBM 将秘密消息嵌入到生成的隐写载体音频中以获得隐写音频,将其传递给训练好的隐写分析器以将其误分类为载体音频。这是试图欺骗训练好的隐写分析器以输出错误的预测概率。当发生误分类时,与预测损失对应的误差将反向传播到生成器以更新权重参数。一旦这三方之间的对抗训练完成,就可以获得训练良好的生成器来生成隐写载体音频用于后续消息嵌入,这确保了生成的隐写载体音频的数据分布与消息的数据分布很好地匹配。

应该注意的是,隐写载体音频是指适合消息嵌入的载体音频,而不是隐写音频。隐写音频是通过使用传统隐写术方法将秘密消息嵌入到隐写载体音频中产生的。实验结果表明,我们提出的音频隐写术可以产生保持相当高感知质量的载体音频用于消息嵌入,并且与现有的音频隐写术方法相比,所提出的方法对最先进的基于深度学习的隐写分析器表现出卓越的不可检测性。

本文的主要贡献总结如下:

- 我们精心设计了GAN 框架的生成器和判别器的网络架构,确保生成器学习生成具有高感知质量的隐写载体音频。

- 我们不仅使用L1范数 来衡量载体音频与原始音频之间的相似性,还衡量隐写音频与原始音频之间的相似性,进一步增强了所提出音频隐写术方法的不可检测性。

- 进行了大量实验来证明所提出的音频隐写术方法与传统音频隐写术方法相比的有效性和优越性。

本文的其余部分组织如下。第II节 回顾了相关工作,第III节 描述了所提出的框架,包括生成器和判别器的网络架构、损失函数和训练策略。第IV节 展示了实验结果,包括隐写载体音频的感知质量、与现有方法的比较以及消融实验。最后,第V节 得出结论。

II. 相关工作(RELATED WORK)

在本节中,我们首先简要回顾生成对抗网络,然后阐述基于GAN 的隐写术方法的最新进展。

A. 生成对抗网络(GENERATIVE ADVERSARIAL NETWORK)

生成对抗网络(GAN) 首先由Goodfellow等人[23] 提出。GAN 的基本目的是利用真实样本建立生成器,该生成器可以生成服从与真实样本相同数据分布的样本。生成器可以被视为将随机噪声转换到真实样本空间的变换。为了获得这样的生成器,引入判别器来区分生成的样本与真实数据,旨在增强生成器的性能。简而言之,通过生成器和判别器之间的持续对抗博弈,最终在训练过程中达到平衡点。这使得判别器无法区分生成的样本与真实样本成为可能。

然而,朴素GAN 的训练过程并不稳定,也可能出现梯度消失问题。因此研究人员提出了一些改进的GAN 来优化GAN 的训练。Arjovsky等人[24] 提出了WGAN(Wasserstein GAN) ,使用Earth-Mover距离 而不是JS散度 来衡量真实样本分布与生成样本分布之间的距离。Qi [25] 提出了损失敏感GAN(Loss-Sensitive GAN,LS-GAN) 来限制损失函数满足Lipschitz约束 。Mirza和Osindero [26] 提出了条件GAN(Conditional GAN,CGAN) ,为判别器和生成器添加额外的条件信息来指导GAN 的训练。

B. 基于GAN的隐写术方法(GAN-BASED STEGANOGRAPHY APPROACHES)

近年来,研究人员将GAN 应用于信息隐藏领域,大多数基于GAN 的隐写术方法都集中在图像域。虽然已经提出了一些基于GAN 的音频隐写术方法,但它们仍有改进空间。

Volkhonskiy等人[14] 首次提出了一个称为隐写生成对抗网络(Steganographic GAN,SGAN) 的隐写模型,该模型将随机噪声作为输入来生成与原始载体在视觉上无法区分的载体图像。然后通过LSBM 生成相应的隐写图像。最后,生成器和隐写分析器参与对抗博弈。这种博弈的目标是强制隐写分析器将隐写图像分类为真实载体。Shi等人[27] 在SGAN 的基础上提出了安全隐写GAN(Secure Steganography GAN,SSGAN) ,采用WGAN 来替换SGAN 的GAN 框架。这可以加速SSGAN 的训练并增强生成图像的感知质量。Hayes和Danezisv [15] 提出了另一个基于GAN 的隐写模型(HayesGAN ),该模型将载体图像和秘密消息作为GAN 的输入来合成隐写图像。判别器用于提取秘密消息并评估其提取准确性。隐写分析器评估合成隐写图像的不可检测能力。然而,由于误差的存在,很难确保嵌入的秘密消息能够完全提取。Tang等人[17] 将GAN 和自适应隐写术结合,设计了ASDL-GAN 用于隐写失真代价。根据报告的ASDL-GAN ,生成器的目标是生成修改概率图,判别器(即隐写分析器)旨在区分隐写图像与载体图像。经过生成器和判别器之间的几轮对抗训练后,生成器可以产生相对最优的修改概率图来计算隐写失真代价。最后,基于隐写失真代价采用STC 嵌入秘密消息。而Yang等人[28] 对ASDL-GAN 进行了几项改进,提出使用tanh-simulator 作为激活函数来替换ASDL-GAN 中的TES(三元嵌入模拟器) ,以解决TES 难以执行梯度反向传播的问题。在判别器的设计中也考虑了选定通道,使得学习的失真代价能够抵抗基于选定通道的隐写分析方法。此外,Ye.等人[29] 提出了一种基于GAN 的音频隐写术方法,其中秘密音频的嵌入和提取由GAN 完成。Yang等人[30] 采用GAN 学习嵌入代价,在时域接近音频隐写术的最优嵌入。

- 生成对抗网络(GAN)的发展核心概念:

• GAN由Goodfellow等人[23] 首次提出,目标是建立能生成与真实样本相同数据分布的生成器

• 通过生成器和判别器的持续对抗博弈达到平衡点,使判别器无法区分生成样本和真实样本

技术改进:

• WGAN [24]:使用Earth-Mover距离替代JS散度,解决训练不稳定问题

• LS-GAN [25]:限制损失函数满足Lipschitz约束

• 条件GAN (CGAN) [26]:为判别器和生成器添加条件信息指导训练- 基于GAN的隐写术方法演进

图像域的发展历程:

早期探索:

• 隐写GAN (SGAN) [14]:首个GAN隐写模型,以随机噪声生成视觉上不可区分的掩体图像

• 安全隐写GAN (SSGAN) [27]:基于SGAN改进,采用WGAN框架提升训练速度和感知质量

方法创新:

• HayesGAN [15]:直接以掩体图像和秘密消息为输入合成隐写图像

• 生成隐写术 (GSS) [16]:通过生成器直接采样产生隐写图像,无需使用掩体

• 自动隐写失真学习框架 (ASDL-GAN) [17]:结合GAN与自适应隐写术学习嵌入概率图

技术优化:

• Yang等人的改进 [28]:用tanh模拟器替代TES解决梯度反传问题,考虑选择通道抵抗相应分析方法

对抗样本启发的方法:

• Zhang等人[18]:采用FGSM在掩体上添加噪声模拟嵌入操作,通过对抗攻击获取扰动

• Tang等人[20]:从隐写术角度研究对抗样本,用于调整隐写失真代价- 音频隐写术的挑战与现状

检测威胁:

• Lin-Net [21]和Chen-Net [22] 等深度学习隐写分析器对传统音频隐写术构成严重威胁

• 传统音频隐写术无法有效抵抗这些先进的检测方法

音频GAN隐写术的有限进展:

• Ye等人[29]:提出基于GAN的音频隐写术,由GAN完成秘密音频的嵌入和提取

• Yang等人[30]:采用GAN学习嵌入代价,在时域接近音频隐写术的最优嵌入

研究空白:

• 相比图像域的丰富研究,音频域的GAN隐写术方法较少

• 现有音频GAN隐写术在感知质量和不可检测性方面仍有较大改进空间

• 缺乏专门针对深度学习隐写分析器设计的音频隐写术对抗方法- 技术发展趋势

从非自适应到自适应: 从简单的LSB、LSBM发展到WOW、HUGO、HILL、S-UNIWARD等基于STC的自适应方法

从传统到深度学习: 从SRM等传统分析方法发展到深度学习分析器,推动隐写术向GAN等深度学习方法演进

从图像到音频: 研究重点从图像域扩展到音频域,但音频领域的研究仍相对滞后

这些相关工作为本文提出的基于GAN的音频隐写术方法奠定了理论基础,同时也突出了在音频域开发更有效隐写术方法的必要性和紧迫性。

III. 使用GAN生成隐写载体音频(GENERATING STEGANOGRAPHIC COVER AUDIO USING GAN)

在本节中,我们首先描述所提出的训练框架,包括生成器和判别器的网络架构、损失函数和训练策略。

A. 总体框架(OVERALL FRAMEWORK)

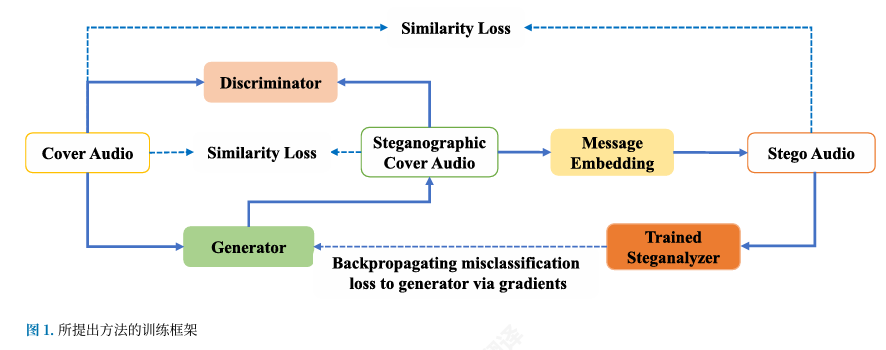

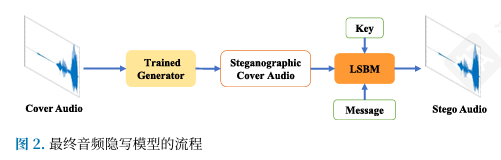

图1 展示了所提出隐写术方法的训练框架,它由三个主要部分组成:生成器、判别器和训练好的隐写分析器。应该指出的是,训练好的隐写分析器在Lin-Net 上实现,该网络已经预先训练到收敛。具体而言,将原始载体音频作为生成器的输入,用于生成无法区分的隐写载体音频。也就是说,生成的隐写载体音频应该尽可能与原始载体相似。然后采用传统消息嵌入算法LSBM 将秘密消息嵌入到隐写载体音频中以获得隐写音频,将其传递给训练好的隐写分析器以将其误分类为载体音频。一旦发生误分类,与预测损失对应的误差将反向传播到生成器以更新权重参数。值得注意的是,我们鼓励隐写分析器的误行为,因为我们的目标是欺骗基于深度学习的隐写分析器。经过充分的对抗训练,将获得训练良好的生成器。在最终的隐写术中,我们使用训练良好的生成器生成隐写载体音频,然后使用传统隐写术算法LSBM 在隐写载体音频上嵌入秘密消息以产生不可检测的隐写音频。最终隐写术模型的工作流程如图2 所示。

B. 生成器架构(GENERATOR ARCHITECTURE)

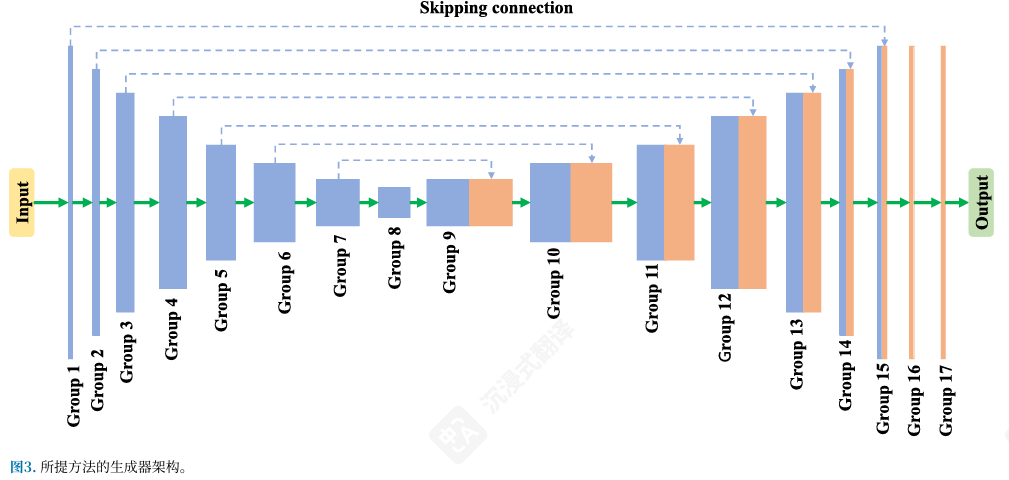

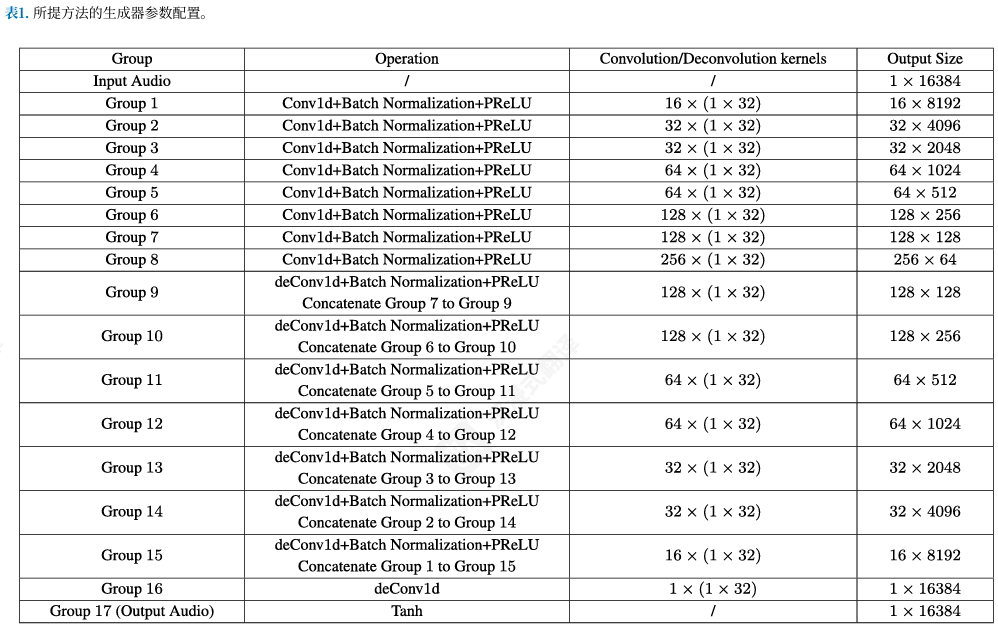

受U-Net [31] 架构能够以出色的性能处理图像到图像转换任务这一事实的启发,我们精心设计了生成器的架构,采用U-Net 风格。生成器的目标是自动学习生成用于消息嵌入的隐写载体音频,然后隐写分析器可以将相应的隐写音频误分类为载体音频。如图3 所示的生成器架构包含8个卷积层和8个反卷积层,表1 说明了所提出方法中生成器的详细参数配置。

具体而言,所有卷积层和反卷积层的卷积核大小均为1×32,步幅为2,填充为15,并级联批归一化。由于网络越深,卷积操作后保留的内容信息越少,这可能导致隐写载体音频的感知质量较差。因此,我们采用跳跃连接(Skip Connection) 作为快捷方式,将卷积层和相应反卷积层之间具有相同大小的特征图连接起来。跳跃连接可以使反卷积层共享卷积层提取的特征,这有利于隐写载体音频的感知质量。我们将来自Group i 的特征图连接到Group L − i ,这里L是16。我们从Group 1 到Group 15 应用参数化修正线性单元(PReLU)[32] 。Group 17 中的正切激活函数用于保证隐写载体音频的采样值范围从-1到1。应该指出的是,生成器的所有卷积和反卷积层都使用Xavier [33] 方法初始化。

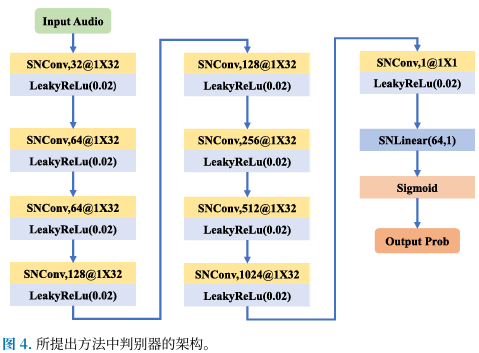

C. 判别器架构(DISCRIMINATOR ARCHITECTURE)

所提出方法中判别器的架构如图4 所示。判别器旨在区分原始音频与隐写载体音频,这可以激励生成器产生逼近原始音频中数据分布的载体音频。在我们提出的方法中,我们采用谱归一化(Spectral Normalization) 技术,该技术在谱归一化GAN(SNGAN) ¹ [34] 的工作中提出。与其他GAN 相比,SNGAN 的亮点之一是所有卷积层和全连接层的权重参数都通过谱范数归一化。我们采用谱归一化的原因是这可以稳定GAN 的训练过程,并最终激励我们提出方法中的生成器产生具有更好感知质量的隐写载体音频。

更详细地说,我们提出方法中的判别器包含9个卷积层和1个全连接层。应该指出的是,我们通过使用谱范数归一化其权重参数来重新设计卷积层中的新颖卷积核。这个重新设计的卷积核可以称为"SNConv "。在重新设计的全连接层"SNLinear "中,权重参数也通过谱范数归一化。每个卷积块级联LeakyReLU [35] ,斜率设置为0.01,sigmoid函数放置在全连接层的后面。所有卷积层的卷积核大小设置为1×32,步幅为1,填充为15。

D. 损失函数(LOSS FUNCTION)

为了迫使生成器产生具有出色感知质量的隐写载体音频,损失函数是指导生成器和判别器训练过程的重要标准。为了确保判别器具有相对较好的判别能力,并且还促进载体音频抵抗消息嵌入操作造成的影响。我们将训练过程分为两个阶段:在第1阶段,只有判别器和生成器参与对抗训练,在第2阶段,训练好的隐写分析器开始加入剩余的对抗训练。相应地,我们精心设计了两个阶段的损失函数。

特别地,为了定义损失函数,我们将隐写音频和隐写音频的对应标签都设置为0,将原始音频和载体音频的对应标签都设置为1。

对于第1阶段,损失函数可以表示为:

L s t a g e 1 = L D + L G 1 (1) L_{stage1} = L_D + L_{G1} \tag{1} Lstage1=LD+LG1(1)

其中 L s t a g e 1 L_{stage1} Lstage1表示第1阶段GAN 框架的损失。损失 L D L_D LD和 L G 1 L_{G1} LG1根据二元交叉熵计算。第1阶段生成器的损失可以通过以下方式计算:

L G 1 = E x [ log ( 1 − D ( G ( x ) ) ) ] (2) L_{G1} = E_x[\log(1 - D(G(x)))] \tag{2} LG1=Ex[log(1−D(G(x)))](2)

其中 x x x表示原始音频(生成器的输入), E x [ ⋅ ] E_x[·] Ex[⋅]是输入真实音频片段上的期望算子。判别器旨在区分隐写载体音频与原始载体音频。因此判别器的损失可以通过以下方式计算:

L D = − { E x [ log D ( G ( x ) ) ] + E x [ log ( 1 − D ( x ) ) ] } (3) L_D = -\{E_x[\log D(G(x))] + E_x[\log(1 - D(x))]\} \tag{3} LD=−{Ex[logD(G(x))]+Ex[log(1−D(x))]}(3)

对于第2阶段,损失函数展示如下:

L s t a g e 2 = α L G A N + β L S i m (4) L_{stage2} = \alpha L_{GAN} + \beta L_{Sim} \tag{4} Lstage2=αLGAN+βLSim(4)

其中 L s t a g e 2 L_{stage2} Lstage2表示第2阶段GAN 框架的损失, L S i m L_{Sim} LSim是相似性损失函数,用于衡量隐写载体音频与原始音频之间的相似性。超参数 α \alpha α和 β \beta β平衡两部分的重要性。更具体地, L G A N L_{GAN} LGAN由生成器和判别器的损失组成,可以表示为:

L G A N = L D + L G 2 (5) L_{GAN} = L_D + L_{G2} \tag{5} LGAN=LD+LG2(5)

损失 L D L_D LD和 L G 2 L_{G2} LG2根据二元交叉熵计算。对于生成器,其目标是产生在听觉上与原始音频没有差异的隐写音频,通过嵌入操作产生的隐写音频被发送到隐写分析器以预测属于载体音频的概率。载体音频标签与预测概率之间的损失应该被最小化,用于传播到生成器以更新其参数。这致力于迫使生成器产生适合嵌入消息的更好隐写载体音频,使得隐写音频不容易被隐写分析器区分。因此,生成器的损失可以通过以下方式计算:

L G 2 = E x [ log ( 1 − D ( G ( x ) ) ) ] + E x [ log ( 1 − S ( F ( G ( x ) ) ) ) ] (6) L_{G2} = E_x[\log(1 - D(G(x)))] + E_x[\log(1 - S(F(G(x))))] \tag{6} LG2=Ex[log(1−D(G(x)))]+Ex[log(1−S(F(G(x))))](6)

其中 x x x表示原始音频。 E x [ ⋅ ] E_x[·] Ex[⋅]是输入原始音频片段上的期望算子。 F ( ⋅ ) F(·) F(⋅)表示传统信息方法,例如LSBM , D ( ⋅ ) D(·) D(⋅)、 S ( ⋅ ) S(·) S(⋅)和 G 2 ( ⋅ ) G2(·) G2(⋅)分别表示判别器、隐写分析器和生成器。相似性损失项 L S i m L_{Sim} LSim应该有两部分:第一部分衡量隐写载体音频与原始载体音频之间的差异,第二部分衡量隐写音频与原始音频之间的差异。这可以表示为:

L S i m = E x [ ∥ G ( x ) − x ∥ 1 ] + E x [ ∥ F ( G ( x ) ) − x ∥ 1 ] (7) L_{Sim} = E_x[\|G(x) - x\|_1] + E_x[\|F(G(x)) - x\|_1] \tag{7} LSim=Ex[∥G(x)−x∥1]+Ex[∥F(G(x))−x∥1](7)

这里,应用L1范数 来衡量隐写载体音频与原始音频之间的相似性损失。在我们的实验中,也使用L2范数 来衡量上述相似性损失,然后我们发现使用L1范数 的隐写载体音频与使用L2范数 生成的相比享有稍好的感知质量。

最后,我们想要说明隐写分析器是基于Lin-Net [21] 的训练良好的神经网络。因此在第2阶段,涉及隐写分析器,但其所有模型参数都是固定的;它只负责通过梯度反向传播预测误差。反向传播的误分类误差用于更新生成器的参数,这可能迫使生成器学习生成适合消息嵌入的隐写载体音频,并试图欺骗隐写分析器。

基于文档内容,我来详细解析损失函数的设计思路和各公式的含义:

损失函数设计理念

两阶段训练策略

阶段1:仅生成器和判别器参与,建立基础对抗能力

阶段2:加入隐写分析器,针对性增强反检测能力

标签设置策略

- 隐写音频和隐写掩体音频 → 标签 = 0(假样本)

- 原始音频和真实掩体音频 → 标签 = 1(真样本)

阶段1:基础GAN训练

总损失函数

L s t a g e 1 = L D + L G 1 ( 1 ) L_{stage1} = L_D + L_{G1} \quad (1) Lstage1=LD+LG1(1)

生成器损失

L G 1 = E x [ log ( 1 − D ( G ( x ) ) ) ] ( 2 ) L_{G1} = E_x[\log(1 - D(G(x)))] \quad (2) LG1=Ex[log(1−D(G(x)))](2)

含义解析:

- G ( x ) G(x) G(x):生成器将原始音频 x x x转换为隐写掩体音频

- D ( G ( x ) ) D(G(x)) D(G(x)):判别器对生成音频的真实性评分(0-1之间)

- log ( 1 − D ( G ( x ) ) ) \log(1 - D(G(x))) log(1−D(G(x))):当 D ( G ( x ) ) D(G(x)) D(G(x))接近1时(判别器认为是真的),损失变大

- 目标:让生成器"欺骗"判别器,使其认为生成的音频是真实的

判别器损失

L D = − { E x [ log D ( G ( x ) ) ] + E x [ log ( 1 − D ( x ) ) ] } ( 3 ) L_D = -\{E_x[\log D(G(x))] + E_x[\log(1 - D(x))]\} \quad (3) LD=−{Ex[logD(G(x))]+Ex[log(1−D(x))]}(3)

含义解析:

- 第一项 E x [ log D ( G ( x ) ) ] E_x[\log D(G(x))] Ex[logD(G(x))]:希望判别器将生成音频识别为假( D ( G ( x ) ) → 0 D(G(x)) \rightarrow 0 D(G(x))→0)

- 第二项 E x [ log ( 1 − D ( x ) ) ] E_x[\log(1 - D(x))] Ex[log(1−D(x))]:希望判别器将真实音频识别为真( D ( x ) → 1 D(x) \rightarrow 1 D(x)→1)

- 目标:增强判别器的分辨能力

阶段2:加入隐写分析器

总损失函数

L s t a g e 2 = α L G A N + β L S i m ( 4 ) L_{stage2} = \alpha L_{GAN} + \beta L_{Sim} \quad (4) Lstage2=αLGAN+βLSim(4)

设计思路:

- α L G A N \alpha L_{GAN} αLGAN:维持GAN的基本对抗能力

- β L S i m \beta L_{Sim} βLSim:确保生成音频与原始音频的相似性

- α , β \alpha, \beta α,β:平衡两个目标的重要性权重

GAN损失部分

L G A N = L D + L G 2 ( 5 ) L_{GAN} = L_D + L_{G2} \quad (5) LGAN=LD+LG2(5)

增强生成器损失

L G 2 = E x [ log ( 1 − D ( G ( x ) ) ) ] + E x [ log ( 1 − S ( F ( G ( x ) ) ) ) ] ( 6 ) L_{G2} = E_x[\log(1 - D(G(x)))] + E_x[\log(1 - S(F(G(x))))] \quad (6) LG2=Ex[log(1−D(G(x)))]+Ex[log(1−S(F(G(x))))](6)

关键创新:

- 第一项:保持原有的对抗判别器能力

- 第二项 :核心创新 - 对抗隐写分析器

- F ( G ( x ) ) F(G(x)) F(G(x)):在生成的隐写掩体音频上嵌入秘密消息得到隐写音频

- S ( F ( G ( x ) ) ) S(F(G(x))) S(F(G(x))):隐写分析器对隐写音频的分类概率

- log ( 1 − S ( F ( G ( x ) ) ) ) \log(1 - S(F(G(x)))) log(1−S(F(G(x)))):希望隐写分析器将隐写音频误分类为掩体音频

相似性损失

L S i m = E x [ ∥ G ( x ) − x ∥ 1 ] + E x [ ∥ F ( G ( x ) ) − x ∥ 1 ] ( 7 ) L_{Sim} = E_x[\|G(x) - x\|_1] + E_x[\|F(G(x)) - x\|_1] \quad (7) LSim=Ex[∥G(x)−x∥1]+Ex[∥F(G(x))−x∥1](7)

双重约束:

- 第一项 : ∥ G ( x ) − x ∥ 1 \|G(x) - x\|_1 ∥G(x)−x∥1 - 确保隐写掩体音频与原始音频相似

- 第二项 : ∥ F ( G ( x ) ) − x ∥ 1 \|F(G(x)) - x\|_1 ∥F(G(x))−x∥1 - 确保最终隐写音频与原始音频相似

设计精髓

对抗性设计

通过公式(6)的第二项,生成器学会产生能够"愚弄"隐写分析器的掩体音频,这是传统隐写术无法实现的主动防御能力。

多目标优化

- 欺骗判别器:确保生成质量

- 欺骗隐写分析器:确保安全性

- 保持相似性:确保不可感知性

端到端优化

整个流程从原始音频到最终隐写音频的完整路径都在优化范围内,形成了闭环的对抗训练机制。

固定隐写分析器

隐写分析器 S S S的参数固定不变,仅作为"老师"提供梯度信号,避免了训练不稳定问题。

这种损失函数设计巧妙地将传统隐写术的嵌入过程纳入了GAN的训练框架中,实现了针对深度学习检测器的主动对抗能力。

E. 训练策略(TRAINING STRATEGY)

在我们提出的方法中,训练过程包括两个阶段。在第1阶段,我们预先训练GAN 框架(即生成器G 和D )N 个周期(我们经验性地设置N 为30)。在第2阶段,隐写分析器加入训练过程开始后训练,这大约需要另外100个周期。这是为了保证判别器具有更强的判别能力来区分隐写载体音频与原始载体音频,并且也促使生成器产生具有优越感知质量的载体音频。生成器和判别器交替训练,也就是说,当训练生成器时,判别器的权重参数是固定的,反之亦然。应该指出的是,隐写分析器的参数在整个训练过程中不会更新。隐写分析器的作用是输出隐写音频属于原始音频的置信度。然后产生的误分类损失可以通过梯度反向传播到生成器G ,用于更新生成器的参数。训练策略在算法1 中简要描述。

IV. 实验结果(EXPERIMENTAL RESULTS)

A. 实验设置(EXPERIMENTAL SETUP)

TIMIT语料库[36] 和UME语料库[37] 是语音识别说话人识别等中两个广泛使用的数据集。TIMIT 和UME 都包含采样频率为16 kHz的无压缩单声道音频。我们分别在两个数据集上进行了实验来验证所提出方法的有效性。TIMIT 用于训练所提出方法中的生成器,UME 用于使用不同的基于深度学习的隐写分析方法评估不可检测性性能。

为了便于设计生成器的框架,我们将音频文件裁剪成具有16384个采样点的小片段。在训练过程中,使用15000个小片段来训练生成器,mini-batch 大小设置为32。使用Adam优化器 ,学习率为0.0001。经验性地,损失函数中的超参数 α \alpha α和 β \beta β都设置为1。输入在馈送到生成器之前首先进行归一化,使用最大-最小归一化技巧将输入音频归一化到[-1, 1]。所提出的方法使用PyTorch 实现,并在四个具有11 GB内存的NVIDIA RTX1080 Ti GPU 上训练。

B. 隐写载体音频的感知质量(PERCEPTION QUALITY OF STEGANOGRAPHIC COVER AUDIO)

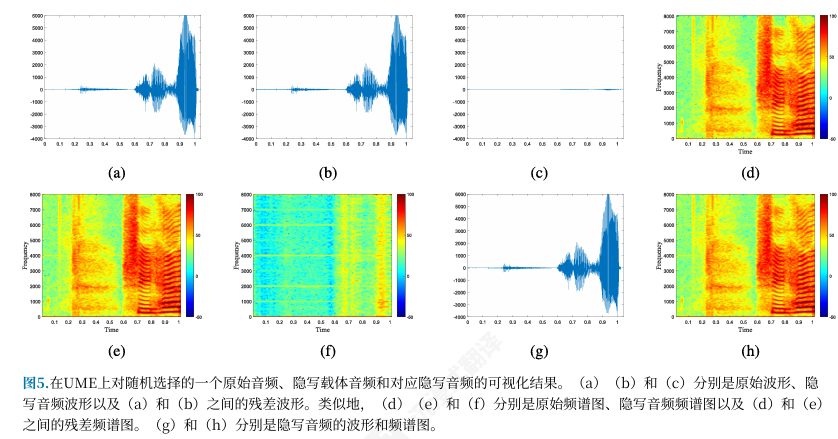

回想一下,我们方法的一个目标是在隐写载体音频上产生较小的扰动。换句话说,隐写载体音频在听觉上应该与原始载体音频无法区分,并且隐写音频(通过在隐写载体音频上嵌入消息产生)在听取时应该与原始载体音频没有差异。为了显示这一点,图5 展示了UME 上随机选择的一个原始载体音频、隐写载体音频和相应隐写音频的可视化结果。如可以看到的,隐写载体音频的波形和频谱图几乎与原始载体音频相同。残差波形验证了与原始载体音频相比,扰动的幅度相当小。隐写音频的波形和频谱图也与隐写载体音频相似。

此外,为了定量评估音频感知质量,我们采用广泛使用的参考音频质量指标,即主观指标PESQ [38] 和客观指标SNR(峰值信噪比) 。PESQ 分数范围从-0.5到4.5,较高的值表示更好的感知质量。SNR 表征了固有信号与噪声之间的平均功率比。我们从UME 中随机选择100个测试音频样本作为参考,以及相应的隐写载体音频进行评估。平均PESQ 分数为4.4235,SNR 为83.275 dB。这意味着隐写载体音频在人类听觉中无法与原始音频区分,这验证了我们提出方法通过生成具有高感知质量的隐写载体音频的有效性。

C. 与现有方法的比较(COMPARISON WITH EXISTING METHODS)

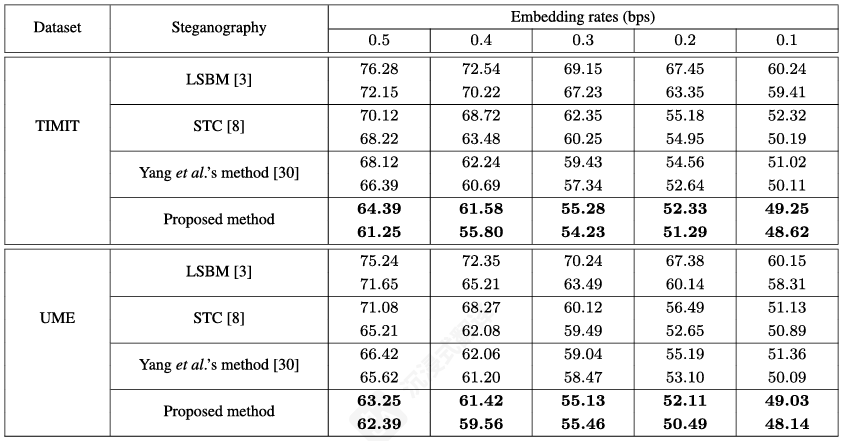

为了证明我们提出方法的性能,在我们的工作中进行了TIMIT 和UME 的两个实验。我们将检测准确性与LSBM [3] 、STC [8] 和Yang等人的基于GAN的方法[30] 进行比较。应该注意的是,我们将STC 失真代价定义为1以便于实验。两种最先进的基于深度学习的隐写分析方法,Lin-Net [21] 和Chen-Net [22] 分别用于评估这些隐写术方法的不可检测性性能。

对于TIMIT 上的实验,从TIMIT 中选择15000个音频片段作为在TIMIT 上训练的生成器的输入,用于生成相应的15000个隐写载体音频样本。然后将比特流秘密消息嵌入到隐写载体音频样本中。这最终产生15000个载体-隐写对样本。12000个载体-隐写对用作训练集,剩余的3000对用于测试集。我们考虑了五个嵌入率进行测试,即每样本0.5比特(bps)、0.4 bps、0.3 bps、0.2 bps和0.1 bps。

为了减少实验结果的随机性,我们在随机分割训练集和测试集下重复所有实验10次,然后平均检测准确性。如上所述的类似实验也在UME 上进行。唯一的区别是我们将UME 的音频片段作为在TIMIT 上训练的生成器的输入,用于生成相应的隐写载体音频样本。

检测准确性结果列在表2 中。如可以看到的,一般而言,对于所有嵌入率、所有测试数据集和所有基于深度学习的隐写分析器,我们的方法一致地获得了较低的检测准确性。这意味着所提出的方法可以为消息嵌入生成更好的隐写载体音频,有益于传统隐写术方法。通过更仔细的比较,对于低嵌入率,例如0.1 bps,我们方法的检测准确性范围从48.14%到49.25%,接近随机猜测(即50%),STC 也可以观察到类似现象。相反,传统方法LSBM 的检测准确性都超过58%。这表明,对于较低的嵌入率,传统方法LSBM 更容易受到基于深度学习的方法的攻击,而我们提出的方法和STC 都保持良好的不可检测性。

然而,对于大的嵌入率,例如0.5 bps,我们提出方法的优越性变得更加明显。例如,对于UME 数据集上隐写分析器Lin-Net 的情况,LSBM 和STC 的检测准确性分别为75.24%和71.08%。相比之下,我们的方法产生63.25%,仍然享有较低的不可检测性。此外,与Yang等人的基于GAN的方法 相比,我们提出的方法在各种嵌入率下都取得了较低的检测准确性。这是因为我们提出的方法可以生成适合消息嵌入的隐写载体音频,这确保了隐写音频的数据分布更接近原始载体音频的数据分布。这使得隐写分析器难以区分隐写音频与载体音频。

例如,当在TIMIT 上训练生成器并使用Chen-Net 评估UME 的不可检测性时,在0.5 bps下,我们提出方法的检测准确性比Yang等人的方法 低3.23%。类似地,当嵌入率为0.1 bps时,我们提出的方法享有更好的不可检测性性能。

因此,无论与传统音频隐写术方法还是现有基于GAN 的音频隐写术方案相比,我们提出的方法在各种嵌入率下都见证了出色的不可检测性性能。

D. 消融实验(ABLATION EXPERIMENT)

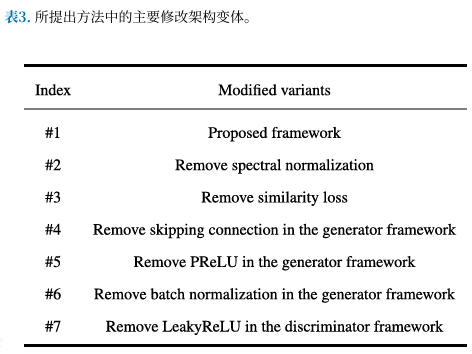

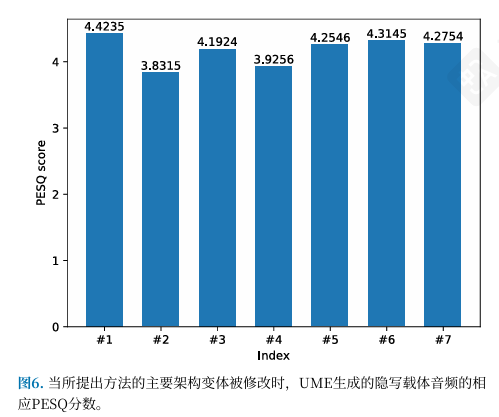

在本节中,我们对所提出框架的主要架构变体进行了消融实验,如表3 所示。图6 说明了当修改这些主要变体时,UME 隐写载体音频的相应PESQ 分数。很明显,我们提出的框架可以生成具有最大PESQ 分数4.4235的隐写载体音频,与其他6个生成式隐写术模型相比。这意味着我们提出的框架在生成具有出色感知质量的载体音频方面最有效。

此外,变体2和4可能对隐写载体音频的感知质量产生突出影响,PESQ 分数分别为3.8315和3.9256。我们可能感知到在听取时隐写载体音频中存在明显噪声,这享有低听觉体验。总而言之,所提出框架中的架构变体是最优的。

V. 结论(CONCLUSION)

在这项工作中,我们提出使用生成对抗网络为隐写术生成更好的隐写载体音频。在这种隐写载体音频上嵌入消息可以产生更安全的隐写音频,能够抵抗基于深度学习的隐写分析器。所提出方法的训练框架包含三个主要模块:生成器、判别器和现成的基于深度学习的隐写分析器。我们精心设计了生成器和判别器的网络架构,并为所提出框架中三个模块之间的对抗训练提出了有效的训练策略。

一旦这三方之间的对抗训练完成,就可以获得训练良好的生成器,该生成器可以生成隐写载体音频用于后续消息嵌入。通过使用训练良好的生成器,可以像往常一样使用传统隐写术嵌入秘密消息。实验结果表明,所提出音频隐写术方法的生成器可以产生具有高感知质量的隐写载体音频,同时保持合理的不可检测性性能,即使在大的嵌入率下也是如此。

本文为个人阅读

GAN音频隐写论文,部分内容注解,由于原文篇幅较长这里就不再一一粘贴,仅对原文部分内容做注解,仅供参考详情参考原文链接

原文链接:https://ieeexplore.ieee.org/abstract/document/9459771希望对你有帮助