1. 问题描述

- 用以下命令启动 vllm 服务时报错,报错截图如下。

shell

# 启动命令

vllm serve /home/paulyu12/models/ilama-3.2-1B \

--gpu-memory-utilization 0.8- 报错文本

txt

Value error, The repository /home/paulyu12/models/ilama-3.2-1B contains custom code which must be executed to correctly load the model. You can inspect the repository content at /home/paulyu12/models/ilama-3.2-1B .- 报错截图

2. 问题分析

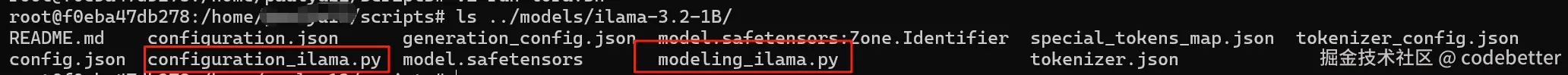

查看模型文件目录,可以看到存在 *.py 的脚本文件。这些文件就是报错中所说的 "custom code"。

3. 问题解决

启动 vllm 服务时,添加 --trust-remote-code 参数。

4. 其它参数说明

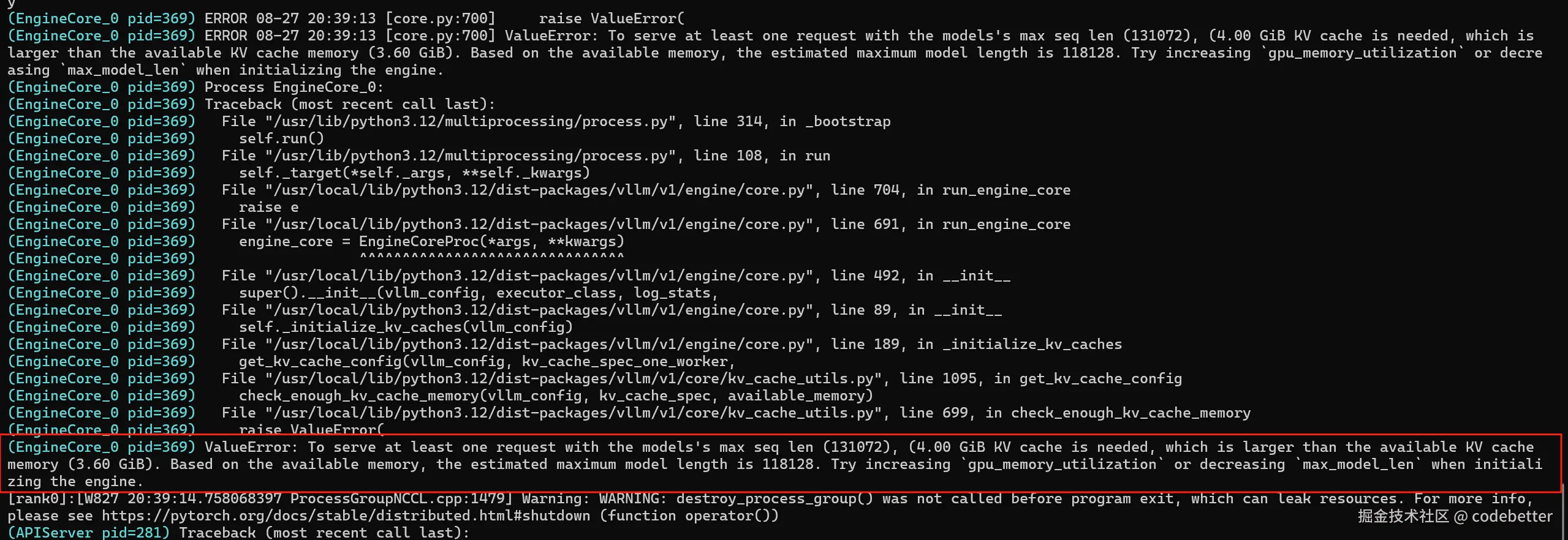

- max_model_len:模型的最大生成长度,包含prompt长度和generated长度。这个值需要根据实际情况输入。当显存容量不足时,也可以通过控制该参数,使模型得以正常启动。否则会报如下错误。