欢迎关注微信公众号:科技洞察者 📌

AI 驱动的视频和音频内容创作正迎来爆发式增长,中国科技巨头阿里巴巴和腾讯的最新开源模型,正共同定义这一领域的全新范式。

视频生成:从图像到电影级叙事

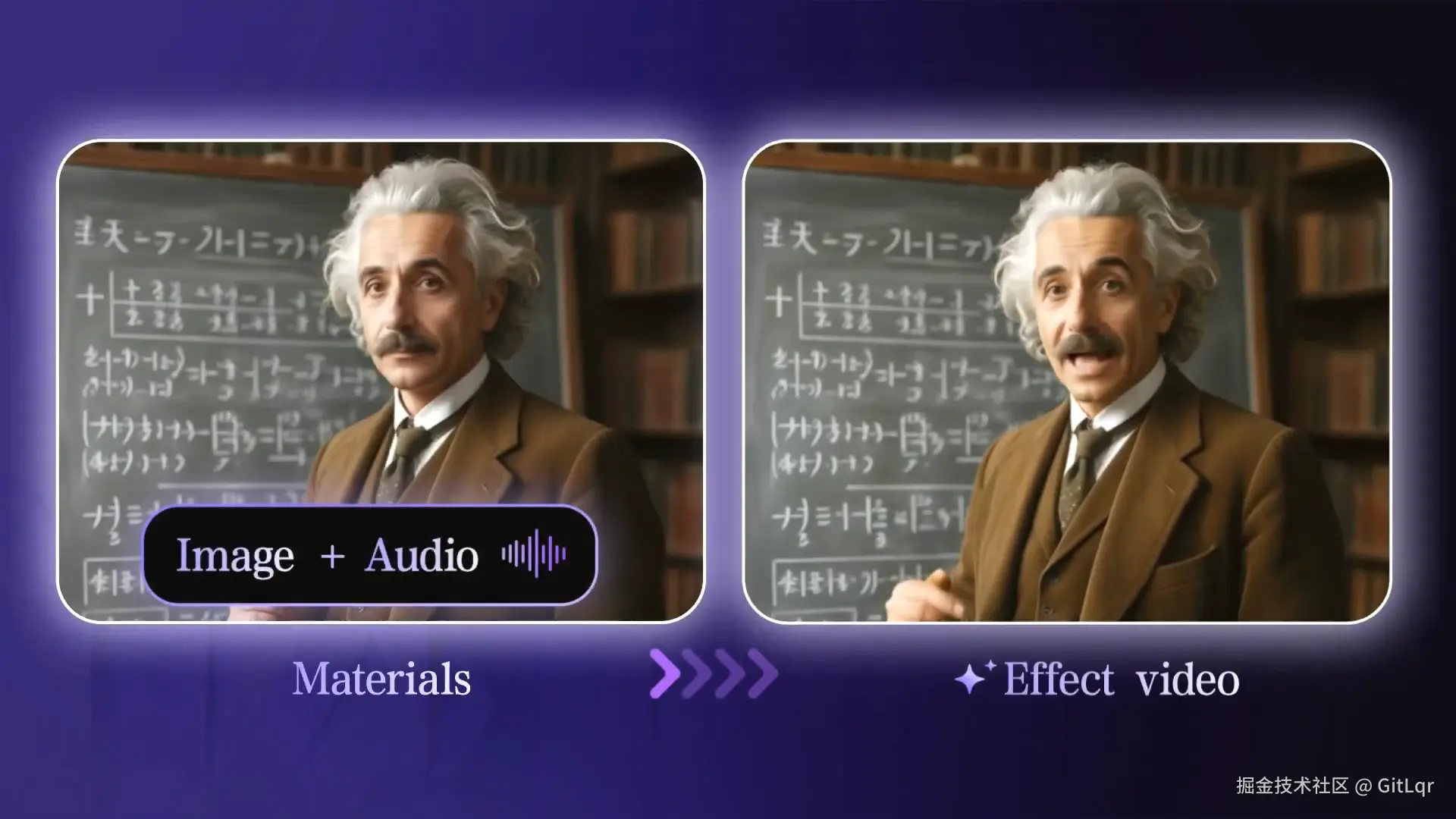

阿里巴巴 Wan2.2-S2V:音频驱动的"通义时刻"

阿里巴巴已开源其 14B 音频驱动视频模型 Wan2.2-S2V,标志着 AI 视频生成领域的又一个"通义时刻"。

这款模型仅需一张图片和一段音频,便能生成具有自然面部表情、口型高度一致且动作流畅的电影级数字人视频。

它的核心亮点在于:

- 长时稳定生成:单次生成时长可达分钟级,并保持高度稳定性和一致性,这在长视频生成中尤为关键。

- 影院级音画同步:提供高质量的音频驱动视频能力,确保数字人的表情、口型与音频内容完美匹配。

- 高级动作控制:支持基于指令的高级动作与环境控制,显著提升了电影情节的自然度和人物动作的流畅性。

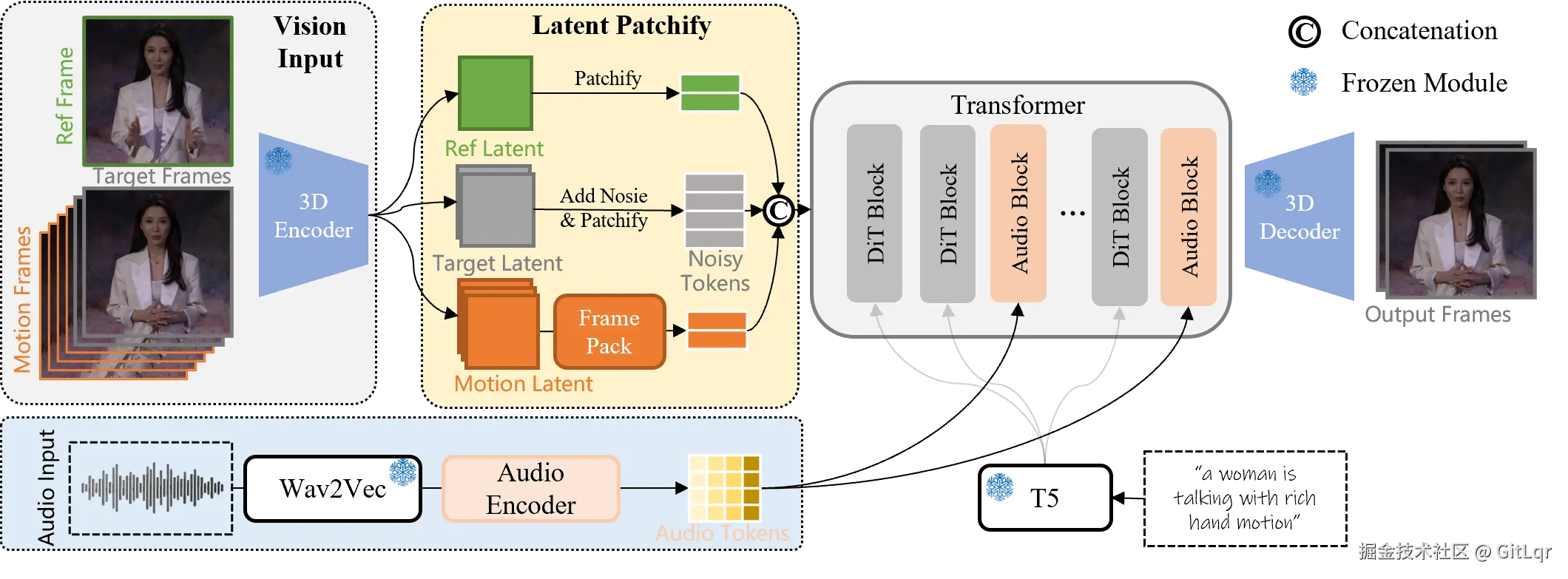

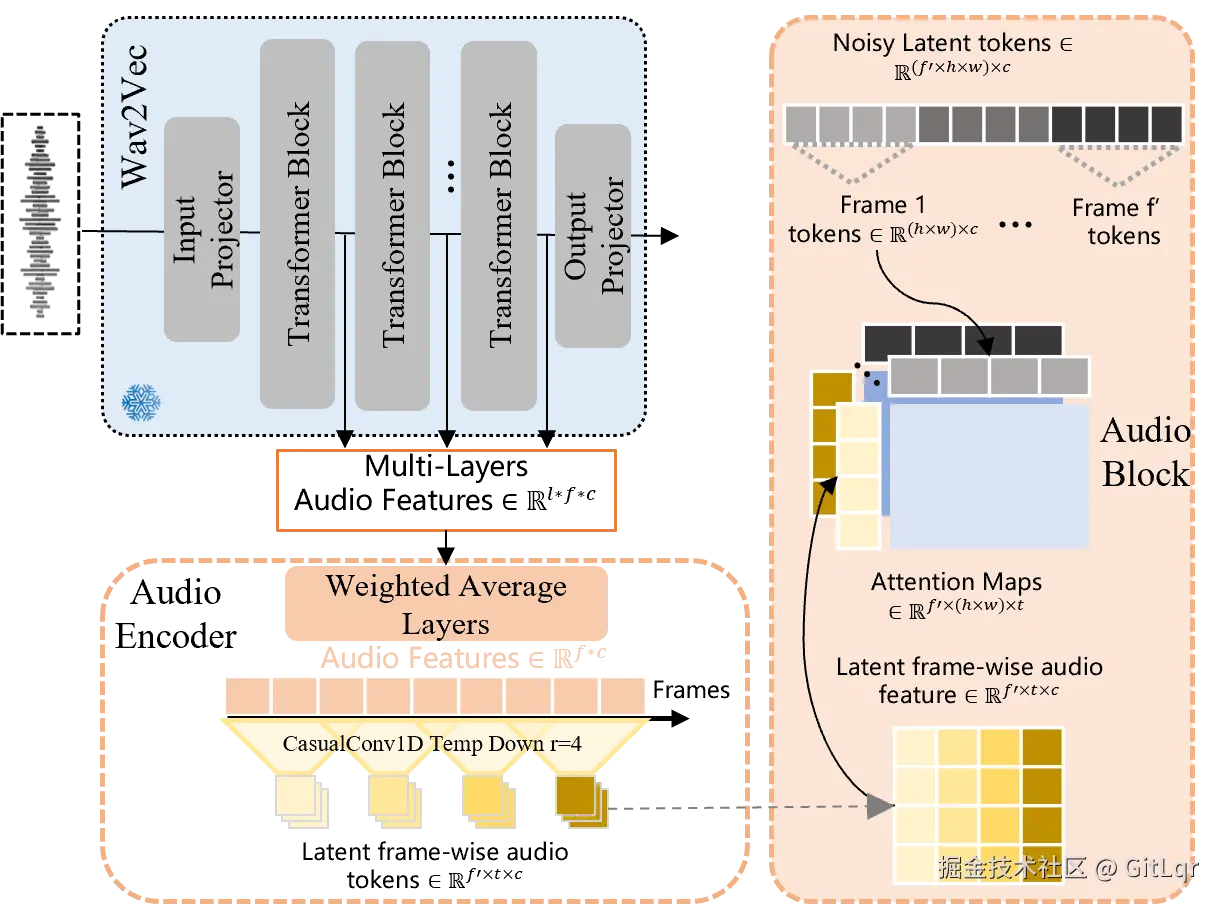

Wan2.2-S2V 基于通义万相视频生成基础模型,通过超过 60 万个音视频片段的混合并行训练构建。

它巧妙融合了文本引导的全局运动控制和音频驱动的细粒度局部运动,并引入 AdaIN+CrossAttention 机制确保音画同步。

为实现长视频生成,模型采用层次化帧压缩技术,将历史参考帧长度扩展至 73 帧,同时支持多分辨率训练和推理以适应不同视频场景。

该模型的发布,无疑让阿里巴巴通义的视频生成"全家桶"更为完善,其模型家族在开源社区和第三方平台下载量已超 2000 万,进一步巩固了其在 AI 视频生成领域的领先地位。

官网:wan.video/

主页:humanaigc.github.io/wan-s2v-web...

GitHub:github.com/Wan-Video/W...

HuggingFace:huggingface.co/Wan-AI/Wan2...

音效补全:让 AI 视频"声"临其境

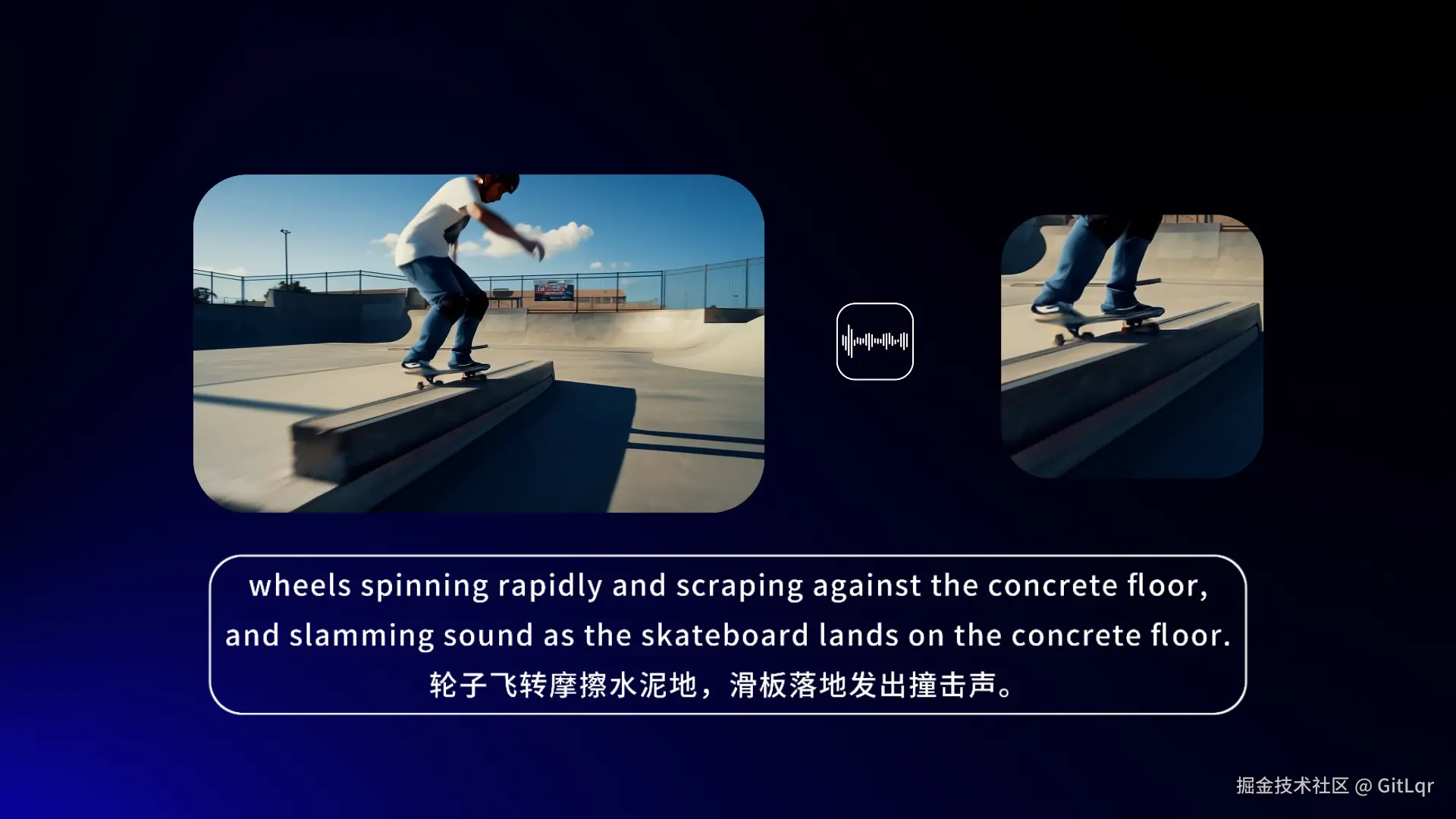

腾讯混元 HunyuanVideo-Foley:告别"有画面无声音"

在 AI 视频生成领域,一个长期存在的痛点是"有画面无声音"。腾讯混元开源的端到端视频音效生成模型 HunyuanVideo-Foley,正是为此而来。该模型能通过输入视频和文本,为视频自动匹配电影级音效,彻底打破了这一壁垒。

HunyuanVideo-Foley 解决了现有音频生成技术的三大难题:

- 高质量大规模数据集:构建了大规模高质量 TV2A(文本-视频-音频)数据集,显著提升了模型的泛化能力,使其能适应各类视频内容。

- 创新双流多模态架构:采用了创新的双流多模态扩散变换器(MMDiT)架构,有效平衡文本和视频语义,生成层次丰富的复合音效,避免了音频与场景脱节。

- 专业级生成质量:引入了表征对齐(REPA)损失函数,确保了专业级的音频生成质量和稳定性。

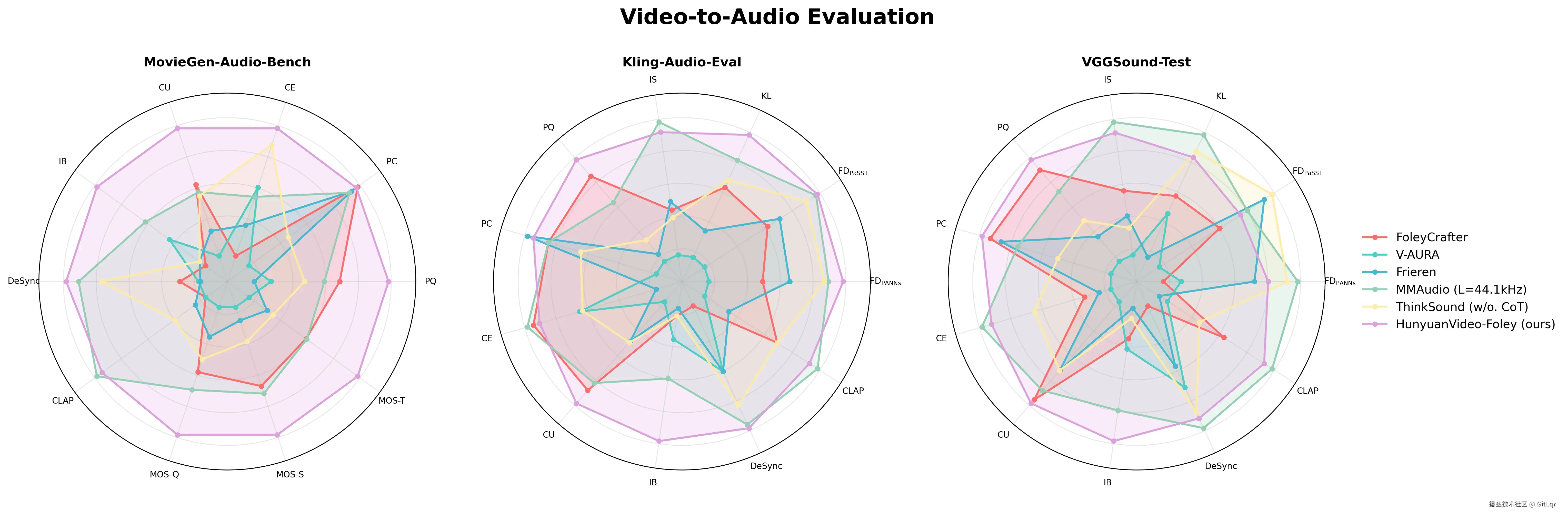

HunyuanVideo-Foley 在多项权威评测基准上均达到了新的 SOTA 水平,其音频质量、视觉语义对齐和时序对齐指标均表现出色,并在主观评测中获得接近专业水准的高分。

该模型的开源为多模态 AI 在内容创作领域的应用提供了可复用的技术范式,将极大赋能短视频创作者、电影制作团队和游戏开发者,帮助他们高效生成场景化音效、完成环境音设计和构建沉浸式听觉体验。

官网:hunyuan.tencent.com/video/zh?ta...

主页:szczesnys.github.io/hunyuanvide...

GitHub:github.com/Tencent-Hun...

HuggingFace:huggingface.co/tencent/Hun...

叙事音频:文本到复杂声景的飞跃

腾讯 ARC 实验室 AudioStory:AI 有声书与沉浸式体验的基石

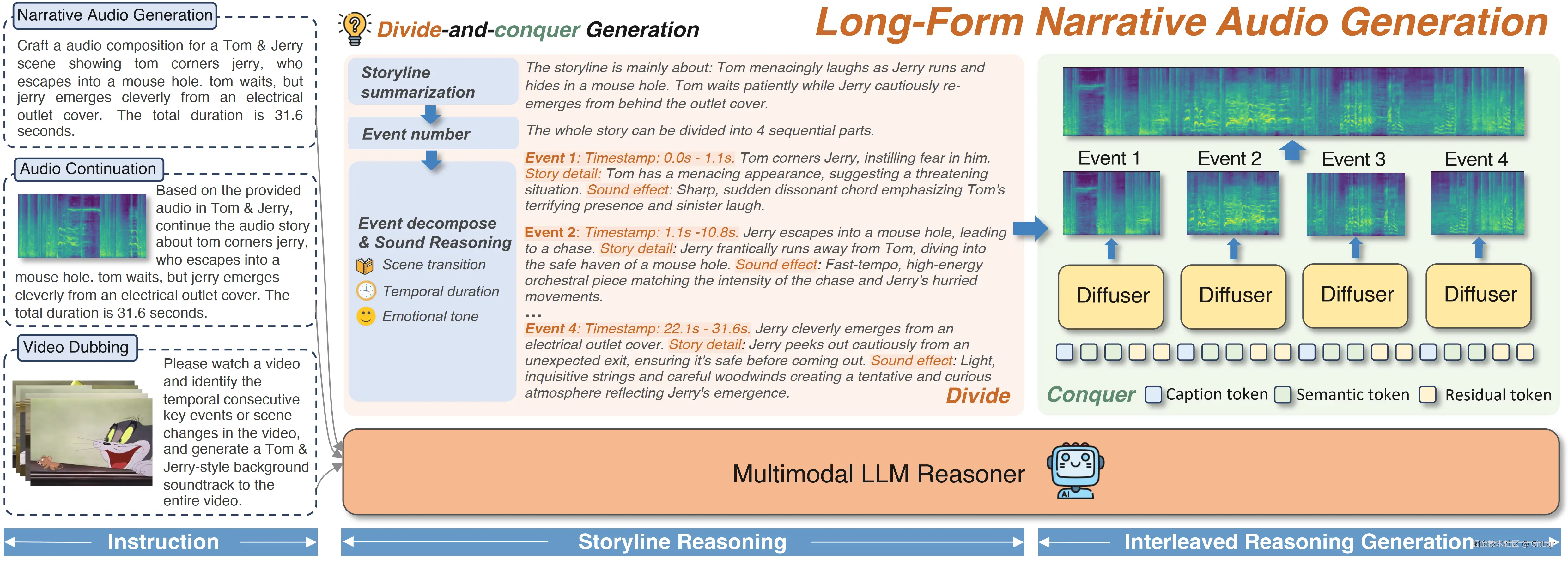

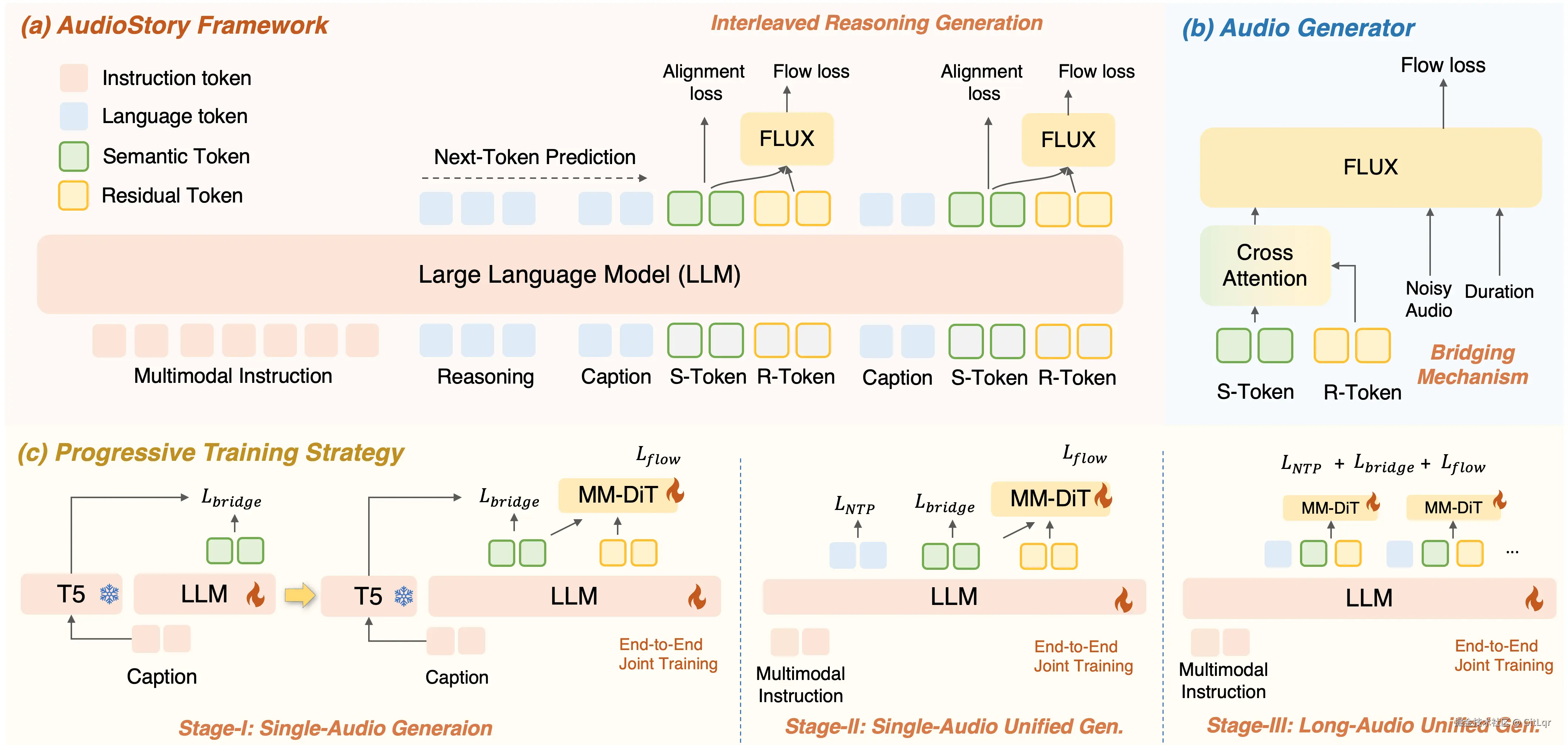

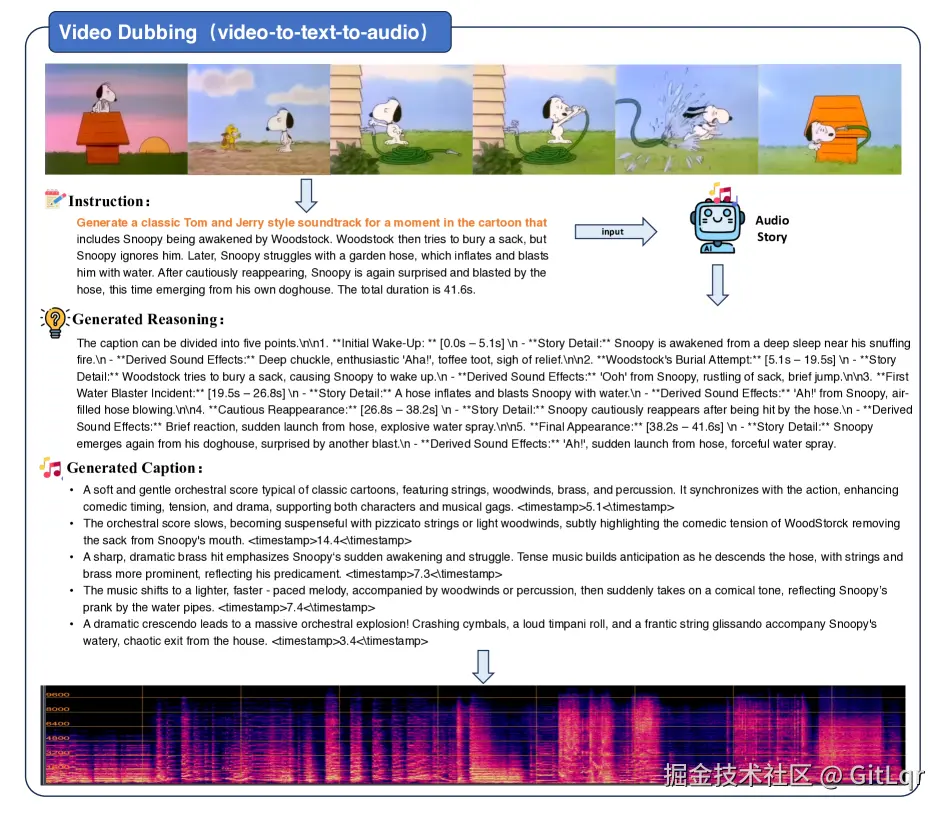

腾讯 ARC 实验室推出的 AudioStory 技术,代表着 AI 音频生成领域的又一重大突破。它使机器能够从文本描述中生成复杂、电影级的叙事音频,超越了传统模型仅能生成单一音效的局限。

这项技术旨在将文本描述转化为丰富而有层次的听觉体验,如同为故事配上电影原声。

AudioStory 的核心创新在于:

- 融合大模型与文生音频:通过融合大型语言模型(LLM)与文生音频系统,实现对复杂文本语义的深刻理解。

- "分而治之"策略:将复杂叙事分解为有序的音频事件,每个事件都配备详细的时间、情绪和场景指令,确保音频的逻辑性和连贯性。

- "解耦式连接机制":利用语义令牌传达宏观含义,同时通过残差令牌捕捉细微的音频质感,确保音频的连贯性和细节表现。

经过三阶段渐进式训练,AudioStory 在 AudioStory-10K 基准数据集上展现出卓越的指令遵循能力、音频质量和一致性,性能全面超越现有竞品。

这项技术具有广泛的应用前景,包括自动为视频配音,以及智能推断并续写音频场景等,为 AI 有声书、智能播客和沉浸式游戏音效等领域铺平了道路,标志着 AI 在创意表达和艺术化叙事方面实现了质的飞跃。

GitHub:github.com/TencentARC/...

🔥往期推荐:

- AI洞察 | Nano banana 图像新玩法,可试玩,效果惊艳

- AI洞察 | 影视配音、动漫制作提效赋能

- AI洞察 | DeepSeek-V3.1发布,自进化智能体诞生!

- AI洞察 | 混元、昆仑 重塑 3D 世界新方向

- AI洞察 | 好酷!国产模型在 电影、3D、TTS 领域取得巨大进步!

如果对你有帮助的话,请点赞、分享。关注微信公众号 科技洞察者,第一时间获取 前沿科技讯息,还有 数字人播客、演示视频 等丰富内容,我们下期再见。