引言:从"能算会说"到"会看能做"

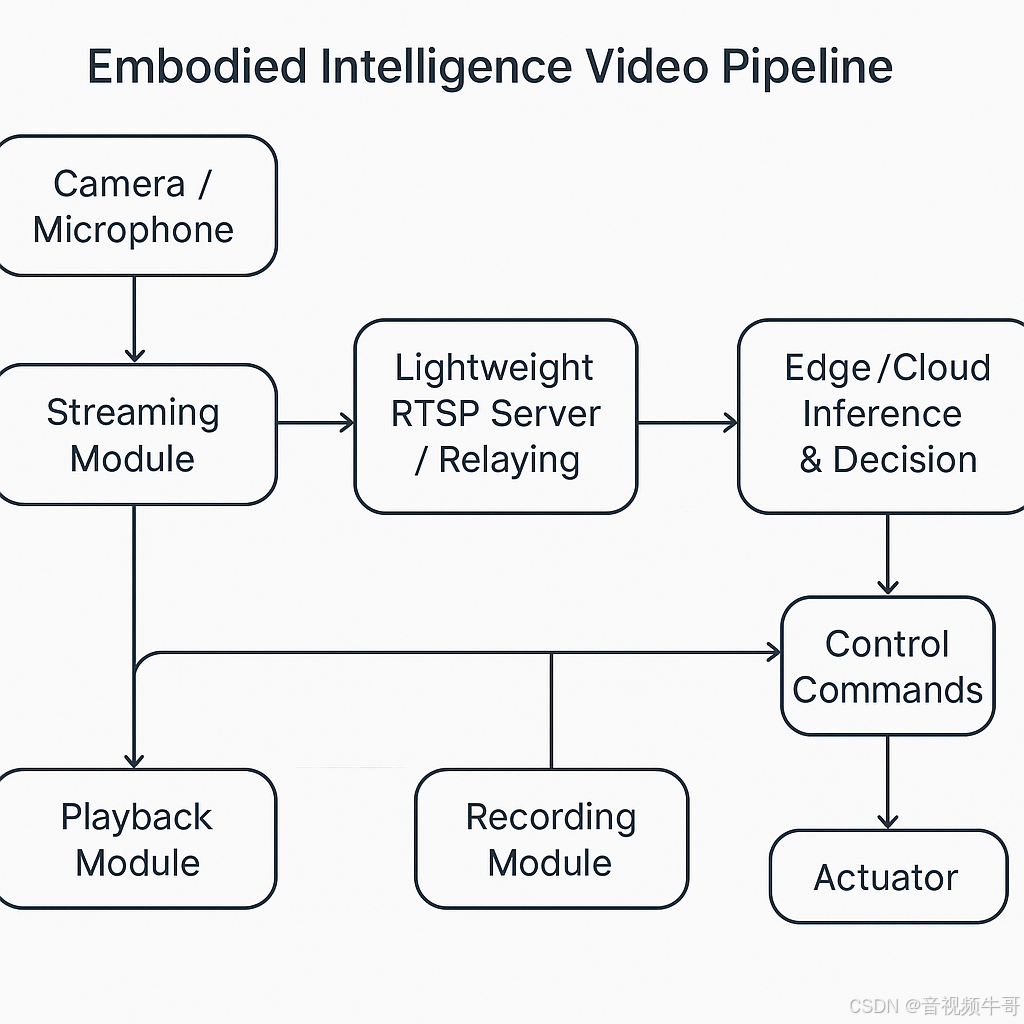

具身智能真正的门槛,不在于把模型做得更大,而在于把感知---决策---执行 焊成一条低时延、稳态可控的闭环工程链路:从相机/麦克风采集,到编解码与传输,再到边/端推理、指令下发与动作执行,最后回到新一轮的感知反馈。

这个闭环要想在真实世界长期稳定运行,离不开一条跨平台、可运维、可度量的音视频"神经通道"。大牛直播SDK(SmartMediaKit)提供的推流、播放、轻量级 RTSP 服务、GB28181 接入、多路转发与录像等模块,正是这条通道的标准化积木。

本文聚焦工程落地与复用 ,回答一个核心问题------如何用这些模块搭建具身智能的通用底座,使系统真正做到看得清、传得稳、算得快、控得准。

技术落地的关键:先固链路,再谈智能

如果把具身智能类比为"人",那么模型是大脑,而视频链路就是眼耳鼻喉与神经通道。没有稳定的链路,感知再精准、算法再强大,也无法在真实场景中闭环。

在这一点上,大牛直播SDK的价值不只是"能推流能播放",而是将 RTSP/RTMP 播放器、推流模块、轻量级 RTSP 服务、GB28181 对接、多路转发、录像 等能力打磨成可组合的基础部件。它让开发者无需从零构建底层传输栈,就能快速拼出可复用、可扩展的"视频-控制"底座。

换句话说,大牛直播SDK并不是简单的工具箱,而是具身智能场景里实现"看得清、传得稳、控得准"的工程基座。

典型架构示例:视频链路作为具身智能的"神经系统"

在机器人、无人机或工业场景中,典型的具身智能架构可以抽象为以下链路:

[传感器/摄像头/麦克风] → [大牛直播SDK 推流模块] → [5G/专网/局域网] → [轻量级 RTSP 服务/多路转发] → [边缘/云端推理与决策] → [控制指令下发 → 执行器] → [录像存证/回放训练]

其中:

-

推流模块:保证视频/音频数据以低延迟、高稳定性方式传出;

-

轻量级 RTSP 服务:支持局域内转发、多协议适配(RTSP↔RTMP、RTSP|RTMP→GB28181);

-

播放模块:既服务人机交互终端,也为算法节点提供实时画面;

-

录像模块:实现预录、事件打点、离线回灌,既满足合规留痕,又为模型训练提供数据。

通过这种模块化拼装,开发者能快速构建一个"即插即用"的视频通感通道,把智能算法稳稳地绑在真实物理环境中。

安卓RTSP播放器多实例播放时延测试

分场景解析:不同具身智能应用的链路重点

1. 无人机巡检

-

挑战:带宽波动大、环境复杂;

-

重点:推流稳定性与断点续连;

-

方案:H.265/Enhanced RTMP HEVC 节省带宽,RTSP 服务支持边缘汇聚,录像模块提供飞行全程留痕。

2. 工业机器人

-

挑战:强调控制精度与延迟下限;

-

重点:链路必须"短而稳";

-

方案:局域网 RTSP 推流保证 <100ms 时延,播放模块与算法节点结合,预录+事件录像用于异常复盘。

3. 人形/服务机器人

-

挑战:多模态数据、多终端交互;

-

重点:多实例同步与跨平台适配;

-

方案:SDK 支持多实例推流/播放,Unity3D 集成 OES 渲染,录像事件打点与语义时间线结合,方便训练与交互。

工程落地要点:从"能跑通"到"可运维"

-

监控与告警:提供码率、帧率、丢包率、RTT 等指标,构建可观测链路;

-

容错与重连:内置断线重连与清缓存机制,避免延迟被历史数据拖长;

-

数据回灌与迭代:事件打点与预录支持"录像回灌→算法优化→部署验证"的闭环;

-

跨平台统一性:Windows/Linux/Android/iOS/Unity3D 一致接口,降低集成与运维成本。

真正的规模化应用,不是先有算法,而是先要一条能观测、能修复、能持续演进的链路。

安卓RTMP播放器同时播放4路RTMP流延迟测试

结语与展望:让智能真正"落地生根"

具身智能的发展正在从实验室走向工厂车间、城市街区与低空空域。核心挑战不是"有没有大模型",而是能否通过稳定的链路把算法绑在真实世界。

大牛直播SDK通过模块化的推流、播放、轻量级 RTSP 服务、GB28181 接入、多路转发与录像功能,已经成为具身智能落地的"神经系统工程件"。

未来,它将在三个方向持续演进:

-

更低延迟与更强鲁棒性:适配新一代编解码与传输协议;

-

更紧密的 AI 融合:录像与回灌功能服务于模型训练与在线优化;

-

更开放的生态接口:深度对接 ROS、Unity、工业总线,成为跨行业的视频枢纽。

当系统能够做到看得清、传得稳、控得准,具身智能才真正具备走向规模化产业的可能,也才能推动人机协作和生产力范式的全面升级。

📎 CSDN官方博客:音视频牛哥-CSDN博客****