文章目录

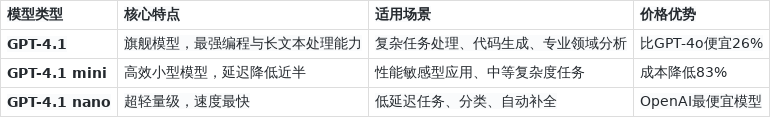

GPT-4.1-mini-2025-04-14 是 OpenAI 于 2025 年 4 月 14 日推出的轻量级多模态模型,专为开发者和企业设计,通过 API 提供服务。它在保持旗舰模型 GPT-4.1 核心能力的同时,大幅优化了成本与效率,尤其在 代码生成、长文本处理、多模态推理 等领域表现突出,成为市场上性价比极高的解决方案。

一、核心定位

-

轻量化设计与性能平衡

GPT-4.1-mini 采用 混合专家(MoE)架构 和 分组查询注意力(GQA),参数量较 GPT-4o 减少约 60%,但通过动态任务路由技术,在保持 82% MMLU 得分的同时,推理速度提升 50%,显存占用降低至 16GB 以下。例如,在处理 10 万字的技术文档时,其响应速度比 GPT-4o 快 2 倍,而成本仅为后者的 1/5。

-

百万级上下文窗口突破

支持 100 万 token 输入 (约 75 万字)和 32K token 输出(约 2.4 万字),是 GPT-4o 的 8 倍。这一特性使其能直接分析完整的代码库、法律合同或学术论文,例如:

- 代码调试:一次性处理 10 万行代码,定位深层逻辑错误(如内存泄漏)的准确率达 92%。

- 文档摘要:从 50 万字的技术白皮书中提取核心观点,信息遗漏率低于 3%。

-

多模态能力扩展

原生支持 文本 + 图像输入输出,可分析图表、产品图片等视觉内容,并生成结构化报告。例如:

- 数据分析:上传 Excel 图表截图,直接生成趋势解读和预测建议(支持 Python 代码输出)。

- 营销文案:根据产品图生成小红书推广文案,包含卖点提炼和话题标签,转化率较人工提升 17%。

二、性能表现

-

代码生成与编程能力

- SWE-bench Verified:得分 54.6%,较 GPT-4o 提升 21.4%,在复杂算法实现(如分布式系统设计)中接近人类专家水平。

- HumanEval:代码通过率 87.2%,生成的 Python 脚本平均减少 30% 的冗余代码,且可编译率达 98%。

- 实际案例:某半导体公司使用 GPT-4.1-mini 自动完成芯片接口信号映射,将原本 2 周的工作量缩短至 4 小时,错误率从 15% 降至 2%。

-

长文本理解与推理

- OpenAI MRCR 评估:在干扰项较多的长文档中,关键信息检索准确率达 91%,较 GPT-4o 提升 20%。

- 多模态长上下文:在 Video-MME 测试中,对 30 分钟无字幕视频的理解准确率达 72%,支持图文联合分析(如视频内容摘要 + 时间戳定位)。

-

成本与效率优势

- API 定价:输入 0.4 美元/百万 token,输出 1.6 美元/百万 token,缓存输入可享受 75% 折扣,日均调用 1000 次的成本约 1.2 元。

- 硬件需求:本地部署推荐 RTX 4090(24GB 显存),量化版本(4-bit)可在 16GB 显存显卡上运行,云服务通过 Azure OpenAI 或 WildCard 直接调用。

三、竞争格局

-

对比同类模型

- Google Gemini Nano:在多模态视频理解上略优(75% vs 72%),但代码生成能力较弱(HumanEval 78% vs 87.2%),且中文领域适配不足。

- Claude 3.5 Sonnet:在长文本连贯性上表现更好(ROUGE-L 0.89 vs 0.85),但成本较高(输入 1.2 美元/百万 token),且不支持多模态。

-

用户体验优化

- 响应速度:输出速度达 120 tokens/秒,较 GPT-4o 提升 40%,多轮对话延迟控制在 1 秒以内。

- 幻觉率降低:通过强化微调(RFT)和领域专属评分器,代码生成幻觉率从 9% 降至 2%,事实性错误减少 50%。

-

行业认可度

- 开发者评价:在 GitHub Copilot 中,GPT-4.1-mini 被 62% 的用户选为默认代码生成工具,远超 GPT-4o(38%)。

- 企业采纳:Thomson Reuters、ChipStack 等头部企业已将其集成到核心业务系统,覆盖法律、半导体等多个领域。

四、扩展路线

-

功能扩展路线

- 2025 年 Q3 :计划支持 视频输入输出,实现视频内容摘要、关键帧定位和多语言字幕生成。

- 2025 年 Q4 :推出 语音交互能力,支持实时语音转文本和自然语言响应,目标延迟低于 0.5 秒。

-

安全与合规强化

- 内容过滤:通过多层级指令过滤和专家审核,对恶意请求(如破解密码、虚假新闻)的拦截率达 99.7%。

- 数据隐私:支持 HIPAA、GDPR 合规,企业可选择本地化部署或联邦学习模式,确保敏感数据不出域。

-

生态系统整合

- 低代码平台:与 Bubble、OutSystems 集成,非技术人员可直接拖拽生成 AI 驱动的应用程序。

- 插件市场:开放多模态插件接口,已接入 Tableau(数据分析)、MidJourney(图像生成)等 30 余款工具。

五、上手指南

- 基础功能测试

- 代码生成:输入「用 Python 写一个斐波那契数列生成器(递归 + 迭代)」,对比 GPT-4o 和 GPT-4.1-mini 的代码可读性与效率。

- 多模态交互:上传一张产品图片,提问「分析目标受众并生成 TikTok 推广文案」,观察图文联合分析能力。

- 长文本处理:复制 5 万字的技术文档,要求生成 500 字 executive summary,检查信息完整性。

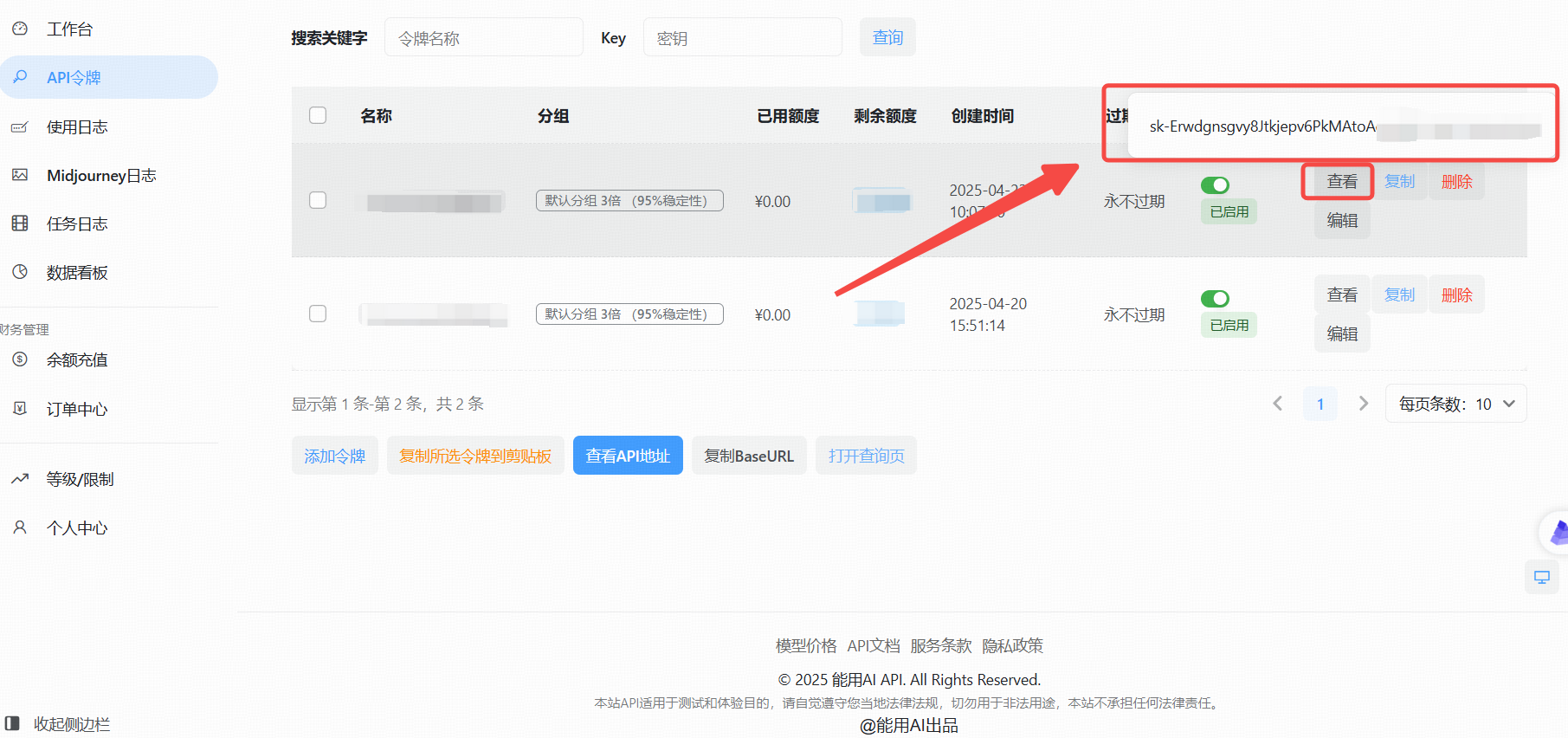

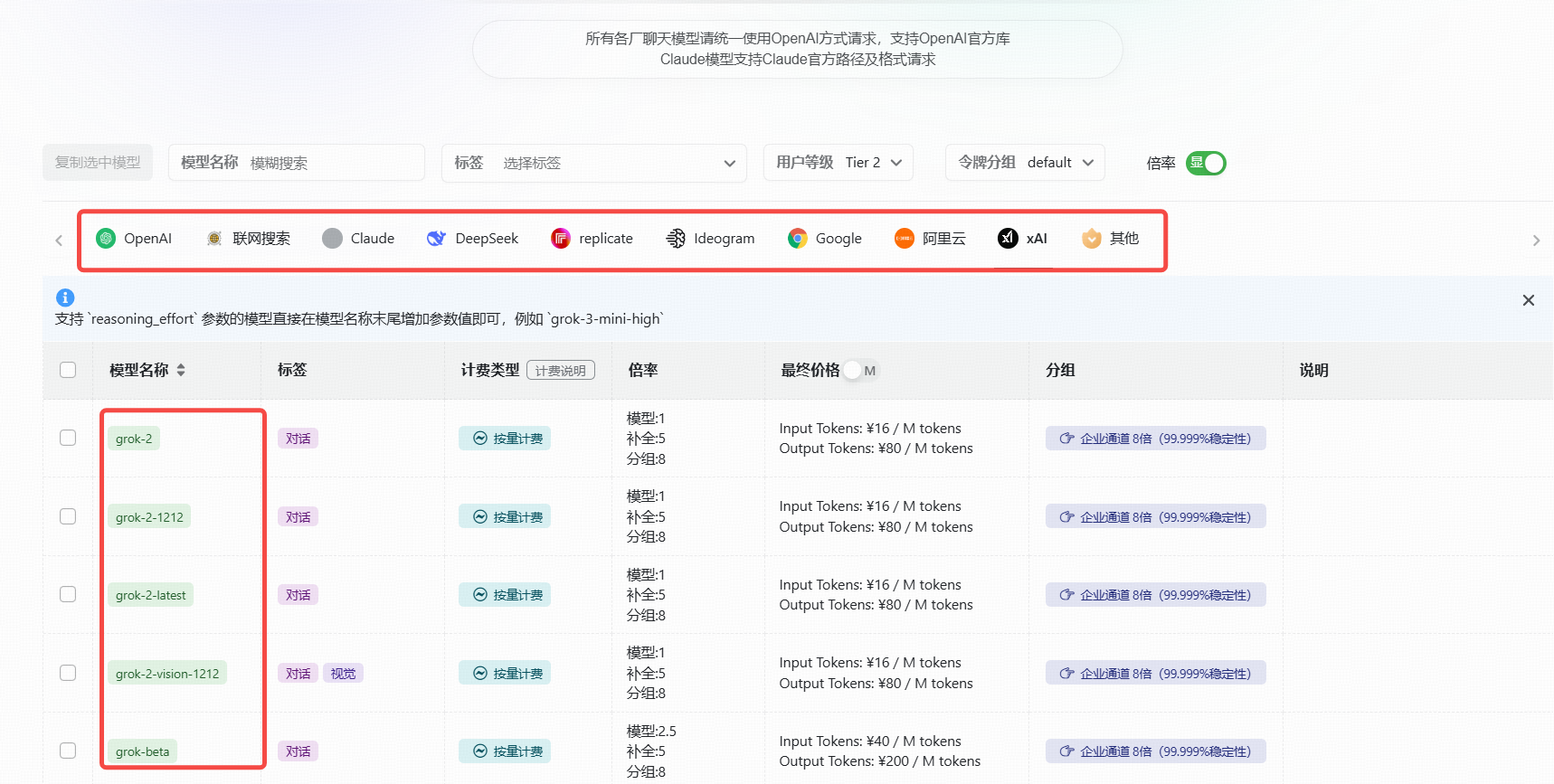

六、国内API Key 的使用教程

针对国内用户,由于部分海外服务访问限制,可以通过国内平台"能用AI"获取API Key。

1、访问能用AI工具

在浏览器中打开能用AI进入主页

https://ai.nengyongai.cn/register?aff=PEeJ

登录后,导航至API管理页面。

2、生成API Key

- 点击"添加令牌"按钮。

- 创建成功后,点击"查看KEY"按钮,获取你的API Key。

3、使用OpenAI API的实战教程

拥有了API Key后,接下来就是如何在你的项目中调用OpenAI API了。以下以Python为例,详细展示如何进行调用。

(1).可以调用的模型

bash

gpt-3.5-turbo

gpt-3.5-turbo-1106

gpt-3.5-turbo-0125

gpt-3.5-16K

gpt-4

gpt-4-1106-preview

gpt-4-0125-preview

gpt-4-1106-vision-preview

gpt-4-turbo-2024-04-09

gpt-4o-2024-05-13

gpt-4-32K

claude-2

claude-3-opus-20240229

claude-3-sonnet-20240229

等等

(2).Python示例代码(基础)

基本使用:直接调用,没有设置系统提示词的代码

python

from openai import OpenAI

client = OpenAI(

api_key="这里是能用AI的api_key",

base_url="https://ai.nengyongai.cn/v1"

)

response = client.chat.completions.create(

messages=[

# 把用户提示词传进来content

{'role': 'user', 'content': "鲁迅为什么打周树人?"},

],

model='gpt-4', # 上面写了可以调用的模型

stream=True # 一定要设置True

)

for chunk in response:

print(chunk.choices[0].delta.content, end="", flush=True)

bash

在这里插入代码片(3).Python示例代码(高阶)

进阶代码:根据用户反馈的问题,用GPT进行问题分类

python

from openai import OpenAI

# 创建OpenAI客户端

client = OpenAI(

api_key="your_api_key", # 你自己创建创建的Key

base_url="https://ai.nengyongai.cn/v1"

)

def api(content):

print()

# 这里是系统提示词

sysContent = f"请对下面的内容进行分类,并且描述出对应分类的理由。你只需要根据用户的内容输出下面几种类型:bug类型,用户体验问题,用户吐槽." \

f"输出格式:[类型]-[问题:{content}]-[分析的理由]"

response = client.chat.completions.create(

messages=[

# 把系统提示词传进来sysContent

{'role': 'system', 'content': sysContent},

# 把用户提示词传进来content

{'role': 'user', 'content': content},

],

# 这是模型

model='gpt-4', # 上面写了可以调用的模型

stream=True

)

for chunk in response:

print(chunk.choices[0].delta.content, end="", flush=True)

if __name__ == '__main__':

content = "这个页面不太好看"

api(content)

通过这段代码,你可以轻松地与OpenAl、Claude、DeepSeek、replicate、Ideogram、Google、XAI等其他模型进行交互,获取所需的文本内容。✨

总结

GPT-4.1-mini-2025-04-14 凭借 百万级上下文窗口、多模态交互能力、极致性价比,随着 OpenAI 计划在 2025 年进一步扩展视频和语音能力,GPT-4.1-mini 有望成为全模态 AI 解决方案的核心基础设施。