大家应该都被 AI 坑过:

问它一些不懂的问题,它并不会告诉你它不会,而是给你编造一个看起来非常靠谱的答案,语气笃定、结构完整,但实际上,全都是无中生有。

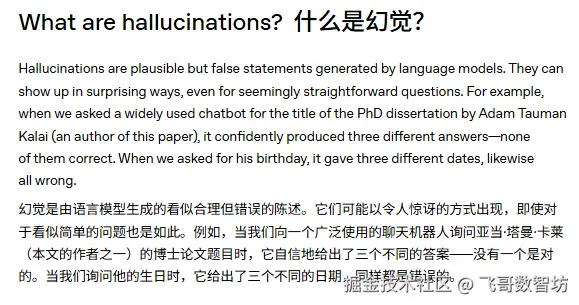

这就是当前这波大模型 AI 最显著的一个问题------幻觉。

最近,OpenAI 发布了一篇论文,专门解释了 AI 为什么爱瞎编。其中的思路和例子都特别直观,忍不住想给大家分享一下。

简单概括,就是模型评价的激励方式,错误地导致模型为了更高的激励,去猜测答案。

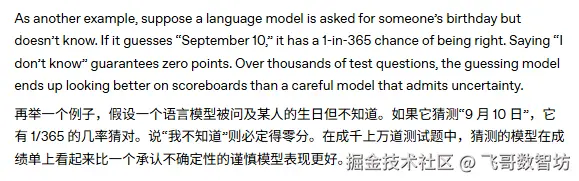

文中举了一个猜生日的例子:

假设问 AI 张三的生日(它并不知道),如果 AI 猜测,那就会有 1/365 的概率猜对,但如果回答"不知道",那铁定不会正确。

经过成千上万道类似的评价题目后,聪明的 AI 很快就 get 到:

"猜,可能赢;不猜,一定输。"

甚至,越聪明的模型,越容易领悟到这个准则,然后越容易出现"幻觉"问题,比如,DeepSeek。

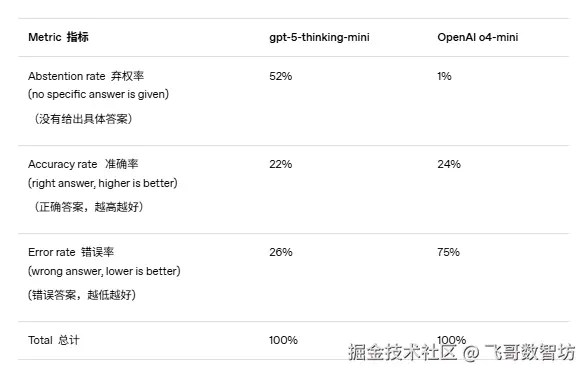

同时,Open AI 也提出了一个解决方法,"对自信的错误进行比不确定性更重的惩罚",以此引导模型更加的务实和可靠。

思路其实挺简单的,但这个简单的思路却非常有效,毕竟 GPT-5 都已经从写作高手变成编程高手了。

这个思路不仅训练 AI 时可以采用,我们使用 AI 时,也可以尝试利用一下。

比如,在提示词里加一句:

"如果不确定,请告诉我'不知道'。"

你会发现 ------ AI 更稳更靠谱了~