前言

Ollama 是一个开源的本地化大模型运行平台,支持用户直接在个人计算机上部署、管理和交互大型语言模型(LLMs),无需依赖云端服务。而且其混合推理的特性也使得CPU和GPU的算力能够充分被使用,能够在同等配置下跑更大的模型,是非常适合个人学习使用的平台。本篇将详细介绍Ollama在各种平台上的详细安装过程以及应用。

Ollama的安装

官网地址: ollama.com/

进到官网之后点击Download 然后就可以选择相应的安装包

进到官网之后点击Download 然后就可以选择相应的安装包

在线安装

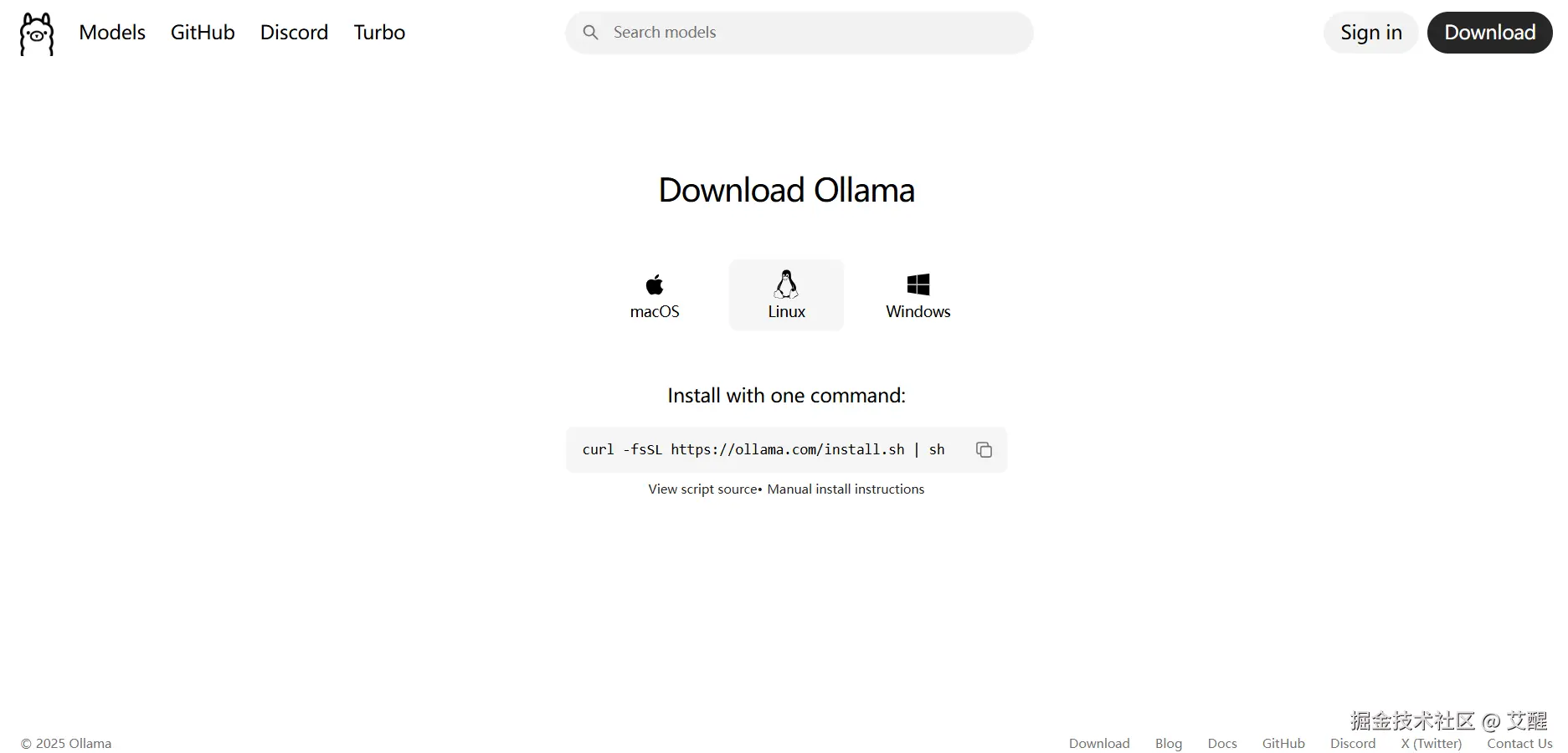

Windows环境下下载安装根据安装包指引下载安装即可,linux环境下执行以下命令:

Windows环境下下载安装根据安装包指引下载安装即可,linux环境下执行以下命令:

bash

curl -fsSL https://ollama.com/install.sh | sh离线安装

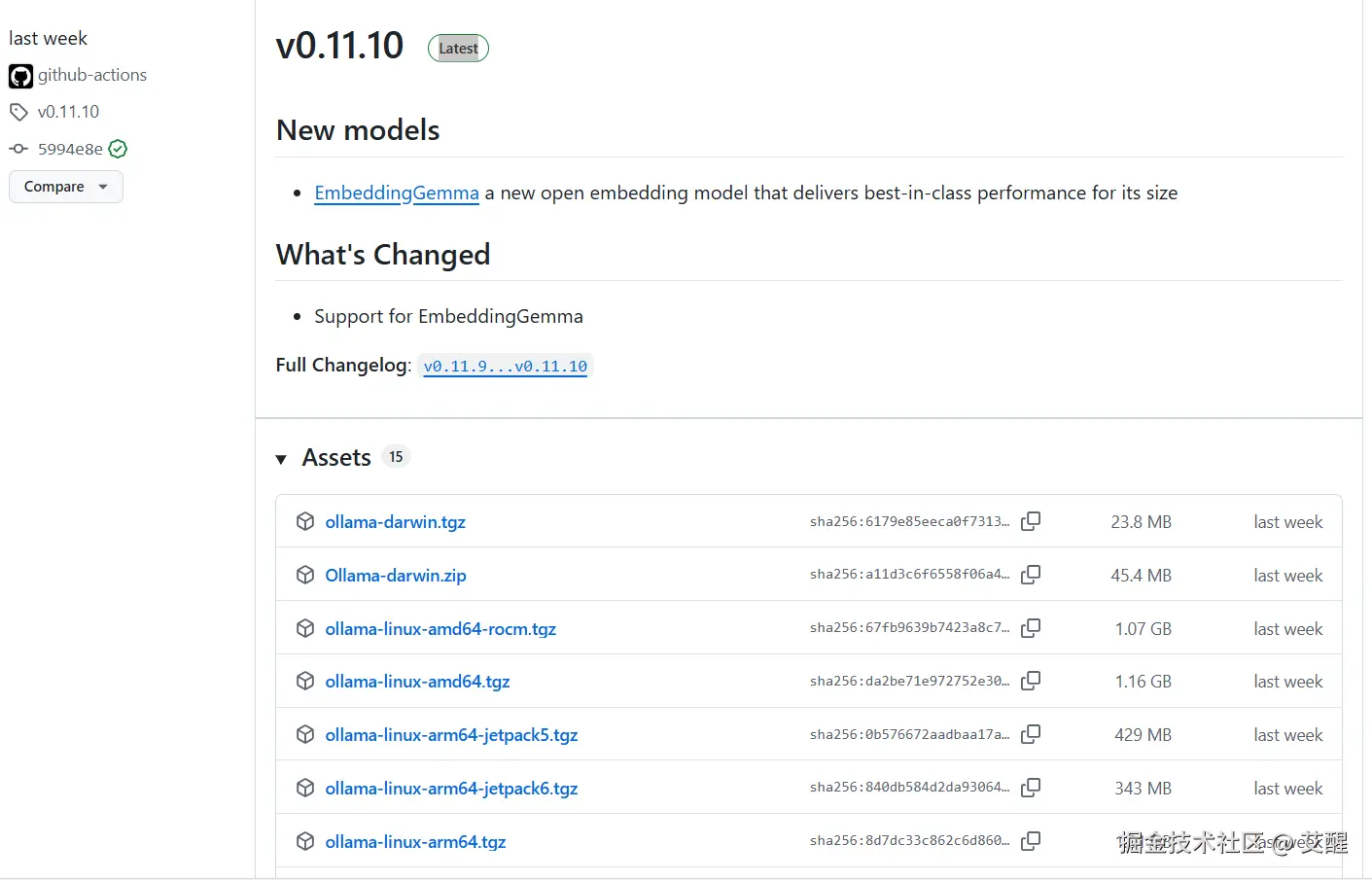

在线安装受网络的影响,并不能完全解决所有的安装问题,那么就可以选择离线安装的方式安装Ollama。 离线包下载地址: github.com/ollama/olla...  由于Windows可以直接在官网下载安装包并安装,本文以Linux-amd64环境下的安装为例 下载好压缩包后,新建一个文件夹名为

由于Windows可以直接在官网下载安装包并安装,本文以Linux-amd64环境下的安装为例 下载好压缩包后,新建一个文件夹名为ollama,然后解压

bash

mkdir ./ollama

tar -zxvf ollama-linux-amd64.tgz -C ./ollama为ollama添加执行权限

bash

cd ./bin

chmod +x ollama添加环境变量 在 .bashrc 文件结尾写入ollama/bin文件路径

bash

vi ~/.bashrc然后在下面添加以下内容(假设压缩包下载的路径为/home/data,读者应该根据自己实际路径调整)

bash

export PATH=$PATH:/home/data/ollama/bin更新环境变量

bash

source ~/.bashrc修改Ollama模型保存路径

这一步还是很有必要的,能够方便管理模型,尤其是在windows系统中,如果不做相关的设置,会默认下载到C盘

Windows环境修改保存路径

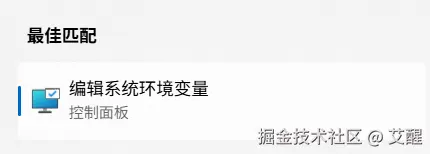

然后点击环境变量

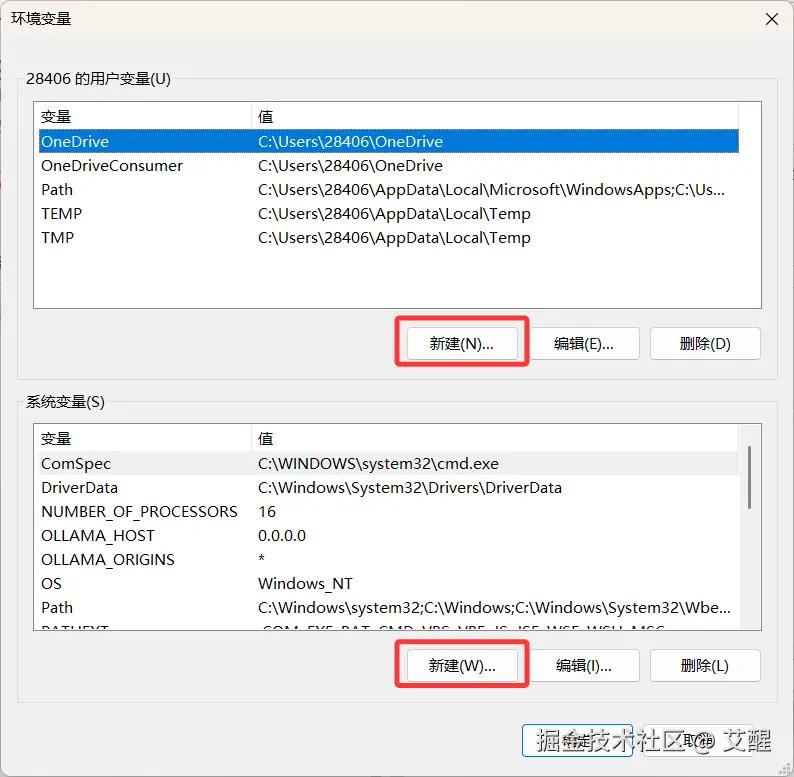

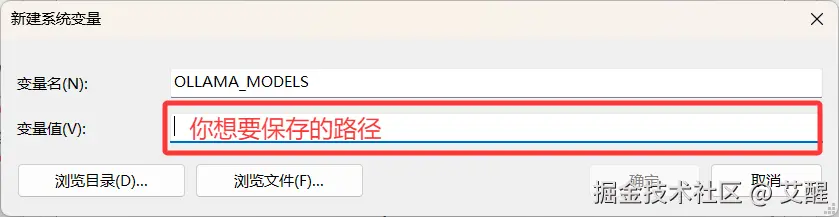

然后点击环境变量  这里选任意一个就行 变量名为

这里选任意一个就行 变量名为OLLAMA_MODELS

Linux环境修改保存路径

Linux环境更为简单,直接打开bashrc添加环境变量即可

bash

vi ~/.bashrc然后添加

bash

export OLLAMA_MODELS=你想设置的路径保存并退出后

bash

source ~/.bashrc然后可以使用以下命令启动ollama

bash

ollama start模型下载

在线下载

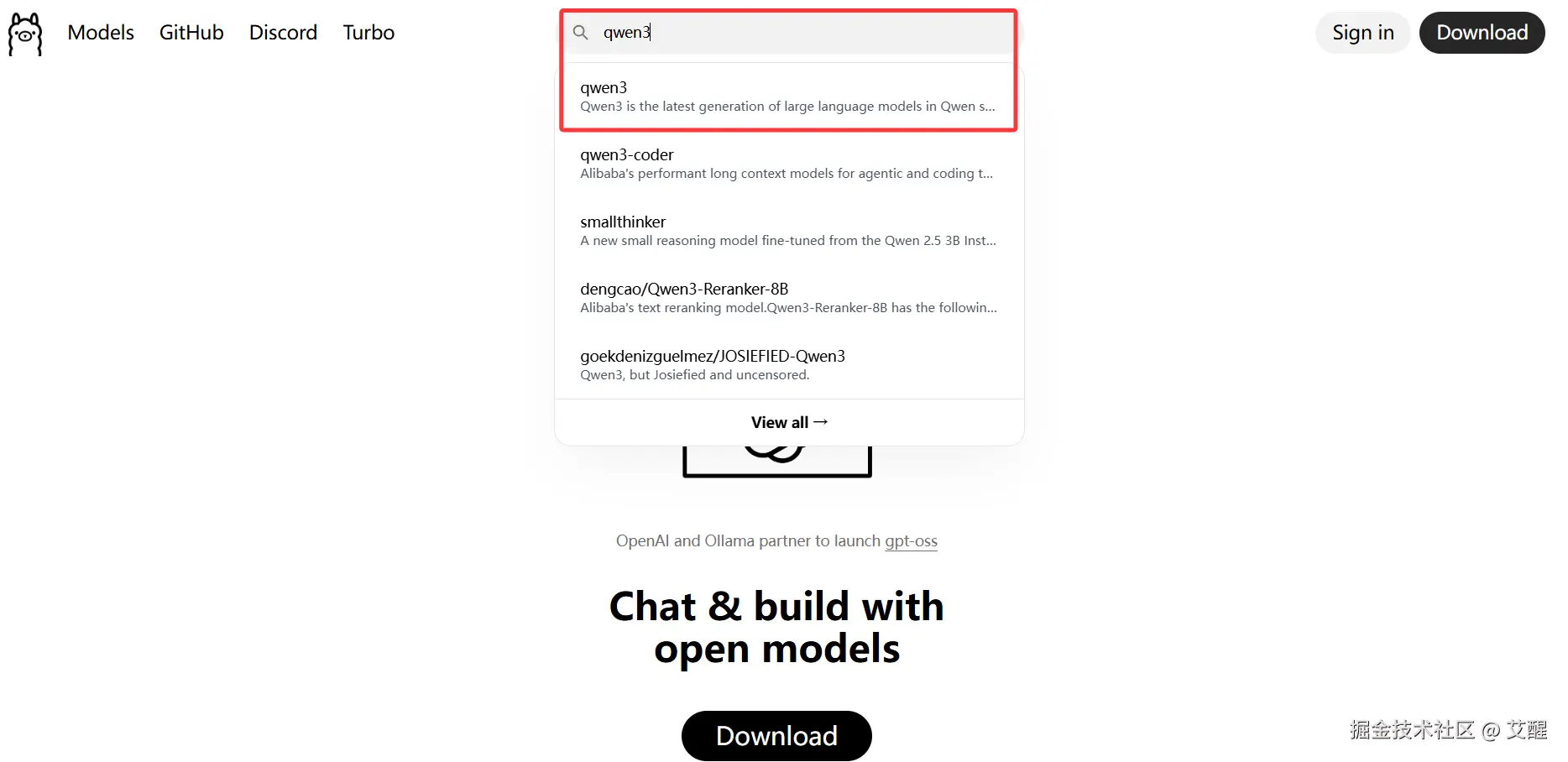

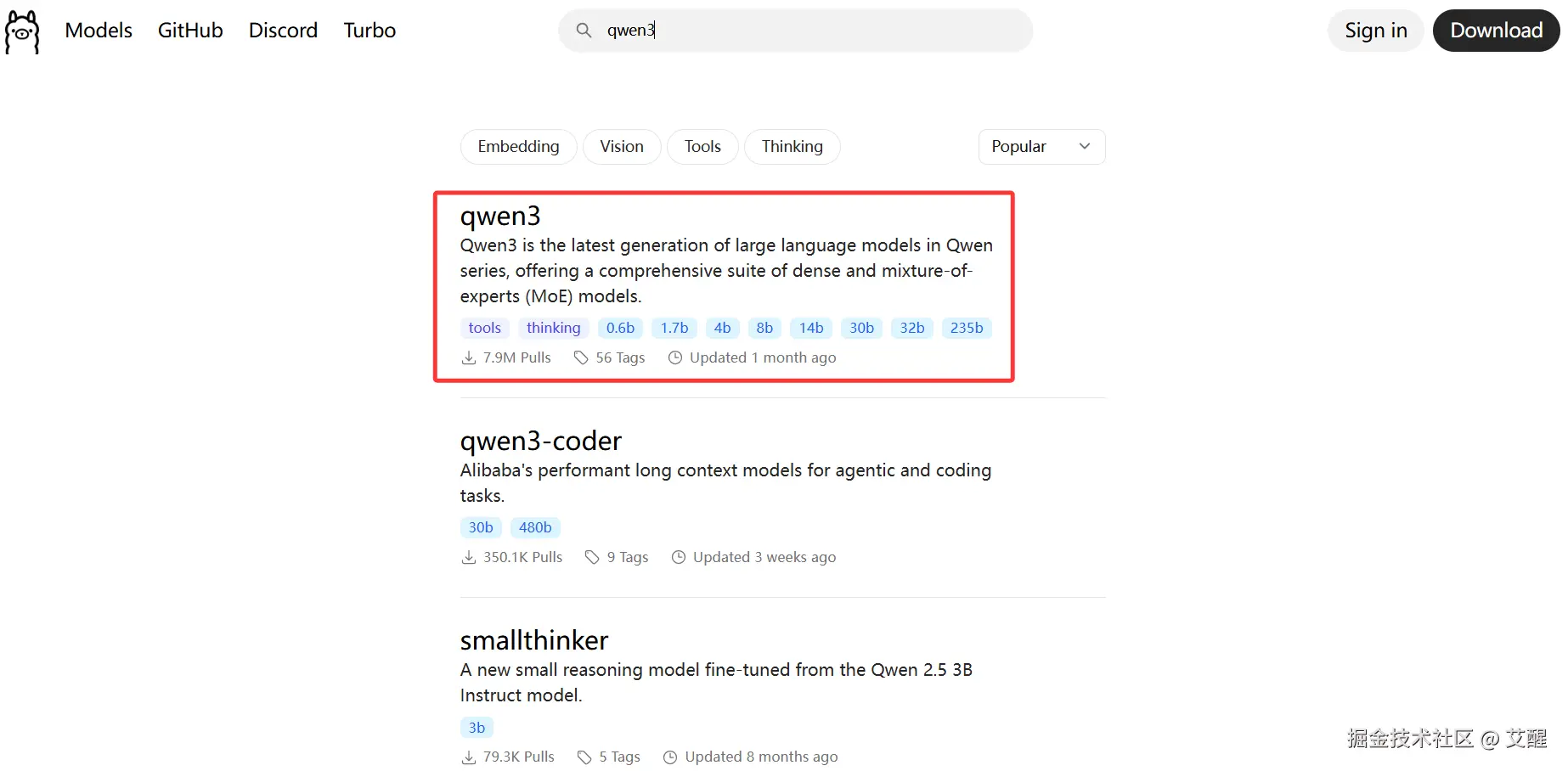

ollama官网: ollama.com/ 打开官网直接搜索需要的模型,本文以qwen3为例

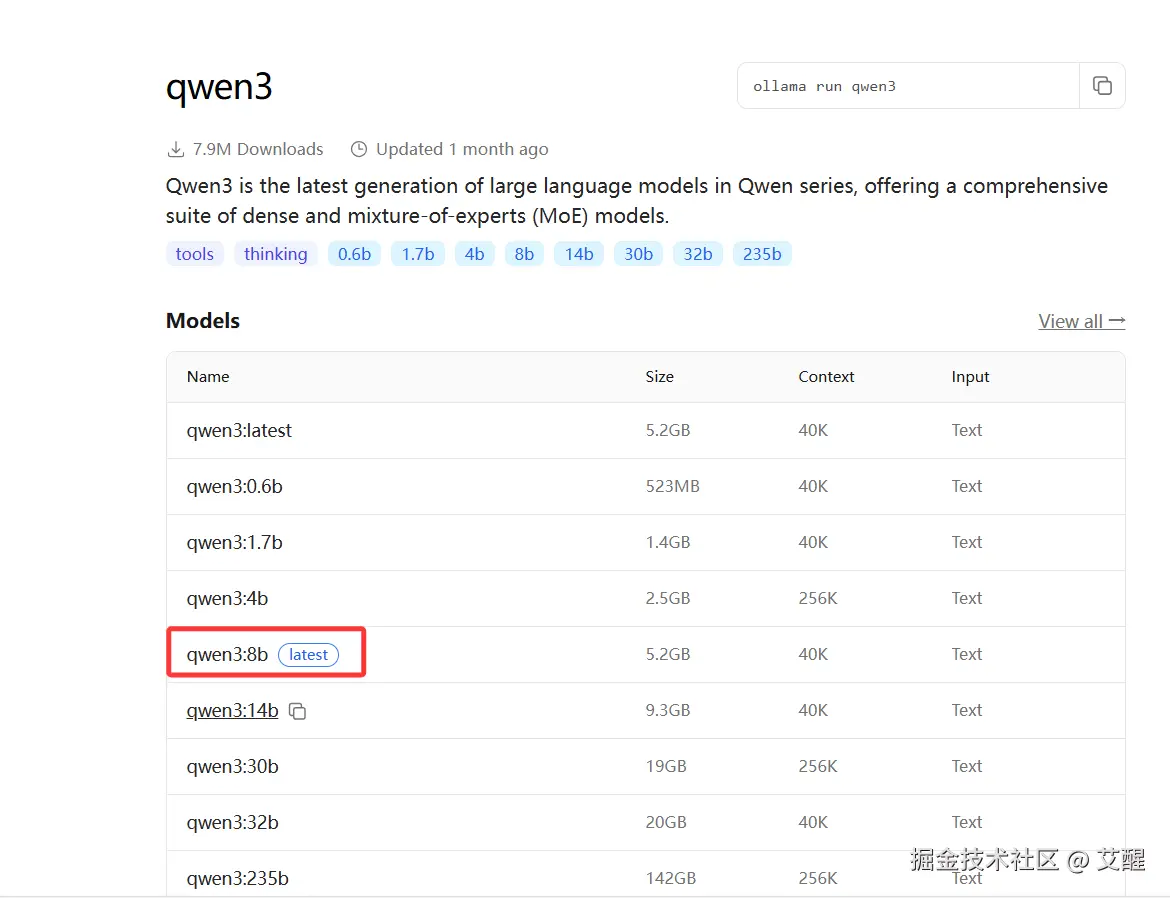

然后点击适合自己设备的模型(基本上size比自己的显存小一点就合适)

然后点击适合自己设备的模型(基本上size比自己的显存小一点就合适)  然后复制命令到命令行

然后复制命令到命令行  随后ollama会自动下载并运行该模型

随后ollama会自动下载并运行该模型

手动下载

手动下载的方式参照玩转大语言模型------ollama导入huggingface下载的模型,这里不再赘述