缓存是现代互联网架构的"性能放大器"。从本地内存到分布式缓存,从CDN到边缘计算,缓存无处不在。它能极大降低后端压力、缩短响应时间、降低成本。但缓存的效能,取决于"预测"能力:只有在真正热点数据被提前缓存时,才能发挥最大价值;若缓存命中率低,不仅浪费资源,还可能造成一致性、失效风暴等问题。

长期以来,缓存策略依赖固定规则(LRU、LFU、TTL 等)和人工调优。这种方式在稳定业务下尚可应付,在流量高波动、内容多样化的今天,显得力不从心。业务热点的动态性、用户行为的多样性,使得传统缓存策略频繁"踩空"。这正是"智能缓存架构"的突破口:用算法提前识别并预测数据热点,让缓存真正变"被动反应"为"主动预热"。

一、传统缓存策略的局限

常见的缓存淘汰与预加载策略,包括 LRU(最近最少使用)、LFU(最少使用频率)、FIFO、TTL 等。这些算法的核心假设是:过去的访问模式能反映未来;缓存空间有限,需要按照某种度量进行淘汰。

然而在现代业务中,这些假设常常失效:

- 热点瞬时爆发:电商秒杀、直播、突发新闻,热点在短时间急剧升温,LRU无法提前感知。

- 访问模式多变:推荐系统、A/B 测试等会导致不同用户群的访问特征差异巨大。

- 多级缓存协同复杂:CDN、边缘缓存、应用内缓存之间缺乏全局视角,导致热点预热滞后。

结果就是:命中率不稳定、缓存资源浪费、后端承压。

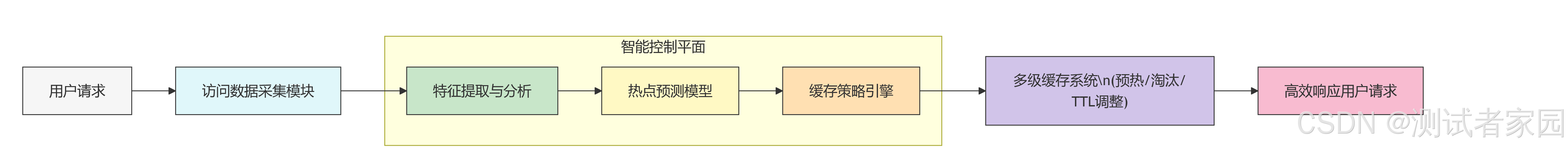

二、智能缓存架构的核心思路

智能缓存架构的本质,是用数据驱动 替代规则驱动。通过对请求流量、用户行为、内容特征的实时分析,预测未来的热点数据,提前缓存并动态调整策略。它有三个关键特征:

- 实时采集多维度数据:包括请求频率、用户画像、上下文、地理分布、内容关联等。

- 预测模型识别热点:通过时序分析、聚类、序列预测等算法,推断哪些数据将在未来短期内变热。

- 动态策略调整与预加载:根据预测结果动态调整缓存优先级、TTL、分布位置,实现预热和淘汰策略的智能化。

这样,缓存系统从"记录历史"转变为"预见未来"。

三、架构设计关键点

1. 数据采集与特征工程

缓存层需要与API网关、日志系统、用户行为采集模块打通,形成完整的访问轨迹。提取特征包括:时间窗口内访问频次、访问增长率、用户分布、内容上下游关系等。

2. 模型训练与在线推断

- 离线训练:用历史数据训练预测模型,如ARIMA、LSTM、图神经网络等,掌握访问模式演化规律。

- 在线推断:将模型部署在缓存控制平面,实时输入最新数据输出热点预测,指导缓存策略。

3. 缓存策略动态调优

预测结果落地到策略:哪些Key提前加载到内存,哪些热点在多级缓存中加速分发,哪些冷数据降低优先级。TTL可根据预测动态调整,而非固定值。

4. 可解释性与安全性

预测失败会导致缓存污染,因此系统应提供可解释指标(预测置信度、热点阈值)和回退机制(当模型异常时自动切换到规则策略),保证稳健运行。

四、典型应用场景

- 内容分发网络(CDN):预测热门视频、新闻提前推送至边缘节点,降低中心带宽压力。

- 电商秒杀活动:预测爆品详情页、库存接口热点,提前加载至分布式缓存,避免数据库雪崩。

- 金融风控:预测高频交易规则或风控模型参数访问,提前缓存关键数据以保障低延迟。

这些场景的共同点是:热点变化快、访问量大、对延迟敏感。智能缓存架构能显著提高系统韧性与用户体验。

五、未来展望:从缓存到"数据前置"

智能缓存不仅是性能优化,更是数据架构思维的转型。随着算法和算力发展,缓存有望向"数据前置"演进:不仅预测热点,还能预测计算需求,提前准备好数据和结果,实现真正的"零等待体验"。在多云和边缘计算环境下,这种能力将成为竞争力的新基准。

六、总结:预测驱动缓存的新范式

智能缓存架构通过"预测数据热点"实现了缓存策略的主动化与动态化,解决了传统规则驱动缓存的滞后与低效问题。在高并发、高波动的业务环境下,它是系统稳定性和用户体验的关键保障。

下面用一张 Mermaid 图总结智能缓存架构的核心流程: