论文阅读 | TGRS 2025 | DHANet:用于多模态无人机目标检测的双流分层交互网络

- [1&&2. 摘要&&引言](#1&&2. 摘要&&引言)

- 3.方法

-

- [3.1. 框架概述](#3.1. 框架概述)

- [3.2. 模态自适应非对称注意力模块 (M-AAM)](#3.2. 模态自适应非对称注意力模块 (M-AAM))

- [3.3. M-SC 模块](#3.3. M-SC 模块)

- [3.4. 多模态决策集成](#3.4. 多模态决策集成)

- [4. 实验结果与分析](#4. 实验结果与分析)

- [5. 结论**](#5. 结论**)

题目:DHANet: Dual-Stream Hierarchical InteractionNetworks for Multimodal Drone Object Detection

期刊:TGRS(IEEE TRANSACTIONS ON GEOSCIENCE AND REMOTE SENSING)

论文:paper

代码:code

年份:2025

1&&2. 摘要&&引言

基于无人机的遥感已成为高分辨率动态监测的关键技术。然而,日间和夜间模式之间的差异会在极端光照条件下引发多尺度目标特征的失配。

本文提出了一种用于多模态无人机目标检测的双流分层交互网络(DHANet),该网络增强了每种模态下多尺度目标与背景之间的可区分性。

具体来说,DHANet设计了一个模态自适应非对称注意力模块(M-AAM) ,通过全局和局部注意力机制增强目标级语义表示。M-AAM采用全局上下文注意力和局部位置注意力来替代传统的多尺度上下文提取,从而有效整合对象的空间-通道信息。

此外,该网络配备了一个多模态尺度注意力卷积(M-SC)模块,能动态生成模态特定的特征聚合权重。这种设计实现了全局跨模态信息融合,同时降低了计算复杂度。

总而言之,本文有以下贡献:

- 提出了一种用于多模态无人机目标检测的双流分层交互网络(DHANet),该网络减少了极端光照条件下多模态目标特征的失配。

- 设计了一个M-AAM模块,用混合的全局-局部注意力机制取代传统的多尺度上下文提取,减少了特征模糊性。

- 开发了一个M-SC模块,该模块利用多尺度深度条纹卷积与多模态门控,实现了全局跨模态信息融合,同时降低了计算复杂度。

- 在两个多模态遥感基准数据集(DroneVehicle 和 VEDAI)以及两个自然数据集(LLVIP 和 FLIR)上评估了 DHANet 的检测性能,证明了其鲁棒性和泛化能力。

3.方法

在本节中,首先介绍了为多模态目标检测设计的DHANet架构。然后描述了M-AAM模块,它有效增强了单模态的特征,接着是M-SC模块,它实现了无缝的多模态协作。然后我们讨论了多尺度检测头的优势。最后,详细解释了模型的损失函数。

3.1. 框架概述

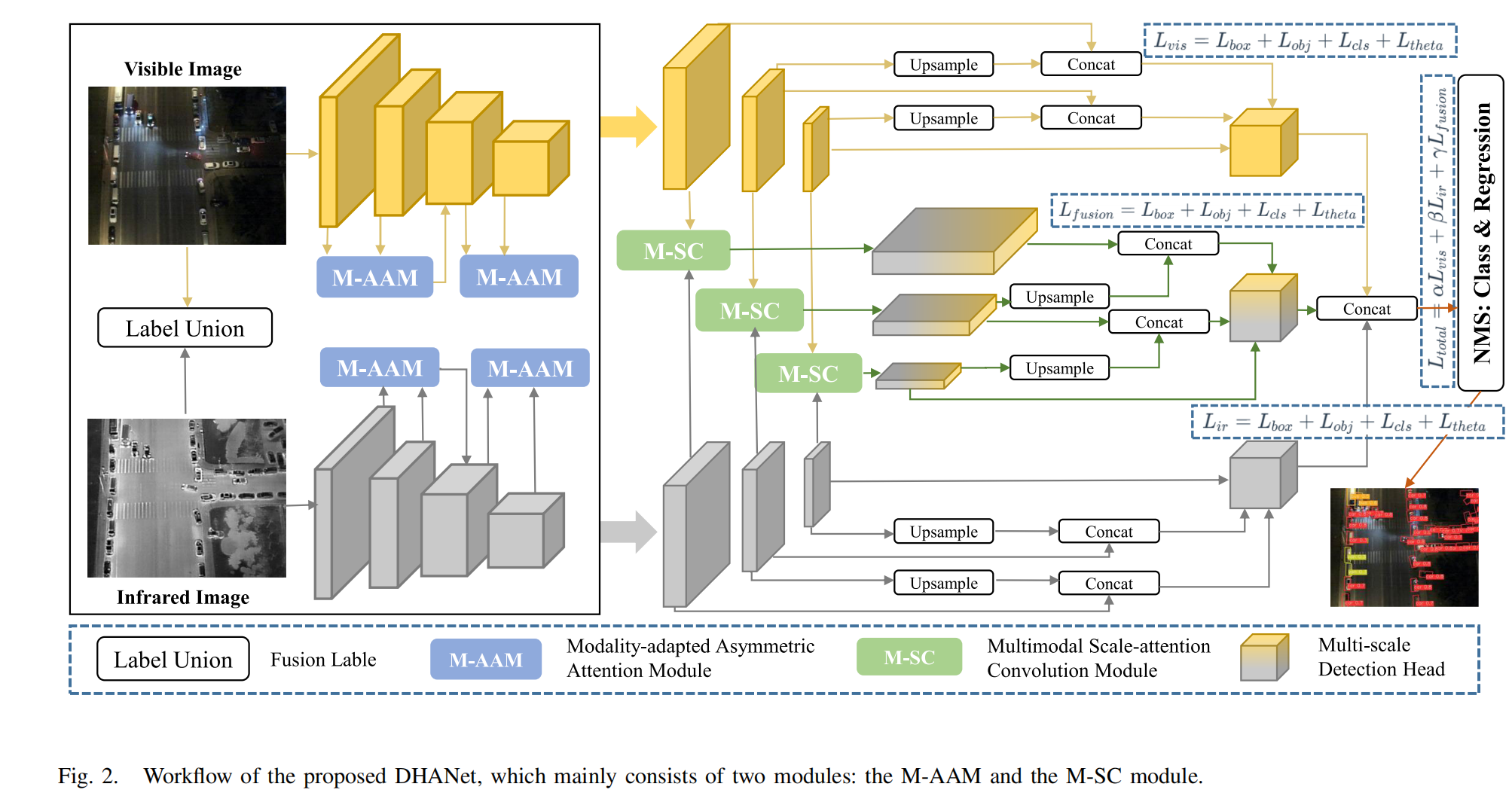

本节提出了DHANet,一种多模态无人机目标检测网络,如图2所示,主要包括M-AAM和M-SC模块。多模态数据标签是可见光和红外模态标签的并集,以解决跨模态的数据标签失配问题。随后,我们采用Yolov5s方法,使用两个Darknet53主干网络(每个包含两个流)处理红外和可见光图像输入。之后,M-AAM模块通过用全局和局部注意力替代多尺度上下文来增强目标语义特征,有效整合了空间和通道细节,特别是对于小目标(见第III-B节)。M-SC模块通过注意力引导机制实现高效的全局跨模态融合,同时展示了较低的计算复杂度并保持了有竞争力的检测精度(见第III-C节)。随后,不同尺度的特征被上采样并连接起来,发送到多尺度检测头,并且来自可见光、红外和特征融合分支的结果通过决策融合进行整合(见第III-D节)。最后,NMS过滤掉冗余框以提供最终的检测结果。

3.2. 模态自适应非对称注意力模块 (M-AAM)

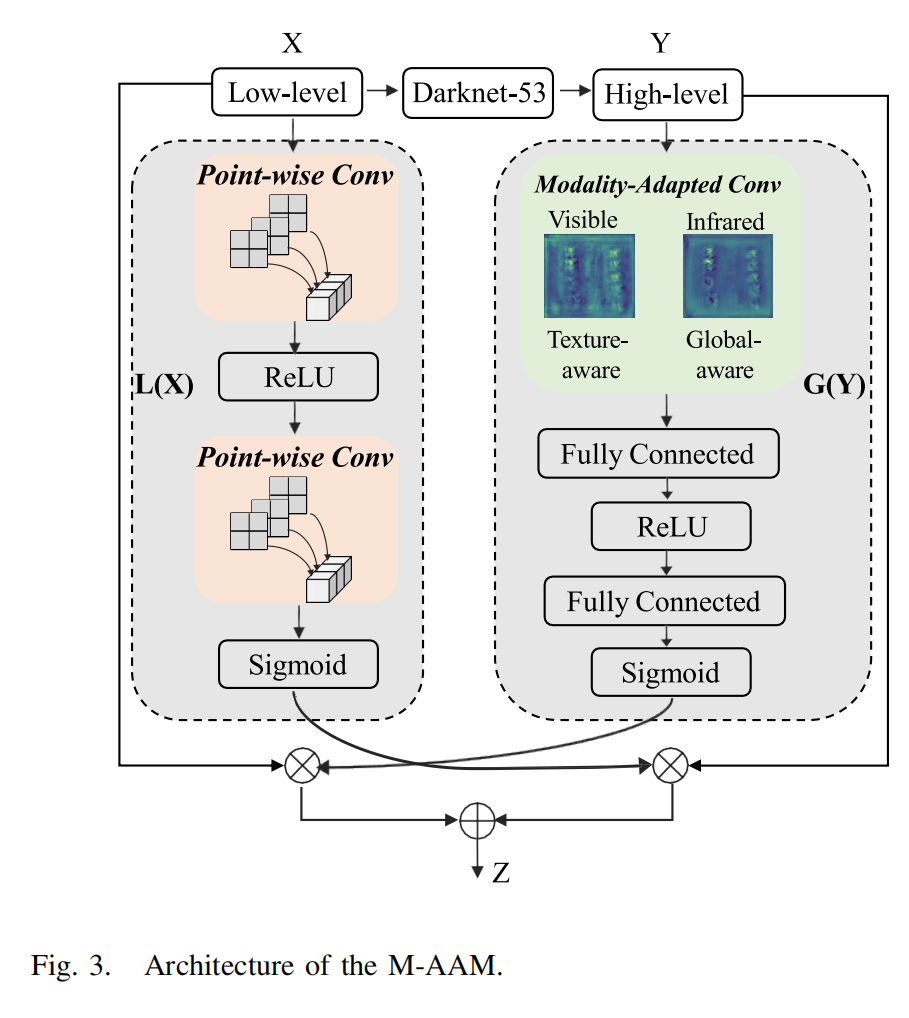

无人机平台固有的长距离成像几何结构导致车辆目标存在显著的尺度变化。此外,昼夜转换等条件会引起目标表面显著的光度变化,大大增加了检测任务的视觉复杂性。由于拍摄距离远,从远处捕获的车辆通常呈现多尺度且比自然场景图像中的车辆更小。此外,在不同光照条件(如白天和夜晚)下捕获的目标在其表面上表现出不同的反射和阴影特性,显著增加了检测任务的视觉复杂性。通过整合高层语义特征和低层细节特征,我们可以有效缓解因目标判别信息不足或网络过深导致的信息丢失问题。然而,过度依赖高层语义特征可能导致在复杂环境中或目标颜色与背景相似时检测不足。

因此,我们提出了M-AAM。对于红外模态,M-AAM采用自适应平均池化层来获取大小为1 x 1 x D的特征,并在每个空间位置(表示为H x W x 1)单独聚合通道特征上下文信息。对于可见光模态,M-AAM用细节保留池化操作替换了平均池化操作。相反,M-AAM考虑了空间细节并整合了可见光模态的颜色通道特定上下文信息。这种定制化增强使模块能够利用每种模态的独特特性,特别是在具有可变光照条件的复杂场景中。可见光更侧重于保留纹理特征,而红外则侧重于保留数据的整体特征,从而更好地改善目标对比度,以有效应对变化的光照条件。

我们定义变量X和Y分别为低层和高层特征。输出Z由以下公式给出:

Z = G ( Y ) ⊙ L ( X ) Z = G(Y) \odot L(X) Z=G(Y)⊙L(X)

其中 G ( Y ) G(Y) G(Y) 和 L ( X ) L(X) L(X) 分别表示全局和局部注意力。 ⊙ \odot ⊙ 表示逐元素乘法。全局注意力 G ( Y ) G(Y) G(Y) 定义为:

G ( Y ) = σ ( W 2 ( R e L U ( W 1 ( y ) ) ) ) G(Y) = \sigma(W_2(ReLU(W_1(y)))) G(Y)=σ(W2(ReLU(W1(y))))

其中ReLU是一个激活函数,y表示通过全局平均池化获得的全局上下文特征。 W 1 W_{1} W1 和 W 2 W_{2} W2 分别是两个全连接层的权重矩阵。

局部注意力 L ( X ) L(X) L(X) 表示为:

L ( X ) = σ ( P W C o n v ( X ) ) ⊗ X L(X) = \sigma(PWConv(X)) \otimes X L(X)=σ(PWConv(X))⊗X

其中PWConv代表逐点卷积。 ⊗ \otimes ⊗ 表示逐元素乘法。

3.3. M-SC 模块

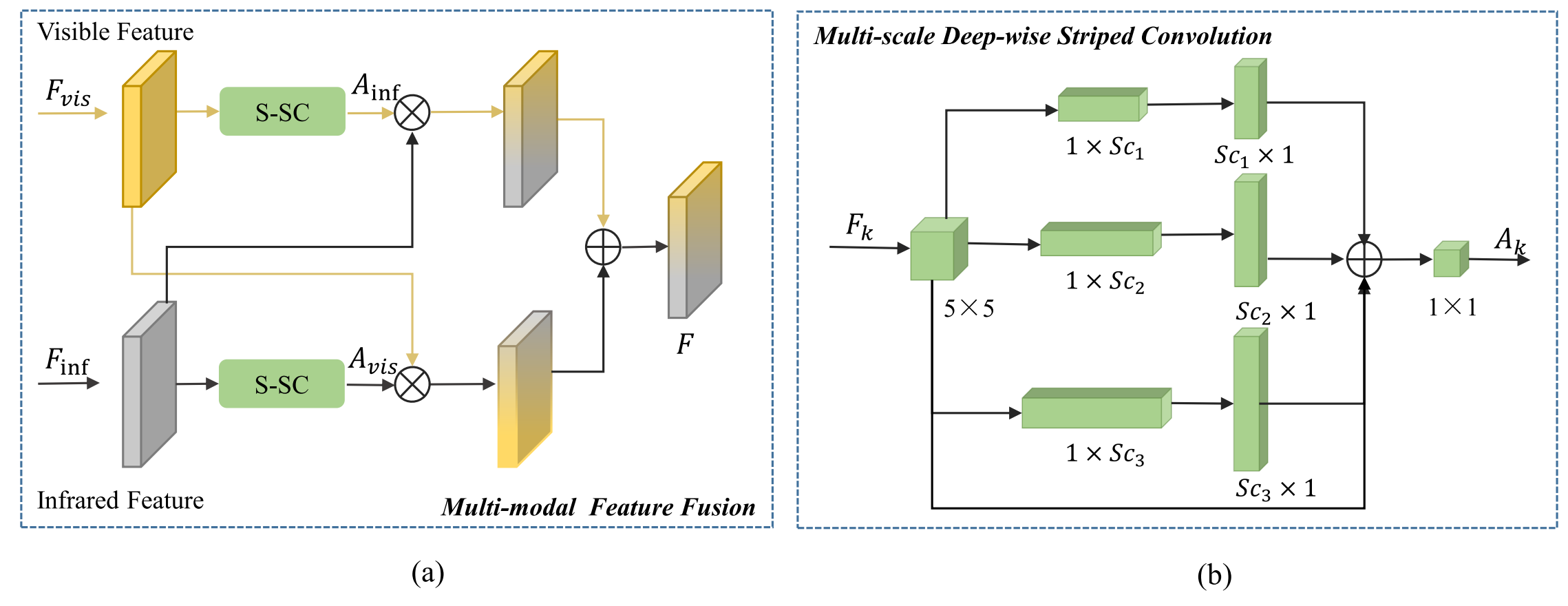

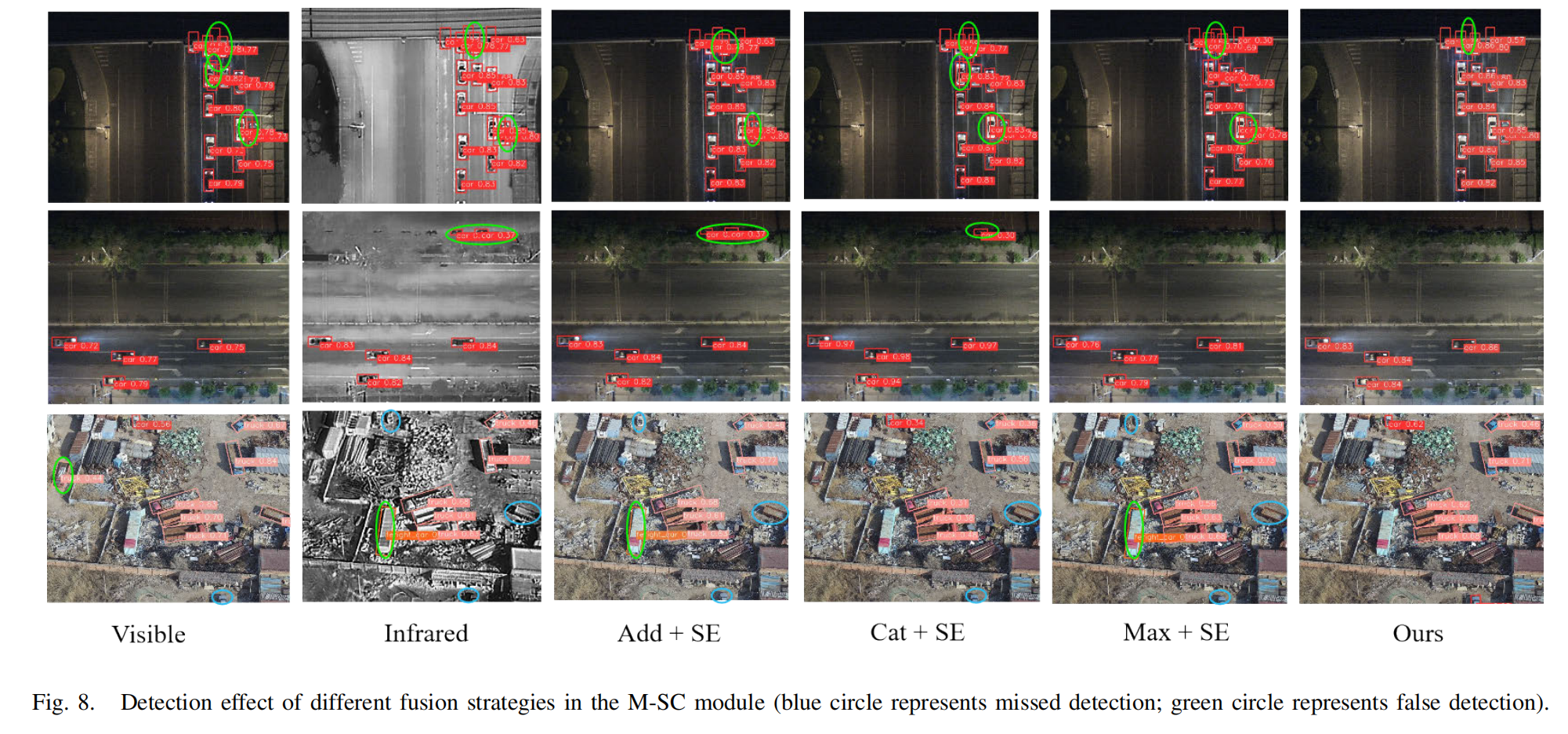

虽然Transformer模型通过自注意力机制擅长全局依赖建模,但其二次计算复杂度(O(n²))对于高分辨率无人机图像仍然过高。为了解决这个问题,我们提出了一个M-SC模块,它模拟Transformer式的全局上下文聚合,同时保持线性计算复杂度(O(n))。我们首先引入一个多尺度深度条纹卷积(DWSConv)[19]来关注每个模态的多尺度局部空间注意力,同时降低计算复杂度。然后,这些注意力权重随后通过多模态门控机制被用来实现全局跨模态信息补偿。M-SC模块通过注意力引导机制实现高效的全局跨模态融合,同时保持较低的计算复杂度并实现有竞争力的检测精度。

图4显示了M-SC模块的结构。该模块首先计算每个模态的注意力权重。计算分为两部分:1) 一个多尺度深度条纹卷积来捕获多尺度局部信息,同时降低计算复杂度,如图4(b)所示;2) 单模态尺度注意力(SC)模块采用恒定连接和深度可分离卷积来近似全局表示。每个模态的输出表示为 A k A_{k} Ak:

A k = ∑ i = 0 3 S c a l e i ( F k ) A_{k} = \sum_{i=0}^{3} Scale_i(F_k) Ak=i=0∑3Scalei(Fk)

其中k代表模态(可见光或红外),i的范围从0到3,表示分支, Scale i \operatorname{Scale}{i} Scalei,其中 i ∈ 0 , 1 , 2 , 3 i\in {0,1,2,3} i∈0,1,2,3 表示第i个DWSConv分支。当 i = 0 i=0 i=0 时,它对应于恒定连接,而其他分支使用深度可分离卷积来近似大卷积核,例如 S c 1 × S c 1 Sc{1}\times Sc_{1} Sc1×Sc1, S c 2 × S c 2 Sc_{2}\times Sc_{2} Sc2×Sc2, 和 S c 3 × S c 3 Sc_{3}\times Sc_{3} Sc3×Sc3,如图4(b)所示。详细设置在第四节B部分提供。采用 1 × 1 1\times 1 1×1 卷积来建模各种通道之间的关系。

该模块随后通过一个模态的空间注意力图 A k A_{k} Ak 与另一个模态的特征张量 F k F_{k} Fk 之间的哈达玛积(Hadamard product)操作执行跨模态注意力传播。最终融合的特征F是:

F = A v i s ⊙ F I R + A I R ⊙ F v i s F = A_{vis} \odot F_{IR} + A_{IR} \odot F_{vis} F=Avis⊙FIR+AIR⊙Fvis

3.4. 多模态决策集成

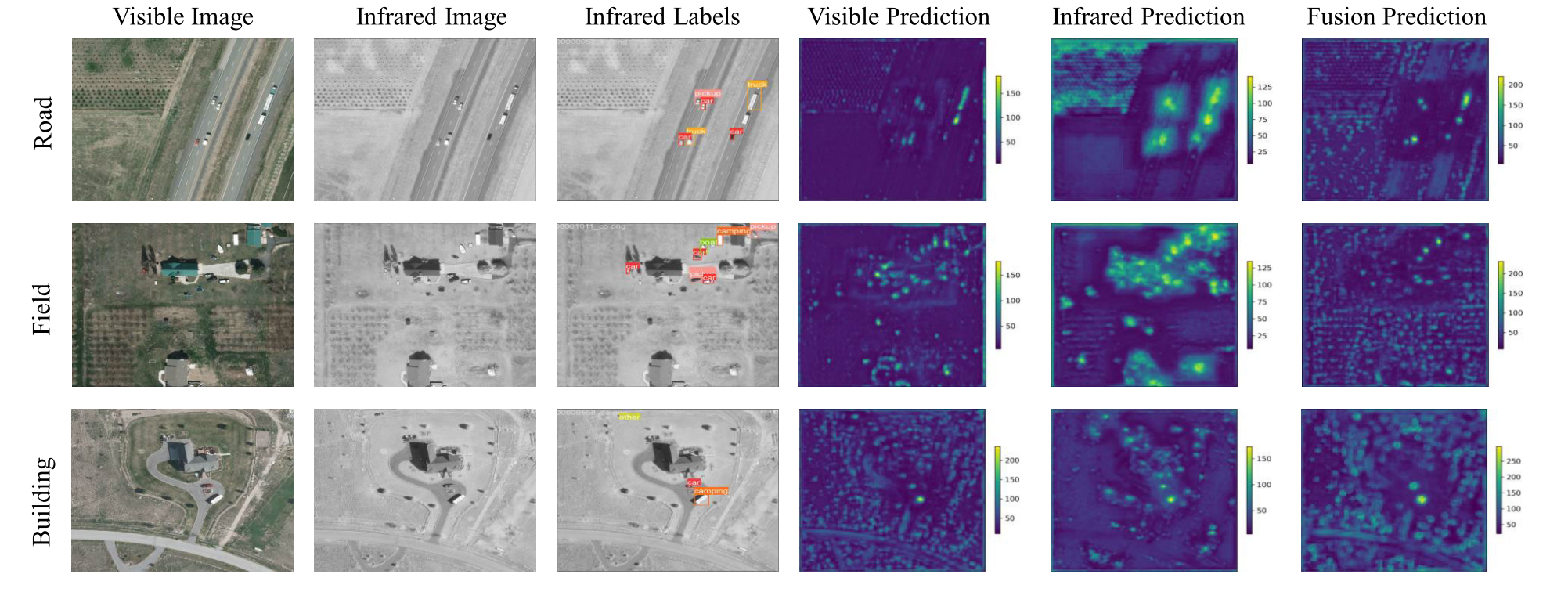

遥感图像中的目标通常表现出尺度多样性。为了解决这个问题,我们引入了特征金字塔网络(FPN)[20]方法,该方法为单模态和多模态数据整合多尺度特征。它通过自顶向下的方式将具有高语义信息的低分辨率高层特征与具有高分辨率和低语义信息的低层特征相结合,确保所有尺度的特征都富含语义信息。如图2的模型训练部分所示,可见光和红外分支在特征提取后输出不同尺度的特征图。然后使用M-SC模块融合这三对特征图,产生多尺度融合的多模态特征。这些特征被上采样以匹配浅层特征的大小,从而获得与浅层特征大小相同的特征图。然后将这些特征图连接起来形成最终的特征图,随后输入到多尺度检测头中。检测部分为可见光、红外和融合分支分别分配一个多尺度检测头。这种方法的优势在于它能够对来自不同模态的多尺度检测结果进行决策融合,最大限度地减少单模态误差对检测结果的影响。

4. 实验结果与分析

A. 数据描述

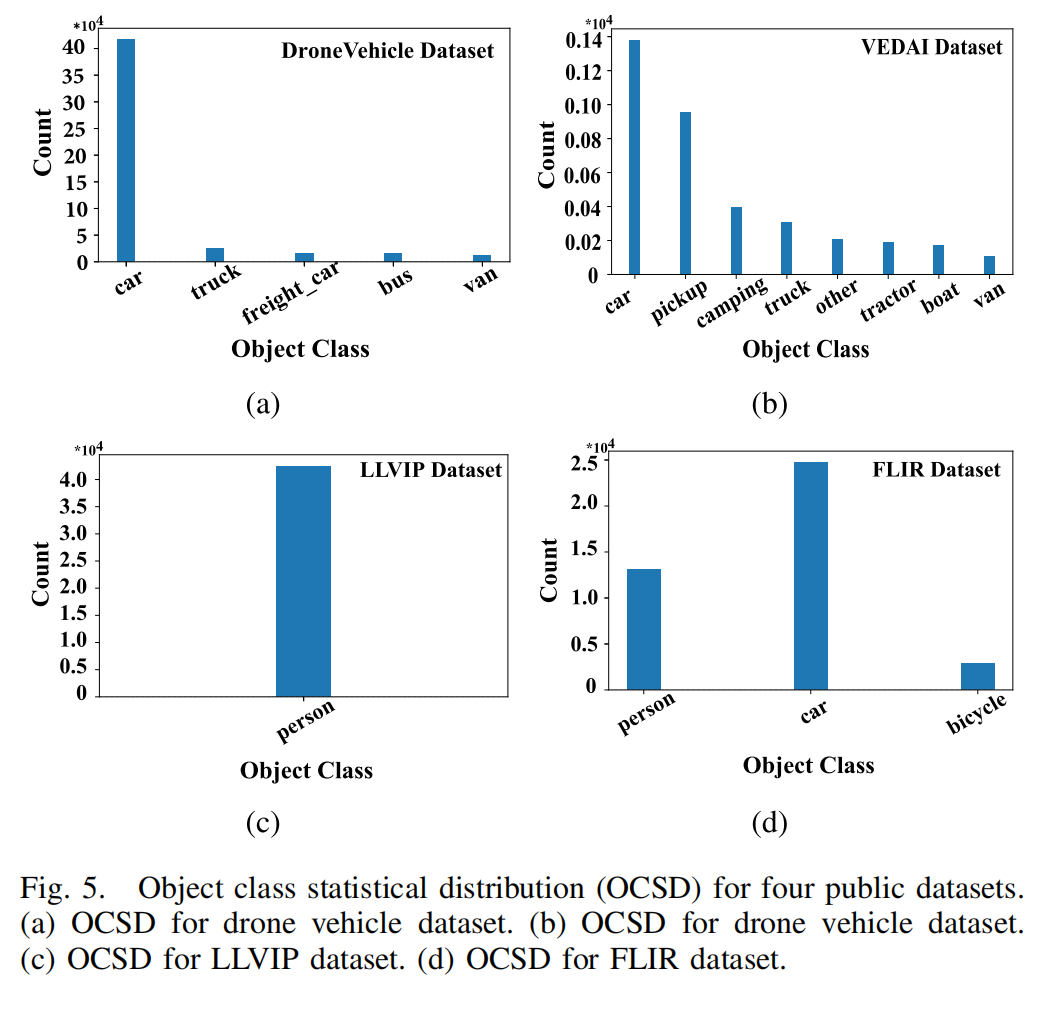

实验中,我们使用了两个公共无人机多模态遥感基准数据集(DroneVehicle 和 VEDAI)以及两个自然场景数据集(LLVIP 和 FLIR)来验证所提出的DHANet的鲁棒性。表I列出了四个数据集的统计信息。图5提供了每个数据集中包含的目标类别的统计分布。

图 5. 四个公开数据集的目标类别统计分布(OCSD)。(a) 无人机车辆数据集的 OCSD。(b) 无人机车辆数据集的 OCSD。© LLVIP 数据集的 OCSD。(d) FLIR 数据集的 OCSD。

B. 实验设置

介绍了骨干网络、基线模型、数据增强、优化器、超参数设置以及M-SC模块中卷积核的具体配置。

C. 评估指标

采用常用的目标检测评估指标平均精度均值(mAP)进行定量分析。

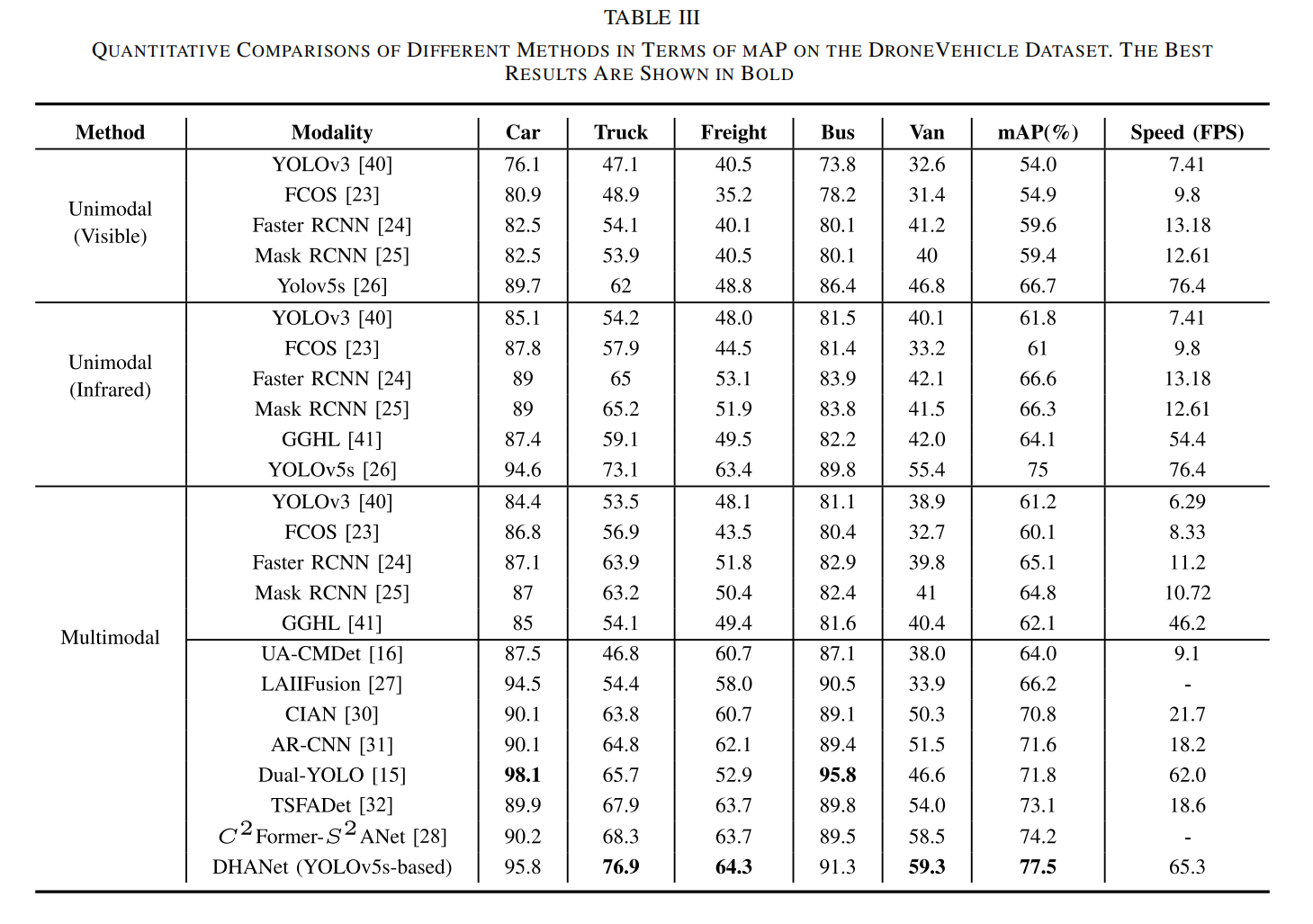

D. 结果分析

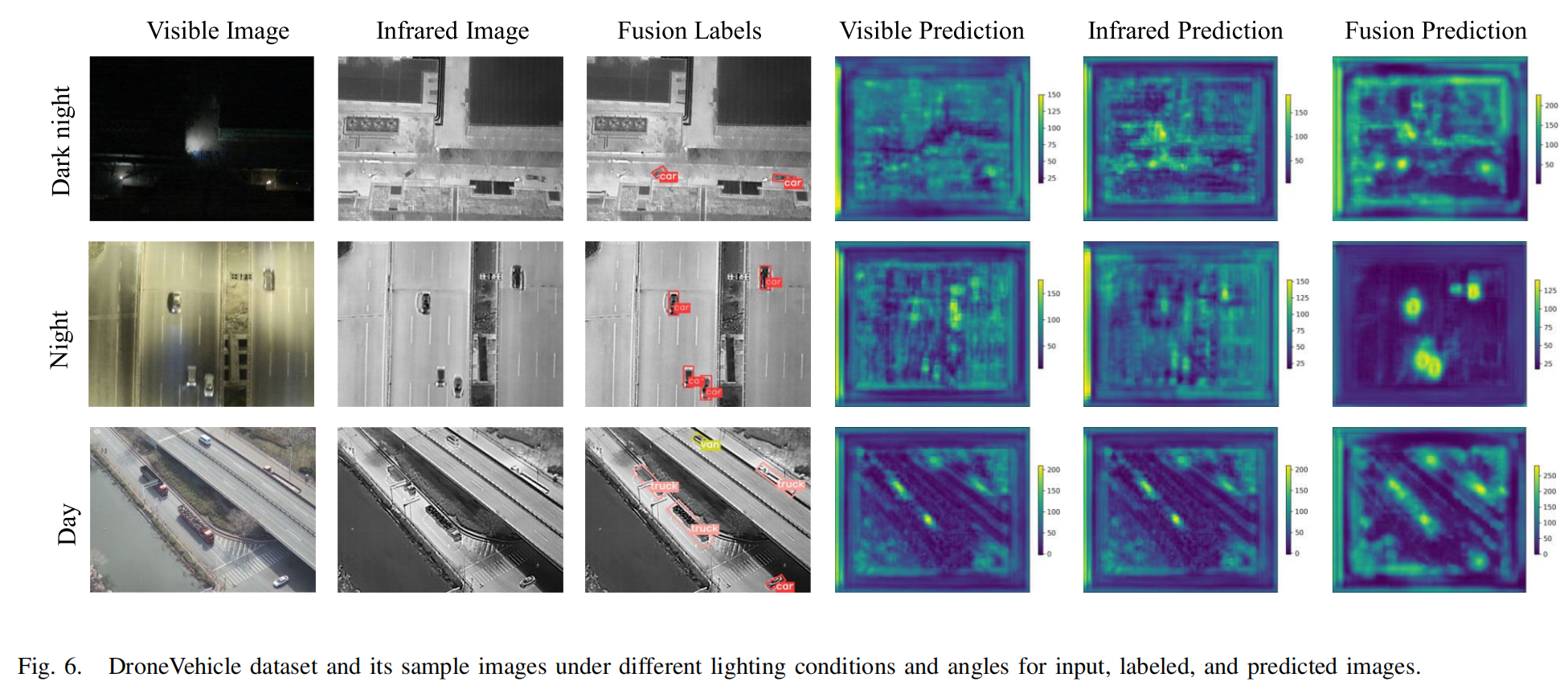

- 在DroneVehicle数据集上的结果: 定量分析(表III)表明,DHANet相比单模态方法性能更优,并超越了其他先进的多模态检测方法(如UA-CMDet, C2Former-S2ANet等)。可视化结果(图6)显示了DHANet在不同光照条件(白天、夜晚、黑夜)下对多尺度目标的有效检测。

-

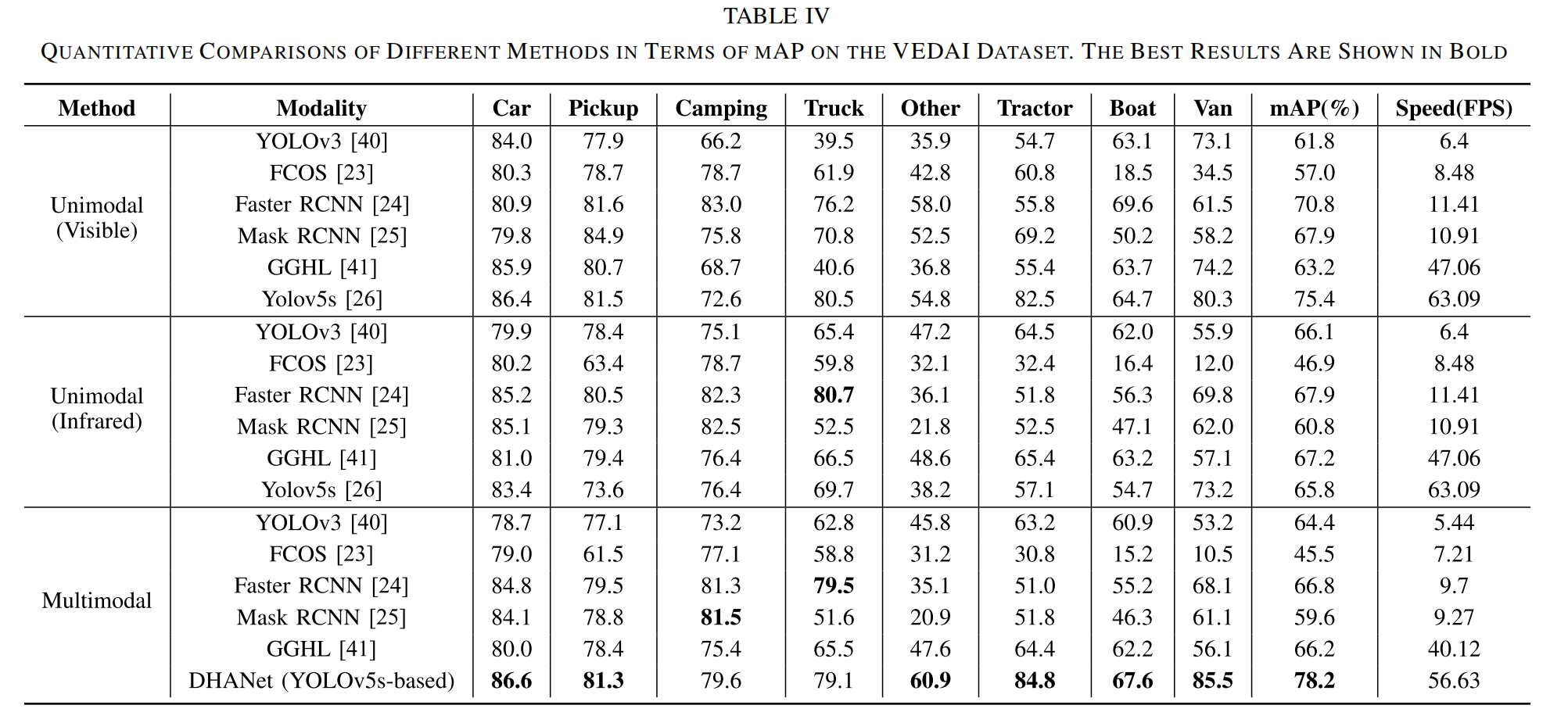

在VEDAI数据集上的结果: 定量分析(表IV)显示了DHANet在可见光和红外模态上的提升,特别是在红外模态和某些特定类别上。可视化结果(图7)展示了模型在遮挡、阴影等挑战下的检测能力。

-

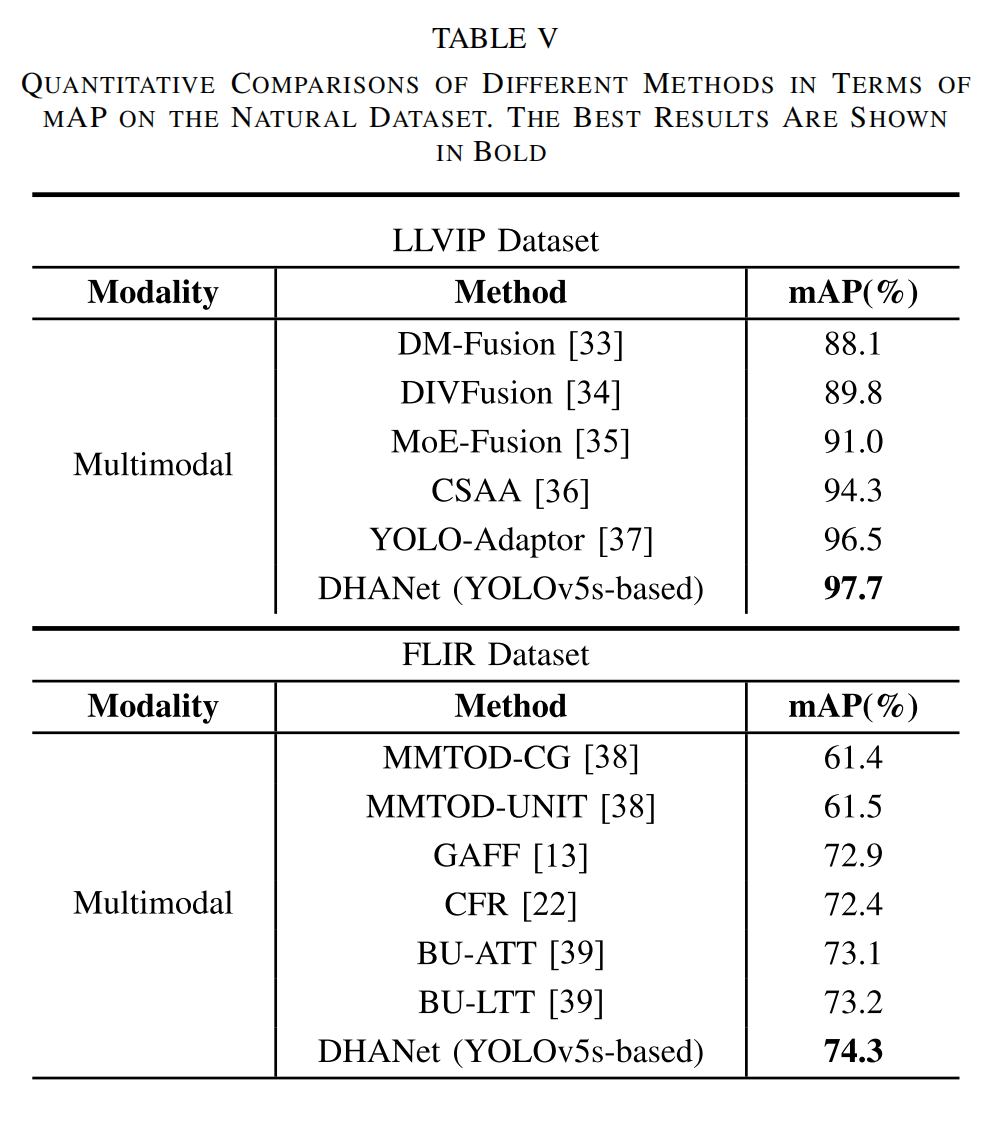

在自然场景数据(LLVIP, FLIR)上的结果: 定量分析(表V)表明DHANet在这些数据集上也取得了领先或具有竞争力的性能,证明了其良好的泛化能力。

E. 消融实验

系统性地评估了各个模块的贡献:

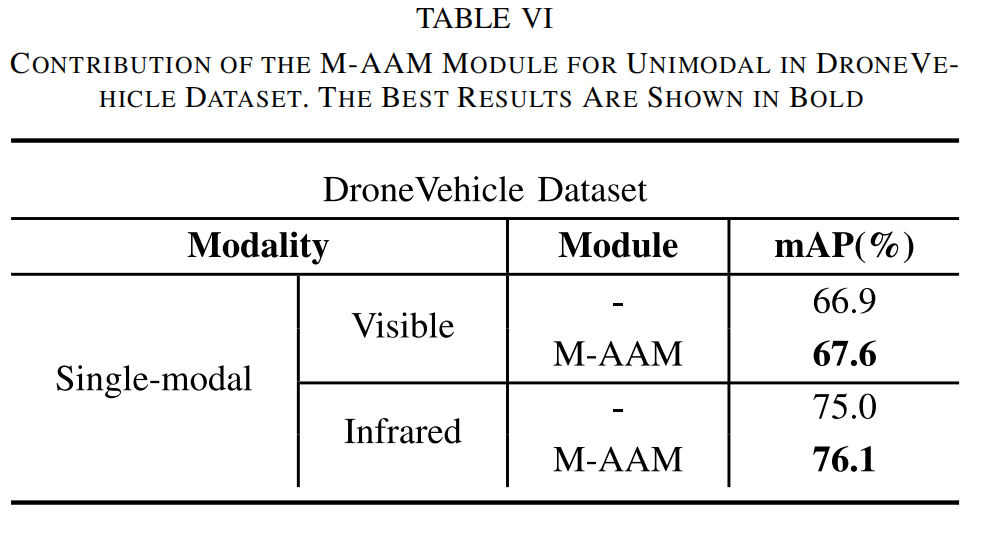

- M-AAM模块的贡献: (表VI)显示了该模块在单模态特征增强上的有效性。

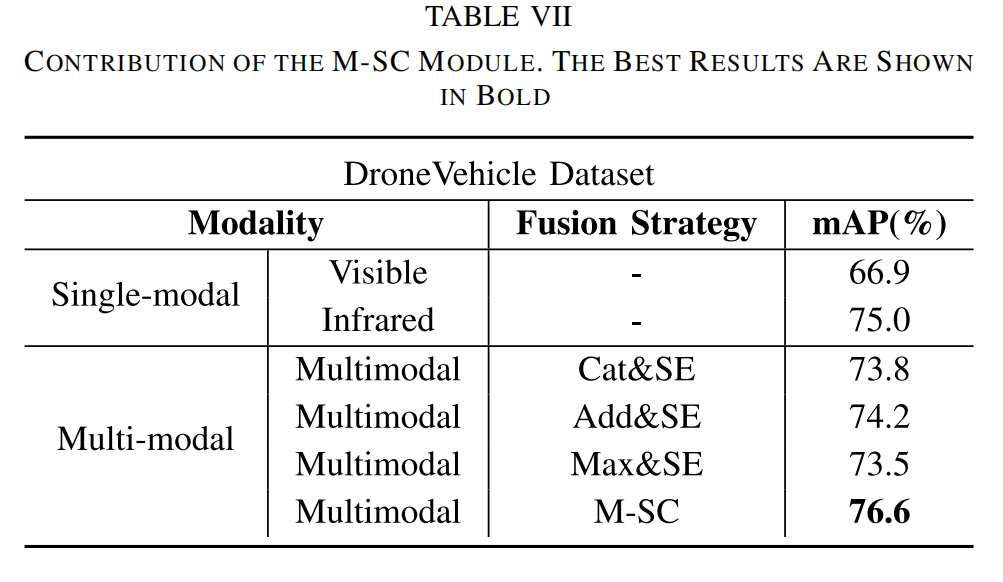

- M-SC模块的贡献: (表VII, 图8)对比了不同的融合策略,证明了M-SC模块的优越性。

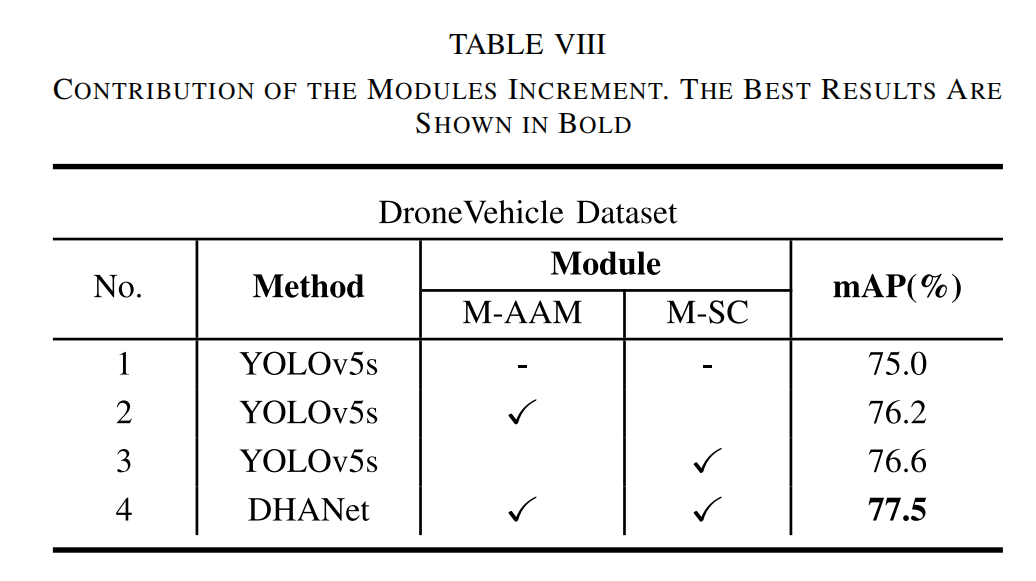

- 模块增量贡献: (表VIII)展示了逐步添加模块带来的性能提升,证明了模块设计的有效性。

5. 结论**

在本文中,我们提出了一种用于多模态无人机目标检测的DHANet,专门设计用于解决具有挑战性的光照变化和复杂环境条件下的多尺度目标识别问题。DHANet包括一个非对称注意力模块来增强单模态特征,以及一个多尺度条纹深度卷积模块用于高效的多模态和多尺度融合,从而提高了目标检测精度并降低了计算成本。我们通过在两个公共无人机多模态遥感基准数据集和两个自然数据集上的实验验证了所提出的DHANet的有效性,证实了其鲁棒性。未来的工作将侧重于改进网络架构以更有效地捕获小目标和复杂细节,优化模型结构和计算过程以减少推理时间,并满足实时监控和分析的要求。