摘要:

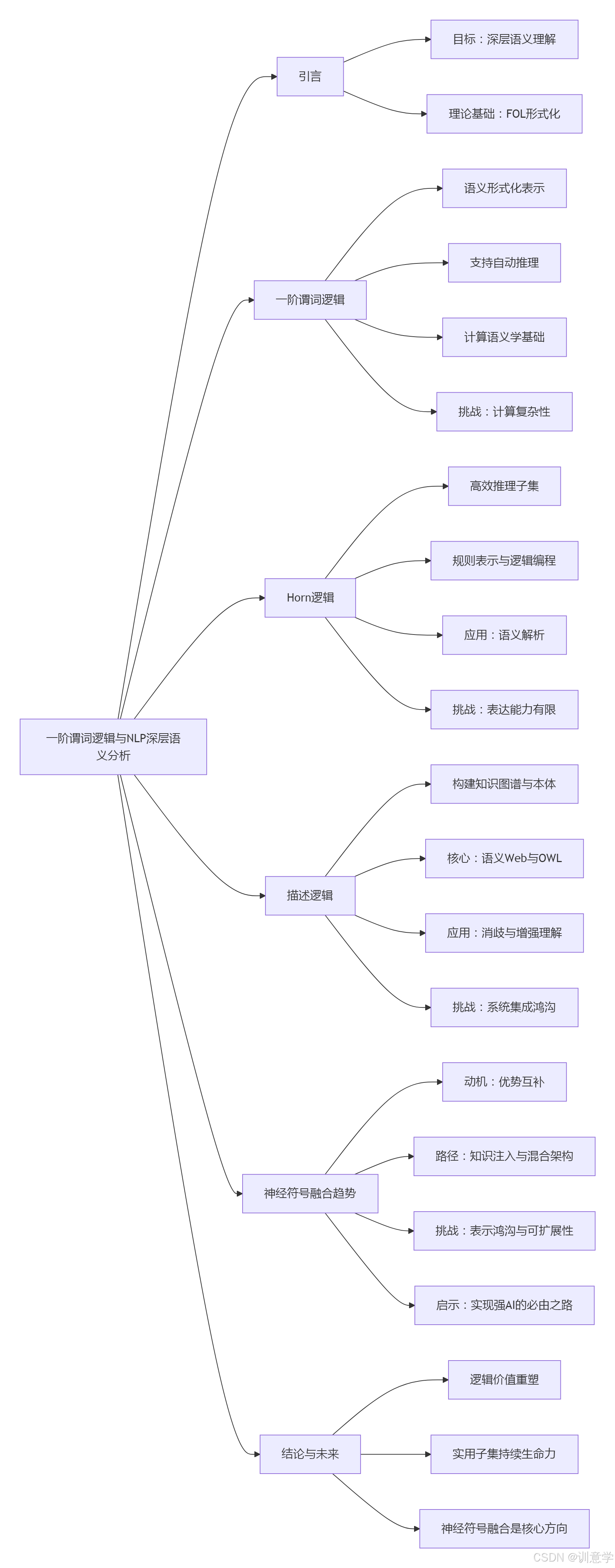

本报告旨在深入探讨一阶谓词逻辑(First-Order Logic, FOL)及其两个重要的计算友好型子集------Horn逻辑(Horn Logic)和描述逻辑(Description Logic, DL),在人工智能(AI)驱动的自然语言处理(NLP)领域的深层语义分析中所扮演的角色、产生的影响以及未来的发展启示。报告首先阐述了一阶逻辑作为知识表示与推理的基石,为自然语言赋予形式化、结构化语义的理论基础。随后,报告分别剖析了Horn逻辑在规则表示与逻辑编程中的应用潜力,以及描述逻辑在构建本体知识库与语义网络中的核心价值。最后,本报告将综合分析当前逻辑系统与主流深度学习模型融合的趋势、面临的挑战,特别是在实现、评测和计算效率方面的差距,并展望其在推动更具可解释性、鲁棒性和推理能力的下一代NLP技术中的关键作用。

1. 引言:从语言符号到逻辑形式的跨越

自然语言处理的终极目标之一是实现机器对人类语言的深层理解,即"深层语义分析"。这不仅仅是识别词汇、句法结构或情感倾向,而是要精确捕捉句子背后的逻辑关系、实体属性、事件结构以及话语意图 。一阶谓词逻辑(FOL)作为一种强大而富有表达力的形式化语言,为这一目标提供了坚实的理论框架 。它能够精确地表示世界中的对象(个体)、对象的属性(谓词)以及对象之间的关系(关系谓词),使得将模糊、多义的自然语言转换为明确、可计算的逻辑形式成为可能 。

然而,通用一阶逻辑的表达能力也带来了巨大的计算复杂性,其推理过程在许多情况下是不可判定的 。这促使研究者们探索其更为高效的子集,其中Horn逻辑和描述逻辑因其在表达能力和计算效率之间的优良权衡而备受关注 。本报告将系统性地梳理这三者在NLP深层语义分析中的脉络。

2. 一阶谓词逻辑(FOL):NLP深层语义分析的理论基石

一阶谓词逻辑是人工智能领域知识表示与自动推理的通用语言 。它在NLP深层语义分析中的基础性影响主要体现在以下几个方面:

-

语义形式化表示 :FOL的核心贡献在于提供了一套严格的语法和语义,能够将自然语言句子转化为结构化的逻辑公式。例如,句子"所有人类都会死亡"可以被转换为 FOL 表达式

∀x (Human(x) → Mortal(x))。这种转换使得计算机能够摆脱自然语言的歧义性,进行确定性的处理和推理 。这对于问答系统、信息抽取和机器翻译等任务至关重要,因为这些任务需要精确理解语句的真实含义 。 -

支持自动推理与问答 :一旦知识被表示为FOL形式,AI系统就可以利用自动定理证明、归结等推理机制进行逻辑推演。例如,在知识库中加入事实

Human(Socrates),系统便能自动推导出Mortal(Socrates)的结论 。这构成了许多高级问答系统和对话系统的核心,使其不仅能检索显性信息,还能基于已有知识推理出隐性答案。 -

计算语义学的基础:在计算语言学领域,FOL长期以来被用于分析和表示语言的语义内容 。虽然其通用性导致了计算上的挑战,但它为后续更专业的逻辑,如模态逻辑或描述逻辑,提供了一个参照系和理论起点 。

尽管FOL的理论价值巨大,但其在实际NLP系统中的直接、大规模应用受到了限制。主要的挑战在于计算复杂性 。对复杂的FOL公式进行推理计算成本极高,这促使学界和业界转向其更易于处理的子集。

3. Horn逻辑:连接逻辑编程与语义规则的桥梁

Horn逻辑是一阶逻辑的一个重要子集,其形式为一组Horn子句(Horn Clauses)。每个Horn子句最多只包含一个正文字(positive literal),这种受限的形式极大地简化了推理过程,使其成为逻辑编程语言(如Prolog)的理论基础 。

-

在规则表示与学习中的应用:Horn逻辑非常适合表示"如果-那么"(if-then)形式的确定性规则。在NLP中,这可以用于定义语法规则、语义约束或领域知识 。例如,在归纳逻辑编程(Inductive Logic Programming, ILP)中,系统可以从数据中自动学习出Horn子句形式的规则,用于知识发现和关系学习 。这为从文本中自动抽取结构化知识提供了一条符号主义的路径。

-

语义解析与代码生成:Horn逻辑的指称语义(denotational semantics)能力使其能够用于形式语言的处理,包括自动生成解析器和解释器 。理论上,它可以将自然语言句子解析为一种中间逻辑形式(表示为Horn子句),这种形式既能代表其语义,又可以直接或间接地被执行,从而连接语言理解与程序执行。

-

新兴趋势与挑战:

- 与神经模型的结合:虽然搜索结果并未明确展示Horn逻辑在现代主流NLP语义解析任务中的广泛应用案例 但其思想在神经符号计算(Neuro-symbolic Systems)领域重新焕发生机。研究者们正在探索如何将逻辑规则(如Horn子句)作为先验知识或约束,集成到深度学习模型中,以提高模型的推理能力、泛化性和可解释性 。例如,通过神经网络学习逻辑规则的参数,或者使用逻辑推理来指导神经网络的搜索过程。

- 计算效率与表达能力的权衡:Horn逻辑虽然高效,但其表达能力有限,无法表示带有否定或不确定性的知识,这限制了它在处理复杂自然语言现象时的应用 。如何扩展Horn逻辑以容纳更丰富的语义表达,同时保持其计算优势,是一个持续的挑战。

- 实现与评测的缺失:目前的搜索结果显示,关于在PyTorch或TensorFlow等现代NLP框架中实现基于Horn逻辑的语义解析器的具体案例、计算效率分析和标准基准(如在PropBank或FrameNet上的F1分数)的公开报告极为匮乏 (Query results for implementation and benchmarks)。这表明,Horn逻辑的应用更多停留在理论和特定研究领域,尚未形成标准化的工业级实践。

4. 描述逻辑(DL):构建语义网络与本体知识库的利器

描述逻辑是另一个为知识表示而设计的一阶逻辑片段,它在表达能力和推理复杂性之间取得了精妙的平衡,尤其擅长描述概念(Concept)、角色(Role)以及它们之间的关系 。DL是语义网(Semantic Web)及其核心语言OWL(Web Ontology Language)的逻辑基础 。

-

构建本体与知识图谱:DL在NLP中的最重要应用是作为构建领域本体和知识图谱的底层形式化工具。本体提供了一个共享的、明确的概念化规范,能够系统地定义一个领域内的术语及其关系 。NLP系统可以利用这些由DL构建的知识库来:

- 消解词义歧义:通过将文本中的词语链接到本体中的确定概念,解决一词多义问题 。

- 增强语义理解:提供背景知识,帮助系统理解句子中实体间的深层关系。例如,知道"CEO"是"公司"的"高层管理人员",这比简单的共现统计提供了更丰富的语义信息 。

- 驱动问答系统:在知识图谱问答(KGQA)中,自然语言问题被解析为对DL知识库的查询,利用DL推理器(Reasoner)来寻找或推断答案 。

-

历史与现状:在1980年代和1990年代初期,DL在计算语言学中被用于将句子的语法分析结果转换为逻辑形式,以表示其字面意义和上下文意义 。尽管后来统计方法的兴起使其在NLP中的热度有所下降,但随着知识图谱在现代AI中的重要性日益凸显,DL再次成为连接语言模型与结构化知识的关键技术 。

-

与深度学习的融合:

- 知识注入:研究者们探索将DL构建的知识图谱中的知识(如实体、关系)嵌入到向量空间中,然后将这些知识表示注入到BERT等预训练语言模型中,以增强模型对事实性知识的理解 。

- 神经符号集成:有研究尝试将DL推理能力与神经网络相结合。例如,一个深度学习模块(如Transformer)负责从文本中提取特征和实体,而一个逻辑模块(基于DL)则负责在这些实体之上进行推理和一致性检查 。这种结合旨在融合深度学习的模式识别能力和逻辑推理的严谨性。

- 实现的挑战:与Horn逻辑类似,在PyTorch或TensorFlow等主流框架中直接集成一个完整的DL推理器的案例非常罕见 (Query results for DL in PyTorch/TensorFlow)。集成通常发生在系统层面,即深度学习模型与外部的知识库/推理引擎进行交互,而不是在框架内部实现逻辑运算。这带来了系统耦合、效率瓶颈等工程挑战。

5. 综合分析:逻辑系统在现代NLP中的困境、融合与启示

通过对搜索结果的综合分析,我们可以看到一阶逻辑及其子集在NLP深层语义分析中的应用呈现出一条从"核心"到"辅助"再到"融合"的演变路径。

-

评测指标的缺失与错位:一个显著的发现是,几乎没有搜索结果提供了针对一阶逻辑、Horn逻辑或描述逻辑在标准NLP任务(如语义角色标注SRL)上的性能基准(如F1分数、准确率)(Query results for benchmarks, SRL)。现有的NLP基准(如CoNLL-2009, PropBank, FrameNet)主要是为评估端到端的、通常是基于统计或深度学习的模型而设计的 。这反映出纯逻辑方法在这些主流评测中已不是主要参与者。评估逻辑增强型NLP系统需要新的、更侧重于推理、泛化和可解释性的指标,而这方面的研究仍处于初级阶段 。

-

实现层面的鸿沟:搜索结果一致表明,在TensorFlow、PyTorch等主流深度学习框架中,并没有成熟的、内建的机制来直接实现和高效执行一阶逻辑、Horn逻辑或描述逻辑的推理 (Query results for implementation in PyTorch/TensorFlow)。像LogiTorch这样的库是专门为逻辑推理任务构建的,而非通用框架的组成部分 。这种实现上的鸿沟是逻辑与深度学习融合的主要障碍之一,导致多数工作停留在系统级集成,而非模型级融合。

-

未来的启示:走向混合智能

- 可解释性与鲁棒性的基石:纯粹的深度学习模型因其"黑箱"特性和对训练数据分布的依赖而备受诟病。逻辑系统以其明确的符号和推理规则,为提高AI系统的可解释性和鲁棒性提供了不可或缺的工具。未来的NLP系统可能会利用逻辑规则来解释模型的决策过程,或者在对抗性攻击下保持预测的一致性。

- 知识驱动的NLP:随着大型语言模型(LLMs)能力的增强,如何有效利用外部的结构化知识以避免"事实幻觉"并进行复杂推理,变得愈发重要。描述逻辑构建的知识图谱将继续作为高质量知识的核心来源,为LLMs提供事实依据和推理骨架。

- 组合泛化:深度学习模型在处理与训练数据结构不同但语义组合方式新颖的输入时常常表现不佳(即组合泛化能力差)。逻辑系统天然具备处理组合结构的能力。神经符号方法,通过结合神经网络的表示学习和符号逻辑的组合推理,被认为是解决这一问题的关键途径。

- 从隐式学习到显式推理的演进:Horn逻辑和描述逻辑代表了两种不同风格的显式知识。Horn逻辑擅长表达过程性和因果性的规则,而描述逻辑擅长表达层次性和定义性的知识。未来的深层语义分析系统需要能够同时整合这两种知识,以构建一个既能理解世界"如何运作"(规则),又能理解世界"是什么"(本体)的综合认知模型。

6. 结论

一阶谓词逻辑及其重要的计算友好型子集------Horn逻辑和描述逻辑,为人工智能中的自然语言处理深层语义分析提供了从理论基础到实践工具的完整光谱。一阶逻辑奠定了将语言形式化的理论根基;Horn逻辑为表示和学习程序性、推导性规则提供了高效途径;而描述逻辑则在构建结构化、层次化的本体知识库方面无可替代。

截至2025年,虽然这些传统的逻辑方法在主流的端到端深度学习范式中并非主角,但它们的思想和价值正在以新的形式回归。面对深度学习在可解释性、常识推理和事实准确性方面的内在局限,一个清晰的趋势是走向逻辑与学习的深度融合。无论是通过神经符号架构,还是将知识图谱作为语言模型的外部"大脑",逻辑系统正在从一个独立的AI范式,转变为增强下一代NLP模型的关键组件。

未来的研究需要填补当前在标准化实现、混合模型评测和计算效率优化方面的空白。只有这样,我们才能充分释放逻辑推理的严谨性与深度学习的泛化能力相结合的巨大潜力,最终实现对人类语言真正深邃、可靠的机器理解。