1.概述

两款模型的升级,清晰地指向了当前大模型发展的两个关键方向:DeepSeek V3.2致力于通过引入稀疏注意力等新技术,让长文本处理更高效、更经济;而Claude Sonnet 4.5则聚焦于让AI智能体更持久、更可靠地完成实际工作,例如其宣称能连续自主工作超过30小时,并大幅提升了计算机操作能力。

2.内容

2.1 DeepSeek V3.2

自问世以来,Transformer架构始终是大语言模型(LLM)发展中无可争议的核心引擎。其关键创新------自注意力机制,赋予模型捕捉海量数据序列中长距离依赖与上下文细微差别的卓越能力。然而这种强大能力伴随着愈发高昂的代价:标准自注意力机制的计算与内存复杂度高达O(L²)(L为输入序列长度)。这种二次方增长特性意味着上下文长度每增加一倍,所需计算资源将增长四倍,这为处理现代AI应用所需的持续扩张的信息库(如长文档分析、扩展对话、大规模代码库解析)筑起了巨大屏障。这种"二次复杂度的桎梏"已成为大语言模型演进的主要瓶颈,使得对架构效率的追求不再仅是学术探索,更成为推动领域持续发展并保持经济可行性的关键所在。

面对这一根本性瓶颈,各类稀疏注意力技术应运而生。其核心思路是通过仅计算经过策略性筛选的查询-键交互子集,来*似模拟完整注意力矩阵的输出效果。这种方法旨在突破二次方缩放定律,将复杂度降至*线性水*(如O(Lk)或O(LlogL),其中k为固定注意力令牌数)。本报告将深入解析该领域的重要新突破:DeepSeek-V3.2-Exp。这款实验性模型引入了名为DeepSeek稀疏注意力(DSA)的新型细粒度稀疏注意力机制。

分析表明,DeepSeek-V3.2-Exp代表了一项意义重大的工程实践突破。它并非通过消除二次缩放的理论捷径,而是采用软硬件协同的混合策略,通过精细管理与最小化计算负载来实现长上下文效率的跃升。该模型在保持与前代强模型DeepSeek-V3.1-Terminus性能*乎持*的同时,显著降低了推理成本。更值得关注的是,其作为"实验版"发布的决策,标志着顶尖AI实验室在架构验证与部署策略上的重要转变------通过开放社区构建大规模试验场,为未来发展路径规避风险。本报告将解构DSA架构原理,剖析其训练方法论,客观评估其性能表现与经济价值,并置于注意力机制发展脉络中审视,以全面把握其对大规模AI发展的深远意义。

2.2 DeepSeek稀疏注意力(DSA)

DeepSeek-V3.2-Exp与前代模型最核心的架构差异,在于引入了DeepSeek稀疏注意力(DSA)机制。这项创新并非对整个注意力模块的彻底替换,而是一个旨在与原有模型架构协同工作的智能过滤层。

DSA的设计哲学以实际效率与硬件性能优先,通过一个包含两个组件的系统,在主注意力计算发生之前,对注意力空间进行智能剪枝。这两个关键组件分别是:

- 闪电索引器 (Lightning Indexer):一个高效的组件,能以极快的速度判断对于当前正在处理的Token,序列中哪些历史Token是最重要的。

- 细粒度Token选择机制 (Fine-grained Token Selection Mechanism):从闪电索引器筛选出的候选Token中,精准选择最相关的Top-k个Token参与最终的注意力计算。

通过这种协同设计,DSA巧妙地管理和最小化了二次复杂度问题,其目标是在保持模型强大性能的同时,实现长上下文处理效率的质的飞跃。

2.3 闪电索引器与细粒度Token选择机制

DeepSeek稀疏注意力(DSA)的原型由闪电索引器(Lightning Indexer) 和细粒度Token选择机制(Fine-grained Token Selection Mechanism) 这两个主要组件协同工作,其核心思想是 "先筛选,后计算" ,从而将稠密的注意力计算问题转化为稀疏计算问题。

⚡️ 闪电索引器 (Lightning Indexer)

这是一个基于内容的快速预注意力过滤器。对于序列中的每个查询Token(Query Token),索引器的任务是计算其与上下文里每一个前序Token 的关联度得分(即"索引分数")。

-

其关键在于,这种稀疏模式是动态自适应的。它根据具体的输入内容决定哪些Token是重要的,这与那些依赖固定模式(如滑动窗口或跨度注意力)的刚性稀疏方法有本质区别,后者的注意力模式是预先确定且与输入内容无关的。

-

为了实现极致的速度,闪电索引器采用了轻量级设计,例如使用非常小的键缓存(据资料提及,每个Token仅128维),并能够利用FP8精度 在DeepSeek自研的DeepGEMM 算子上运行,从而为后续的注意力计算显著提速。

🎯 细粒度Token选择

该机制基于闪电索引器的输出进行工作。对于给定的查询,Top-k选择器 会根据计算出的索引分数,仅筛选出得分最高的k个Token所对应的键值对。

-

这是实现稀疏化的关键一步。经过此步骤,所有其他未被选中的键值对在后续的核心注意力计算中都将被忽略。

-

根据论文,在稀疏训练阶段,模型为每个查询Token选择 k=2048 个键值Token。这使得核心注意力计算的实际序列长度从完整的上下文长度L大幅缩减至一个小得多的常数值k,从而将注意力计算的复杂度从O(L²)有效降低至O(L·k)。

-

最终的注意力输出将仅基于这个稀疏选出的键值集合,按照传统方式计算得出。

2.4 数学原理与工程实现

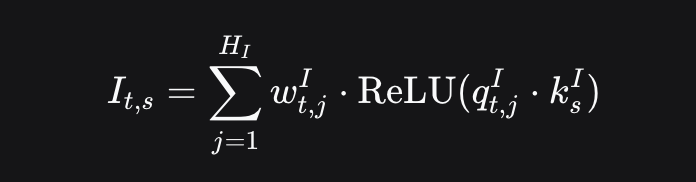

闪电索引器的计算核心通过一个精心设计的数学公式实现极致效率。查询词元 ht 与历史词元 hs 间的索引评分 It,s 计算公式如下:

该公式的每个组件都体现了对硬件吞吐量的深度优化:

-

激活函数选择:特别选用ReLU而非GELU或SwiGLU等更复杂函数,纯粹出于"吞吐量考量"

-

精度优化:索引器全程采用FP8精度运行,充分利用现代GPU的低精度计算单元,显著降低内存占用与计算开销

复杂度特性的深层解析

尽管核心注意力复杂度成功从 O(L2)O(L2) 降至 O(Lk)O(Lk),但需注意闪电索引器本身仍保持 O(L2)O(L2) 的二次复杂度------这是理解DSA设计哲学的关键:

-

工程折衷艺术:通过将二次复杂度隔离至经过极致优化的轻量级模块(极少注意力头数+简易ReLU+FP8精度),使其常数因子 c1c1 被压缩至极低水*

-

混合复杂度模型:系统总成本遵循 Cost≈O(c1⋅L2)+O(c2⋅Lk)Cost≈O(c1⋅L2)+O(c2⋅Lk) 的混合模式,其中 c1≪c2c1≪c2

-

现实意义:在128K上下文长度等实际场景中,索引器的计算成本相较被替代的稠密注意力可忽略不计

这种设计本质上并非从理论上消除二次缩放,而是通过工程隔离策略取得的实践突破:将不可避免的全局搜索问题约束在特化模块中高效执行。然而,这也预示着当上下文长度延伸至百万词元级别时,无论常数因子多小,O(c1⋅L2)O(c1⋅L2) 项终将成为新的系统瓶颈------这为下一代长上下文模型的架构演进指明了方向。

2.5 架构协同:在多头潜在注意力(MLA)中实现DSA

DeepSeek稀疏注意力(DSA)并非一个从零开始设计的全新架构,而是基于DeepSeek-V2和V3.1所使用的多头潜在注意力(MLA)框架进行的增强改造。这一设计决策明确是为了"考虑到能够从DeepSeek-V3.1-Terminus进行持续训练",凸显了一种战略选择:优先考虑迭代改进,而非代价高昂的推倒重来。

🔄 基于MQA模式的高效实现

DSA的具体实现基于MLA的多查询注意力(MQA)模式。

-

标准多头注意力(MHA):每个注意力头都拥有自己独立的查询(Query)、键(Key)和值(Value)投影矩阵。

-

多查询注意力(MQA):作为一种注重效率的变体,所有查询头共享同一组公共的键头和值头。

-

多头潜在注意力(MLA):这是DeepSeek先前的创新,它通过低秩分解将键和值投影压缩到一个更小的"潜在"向量中,在计算时再解压缩为独特的键头和值头,从而在MHA的质量和MQA的效率之间取得了*衡。

通过在MLA的MQA模式中实现DSA,每个潜在向量(代表键值条目)在给定词元的所有查询头之间是共享的。这种共享对于硬件内核层面的计算效率至关重要,因为它最大限度地减少了内存带宽------即数据从高容量GPU内存(HBM)到快速片上处理核心(SRAM)的移动,而这正是现代LLM推理中常见的性能瓶颈。

💎 战略与经济效益

这种将新架构特性"嫁接"到强大现有模型上的"持续训练"方法,具有深远的战略和经济意义。

-

从头开始训练一个最先进的基座模型成本极其高昂,动辄数千万美元。

-

通过设计能够"修补"到现有模型检查点上的创新,研究实验室能够以更快的速度和更低的成本进行迭代并验证新想法。

3.DeepSeek V3.2 模型训练与优化

DeepSeek-V3.2-Exp的诞生并非从零开始训练新模型,而是一个对现有高性能稠密模型进行多阶段精细化适配,使其转型为稀疏架构的严谨过程。此过程始于一个已能处理128K上下文长度的DeepSeek-V3.1-Terminus模型检查点,包含精心设计的持续预训练方案以及一个特意保持与 predecessor 模型完全一致的后训练流程,以确保评估的公*性和可控性。

具体而言,其训练过程主要包含两个核心阶段:

-

持续预训练:此阶段首先进行密集预热,冻结主模型参数,仅训练轻量化的Lightning索引器,使其输出与原始注意力分布对齐;随后进入稀疏训练,引入细粒度Token选择机制,并优化所有模型参数以适应DSA的稀疏模式。

-

后训练:此阶段完全沿用DeepSeek-V3.1-Terminus的后训练流程、算法和数据配置,通过专家蒸馏与混合强化学习等技术进一步优化模型,确保在引入稀疏注意力的同时,模型性能与 predecessor 保持严格可比。

3.1 从稠密到稀疏:持续预训练方案解析

DeepSeek-V3.2-Exp对DeepSeek稀疏注意力(DSA)的适配,通过两个独立的预训练阶段完成。这两个阶段均采用了与DeepSeek-V3.1-Terminus进行128K上下文扩展训练时相同的数据分布。

🔥 阶段一:稠密预热

这是一个短暂但至关重要的初始化阶段。

-

核心目标:在激活完整的稀疏机制之前,为 newly introduced Lightning Indexer 注入有意义的权重,使其具备初步的令牌筛选能力。

-

运行机制:此阶段模型仍运行标准稠密注意力,并冻结主模型的所有参数,仅训练Lightning Indexer的参数。

-

训练技巧:通过KL散度损失函数,让索引器学习模仿原始成熟稠密模型的注意力模式,即将稠密模型中关于"哪些令牌重要"的知识蒸馏到轻量级索引器中。

-

高效性:此预热阶段异常短暂,仅持续1000个训练步,消耗21亿令牌,凸显了其作为快速高效初始化步骤的角色。

🚀 阶段二:稀疏训练

在索引器初始化后,模型进入核心的稀疏训练阶段。

-

机制激活:在此阶段,细粒度的Top-k令牌选择机制被激活,并且所有模型参数(包括主模型和索引器)同时解冻并进行优化。

-

关键技术:采用分离的计算图进行优化:

-

索引器的训练信号继续且仅来自KL散度损失,确保其选择与主模型在已选令牌集上的注意力分布保持一致。

-

主模型则仅基于标准的语言建模损失进行优化。

-

-

训练规模:此阶段明显更长且数据更密集,运行了15,000个训练步,总计消耗9437亿令牌,反映了整个模型适应新稀疏范式所需的大量工作。

3.2 精炼专项能力:基于专家蒸馏的后训练

在通过持续预训练使模型适应稀疏架构后,DeepSeek团队进行了后训练阶段以打造最终的指令微调版DeepSeek-V3.2-Exp。为了保持实验的严谨性并精准评估DSA架构的影响,整个后训练流程------包括算法与数据------均与用于训练DeepSeek-V3.1-Terminus的设置保持一致。

此过程始于专家蒸馏。与在混合任务上训练单一通用模型不同,DeepSeek-AI首先从同一个预训练基础检查点出发,培育了一系列专项模型。每个模型都通过大规模强化学习进行微调,以在特定领域达到卓越水*,这些领域涵盖了数学、竞技编程、逻辑推理、智能体编码、智能体搜索,以及通用的写作和问答任务。

待这些专家模型训练完成后,它们被用于生成海量的、高质量的领域特定数据。这些凝聚了专家模型精髓的蒸馏数据,随后被用于训练最终的通用模型。这种方法是一种强大的知识整合手段,它使得最终模型能够获得接*各个专项专家的性能水*,而无需在其自身的训练过程中同时精通所有领域。

此外,由这些专家生成的数据经过了精心设计,同时包含了长链思维推理和直接简洁回答两种模式,为最终训练阶段提供了一个丰富而多样的数据集。

3.3 对齐人类意图:混合强化学习与GRPO的作用

模型打造的最后一步是混合强化学习训练,其核心采用了组相对策略优化(GRPO) 算法。与先前DeepSeek模型采用多阶段强化学习不同,此阶段将推理、智能体操作和通用人类对齐训练融合为一个统一的强化学习阶段。

这种集成方法旨在有效*衡模型各项能力,同时关键性地规避了"灾难性遗忘" 问题------即模型在某个任务上微调后,会丧失其他任务上的能力。

此阶段采用的奖励机制设计精妙:

-

面向客观任务:针对推理、智能体工具使用等任务,模型依据规则获得奖励或惩罚,评估维度包括答案正确性、避免冗长以及保持语言一致性。

-

面向主观任务:对于通用任务,则使用生成式奖励模型,每个提示都根据其独特的一套评估准则进行打分。

这种精密的奖励设计巧妙权衡了详尽度与准确性、语言一致性与正确性之间的*衡,最终产出的模型不仅能力强,而且能更好地与用户期望对齐。

DeepSeek-V3.2-Exp在多项关键基准测试中,与前代模型DeepSeek-V3.1-Terminus的总体表现相*。例如,在综合知识评测MMLU-Pro上得分持*(均为85.0),在数学推理AIME 2025和编程竞赛Codeforces等任务中性能甚至有小幅提升。

更重要的是,在效率上实现了质的飞跃。官方性能数据显示:

-

长文本推理速度提升约2-3倍。

-

内存使用量降低约30%-40%。

-

API调用成本整体降幅超过50%。在高缓存命中场景下,输入成本可低至0.2元/百万token,输出成本降至0.16元/百万token,使得高缓存场景成本降幅最高可达70%-80%。

4. Claude Sonnet 4.5

Claude Sonnet 4.5 被认为是当前全球最强的代码模型。它不仅在复杂智能体(Agent)的构建中表现卓越,也是最擅长"使用计算机"的模型,并且在推理与数学能力上取得了显著突破。

代码无处不在,它驱动着我们使用的每一个应用、表格和软件工具。能够熟练运用这些工具并解决复杂问题,正是现代工作的核心。而 Claude Sonnet 4.5 正是让这一切成为可能的关键。

本次更新,我们为 Claude Code 带来了重磅功能:

-

检查点(Checkpoints) ------ 保存进度,可一键回滚到任意历史状态;

-

全新终端界面 ,并推出 原生 VS Code 插件;

-

Claude API 新增上下文编辑与记忆工具,让智能体运行更持久、处理更复杂任务;

-

在 Claude 应用 中,直接支持代码执行和文件生成(表格、幻灯片、文档);

-

Claude Chrome 插件 向上月预约的 Max 用户开放。

同时,我们还首次开放 Claude Agent SDK ------ 这套为前沿产品提供动力的基础设施,如今也成为开发者的积木,帮助你像我们一样构建智能系统。

这是迄今为止 对齐度最高的前沿模型,在多个维度上超越了以往的 Claude 系列。

Claude Sonnet 4.5 今日全球可用 。开发者只需通过 Claude API 使用 claude-sonnet-4-5 模型即可,价格保持不变:每百万 tokens 依然为 3 / 15。

Claude Sonnet 4.5 在 SWE-bench Verified 测评中表现达到了业界最先进水*,该测评专注于检验模型在真实场景中的软件编程能力。实际应用中,我们观察到它在复杂的多步骤任务上能够持续专注超过 30 小时,展现出卓越的稳定性与执行力。

在真实操作系统任务评测 OSWorld 上,它以 61.4% 的成绩位居榜首,而就在四个月前,Sonnet 4 的领先成绩还是 42.2% 。这一跨越式提升充分展现了模型在真实计算场景中的强大能力。该模型在多个评测任务中表现出更强的能力,尤其在 推理 与 数学 等方面有了显著提升。

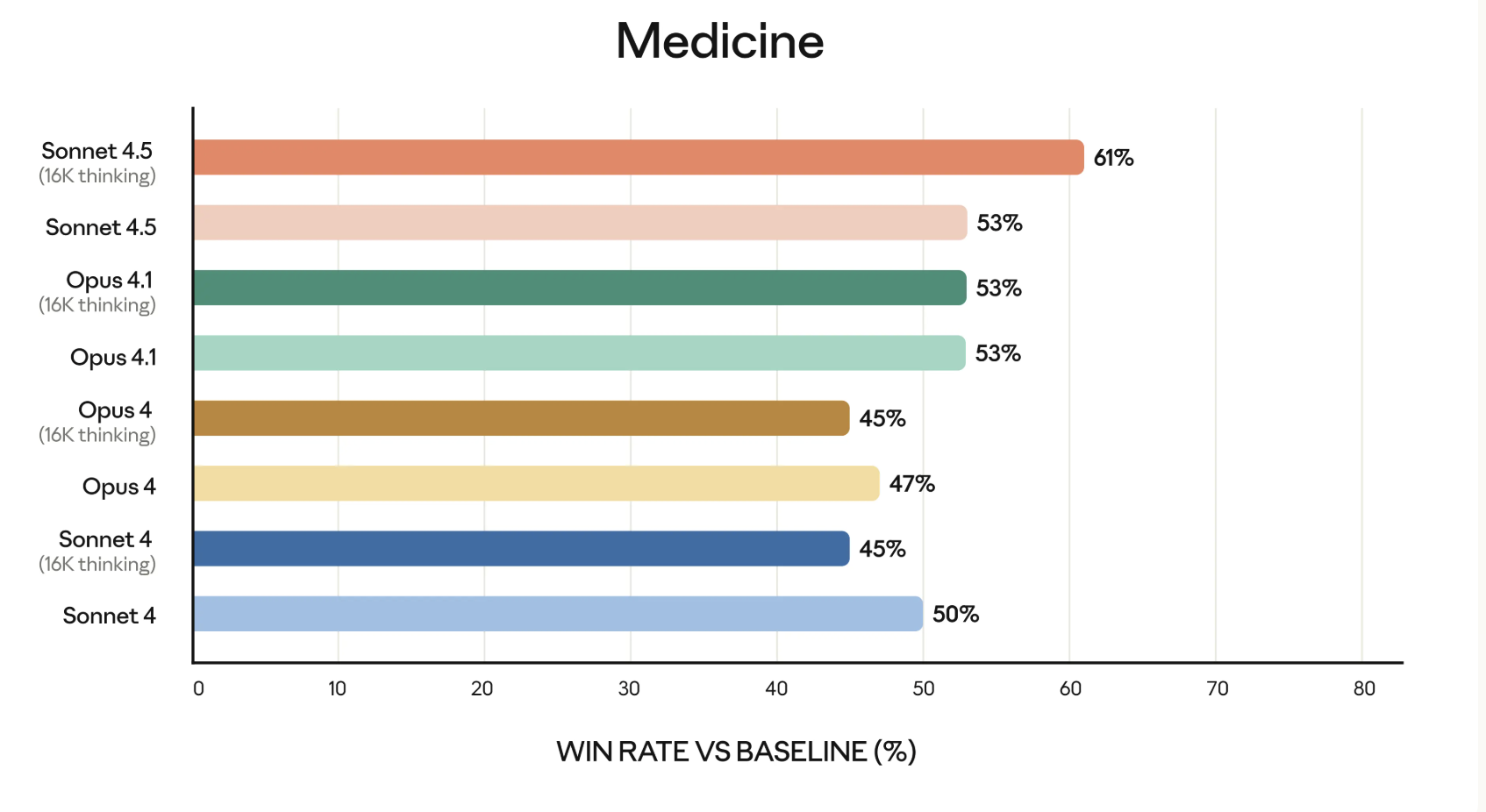

金融、法律、医学以及理工科领域的专家一致认为,Sonnet 4.5 在专业知识掌握和推理能力方面,相较于包括 Opus 4.1 在内的旧模型都有显著提升。

除了成为性能最强的模型之外,Claude Sonnet 4.5 也是我们迄今为止 对齐性最高的前沿模型 。凭借能力提升与大规模安全训练,我们显著改善了模型的行为表现,减少了迎合式回答、误导、权力寻求 以及鼓励不切实际思维等风险。

在智能体与计算机操作能力方面,我们同样取得了重要进展,尤其是在抵御 提示注入攻击 这一高风险问题上,提升了模型的安全防护能力。

5.总结

DeepSeek-V3.2-Exp 于9月29日发布,是一款专注于提升长文本处理效率的开源模型。它首次引入DeepSeek Sparse Attention(DSA) 机制,在保持与前代模型相当性能的同时,显著优化了长文本的训练和推理效率。其API价格大幅下调超过50%,降低了开发者的使用门槛。

Claude Sonnet 4.5 则于次日(9月30日)发布,强化了其在编程和复杂任务处理上的优势。官方称其能连续自主工作超过30小时,在真实软件编码测试SWE-bench Verified中达到了业界领先水*。同时,它在计算机操作能力测试OSWorld上的成绩提升至61.4%,标志着其"动手"能力的质变。此次更新还同步了多项产品增强,包括开放了Claude Agent SDK,允许开发者构建自己的智能体。

简单来说,这两款模型的升级体现了AI发展的两个关键方向:DeepSeek V3.2致力于让长文本处理更高效、更经济;而Claude Sonnet 4.5则聚焦于让AI智能体更持久、更可靠地完成实际工作。

6.结束语

这篇博客就和大家分享到这里,如果大家在研究学习的过程当中有什么问题,可以加群进行讨论或发送邮件给我,我会尽我所能为您解答,与君共勉!

另外,博主出新书了《Hadoop与Spark大数据全景解析》、同时已出版的《深入理解Hive》、《Kafka并不难学》和《Hadoop大数据挖掘从入门到进阶实战》也可以和新书配套使用,喜欢的朋友或同学, 可以在公告栏那里点击购买链接购买博主的书进行学习,在此感谢大家的支持。关注下面公众号,根据提示,可免费获取书籍的教学视频。