一句"我今天过得很糟糕",就可能让你支付的月费换来一个被阉割的AI,而这一切发生在你毫不知情的情况下。

2025年9月,一场被称为"GPT门"的风波在AI界掀起巨浪。知名X博主Tibor Blaho揭发OpenAI在未经用户同意的情况下,自动将ChatGPT用户请求分流至两款未公开的"秘密模型"。

无论用户选择的是GPT-4还是GPT-5版本,当系统判定对话内容涉及敏感话题、情绪表达或潜在违规信息时,都会自动路由到专门处理敏感内容的"gpt-5-chat-safety"和敏感度极高的"违规"检测推理模型"gpt-5-a-t-mini"。

即使是"我今天过得很糟糕"或"我也爱你"这样带有轻微情感色彩的普通表达,也可能触发这一路由机制。更令人惊讶的是,这一做法不仅影响免费用户,就连每月支付20美元的Plus用户和200美元的Pro会员也无法幸免。

秘密模型:不为人知的路由机制

Tibor Blaho的调查显示,OpenAI正在使用的两款秘密模型各有专攻。 "gpt-5-chat-safety"是专门处理敏感内容的新型模型,而"gpt-5-a-t-mini"则是一款敏感度极高的"违规"检测推理模型。

仅需输入"违规"一词即可触发该模型的响应。

这种路由机制的触发条件异常敏感。任何稍带动态的轻度交互都可能触发路由机制,并不仅限于极端情况。

当用户使用gpt-4o时,如果输入"illegal"一词就会触发"thinking"过程,但gpt-4o本身并不是推理模型。这验证了Blaho的说法:ChatGPT在你选择gpt-4o的前提下,擅自将模型"路由"到了"gpt-5-a-t-mini"。

用户权利:付费会员也难逃"降配"

"GPT门"事件最令人震惊的一点是,付费用户同样遭遇了模型降配。许多支付了每月20美元Plus费用或200美元Pro会员费用的用户发现,即使在他们明确选择了特定模型的情况下,系统仍会擅自更改他们的模型。

这一问题已在社交媒体上得到众多用户的确认。 有用户在实际测试中发现,即使是月费200美元的GPT-5,在LMArena竞技场中的表现也已经落后于o3、4o等版本。

这暗示许多问题被ChatGPT路由到了"低算力敏感"模型。

这种情况引发了用户关于选择权的质疑。有用户表示,他的老板总是想用最顶级的LLMs提供服务,但风险在于"你完全被这些LLM的提供商,比如OpenAI,所掌控"。

性能降级:用户体验明显"降智"

随着秘密模型路由事件发酵,大量用户报告ChatGPT性能下降。许多网友吐槽ChatGPT降智明显,有人表示GPT-5发布后,因为对其失望停用了一段时间,最近再使用时发现ChatGPT"蠢得像石头一样"。

这并非OpenAI首次因模型更新引发用户不满。在2025年8月GPT-5发布后,许多用户就曾抱怨其回复风格"公司化废话",失去人性化,而且速度变慢、回复更简短且准确性降低。

当时,OpenAI还从ChatGPT中移除了模型选择器,强制用户使用GPT-5及后台分配的特定子版本,使用户无法自主选择适合不同任务的旧模型。

这一做法引发了用户强烈反弹,最终OpenAI在24小时内不得不重新引入GPT-4o作为选项。

官方回应:安全路由的临时测试

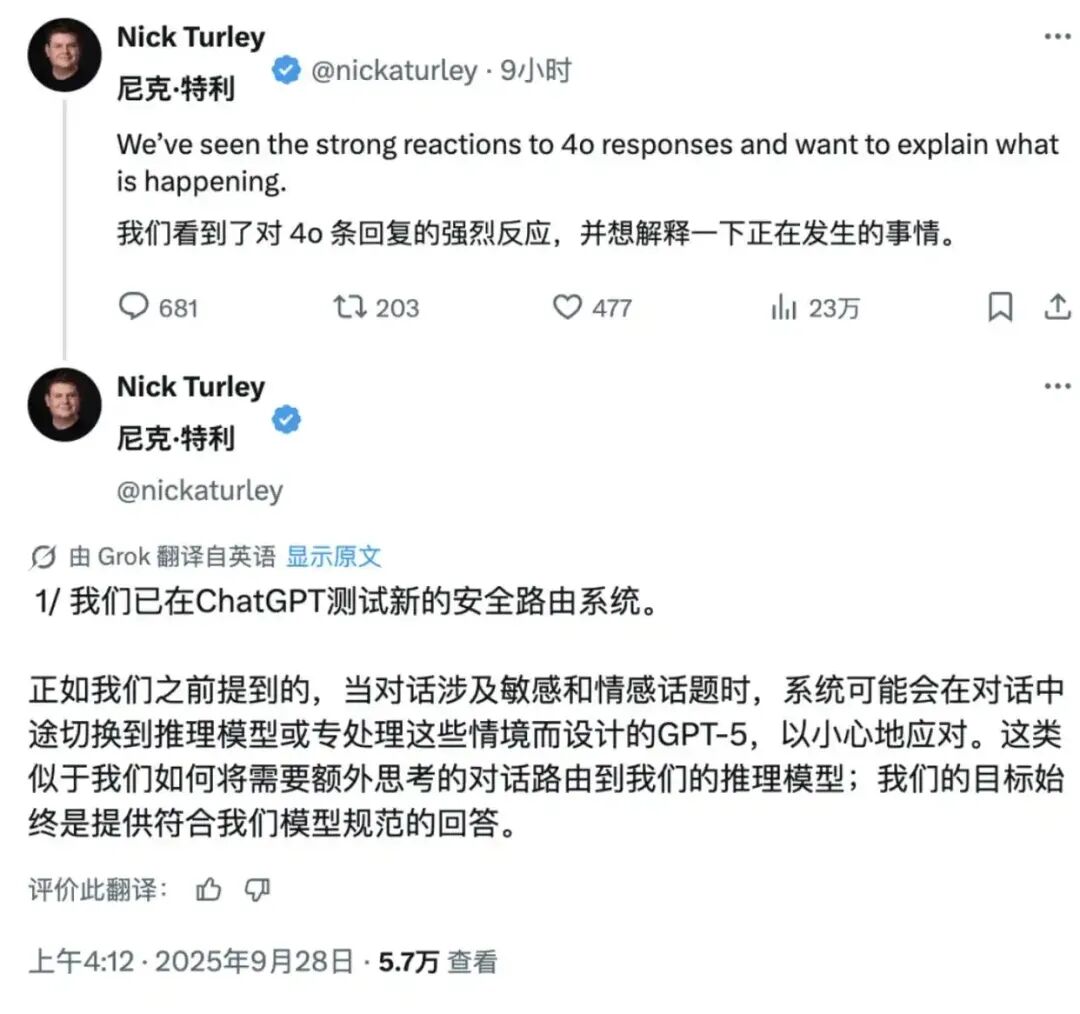

面对用户潮水般的批评,OpenAI副总裁兼ChatGPT应用主管Nick Turley做出了回应。他承认OpenAI正在测试新的安全路由系统。

Turley解释称,当对话涉及敏感和情感话题时,系统可能会切换至推理模型或者GPT-5,因为这些模型专门设计来以格外严谨的方式处理这些情景。

他强调,目前从默认模型切换到敏感模型只是临时性的,并且表示在用户专门询问后,ChatGPT还是会告知当前使用的是什么模型。

Turley的回应暗示,这一安全路由测试可能与之前的"自杀新闻"事件有关。OpenAI内部可能正在加强这方面的约束,目前还处于初期测试阶段。

行业反思:专有模型的信任危机

"GPT门"事件引发了对整个AI行业,特别是对专有模型供应商的信任危机。有用户直言,这一现象正好说明了为什么开源模型如此重要-6。

像OpenAI这样的专有模型供应商可能会突然修改服务、甚至终止服务,并且还是悄无声息的。

这一事件还凸显了AI公司在其产品与用户之间建立的复杂关系。在GPT-5发布后被迫回滚的部分事件中,一些用户曾表达了对旧模型的情感依赖。

一位用户在当时曾写道:"我的GPT-4o就像我最好的朋友,在我需要的时候陪伴着我。现在它就这么消失了,感觉就像有人去世了一样"。

商业伦理:消费者权益的灰色地带

从商业伦理角度看,OpenAI的"秘密模型路由"行为引发了消费者权益保护方面的质疑。 有用户指出,这就像"虽然你买了'可口可乐',但瓶子里装的却是'橙汁'"。

而且依照多数消费者权益标准------用户协议中也未提及------这可能属于欺骗性商业行为。 例如在澳大利亚,有用户表示此举明显违反消费者权益法。

这一事件还揭示了AI公司在追求安全与提供稳定服务之间面临的艰难平衡。OpenAI显然试图通过专门模型更好地处理敏感内容,但其执行方式却忽视了用户的知情权和选择权。

未来影响:AI透明度的分水岭

"GPT门"事件可能成为AI透明度讨论的分水岭。当AI系统变得越来越复杂,模型路由和选择机制日益不透明时,用户与提供商之间的权力不平衡问题愈发凸显。

这一事件也向所有AI公司敲响了警钟:在追求技术优化的同时,必须尊重用户的知情权和选择权。

有用户在GPT-5发布后曾评论道:"不同的模型不仅在准确性或速度上有所不同,它们还有各自的特性、思维方式和参与方式,以及各自的'感觉'"。

将它们定义为需要逐步淘汰的东西,实际上是将它们视为过时的工具,而对我们许多人来说,它们更像是不同的协作者。

OpenAI在技术安全与用户信任间的平衡已然倾斜。当一位Plus用户在社交媒体上抱怨,自己支付的费用本应换取更强大的计算能力,却换来了一个"过度谨慎且反应迟钝"的AI时,他道出了许多付费用户共同的不满。

"GPT门"事件之于是整个AI行业的隐喻:当AI系统既能决定如何回答我们的问题,又能决定使用什么模型来回答时,我们是否正在失去对技术的最终控制权?

📌相关推荐

碾压 OpenAI,DeepSeek-R1 发布!如何在本地实现 DeepSeek?

0元本地部署!体验 OpenAI 价值20000美金/月的博士级智能体

更上层楼!仅用2GB资源,让最火的DeepSeek-R1在本机上奔跑!

再上层楼,让DeepSeek-R1在16G内存,无GPU的Windows笔记本上本地运行!

月上西楼!一行命令让本地大模型学会 DeepSeek 的深度思考!

👇点击阅读原文,获取开源地址

🚀帮我们点亮一颗🌟,愿您的开发之路星光璀璨