文章目录

摘要

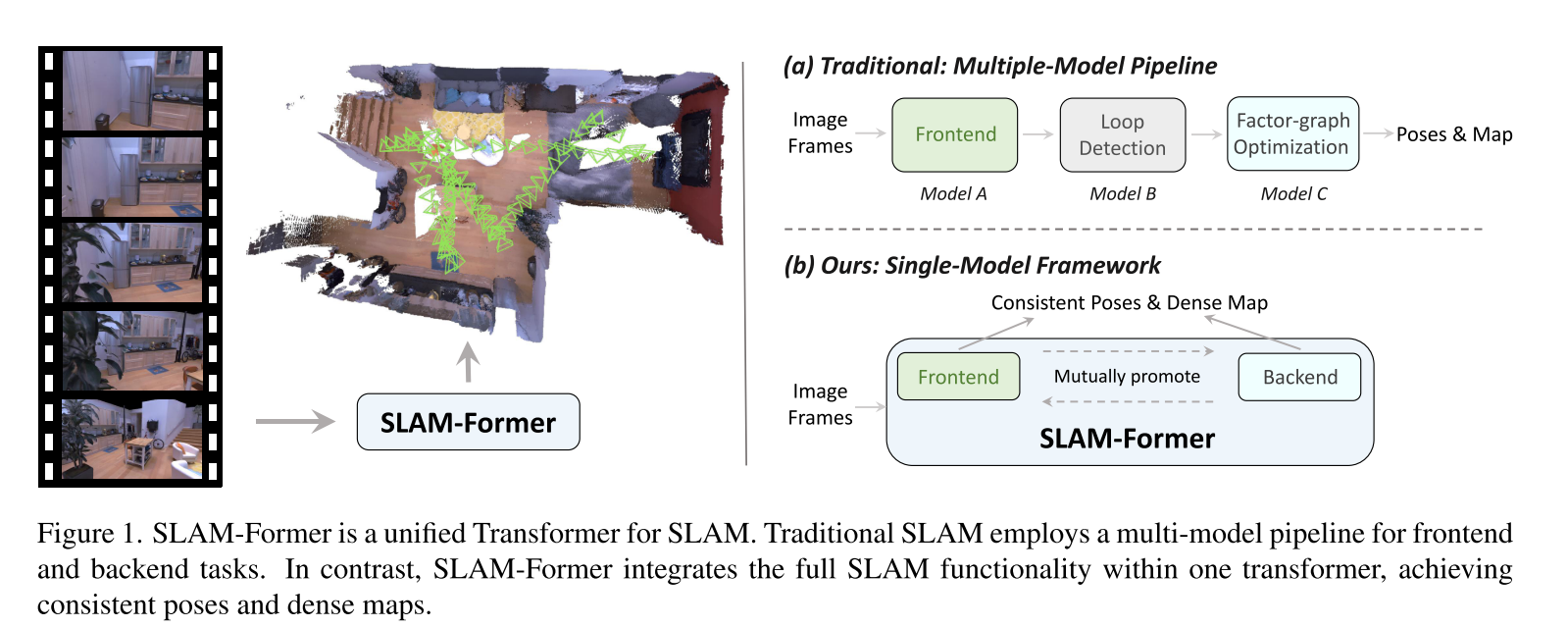

本文提出了SLAM-Former,这是一种新的神经方法,它将全部SLAM功能集成到单个变压器中。与传统的SLAM系统类似,SLAM-FORM由前端和后端组成,两者串联运行。前端对连续的单目图像进行实时处理,进行增量映射和跟踪,后端进行全局细化,以确保几何一致的结果。这种交替执行允许前端和后端相互促进,从而提高整体系统性能。综合实验结果表明,与目前最先进的密集SLAM方法相比,SLAM-FORM具有更好或更具竞争力的性能。

引言

目前SLAM算法主要是视觉SLAM是无法提供相关环境信息,考虑到目前神经网络和计算机视觉的应用来估测单个相机深度和运动而不需要进行多传感器融合创建稠密地图,如DUSt3R[9]和VGGT[10]。这些模型揭示了数据驱动的三维结构预测的巨大潜力

传统SLAM和本文提出大一统的框架对比图:

作者观察到,使用几何基础模型作为重建模块的SLAM方法,如MAST3R-SLAM和VGGT-SLAM,由于依赖于局部子地图的对齐,存在全局不一致的问题。另一方面,StreamVGGT和Stream3R等流方法在不重新映射过去的情况下处理增量输入,这可能会导致过去数据和新传入数据之间的严重不匹配。在这项工作中,作者介绍了一个在单个统一的变压器体系结构中实现的可视化SLAM框架,称为SLAM-Former。

SLAM-Former由同一变压器中的前端和后端组成,协同工作,如图1(B)所示。前端对连续的RGB图像进行实时操作,以进行关键帧选择以及增量贴图和姿势更新。随着前端的增量输出,后端会定期对地图进行细化,并以较低的频率全局摆姿势。在这个交替的过程中,前端和后端相互促进。每次后端运行后,变压器的KV缓存都会更新到前端,以进行进一步的增量操作。作为回报,前端提供初始结果和顺序,帮助后端进行优化。为了使单个变压器具备所有SLAM能力,作者提出了SLAMFormer的三种培训模式。与传统的SLAM流水线需要额外的环路检测模块来关闭其姿势图相比,SLAM-Forform的后端完全专注地完成了这一点,相当于在密集因子图上处理环路检测。与校准和未校准的最先进方法相比,SLAM-Former前者在广泛使用的密集Mono SLAM基准上实现了显著更好的重建和最先进的跟踪性能。

相关工作

稠密RGB-SLAM

近年来,由于深度学习技术的应用,使用单目相机的密集SLAM的研究取得了重大进展[5-8,13]。由于没有深度传感器,密集的RGB SLAM需要从整体上优化几何体和相机的整个序列。早期的工作集中在降低深度估计的计算成本上。例如,CodeSLAM[14]和DeepFtors[15]将潜在深度优化为另一种选择。Tandem借鉴了MVSNet[16]的优点,依赖于外部模型,但它打破了共同优化结构[17]。相反,Droid-SLAM[5]和SceneFactory[6]将深度光流模型整合到流水线中,并通过速度密集型捆绑调整共同优化两者。另一方面,基于NERF[18]和高斯飞溅[19]的方法已经成为重塑密集SLAM的一种趋势。NERF-SLAM方法[13,20]和GS-SLAM方法[21]将场景作为一个整体进行优化,以实现高度逼真的新颖视图合成目标。然而,这些基于渲染的SLAM通常很耗时,重建负担不起,而且对模糊和噪声高度敏感,这在很大程度上限制了它们在现实生活中的使用。

随着最近基础几何技术的出现,如DUSt3R[9]和VGGT[10],研究人员发现了新的灵感。MASt3R-SLAM[7]利用先进的成对模型MASt3R[22]进行高质量的免校准匹配和几何构造,展示了在传统SLAM管道下的最先进性能。另一方面,VGGTSLAM[8]将子图送入VGGT,并使用一种新颖的SL(4)流形将它们连接起来,首次在基础几何中模拟几何变形。然而,这些方法依赖于几何体的对子映射优化,这往往会导致帧之间的结构冲突。MASt3R-SLAM试图通过TSDF-Fusion[4]解决这个问题,它只能修复小的不匹配。同时,由于VGGT-SLAM只有前端和端节点的子图连接,因此不能处理这一问题。这促使我们开发一种前端-后端SLAM结构,能够正确而灵活地解决这个问题。

前馈三维重建

最近,DUSt3R[9]引领了一种直接使用可伸缩训练数据回归3D结构的趋势。然而,在处理图像对时,DUSt3R需要对较大的场景进行全局优化,这降低了推理效率。已经提出了几项工作来解决这一局限性。Fast3R[23]、VGGT[10]和PI3[24]在一次正向传递中处理多视角图像,避免了耗时的后处理全局优化。这三个模型都是基于Transformer的多视点地图估计模型。Fast3R突出了高效处理数千张图像的能力,而VGGT则展示了具有3D多任务学习和可扩展训练数据的简单架构可以实现最先进的结果。PI3进一步引入了置换等变设计,消除了对固定参考视图的依赖,增强了对输入排序的健壮性和可扩展性。

LONG3R[27]使用3D时空存储器和从粗到精的流水线来处理长序列流重建。StreamVGGT[11]和STream3R[12]进一步纳入了因果注意,从现代语言模型中汲取灵感,以实现实时流重建。然而,现有的流方法只关注增量更新,而不重新检查过去的估计,导致漂移和有限的全局一致性。为了解决这个问题,我们提出了SLAM-FORFER,这是一个统一的神经SLAM流水线,集成了前端和后端,以实现高效的增量更新和周期性的全局优化。

SLAM-Former

总体框架

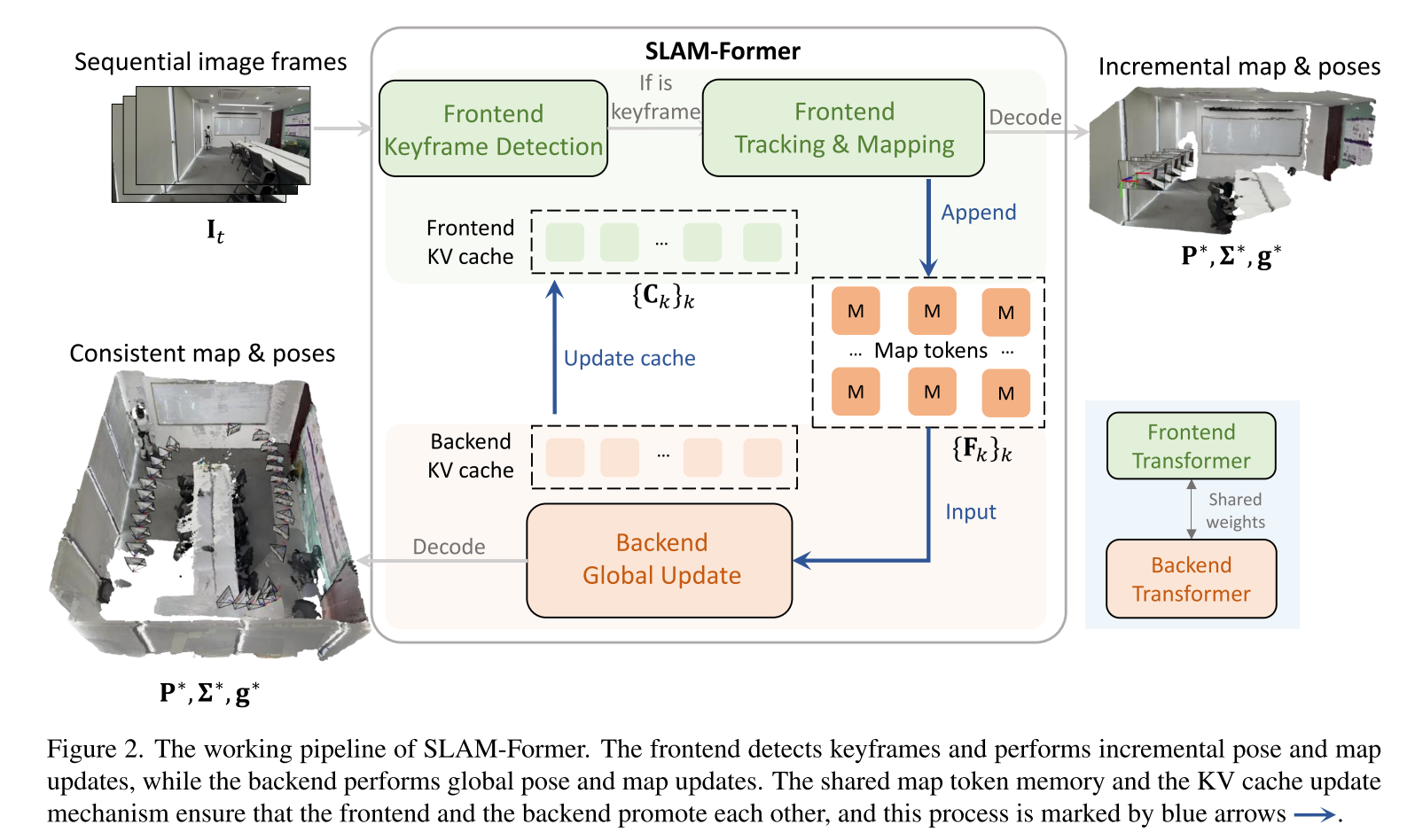

前端检测关键帧并执行增量姿势和贴图更新,而后端执行全局姿势和贴图更新。共享的地图令牌内存和KV缓存更新机制确保了前端和后端的相互促进,这个过程用蓝色箭头标出。

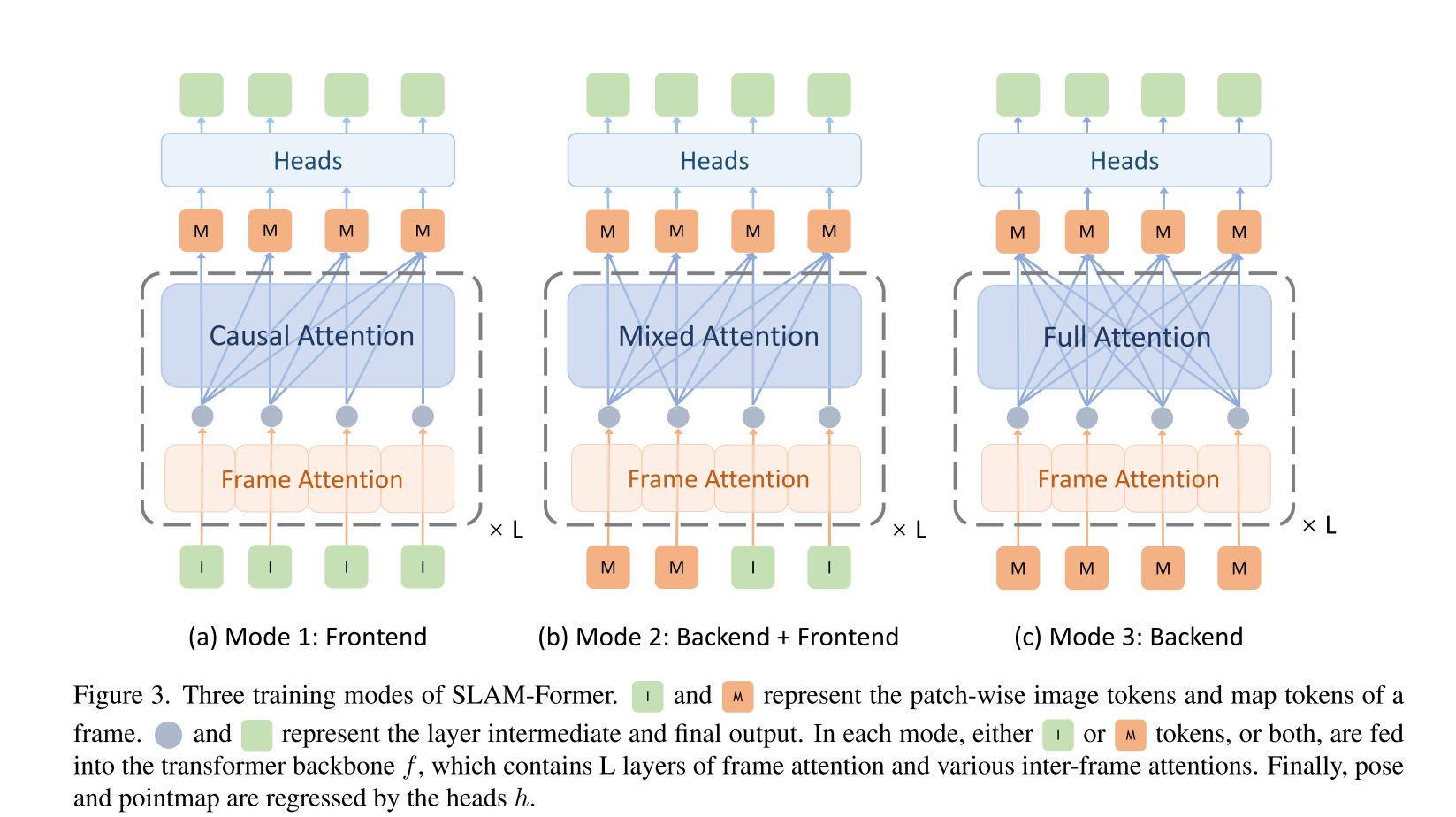

Transformer Architecture:Transformer Architecture使SLAM-Former建立在单个变压器模型上,其中变压器主干f聚合帧内和帧间信息,而特定于任务的头部h解码场景几何图形和相机姿势。为了清楚起见,我们假设图像特征是预编码的,并且f的输入由一组用寄存器令牌扩充的图像块令牌组成。遵循类似PI3的设计,我们在所有帧中使用共享寄存器令牌,从而消除了指定参考帧的需要。主干包含L层,每个层都配备了帧内和帧间注意,共同捕获局部图像上下文和时间对应。SLAM-Former集成了用于增量帧处理的前端和用于在共享变压器主干内进行全局贴图和姿势优化的后端(参见图2)。

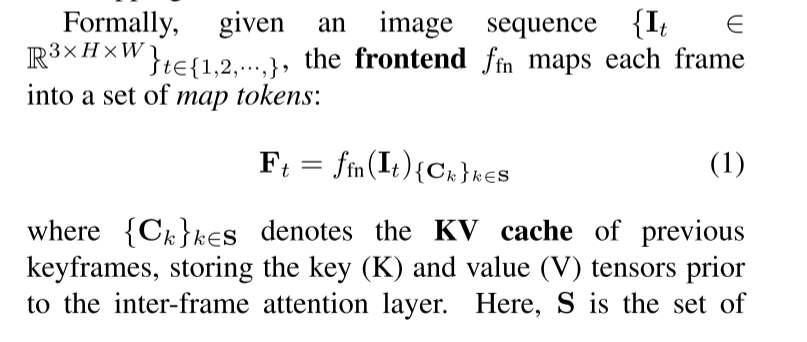

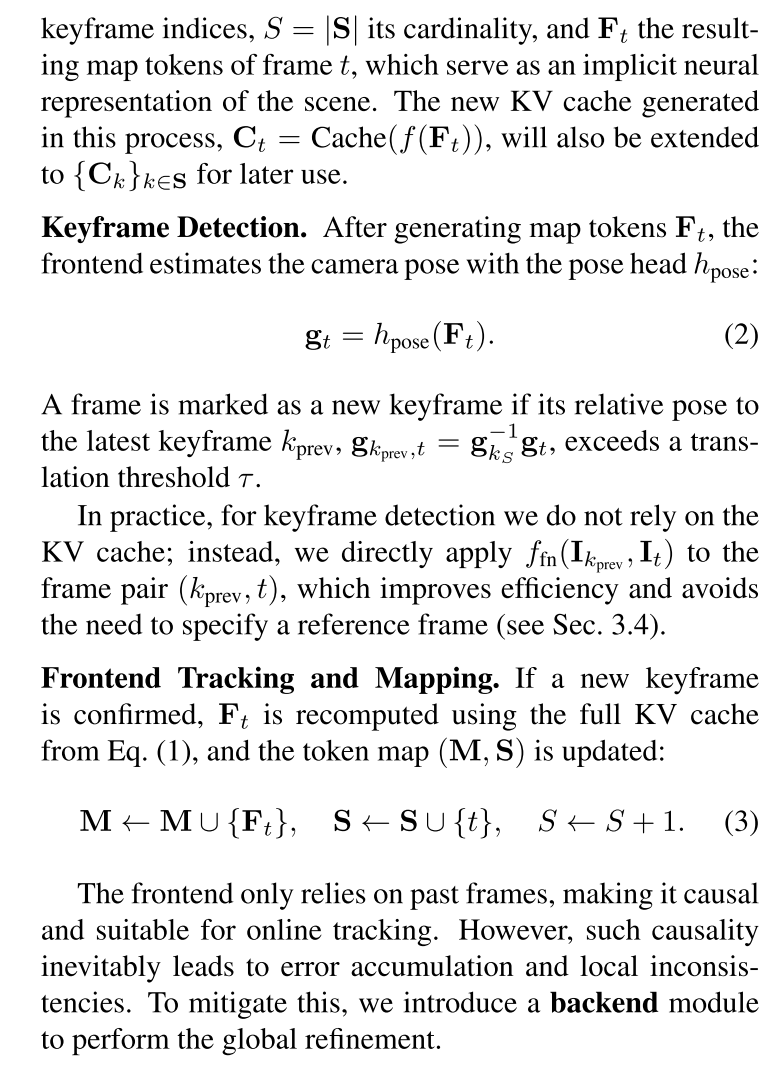

前端:当新的帧到达时,前端首先决定它是否应该是新的关键帧。如果是,系统将继续跟踪和映射。

后端:

训练策略;

实验

3D Tracking Evaluation

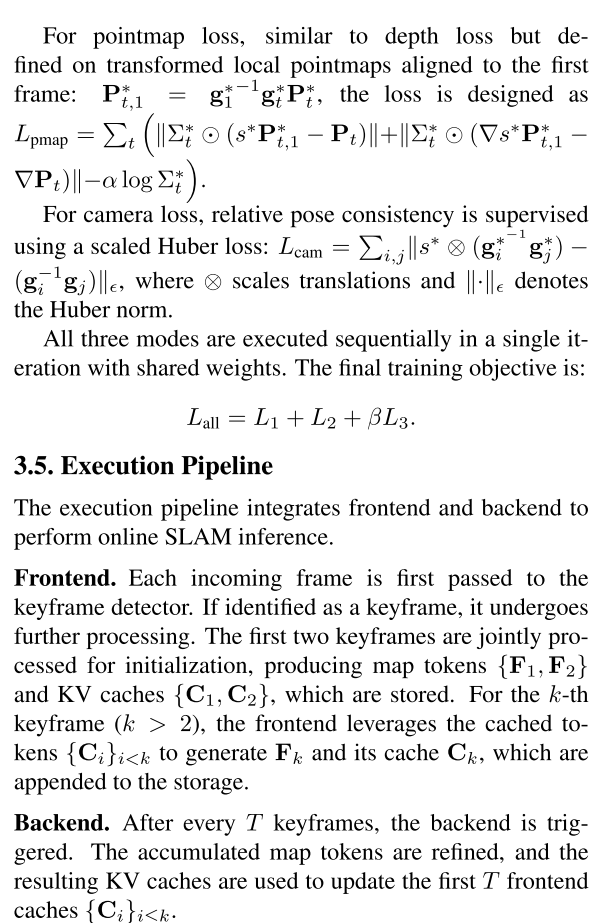

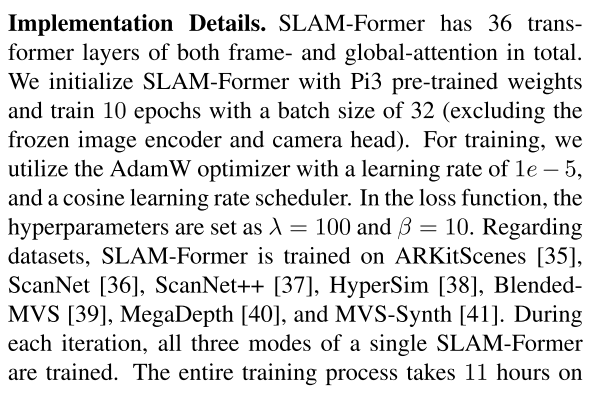

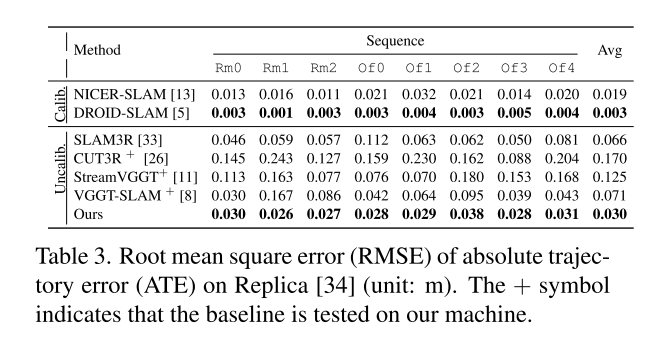

我们首先评估了SLAMFormer在TUM RGB-D、7场景和副本上的跟踪性能。计算了各种方法在标定和未标定条件下的绝对弹道误差(ATE)的均方根误差(RMSE)。

TUM RGB-D Track:在TUM测试中,评估是在广泛使用的场景子集上进行的。结果汇总在表格1.如图所示,在未校准设置下,我们的模型始终优于大多数基线。在这些更复杂的序列中的卓越表现,例如涉及大量摄像头旋转和环路关闭的房间和地板,表明我们后端的全局优化在缓解累积漂移方面特别有效。更重要的是,它显著减少了相对于校准基线的误差,达到了极具竞争力的水平。

7-scenes Track:遵循与TUM RGB-D曲目类似的协议,我们评估7-Scene,如表格2.在未校准和已校准设置下,我们的方法都优于大多数基线。在更复杂的场景中,如办公室、南瓜和厨房,我们的模型实现了明显更高的性能差距。平均而言,我们的方法比所有基线都要好。

Replica Track.:以前的跟踪实验是使用真实捕获的数据进行的,而副本数据集是合成的。我们的方法在未校准的设置下显示了显著的改进,与SLAM3R相比,ATE减少了大约50%,表现优于所有基线,如Tab3.然而,我们的方法的性能与NICER-SLAM相当,但仍落后于传统的SLAM方法Droid-SLAM。这是因为合成数据缺少噪波和模糊,使得匹配足够精确,可用于捆绑调整中的姿势解算。相比之下,在之前的真实数据测试中,Droid-SLAM的表现与我们的方法类似。

重建评估

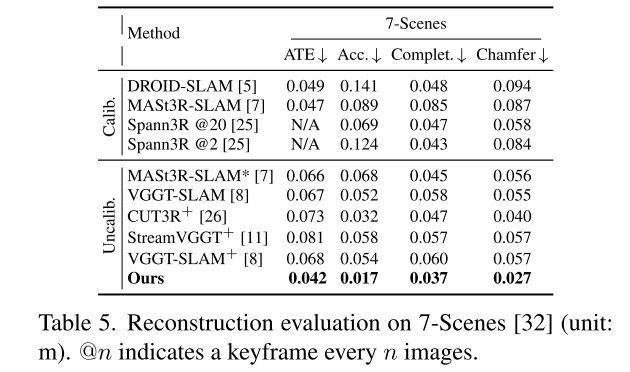

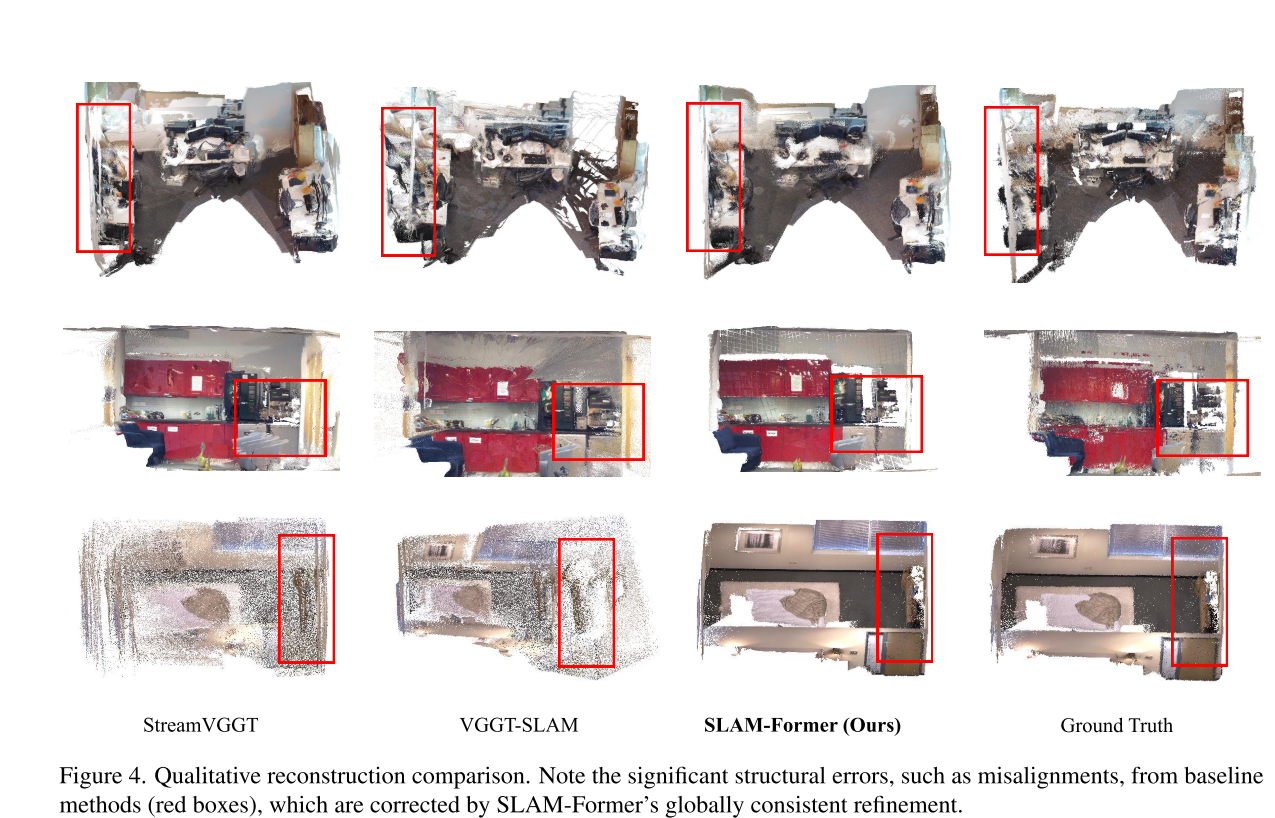

7-scenes Reconstruction7个场景的密集重建结果显示在表格5中,与其他密集SLAM方法相比,我们的方法有很大的差距。在重建质量方面,我们的方法达到了0.017m的最高重建精度,而其他方法都在0.05m以上。在完备性和倒角距离方面,我们的方法分别达到了0.037m和0.027m,仍然比所有基线高出50%左右。在我们的重建演示图4中也展示了这种在所有主要重建指标上的一贯优越性能。如前两行(办公室和南瓜)所示,基线在红色窗口区域内的帧之间显示了不匹配的表面。相比之下,我们的SLAM-Former的重建始终显示出连贯和准确的结构。

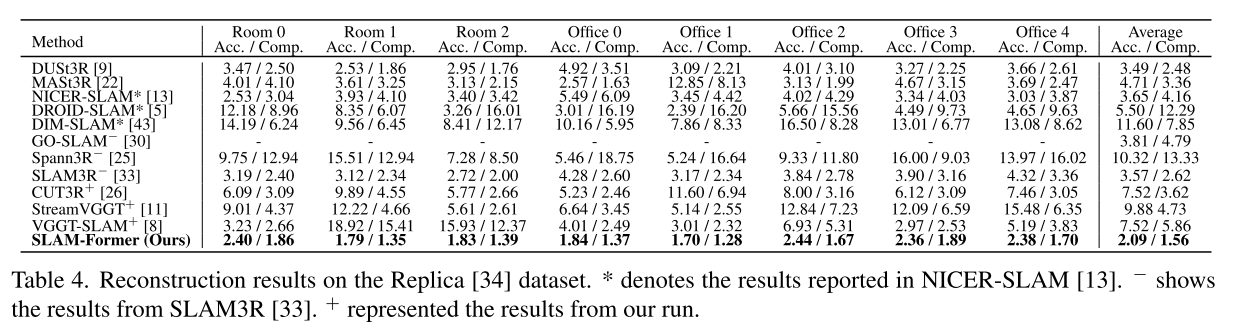

Replica Reconstruction。表格4中列出了数据集上的密集重建结果。我们的方法在所有基线上的准确率和完备率都达到了最好。具体地说,我们的2.09/1.56 ACC/Comp.在这两个指标上,分别显示出至少1厘米的差距。

我们还演示了图4第三行的重建。在这里,StreamVGGT显示了房间中的多层表面,如红色窗口区域中突出显示的那样。更严重的是,VGGT-SLAM显示的层数具有显著的尺度差异。而SLAM-FORM则与基本事实非常吻合。基线的点云密度较低是由于层的不匹配造成的,因为测试抽取了恒定数量的点进行评估。

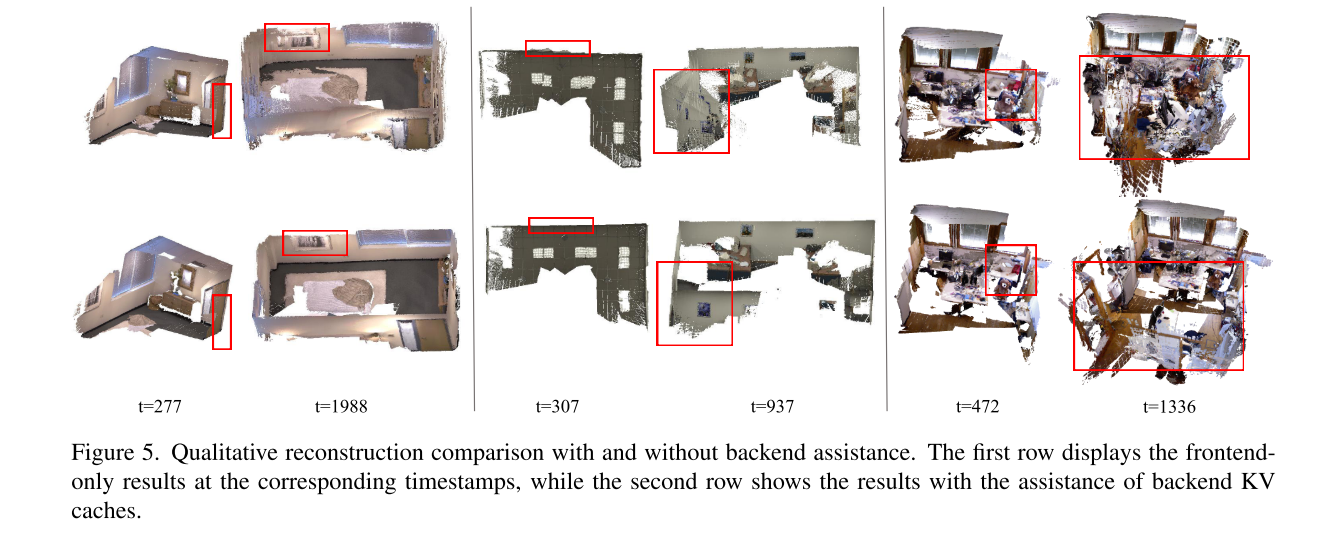

前后端协同工作

为了研究SLAM-Former的后端设计如何以类似SLAM的方式对整体系统性能做出贡献,我们进行了一系列烧蚀实验。结果汇总在表格6,这里,F、MB和EB。分别表示我们的体系结构的前端、中后端和后端组件。所有评估都是在TUM RGB-D基准上进行的,使用ATE的RMSE作为衡量标准。结果表明,与单独使用前端相比,包含后端模块可以显著提高准确率,证实了我们提出的前端-后端设计的有效性。后台如何辅助前端?此外,虽然甲基溴的个别贡献。还有EB。在ATE和甲基溴的综合使用方面似乎具有可比性。还有EB。总体指标没有明显改善,但需要强调的是MB。在最终EAT捕获的内容之外起着至关重要的作用。我们展示了数据集中一些最具挑战性的序列的中间结果,包括Replicaroom1、ICLNUIM[44]-ofkt1和TUM-Room,所有这些序列如图5所示,从内到外捕捉室内环境。最初,只有前端的结果中的误差相对较小,如红色窗口突出显示的那样。然而,随着时间的推移,仅限前端的重建变得严重扭曲。这种失真的产生是因为前端只会随着时间的推移积累误差,从而导致后期的大量不准确。相比之下,我们的模型结合了一个后端,在整个过程中保持了一致性,有效地缓解了这些问题。

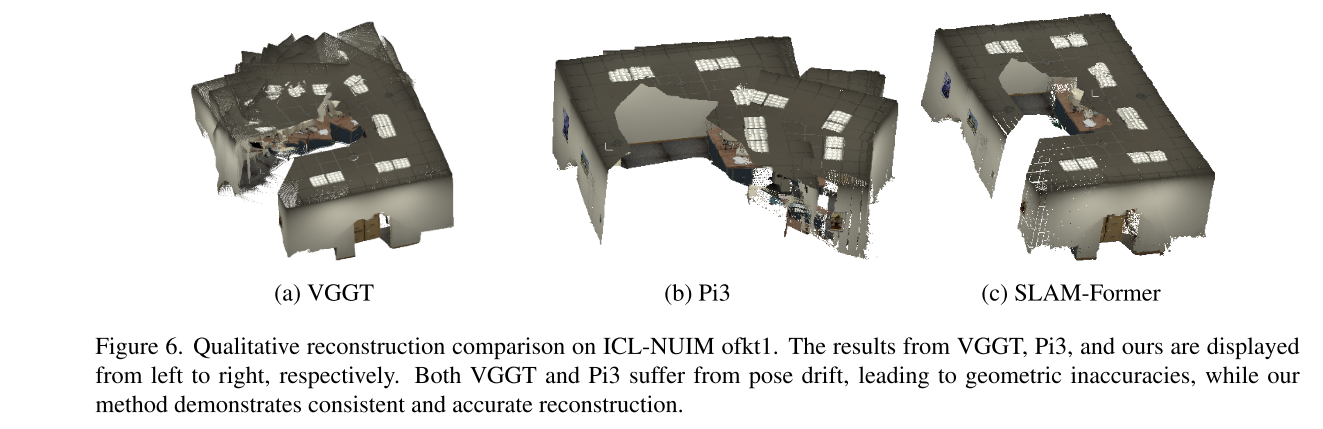

后端如何从前台获益?上述测试表明,前端可以受益于后端,从而实现长期一致的性能。然而,后端如何从前端获益呢?这是否等同于通过一次VGGT或PI3简单地运行所有关键帧图像?为了回答这个问题,我们使用ICL-NUIM场景ofkt0序列进行了演示。如图6所示,当所有关键帧图像都作为输入时,左边两幅图像显示了VGGT和PI3的结果,没有任何顺序信息。右图显示了我们的结果。很明显,如果没有我们前端提供的顺序信息,VGGT和PI3就会产生无序的重建。相比之下,我们的后端利用前端提供的隐含顺序来实现更连贯、更准确的重构。

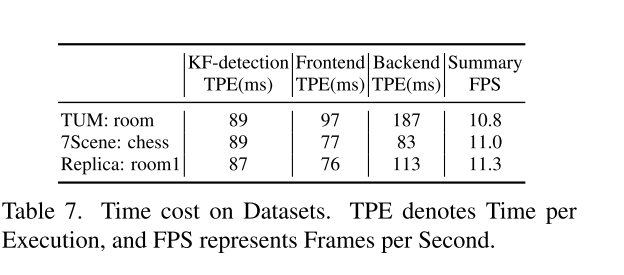

我们还记录了该方法的时间成本,如选项卡所示。7.给出了模块在不同数据集上的执行时间。KF检测和前端平均运行时间不到100ms,而后端虽然速度较慢,但执行频率较低。请注意,总体速度大于10赫兹,这表明我们的方法是实时运行的。

总结

在这项工作中,我们引入了SLAM-Former,将全部SLAM能力放入单个变压器中。SLAM-FORFER通过交替增量前端处理和全局后端处理,使前端和后端相互协作、相互增强,从而实现整体提升。结果表明,SLAM-Former在跟踪和重建方面都明显优于传统的基于几何基础的SLAM方法。此外,在使用真实数据进行测试时,与传统方法相比,该方法获得了极具竞争力的跟踪性能和极大的优势。限制-SLAM-Former仍然有几个局限性。首先,我们利用后台的全神贯注来取代传统SLAM中的环路检测和优化。然而,由于O(N2)时间复杂性,使用全注意力会导致问题。我们相信,在未来的工作中,可以通过SLAM方法(使用稀疏图)或通过转换技术(如稀疏关注和标记合并)来解决这一问题。其次,SLAM-Former在本地不支持前端模式;在推理过程中,所有以前的KV缓存都应该被反馈到模型中。

好吧想尝试但是没有这么多显卡