本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

面试资料较长,建议点赞收藏,以免遗失。如果对你有所帮助,记得告诉身边有需要的朋友。

1. 什么是Prompt(提示词)?在AI大模型语境下,它的核心作用是什么?

答案: Prompt是用户提供给大语言模型(LLM)的输入文本或指令,用于引导和激发模型生成符合期望的输出。它的核心作用是与模型进行通信,将用户的意图、上下文、约束和任务格式清晰地传递给模型,从而"提示"模型产生高质量、相关且有用的回应。可以将其理解为模型的"编程接口"或"操作指令"。

2. 解释一下"Zero-Shot", "Few-Shot" 和 "Chain-of-Thought (CoT)" Prompting的区别。

答案:

****** Zero-Shot Prompting(零样本提示):** 直接给模型一个任务指令,不提供任何完成任务的具体示例。完全依赖模型的内化知识和对指令的理解能力。****

示例:Prompt -> "将以下英文翻译成中文: 'Hello, world!'"

****** Few-Shot Prompting(少样本提示):* 在指令中提供几个输入-输出的示例(通常1-5个),让模型通过类比来学习并完成新任务。这有助于教会模型复杂或特定格式的任务。 *****

示例:Prompt -> "请将情感分类为正面或负面。

示例1: 电影太精彩了! -> 正面。

示例2: 我等得无聊死了。 -> 负面。现在请分类:服务非常周到。"

****** Chain-of-Thought (CoT) Prompting(思维链提示): 在Few-Shot示例中,不仅展示答案,还展示得出答案的推理步骤和逻辑过程。这尤其能提升模型在复杂推理(如数学、逻辑)问题上的表现。 ******

示例:Prompt -> "Q: 一个食堂有23个苹果,用了20个做午餐,又买了6个,还有几个?

A: 最初有23个,用了20个,所以剩下 23-20=3个。又买了6个,所以现在有 3+6=9个。所以答案是9。

Q: 房间里有10个人,走了4人,又来了5人,现在有几人?"

3. 什么是"指令微调"(Instruction Tuning)?它如何影响我们设计Prompt的方式?

答案: 指令微调是在预训练之后,使用大量(指令,期望输出)配对数据对模型进行进一步训练的过程。它的目的是让模型更好地理解和遵循人类指令。

影响: 经过指令微调的模型(如ChatGPT、Claude)对Zero-Shot Prompting的能力极大增强。我们不再总是需要提供复杂的Few-Shot示例,模型就能很好地理解并执行"总结这篇文章"、"用Python写一个函数"等直接指令。这使得Prompt设计更倾向于清晰、明确的自然语言指令。

4. 设计一个高效Prompt的关键原则有哪些?请列举并简要说明。

答案:

- 清晰明确(Clarity): 指令必须无歧义,明确任务目标。避免使用模棱两可的词汇。

- 提供上下文(Context): 给予模型完成任务所需的背景信息,减少其"臆测"。

- 设定角色(Role Playing): 让模型扮演一个特定角色(如"你是一位资深机器学习工程师"),可以使其输出更专业、更符合特定视角。

- 分解任务(Task Decomposition): 对于复杂任务,将其拆解成多个简单的子步骤,并通过一系列Prompt或让模型"一步步思考"来完成。

- 指定格式(Output Formatting): 明确指定输出的格式,如JSON、XML、Markdown、纯文本、列表等。

- 使用负面提示(Negative Prompting): 明确指出不希望出现的内容,如"避免使用技术 jargon"、"不要列清单"。

5. 请优化以下Prompt:"写点关于人工智能的东西。"

原始Prompt分析: 过于模糊、宽泛,没有指定主题、长度、风格、受众或格式。

优化后Prompt示例:

"你是一位科技专栏作家,请为一位对AI技术感兴趣但非专业的大学生读者,写一篇关于大型语言模型(如GPT-4)如何工作的简短科普文章(约500字)。文章应通俗易懂,包含一个简单的比喻来解释核心概念,并以Markdown格式输出,包含标题和段落。"

优化点:

- 设定角色: 科技专栏作家。

- 明确主题: 大型语言模型的工作原理。

- 定义受众: 非专业的大学生。

- 指定长度: 约500字。

- 增加约束: 包含一个比喻。

- 指定格式: Markdown。

6. 什么情况下应该使用Few-Shot而不是Zero-Shot?请举例说明。

答案: 在以下情况下应优先使用Few-Shot:

任务格式非常特殊: 需要模型输出特定结构的数据,如JSON。

示例:将"姓名:张三,年龄:30,城市:北京"转换为JSON。提供示例:输入: 姓名:李四,年龄:25,城市:上海 -> 输出: {"name": "李四", "age": 25, "city": "Shanghai"}

任务定义模糊,难以用指令描述: 比如"写出有创意的产品标语",提供几个"输入产品描述 - 输出标语"的示例比单纯指令更有效。

需要模仿特定风格或语调: 提供几个风格一致的示例,让模型模仿。

模型在Zero-Shot下表现不佳时: 作为提升模型表现的实用技巧。

7. 如何通过Prompt来控制生成文本的"创造性"和"确定性"?

答案: 虽然通常通过API参数(如OpenAI的 temperature和 top_p)来控制,但Prompt本身也能起到重要作用。

- 鼓励创造性: 使用如"发挥你的想象力"、"提出一些新颖的想法"、"列出一些可能但非主流的观点"等指令。

- 鼓励确定性/事实性: 使用如"基于以下已知信息"、"根据事实回答"、"如果你不确定,请说不知道"、"一步步推理,确保答案准确"等指令。结合检索增强生成(RAG) 技术提供事实依据是最佳实践。

8. 解释什么是"思维链"(Chain-of-Thought, CoT)Prompting,并说明它为什么有效。

答案: CoT Prompting是一种通过提示模型模拟人类逐步推理过程来解决问题的方法。它在Prompt中展示推理的中间步骤,而不仅仅是最终答案。

有效性原因:

- 对齐推理过程: 将复杂的多步问题分解,使模型的内部计算过程更接近问题本身的逻辑结构。

- 减少"一步到位"的错误: 很多问题无法直接得出答案,CoT迫使模型进行中间计算,避免了跳跃性思维导致的错误。

- 可解释性: 模型的推理过程变得可见,便于开发者调试和验证答案的正确性。

9. 什么是"自洽性"(Self-Consistency)?它如何与CoT结合使用?

答案: 自洽性是一种对CoT的改进技术。它不再只生成一条推理链,而是让模型生成多条不同的推理路径(即多种"思路") ,然后通过投票的方式从这些推理链产生的多个答案中选择一个最一致的答案。

结合方式:

- 使用CoT Prompt让模型对同一个问题生成K次输出(每次输出都是一条完整的推理链+答案)。

- 从这K个输出中提取出最终的答案。

- 选择出现频率最高的答案作为最终结果。

- 优点: 这种方法可以抵消CoT过程中可能出现的随机错误,显著提高复杂推理任务的准确性。

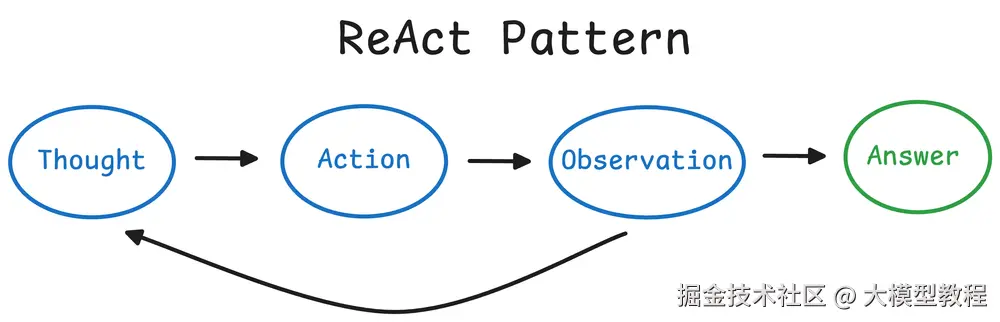

10. 请解释"ReAct"(Reason+Act)模式的概念及其组成部分。

答案: ReAct是一个将推理(Reasoning) 和行动(Action) 相结合的Prompting框架,用于构建智能代理(Agent)。

组成部分:

- Thought(思考): 模型分析当前情况,推理下一步该做什么。这是模型的"内心独白"。

- Action(行动): 模型根据思考,决定执行一个具体动作(如使用搜索工具、查询API、执行代码)。

- Observation(观察): 模型接收来自工具或环境的行为结果(如搜索返回的信息)。

这个"思考->行动->观察"的循环会持续进行,直到模型得出最终答案。ReAct模式极大地增强了模型与外部世界互动和获取实时信息的能力。

11. 如果一个模型的输出不符合预期,你的调试思路和排查步骤是什么?

答案: 我会遵循以下步骤:

- 检查Prompt本身: 指令是否清晰?上下文是否充足?格式要求是否明确?是否存在歧义?这是最常见的问题源。

- 简化问题(简化Prompt): 尝试一个更简单、更核心的Prompt,看模型是否能正确响应。以此判断是基础能力问题还是复杂Prompt设计问题。

- 提供示例(Few-Shot): 如果Zero-Shot不行,尝试提供1-2个完美示例,看模型能否通过模仿来正确输出。

- 分步执行(Task Decomposition): 将复杂任务拆解,一步步问模型,看哪一步出了错。

- 检查模型参数: 确认

temperature(创造性)等参数设置是否合理。对于确定性任务,应设置为0或较低值。 - 外部验证: 模型输出的事实是否正确?是否需要通过RAG为其提供可靠的知识来源,而不是依赖其内部可能过时或错误的知识?

- 迭代优化: 基于以上发现,逐步修改和优化Prompt,并进行A/B测试。

12. 在构建一个基于RAG(检索增强生成)的问答系统时,Prompt应该如何设计?

答案: RAG系统中的Prompt核心在于让模型基于检索到的上下文回答问题,而非依赖自身知识。

关键Prompt设计模板:

"请严格根据以下提供的【上下文】来回答问题。如果上下文中的信息不足以回答问题,请直接回答'根据已知信息无法回答该问题'。

【上下文】:

{retrieved_context}

【问题】:

{user_question}

【回答】:"

设计要点:

- 强指令: "严格根据..." 强调答案来源的约束。

- 处理未知情况: 明确指导模型在信息不足时如何回应,避免幻觉。

- 清晰的结构: 将上下文、问题、回答指令分块,帮助模型理解不同部分的用途。

13. 如何设计Prompt来实现"文本摘要"的功能?并针对"新闻摘要"和"会议纪要生成"两个场景给出差异化的设计思路。

答案:

通用摘要Prompt结构: "请为以下文本生成一个摘要:[插入文本]"

差异化设计:

新闻摘要:

重点: 提取关键事件、时间、地点、人物、结果(5W1H)。

风格:客观、简洁、信息密度高。

示例Prompt: "你是一名新闻编辑,请用一句话概括以下新闻的核心事件,并再用100字补充关键细节。确保包含主要人物和结果。"

会议纪要生成:

重点: 识别讨论主题、达成的共识、待办事项(Action Items)、负责人和截止日期。

风格: 结构化、注重行动项。

示例Prompt: "你是一名会议秘书,请根据以下会议转录文本,生成结构化的纪要。必须包含以下部分:

- 会议主题

- 主要讨论点(列表)

- 决议与共识

- 行动项(清晰标注负责人和截止日期)。请使用Markdown格式。"

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。