论文阅读 | TCSVT 2024 | CCAFusion: 用于红外与可见光图像融合的跨模态坐标注意力网络

题目:CCAFusion: Cross-Modal Coordinate Attention

Network for Infrared and Visible Image Fusion

期刊:TCSVT(IEEE Transactions on Circuits and Systems for Video Technology)

论文:paper

代码:未开源

年份:2024

1&&2. 摘要&&引言

红外与可见光图像融合旨在生成包含全面信息的单一图像。它可以保持丰富的纹理特征和热信息。然而,对于现有的图像融合方法,融合图像要么牺牲了热目标的显著性和纹理的丰富性,要么引入了像伪影这样的无用信息干扰。

为了缓解这些问题,本文提出了一种有效的用于红外与可见光图像融合的跨模态坐标注意力网络,称为CCAFusion。

为了充分整合互补特征,设计了基于坐标注意力的跨模态图像融合策略 ,该策略由特征感知融合模块 (FAF )和特征增强融合模块 (FEF)组成。此外,采用了一个基于多尺度跳跃连接的网络来获取红外和可见光图像中的多尺度特征,这可以充分利用融合过程中的多层级信息。

为了减少融合图像与输入图像之间的差异,开发了一个包含基础损失和辅助损失的多约束损失函数,以调整灰度分布并确保融合图像中结构与强度的和谐共存,从而防止像伪影这样的无用信息污染。

本文的主要贡献如下:

- 提出了一种新颖的用于红外和可见光图像融合的跨模态坐标注意力网络(CCAFusion),在该任务上实现了卓越的性能。此外,在显著目标检测上的扩展应用表明CCAFusion可以促进后续高级视觉任务的检测性能。

- 我们设计了一个简单而有效的跨模态图像融合策略,包括特征感知融合模块 (FAF )和特征增强融合模块 (FEF)。FAF旨在基于单模态注意力权重整合互补特征。FEF用于通过跨模态注意力权重增强互补特征。在融合模块上的消融实验评估了我们融合策略的有效性,并表明FAF和FEF协同工作使我们的融合网络能够保留丰富信息。

- 我们为图像融合开发了一个多约束损失函数。具体来说,本文提出了一个新的基础损失,通过KL散度施加融合图像与源图像之间相似的灰度分布,保留基础信息。此外,辅助损失可以保持细节信息和热辐射信息。通过开发的损失函数训练的CCAFusion可以合理调整灰度分布并确保结构与强度的和谐共存,从而防止伪影污染。在损失函数上的消融实验证明了每个损失项的有效性和多样化贡献。

3.方法

在本节中,首先讨论方法的动机。然后介绍CCAFusion的整体架构,并详细说明跨模态坐标注意力融合策略。接着,我们给出设计的多约束损失函数的细节。最后,阐述了CCAFusion用于RGB-红外图像融合的具体框架。

A. 动机

红外与可见光图像融合旨在获得包含全面信息的单一图像,该图像保留可见光图像中丰富的纹理特征和红外图像中的热信息。然而,红外和可见光图像是由具有不同成像机制的不同传感器生成的,导致源图像之间存在域差异。域差异是红外和可见光图像融合任务的一个巨大挑战,因为很难平衡源图像之间重要特征的差异。

当来自源图像的结构和强度不能和谐共存时,许多伪影往往出现在融合图像的高对比度边缘区域。此外,由于融合过程中有限的特征表示和重要信息丢失,现有红外和可见光图像融合方法的融合结果也容易受到不良伪影的影响,这不可避免地影响最终性能。考虑到上述限制,我们提出了一种新颖的红外和可见光图像融合网络,旨在实现充分的信息保存、强大的特征表示以及重要特征的和谐共存,从而避免在融合图像中引入不良伪影。

B. 概述

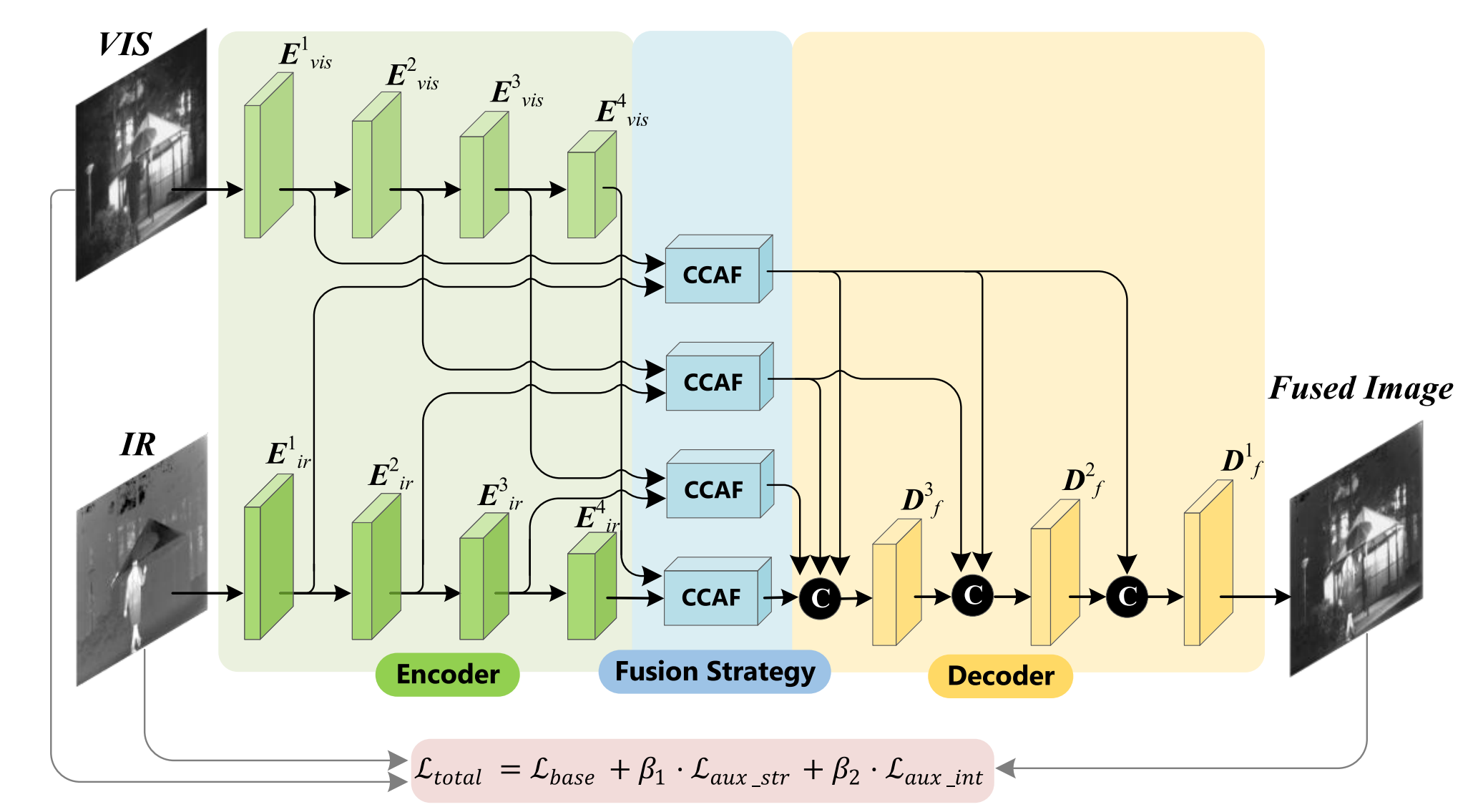

提出的网络遵循双流模型,包括四个编码器块 ( E j i i ∈ { 1 , 2 , 3 , 4 } , j ∈ { i r , v i s } ) (E_{j}^{i} i\in\{1,2,3,4\}, j\in\{i r, v i s\}) (Ejii∈{1,2,3,4},j∈{ir,vis})、四个融合块和三个解码器块 ( D f i i ∈ { 1 , 2 , 3 } ) (D_{f}^{i} i\in\{1,2,3\}) (Dfii∈{1,2,3})。

图2展示了提出的网络整体框架。具体来说,红外图像和可见光图像首先分别输入双流特征提取网络。每个流的主干是一个基于多尺度跳跃连接架构[50]的编码器-解码器网络,如图3所示。编码器块旨在提取每个层级的深度特征。然后,我们将编码器块的输出传递到跨模态坐标注意力融合块(CCAF),从而在每个层级实现跨模态融合。随后,这些跨模态融合特征被输入到基于跳跃连接架构的解码器块中,最终融合图像从高级信息逐步重建到低级信息。

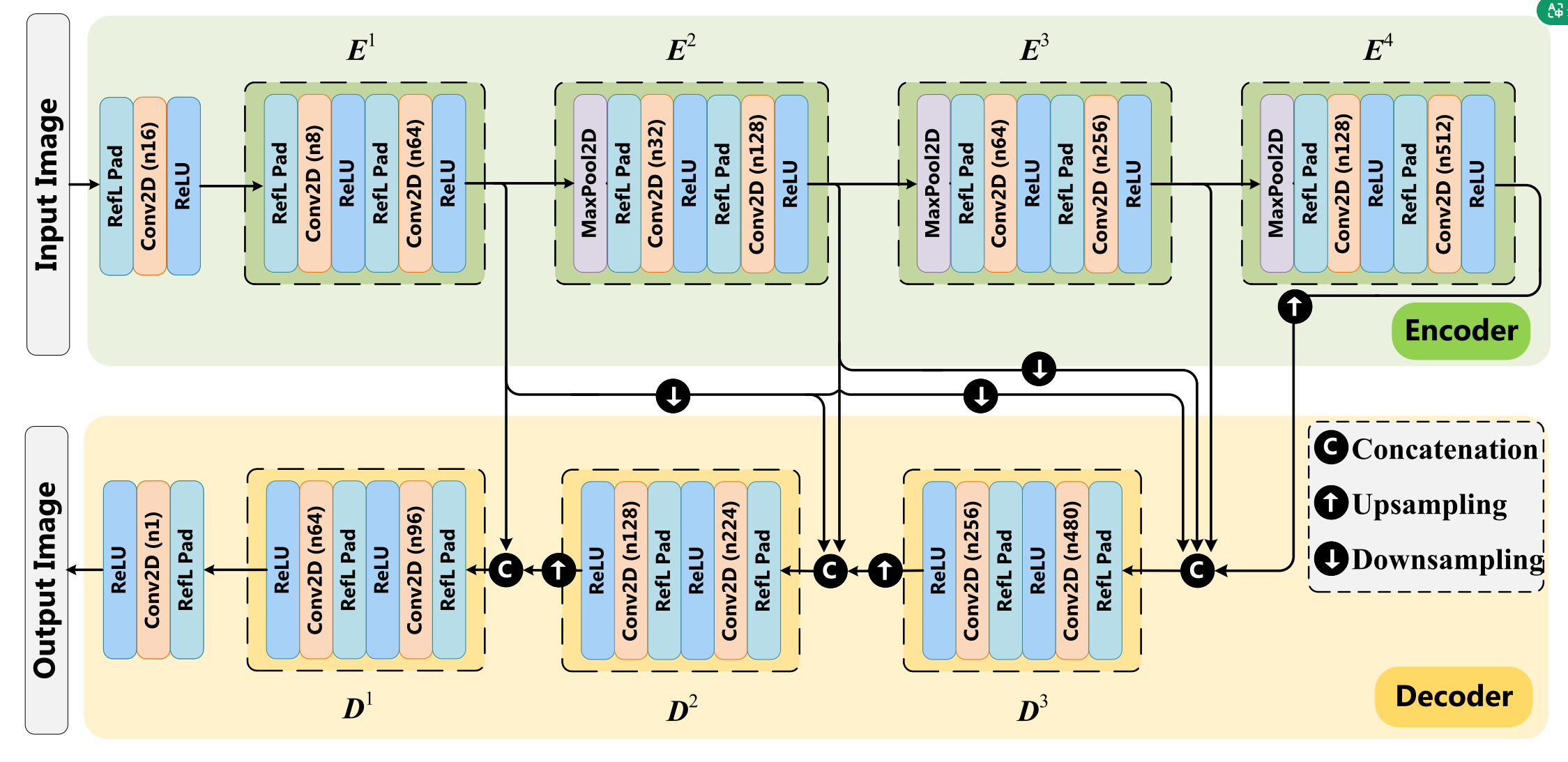

编码器-解码器网络的详细架构如下。该网络受Densefuse[21]启发。与通过基于密集连接的网络获得重建图像的Densefuse架构不同,我们采用基于多尺度跳跃连接的编码器-解码器网络[50]来充分利用红外和可见光图像中的多尺度特征,如图3所示。每个流中的编码器由四个块组成,每个块包含两个Padding层、两个卷积层和两个ReLU层。第一个和第二个卷积层的核大小分别为3x3和1x1。通过多尺度跳跃连接架构和拼接操作整合不同尺度提取的特征。结果随后被输入到三个解码器块中。与编码器部分类似,解码器的每个块包含两个Padding层、两个卷积层和两个ReLU层。卷积层的通道数在图3中报告。通过将通道数减少到一来生成输出图像。

C. 融合策略

可见光图像包含丰富的纹理特征。红外图像呈现热辐射特征。在复杂环境(如背景杂乱、遮挡和光线变化)中,这两种特征是互补的。考虑到不同的空间信息和通道起着不同的作用,在整合这些互补特征时,我们应关注有用信息。因此,一种新颖的注意力机制被引入融合策略以区分特征的重要性。

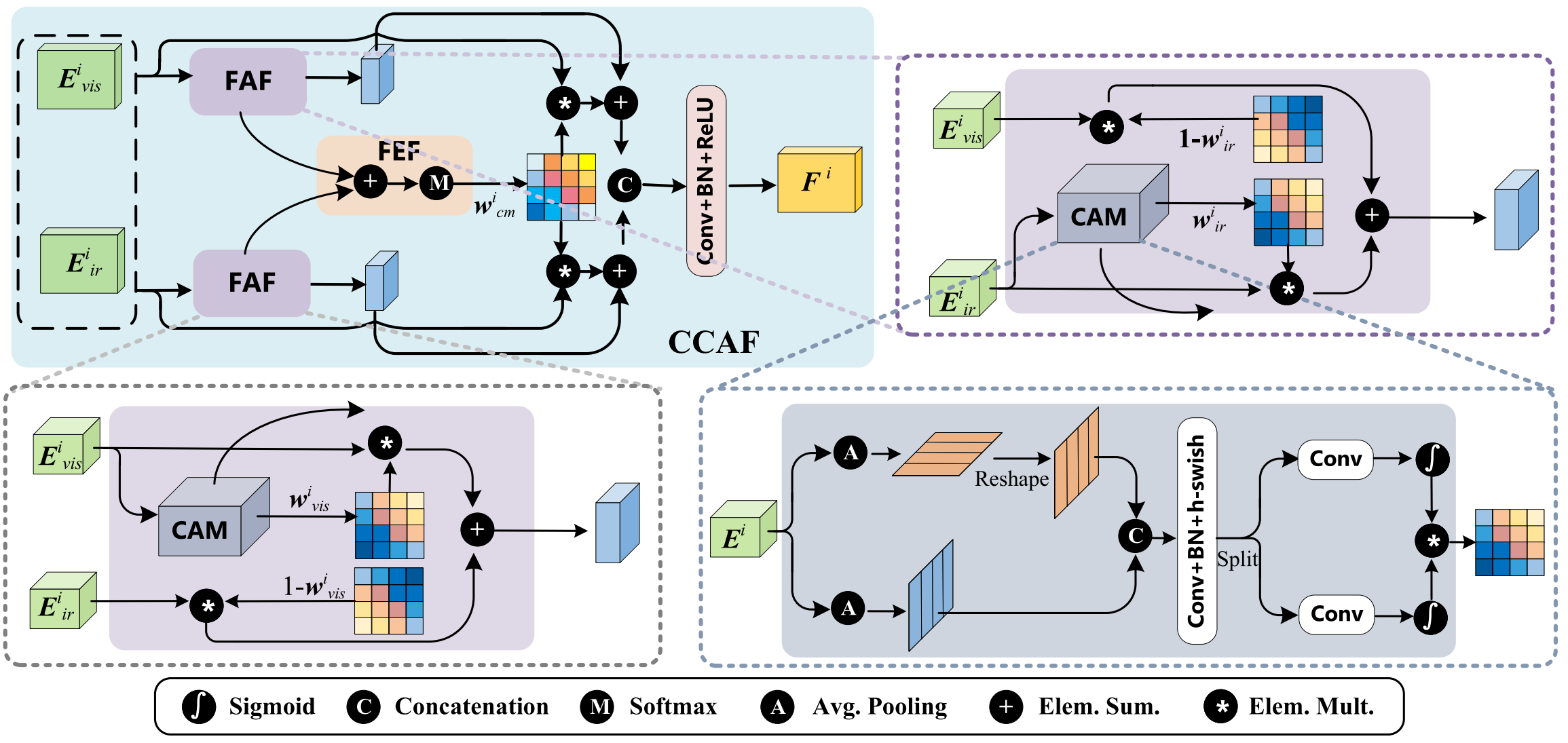

注意力机制已被广泛研究并应用于多个领域,它可以指导模型更多地关注重要内容[51],[52]。最著名和广泛使用的方法是挤压激励(SE)注意力[53]。然而,SE模块仅考虑通道间信息,忽略了位置信息的重要性。CBAM同时考虑了通道信息和位置信息,并在[25]中被用于图像融合。然而,这种注意力机制缺乏长程依赖性。我们的融合策略基于坐标注意力[28]开发,它可以同时捕获通道和位置重要性以及长程依赖性。图4显示了我们跨模态融合策略的具体结构,它包括两个关键部分:特征感知融合模块 (FAF)和特征增强融合模块 (FEF)。

我们使用FAF来整合互补特征,包括可见光图像中的纹理特征和红外图像中的热辐射特征。首先,可见光流生成的第i个特征 E v i s i E^{i}{vis} Evisi 和红外流生成的第i个特征 E i r i E^{i}{ir} Eiri 被输入到CCAF。我们采用坐标注意力模块(CAM)来获取权重 w v i s i w^{i}{vis} wvisi 和 w i r i w^{i}{ir} wiri,分别反映可见光和红外特征的重要性。CAM的具体实现如图4右下部分所示。给定大小为 C × H × W C\times H\times W C×H×W 的第i个输入特征 E i E^{i} Ei,我们采用池化核(H,1)和(1,W)分别沿水平坐标和垂直坐标编码不同通道的信息。高度h处第c个通道的过程定义如下:

z c h ( h ) = 1 W ∑ 0 ≤ i < W x c ( h , i ) z_c^h(h) = \frac{1}{W} \sum_{0 \leq i < W} x_c(h, i) zch(h)=W10≤i<W∑xc(h,i)

类似地,宽度w处第c个通道的过程定义如下:

z c w ( w ) = 1 H ∑ 0 ≤ j < H x c ( j , w ) z_c^w(w) = \frac{1}{H} \sum_{0 \leq j < H} x_c(j, w) zcw(w)=H10≤j<H∑xc(j,w)

上述两个过程产生了一对沿两个空间方向的方向感知特征图。这允许注意力块沿一个空间方向捕获长程依赖性,并沿另一个空间方向保留精确的位置信息,从而帮助网络准确定位感兴趣对象的位置。CAM的直观效果在第四节F.3中详述。

为了产生聚合的特征映射,我们将重塑后的 z c h ( h ) z_c^h(h) zch(h) 和 z c w ( w ) z_c^w(w) zcw(w) 拼接起来,并通过 1 × 1 1\times 1 1×1 卷积操作将通道数减少到 C / r C/r C/r。r是减少率,设置为32[28]。公式如下:

f = δ ( F 1 ( [ z h , z w ] ) ) f = \delta(F_1([z^h, z^w])) f=δ(F1([zh,zw]))

其中 [ ⋅ , ⋅ ] [\cdot,\cdot] [⋅,⋅] 是拼接操作。 F 1 F_{1} F1 表示 1 × 1 1\times 1 1×1 卷积变换函数。 δ \delta δ 是h-swish激活函数[54]。输出特征映射 f ∈ R C / r × ( H + W ) f\in R^{C/ r\times(H+W)} f∈RC/r×(H+W) 然后被分解为单独的张量 f h ∈ R C / r × H f^{h}\in R^{C/ r\times H} fh∈RC/r×H 和 f w ∈ R C / r × W f^{w}\in R^{C/ r\times W} fw∈RC/r×W。为了将通道数恢复到C,我们使用两个 1 × 1 1\times 1 1×1 卷积变换函数 F 1 h F_{1}^{h} F1h 和 F 1 w F_{1}^{w} F1w。权重矩阵 w i w^i wi 是 F 1 h F_1^h F1h 和 F 1 w F_1^w F1w 的相乘输出,可以写为:

w i = σ ( F 1 h ( f h ) ) ⋅ σ ( F 1 w ( f w ) ) w^i = \sigma(F_1^h(f^h)) \cdot \sigma(F_1^w(f^w)) wi=σ(F1h(fh))⋅σ(F1w(fw))

其中 σ \sigma σ 是sigmoid函数。我们可以通过将 E v i s i E_{v i s}^{i} Evisi 和 E i r i E_{i r}^{i} Eiri 输入CAM来获得权重矩阵 w v i s i w_{v i s}^{i} wvisi 和 w i r i w_{i r}^{i} wiri。然后,这两个权重矩阵与输入特征相乘,以关注重要特征并抑制融合任务中不必要的特征,描述为:

F j i = w j i ⊙ E j i , j ∈ { i r , v i s } F_{j}^{i} = w_{j}^{i} \odot E_{j}^{i}, \quad j \in \{ir, vis\} Fji=wji⊙Eji,j∈{ir,vis}

F i r i F_{i r}^{i} Firi 和 F v i s i F_{v i s}^{i} Fvisi 是FAF的结果。此外,一些纹理特征也反映在红外图像中,一些热辐射特征也反映在可见光图像中。

因此,应用FEF来增强这些互补特征。我们首先聚合权重矩阵 w v i s i w_{v i s}^{i} wvisi 和 w i r i w_{i r}^{i} wiri。聚合结果然后输入softmax函数,得到跨模态权重矩阵 w c m i w_{c m}^{i} wcmi,表示为:

w c m i = Softmax ( w v i s i + w i r i ) w_{c m}^{i} = \text{Softmax}(w_{vis}^i + w_{ir}^i) wcmi=Softmax(wvisi+wiri)

基于跨模态权重矩阵 w c m i w_{c m}^{i} wcmi,通过将FAF结果和FEF结果相加获得增强特征 F I R i F_{I R}^{i} FIRi 和 F V I S i F_{V I S}^{i} FVISi,表示为:

F I R i = F i r i + w c m i ⊙ F v i s i F_{IR}^{i} = F_{ir}^{i} + w_{cm}^{i} \odot F_{vis}^{i} FIRi=Firi+wcmi⊙Fvisi

F V I S i = F v i s i + w c m i ⊙ F i r i F_{VIS}^{i} = F_{vis}^{i} + w_{cm}^{i} \odot F_{ir}^{i} FVISi=Fvisi+wcmi⊙Firi

可见光分支和红外分支生成的增强特征进一步拼接并输入卷积层,以获得跨模态融合特征 F i F^{i} Fi。公式如下:

F i = Conv ( [ F I R i , F V I S i ] ) F^{i} = \text{Conv}([F_{IR}^{i}, F_{VIS}^{i}]) Fi=Conv([FIRi,FVISi])

D. 损失函数

针对图像融合中缺乏理想真实数据的问题,我们设计了CCAFusion的损失函数,该函数包含两个部分:基础损失和辅助损失。

一方面,我们认为融合图像与源图像中感兴趣对象的灰度分布应该相似。灰度分布和Kullback-Leibler(KL)散度用于设计基础损失 L base \mathcal{L}{\text{base}} Lbase,其公式为:

L base = K L ( S ( p f ) , S ( q i r ) ) + K L ( S ( p f ) , S ( q v i s ) ) \mathcal{L}{\text{base}} = KL(S(p_f), S(q_{ir})) + KL(S(p_f), S(q_{vis})) Lbase=KL(S(pf),S(qir))+KL(S(pf),S(qvis))

其中 q i r q_{i r} qir 和 q v i s q_{v i s} qvis 分别表示红外图像和可见光图像的灰度分布。 p f p_{f} pf 代表融合图像的灰度分布。 S ( ⋅ ) S(\cdot) S(⋅) 表示softmax函数,用于重新缩放元素。应用KL散度是为了施加融合图像与源图像之间相似的灰度分布,以保持源图像中的基础信息。

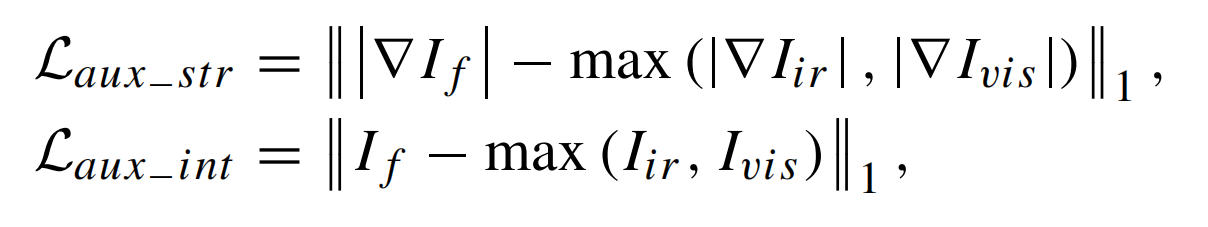

另一方面,我们认为融合图像中的细节信息和热辐射信息应得到充分保证。融合图像的细节可以通过梯度操作符保留,从而保持丰富的细节信息。逐元素最大选择表示融合图像的最佳强度分布,从而突出热辐射信息。

其中 I f , I i r I_{f}, I_{i r} If,Iir 和 I v i s I_{v i s} Ivis 分别是融合图像、红外图像和可见光图像。 ∇ \nabla ∇ 表示梯度操作符。

最后,CCAFusion的损失函数由两部分组成:基础损失和辅助损失。辅助损失进一步包括辅助结构损失和辅助强度损失。多约束总损失函数 L total \mathcal{L}_{\text{total}} Ltotal 表示为:

其中 β 1 \beta_1 β1 和 β 2 \beta_2 β2 是权重,用于在不同项之间取得平衡。关于 β 1 \beta_{1} β1 和 β 2 \beta_{2} β2 值的具体调整在第四节B.1中展示。

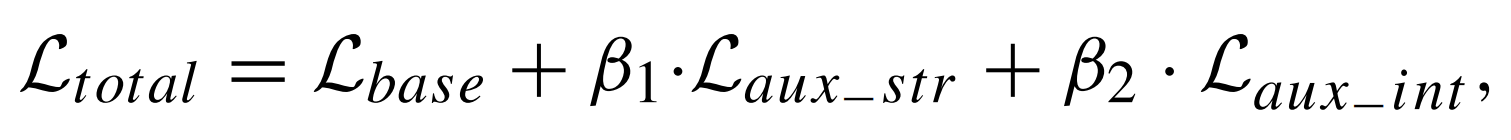

E. RGB-红外融合

在前面的内容中,所述的融合过程是针对灰度可见光和红外图像的。对于RGB和红外图像融合,我们可以首先将RGB图像转换到IHS颜色空间。I代表强度通道,H和S分别代表色调通道和饱和度通道。由于主要的空间信息分布在I通道中,我们可以使用CCAFusion来融合红外图像和由RGB图像生成的I通道。在与H和S通道结合后,通过转换回RGB颜色空间可以获得最终的融合图像。用于RGB和红外图像融合的相应架构如图5所示。

4. 实验与结果

在本节中,首先陈述实验设置,包括数据集、评估指标、对比方法和实现细节。然后我们提供消融实验来验证CCAFusion中每个组件的有效性,并将提出的网络与最先进的图像融合方法进行比较。此外,我们进行了泛化实验以证明其对显著目标检测的通用性,说明我们的CCAFusion对高级视觉任务的促进作用。

A. 实验设置

1) 数据集和评估指标: 我们在VTUAV数据集[55]上训练提出的网络,这是当前最新的公开可用的多模态可见光-热数据集。它包含跨越两个城市的15个场景,包括桥梁、海洋、道路、公园和街道。这些不同的场景覆盖了不同的天气,包括雾天、大风天和阴天。为了形成训练图像,我们从VTUAV数据集中随机选择10000对。应注意,这些训练图像被转换为灰度并调整为 256 × 256 256\times 256 256×256。

我们在两个公共数据集上测试提出网络的融合性能,包括从TNO[56]收集的21对灰度可见光和红外图像,以及从RoadScene[27]收集的61对RGB和红外图像。注意,TNO数据集是预注册的,包含几个多波段相机系统,并包含不同军事和监视场景的多光谱(即,增强可见光、近红外和长波红外或热)图像。RoadScene是一个基于FLIR视频[57]的RGB-红外对齐图像数据集,包含具有丰富场景的图像对,包括道路、车辆和行人。

为了全面评估融合质量,从定性评估和定量指标两方面评估融合图像。定性评估基于主观视觉感知。然而,主观视觉感知可能不可靠,因此我们还采用广泛使用的定量指标来评估不同方法的融合质量,包括互信息(MI)[58]、视觉信息保真度(VIF)[59]、空间频率(SF)[60]和熵(EN)[61]。MI可以衡量从输入图像传输到最终融合图像的信息量。MI值越高,融合图像包含的信息越多。VIF可以评估融合结果的保真度。VIF越大,与人类视觉感知的一致性越好。SF可以评估融合图像中纹理的丰富程度。SF越大表明纹理越丰富。EN可以评估融合结果中剩余的信息量。EN越大意味着融合结果中的信息越多。

2) 对比方法和实现细节: 为了验证CCAFusion的融合性能,将提出的网络与最先进的图像融合方法进行比较,包括传统图像融合方法和基于深度学习的图像融合方法。传统图像融合方法是MDLatLRR[62]。基于深度学习的图像融合方法包括DenseFuse[21]、SDNet[43]、PIAFusion[26]和U2Fusion[27]。对于对比方法,采用默认参数设置。

MDLatLRR的实验在MATLAB R2020b with an AMD R7-4800H 2.9GHz CPU上实现。DenseFuse、SDNet、PIAFusion和U2Fusion的实验基于TensorFlow with one Nvidia 2080Ti GPU。提出的网络在Pytorch中实现,并在 one Nvidia 2080Ti GPU上训练。我们选择Adam优化器,学习率为0.0001。批量大小为8,训练轮数(epoch)为10。训练过程大约需要9小时。

B. 消融研究

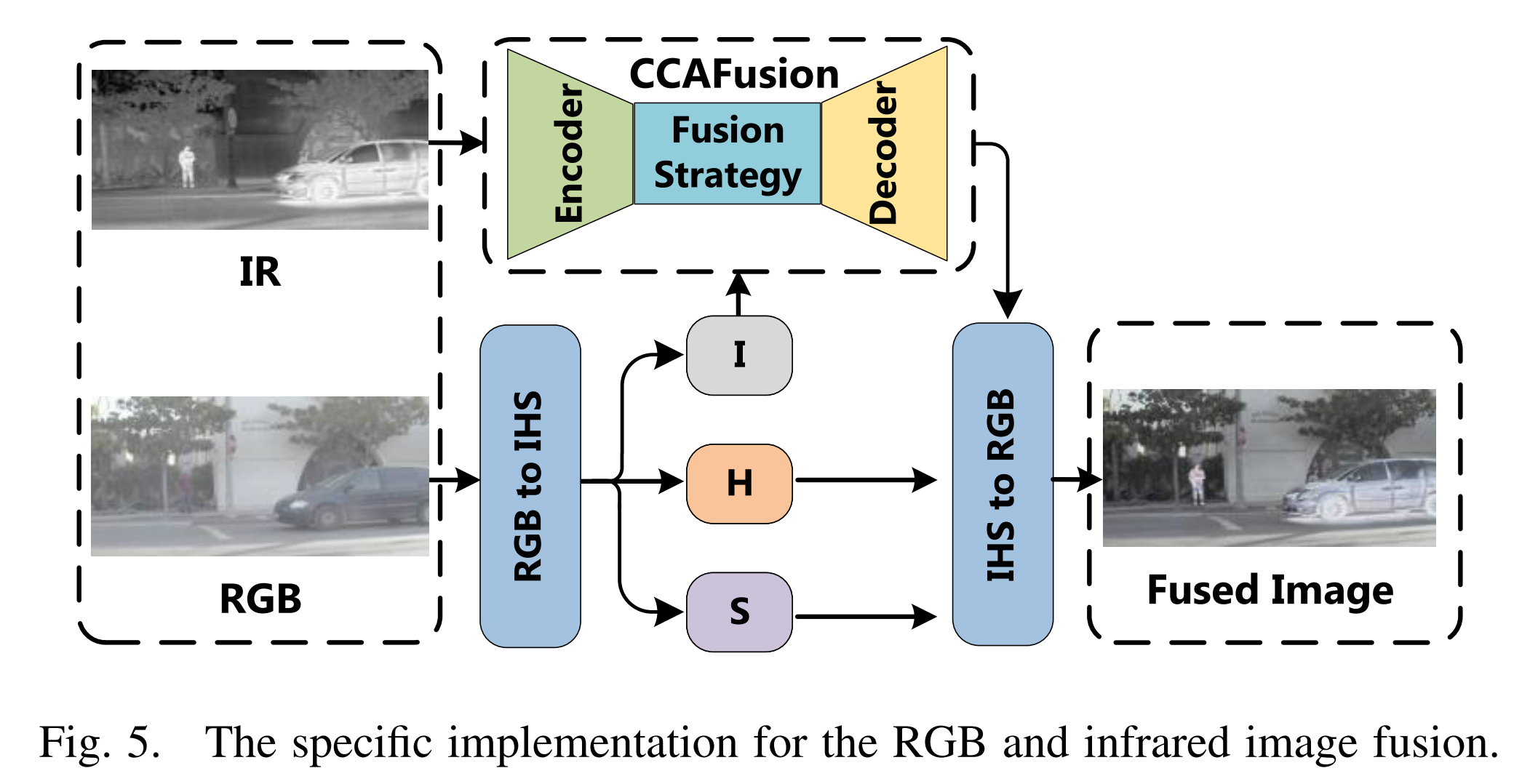

1) 超参数效果: 在我们的CCAFusion中,超参数 β 1 \beta_1 β1 和 β 2 \beta_2 β2 用于平衡总损失函数中不同项的重要性。 β 1 \beta_1 β1 用于平衡基础损失和辅助结构损失, β 2 \beta_2 β2 用于平衡基础损失和辅助强度损失。基础损失是主要约束,确保源图像中的基础信息可以保留在融合图像中。辅助结构损失和辅助强度损失是次要的,用于进一步确保融合图像中的纹理特征和热辐射信息。因此,我们将超参数 β 1 \beta_{1} β1 和 β 2 \beta_{2} β2 的范围设置为0到1以进行敏感性分析。我们首先固定 β 2 \beta_2 β2 的值并测试不同的 β 1 \beta_1 β1 来训练CCAFusion网络。然后我们固定 β 1 \beta_{1} β1 的值并测试不同的 β 2 \beta_{2} β2 来训练CCAFusion网络。大量实验表明,当 β 1 = 0.7 \beta_{1}=0.7 β1=0.7 和 β 2 = 0.7 \beta_{2}=0.7 β2=0.7 时,在四个评估指标上取得了最佳性能,如图6所示。

图 6. 多约束损失函数中超参数的影响。第一行:不同 β₁值下对互信息(MI)、视觉信息保真度(VIF)、熵(EN)和空间频率(SF)的评估结果。第二行:不同 β₂值下对互信息(MI)、视觉信息保真度(VIF)、熵(EN)和空间频率(SF)的评估结果。

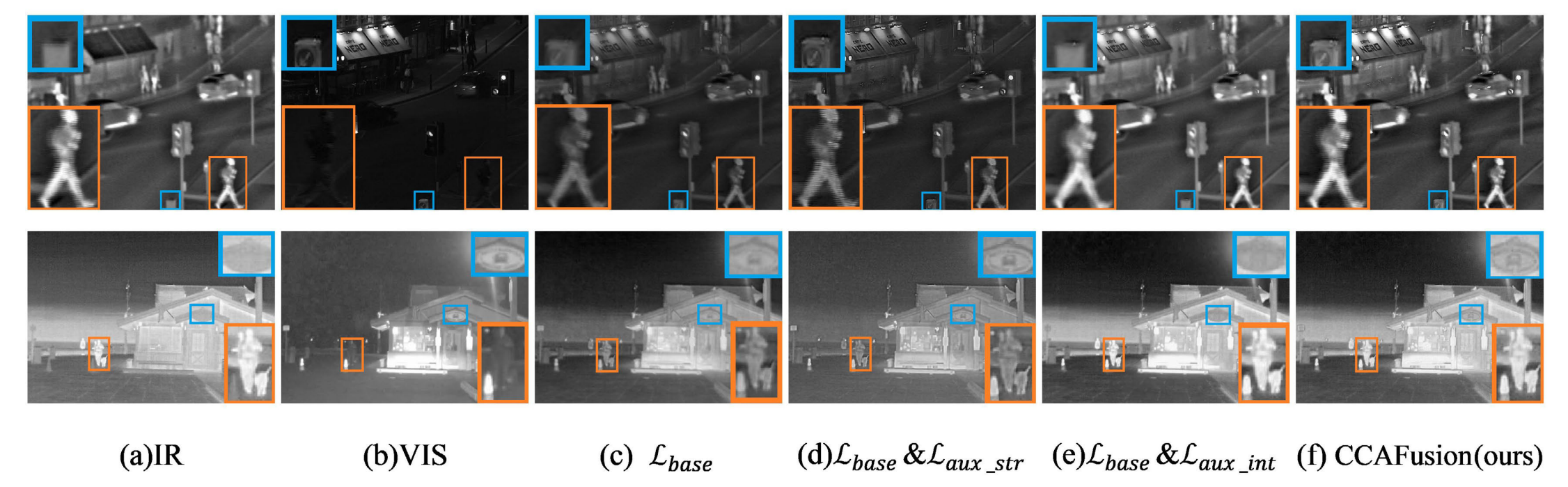

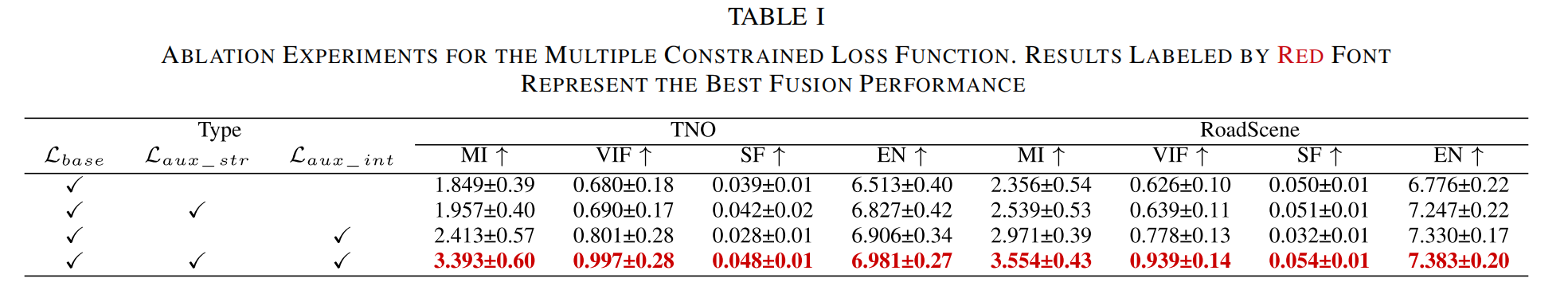

2) 损失函数效果: 为了证明所设计的多约束损失函数的有效性,我们对设计的损失函数的三个项进行了消融研究,包括基础损失 L b a s e \mathcal{L}{base} Lbase、辅助结构损失 L a u x _ s t r \mathcal{L}{aux\str} Laux_str 和辅助强度损失 L a u x _ i n t \mathcal{L}{aux\int} Laux_int。图7和表I显示了使用不同损失函数的融合结果。从这些融合结果中,我们可以观察到,当仅使用基础损失 L b a s e \mathcal{L}{base} Lbase 时,提出的网络只能确保主要的灰度分布,并且丢失了一些热信息和纹理特征(如图7©所示)。使用基础损失 L base \mathcal{L}{\text{base}} Lbase 和辅助结构损失 L aux_str \mathcal{L}{\text{aux\str}} Laux_str,虽然源图像中的细节被传输到融合结果中,但热目标并不显著(如图7(d)所示)。在使用基础损失 L b a s e \mathcal{L}{base} Lbase 和辅助强度损失 L a u x _ i n t \mathcal{L}_{aux\_int} Laux_int 时,热信息很突出。然而,细节特征丢失了(如图7(e)所示)。当采用多约束损失函数进行图像融合时,热信息和纹理特征都保留在融合结果中(如图7(f)所示)。更重要的是,多约束损失函数在每个指标上都达到了更大的平均值(列于表I),这显示了所设计损失函数的有效性。

图7. 多约束损失函数的消融实验。从左至右依次为:红外图像、可见光图像,以及分别使用以下损失函数得到的融合图像------基础损失 L base \mathcal{L}{\text{base}} Lbase、基础损失 L base \mathcal{L}{\text{base}} Lbase与辅助结构损失 L aux-str \mathcal{L}{\text{aux-str}} Laux-str、基础损失 L base \mathcal{L}{\text{base}} Lbase与辅助强度损失 L aux-int \mathcal{L}_{\text{aux-int}} Laux-int,以及多约束损失函数。

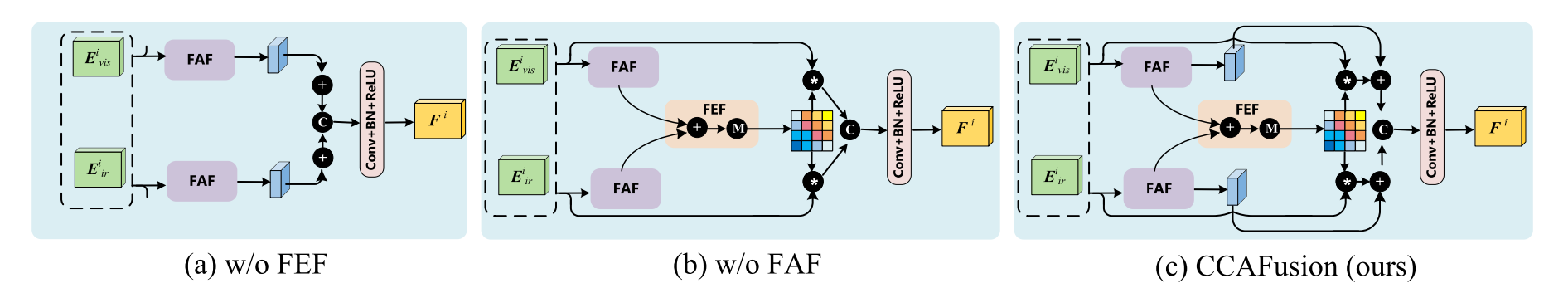

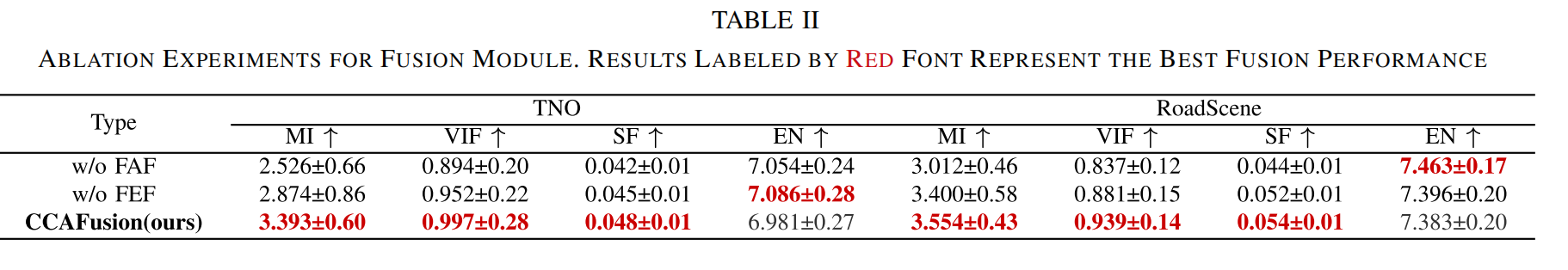

3) 融合模块效果: 为了评估我们融合策略中关键组件的有效性,我们分别移除了CCAFusion的FAF和FEF,以探讨它们对融合性能的影响。图8显示了没有特征增强融合模块的网络(称为 w/o FEF)、没有特征感知融合模块的网络(称为 w/o FAF)和CCAFusion网络。每种融合类型的实验结果列于表II。我们可以看到,CCAFusion在三个指标(即MI、VIF和SF)上取得了更大的平均值。MI上的最优结果表明CCAFusion将更多的信息从源图像传输到融合结果中。VIF方面的最佳结果与人类视觉感知更好地对应。SF方面的最佳结果表明所提出的方法在保留细节信息方面具有卓越的能力。尽管CCAFusion的EN与 w/o FEF 和 w/o FAF 的网络差距很小,但与第四节C和D节提供的最先进的图像融合方法相比,CCAFusion仍然具有可观的性能,表明CCAFusion的融合结果仍然包含丰富的信息。

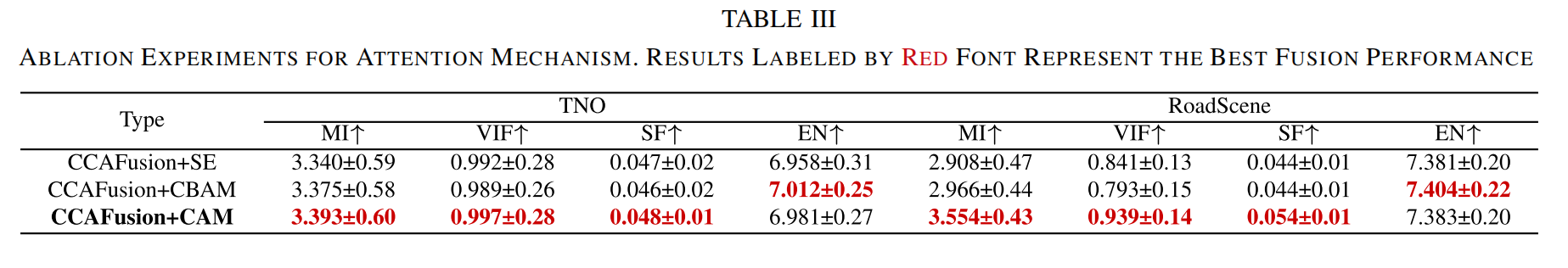

4) 注意力机制效果: 为了评估坐标注意力对我们CCAFusion网络的有效性,我们使用常用的注意力方法(包括SE注意力和CBAM)替换CAM。其余方面与原始CCAFusion网络保持一致。使用不同注意力机制融合的定量结果如表III所示。由于捕获了基本的通道信息、位置信息和长程依赖性,使用CAM的CCAFusion网络在MI、VIF和SF上取得了最佳值,并且在EN上距离最优值差距很小,这表明了CAM在我们CCAFusion网络上的有效性。

C. 对比实验

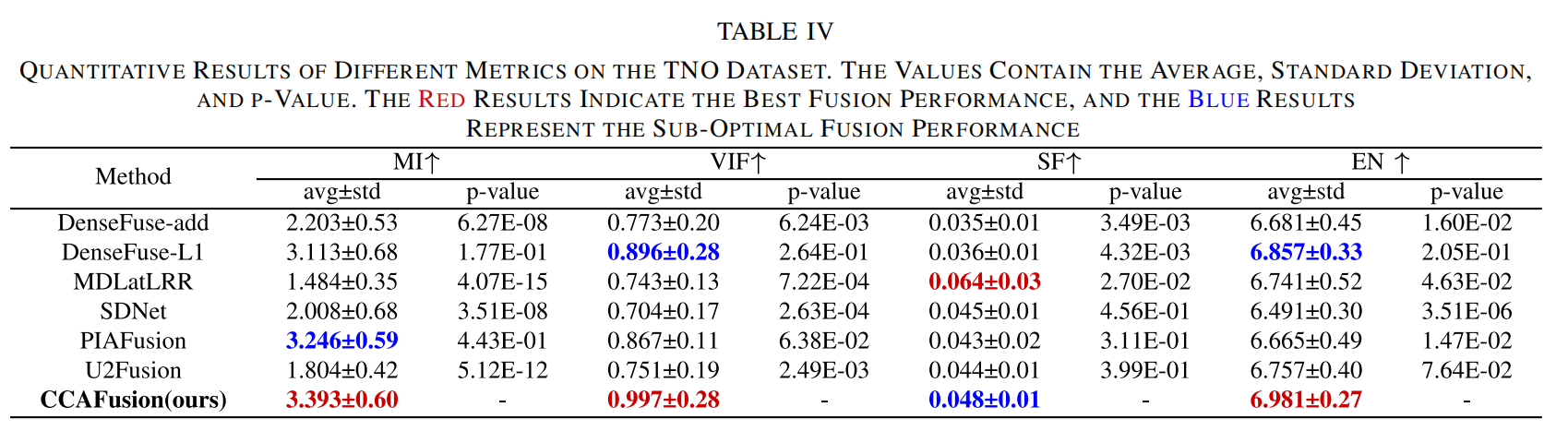

为了评估CCAFusion的融合性能,将提出的网络与最先进的图像融合方法在TNO数据集上进行比较,包括定性比较和定量比较。

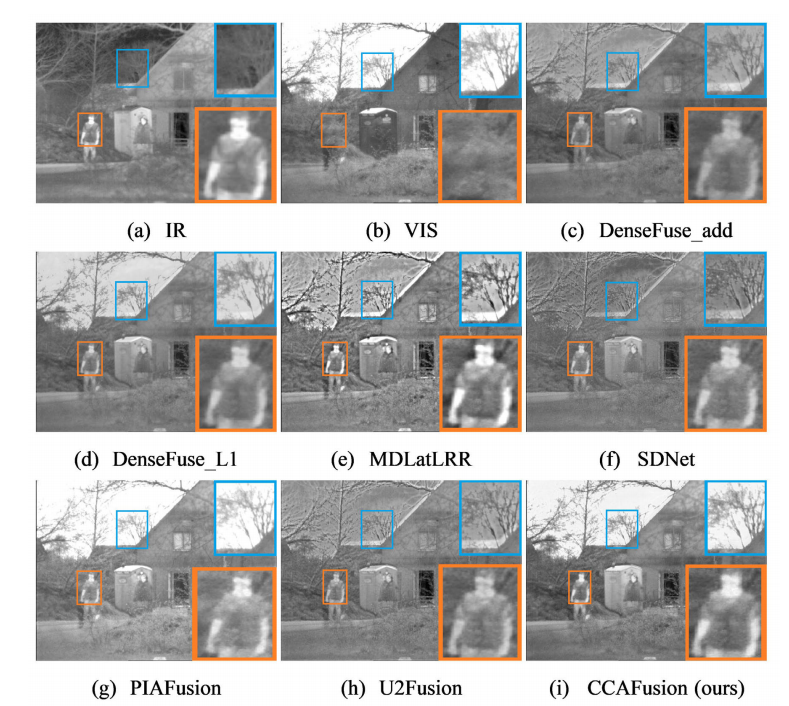

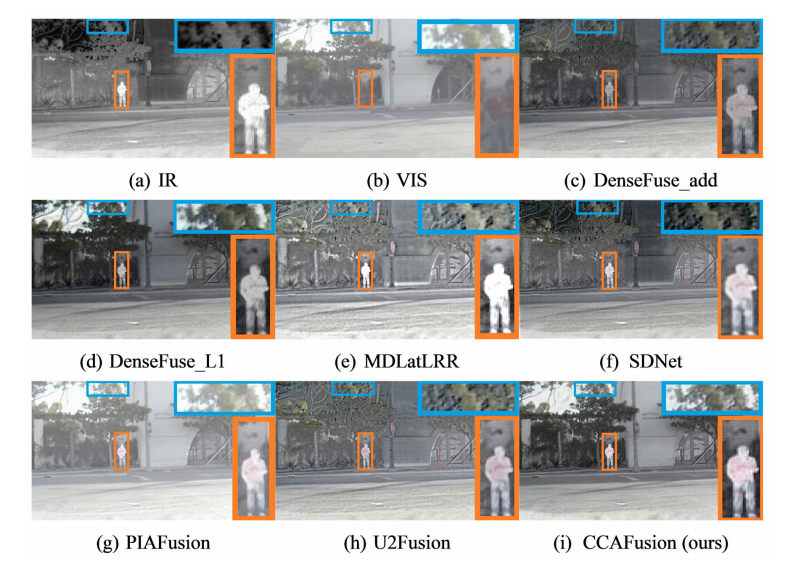

1) 定性比较: 为了直观展示各种图像融合方法的性能差异,从TNO数据集中选择三对融合图像进行定性比较,如图9-11所示。每幅图中从左上到右下的图像依次是红外图像、可见光图像,以及DenseFuse-add、DenseFuse-L1、MDLatLRR、SDNet、PIAFusion、U2Fusion和CCAFusion的融合图像。为清晰展示融合差异,我们在每个融合图像中选择局部区域(即蓝色框和橙色框)。然后将局部区域放大并放置在角落。

图9显示,DenseFuse-add、MDLatLRR、SDNet和U2Fusion的融合结果在一定程度上保持了热目标,但存在伪影的缺点。例如,在MDLatLRR中,房屋边缘和树枝上出现了不理想的光晕或亮边,而这种现象也存在于DenseFuse-add、SDNet和U2Fusion的结果中(如蓝色框所示)。尽管DenseFuse-L1的融合结果没有产生伪影,但它缺乏显著目标与背景区域之间的对比度,导致与可见光图像的天空不一致,而PIAFusion保持了背景信息,但丢失了一些树枝的纹理。CCAFusion融合图像中的树枝纹理与可见光图像最为一致。整体上,CCAFusion可以在没有伪影的情况下保留红外图像中的显著目标和可见光图像中的细节。

图10和图11显示,提出的CCAFusion可以有效地合并源图像中的互补信息。具体来说,在图10中,除CCAFusion和PIAFusion外,其他融合结果中的天空与可见光图像不一致或被伪影污染。然而,在复杂背景区域,PIAFusion削弱了热辐射目标。在图11中,由CCAFusion和SDNet生成的融合图像中的热辐射目标最为显著。然而,SDNet背景区域中的云与可见光图像不一致。总体而言,我们的CCAFusion不仅能有效突出红外图像中的显著目标,而且在保持可见光图像中的细节纹理方面具有优势。

2) 定量比较: 除了视觉感知,我们还采用广泛使用的定量指标进一步评估CCAFusion的融合质量。图12和表IV显示了在TNO数据集上21对图像的各种定量指标的对比结果。具体来说,图12显示了现有图像融合方法与CCAFusion在各种定量指标上直方图分布的比较。更右偏的数据意味着更高的指标和更好的融合性能。表IV列出了不同指标的平均值、标准差和p值。由于数值越大的指标表示融合性能越好,p值p基于单侧右尾检验,其中p= Pr(T≥t| H0)。T表示来自我们方法的检验统计量。t是来自对比方法的检验统计量。Ho是零假设。Pr是如果Ho为真,T至少与t一样极端的概率。此外,红色字体标注的值表示最佳结果,蓝色字体标注的值表示次优结果。在四个指标中,注意CCAFusion在其中三个(即MI、VIF和EN)上具有显著优势。更高的MI表明CCAFusion生成的融合结果包含了更多从源图像传输到融合图像的信息。更大的VIF意味着我们的融合图像包含了更好的信息保真度,并且与人类视觉感知更好地对应。此外,CCAFusion提供了更大的EN,这意味着融合结果中的信息更多。在SF方面,CCAFusion仅略低于MDLatLRR。原因是MDLatLRR产生的伪影和过度锐化导致更高的SF。

D. 泛化实验

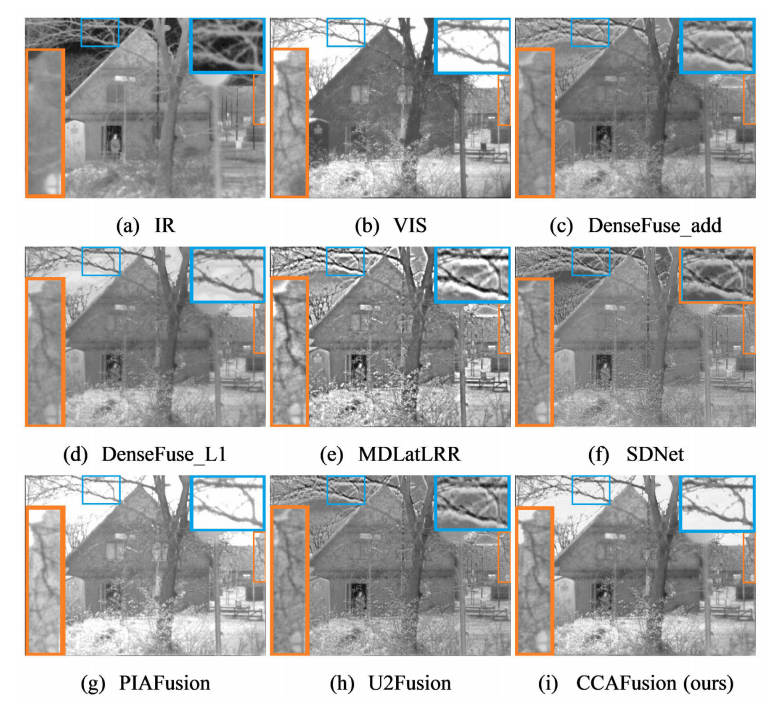

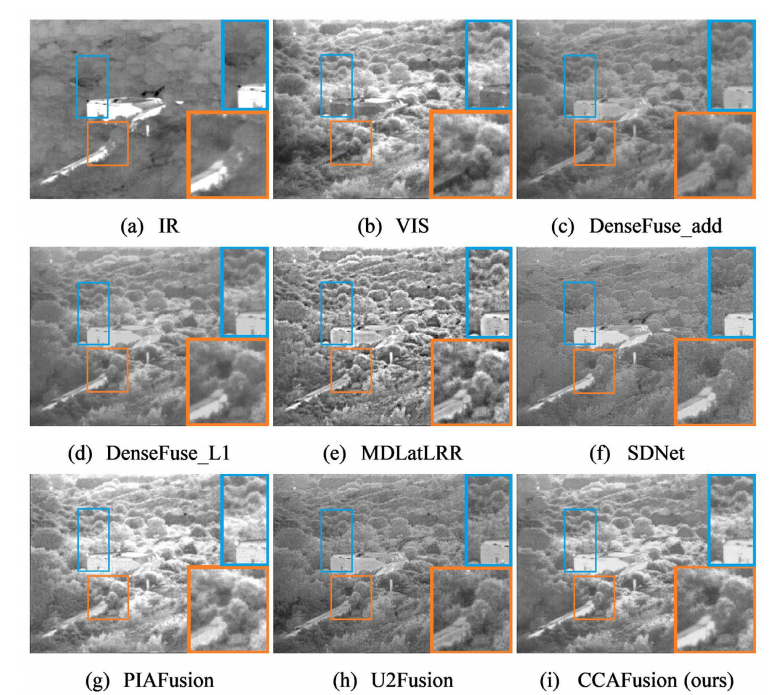

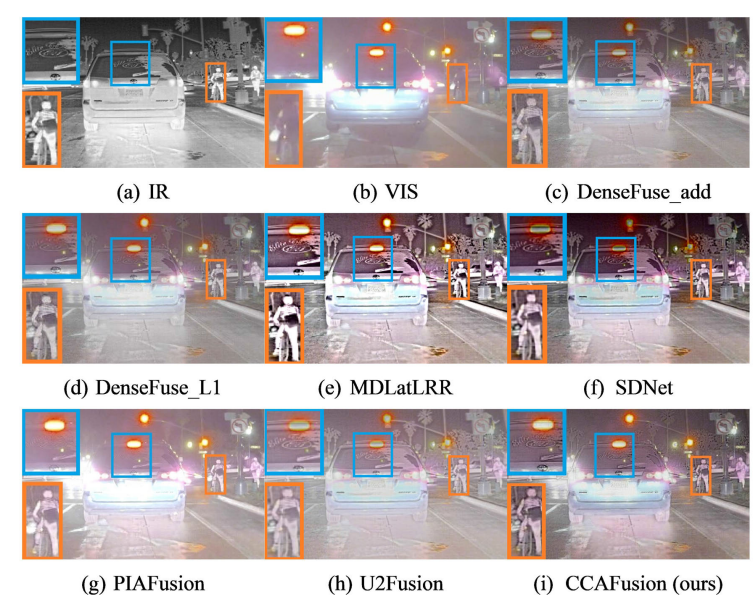

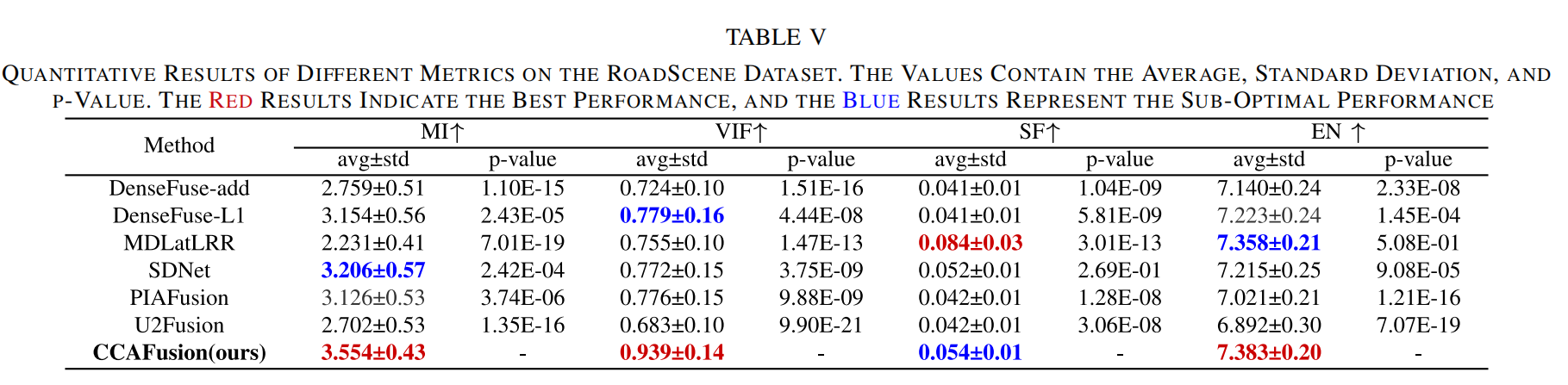

为了证明CCAFusion的泛化能力,我们在RoadScene数据集上提供了实验。由于RoadScene数据集中的可见光图像是RGB图像,我们采用第III-E节中描述的RGB-红外融合策略来实现图像融合。

1) 定性比较: 图13-15是来自RoadScene数据集的三对融合图像,显示了各种图像融合算法的定性比较。为清晰观察视觉差异,使用橙色框和蓝色框在每个图像中放大局部区域。在图13-15中,我们可以观察到,失真的信息被引入到DenseFuse-add、MDLatLRR、SDNet和U2Fusion的融合结果中,表现为失真的天空颜色(如图13和图15所示)和失真的路灯颜色(如图14所示)。此外,源图像中的纹理信息和突出目标在DenseFuse-L1和PIAFusion生成的融合图像中被削弱(如图13-15所示)。值得一提的是,CCAFusion有效地保留了源图像中的纹理细节和显著目标。

2) 定量比较: 在本节中,进行了定量评估。RoadScene数据集上61对图像的各种定量指标的结果如图16和表V所示。与TNO数据集上的定量比较类似,图16显示了各种定量指标的直方图分布。更右偏的数据表示更高的指标和更好的融合性能。表V报告了不同指标的平均值、标准差和p值。最佳结果以红色突出显示,次佳结果以蓝色突出显示。可以看出,CCAFusion在MI、VIF和EN上具有最佳值。这些结果表明,CCAFusion生成的融合图像不仅可以保持丰富的信息,而且具有令人满意的视觉质量。由于MDLatLRR中存在伪影和过度锐化,CCAFusion在SF方面的优势并不特别明显。

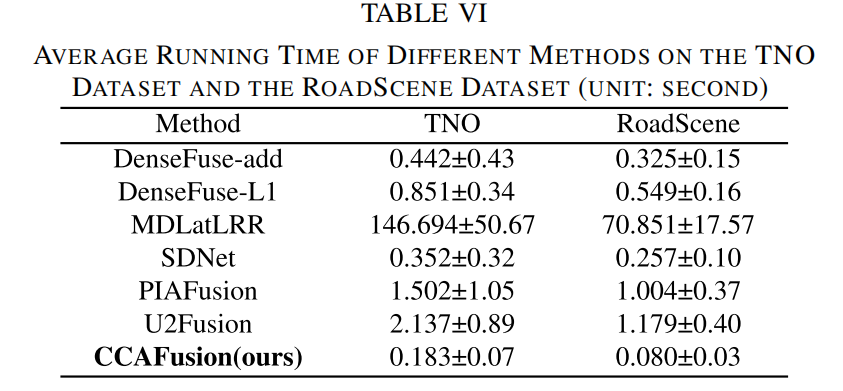

E. 效率比较

为了比较所提出方法与其他方法的处理速度,我们记录了不同方法在TNO数据集和RoadScene数据集上的平均运行时间,比较结果如表VI所示。注意,传统方法(MDLatLRR)在AMD R7-4800H 2.90GHz CPU上实现,其他基于深度学习的方法在Nvidia 2080Ti GPU上进行。平均运行时间反映了模型的处理速度。运行时间的标准差反映了模型的稳健性。在表VI中,我们可以看到,基于深度学习的方法明显快于传统方法,这得益于GPU加速。与其他基于深度学习的方法相比,我们的方法具有竞争力的操作效率和可比的稳健性。为此,我们的方法可以胜任地部署为高级视觉任务的预处理模块。

F. 在显著目标检测中的应用

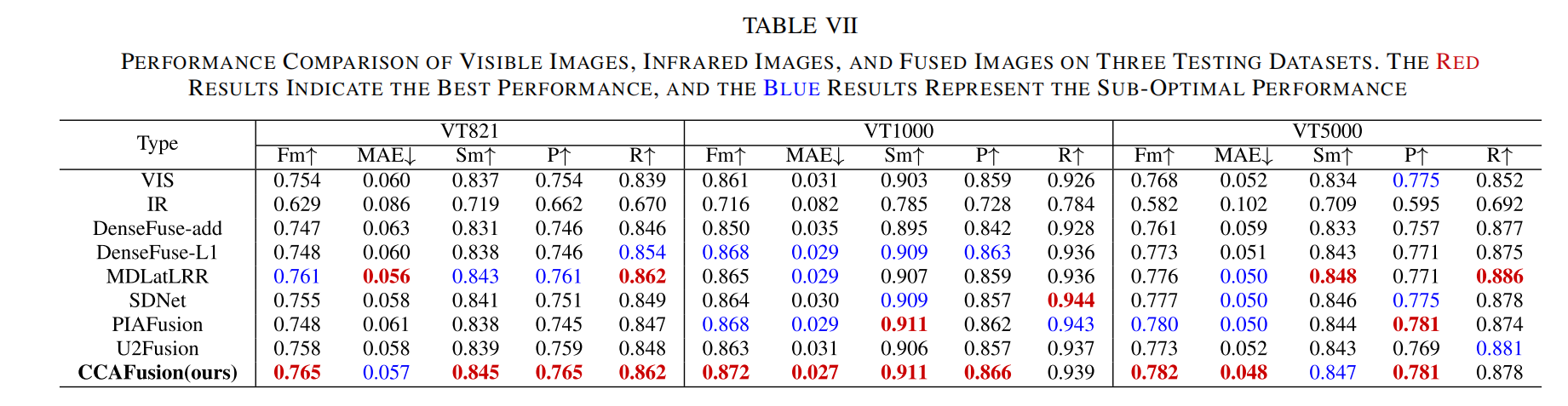

显著目标检测(SOD)是常见的高级视觉任务之一,旨在估计数字图像中的显著对象或区域。为了进一步证明所提出的融合方法的有效性,我们还将源图像和融合结果分别输入到显著目标检测方法[63]中。选择VT821[64]、VT1000[65]和VT5000[66]作为测试数据集,它们是三个关于红外和可见光图像的公共SOD数据集。

1) 定性比较: 我们在图17中提供了一些典型示例来说明我们的CCAFusion在促进显著目标检测方面的优势。可以看出,由于背景限制,可见光图像无法突出所有显著对象,这导致检测结果中的区域不完整。当背景与显著对象混合时,基于红外图像的检测结果与地面真相(GT)相去甚远。与基于单一模态的检测结果相比,融合图像在显著目标检测中发挥了积极作用。值得一提的是,我们的融合图像获得了与地面真相最一致的结果,因为其整合热信息和纹理信息的能力强大。

2) 定量比较: 我们进一步采用定量指标来评估显著目标检测的性能,如表VII所示。P和R分别是平均精确率和平均召回率。F-measure(Fm)表示精确率和召回率的加权调和平均值。S-measure(Sm)评估地面真相与其预测图之间空间结构的相似性。平均绝对误差(MAE)测量地面真相与其预测图之间的平均像素级相对误差。MAE值越低,检测性能越好。表VII显示了可见光图像、红外图像以及由我们的方法和其他方法生成的融合图像的性能比较。可以看出,与单一模态相比,融合图像取得了更好的性能,表明图像融合对显著目标检测具有积极作用。此外,由于融合层中直接使用加法策略,DenseFuse-add的融合图像在显著目标检测上表现出较差的性能。相比之下,我们的CCAFusion的融合图像在大多数指标上取得了明显优势,这证明了所提出方法的有效性。

3) 注意力机制比较: 为了进一步比较坐标注意力与其他注意力方法在我们CCAFusion网络上的性能,我们用其他注意力方法替换CAM,包括广泛采用的SE注意力和CBAM。对于其他设置,我们遵循原始CCAFusion网络。使用不同注意力机制的定性和定量结果分别如图18和表VIII所示。在图18中,可以看出,我们的CCAFusion网络与CAM相比SE注意力和CBAM能更好地帮助检测显著对象。坐标注意力在CCAFusion上的优势也体现在表VIII中。我们的CCAFusion网络与CAM在大多数指标上优于其他注意力方法。我们认为这一优势得益于对基本通道信息、位置信息和长程依赖性的捕获。然而,SE模块忽略了位置信息的重要性,仅考虑了通道间的信息。CBAM同时考虑了通道信息和位置信息,但缺乏长程依赖性。CAM可以同时捕获通道和位置重要性以及长程依赖性。因此,我们在CCAFusion中采用CAM以获得卓越性能。

5.结论:

本文提出了一种用于红外与可见光图像融合的跨模态坐标注意力网络(CCAFusion)。通过设计包含特征感知和特征增强模块的融合策略,以及多约束损失函数,CCAFusion能够有效保留源图像的纹理细节和热辐射信息,同时避免伪影产生。在多个标准数据集上的实验表明,CCAFusion在主观视觉质量和客观评价指标上均优于现有主流方法。此外,在显著目标检测上的应用验证了其对于高级计算机视觉任务的实际价值。

基于当前研究,我们计划从以下几个方向展开未来工作:

模型轻量化: 探索网络剪枝、量化或更高效的架构设计,以降低模型复杂度和计算资源消耗,推动其在移动设备和嵌入式系统上的应用。

视频融合: 将CCAFusion扩展至视频序列融合,引入时序建模机制(如3D卷积或递归神经网络),以处理动态场景并保证视频时序的稳定性。

多任务学习: 研究端到端的多任务学习框架,将图像融合与目标检测、语义分割等高级任务联合优化,进一步提升整体系统的性能和效率。

恶劣条件增强: 针对极端光照、恶劣天气等复杂条件,设计更具鲁棒性的融合机制,提升模型在真实世界复杂环境下的适用性。

我们相信CCAFusion为多模态图像融合提供了一个强有力的基线,其设计思路也可为其他相关领域的研究提供借鉴。