第1节 语义向量空间:Embedding的基础原理

现代自然语言处理(NLP)的核心是将非结构化文本转化为机器可理解的数学表示,Embedding模型是实现这一转化的关键技术。

1.1 分布式假设:Embedding的哲学基石

所有现代词嵌入技术源于分布式假设(Distributional Hypothesis) (语言学家J.R. Firth提出),核心思想为:"观其伴而知其言(You shall know a word by the company it keeps)"------出现在相似上下文的词语,语义更相近。

- 示例:"国王"与"女王"常与"皇家""宫殿"共现,因此语义关联紧密;

- 价值:无需人工定义词典/本体,可通过"语料中共现模式"学习语义关系,为Word2Vec、BERT等模型提供理论支撑。

1.2 定义Embedding:从非结构化文本到有意义的向量

Embedding是将文本/图像/音频等对象转化为**稠密向量表示(dense vector representation)**的技术,目标是将人类可读文本转为机器可处理的数值格式。

- 语义空间(semantic space):向量间距离反映语义相似度(如"国王"与"女王"向量近,与"汽车"向量远);

- 向量运算的语义性:通过向量运算可揭示抽象关系,经典案例:

vector("国王") - vector("男人") + vector("女人") ≈ vector("女王")

1.3 Embedding在AI系统中的目的

通过语义向量化,为多类AI应用提供基础:

- 语义搜索:理解查询意图,检索"概念相关但关键词不同"的文档(区别于传统关键词匹配);

- 文本分类与聚类:通过向量相似度,自动分组/分类文本(如情感分析、主题建模);

- 检索增强生成(RAG):将查询转为Embedding,在向量库检索相关文档,为大语言模型(LLM)提供事实性上下文;

- 泛化能力:对罕见词,可通过上下文推断其Embedding(如"轿车"与"汽车"语义近,向量表示也近)。

范式转变:Embedding标志着NLP从"人工规则/符号系统"向"数据驱动的统计学习"转变------意义不再是预设实体,而是数据统计结构的涌现属性,解锁了机器处理语言复杂性、歧义性的能力。

第2节 Embedding模型的维度变换:一个明确的澄清

关于"Embedding是升维还是降维"的困惑,需从"文本表示的起点与终点"对比分析。

2.1 起点:稀疏、高维的表示法

Embedding出现前,主流方法是独热编码(One-Hot Encoding):

- 向量维度 = 词汇表大小(如5万词表对应5万维向量),仅目标词位置为1,其余为0;

- 缺陷:

- 维度灾难:词汇量扩大导致向量维度爆炸,模型参数量与计算开销剧增;

- 数据稀疏:绝大多数元素为0,存储与计算低效;

- 无语义信息:任意两词向量正交(点积为0),无法体现"猫-狗"与"猫-火箭"的语义差异。

2.2 转换:稠密、低维的Embedding

Embedding模型(Word2Vec、GloVe、BERT等)的核心是**"高维稀疏→低维稠密"的降维(Dimensionality Reduction)**:

- 维度显著降低:Embedding维度远小于词汇表(如300、768、4096维);

- 稠密性:向量元素多为非零浮点数,每个维度承载语义信息。

2.3 真正的目标:语义压缩,而非简单的维度降低

Embedding的核心不是"降维",而是**"降维同时编码语义关系"**------训练中学习"语义相似词在低维空间相近",使模型具备泛化能力(如未见过的"轿车"可通过"汽车"的Embedding推断)。

表1:稀疏与稠密向量表示法对比

| 特性 | 独热编码 (One-Hot Encoding) | Embedding (稠密向量) |

|---|---|---|

| 维度 | 极高(=词汇表大小,如>5万) | 较低(固定值,如300、768) |

| 稀疏性 | 极度稀疏(仅1个非零元素) | 稠密(多数元素非零) |

| 语义表示 | 无(向量正交,无法体现相似度) | 丰富(向量距离反映语义相似度) |

| 计算效率 | 低(模型参数量大,计算开销高) | 高(参数量减少,计算更高效) |

| 泛化能力 | 差(无法处理未见过的词) | 好(可通过上下文推断相似词表示) |

维度的动态权衡:套娃表示学习(Matryoshka Representation Learning)

Embedding维度是"表示能力"与"计算成本"的权衡:

- 低维(如128维):存储/计算成本低,但可能丢失细粒度语义;

- 高维(如4096维):语义容量大,但存储、检索开销高。

"套娃表示学习"为动态权衡提供方案:训练时让Embedding可截断为不同维度(如推理时根据场景选"低维保性能"或"高维保精度"),使维度从"前置设计"变为"运行时决策",增强模型适用性。

第3节 语义相关性架构:Bi-Encoder与Cross-Encoder

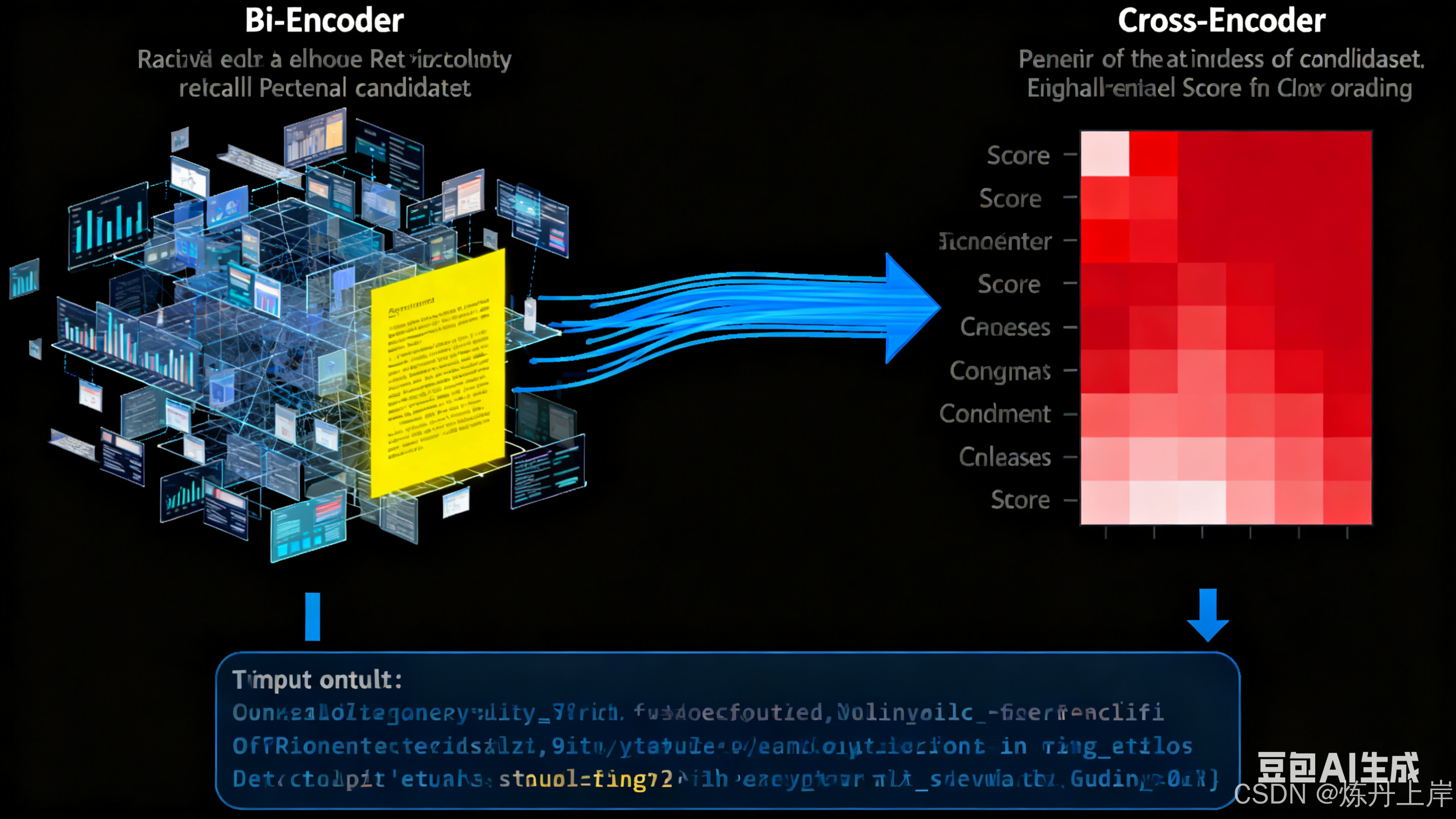

现代信息检索的核心是"评估查询与文档的语义相关性",衍生出**Bi-Encoder(双编码器)与Cross-Encoder(交叉编码器)**两种主流架构,二者在"检索流程"中角色互补。

3.1 可扩展的检索器:Bi-Encoder(双编码器)架构

Bi-Encoder为大规模、高效率的初步检索设计,核心是"独立编码查询与文档,离线存储文档Embedding,在线快速匹配"。

工作机制

- 离线索引:文档库中所有文档逐一通过"文档编码器"生成Embedding;

- 向量存储 :文档Embedding存入向量数据库(优化近似最近邻搜索);

- 在线查询:用户查询通过"查询编码器"生成Embedding;

- 相似性搜索 :向量数据库执行近似最近邻(ANN)搜索,快速返回最相似的文档Embedding。

核心优势:效率与可扩展性------文档Embedding离线预计算,实时搜索仅需"查询编码+ANN搜索",毫秒级完成海量数据检索,是语义搜索"检索(Retrieval)阶段"的核心。

3.2 高精度的重排器:Cross-Encoder(交叉编码器)架构

Cross-Encoder为**最高精度的重排序(Re-ranking)**设计,核心是"拼接查询与文档,同时编码以捕捉细粒度交互"。

工作机制

- 输入:将查询与候选文档拼接(如用``分隔),送入Transformer模型;

- 交互:模型通过自注意力机制,深度交互查询与文档的所有词元;

- 输出:生成单一分数,直接表示"文档与查询的相关性程度"。

核心优势:准确性------直接建模查询与文档的交互,在"细粒度相关性判断"上远超Bi-Encoder。

3.3 共生关系:"检索与重排"流水线

Bi-Encoder与Cross-Encoder并非竞争关系,而是**"检索→重排"的两阶段流水线**:

- 检索阶段:Bi-Encoder从海量文档召回候选集(如Top 100),保证"召回率(Recall)";

- 重排阶段:Cross-Encoder仅对候选集重排序,提升"精确率(Precision)"。

该架构平衡"速度"与"精度",是高性能语义搜索的关键。

表2:架构权衡:Bi-Encoder vs. Cross-Encoder

| 特性 | Bi-Encoder (双编码器) | Cross-Encoder (交叉编码器) |

|---|---|---|

| 输入处理 | 查询、文档独立编码 | 查询、文档拼接后共同编码 |

| 输出 | 每个输入对应1个Embedding | 每个输入对对应1个相关性分数 |

| 计算成本 | 低(文档可离线预计算) | 高(每个查询-文档对需完整计算) |

| 可扩展性 | 极高(适配数十亿级文档) | 差(仅适配少量候选文档) |

| 准确性 | 中等 | 高(捕捉细粒度交互) |

| 主要用例 | 检索(Retrieval)/ 召回 | 重排序(Re-ranking)/ 精排 |

第4节 现代Embedding模型的训练方案

训练高性能Embedding模型需"架构选择→数据准备→损失函数设计"的系统化流程。

4.1 基础架构:Transformer与自注意力机制

现代Embedding模型多基于Transformer架构 (如BERT),核心是自注意力机制(Self-Attention)------允许模型动态评估序列中词元的重要性,加权聚合信息,从而捕捉上下文相关的词语关系。

4.2 用于比较的孪生网络结构

为训练"用于相似性比较的Embedding",常采用孪生网络(Siamese Network):两个共享权重的编码器,依次处理"数据对/三元组"中的文本,确保所有文本映射到同一语义空间,使Embedding可直接比较。

4.3 从词元到句子:池化的作用

Transformer输出"每个词元的Embedding",但任务常需"句子/文档级Embedding",因此需**池化(Pooling)**操作:

- 平均池化(Mean Pooling):对所有词元Embedding逐维度取平均,综合所有信息;

- 词元池化(CLS Token Pooling):用BERT输入序列前的``词元Embedding(设计用于聚合全局语义)。

4.4 构建学习信号:训练数据格式

模型学习依赖"相似性信号的结构化数据",训练数据格式与损失函数强相关,主流格式:

- 带标签的句对 :

(句子1, 句子2, 标签)(标签为"相似度分数/离散类别",适配CosineSimilarityLoss等); - 正例句对 :

(句子1, 句子2)(隐含"两句话相似",适配MultipleNegativesRankingLoss); - 三元组 :

(锚点anchor, 正例positive, 负例negative)(定义"锚点与正例更相似",是TripletLoss的必需格式)。

4.5 目标函数:塑造向量空间的损失函数

损失函数定义训练目标,指导模型调整权重以优化Embedding空间,核心损失函数:

(1)对比损失(Contrastive Loss)

- 作用于"句对",目标:拉近正例对(相似句子)的Embedding,推开负例对(不相似句子),且保证间距≥预设边距(margin)。

(2)三元组损失(Triplet Loss)

- 作用于"三元组

(A, P, N)",目标:确保"锚点A与正例P的距离 + 边距" < "锚点A与负例N的距离"; - 公式:

Loss = max(0, D(A,P) - D(A,N) + margin)(D(x,y)为向量距离,如欧氏距离)。

表3:Embedding模型训练目标概览

| 损失函数 | 所需数据格式 | 标签类型 | 主要训练目标 |

|---|---|---|---|

| ContrastiveLoss | 句对 (Pairs) | 整数 (0/1) | 正/负例对间强制施加边距 |

| TripletLoss | 三元组 (Triplets) | 无 | 正例比负例更接近锚点,且满足边距 |

| MultipleNegativesRankingLoss | 正例句对 (Positive Pairs) | 无 | 从一批样本中区分正例与所有负例 |

| CosineSimilarityLoss | 句对 (Pairs) | 浮点数 (0-1) | Embedding余弦相似度逼近标签分数 |

关键补充:难负例挖掘(Hard Negative Mining)

Embedding模型质量依赖"负例的挑战性"------若负例"过于简单"(与锚点语义完全无关),模型易学懂,无法捕捉细粒度语义。因此需动态挖掘难负例:

- 用基线模型为查询召回候选文档;

- 用Cross-Encoder(或人工)识别"被基线模型错误召回的假阳性文档"(即难负例);

- 将难负例加入训练集,迫使模型学习更细微的语义差异。

第5节 先进架构:ColBERT的延迟交互机制探析

ColBERT是突破"Bi-Encoder/Cross-Encoder范式"的先进架构,代表检索模型的演进方向。

5.1 超越单一向量:ColBERT范式

ColBERT挑战"将文档压缩为单一向量"的范式,核心是**"为每个文档存储词元Embedding矩阵"**------保留文档内部细粒度语义信息,避免"单一向量的信息瓶颈"。

5.2 "延迟交互"机制

ColBERT结合Bi-Encoder的效率与Cross-Encoder的精度,核心是延迟交互(Late Interaction):

- 独立编码:与Bi-Encoder类似,独立计算查询、文档的词元Embedding(文档Embedding可离线预存,保证检索效率);

- 细粒度交互式评分 :查询时,对"查询词元Embedding"与"候选文档所有词元Embedding"计算相似度(点积),取每个查询词元的最大相似度(MaxSim);

- 聚合得分:将查询所有词元的MaxSim相加,得到文档与查询的最终相关性分数。

5.3 新的权衡:性能与存储

ColBERT在"Bi-Encoder(效率)"与"Cross-Encoder(精度)"间取得新平衡:

- 精度:逐词元细粒度匹配,准确性远超标准Bi-Encoder;

- 速度:避免Cross-Encoder的"每个查询-文档对完整计算",远快于Cross-Encoder;

- 挑战:存储成本高(需存词元Embedding矩阵)、向量数据库索引复杂。

设计哲学:ColBERT解构"Embedding为单一向量"的概念,将"语义比较"从"向量点积"转为"多词元的聚合评分",预示未来检索模型可能"在编码、交互、存储间寻求新平衡",以实现更高精度与效率。

第6节 实践应用:面向特定领域的检索模型微调

本节以"在MS MARCO数据集上构建语义搜索引擎"为例,展示Embedding模型的领域微调流程。

6.1 应用案例:MS MARCO数据集

MS MARCO是微软Bing的真实用户搜索语料库,含约880万段落、50万+训练查询,是语义搜索的"黄金评估标准"。目标是将通用Sentence-BERT模型微调为"精准检索相关段落的领域专家"。

6.2 关键环节:难负例挖掘的实践

MS MARCO的训练流程是"难负例挖掘"的经典实践,步骤:

- 初步检索:用基线Bi-Encoder(如预训练SBERT)为每个查询召回Top-k候选段落(如Top 200);

- "真值"重排:用高精度但慢的Cross-Encoder对候选段落重新打分(分数作为近似"真值标签");

- 识别难负例:筛选"被Bi-Encoder高评分召回,但被Cross-Encoder低评分判定为不相关"的段落(即迷惑Bi-Encoder的"干扰项");

- 构建训练三元组 :用难负例构建

(查询, 正例段落, 难负例段落)格式的训练数据。

6.3 微调循环

通用Sentence-BERT在"难负例三元组"上微调,常用TripletLoss或MultipleNegativesRankingLoss------训练模型区分"真正相关的正例"与"语义相似但实际无关的难负例",学习细粒度语义差别。

6.4 评估结果

微调后模型在独立验证集 上用MRR@10(Mean Reciprocal Rank at 10)、NDCG@10(Normalized Discounted Cumulative Gain at 10)评估,预期结果:微调模型指标显著优于原始通用模型,证明"领域特化成功,性能提升"。

深层原理 :微调是知识蒸馏(Knowledge Distillation)------将"庞大复杂但精准的Cross-Encoder(教师模型)"的推理能力,迁移到"轻量高效的Bi-Encoder(学生模型)"的Embedding空间,使大规模语义检索在实际中可行。

结论

Embedding模型是"人类语言与机器智能"的桥梁,其核心要点总结:

- 维度变换本质:从"高维稀疏独热编码空间"到"低维稠密语义空间"的降维过程,核心目标是"语义压缩"而非简单降维,通过低维向量保留并编码语义关系;

- 架构角色分工:Bi-Encoder以"效率与可扩展性"为核心,负责海量数据的初步检索(召回);Cross-Encoder以"高精度"为核心,负责候选集重排序(精排),二者组成的"检索-重排"流水线是高性能语义搜索的标配;

- 训练范式核心:基于Transformer与孪生网络架构,通过"池化"生成句子级Embedding;关键在于"匹配数据格式的损失函数"(如Triplet Loss)与"动态难负例挖掘",持续向模型提供挑战性学习信号,精细塑造语义空间;

- 未来方向启示:以ColBERT为代表的先进模型,通过"延迟交互"与"多向量表示"突破单一向量局限,预示未来检索模型将在"编码、交互、存储"的权衡中持续优化,追求更高精度与效率的平衡。

深刻理解Embedding的理论基础、架构差异与训练逻辑,是构建智能、高效、可靠的AI应用(如RAG、语义搜索)的关键,而对"精度-效率-成本"的持续权衡,将推动NLP领域不断向前发展。