本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

一款开箱即用、模型中立的企业级智能问答解决方案

在人工智能技术迅猛发展的今天,如何高效地管理和利用企业内部知识资源成为了众多组织面临的挑战。MaxKB(Max Knowledge Base)作为一款基于大语言模型和RAG的开源知识库问答系统,正以其开箱即用的体验 和强大的模型兼容性,在GitHub上引发广泛关注,成为企业构建智能问答系统的理想选择。

项目概述

MaxKB是由1Panel开源项目组 开发的一款基于大语言模型(LLM)的知识库问答系统。该项目在GitHub上已获得数万星标(截至2025年4月数据显示超过15,000个Star),显示出强大的社区支持力和发展潜力。

与其他知识库解决方案相比,MaxKB最大的特点是其模型中立 的设计理念。它支持对接各种大语言模型,包括本地私有大模型 (如Llama 3、Qwen 2等)、国内公共大模型 (如通义千问、腾讯混元、字节豆包、智谱AI、百度千帆、Kimi、DeepSeek等)以及国外公共大模型(如OpenAI、Gemini等)。这种灵活性使得用户可以根据自身需求和安全要求选择合适的模型。

核心功能解析

1. 开箱即用的知识库管理

MaxKB提供了一套完整的知识库管理解决方案,支持多种文档导入方式:

- 直接上传文档:支持常见格式的文档上传和处理

- 自动爬取在线文档:能够从指定网站自动抓取内容并生成知识库

- 智能文本处理:内置文本自动拆分和向量化功能,为后续的智能检索奠定基础

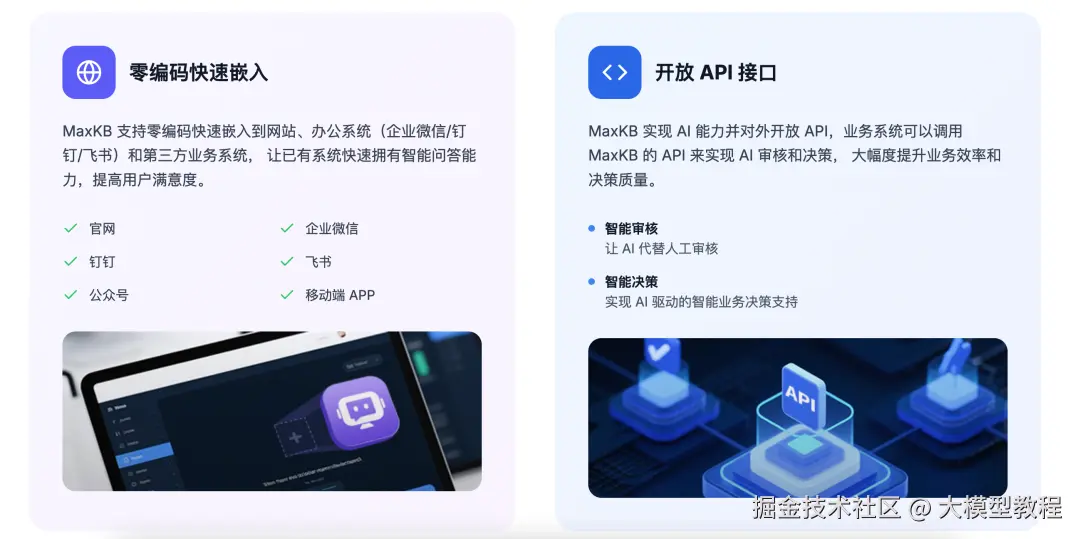

2. 无缝嵌入第三方系统

MaxKB支持零编码快速嵌入到第三方业务系统,让已有系统快速拥有智能问答能力。通过简单的脚本嵌入,企业可以在自己的CRM、ERP或内部培训系统中集成智能问答功能,无需复杂的开发工作。

3. 灵活的工作流编排

MaxKB内置了强大的工作流引擎和函数库,支持编排AI工作过程,满足复杂业务场景下的需求。用户可以通过图形化界面设计复杂的工作流程,实现更加精准和高效的问答体验。

4. 多模型支持与管理

MaxKB在模型支持方面表现出色:

- 公有模型支持:支持多家主流模型厂商,包括千问、百炼、OpenAI、DeepSeek、Gemini、Kimi等

- 私有模型部署:支持通过Ollama、vLLM等方式本地部署私有模型

- 统一模型管理:提供统一的模型管理界面,简化模型配置和切换过程

技术架构与实现原理

系统架构

MaxKB采用前后端分离的架构设计:

- 前端:基于Vue.js框架开发,提供直观易用的用户界面

- 后端:使用Python/Django框架,提供稳定的API服务

- 向量数据库:使用PostgreSQL/pgvector作为向量数据库,支持高效的相似性检索

- 开发框架:集成Langchain等AI开发框架,增强系统能力

RAG实现原理

MaxKB基于RAG(检索增强生成) 技术构建,其工作原理如下:

- 文档处理:将上传的文档进行切片和向量化处理,构建知识向量库

- 语义检索:根据用户问题,从向量库中检索最相关的文档片段

- 增强生成:将检索到的相关文档与用户问题一起提交给大模型,生成准确可靠的答案

这种方法有效减少了大模型的幻觉问题,提高了问答的准确性和可靠性。

安装与部署指南

环境要求

MaxKB支持多种部署方式,对环境要求较为灵活:

- Docker环境:需要安装Docker和Docker Compose

- 系统资源:建议至少2核CPU、4GB内存

- 存储空间:根据知识库规模预留足够存储空间

Docker部署

通过Docker可以快速部署MaxKB:

bash

docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data 1panel/maxkb部署完成后,可以通过http://localhost:8080 访问系统,默认用户名和密码为admin/MaxKB@123..。

1Panel应用商店部署

对于使用1Panel的用户,可以通过1Panel应用商店更便捷地安装MaxKB。这种方式可以在30分钟内完成基于LLM大语言模型的知识库问答系统的部署。

离线部署

对于网络受限的环境,MaxKB还提供离线部署方案。用户可以先下载离线安装包,然后通过简单的命令完成安装:

tar -zxvf maxkb-v1.2.0-offline.tar.gzcd maxkb-v1.2.0-offlinebash install.sh配置与使用教程

模型配置

MaxKB支持多种模型接入方式,以下以配置Ollama本地模型为例:

- 部署Ollama :使用

ollama pull deepseek-r1:8b命令拉取模型 - 配置MaxKB:在系统设置→模型设置中添加Ollama模型

- 测试连接:通过演示功能测试模型是否正常工作

知识库创建

创建知识库的基本步骤:

- 创建知识库:指定知识库名称和类型

- 上传文档:支持单个或多个文档上传

- 配置处理参数:设置文本拆分策略和向量化参数

- 构建索引:系统自动处理文档并构建检索索引

应用创建

创建智能问答应用的流程:

- 创建应用:设置应用名称和描述

- 选择AI模型:从已配置的模型中选择合适的AI模型

- 关联知识库:绑定相关的知识库资源

- 配置问答参数:设置温度、最大令牌数等生成参数

应用场景分析

企业内部知识管理

企业可以使用MaxKB构建内部知识库,帮助员工快速找到产品文档、技术资料和业务流程信息。例如,可以将企业的人才储备库导入到知识库中,当有招聘需求时,HR可以通过智能问答快速找到合适的候选人。

智能客服系统

MaxKB可以嵌入到企业的客服系统中,提供7x24小时的智能客服服务。通过训练企业特定的知识库,客服机器人可以准确回答客户问题,大大提高客服效率。

教育机构知识问答

教育机构可以利用MaxKB构建学科知识问答系统,帮助学生快速获取学习资料和解答疑问。例如,可以构建包含《水浒传》原文的知识库,用于历史文学研究和传统文化学习。

第三方系统集成

MaxKB支持嵌入到第三方业务系统中。例如,DataEase开源数据可视化分析工具已经基于MaxKB开发了"DataEase小助手",嵌入到操作界面和在线文档页面中。

版本演进与新特性

MaxKB项目保持活跃开发,近期发布的v2.2.0版本引入了多项强大功能:

工具商店

v2.2.0版本新增了工具商店,用户可以直接在商店中选择所需的智能体开发相关工具,无需手动开发或进行复杂集成。这一功能进一步完善了MaxKB开源智能体平台的工具生态闭环。

高级工作流节点

新版本的工作流引擎增加了多种高级节点:

- 循环节点:支持数组循环、按次数循环和无限循环,提升应用流程的灵活性与效率

- 意图识别节点:能够识别用户输入意图,并将不同意图流转至工作流的不同分支

- 文生视频和图生视频节点:支持基于文本或图片生成视频内容,扩展了多媒体处理能力

MCP和工具调用

简易应用新增MCP(Model Context Protocol)和工具调用功能,通过让模型自主决策如何调用工具,大幅降低非技术用户搭建实用型AI应用的门槛。

优势与挑战

核心优势

MaxKB在知识库问答领域具有多重优势:

- 开箱即用:简化了从文档上传到智能问答的全流程,大幅降低使用门槛

- 模型中立:支持多种大语言模型,用户可以根据需求灵活选择

- 无缝集成:提供简单的嵌入方式,便于集成到现有系统中

- 持续更新:项目保持活跃开发状态,定期推出新功能和优化

面临的挑战

尽管MaxKB功能强大,但也存在一些限制:

- 社区版限制:开源版本在知识库数量、应用数量和用户管理上有限制

- 专业版费用:完整功能需要升级到专业版,需要一定的费用预算

- 技术依赖:需要一定的技术基础进行部署和维护

总结与展望

MaxKB作为一款功能全面的开源知识库问答系统,通过直观易用的界面 、强大的多模型支持 和灵活的部署选项 ,为企业构建智能问答系统提供了优秀的解决方案。其基于RAG的技术架构既保证了问答的准确性,又充分利用了大语言模型的生成能力。

随着人工智能技术的普及和企业数字化转型的深入,像MaxKB这样的知识管理工具将发挥越来越重要的作用。无论是对于需要构建内部知识库的企业,还是希望为客户提供智能问答服务的组织,MaxKB都提供了一个值得尝试的解决方案。

项目地址 :github.com/1Panel-dev/...

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。