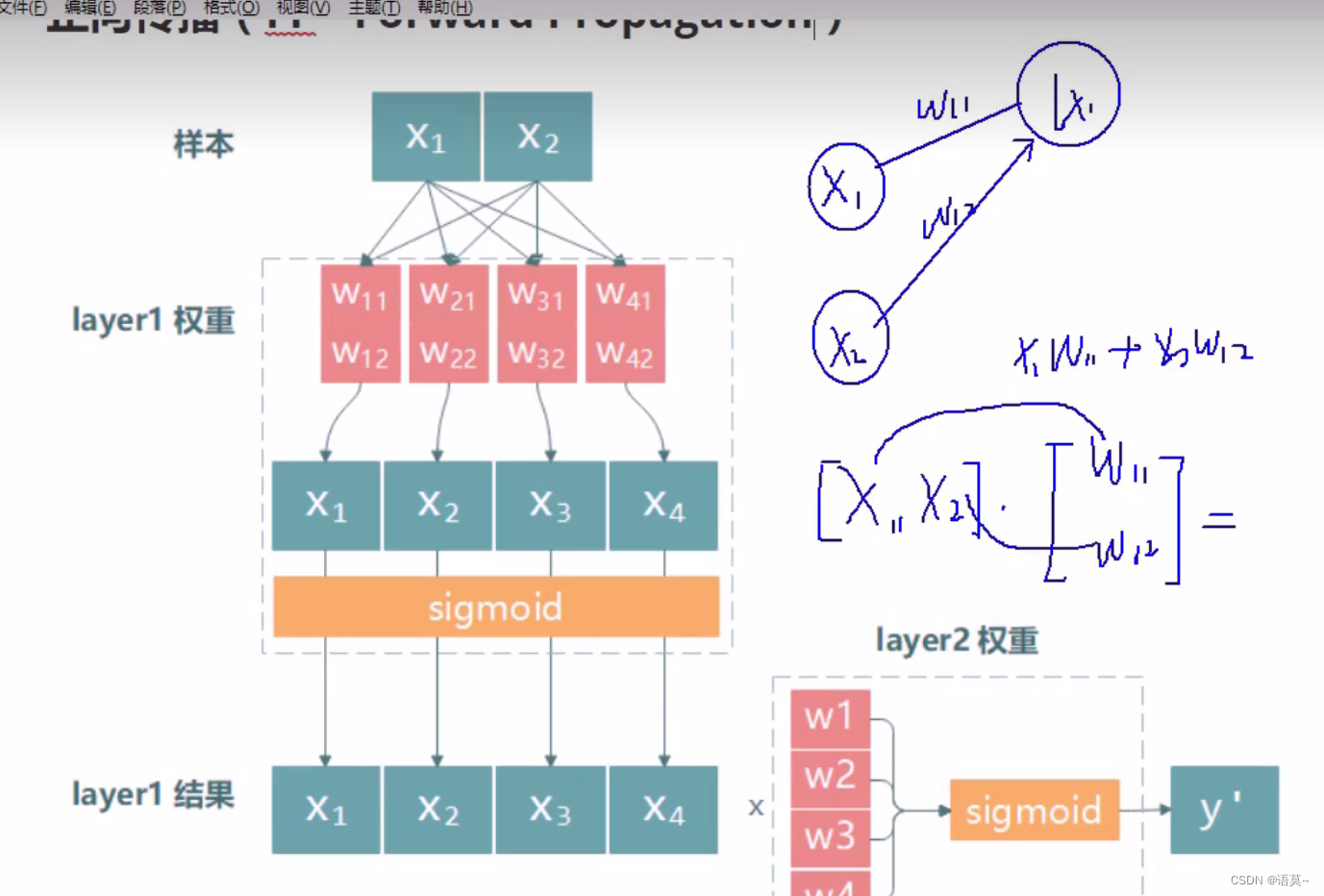

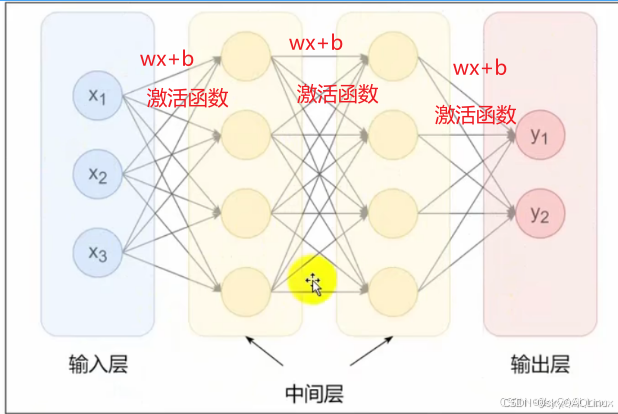

神经网络原理图

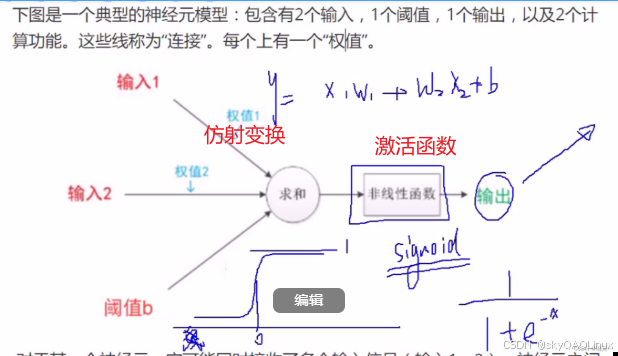

仿射变换和激活函数的使用

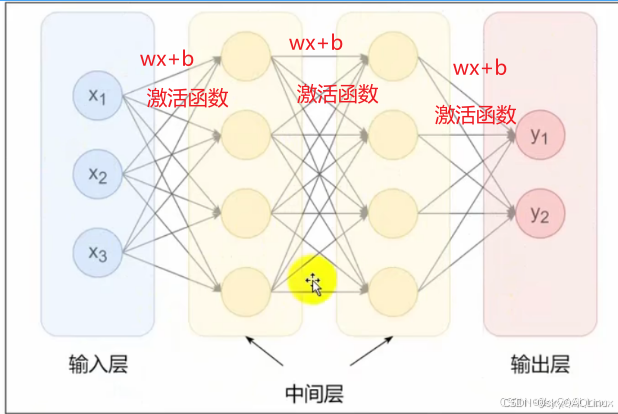

不同层级之间使用不同的激活函数

仿射变换:wx+b

激活函数:构造非线性关系

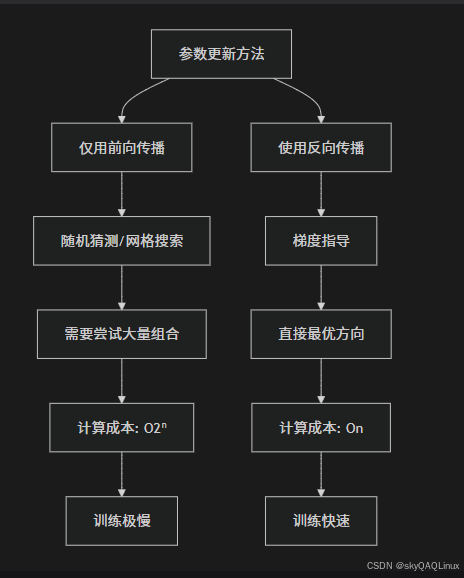

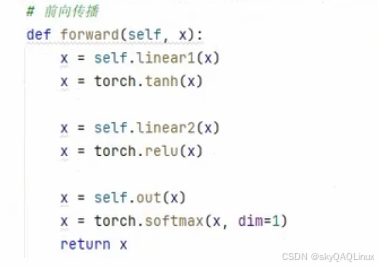

整体流程

前向传播 → 计算损失 → 反向传播(引入梯度下降) → 更新参数 → 再次前向传播

参数说明

深度学习

多层神经网络

pytorch实现深度学习

线性回归案例

步骤(86集)

1.构建数据

2.构建模型

3.定义损失函数和优化器(这里用于反向传播,计算损失和,梯度下降更新参数)

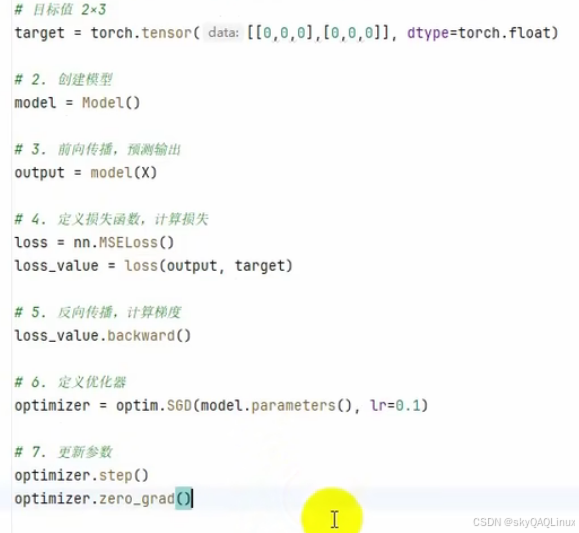

4.模型训练--->前向传播--->计算损失--->反向传播--->更新参数--->梯度清零

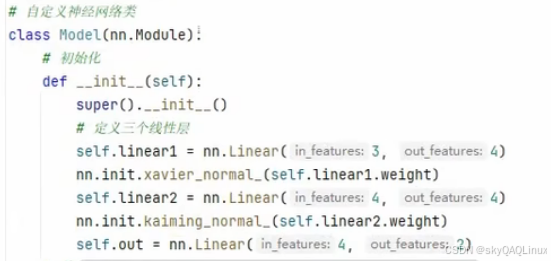

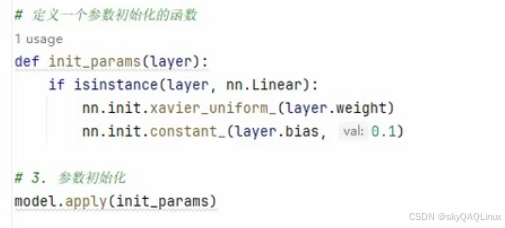

wb参数初始化

xavier和kaiming初始化:缓解梯度消失和梯度爆炸问题

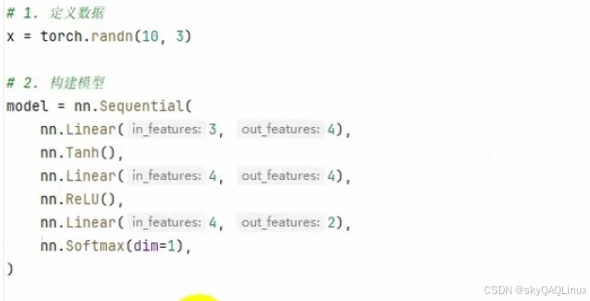

激活函数适用层级

回归问题输出层:不需要激活函数

分类问题的输出层:Sigmoid、Softmax

隐藏层常用激活函数:Tanh、ReLU

隐藏层=全连接层(仿射层,权重w和偏置b)+激活函数

优化方法,防止过拟合

随机失活dropout

层类型

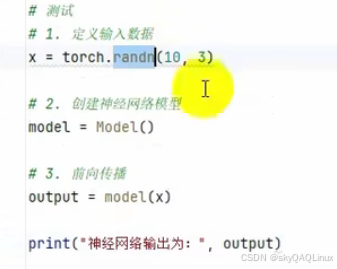

自定义神经网络模型,方式一

1.初始化隐藏层和参数

2.定义前向传播,参数传递给隐藏层和激活函数

3.调用模型输出

sequential定义神经网络模型,applay初始化,方式二

applay传递一个函数

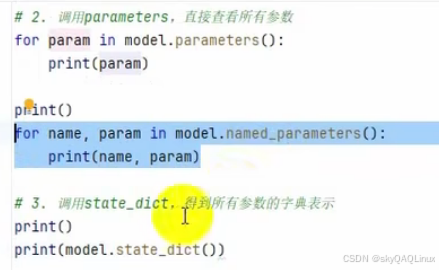

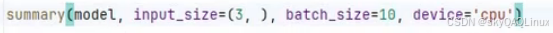

查看参数和模型结构

1.查看参数

2.查看模型结构

输入维度,x数量

模型训练工作流程

循环这个流程

房价预测,完整流程

1.特征工程

读取数据

去除无关列

划分特征和目标

划分训练集和测试集

按照特赠数据类型划分成数值型和类别型

数值型和类别型的数据标准化等处理

构建为tensor数据集

2.创建模型

定义层级结构

3.定义损失函数

4.模型的训练和测试

模型训练

(1)初始化权重偏执等参数相关操作

(2)定义优化器

(3)前向传播

(4)计算损失

(5)反向传播

(6)优化器更新参数

(7)梯度清零

模型测试

只进行前向传播相关操作