引言:目标检测的革命性突破

在计算机视觉领域,目标检测一直是一个核心且具有挑战性的任务。传统的目标检测方法往往需要复杂的多阶段处理流程,直到YOLO(You Only Look Once)系列的诞生,才真正实现了端到端的实时目标检测。YOLO系列以其独特的设计思想和卓越的性能,成为目标检测领域的重要里程碑。

YOLO-V1:开创性的单阶段检测方法

核心思想与设计理念

YOLO-V1的最大创新在于将目标检测问题重新定义为回归问题,实现了"You Only Look Once"的设计理念。与传统的两阶段检测方法不同,YOLO只需要一个CNN网络就能完成整个检测流程,极大地提高了检测速度,使其能够对视频进行实时检测。

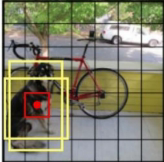

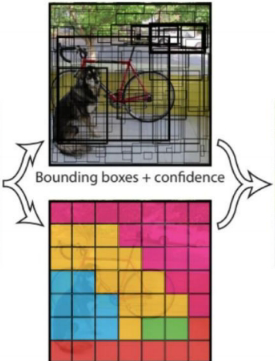

YOLO-V1的核心思想是将输入图像划分为S×S的网格,每个网格负责预测固定数量的边界框和类别概率。这种设计使得模型能够一次性完成所有检测任务。

网络架构与输出表示

YOLO-V1的网络架构基于修改的GoogLeNet模型,包含24个卷积层和2个全连接层。网络的输出维度为S×S×(B×5+C),其中:

-

S×S表示最终网格的大小(通常为7×7)

-

B表示每个网格预测的边界框数量(通常为2)

-

5表示每个边界框的参数(x, y, w, h, confidence)

-

C表示类别数量(PASCAL VOC数据集为20)

每个网格单元的预测可以表示为:10 = (x, y, h, w, c) × B(2个边界框),再加上20个类别的概率。

损失函数设计

YOLO-V1的损失函数是模型成功的关键,它综合考虑了定位误差和分类误差:

def yolo_loss(predictions, targets, S=7, B=2, C=20):

# 坐标损失(只考虑有物体的网格)

coord_loss = lambda_coord * sum(

[(predictions[..., 0:2] - targets[..., 0:2])**2 +

(predictions[..., 2:4].sqrt() - targets[..., 2:4].sqrt())**2]

)

# 置信度损失

obj_loss = (predictions[..., 4] - targets[..., 4])**2

no_obj_loss = lambda_noobj * (predictions[..., 4] - targets[..., 4])**2

# 分类损失

class_loss = (predictions[..., 5:] - targets[..., 5:])**2

return coord_loss + obj_loss + no_obj_loss + class_loss非极大值抑制(NMS)

由于每个目标可能被多个网格检测到,YOLO使用非极大值抑制来消除冗余的检测结果:

def nms(detections, threshold=0.5):

"""

非极大值抑制算法

"""

if len(detections) == 0:

return []

# 按置信度排序

detections = sorted(detections, key=lambda x: x[4], reverse=True)

keep = []

while detections:

# 取置信度最高的检测结果

current = detections.pop(0)

keep.append(current)

# 计算与剩余检测结果的IoU

detections = [

detection for detection in detections

if iou(current, detection) < threshold

]

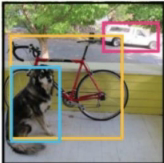

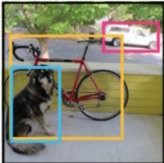

return keepYOLO-V1的优势与局限性

优势:

-

速度极快,能够实现实时检测

-

全局推理,背景误检率低

-

设计简单,端到端训练

局限性:

-

每个网格只能预测一个类别,难以处理重叠目标

-

小物体检测效果一般

-

边界框的长宽比选择有限

YOLO-V2:更快更强的检测器

Batch Normalization的引入

YOLO-V2的一个重要改进是全面引入Batch Normalization。V2版本舍弃了Dropout,在每个卷积层后都加入Batch Normalization:

class YOLOv2ConvBlock(nn.Module):

def __init__(self, in_channels, out_channels, kernel_size=3, stride=1):

super().__init__()

self.conv = nn.Conv2d(in_channels, out_channels,

kernel_size, stride, padding=1)

self.bn = nn.BatchNorm2d(out_channels)

self.leaky_relu = nn.LeakyReLU(0.1)

def forward(self, x):

return self.leaky_relu(self.bn(self.conv(x)))Batch Normalization的引入使得每一层的输入都进行了归一化处理,大大加快了模型的收敛速度,并将mAP提升了约2%。

高分辨率分类器

YOLO-V1在训练时使用224×224分辨率,测试时使用448×448,这种不一致可能导致性能下降。YOLO-V2改进了这一设计:

-

先在224×224分辨率上训练分类网络

-

然后使用448×448分辨率进行10个epoch的微调

-

这种高分辨率分类器使mAP提升了约4%

DarkNet-19网络架构

YOLO-V2采用了新的主干网络DarkNet-19,具有以下特点:

-

输入分辨率为416×416

-

包含19个卷积层和5个最大池化层

-

没有全连接层,5次降采样后得到13×13的特征图

-

使用1×1卷积来减少参数数量

class DarkNet19(nn.Module):

def init(self, num_classes=1000):

super().init()

self.features = nn.Sequential(

# 初始卷积层

nn.Conv2d(3, 32, 3, 1, 1), nn.LeakyReLU(0.1),

nn.MaxPool2d(2, 2),# 后续卷积块 YOLOv2ConvBlock(32, 64), nn.MaxPool2d(2, 2), YOLOv2ConvBlock(64, 128), YOLOv2ConvBlock(128, 64, 1), YOLOv2ConvBlock(64, 128), nn.MaxPool2d(2, 2), # ... 更多层 )

先验框的聚类分析

YOLO-V2创新性地使用K-means聚类来提取更适合数据集的先验框比例。距离度量采用:

d(box,centroids)=1−IOU(box,centroids)这种方法相比Faster R-CNN中手工设定的先验框比例更加数据驱动,能够更好地适应特定数据集的目标分布。

Anchor Box机制

通过引入Anchor Boxes,YOLO-V2显著增加了预测的边界框数量(13×13×n)。与Faster R-CNN不同的是,YOLO-V2的先验框不是直接按照固定长宽比给定,而是通过聚类分析得到。

定向位置预测

YOLO-V2改进了边界框的位置预测方法,解决了直接预测偏移量可能导致的不稳定问题:

def decode_predictions(predictions, anchors, grid_size):

"""

解码YOLO-V2的预测结果

"""

batch_size, _, grid_h, grid_w = predictions.shape

# 预测值包括tx, ty, tw, th, confidence, class_prob

predictions = predictions.view(batch_size, len(anchors), -1, grid_h, grid_w)

# 应用sigmoid到中心点偏移量

bx = torch.sigmoid(predictions[..., 0]) + grid_x # grid_x是网格坐标

by = torch.sigmoid(predictions[..., 1]) + grid_y

# 应用指数函数到宽高缩放

bw = anchors[..., 0] * torch.exp(predictions[..., 2])

bh = anchors[..., 1] * torch.exp(predictions[..., 3])

return bx, by, bw, bh例如,当预测值为(σtx, σty, tw, th) = (0.2, 0.1, 0.2, 0.32),先验框为pw=3.19275, ph=4.00944时,最终边界框的计算考虑了相对网格的偏移量,使得训练更加稳定。

感受野的理解与应用

感受野是卷积神经网络中的重要概念,表示特征图上的点能够看到的原始图像区域大小。YOLO-V2深入利用了感受野的特性:

小卷积核的优势:

-

堆叠3个3×3卷积核的感受野与1个7×7卷积核相同(7×7)

-

参数数量对比:

-

7×7卷积核:C×(7×7×C)=49C2

-

3个3×3卷积核:3×(C×3×3×C)=27C2

-

小卷积核不仅参数更少,还能引入更多的非线性变换,使特征提取更加细致。

细粒度特征融合

为了解决深层网络中小目标丢失的问题,YOLO-V2引入了细粒度特征融合机制:

通过将13×13×1024的特征图与之前层的特征图进行融合,保留了更多的细节信息,显著提升了小目标的检测性能。

多尺度训练

YOLO-V2充分利用了全卷积网络的特性,支持多尺度训练:

def multi_scale_training(model, optimizer, dataloader, scales=[320, 352, 384, 416, 448, 480, 512, 544, 576, 608]):

"""

多尺度训练策略

"""

for epoch in range(num_epochs):

# 每10个batch改变一次输入尺度

if batch_idx % 10 == 0:

scale = random.choice(scales)

# 调整网络输入尺寸

adjust_input_size(model, scale)

# 正常训练步骤

for images, targets in dataloader:

# 调整图像到当前尺度

scaled_images = F.interpolate(images, size=scale)

outputs = model(scaled_images)

loss = compute_loss(outputs, targets)

optimizer.zero_grad()

loss.backward()

optimizer.step()多尺度训练使模型能够适应不同大小的输入图像,最小尺度为320×320,最大尺度为608×608,极大地增强了模型的鲁棒性。

技术对比与性能分析

YOLO-V1 vs YOLO-V2 主要改进

| 特性 | YOLO-V1 | YOLO-V2 |

|---|---|---|

| 主干网络 | 基于GoogLeNet | DarkNet-19 |

| 归一化 | 无 | Batch Normalization |

| 输入分辨率 | 固定448×448 | 多尺度训练 |

| 先验框 | 手工设计 | K-means聚类 |

| 特征融合 | 无 | 细粒度特征融合 |

| mAP(VOC2007) | 63.4% | 78.6% |

| 速度(FPS) | 45 | 67 |

实际应用效果

YOLO-V2在实际应用中表现出色,不仅检测精度大幅提升,检测速度也进一步加快,真正实现了精度与速度的平衡。

实践建议与最佳实践

模型选择策略

-

实时性要求高:选择YOLO-V2基础版本

-

精度要求高:使用YOLO-V2的多尺度训练版本

-

资源受限:可以考虑更小的输入尺度(如320×320)

训练技巧

-

学习率调度:使用余弦退火或阶梯式下降

-

数据增强:结合随机裁剪、颜色抖动等增强策略

-

正则化:合理使用Batch Normalization和权重衰减

部署优化

-

模型量化:对训练好的模型进行量化,减少存储和计算需求

-

硬件加速:利用GPU、TPU等硬件加速推理过程

-

边缘部署:针对移动设备进行模型轻量化

结论与展望

YOLO系列目标检测算法通过创新的设计思想和持续的技术改进,为目标检测领域带来了革命性的变化。从YOLO-V1的简单直接到YOLO-V2的精细优化,这一系列算法展现了深度学习在计算机视觉领域的强大潜力。

YOLO-V2通过引入Batch Normalization、高分辨率训练、先验框聚类、细粒度特征融合和多尺度训练等一系列创新技术,显著提升了检测精度和鲁棒性,同时保持了优秀的实时性能。

随着技术的不断发展,YOLO系列后续版本(V3、V4、V5等)在V2的基础上进一步优化,但YOLO-V2的核心创新思想仍然对整个目标检测领域产生着深远影响。掌握YOLO-V2的技术原理和实践方法,对于深入理解现代目标检测算法具有重要意义。