安装Pytorch GPU+CPU版本

- 一、检查环境

- 二、安装Pytorch

- [三、验证【GPU 版】](#三、验证【GPU 版】)

本文方案为 只用驱动 + GPU 版 PyTorch 。

一、检查环境

1.检查CUDA版本

在命令行(CMD 或 PowerShell)运行:

nvidia-smi如果你看到 NVIDIA 驱动信息(例如 RTX 3060、CUDA Version 12.8),说明显卡驱动安装正常。

如果这个命令报错,说明 NVIDIA 驱动都没装好,请先安装驱动。

正常输出示例:

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 573.24 Driver Version: 573.24 CUDA Version: 12.8 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Driver-Model | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA GeForce RTX 5060 ... WDDM | 00000000:01:00.0 On | N/A |

| N/A 48C P4 14W / 115W | 1697MiB / 8151MiB | 1% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

+-----------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=========================================================================================|这里可以看到CUDA型号,如:12.8。

2.检查Python版本

打开命令行输入:

python --version输出:

Python 3.12.10二、安装Pytorch

1.pip下载安装

官方链接:https://pytorch.org/get-started/locally/

清华源:

pip install torch torchvision torchaudio --no-cache-dir -i https://pypi.tuna.tsinghua.edu.cn/simple1.1GPU版本安装

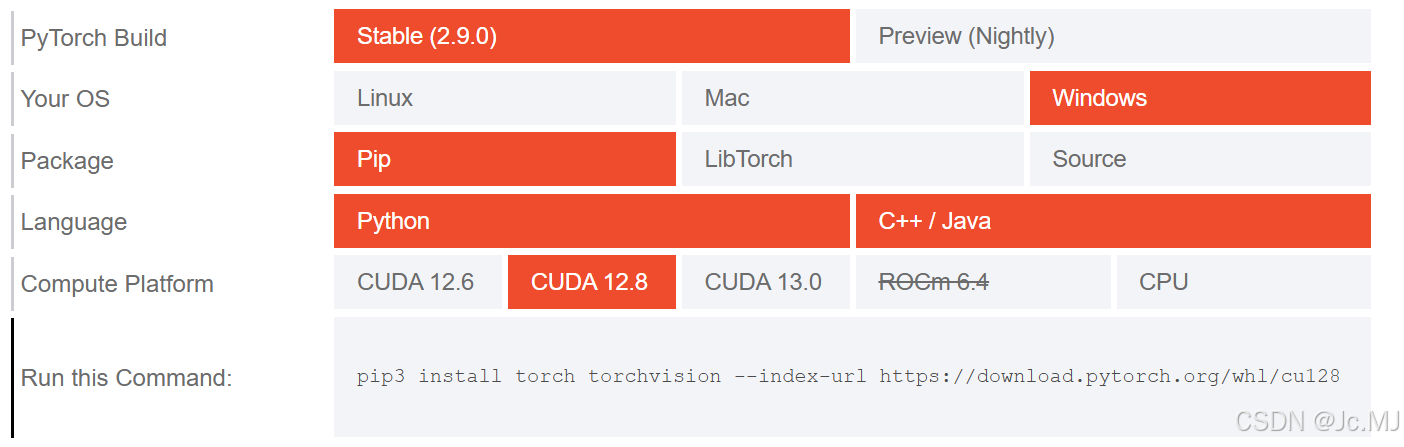

在这里选择对应的CUDA版本即可生成pip指令,在PyCharm的终端里直接运行即可安装成功。

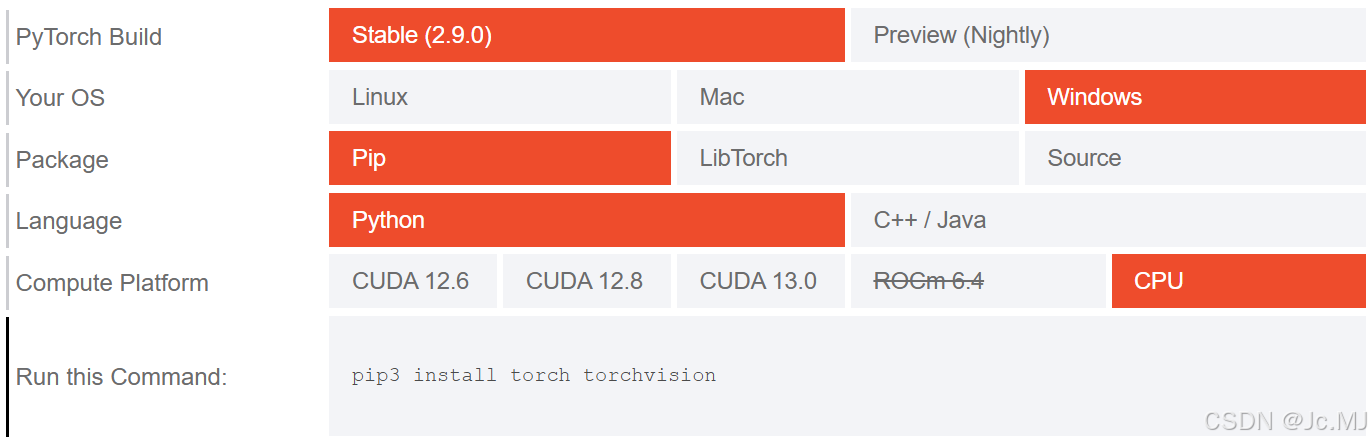

1.2CPU版本安装

直接选择CPU即可。

2.pip本地安装【GPU版本】

在国内使用生成的pip指令大概率是连不通的,尝试使用镜像源发现,似乎这会默认安装 CPU 版(可能是因为 PyPI 不区分 CUDA)。

所以这里提供第二种方案:使用pip指令本地安装。

2.1下载.whl文件

打开 PyTorch 官方下载页面:https://download.pytorch.org/whl/cu128/

这个链接就是在[二、1.1]中生成的pip指令末尾的链接,本文以CUDA12.8为示例。

2.2选择对应版本

示例:

| 文件名 | 系统 | Python版本 | GPU支持 | 说明 |

|---|---|---|---|---|

torch-2.7.0+cu128-cp310-cp310-win_amd64.whl |

✅ Windows | 3.10 | ✅ CUDA 12.8 | 适合RTX + Windows |

torch-2.7.0+cu128-cp310-cp310-manylinux_2_28_x86_64.whl |

✅ Linux | 3.10 | ✅ CUDA 12.8 | 服务器或 WSL 上用 |

torch-2.7.0+cu128-cp310-cp310-manylinux_2_28_aarch64.whl |

✅ Linux ARM | 3.10 | ✅ CUDA 12.8 | Jetson、树莓派等 ARM 平台 |

torch-2.4.1+cpu-cp38-cp38-win_amd64.whl |

✅ Windows | 3.8 | ❌ CPU only | 无 GPU 加速版 |

跟据自己的CUDA版本和Python版本选择匹配的文件,比如:

torch-2.4.1+cu128-cp38-cp38-win_amd64.whl

torchvision-0.19.1+cu128-cp38-cp38-win_amd64.whl

torchaudio-2.4.1+cu128-cp38-cp38-win_amd64.whl2.3安装

下载后放在同一目录下,然后在该目录中执行:

pip install torch-2.4.1+cu128-cp38-cp38-win_amd64.whl

pip install torchvision-0.19.1+cu128-cp38-cp38-win_amd64.whl

pip install torchaudio-2.4.1+cu128-cp38-cp38-win_amd64.whl这样就能在离线环境下成功安装 GPU 版。

三、验证【GPU 版】

安装完后运行 Python:

python

import torch

print("PyTorch 版本:", torch.__version__)

print("CUDA 版本:", torch.version.cuda)

print("CUDA 是否可用:", torch.cuda.is_available())

print("GPU 数量:", torch.cuda.device_count())

print("当前 GPU 名称:", torch.cuda.get_device_name(0) if torch.cuda.is_available() else "无 GPU")根据输出即可确认是否正确安装。