本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

Google发布的《Agents》白皮书,为AI Agent的工程化实践提供了系统性的技术框架。作为一线开发者,我们需要的不是概念解释,而是可操作的技术方案。本文基于白皮书内容,结合实际开发经验,为Agent应用开发者提供从架构设计到生产部署的完整技术路径。

如果你正在或计划开发Agent应用,这篇文章将帮你避开常见的技术陷阱,选择合适的架构模式。

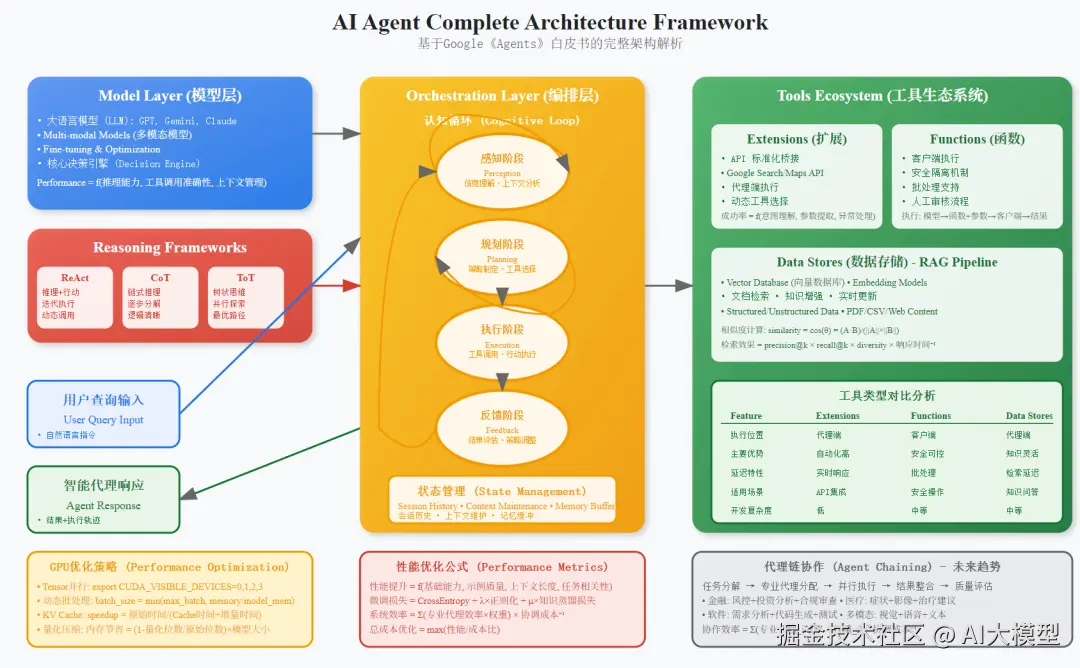

Agent的核心架构分为三个关键部分:模型、工具和编排层。

1. 模型层(Model)

这是Agent的"大脑",负责核心决策。它可以是单个模型,也可以是多个模型的组合,例如使用一个模型负责规划,另一个模型负责执行,还有一个模型负责评估,以达到更好的性能。为了让模型更好地适应Agent任务,可以通过提供示例来对其进行微调,以展示其能力和工具使用方式。

2. 工具层(Tools)

工具是Agent与外部世界交互的"手脚"。它们弥补了模型无法直接感知和影响现实世界的局限性。白皮书详细介绍了三种核心工具类型:

- • Extensions(扩展) :它以标准化的方式连接Agent和外部API,让Agent能够无缝地执行API调用。Agent会根据用户查询、可用扩展和历史上下文来动态选择最合适的API。

- • Functions(函数) :这种模式将API的执行逻辑从Agent端转移到了客户端。模型仅输出函数名称和参数,而不进行实际的API调用。这种方式让开发者对数据流和执行流程有了更精细的控制,特别适用于对安全、认证或时序有严格要求的场景。

- • Data Stores(数据存储) :通过向量数据库实现检索增强生成(RAG),为Agent提供了访问动态、实时知识的能力。它通过将用户查询、文档等转换为向量嵌入(embeddings),然后进行相似度匹配,从而检索相关信息并提供给模型,使其能够生成基于事实的回答。

3. 编排层(Orchestration Layer)

这是Agent的"思维过程",它定义了Agent如何进行推理、规划和决策。它是一个循环过程,接收信息、进行内部推理,并基于推理结果采取下一步行动或决策。

白皮书提到了几种主流的推理框架:

- • ReAct(Reasoning and Action) :这是一种提示工程框架,它让模型能通过"思考"和"行动"的循环来解决问题。Agent先进行内部思考(Thought),然后采取行动(Action),并从行动中获得观察结果(Observation),最后根据观察结果进行下一轮的思考和行动,直至得出最终答案。

- • Chain-of-Thought(CoT) :通过中间步骤来引导模型的推理过程,让复杂问题分解为更简单的子问题。

- • Tree-of-Thoughts(ToT) :这是一种更高级的框架,它允许模型探索多条"思维链",适用于需要探索和战略性预判的任务。

Agent vs 传统LLM应用:核心差异与技术选型

技术架构的本质区别

传统LLM应用本质上是"问答系统":用户提问→模型推理→返回结果。而Agent是"任务执行系统":接收目标→制定计划→调用工具→执行任务→反馈调整。

这种本质上的差异,导致了两种应用在技术架构上的巨大分歧:

| 维度 | 传统LLM应用 | AI Agent |

|---|---|---|

| 知识范围 | 局限于训练数据 | 通过工具访问实时信息 |

| 交互模式 | 单次问答,无状态 | 多轮对话,有状态管理 |

| 执行能力 | 仅文本生成 | 可调用外部API、函数、数据库 |

| 推理架构 | 依赖提示工程 | 内置认知架构,多步推理 |

简而言之,Agent的能力是模型的超集。它在模型之上,构建了一套完整的感知-规划-执行-反馈循环。

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。