斯坦福大学,SambaNova系统和加州大学伯克利分校的研究人员提出了Agentic上下文工程 Agentic Context Engineering(ACE),一个新的框架,旨在通过不断发展的结构化上下文而不是权重更新来改进大型语言模型 (llm)。

ACE是一种让大模型不通过修改内部参数(即不微调),而是通过动态优化和演化其输入的上下文来实现自我提升的新范式。你可以把它想象成模型在不断地为自己编写和更新一本越来越厉害的"战术手册"或"操作手册"。

它主要为了解决传统上下文优化方法中的两大痛点:

-

简洁性偏差:模型为了追求简短而丢失关键细节。

-

上下文坍缩:在多轮迭代中,有用的上下文信息被越压越短,导致性能急剧下降。

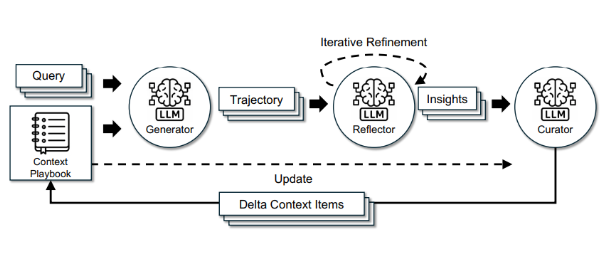

ACE如何工作?三大核心角色

ACE框架通过一个分工明确的三角色循环来实现上下文的自我演化:

-

生成器:像"球员"一样,基于当前的"战术手册"(上下文)去执行任务、生成答案。

-

反思器:像"教练"回看比赛录像,分析生成器的成功与失误,从中提炼出经验教训。

-

整理器:像"战术分析师",将反思器提炼出的新策略,以结构化的方式(称为"Delta Bullets")增量更新到"战术手册"中,而不是重写整个手册,从而有效避免上下文坍缩。

这个循环使得模型的上下文不再是静态的提示词,而是一个能够持续学习、生长和精炼的动态知识库。

ACE vs. 模型微调:核心差异一览

与传统的提示优化或模型微调相比,ACE在这种专业场景下的优势非常明显:

-

告别"上下文坍缩":传统方法让模型自己重写提示,很容易导致关键信息在迭代中被压缩、丢失(即"上下文坍缩")。而ACE的增量更新机制确保了宝贵的领域知识只增不减,得以持续积累。

-

成本与效率:ACE通过动态优化上下文来提升性能,无需重新训练模型(微调)。研究指出,这种方法在提升效果的同时,平均使适应延迟降低了86.9%,显著节约了计算成本。

-

可解释性与可控性:整个"作战手册"以及其中的每一条策略对人类开发者来说都是可读、可审计、可管理的。如果发现某条策略有问题,可以方便地回滚或修改,这大大增强了系统的可靠性和透明度。

为了更清晰地对比,我将它们的核心差异整理成了下面的表格:

| 维度 | ACE (Agentic Context Engineering) | 模型微调 (Fine-Tuning) |

|---|---|---|

| 工作原理 | 优化模型的输入上下文,不改变模型本身 | 更新模型的内部权重参数 |

| 核心优势 | 快速灵活:实时适应,可解释性强,成本低 | 深度改变:能从根本上调整模型的行为与风格 |

| 主要瓶颈 | 依赖基础模型的能力天花板 | 成本高昂:需要数据、算力,周期长,易遗忘旧知识 |

ACE能否完全取代微调?

这是一个关键问题。基于当前信息,结论是:ACE无法完全取代微调,二者是互补而非替代关系。

"微调已死"的说法更多是一种吸引眼球的表述,用以强调ACE范式的革命性。它们有各自最适合的应用场景:

-

ACE的用武之地:ACE非常适合需要快速适应、持续学习且对成本敏感的场景。

-

AI智能体:让智能体在复杂环境中通过试错自我进化,学习使用工具的策略。

-

领域知识快速注入:在金融、法律等领域,无需重新训练就能将最新的规则和案例纳入上下文,实现性能提升。

-

个性化应用:为每个用户维护一套独立演进的操作偏好手册。

-

-

微调依然关键:当需要改变模型底层能力或知识结构时,微调仍是不可或缺的手段。

-

学习全新知识或技能:比如让一个通用模型掌握一门它从未接触过的专业语言或领域。

-

塑造风格与价值观:从根本上让模型的输出风格(如严谨的医疗报告、活泼的客服语调)或价值观与目标对齐。

-

极端压缩与效率:将大模型的能力蒸馏到小模型中,以便在资源受限的边缘设备上部署。

-

与传统的提示优化或模型微调相比,ACE在这种专业场景下的优势非常明显:

-

告别"上下文坍缩":传统方法让模型自己重写提示,很容易导致关键信息在迭代中被压缩、丢失(即"上下文坍缩")。而ACE的增量更新机制确保了宝贵的领域知识只增不减,得以持续积累。

-

成本与效率:ACE通过动态优化上下文来提升性能,无需重新训练模型(微调)。研究指出,这种方法在提升效果的同时,平均使适应延迟降低了86.9%,显著节约了计算成本。

-

可解释性与可控性:整个"作战手册"以及其中的每一条策略对人类开发者来说都是可读、可审计、可管理的。如果发现某条策略有问题,可以方便地回滚或修改,这大大增强了系统的可靠性和透明度。

简单来说,ACE让一个"聪明的员工"学会了使用更高效的工作手册,而微调则是重新塑造一个"员工的专长和性格"。前者更快、更灵活,后者更根本、更彻底。

总结与展望

总的来说,Agentic Context Engineering (ACE) 代表了一个非常激动人心的方向:让大模型通过优化与环境的交互界面(上下文)来实现自我进化,这大大降低了AI应用的门槛和成本。

虽然它因无需更新参数、成本低、可解释性强等优势,在许多场景下比微调更具吸引力,但它并没有突破基础模型本身的能力边界。未来,我们更可能看到的是微调与ACE的结合:先通过微调得到一个强大的领域基础模型,再通过ACE让它在实际使用中不断自我优化和个性化,从而发挥出最大的效能。