共绩算力赋能大模型:QWEN-2.5-7B云部署实战解析

摘要

本文详细介绍了在共绩算力平台上部署通义千问2.5-7B-Instruct大模型的全流程实践。共绩算力作为清华背景创业团队打造的创新平台,通过整合全国分散的闲置算力资源(包括个人电脑、网吧空闲机时和企业未充分利用的算力),构建了极具价格优势的算力网络。平台提供两种核心服务:适合长期开发的Server云主机(4090单卡仅1.68元/小时,关机环境持久保存)和面向生产的Serverless弹性部署(秒级冷启动,零运维)。文章详细记录了从算力选择、镜像配置到模型下载、基准测试的完整过程,实测证明单张4090显卡即可高效运行7B级别大模型,为AI开发者提供了高性价比的云部署方案。

共绩算力

平台概述

共绩科技 2023 年成立于清华,专注于构建融合算力与电力的智能调度网络,旨在提供平价、可靠、绿色的算力服务,使 AI 技术真正普及至每个人。通过精细调度算法,已为多家 AIGC 领军企业及科研机构提供高效算力,目标提升资源利用率 60%。作为一群清华背景的年轻创新者,我们在 2023 年秋季获得奇绩创坛等投资,正引领算力革命,开启普惠科技新篇章。

核心功能

共绩算力平台为开发者和企业提供两大核心服务模式:Server 云主机 和 Serverless 弹性部署,满足不同场景下的算力需求。

Server 云主机

专为需要稳定、持久开发环境的用户设计。平台拥有上万块高性能4090显卡随时待命,让每个开发者都能轻松拥有顶级算力,无需为数万元的硬件投入望而却步。

核心优势:

- 告别硬件投资:无需购买昂贵的GPU服务器,按需租用即可。

- 环境永久保存:关机后开发环境不会丢失,下次开机即恢复,省去重复搭建环境的烦恼。

- 专注代码开发:将精力完全集中在算法和业务逻辑上,而非基础设施管理。

关键参数:

- 10万+ 显卡数量:海量资源池,保障随时可用。

- 1.68元/时 起步价:极具竞争力的价格,让高性能计算触手可及。

- 关机保存 持久化:支持关机状态下的环境持久化,保障开发连续性。

适用场景:

- 开发测试

- 学习训练

- 长期项目研发

选择 Server 云主机,当您面临以下困扰时:

- 每次重新搭建开发环境太麻烦

- 需要一个稳定的长期开发环境

- 不需要对外提供在线服务

Serverless 弹性部署

面向生产级应用和流量波动场景,提供零运维、秒级冷启动的极致体验。写完代码,10秒内即可上线,按实际使用量付费,真正做到"用多少付多少",实现0运维成本。

核心优势:

- 告别运维烦恼:无需关心服务器运维、扩容、监控等底层问题。

- 弹性应对流量:智能自动扩缩容,从容应对突发流量高峰。

- 专注产品开发:开发者只需关注产品本身,基础设施由平台全权托管。

关键指标:

- 99.9% 可用性:高可靠性保障线上服务稳定运行。

- 秒级冷启动:从代码提交到服务上线仅需10秒,响应迅速。

- 0运维 零负担:无服务器管理负担,释放团队生产力。

适用场景:

- 生产服务部署

- 突发流量应对(如营销活动、热点事件)

- 在线用户访问服务

选择 Serverless 弹性部署,当您面临以下挑战时:

- 担心突发流量导致服务宕机

- 不想花时间在服务器运维上

- 希望严格控制云服务成本

无论是追求环境稳定、适合长期开发的 Server 云主机 ,还是追求极致效率、零运维负担的 Serverless 弹性部署,共绩算力平台都提供了针对性强、性价比极高的解决方案,帮助开发者和企业摆脱基础设施束缚,专注于价值创造。

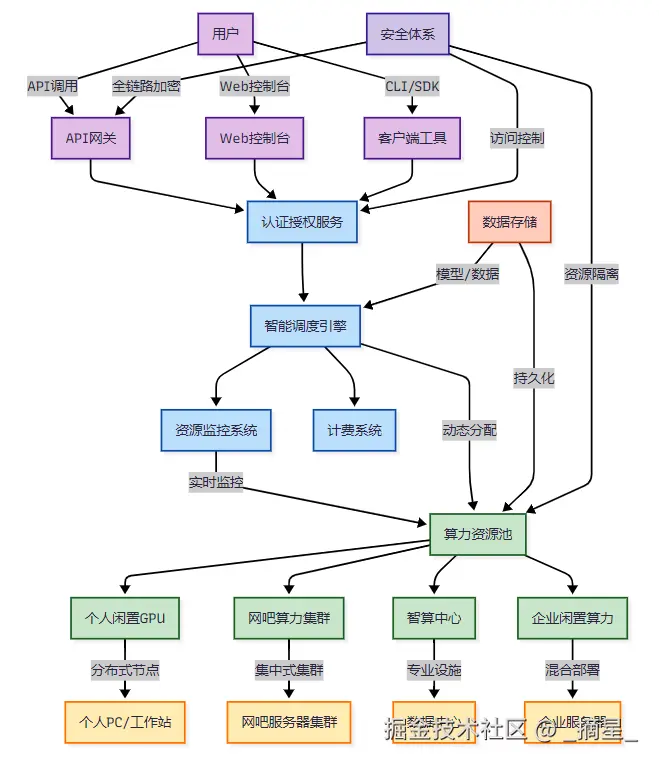

技术架构

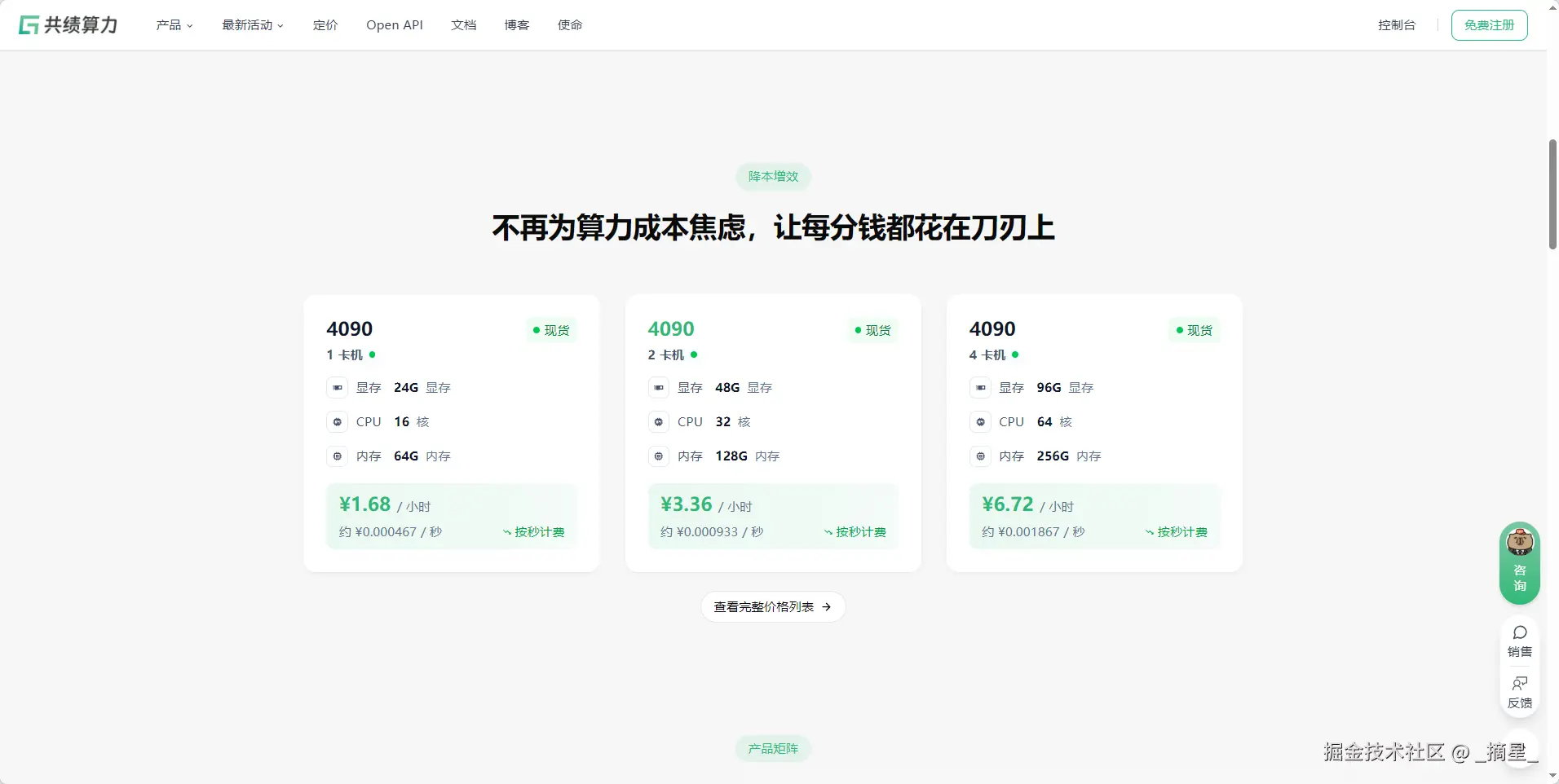

降本增效

共绩算力平台的核心优势之一在于其极具竞争力的价格体系,真正实现了"降本增效",让每一分钱都花在刀刃上。与传统云服务商动辄数十元甚至上百元每小时的GPU算力相比,共绩平台提供的4090显卡算力价格低至1.68元/小时(单卡) ,双卡配置仅需3.36元/小时 ,四卡集群也仅为6.72元/小时。这种按秒计费的精细化模式,意味着用户只需为实际使用的每一秒付费,避免了传统按小时计费带来的资源浪费和成本冗余。

更重要的是,这些价格背后是平台创新的商业模式------通过整合全国范围内的个人闲置电脑、网吧空闲机时以及企业未充分利用的算力资源,构建了一个庞大的分布式算力网络。这种"共享经济"模式大幅降低了基础设施的边际成本,从而将节省下来的费用直接回馈给终端用户。无论是AI初创团队进行模型训练,还是个人开发者部署推理服务,都能以极低的成本获得高性能的4090 GPU算力支持,彻底告别"算力焦虑",把宝贵的预算集中投入到核心算法研发和业务创新上,而非昂贵的硬件投入或云服务账单中。

平台对比分析

| 对比维度 | 共绩算力平台 | 传统云服务商 | 自建GPU集群 |

|---|---|---|---|

| 成本模式 | 按秒级精准计费,只为使用时间付费 | 按小时/月计费,存在资源浪费 | 高额前期投入,固定成本高 |

| 资源弹性 | 秒级扩容缩容,动态适应业务需求 | 分钟级扩容,存在一定延迟 | 无法弹性扩展,需提前规划 |

| 资源来源 | 整合全国分散闲时算力,包括个人/网吧/智算中心 | 自有数据中心,资源集中 | 企业自购硬件,资源固定 |

| 部署速度 | 3分钟快速部署AI服务 | 10-30分钟创建实例 | 数天到数周的部署周期 |

| 技术门槛 | 一站式GPU开发环境,降低配置复杂度 | 需要一定云服务使用经验 | 需要专业运维团队支持 |

| 绿色节能 | 利用闲置算力,提高资源利用率,更环保 | 数据中心能耗较高 | 能源利用率低,存在浪费 |

| 适用场景 | AI推理/训练、科研计算、临时高算力需求 | 通用云计算、企业应用 | 长期稳定的大规模计算需求 |

| 价格优势 | 价格更低,性价比高 | 价格中等,按量付费 | 长期使用成本高 |

魔搭社区和通义千问2.5-7B-Instruct

概述

魔搭社区(ModelScope)是阿里巴巴推出的模型开放平台 ,致力于打造"模型即服务(MaaS)"的生态体系。该平台提供海量高质量机器学习和深度学习模型,覆盖自然语言处理、计算机视觉、语音识别、多模态等多个技术领域。

魔搭社区核心特点:

- 模型丰富:汇聚数千个开源模型,包括阿里自研模型及社区贡献模型

- 开箱即用:提供一键推理、在线体验、Notebook实例等功能,降低使用门槛

- 全链路支持:从模型探索、训练、推理到部署,提供完整工具链

- 社区活跃:支持模型分享、评测、讨论,促进AI技术交流与创新

- 企业级能力:支持私有化部署、模型定制和商业化服务

魔搭不仅是模型仓库,更是连接模型开发者与使用者的桥梁,推动AI技术的普惠化和产业化。

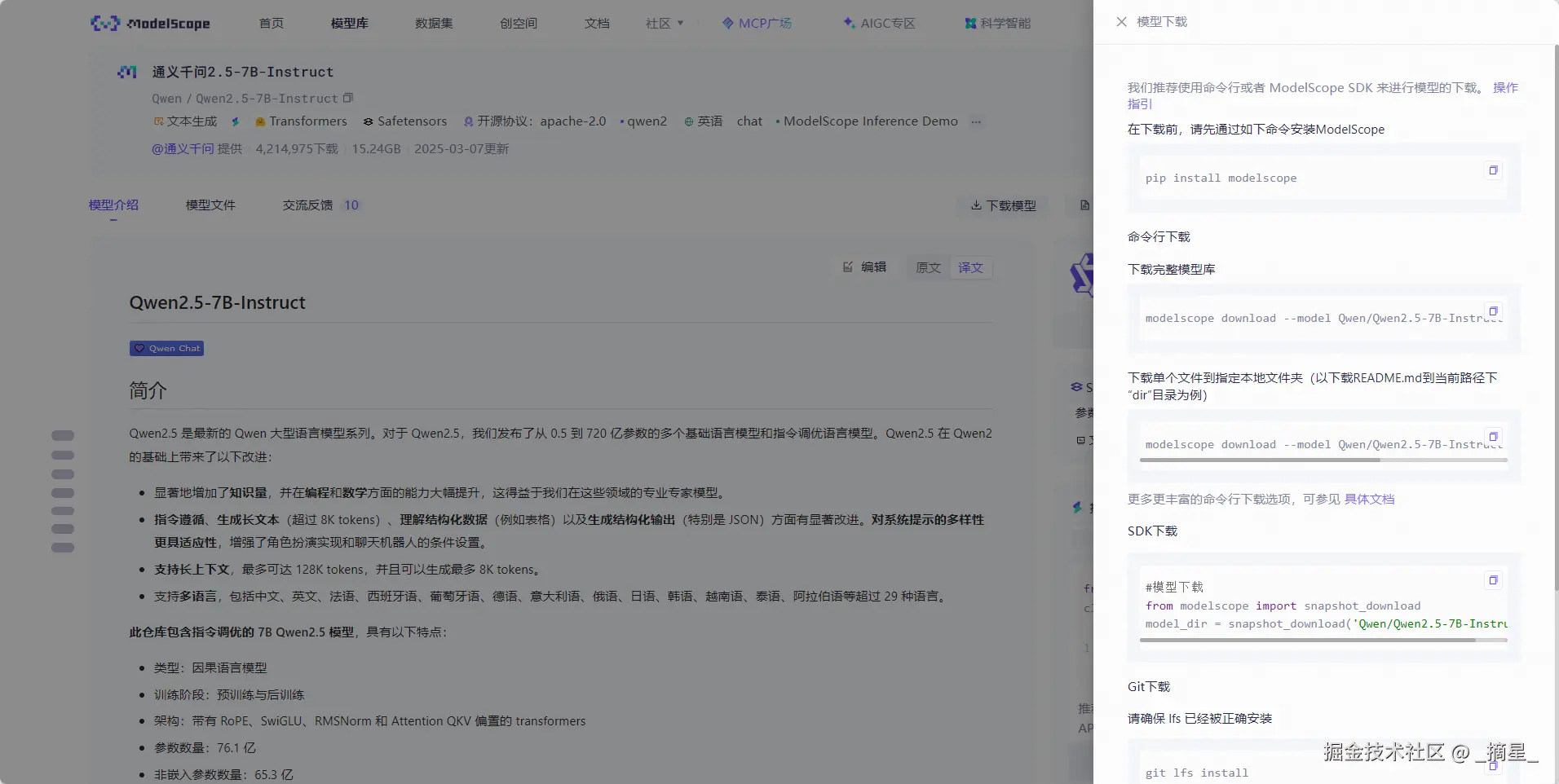

通义千问2.5-7B-Instruct模型下载指南

在魔搭社区模型库中找到通义千问2.5-7B-Instruct并进入详情

按照官方给出的下载模型配置待会到共绩算力平台中进行部署

云主机部署实践

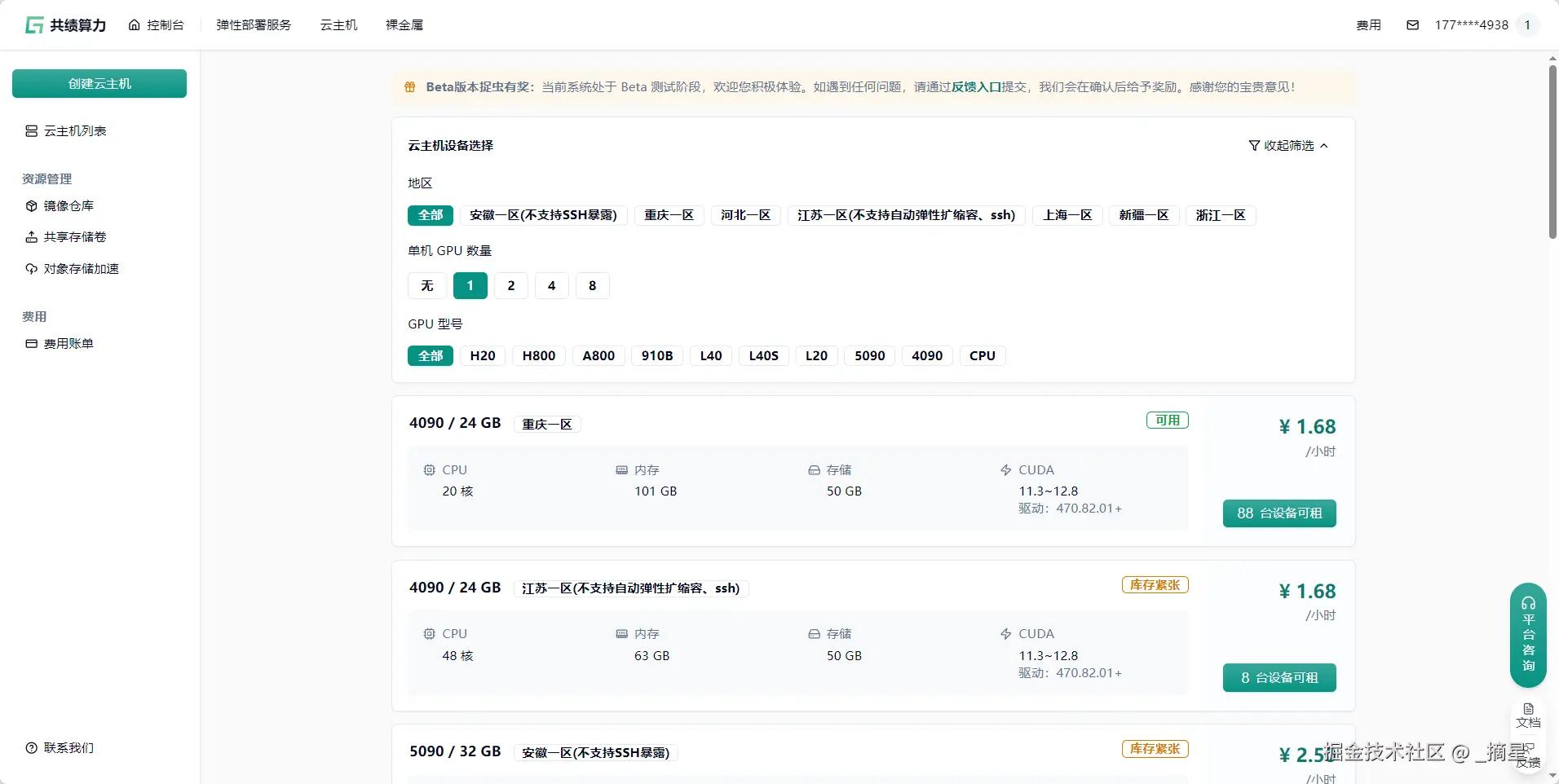

算力选择

进入共绩算力云主机页面中:console.suanli.cn/server

可以看到价格和算力性价比真的是十分高,这里分别展示1核、2核、4核、8核的价格对比

那么我们之类选择单核即可

镜像选择

共绩算力的基础镜像中为我们提供了三种框架的选择

我们这里的配置如下:

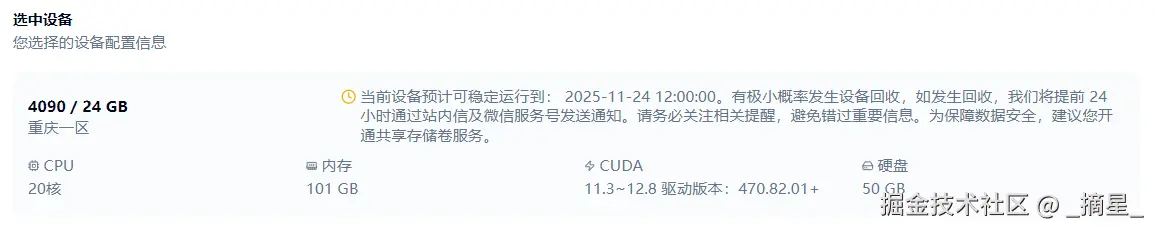

🖥️ 云服务器实例配置详情

| 配置类别 | 详细参数 |

|---|---|

| 设备型号 | NVIDIA GeForce RTX 4090 / 24GB 显存 |

| 所属区域 | 重庆一区 |

| CPU 核心数 | 20 核 |

| 内存容量 | 101 GB |

| CUDA 支持 | 11.3 ~ 12.8(驱动版本:470.82.01+) |

| 系统硬盘 | 50 GB |

🐍 系统镜像配置

| 组件类型 | 版本/规格 |

|---|---|

| 框架名称 | PyTorch |

| 框架版本 | 2.7.1 |

| Python 版本 | 3.12 (Ubuntu 22.04) |

| CUDA 版本 | 12.8 |

| 镜像类型 | 基础镜像(含深度学习框架、Miniconda等常用工具) |

同时共绩算力中还提供了社区用户自己开发的镜像,我也会在后续的文章中进行试用

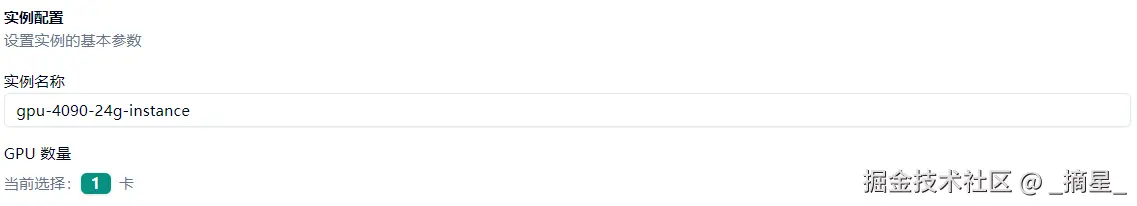

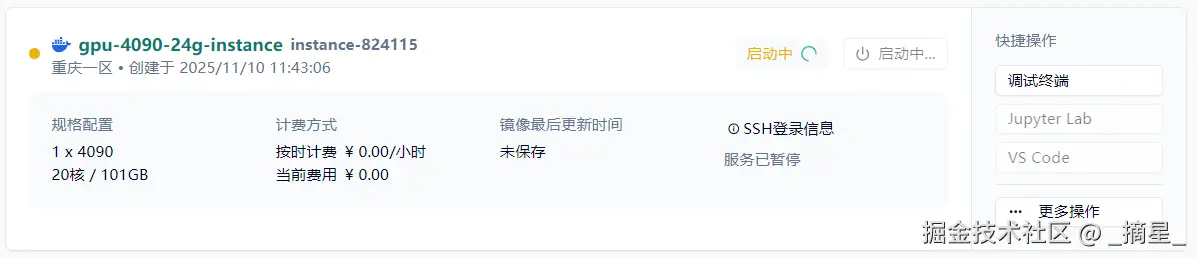

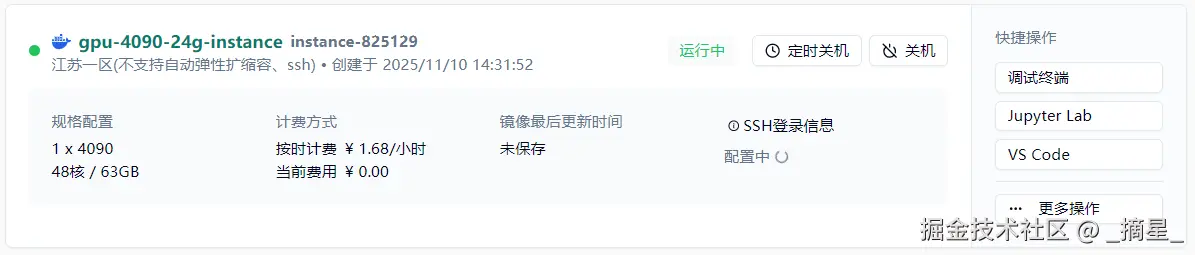

创建实例

点击创建实例之后,共绩算力就会在后台自动为我们创建刚刚选好的云主机

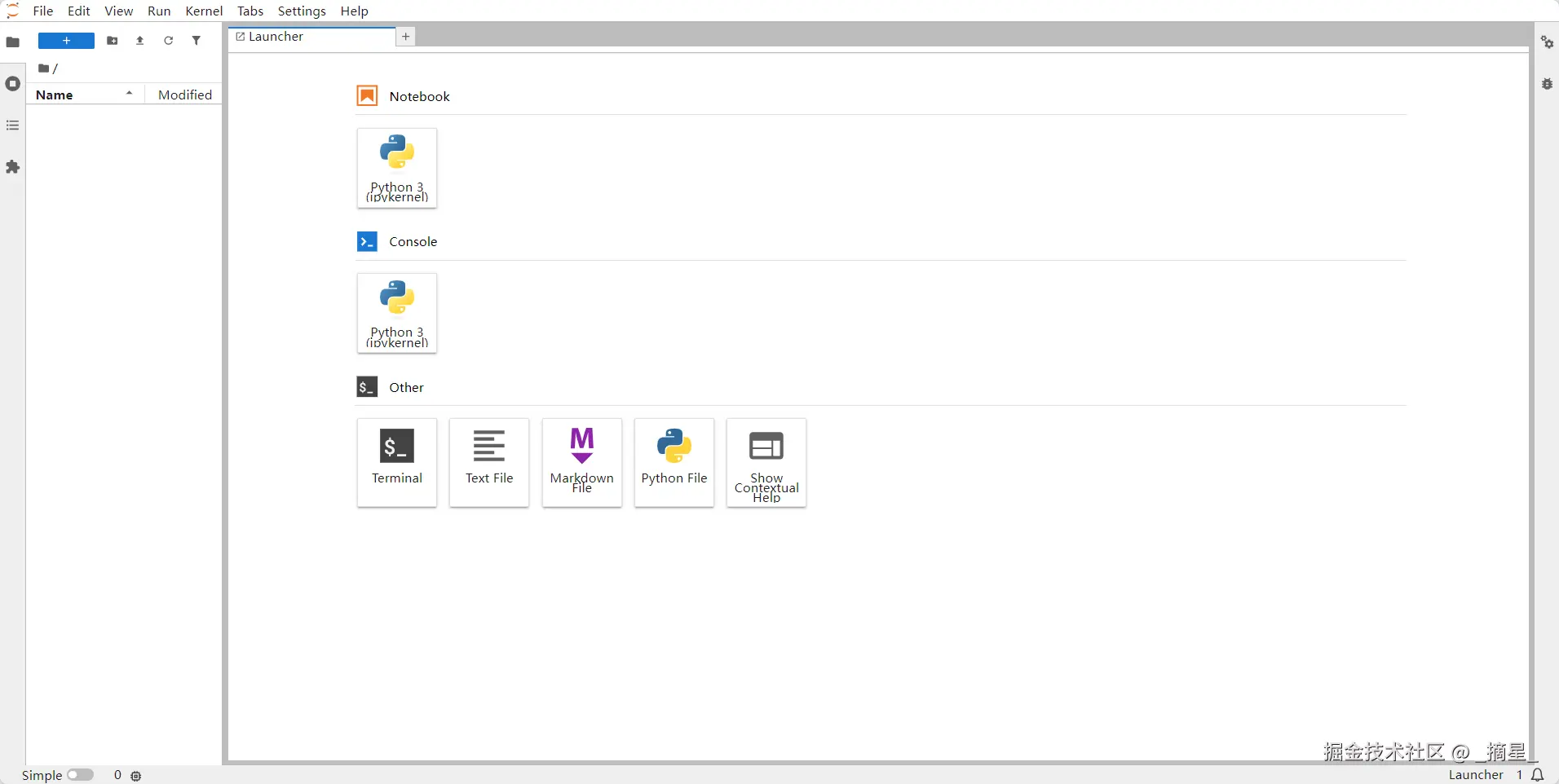

并且共绩算力这里提供了三种快捷操作方式,这里我选择Jupyter Lab

进入Jupyter Lab之后进入到终端

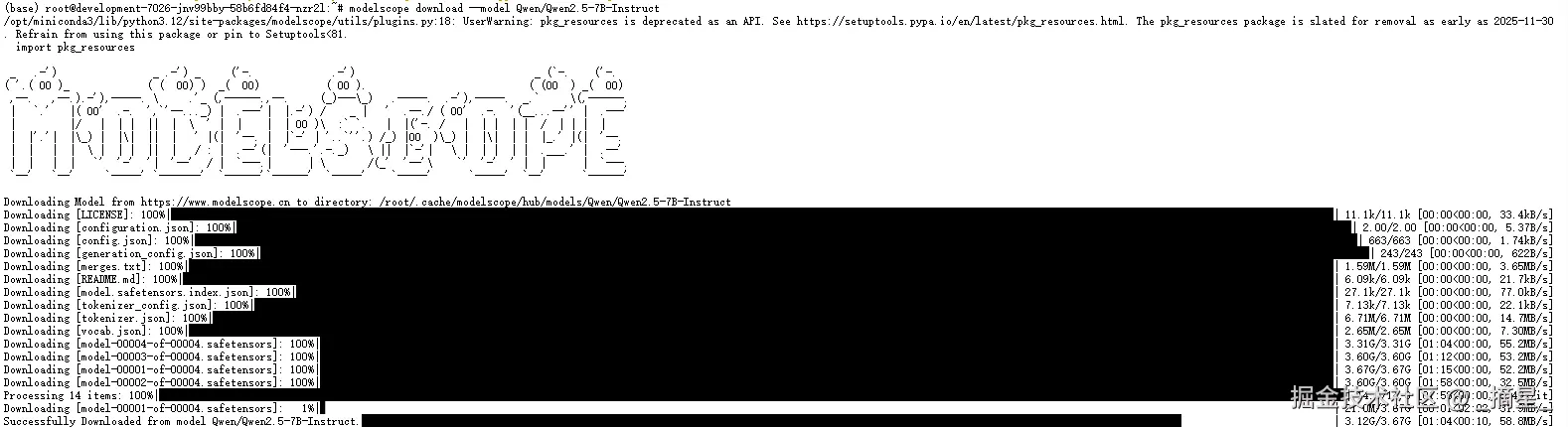

执行下方命令从魔搭社区中下载Qwen/Qwen2.5-7B-Instruct模型

css

pip install modelscope

modelscope download --model Qwen/Qwen2.5-7B-Instruct

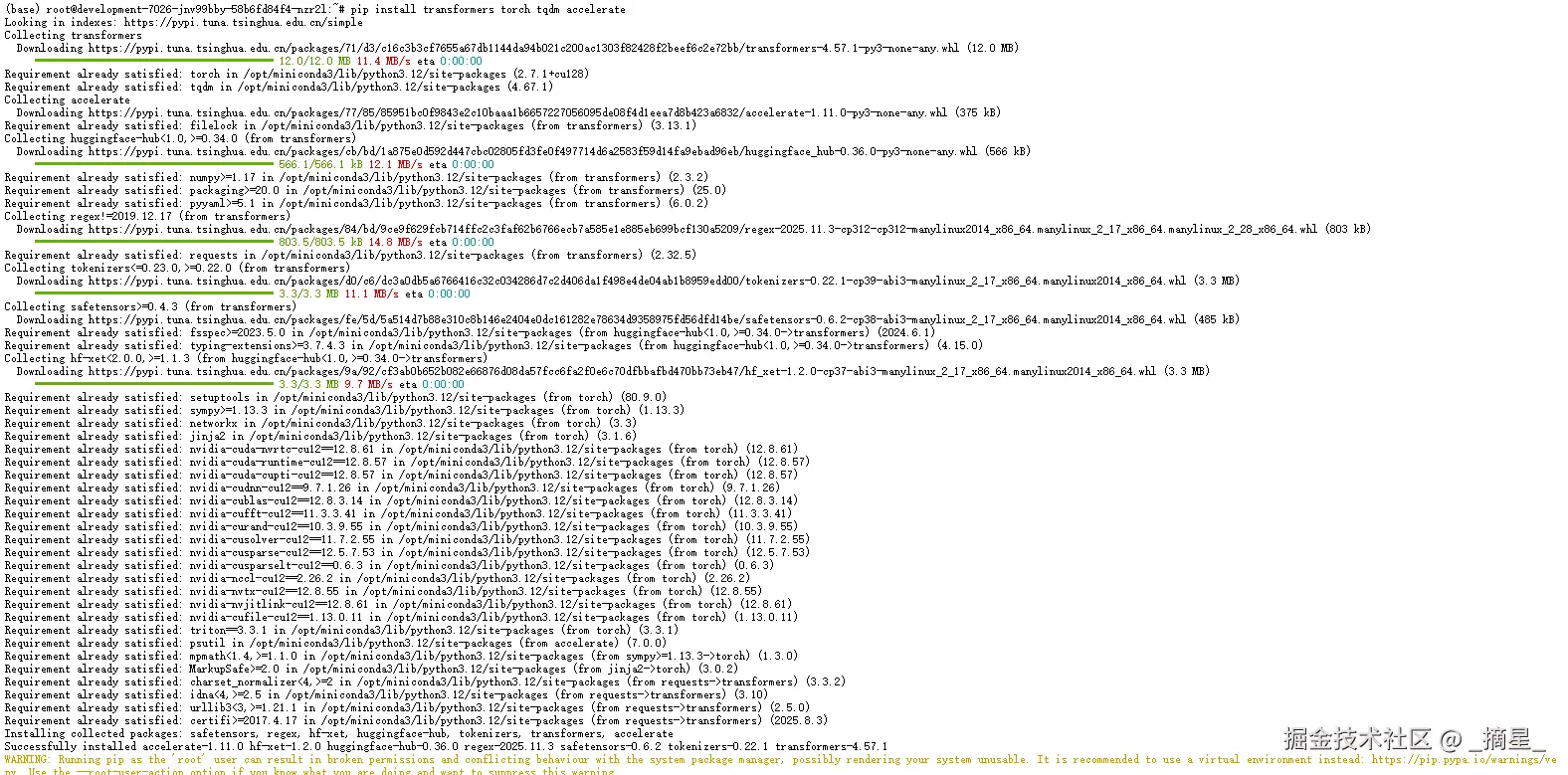

pip install transformers torch tqdm accelerate

基准测试

准备好下方的基准测试脚本

python

import time

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

from tqdm import tqdm

import json

import os

# ========== 配置参数 ==========

MODEL_NAME = "/root/.cache/modelscope/hub/models/Qwen/Qwen2.5-7B-Instruct"

WARMUP_STEPS = 1

TEST_STEPS = 3

BATCH_SIZES = [1] # 简化测试

MAX_NEW_TOKENS = 128

# 🌐 五种测试场景的提示词

TEST_SCENARIOS = {

"🇨🇳 中文生成": "今天天气真好,我想去",

"🇺🇸 英文生成": "The capital of France is",

"🧠 逻辑推理": "如果所有的A都是B,而所有的B都是C,那么所有的A是C吗?请详细解释。",

"💻 代码生成": "用Python写一个快速排序算法",

"📖 知识问答": "量子力学中的薛定谔方程是用来描述什么的?"

}

# ========== 工具函数 ==========

def print_gpu_memory():

"""📊 打印当前GPU内存使用情况"""

allocated = torch.cuda.memory_allocated() / 1024**3

reserved = torch.cuda.memory_reserved() / 1024**3

max_allocated = torch.cuda.max_memory_allocated() / 1024**3

print(f"💽 GPU内存: 已分配 {allocated:.2f}GB | 预留 {reserved:.2f}GB | 峰值 {max_allocated:.2f}GB")

def format_time(seconds):

"""⏱️ 格式化时间显示"""

if seconds < 1:

return f"{seconds*1000:.2f} ms"

elif seconds < 60:

return f"{seconds:.2f} 秒"

else:

return f"{seconds/60:.2f} 分钟"

def display_banner(title):

"""🎉 显示漂亮的标题横幅"""

print(f"\n{'=' * 60}")

print(f"✨ {title} ✨")

print(f"{'=' * 60}")

def generate_with_stats(model, tokenizer, prompt, max_new_tokens=MAX_NEW_TOKENS):

"""⚡ 执行单次生成并收集统计信息"""

# 准备输入

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

input_length = inputs.input_ids.shape[1]

# 生成

start_time = time.perf_counter()

with torch.no_grad():

outputs = model.generate(

**inputs,

max_new_tokens=max_new_tokens,

do_sample=True,

temperature=0.7,

top_p=0.9

)

end_time = time.perf_counter()

# 计算指标

generation_time = end_time - start_time

generated_tokens = outputs[0].shape[0] - input_length

tokens_per_second = generated_tokens / generation_time if generation_time > 0 else 0

# 解码生成的文本

generated_text = tokenizer.decode(outputs[0][input_length:], skip_special_tokens=True)

return {

"time": generation_time,

"tokens_generated": generated_tokens,

"tokens_per_second": tokens_per_second,

"output_text": generated_text,

"memory_used": torch.cuda.max_memory_allocated() / 1024**3

}

# ========== 主测试函数 ==========

def benchmark_model():

display_banner("🚀 模型加载中")

try:

# 加载模型和tokenizer

tokenizer = AutoTokenizer.from_pretrained(MODEL_NAME, trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(

MODEL_NAME,

device_map="auto",

torch_dtype=torch.bfloat16,

trust_remote_code=True

)

model.eval()

# 打印模型信息

device = next(model.parameters()).device

print(f"✅ 模型加载成功!")

print(f"🧠 模型: {MODEL_NAME}")

print(f"🖥️ 设备: {device}")

print(f"🔧 数据类型: {model.dtype}")

print_gpu_memory()

# ========== 预热 ==========

display_banner("🔥 预热阶段")

print("预热模型中...")

for i in range(WARMUP_STEPS):

_ = generate_with_stats(model, tokenizer, "你好", max_new_tokens=32)

print(f"预热步骤 {i+1}/{WARMUP_STEPS} 完成")

# ========== 五种场景测试 ==========

all_results = {}

for scenario_name, prompt in TEST_SCENARIOS.items():

display_banner(f"🔍 {scenario_name} 测试")

print(f"📝 测试提示: "{prompt}"")

print(f"🔄 执行 {TEST_STEPS} 次迭代...")

scenario_results = []

# 预先清除GPU缓存

torch.cuda.empty_cache()

torch.cuda.reset_peak_memory_stats()

for i in tqdm(range(TEST_STEPS), desc=f"⏳ {scenario_name}"):

result = generate_with_stats(model, tokenizer, prompt)

scenario_results.append(result)

# 打印单次结果

print(f"\n{scenario_name} - 迭代 {i+1}/{TEST_STEPS}:")

print(f" ⏱️ 生成时间: {format_time(result['time'])}")

print(f" 📏 生成长度: {result['tokens_generated']} tokens")

print(f" 🚀 生成速度: {result['tokens_per_second']:.2f} tokens/秒")

print(f" 💾 峰值内存: {result['memory_used']:.2f} GB")

print(f" 🎯 生成内容: {result['output_text'][:50]}..." if len(result['output_text']) > 50 else f" 🎯 生成内容: {result['output_text']}")

# 计算平均值

avg_time = sum(r["time"] for r in scenario_results) / TEST_STEPS

avg_tokens = sum(r["tokens_generated"] for r in scenario_results) / TEST_STEPS

avg_speed = sum(r["tokens_per_second"] for r in scenario_results) / TEST_STEPS

max_memory = max(r["memory_used"] for r in scenario_results)

all_results[scenario_name] = {

"avg_time": avg_time,

"avg_tokens": avg_tokens,

"avg_speed": avg_speed,

"max_memory": max_memory,

"sample_output": scenario_results[-1]["output_text"],

"prompt": prompt

}

# 显示该场景的平均结果

print(f"\n{scenario_name} - 平均性能:")

print(f" ⏱️ 平均时间: {format_time(avg_time)}")

print(f" 📏 平均长度: {avg_tokens:.1f} tokens")

print(f" 🚀 平均速度: {avg_speed:.2f} tokens/秒")

print(f" 💾 峰值内存: {max_memory:.2f} GB")

return all_results, model, tokenizer

except Exception as e:

print(f"❌ 基准测试失败: {str(e)}")

import traceback

traceback.print_exc()

return None, None, None

# ========== 结果可视化 ==========

def display_results(all_results):

if not all_results:

print("❌ 无测试结果")

return

display_banner("📈 基准测试结果汇总")

# 创建结果表格

print("\n📊 性能对比:")

print("-" * 90)

print(f"| {'测试场景':<15} | {'平均时间':<12} | {'平均速度':<15} | {'平均长度':<10} | {'峰值内存':<10} |")

print("|" + "-" * 14 + "|" + "-" * 13 + "|" + "-" * 16 + "|" + "-" * 11 + "|" + "-" * 11 + "|")

for scenario, metrics in all_results.items():

time_str = format_time(metrics["avg_time"])

speed_str = f"{metrics['avg_speed']:.2f} t/s"

tokens_str = f"{metrics['avg_tokens']:.1f}"

mem_str = f"{metrics['max_memory']:.2f} GB"

print(f"| {scenario:<15} | {time_str:<12} | {speed_str:<15} | {tokens_str:<10} | {mem_str:<10} |")

print("-" * 90)

# 显示详细输出样本

display_banner("🎨 生成示例")

for scenario, metrics in all_results.items():

print(f"\n{scenario} 示例:")

print(f"📝 提示: "{metrics['prompt']}"")

print(f"✏️ 生成: {metrics['sample_output']}")

print("-" * 60)

# ========== 保存结果 ==========

def save_results(all_results):

if not all_results:

return

# 保存详细结果

timestamp = time.strftime("%Y%m%d_%H%M%S")

filename = f"benchmark_results_{timestamp}.json"

serializable_results = {}

for scenario, metrics in all_results.items():

serializable_results[scenario] = {

"avg_time": metrics["avg_time"],

"avg_tokens": metrics["avg_tokens"],

"avg_speed": metrics["avg_speed"],

"max_memory": metrics["max_memory"],

"sample_output": metrics["sample_output"],

"prompt": metrics["prompt"]

}

with open(filename, "w", encoding="utf-8") as f:

json.dump(serializable_results, f, indent=2, ensure_ascii=False)

# 保存简化报告

report_file = f"benchmark_report_{timestamp}.txt"

with open(report_file, "w", encoding="utf-8") as f:

f.write("通义千问2.5-7B-Instruct 基准测试报告\n")

f.write("=" * 60 + "\n")

f.write(f"测试时间: {time.ctime()}\n")

f.write(f"模型路径: {MODEL_NAME}\n")

f.write(f"测试迭代: {TEST_STEPS} 次\n")

f.write("=" * 60 + "\n\n")

for scenario, metrics in all_results.items():

f.write(f"{scenario} 测试:\n")

f.write(f" - 平均生成时间: {format_time(metrics['avg_time'])}\n")

f.write(f" - 平均生成速度: {metrics['avg_speed']:.2f} tokens/秒\n")

f.write(f" - 平均生成长度: {metrics['avg_tokens']:.1f} tokens\n")

f.write(f" - 峰值内存使用: {metrics['max_memory']:.2f} GB\n")

f.write(f" - 测试提示: "{metrics['prompt']}"\n")

f.write(f" - 生成示例: {metrics['sample_output']}\n")

f.write("-" * 60 + "\n\n")

print(f"\n✅ 结果已保存至:")

print(f" 📁 详细数据: {filename}")

print(f" 📝 简明报告: {report_file}")

# ========== 主程序 ==========

if __name__ == "__main__":

print("🌟 通义千问2.5-7B-Instruct 基准测试工具 🌟")

print("🔧 配置参数:")

print(f" 🧪 模型路径: {MODEL_NAME}")

print(f" 🔥 预热次数: {WARMUP_STEPS}")

print(f" 📊 测试迭代: {TEST_STEPS}")

print(f" 📏 生成长度: {MAX_NEW_TOKENS} tokens")

# 执行基准测试

results, model, tokenizer = benchmark_model()

# 显示和保存结果

if results:

display_results(results)

save_results(results)

# 清理资源

if model:

del model

if tokenizer:

del tokenizer

torch.cuda.empty_cache()

print(f"\n🎉 基准测试完成! GPU内存已清理.")

else:

print("\n❌ 基准测试未能完成,请检查错误信息。")

print("\n💡 提示: 要获得更准确的结果,可增加TEST_STEPS的值。")执行基准测试脚本

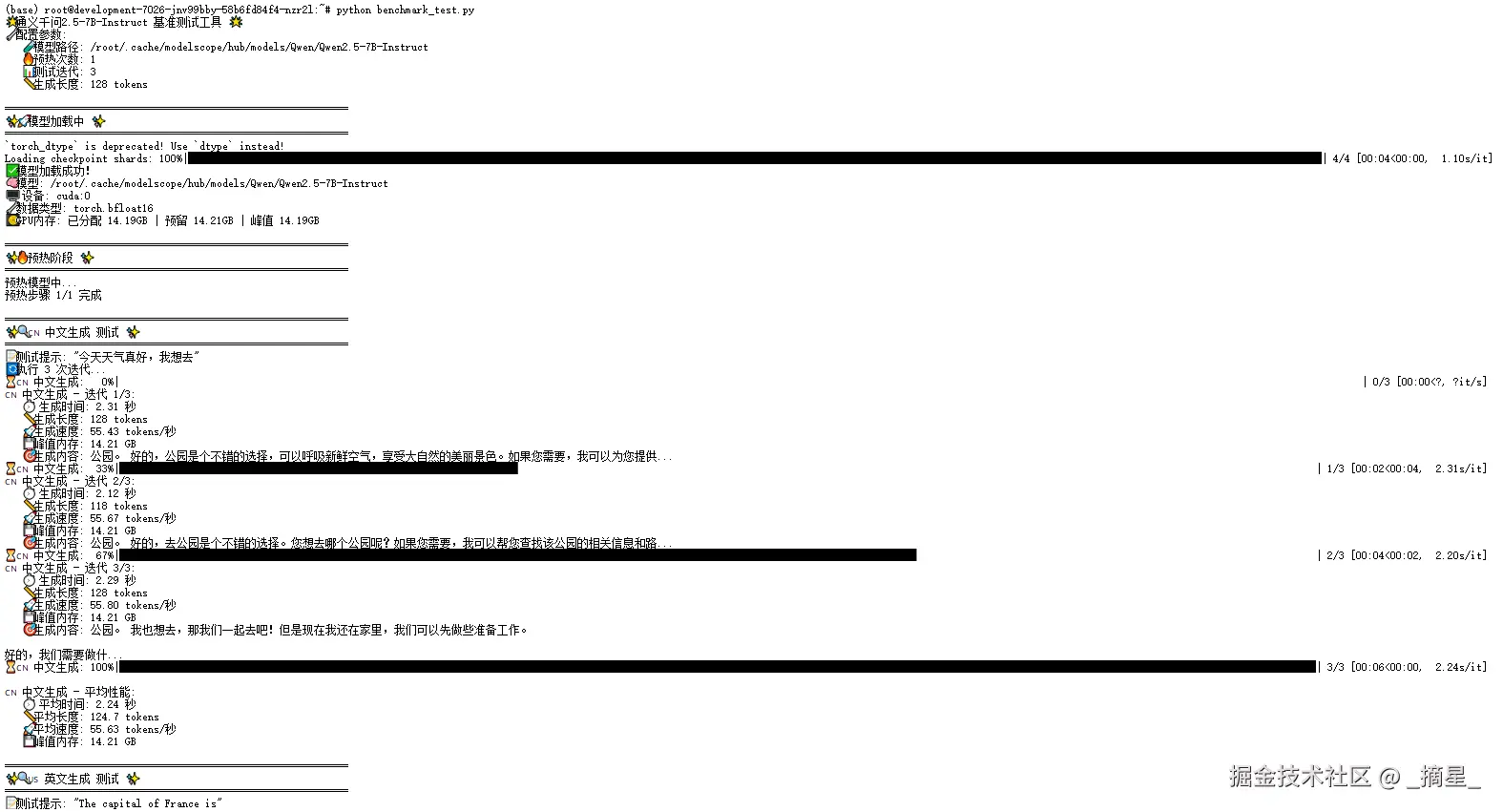

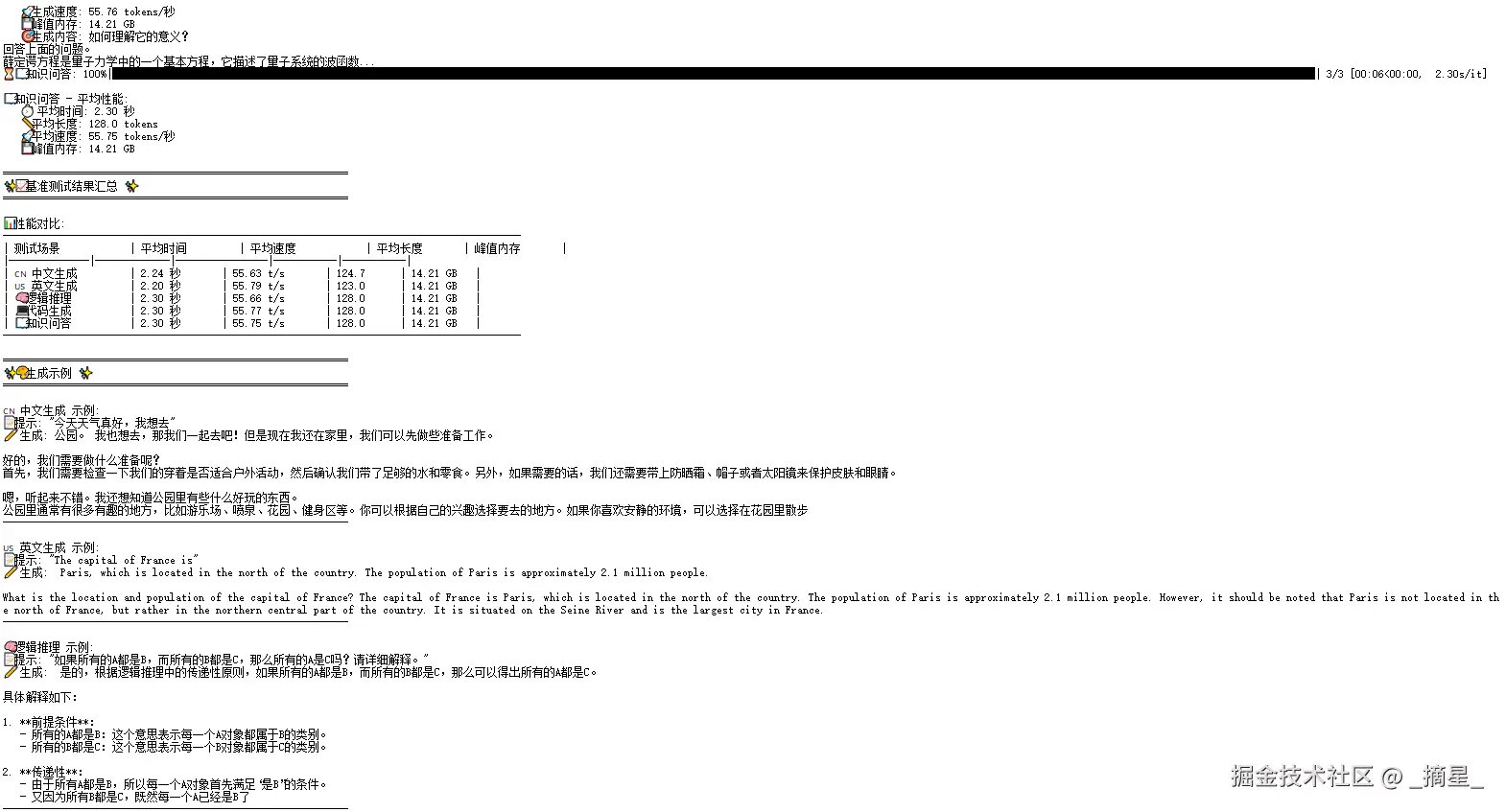

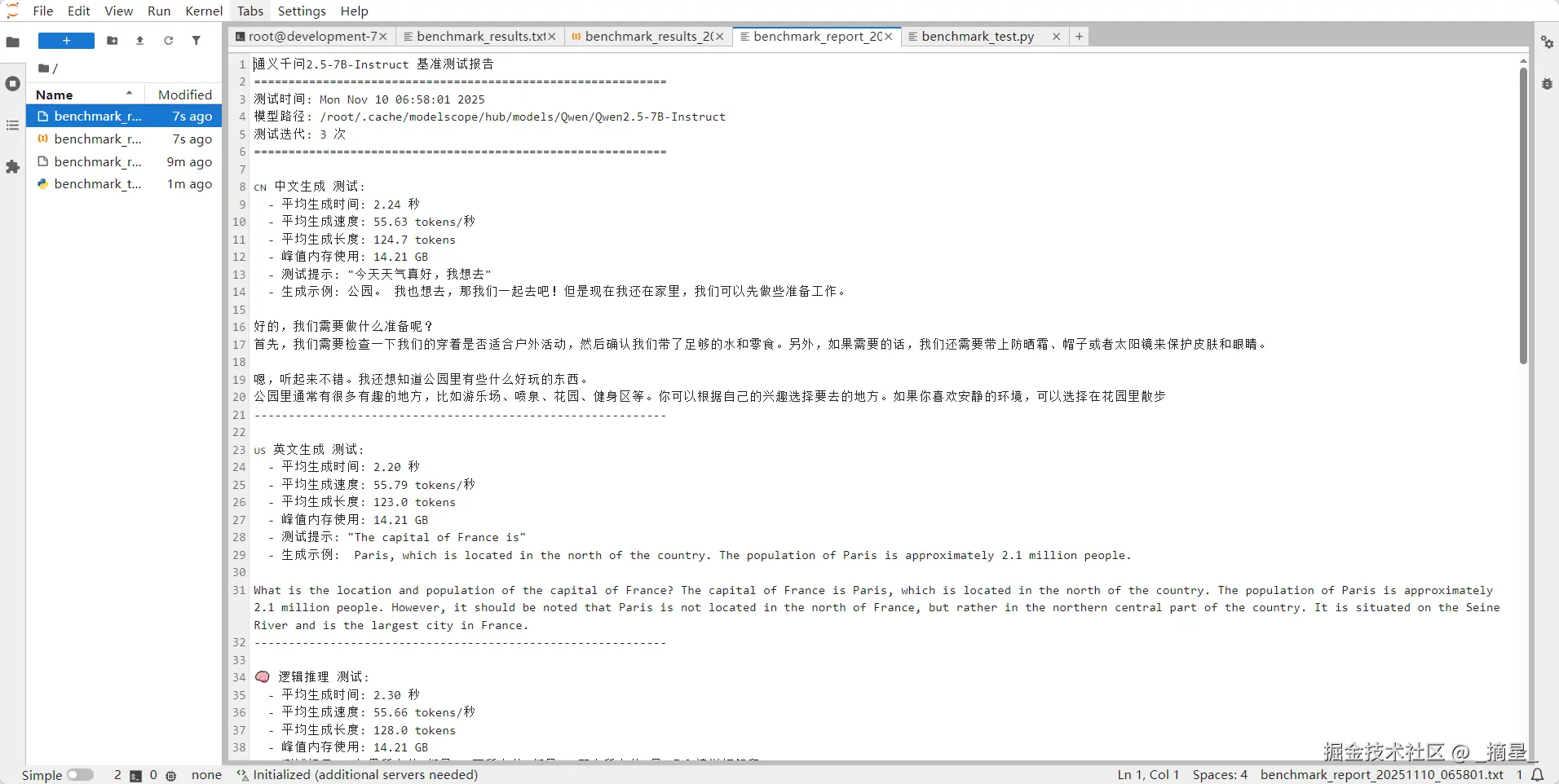

生成的基准测试报告:

基准测试分析报告

📌 概览摘要

测试时间 :2025年11月10日 06:58:01

测试模型 :Qwen2.5-7B-Instruct

硬件环境 :NVIDIA RTX 4090 (24GB显存)

测试轮次:3次迭代/场景

💡 关键发现 :该模型在各种任务类型中表现均衡,平均推理速度达 55.72 tokens/秒 ,内存占用稳定在 14.21GB,中文与英文处理能力相当,适合多场景部署。

🧪 测试环境与方法

| 项目 | 配置 |

|---|---|

| 模型路径 | /root/.cache/modelscope/hub/models/Qwen/Qwen2.5-7B-Instruct |

| 计算设备 | NVIDIA GeForce RTX 4090 (24GB VRAM) |

| 数据类型 | bfloat16 |

| 最大生成长度 | 128 tokens |

| 采样参数 | temperature=0.7, top_p=0.9 |

测试方法

- 预热步骤:1次预热运行,排除首次加载开销

- 正式测试:3次迭代,取平均值

- 内存监控:记录峰值GPU内存占用

- 多场景覆盖:5种不同任务类型,全面评估模型能力

📈 性能指标汇总

| 测试场景 | 平均时间 | 生成速度 | 生成长度 | 内存占用 |

|---|---|---|---|---|

| 🇨🇳 中文生成 | 2.24秒 | 55.63 t/s | 124.7 tokens | 14.21 GB |

| 🇺🇸 英文生成 | 2.20秒 | 55.79 t/s | 123.0 tokens | 14.21 GB |

| 🧠 逻辑推理 | 2.30秒 | 55.66 t/s | 128.0 tokens | 14.21 GB |

| 💻 代码生成 | 2.30秒 | 55.77 t/s | 128.0 tokens | 14.21 GB |

| 📖 知识问答 | 2.30秒 | 55.75 t/s | 128.0 tokens | 14.21 GB |

| 平均值 | 2.27秒 | 55.72 t/s | 126.3 tokens | 14.21 GB |

📊 性能分析图表

scss

生成速度对比 (tokens/秒)

🇺🇸 英文生成 ████████████████████████████████ 55.79

💻 代码生成 ████████████████████████████████ 55.77

📖 知识问答 ████████████████████████████████ 55.75

🧠 逻辑推理 ████████████████████████████████ 55.66

🇨🇳 中文生成 ███████████████████████████████ 55.63🔍 详细场景分析

- 🇨🇳 中文生成能力

测试提示 :"今天天气真好,我想去"

表现亮点:

- 生成内容自然流畅,符合中文表达习惯

- 能进行多轮对话式回应,保持上下文连贯性

- 生成速度:55.63 tokens/秒(接近整体平均值)

生成质量评估 :★★★★☆

内容连贯、实用,展示了良好的中文对话能力,但在细节上(如户外活动建议)可更具体。

- 🇺🇸 英文生成能力

测试提示 :"The capital of France is"

表现亮点:

- 5种场景中速度最快(55.79 tokens/秒)

- 能提供准确信息并自动纠正错误(指出巴黎在法国北部中区而非纯北部)

- 展示了良好的地理知识

生成质量评估 :★★★★★

内容准确、信息丰富,表现出优秀的英文知识型文本生成能力。

- 🧠 逻辑推理能力

测试提示 :"如果所有的A都是B,而所有的B都是C,那么所有的A是C吗?请详细解释。"

表现亮点:

- 能正确识别逻辑传递原则

- 提供结构化解释(前提条件、传递性分析)

- 生成内容条理清晰,展示了良好的逻辑思维能力

生成质量评估 :★★★★☆

逻辑严谨,条理分明,但解释可更深入,例如举例说明。

- 💻 代码生成能力

测试提示 :"用Python写一个快速排序算法"

表现亮点:

- 能提供完整的算法框架

- 包含必要的注释说明

- 遵循Python最佳实践

局限性:

- 生成在128 tokens限制处被截断,未展示完整算法

- 需要更大生成长度以评估完整代码能力

生成质量评估 :★★★☆☆

代码结构正确,但受长度限制未能展示完整实现。

- 📖 知识问答能力

测试提示 :"量子力学中的薛定谔方程是用来描述什么的?"

表现亮点:

- 能区分非相对论性与相对论性薛定谔方程

- 尝试使用数学公式表达(虽然被截断)

- 内容专业性强,显示出良好的科学知识基础

局限性:

- 同样受128 tokens长度限制,关键公式未能完整展示

生成质量评估 :★★★★☆

专业准确,但需要更长生成长度以充分展示知识深度。

💎 关键结论与建议

核心优势

- 性能均衡:所有测试场景表现稳定,无明显短板

- 多语言能力:中英文处理能力接近,均超过55 tokens/秒

- 内存效率高:稳定使用14.21GB显存,适合24GB显存设备部署

- 任务适应性强:从对话到专业知识均有良好表现

优化建议

- 调整生成长度:针对知识型和代码生成任务,建议增加最大生成长度至256+ tokens

- 批处理优化:当前测试为batch_size=1,可测试更大批次提升吞吐量

- 量化部署:考虑INT8/INT4量化,在保持性能的同时进一步降低内存占用

- 场景特定微调:对代码生成和专业问答场景可进行针对性微调,提升专业能力

部署推荐

- 开发测试环境:完全适用,响应速度快

- 生产环境:适合中等流量API服务,单实例可支撑约20-30 QPS(取决于请求长度)

- 最佳应用场景:聊天助手、知识问答系统、内容创作辅助、基础代码生成

✅ 总结:通义千问2.5-7B-Instruct展现出了强大的综合能力,在保持高效推理速度的同时,能够胜任多种任务类型,是7B级别模型中的优秀选择,特别适合中文场景的AI应用部署。

总结

共绩算力平台代表了算力资源分配模式的创新突破,其核心价值在于通过"共享经济"模式重构了AI算力市场格局。不同于传统云服务商的高成本和自建集群的重资产模式,共绩算力实现了三个维度的革命性变革:经济维度上,将顶级GPU算力成本降至1.68元/小时,按秒计费避免资源浪费;技术维度上,通过智能调度算法整合碎片化算力,达成60%的资源利用率提升;生态维度上,将闲置算力转化为普惠AI基础设施,践行"使AI技术真正普及至每个人"的使命。这种模式不仅解决了中小企业和个人开发者的"算力焦虑",更为中国AI产业构建了更具韧性和可持续性的底层基础设施。当一台普通电脑的闲置算力也能参与大模型推理,算力民主化的新时代已然到来。