图片来源网络

文章目录

- 一、RAFT方法的核心定义与定位

- 二、RAFT方法的核心原理:模拟"不完美检索"的训练逻辑

- 三、RAFT方法的技术实现流程

-

- [1. 数据集构建:合成包含干扰的训练数据](#1. 数据集构建:合成包含干扰的训练数据)

- [2. 模型微调:基于合成数据的监督训练](#2. 模型微调:基于合成数据的监督训练)

- [3. 评估优化:多领域基准测试](#3. 评估优化:多领域基准测试)

- 四、RAFT方法的优势:解决传统RAG与微调的痛点

- 五、RAFT方法的应用场景与实践建议

- 六、总结:RAFT方法的价值与展望

一、RAFT方法的核心定义与定位

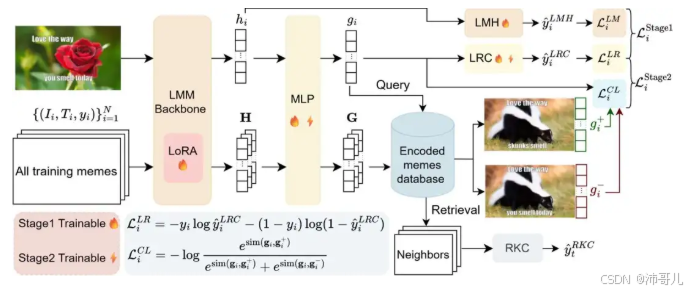

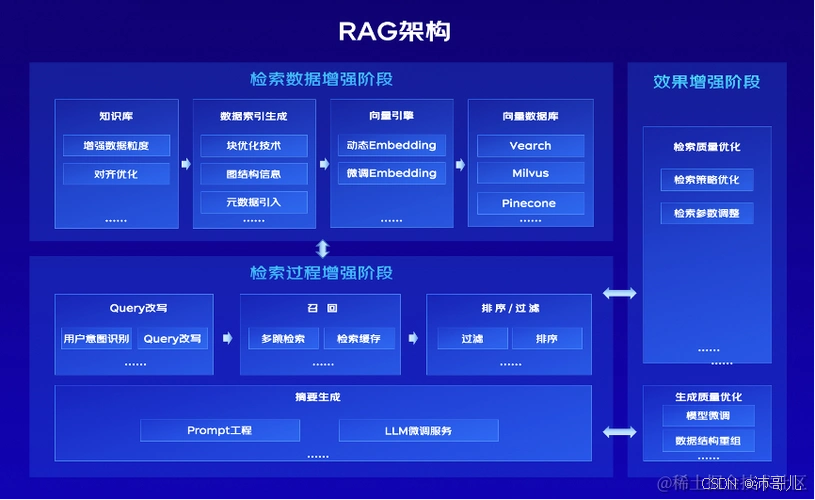

RAFT(Retrieval-Augmented Fine-Tuning,检索增强微调)是一种结合检索增强生成(RAG)与监督微调(SFT)的新型训练方法,旨在提升大型语言模型(LLM)在特定领域RAG任务 中的性能。其核心目标是通过模拟"不完美检索环境"(即训练数据中包含相关文档与干扰文档),让模型学会识别并利用有效文档 ,同时忽略无关干扰,从而在真实RAG场景中生成更准确、可靠的答案。

二、RAFT方法的核心原理:模拟"不完美检索"的训练逻辑

RAFT的设计灵感源于"学生备考"的类比:

- 传统RAG:类似"开卷考试但未提前复习"------模型依赖检索器返回的文档(可能包含干扰)生成答案,性能受限于检索器质量;

- 传统微调(DSF):类似"闭卷考试"------模型仅依赖训练数据中的知识,无法利用外部文档;

- RAFT :类似"提前学习教科书后参加开卷考试"------通过训练让模型学习领域知识 ,同时适应不完美的检索结果(即存在干扰文档的情况)。

其核心原理可概括为三点:

- 模拟不完美检索环境 :训练数据中包含相关文档(Oracle文档,含答案)与干扰文档(Di,不含答案),迫使模型学会区分两者;

- 思维链(CoT)推理 :要求模型生成包含推理过程 的答案,并明确引用文档中的具体内容(如用

##begin_quote##标记),提升答案的可解释性与准确性; - 监督微调 :通过合成数据集(问题+文档+CoT答案)对LLM进行微调,让其掌握"从检索结果中提取有效信息"的能力。

三、RAFT方法的技术实现流程

RAFT的实现需经历数据集构建 、模型微调 、评估优化 三大步骤:

1. 数据集构建:合成包含干扰的训练数据

RAFT的训练数据需模拟真实RAG场景中的"不完美检索",每个样本包含:

- 问题(Q):特定领域的查询(如医学问题、代码API调用);

- 文档集合(D) :包含1个相关文档(Oracle) (含答案)与多个干扰文档(Di)(不含答案);

- CoT答案(A) :由通用LLM(如GPT-4、Llama 2 70B)生成,包含 推理过程 与 文档引用 *(如"根据文档

##begin_quote##...##end_quote##,答案是...")。

例如,在医学领域,问题"Oberoi集团的总部在哪里?"的文档集合可能包含:

- 相关文档:"The Oberoi Group is a hotel company with its head office in Delhi."(含答案);

- 干扰文档:"The Oberoi family is involved in hotels like The Oberoi Group."(无关信息);

- CoT答案:"##Reason: 文档

##begin_quote##The Oberoi Group is a hotel company with its head office in Delhi.##end_quote##明确提到总部位置。##Answer: Delhi"。

2. 模型微调:基于合成数据的监督训练

RAFT采用 监督微调(SFT) 对LLM进行训练,输入为"问题+文档集合",输出为"CoT答案"。训练过程中,模型需学会:

- 从相关文档中提取答案;

- 忽略干扰文档的影响;

- 生成符合逻辑的推理过程。

例如,伯克利团队使用Meta Llama 2 7B 作为基础模型,通过Azure AI Studio进行微调,训练参数包括:

- 学习率:0.00002;

- 训练轮数:1;

- 批量大小:根据GPU资源调整。

3. 评估优化:多领域基准测试

RAFT的性能通过特定领域基准数据集评估,包括:

- 医学领域:PubMed QA(生物医学问题);

- 常识领域:HotpotQA(维基百科常识问题);

- API领域:Gorilla API Bench(代码API调用问题)。

实验结果显示,RAFT在所有领域均显著优于传统方法:

- 在HotpotQA数据集上,RAFT的信息提取准确率较基础Llama 2指令调整模型提升35.25%;

- 在Torch Hub评估中,提升幅度达76.35%。

四、RAFT方法的优势:解决传统RAG与微调的痛点

RAFT的核心优势在于平衡了"领域适应"与"检索鲁棒性",解决了传统方法的三大痛点:

- 克服微调的"知识局限性" :传统微调依赖训练数据中的知识,无法利用外部文档;RAFT通过模拟检索环境,让模型学会结合外部文档生成答案,扩展了知识边界。

- 解决RAG的"干扰问题" :传统RAG的检索结果可能包含无关文档(干扰),导致模型生成错误答案;RAFT通过训练数据中的干扰文档,让模型学会忽略无关信息,提升答案准确性。

- 增强模型的"可解释性" :RAFT要求模型生成思维链推理过程,明确引用文档内容,使答案的生成逻辑可追溯,解决了传统RAG"黑箱"问题。

五、RAFT方法的应用场景与实践建议

RAFT适用于需要利用特定领域知识的RAG场景,包括:

- 企业知识管理:如回答关于企业内部文档(如产品手册、流程指南)的问题;

- 专业领域问答:如医学(PubMed)、法律(法律条文)、代码(API调用)等;

- 智能客服:如处理客户关于产品功能、售后政策的查询。

实践建议:

- 数据集构建:使用通用LLM(如GPT-4)生成CoT答案,确保推理过程的准确性;

- 模型选择 :优先选择参数规模适中的LLM(如Llama 2 7B),平衡训练效率与性能;

- 评估优化 :通过多领域基准测试(如PubMed、HotpotQA)评估模型性能,调整训练参数(如学习率、训练轮数)。

六、总结:RAFT方法的价值与展望

RAFT是RAG技术演进中的重要突破,通过"微调+检索"的组合,解决了传统RAG与微调的痛点,提升了LLM在特定领域的RAG性能。其核心价值在于:

- 让LLM"学会学习":通过模拟不完美检索环境,让模型掌握"从检索结果中提取有效信息"的能力;

- 平衡"领域适应"与"检索鲁棒性":既利用了领域知识,又解决了干扰文档的问题;

- 增强模型的可解释性:思维链推理使答案的生成逻辑可追溯,提升了用户信任度。

未来,RAFT有望在更多专业领域(如金融、教育)得到应用,成为LLM落地的重要技术之一。