我自己的原文哦~ https://blog.51cto.com/whaosoft143/14308733

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#URDF-Anything

使用 3D 多模态语言模型构建关节目标

URDF-Anything 单图直出可执行 URDF:3D-MLLM 预测关节 JSON+[SEG] token 分割点云,mIoU↑17%、关节误差↓29%,OOD 物体仍适用。

25年11 月来自北大和西雅图华盛顿大学的论文"URDF-Anything: Constructing Articulated Objects with 3D Multimodal Language Model"。

构建精确的关节(铰接)体数字孪生模型对于机器人仿真训练和具身人工智能世界模型构建至关重要,但传统上需要耗费大量精力进行手动建模或采用多阶段流程。本文提出一种基于三维多模态大语言模型(MLLM)的端到端自动重建框架------URDF-Anything。URDF-Anything 利用基于点云和文本多模态输入的自回归预测框架,联合优化几何分割和运动学参数预测。它实现一种专门的 [SEG] token 机制,该机制直接与点云特征交互,从而在保持与运动学参数预测一致性的同时,实现细粒度的部件级分割。在模拟数据集和真实数据集上的实验表明,该方法在几何分割(mIoU 提升 17%)、运动学参数预测(平均误差降低 29%)和物理可执行性(比基线方法提升 50%)方面均显著优于现有方法。该方法展现出卓越的泛化能力,即使在训练集之外的目标上也能表现良好。

URDF-Anything 如图所示:从视觉观察(单视图或多视图图像)生成功能性 URDF 数字孪生。该框架利用 3D 多模态大语言模型,并在指令(例如"分割部件并预测参数")的指导下,处理点云,以联合推断几何部件分割和运动学结构。输出结果是一个具有已定义关节(此处用不同部件颜色表示)的分割 3D 模型,形成一个可直接在物理模拟器中使用的功能性 URDF 数字孪生。

01 任务定义

为了确保与标准 3D 仿真器(例如 MuJoCo、PyBullet)兼容,将关节目标表示为 URDF(统一机器人描述格式)模型。URDF 结构将目标定义为一个由以下部分组成的层次树:

连杆:代表目标部件(例如,柜门、抽屉或底座)的刚体组件。每个连杆包含几何(网格)和惯性属性。

关节:连接连杆并指定运动学约束的关节。每个关节包含:

- 类型:棱柱关节、旋转关节、连续关节、浮动关节、平面关节或固定关节。

- 父/子关系:由该关节连接的连杆。

- 原点:相对于父连杆的 3D 位置 (x, y, z) 和方向 (r, p, y) 。

- 轴:定义运动方向的归一化三维向量(例如,垂直滑动时为 [0, 1, 0])。

- 极限:定义棱柱关节、旋转关节和平面关节的运动范围。

目标是从关节目标的视觉输入中自动推断这些 URDF 组件------具体来说,就是每个连杆的网格、每个关节的类型、原点、父关节、子关节和轴。

URDF-Anything框架概述如图所示:该流程以三维点云(来自图像)和结构化语言指令作为输入。三维多级逻辑模型(MLLM,使用LoRa进行微调)自回归地生成符号输出(运动学参数)和[SEG] token。生成的[SEG] token对应的嵌入向量随后通过三维解码器与点云特征交互,从而对点云进行精细的几何分割,将其分割成各个连接。最后,将联合预测的运动学参数和分割后的几何形状集成到一个功能完善的URDF文件中,生成一个完整的、可用于物理仿真的关节三维模型。

02 输入表示

流程的第一步是将关节目标的原始视觉观察结果转换为适合结构解析的三维表示。现实世界的观察结果可能差异很大,有时提供目标的多个视角,有时只提供一个视角。因此,点云采集策略会根据输入模态进行调整:

多视角输入:当有来自不同视角的多个 RGB 图像可用时,利用 DUSt3R生成密集的三维点云 P_obj。 DUSt3R 擅长建立密集的 2D 到 3D 对应关系,并从多个视图重建精确的 3D 几何形状。

单视图输入:对于更具挑战性的单视图场景,采用生成式方法 LGM。首先,使用预训练的扩散模型合成一致的多视图图像。随后,从这些合成视图重建 3D 几何形状,该形状可以表示为 3D 高斯扩散模型,也可以转换为点云 P_obj。

无论输入类型(单视图或多视图),此阶段的输出都是一个密集的点云 P_obj,表示整个关节目标。需要特别注意的是,这个初始点云是一个整体表示;它捕捉整体几何形状,但本身并不区分或分割目标的各个连接或子组件。这个包含整个目标的点云 P_obj 将作为后续多模态关节解析阶段的主要几何输入。

04 基于 3D MLLM 的关节解析

采用ShapeLLM作为主干网络,ShapeLLM 是一个最新的 3D MLLM,它结合点云编码器和大语言模型。ShapeLLM 已展现出执行 3D 视觉定位并输出结构化 3D 信息(例如 3D 边框坐标)的能力。这种预存在的能力对于预测关节参数的任务尤为有利,因为关节参数本身就涉及 3D 位置(原点、轴线)和方向(原点)。这种统一的架构具有两个优势:

- 开放世界泛化:3D MLLM 的几何理解能力,通过大规模 3D 语言预训练得到增强,使其能够对已见和未见的物体类别进行稳健的推理。

- 结构化输出能力:MLLM 本身支持生成任意长度和复杂度的 JSON 格式输出,从而能够灵活地表示关节层次结构和部件关系。

输入:输入点云 P_obj 由 3D 编码器编码,提取密集几何特征 F_pc,其中 M 为点数(可能经过下采样),d_pc 为特征维度。同时,提供自然语言指令以指导解析过程。采用结构化指令模板,该模板显式地包含几何特征,并提示模型输入特定的 URDF 信息。指令的文本部分 X_txt 由 LLM 的标准词嵌入层处理,生成文本嵌入 F_txt,其中 L 为token数,d_txt 为嵌入维度。这些多模态特征(F_pc 和 F_txt)由 LLM 的各个层进行整合和处理。这种核心的多模态处理和输出生成过程可以形式化地表示为:

Y_output = M_LLM(F_pc, F_txt)

输出:虽然 3D MLLM 擅长处理多模态输入并生成结构化的文本输出,但它们本身并不具备生成几何分割所需的密集逐点预测的能力。任务不仅需要预测符号化的 URDF 结构和参数,还需要精确分割每个链接对应的点云几何形状。受 LISA的启发,扩展词汇表,引入一个特殊的token [SEG] 来实现这一联合目标。MLLM 经过训练,能够自回归地生成一个结构化的 JSON 输出序列,其中包含预测的联合参数以及链接的描述。关键在于,输出中的每个链接描述都与一个 [SEG] token相关联(例如,"link_0": "base_cabinet[SEG]","link_1": "drawer[SEG]")。这意味着 MLLM 能够同时预测铰接结构的符号表示,并放置 token([SEG])来指示需要识别的每个部件对应的几何形状。

05 基于特殊token机制的几何分割

对 MLLM 输出序列 Y_output 中由 [SEG] token指示的每个目标部分执行几何分割。对于每个生成的 [SEG] token,利用其最终隐藏状态 h_seg,并结合前一个部分类别token的状态 h_category,形成融合token表示 h_combined = [h_category ; h_seg ]。然后,将此表示用作在交叉注意机制中的查询

H_query = MLP_query(h_combined)

另一个点特征 S_pc 由 3D 主干网络生成 S_pc = F_enc(P_obj)。然后,一个机制处理投影点云特征 F′_pc = MLP_pc(S_pc),有效地计算每个点的得分表示每个点属于该部件的可能性:

y_mask = CrossAttn(Q=H_query, K=F′_pc,V =F′_pc)

这些得分 y_mask 通过 sigmoid 函数和阈值转换为对应链路的二值分割掩码。此过程对每个 [SEG] token 重复进行,从而生成所有预测部件的掩码。

06 网格转换和 URDF 文件生成

流程的最后阶段将重建的几何和运动学信息整合到一个标准的 URDF XML 文件中,以便直接在物理模拟器中使用。从几何分割过程获得的每个链路分割点云,使用点到网格转换方法转换为 3D 网格表示(例如,OBJ 格式)。同时,MLLM的结构化JSON输出提供完整的运动学结构,包括关节类型、父子关系、原点和轴线。解析此JSON并组装最终的URDF XML文件,其中每个链接都指向其生成的网格,并且关节元素填充预测参数。生成的URDF模型可以直接导入到标准物理模拟器(例如MuJoCo、Sapiens )中。下图提供一个示例目标实例生成的URDF文件的完整示例:

07 模型训练

URDF-Anything 模型采用端到端训练方式,联合生成结构化的 URDF 参数并从点云预测精确的部件级分割掩码。总体训练目标 L 是语言建模损失 L_text 和分割损失 L_seg 的加权和。

分割损失结合二元交叉熵损失(BCE)和Dice损失(DICE)。对于与[SEG] token 关联的给定部分,令M_gt ∈ {0, 1}为该部分的真实二值掩码。

实现细节:采用 ShapeLLM 作为 3D MLLM 主干网络,默认设置使用 ShapeLLM-7B-general-v1.0 检查点。对于 3D 主干网络,用 Uni3D 提取密集几何特征。训练采用一块 NVIDIA 80GB A800 GPU。用 LoRA 进行高效微调,LoRA 的 rank 默认设置为 8。用 AdamW 优化器 ,学习率和权重衰减分别设置为 0.0003 和 0。用余弦学习率调度器,预热迭代比设置为 0.03。每个设备的批大小设置为 2,梯度累积步长设置为 10。模型在一块 NVIDIA A800 (80GB) GPU 上用时 2.5 小时完成微调。

数据集:用 PartNet-Mobility 数据集 来训练和评估框架。该数据集包含大量带有 URDF 标注的 3D 关节目标。数据集仅基于目标类别划分为分布内 (ID) 和分布外 (OOD) 子集。由于方法使用图像输入,在仿真环境中渲染数据集中 3D 模型的多视图和单视图 RGB 图像,生成视觉数据。原始 URDF 文件中的真实运动学和几何信息经过处理和重组,形成与模型输出结构相匹配的紧凑 JSON 格式。数据集分为标准训练集和测试集。

基线方法:与三种现有方法进行比较:

- Articulate-Anything,一种 Actor-Critic 系统,通过网格检索机制进行迭代细化,生成可编译成模拟器的代码。

- Real2Code:一种使用定向边框表示物体部件的方法,并使用经过微调的LLM模型将关节参数预测为代码。

- URDFormer:一个直接从真实世界图像构建包含完整关节结构的仿真场景的流程。

评估指标:从三个关键方面评估URDF-Anything框架的性能:部件级几何分割、运动学参数预测精度以及最终重建URDF的物理可执行性。

...

#MiniShift+Simple3D

面向高分辨率3D异常检测的可扩展数据集与实时检测新范式

在工业质检场景中,细微凸起、微划痕等缺陷可能引发严重安全隐患,例如航发动叶片的微小裂纹可能导致高空故障,精冲齿轮的细微划痕会造成啮合失效,而现有3D异常检测技术面临着效率和精度的双重挑战。

来自华中科技大学和湖南大学的团队,提出了全新解决方案------高分辨率数据集MiniShift与实时检测框架Simple3D。其中,MiniShift通过可扩展的异常生成方法,构建了包含2577个点云样本 的数据集,每个样本达500,000点 ,且缺陷占比均低于1% ,首次还原工业级细微缺陷场景;Simple3D集成多尺度邻域描述符(MSND)与局部特征空间聚合(LFSA),以轻量化设计捕捉复杂几何细节,推理速度突破20fps。

二者协同,一举攻克高分辨率下"精准识别"与"高效推理"的核心矛盾,为工业级3D异常检测树立新标杆!

- 论文标题:Towards High-Resolution 3D Anomaly Detection: A Scalable Dataset and Real-Time Framework for Subtle Industrial Defects

- 作者:Yuqi Cheng*, Yihan Sun*, Hui Zhang, Weiming Shen†, Yunkang Cao†

- 机构:华中科技大学智能制造装备与技术全国重点实验室,湖南大学人工智能与机器人学院

- 论文地址:https://hustcyq.github.io/MiniShift-Simple3D

- 代码仓库:https://github.com/hustCYQ/MiniShift-Simple3D

- 数据集:https://huggingface.co/datasets/ChengYuQi99/MiniShift

研究背景与挑战

传统3D异常检测方法普遍存在两个挑战:从数据层面看,主流3D异常检测评测长期依赖低分辨率点云(多下采样至1k点左右),导致工业场景中占比<1%的细微缺陷因空间信息丢失。

如图1(a)所示,一个细微凸起在500k全分辨率点云中清晰可见,8k点云下仍可检测,而下采样到1k点后几乎完全消失,这种分辨率差异直接造成"实验室性能优异,现场检测失效"的行业困境。

从方法层面看,现有基于CNN或ViT的检测模型,在处理高分辨率点云时面临"计算复杂度"与"特征表征精度"的矛盾,团队在评估SOTA方法时发现,这类模型要么因输入点数量激增导致推理速度骤降,无法满足工业实时性要求;要么对局部几何细节表征不足,难以区分细微缺陷与正常表面纹理,最终难以平衡检测精度与效率。

MiniShift数据集+AG-GAS异常合成方法

为打破高分辨率细微缺陷检测的"数据空白",团队创新提出Anchor-Guided Geometric Anomaly Synthesis(AG-GAS)自动化合成框架,打造出首个专注工业细微缺陷的高分辨率数据集MiniShift:

AG-GAS的核心是一套自动化缺陷合成流程(如图2所示):首先随机选取2个锚点,确定连接路径点;再将路径点扩展至局部邻域划定变形区域,通过拉伸操作生成缺陷。与之前仅能模拟局部圆形区域基本突起/凹陷的方法不同,AG-GAS可通过极少参数调整,灵活生成不同形状、尺度的缺陷,精准匹配工业缺陷的随机性与复杂性特征。

基于AG-GAS,MiniShift具备以下特点:

- **规模与分辨率:**包含2577个点云样本,每个样本点云规模达500,000点,远超现有同类数据集,从数据维度还原工业现场高分辨率采集的真实需求。

- **缺陷特性与覆盖:**聚焦工业场景中四类典型细微缺陷------面状、条纹状、划痕、球状,且每类缺陷占比均<1%,精准模拟"毫米级瑕疵隐匿于大尺寸表面"的工业现状。图1 (c)展示了MiniShift代表性样本的可视化,每一行对应一个不同的缺陷类别。

- **分级难度设计:**按"几何显著性+视觉可检测性"将缺陷划分为简单、中等、困难三级,从易到难全面考验模型对细微缺陷的鲁棒识别能力。这一流程既保证了缺陷的工业真实性,又通过分级设计覆盖不同难度场景,希望解决"实验室性能优异,现场检测失效"的行业痛点。

Simple3D框架:轻量高效

针对高分辨率点云检测的效率与精度难题,Simple3D摒弃复杂深度学习骨干网络,采用"手工设计特征+高效聚合"的创新思路,核心包含两大模块:

**多尺度邻域描述符(MSND):**为每个点提取不同邻域尺度的特征并拼接,充分捕捉局部几何细节,适配不同大小的细微缺陷。

**局部特征空间聚合(LFSA):**通过随机采样和层级聚合,扩大特征感受野,在不增加计算量的前提下提升特征判别力。

整个流程简洁高效:输入高分辨率点云→MSND提取多尺度特征→LFSA空间聚合增强→基于原型对比输出异常分数,端到端完成点级和目标级异常检测。

实验结果与分析:全数据集SOTA

定量结果

Simple3D在自主构建的高分辨率数据集MiniShift(Table 2),及Real3D-AD、Anomaly-ShapeNet、MulSen-AD三大主流公开基准(Table 3),表现全面领先现有方法:

从Table 2可见,随着难度提升,现有方法性能普遍大幅下滑,而Simple3D始终保持稳定优势;为验证 Simple3D 的通用适配能力,团队在Real3D-AD、Anomaly-ShapeNet、MulSen-AD上进一步测试,结果显示其在不同数据分布与缺陷类型下,均刷新SOTA记录(Table 3):

定性结果

通过可视化对比可以看到:Simple3D定位的异常图呈现出显著优于对比方法的精准度与清晰度。

高分辨率表示的重要性: 实验通过控制输入点云分辨率(从256点到8192点),固定 LFSA 聚合点数为 16,分析分辨率对检测性能的影响(如图 6 第一行),结果清晰证明:高分辨率是精准识别工业级微缺陷的核心前提。

聚合局部特征的有效性: 为验证局部特征聚合对检测性能的增益,团队围绕LFSA模块的聚合点数展开消融实验,系统调整邻域聚合规模,固定输入分辨率为4k点,结果(如图6第二行所示)明确了"聚合点数越多,特征区分性越强"的规律。

**速度与效率分析:**实验以Anomaly-ShapeNet为测试对象,分析分辨率与LFSA聚合点数对推理速度(FPS)的影响(如图 6 最后一列),验证Simple3D的效率优势。

总结与展望

Simple3D与MiniShift的组合,提出了一套覆盖"数据合成-算法检测-工业落地"的全流程高分辨率 3D 异常检测方案,这套方案已在工业零件质检中展现出巨大应用潜力,未来有望扩展到更多场景。你觉得这套高分辨率3D异常检测方案,还能应用在哪些场景?欢迎在评论区留下你的想法!

...

#特斯拉3D重建可以参考的前馈GS算法有哪些?

推荐最新一篇有关Feed-Forward 3D Reconstruction的综述文章[2507.14501] Advances in Feed-Forward 3D Reconstruction and View Synthesis: A Survey

最近在用3DGS做三维重建,过去per-scene optimization的方法实在用起来不方便,所以开始对feed-forward optimization的方法产生兴趣。下文总结了最新的一些有关feed-forward 3DGS研究的论文,以供参考!

回顾时间线,事实上feed-forward的想法在NeRF中就已经出现了,比如LRM和Instant3D。因此自然而然在3DGS领域也开始有人探索这样的方式是否可行。最早有4篇出现在CVPR2024上,具体如下:

pixelSplat: 3D Gaussian Splats from Image Pairs for Scalable Generalizable 3D Reconstruction【CVPR2024 Oral, Best Paper Runner-Up】

代码链接:https://github.com/dcharatan/pixelsplat

图 3. pixel-aligned Gaussians的概率预测。对于输入特征图中的每个像素特征 F[u],神经网络 f 预测高斯基元参数 Σ 和 S。高斯位置 μ 和不透明度 α 并非直接预测,否则会导致local minima。

pixelSplat当年差一点就拿了CVPR2024的best paper,所以影响力可见一斑。

为了能将3D Gaussians集成到end-to-end可微系统中,需要克服local minima的问题。在per-scene optimization中,按照原始3DGS的做法可以通过pruning和division heuristics,但是它们都是不可微的。因此,pixelSplat的想法就是能否在训练过程中隐式地生成或删除高斯基元(Gaussian primitives),从而避免局部最小值,但仍能保持梯度流。

为了解决上述问题,pixelSplat通过encoder预测dense probability distributions,并从该概率分布中采样高斯均值。同时,它通过reparameterization trick使此采样操作可微分,从而能够通过高斯分布反向传播梯度。

另外一个值得注意的地方是pixelSplat在每个forward pass中仅需要使用一对图片。它证明了从对极 Transformer 中学习到的跨视图感知特征的重要性。当然pixelSplat还有很多技术细节值得去讨论一下,有机会再补吧......

当然pixelSplat仍然存在一些不足,仅凭图像特征预测可靠的概率深度分布仍然具有挑战性,这使得pixelSplat的几何重建质量相对较低,并且存在噪声伪影。而且,从特征到深度分布的映射本质上是模糊且不可靠的,可能会导致糟糕的几何重建。

GPS-Gaussian: Generalizable Pixel-wise 3D Gaussian Splatting for Real-time Human Novel View Synthesis【CVPR2024 Highlight】

代码链接:https://github.com/aipixel/GPS-Gaussian

图 2. GPS-Gaussian提取图像特征,然后进行迭代深度估计。对于每个源视角,深度图和RGB图像分别用作3D位置图和颜色图,以构建高斯表示,而3D高斯的其他参则以像素级方式进行预测。两个视图的2D图像平面上定义的高斯参数图进一步反投影到3D空间,并聚合在一起以实现新颖的视图。 GPS-Gaussian在arxiv挂出来的时间更早一些,而且它的成果已经转化为TPAMI(见GPS-Gaussian+)。

GPS-Gaussian引入了2D Gaussian parameter (position, color, scaling, rotation, opacity) maps,这些maps定义在源视角图像平面上,而不是非结构化点云上。**Gaussian parameter maps使我们能够用像素级参数来表示重建场景,即每个前景像素对应一个特定的高斯点。**此外,它还支持使用高效的二维卷积网络,而不是昂贵的三维算子。得到了二维parameter maps之后,可以通过双目立体视觉估计两个源视角的深度图,从而得到三维高斯点,这是一种可学习的反投影操作。这些来自两个源视角的反投影高斯点构成了表征,而新视图图像可以用Splatting技术进行渲染。

但是作者发现由于人物角色存在严重的自遮挡,现有的cascaded cost volume方法难以解决上述深度估计问题。因此,GPS-Gaussian提出学习一种基于迭代立体匹配的深度估计方法以用于高斯参数回归,并在大规模数据上联合训练这两个模块。最优深度估计有助于提高确定三维高斯位置的精度,同时最小化高斯模块的渲染损失,纠正深度估计可能产生的伪影。这种联合训练策略使每个组件都受益,并提高了训练过程的整体稳定性。

GPS-Gaussian的不足在于它主要用于人体重建,而非一般场景。而且,它依赖于两幅校正后的立体图像来估计视差。在训练过程中,GPS-Gaussian 需要ground truth depth作为监督。

Triplane Meets Gaussian Splatting: Fast and Generalizable Single-View 3D Reconstruction with Transformers【CVPR2024】

代码链接:https://github.com/vast-ai-research/triplanegaussian

图 2. TriplaneGaussian框架的概览。

TriplaneGaussian是第一个利用Gaussian Splatting从single-view图像实现generalizable 3D reconstruction的研究。它主要利用的是triplane表示。

Splatter image: Ultra-fast single-view 3d reconstruction【CVPR2024】

代码链接:https://github.com/szymanowiczs/splatter-image

图 1. Splatter Image 是一种用于单视图和少视图三维重建的超高效方法。它使用图像到图像神经网络将输入图像映射到另一幅图像,该图像每像素包含一个彩色三维高斯分布的参数。Splatter Image 仅使用单个 GPU 进行训练,即可在合成、真实和大规模数据集上实现卓越的三维重建质量。 Splatter image是几乎是跟TriplaneGaussian和pixelSplat同一时间放出来的论文。与pixelSplat不同的是,它每次仅需要一张图片来进行重建。

事实上,正如作者在文中写的,Splatter image主要创新之处在于**设计一个简单的网络,使用二维算子将输入图像映射为每个像素一个三维高斯函数。**由此产生的高斯函数集具有图像的形式,也被称之为Splatter Image。

那么这样做有什么好处呢?得益于这种pixel-level的对齐,这样相当于把重建问题转化成了一个学习一个image-to-image网络的问题。并且,这样仅需要使用二维算子(比如2D卷积的U-Net而不是3D的),大大提高了计算的高效性。此外,Splatter Image中的3D表示是3D Gaussian的混合,因此它统一享有Gaussian Splatting的渲染和空间效率,这有利于推理和训练。

图 2. 预测位置。每个高斯函数的位置由深度d和3D偏移量参数化。3D高斯函数沿相机光线(绿色)投影到深度 d(蓝色),并根据3D偏移量进行移动。

而且作者发现,即使网络仅能识别物体的一侧,它仍然可以利用训练过程中获得的先验知识,对物体进行360° 重建。通过在给定的二维邻域中将不同的高斯分布分配给三维物体的不同部分,将 360°信息编码到二维图像中。这确实挺神奇的!作者给出的解释是网络会自动调整3D偏移量和深度d,以分配一些3D高斯函数来重建输入视图,并分配一些3D高斯函数来重建物体的未见部分。

但是,Splatter Image仍然存在着一些问题,它主要关注对象级(object-level)重建,当应用于更一般和更大的场景时,从单个图像重建 3D 场景本质上是不适定的和模糊的。

随着上述四篇文章的出现,feed-forward 3DGS的论文开始逐渐增多,例如:

AGG: Amortized Generative 3D Gaussians for Single Image to 3DAGG: Amortized Generative 3D Gaussians for Single Image to 3D【TMLR2024】

代码链接:无

图 1:AGG 框架概览。我们设计了一种新颖的级联生成流程,无需逐实例优化即可生成基于 3D 高斯分布的对象。我们的 AGG 框架包含一个粗生成器,用于预测低分辨率 3D 高斯分布的混合表示;以及一个超分辨率模块,用于在精细阶段生成密集的 3D 高斯分布。

Gamba: Marry Gaussian Splatting With Mamba for Single-View 3D Reconstruction【TPAMI2025】

代码链接:https://github.com/SkyworkAI/Gamba

图 2:Gamba 的整体架构。Gamba 以单视图图像及其相机姿态作为输入,预测给定对象的 3D Gaussian Splatting。训练监督仅通过重建损失应用于渲染的多视图图像。

Gamba已经在今年中了TPAMI了,Congratulations!有空补一下。

而在ECCV2024上feed-forward 3DGS的论文又迎来了高峰期。

MVSplat: Efficient 3D Gaussian Splatting from Sparse Multi-View Images【ECCV2024 Oral】

代码链接:https://github.com/donydchen/mvsplat

图 2. MVSplat使用Transformer提取多视图图像特征,并构建每个视图的cost volume。Transformer特征和cost volume被连接在一起,作为二维 U-Net的输入被反投影到三维空间,并使用简单的确定性并集运算组合成三维高斯中心。不透明度、协方差和颜色高斯参数与深度图联合预测。

MVSplat是另一类经典的方法,它证明了cost volume表示在学习feed-forward Gaussians中的重要性。由此引申出了今年CVPR2025的两篇文章DepthSplat和MonoSplat。

事实上,cost volume表示并非第一次出现,在GPS-Gaussian中cost volume已经被用来构建深度估计器。在MVSplat中,为了提高几何重建结果,它认为需要添加额外的深度正则化损失以进行缓慢的深度微调。因此,MVSplat通过plane sweeping在三维空间中构建cost volume表示。cost volume储存了所有潜在深度点的跨视图特征相似性,其中相似性可以为3D表面的定位提供有价值的几何线索(即高相似性更有可能指示表面点)。

有关cost volume的具体内容,可参考:https://www.zhihu.com/question/366970399

MVSplat利用cost volume表示方法,将重建该任务重新表述为学习利用特征匹配来识别高斯中心,这与先前研究的图像特征中数据驱动三维回归不同。这种表述降低了任务的学习难度,使我们的方法能够以轻量级的模型尺寸和快速的速度实现最先进的性能。

具体来说,MVSplat通过使用二维网络对multi-view cost volume估计的multi-view-consistent depths进行反投影,以获得三维高斯中心。此外,MVSplat还与depths并行预测其他高斯属性(协方差、不透明度和球面谐波系数)。预测的三维高斯函数通过可微分的 splatting 操作渲染新的视图图像。

MVSplat 是端到端训练的,仅使用渲染图像和真实图像之间的光度损失。但是它依赖于基于特征匹配的多视图深度估计来定位 3D 高斯位置,这使得它与其他多视图深度方法一样,受到类似的限制(例如遮挡、无纹理区域和反射表面)。

GRM: Large Gaussian Reconstruction Model for Efficient 3D Reconstruction and Generation 【ECCV2024】

代码链接:https://github.com/justimyhxu/grm --> 未开源

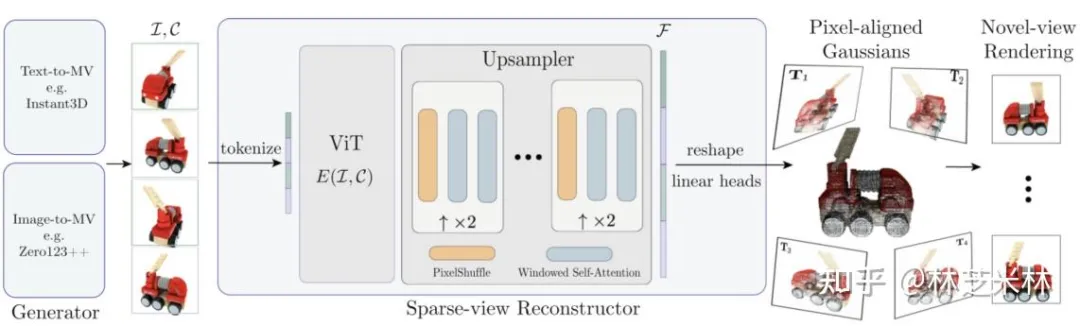

图 2. GRM 流程。给定 4 个输入视图,稀疏视图重建器使用像素对齐的高斯函数,在单次前馈过程中估计底层3D场景。基于 Transformer的稀疏视图重建器配备了一个新颖的基于Transformer的上采样器,能够利用长距离视觉线索高效地生成大量 3D 高斯函数。

GRM比较可惜的是目前还没开源,但是值得提到的一点是,GRM是一个基于feed-forward transformer-based的pixel-aligned Gaussians模型。它有效地整合了多视角信息,将输入像素转换为像素对齐的高斯函数,这些高斯函数无需投影即可创建一组密集分布的三维高斯函数,从而表示一个场景。我们的变换器架构和三维高斯函数的使用共同构建了一个可扩展且高效的重建框架。

具体来说,首先,GRM用3D高斯函数取代了近期前馈生成框架中的triplane场景表示;其次,GRM设计了一个纯Transformer架构,将输入像素集转换为定义输出3D场景的像素对齐的3D高斯函数集。虽然该架构的部分功能使用了标准视觉Transformer (ViT) ,但还引入了一个全新的上采样器,它利用了窗口化自注意力层的变体。该上采样器的独特之处在于能够高效地传递非局部线索。

GS-LRM: Large Reconstruction Model for 3D Gaussian Splatting【ECCV2024】

代码链接:https://github.com/OpenRobotLab/gs-lrm-unofficial

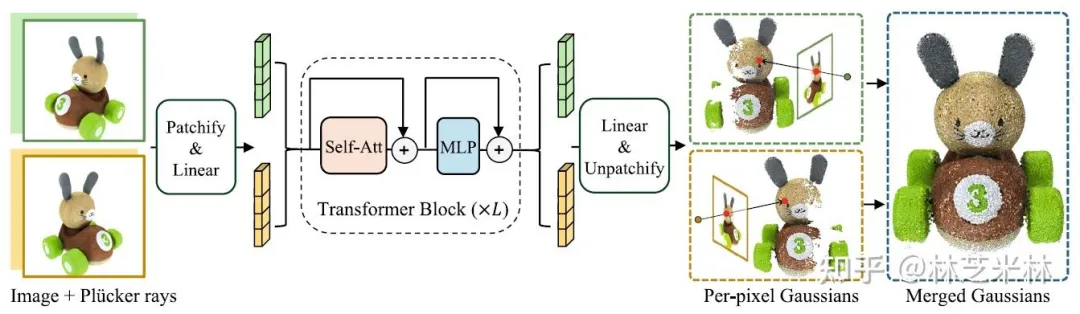

图 2. 基于Transformer的GS-LRM 模型,从稀疏姿态图像中预测 3D 高斯参数。图像被分割,拼接后的分割标记被发送到 Transformer模块。通过对Transformer的输出进行unpatchifying,每个像素都被反投影到3D高斯函数中。最终输出合并了所有 3D 高斯函数。

GS-LRM仍然是采用非常简单的基于Transformer的架构,它的核心是一个简单且可扩展的基于 Transformer 的网络架构,可以预测每个像素的高斯分布。

具体来说,对输入的位姿图像进行patchify得到patch tokens,将连接的多视图图像tokens传递到一系列包含self-attention和MLP层的transformer blocks,然后直接从上下文的多视角tokens中回归出每个视角每个像素的 3D 高斯基元。

作者指出,与之前的LRM不同,之前的LRM需要精心设计额外的(三平面)NeRF 标记来进行重建,GS-LRM将输入(二维图像)和输出(三维高斯)在同一个像素空间中对齐,沿射线方向每个像素预测一个高斯。这种对齐不仅简化了 Transformer架构,也使 3D 高斯能够保留输入图像中的高频细节。此外,预测每像素高斯使GS-LRM能够自由地适应输入图像分辨率,在高分辨率输入中展现准确的场景细节,而之前具有固定三平面分辨率的 LRM 通常难以做到这一点。

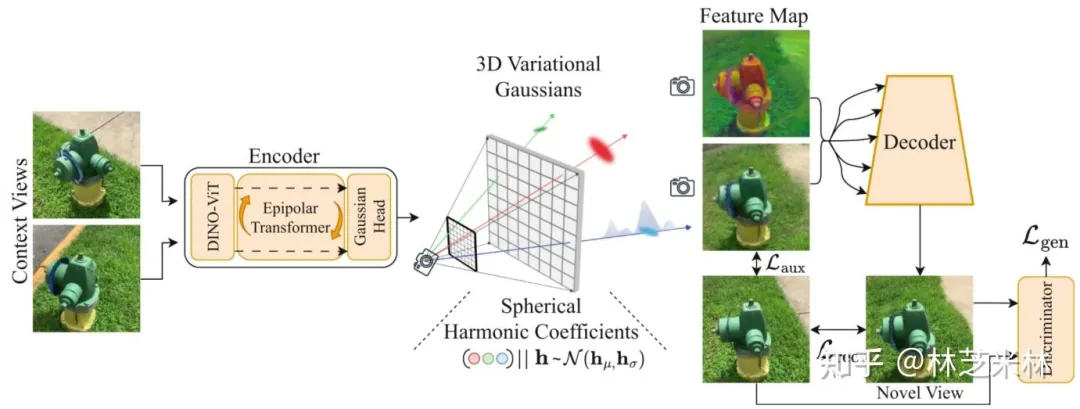

latentSplat: Autoencoding Variational Gaussians for Fast Generalizable 3D Reconstruction【ECCV2024】

代码链接:无

图 2. latentSplat 架构。该架构遵循自动编码器结构。(左)使用对极变换器和高斯采样头将两个输入视图编码为 3D 变分高斯表示。(中)变分高斯允许对球谐函数特征系数进行采样,从而确定语义高斯函数的特定实例。(右)采样的实例可以通过高斯分层和轻量级 VAE-GAN 解码器进行高效渲染。

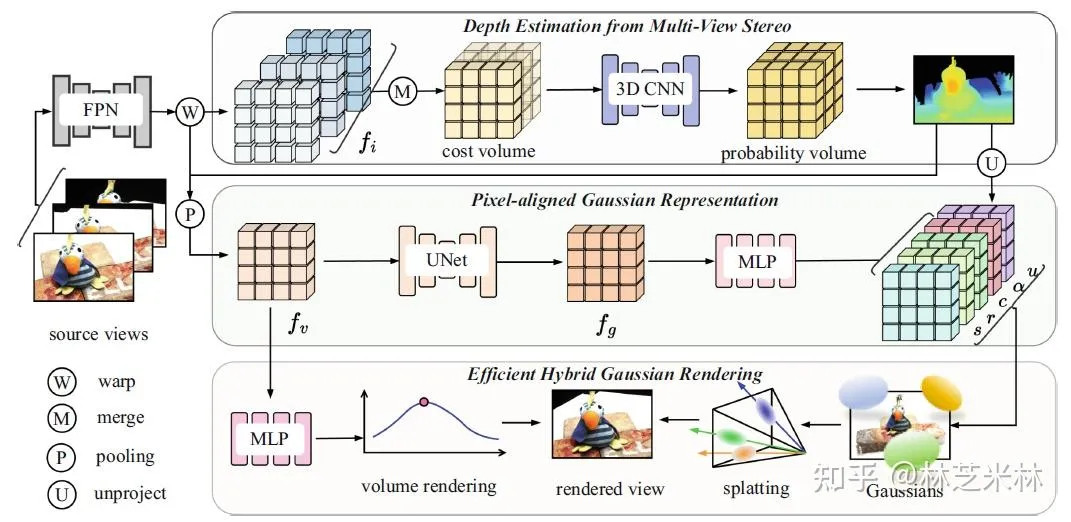

MVSGaussian: Fast Generalizable Gaussian Splatting Reconstruction from Multi-View Stereo【ECCV2024】

代码链接:https://github.com/TQTQliu/MVSGaussian

图 2. MVSGaussian使用 FPN 从输入源视图中提取特征。这些特征被聚合成一个cost volume,并由3D CNN进行正则化以生成深度。随后,对于每个3D点,使用池化网络聚合扭曲的源特征,获得聚合特征。然后使用2D UNet增强该特征,得到增强特征并被解码为高斯参数。聚合特征被解码为volume density和radiance。

作者总结了generalizable Gaussian Splatting framework面临的三个挑战:1)3DGS 是一种参数化的显式表示,它使用数百万个3D高斯函数来过拟合场景。当将预训练的3DGS应用于未见过的场景时,3D高斯函数的参数(例如位置和颜色)会显著不同。设计一个可泛化的表示来适用于3DGS并非易事。2)先前可泛化的 NeRF通过volume rendering实现了令人印象深刻的新视图合成结果。然而,Splatting 的泛化能力仍未被探索。在 Splatting 过程中,每个高斯函数都会对图像中特定区域内的多个像素做出贡献,而每个像素的颜色由多个高斯函数的累积贡献决定。高斯函数与像素之间的颜色对应关系是一种更复杂的多对多映射,这对模型泛化提出了挑战。3)可泛化的 NeRF 模型表明,针对特定场景进行进一步微调可以显著提升合成图像质量,但需要耗时的优化过程。尽管 3DGS 模型比 NeRF 模型速度更快,但仍然耗时。设计一种基于可泛化的 3DGS 模型的快速优化方法具有广阔的应用前景。

为此,作者提出了MVSGaussian,分别解决三个挑战:1)利用Multi-View Stereo (MVS)来编码几何感知的pixel-aligned高斯表示,并将其解码为高斯参数。2)为了进一步提升性能,提出了一种混合高斯渲染,该渲染集成了高效的体绘制设计,用于新颖的视图合成。3)为了支持针对特定场景的快速微调,引入了一种多视图几何一致性聚合策略,以有效地聚合由泛化模型生成的点云,作为每个场景优化的初始化。

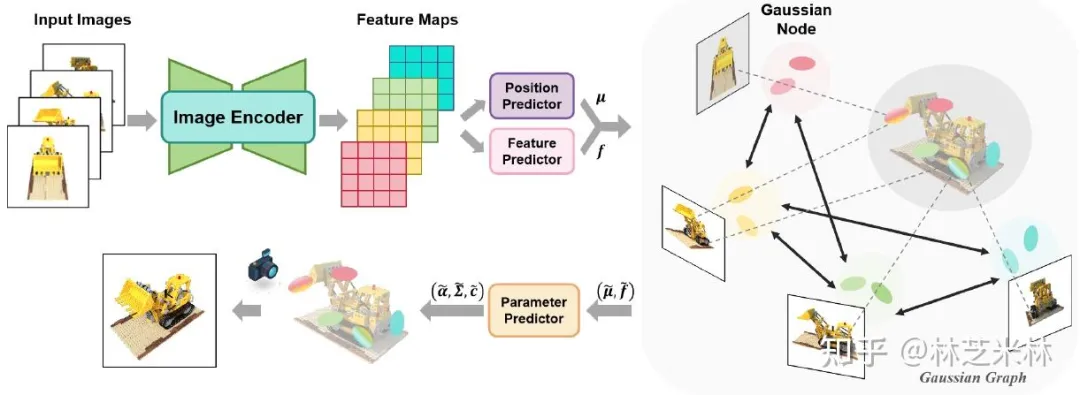

Gaussian Graph Network: Learning Efficient and Generalizable Gaussian Representations from Multi-view Images【NIPS2024】

代码链接:https://github.com/shengjun-zhang/GGN

图 2:高斯图网络概览。给定多幅输入图像,我们提取图像特征并预测pixel-aligned Gaussians的均值和特征。然后,我们构建一个高斯图来建模不同高斯节点之间的关系。我们引入高斯图网络来处理高斯图。参数预测器根据输出的高斯特征生成高斯参数。

到目前为止,绝大多数方法feed-forward 3DGS方法都是pixel-aligned的。正如本文作者提到,之前方法只是简单地将来自多个视图的像素对齐的高斯函数组合起来作为场景表示。这样的做法有可能导致伪影和额外的内存成本,而没有完全捕捉来自不同图像的高斯函数之间的关系。

Gaussian Graph Network (GGN) 构建了Gaussian Graph,将传统的图操作扩展到高斯域,使得来自不同视角的高斯函数不再相互独立,而是可以从其邻近组进行学习,因此从不同视角对Gaussian groups之间的关系进行建模。具体来说,GGN将边的标量权重重新表述为权重矩阵,以描述两个高斯组之间的相互作用,使每个高斯组都能通过高斯特征融合从其连通的高斯组中获益。此外,GGN引入高斯池化策略来聚合高斯函数,以实现高效的表示。

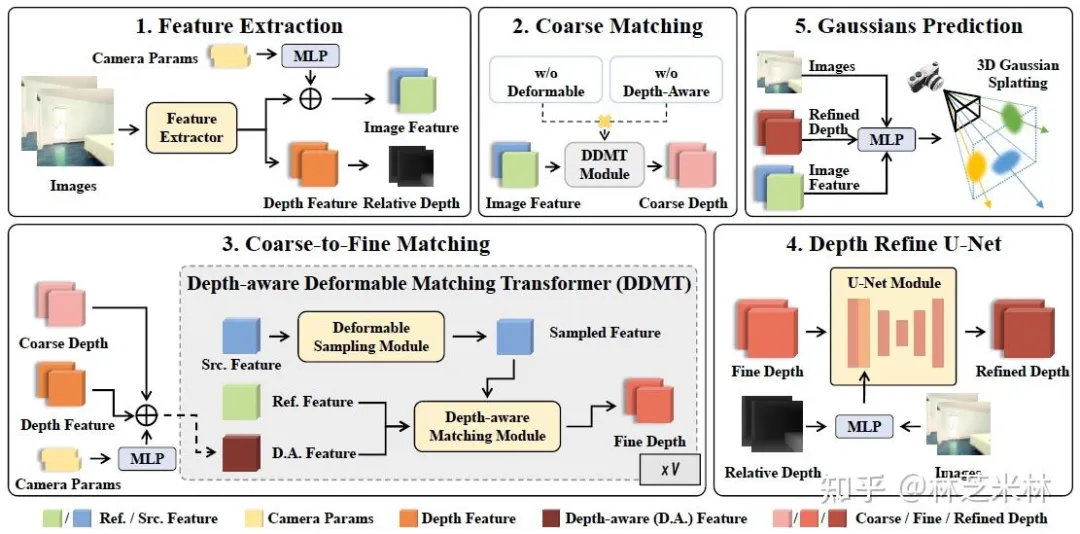

TranSplat: Generalizable 3D Gaussian Splatting from Sparse Multi-View Images with Transformers【AAAI2025】

代码链接:https://github.com/xingyoujun/transplat

图 2:TranSplat 框架。我们的方法以多视角图像作为输入,首先提取图像特征和单目深度先验。具体而言,我们使用我们提出的深度感知可变形匹配变换器 (Depth-Aware Deformable Matching Transformer) 模块计算多视角特征相似度,以获得几何一致的深度分布。然后使用深度精炼 U-Net 进一步精炼深度预测。

TranSplat想要解决的问题是,现有Generalizable 3D Gaussian Splatting方法的良好重建性能在很大程度上依赖于精确的多视图特征匹配,这颇具挑战性。尤其对于不同视图之间存在大量不重叠区域且包含大量相似区域的场景,现有方法的匹配性能较差,重建精度有限。

TranSplat仍然是通过将每个像素投影到三维高斯基元中,利用预测的深度和特征,从稀疏视图中恢复三维结构。但是与之前的方法有两点不同。1)为了精确估计三维高斯中心,TranSplat使用一个基于变换器的模块Depth-aware Deformable Matching Transformer (DDMT)来生成深度估计。该模块根据初始深度分布对具有高置信度的深度候选点进行优先排序,该初始深度分布由粗匹配模块通过评估跨视图特征相似性计算得出。2)TranSplat 利用单目深度先验,并使用深度细化 U-Net 进一步细化深度分布。利用细化的深度和图像特征,TranSplat可以并行预测每个像素的所有高斯参数。TranSplat 采用端到端训练,仅使用真实图像进行监督。

但是从结果来看,其实提升并不明显,虽然memory下降了,但是time反而上升了。

Hisplat: Hierarchical 3d gaussian splatting for generalizable sparse-view reconstruction【ICLR2025】

代码链接:https://github.com/Open3DVLab/HiSplat

图 1:HiSplat 与以往方法的比较。HiSplat 构建了分层的 3D 高斯函数,可以更好地表示大规模结构(定位更准确、裂纹更少)和纹理细节(伪影更少、模糊更少)。

作者提到,现有generalizable 3D Gaussian Splatting方法使用提取的单尺度特征来生成固定分辨率的splatter images。均匀的 3D 高斯分布导致缺乏层次化表示,难以同时捕捉大规模结构和精细的纹理细节。因此,它会导致诸如模糊、裂缝、错位和伪影等问题。

受二维多尺度特征成功的启发,一个自然而然的问题出现了:作为类似于二维特征的显式三维表示,三维高斯函数能否从层次结构中获益,从而释放其表征能力的潜力?但是作者通过实验发现应用hierarchical manner并不是一件易事,其核心问题在于,多尺度三维高斯函数是独立生成的,无法捕捉尺度间的信息。

图 2:HiSplat的整体框架。以两幅输入图像为例,HiSplat利用共享的U-Net主干提取不同尺度的特征。利用这些特征,三个处理阶段分别预测不同尺度的像素对齐高斯参数。Error aware module和modulating fusion module在早期阶段感知错误,并在后期阶段引导高斯函数进行补偿和修复。

HiSplat在generalizable 3DGS中引入了一种分层方式,通过由coarse-to-fine strategy构建分层3D Gaussians。为了促进不同尺度之间的相互作用,HiSplat提出了一个基于注意力机制的错误感知模块,该模块允许细粒度高斯函数专注于补偿粗粒度高斯函数产生的误差,即高斯补偿。此外,为了进一步校正错误的高斯函数,我们提出了一个调制融合模块,该模块基于输入参考图像的渲染质量和当前的联合特征,重新加权大尺度高斯函数的不透明度,即高斯修复。通过整合高斯补偿和修复,可以实现分层三维高斯函数的联合优化。在训练过程中,每个阶段都会对渲染图像进行监督,以引入更多梯度流并提供更丰富的深度信息,从而实现更快的收敛速度和更佳的定位精度。在推理过程中,仅使用最终的融合高斯函数进行渲染。

----------------------------------------手动分割线----------------------------------------

来到2025年,仍然先关注一下CVPR。CVPR2025上有两篇算是MVSplat的继承之作,分别是DepthSplat和MonoSplat。

DepthSplat: Connecting Gaussian Splatting and Depth【CVPR2025】

代码链接:https://github.com/cvg/depthsplat

图 1. DepthSplat 实现了高斯分层和深度之间的跨任务交互。左图:更好的深度可提升高斯分层重建效果。右图:使用Gaussian splatting进行无监督深度预训练可降低深度预测误差。

DepthSplat主要的贡献就是将Gaussian splatting和depth estimation这两个单独研究的领域连接起来,并研究它们之间的相互作用。如上图所示,DepthSplat首先利用预训练的单目深度特征,构建了一个鲁棒的多视图深度模型,从而实现高质量的前馈三维高斯分布重建。另外,DepthSplat还证明了高斯分布重建可以作为无监督预训练目标,用于从大规模多视图姿态数据集中学习强大的深度模型。

作者提到,一方面,MVSplat依赖于基于特征匹配的多视图深度估计来定位三维高斯位置,这使得它与其他多视图深度方法面临类似的限制(例如遮挡、无纹理区域和反射表面)。另一方面,单目深度估计已经取得了显著进展,最近的模型在各种自然数据上实现了稳健的预测。然而,这些深度通常缺乏跨多视图的一致尺度,限制了它们在三维重建等下游任务中的表现。因此,DepthSplat想要克服每种技术的局限性,同时增强它们的优势,即利用sparse-view feed-forward 3DGS 和稳健monocular depth estimation的互补特性来提高这两项任务的性能。

图 2. DepthSplat 将深度估计和 3D 高斯 splatting 通过共享架构连接起来,从而实现跨任务迁移。

具体来说,相比于MVSplat,DepthSplat通过将预训练的单目深度特征(来自Depth anything v2模型)集成到多目特征匹配分支,构建了一个鲁棒的多目深度模型。该模型不仅保持了多目深度模型的一致性,而且在难以匹配的情况下(例如遮挡、无纹理区域和反射表面)也能获得更鲁棒的结果。剩下的就与MVSplat类似。

作者提到先前的方法也尝试融合单目和多目深度,但它们通常依赖于复杂的架构。相比之下,DepthSplat直接使用现成的预训练单目深度模型,并提出使用单目特征来增强multi-view cost volumes,从而简化模型并提升性能。但事实上,笔者认为这一套流程相比于MVSplat其实并没有太大差别,拿一个现成预训练模型结合其实在很多cv任务上是很常见的做法了。

MonoSplat: Generalizable 3D Gaussian Splatting from Monocular Depth Foundation Models【CVPR2025】

代码链接:https://github.com/CUHK-AIM-Group/MonoSplat

图 1. MonoSplat 框架示意图。我们将深度基础模型重新应用于可泛化的高斯重建框架。

另一个用预训练深度模型的方法是MonoSplat。作者强调,以前方法在处理具有不熟悉的视觉内容和布局的场景时常常会遇到限制,因为它们对视觉世界的理解受到训练数据分布的限制,并且受到零样本域泛化挑战的阻碍。这一观察促使研究如何利用最先进的单目深度基础模型中嵌入的丰富视觉先验知识,以实现更稳健、更泛化的高斯重建。当然类似的DepthSplat方法由于使用双分支网络架构引入了冗余的模型参数。

图 2. 所提出的 MonoSplat 框架示意图。该框架包含一个单目-多目特征适配器,用于将单目特征转换为具有跨视图感知能力的多视图特征;以及一个集成高斯预测,用于将单目特征集成到高斯基元预测中。

相比之下,MonoSplat通过直接利用冻结的深度基础模型,并优雅地将单目特征转换为多视图表示,实现了卓越的效率,从而产生了更高效、更有效的解决方案。

正如之前所说,这一套做法事实上在CV其他领域很常见,效果也是很不错。

当然,还有几篇有关depth的文章可以参考一下:

**JointSplat: Probabilistic Joint Flow-Depth Optimization for Sparse-View Gaussian Splatting ** 代码链接:无

图 2:JointSplat的系统流程。给定稀疏视图图像,其相机本征函数为 K,相对姿态为 Ti→i+1,我们使用预训练模型提取混合深度特征和光流特征。然后引入概率优化机制来扩展深度和光流之间的信息融合,以获得精细的深度估计,并将其反向投影以确定高斯中心,从而实现高质量的新视图合成。

Revisiting Depth Representations for Feed-Forward 3D Gaussian Splatting

代码链接:https://github.com/aim-uofa/PM-Loss -->未开源

图 2:PM-Loss 概览。该过程首先使用预训练模型估计场景的稠密点图。然后,该估计的点图作为直接 3D 监督,用于训练feed-forward 3D Gaussian Splattin模型。至关重要的是,与主要依赖 2D 监督的传统方法不同,我们的方法利用明确的 3D 几何线索,从而增强 3D 形状保真度。

随着feed-forward 3DGS研究的发展,研究者们开始在更多的应用领域进行研究。以下举几个例子。

Generalizable Human Gaussians for Sparse View Synthesis【ECCV2024】

代码链接:https://github.com/humansensinglab/Generalizable-Human-Gaussians

图 2. (a) 专注于在非常稀疏的视图设置下实现可泛化的人体渲染。(b) 首先通过扩张人体模板表面来构建多支架。每个支架的二维UV空间用于收集相应三维位置的几何和外观信息。(c) 聚合后的多支架输入被输入到网络中,生成多高斯参数图。(d) 将高斯分布锚定在每个支架的相应表面上,并光栅化为新的视图。

HumanSplat: Generalizable Single-Image Human Gaussian Splatting with Structure Priors【NIPS2024】

代码链接:https://github.com/humansplat/humansplat

图 2:HumanSplat 概览。(a) 首先通过微调的multi-view diffusion model(3.3 节中的新型视图合成器)生成多视图潜在特征。(b) 然后,潜在重建变换器(3.4 节)将全局潜在特征(3.4.1 节)与人类几何先验(3.4.2 节)进行交互。(c) 最后,提出语义引导目标(3.5 节)来重建最终的人类 3DGS。

DrivingForward: Feed-forward 3D Gaussian Splatting for Driving Scene Reconstruction from Flexible Surround-view Input【AAAI2025】

代码链接:https://github.com/fangzhou2000/DrivingForward

图 2:给定来自车载摄像头的稀疏环视输入,我们的模型从空间和时间上下文视图的微小重叠中学习高斯基元的尺度感知定位。高斯网络分别预测每幅图像中的其他参数。该前馈流水线支持实时重建驾驶场景,而基于单帧图像的独立预测支持灵活的输入模式。在推理阶段,我们仅包含深度网络和高斯网络。

EVolSplat: Efficient Volume-based Gaussian Splatting for Urban View Synthesis【CVPR2025】

代码链接:https://github.com/Miaosheng1/EVolSplat

X-GRM: Large Gaussian Reconstruction Model for Sparse-view X-rays to Computed Tomography

代码链接:https://github.com/CUHK-AIM-Group/X-GRM --> 未开源

图 2:X-GRM 是一个大型前馈变换器,在精选的大型 CT 重建数据集上进行训练。(a) X 射线重建变换器能够高效地编码和融合来自多个 X 射线投影的标记;(b) 基于体素的高斯分层技术能够实现高效的 CT 体积提取和可微分的 X 射线渲染。

...

#Depth-Anything-3

3D视觉被过度设计?字节Depth Anything 3来了,谢赛宁点赞

现在,只需要一个简单的、用深度光线表示训练的 Transformer 就行了。

这项研究证明了,如今大多数 3D 视觉研究都存在过度设计的问题。

本周五,AI 社区最热门的话题是一篇新论文,有关 3D 建模的。

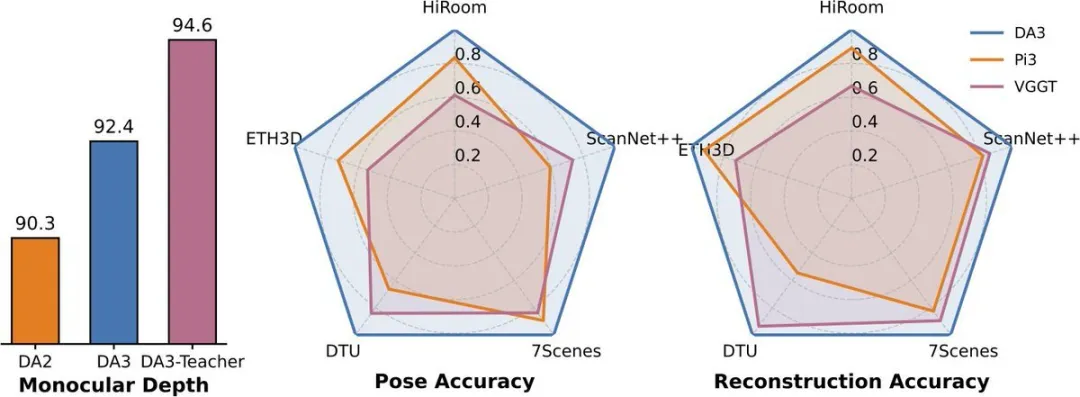

经过一年多的探索,来自字节跳动的团队推出了 Depth Anything 3(DA3),将单目深度估计扩展到了任何视角场景,让计算机实现了媲美人类的空间感知。

- 论文:https://arxiv.org/abs/2511.10647

- 项目页面:https://depth-anything-3.github.io

- 代码:https://github.com/ByteDance-Seed/Depth-Anything-3

- Hugging face Demo: https://huggingface.co/spaces/depth-anything/depth-anything-3

为了追求最小建模,DA3 的工作获得了两个关键见解:

- 搞 3D 视觉,一个普通的 Transformer(如标准的 DINO)就够了,不需要专门的架构。

- 只需单一深度射线表示即可,无需复杂的 3D 任务。

就是这样的方法,在姿态估计方面比当前业界最先进的方法 (SOTA) 提升了 44%,在几何估计方面提升了 25%。

原来 3D 视觉竟然这么简单?

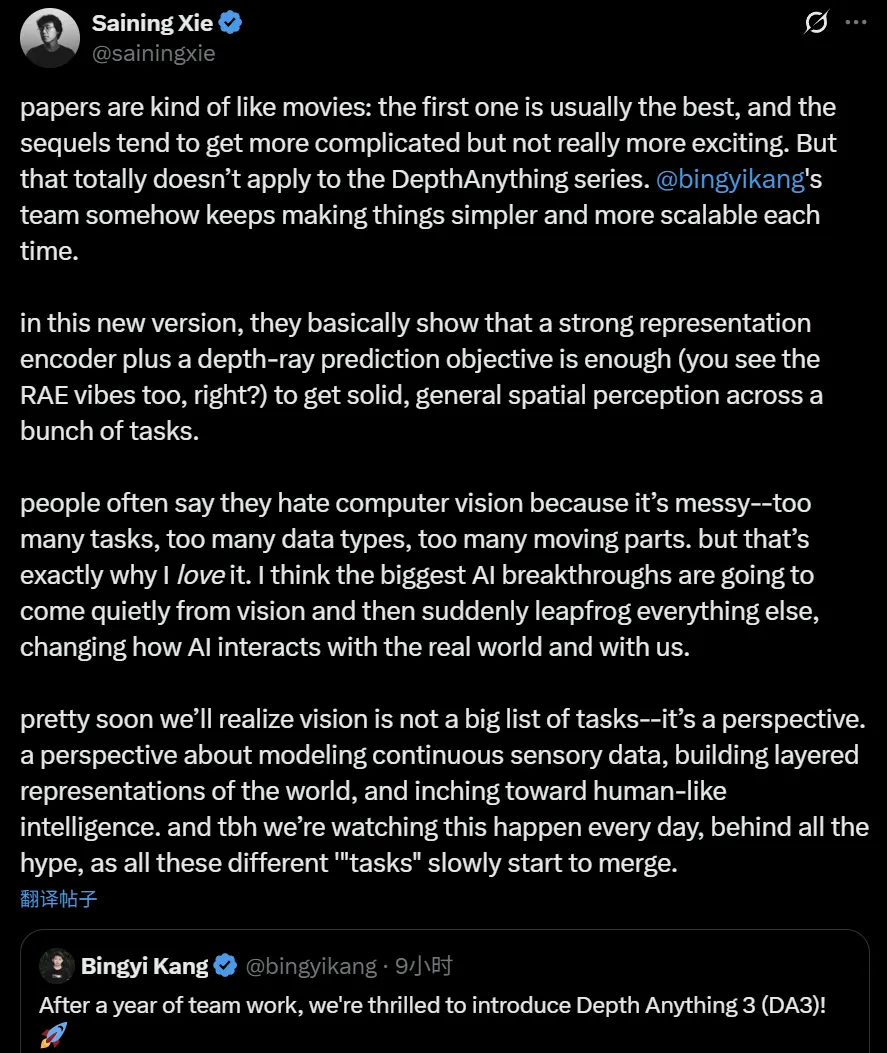

纽约大学计算机科学助理教授、知名 AI 学者谢赛宁表示,论文有点像电影:第一部通常是最好的,续集往往更复杂却并不更精彩。但这完全不适用于 DepthAnything 系列。 Bingyikang 的团队每次都能让事情变得更简单、更易于扩展。

谢赛宁感叹道,「在 Depth Anything 3 上,作者基本上表明,一个强大的表示编码器加上一个深度光线预测目标就足以在很多任务中获得可靠的、通用的空间感知(可以看到 RAE 的影子)。」

「人们常说他们讨厌计算机视觉,因为它太复杂 ------ 任务太多、数据类型太多、涉及的环节太多。但这恰恰是我喜欢它的原因。我认为人工智能最大的突破将悄然来自视觉领域,然后突然间超越其他所有领域,彻底改变 AI 与现实世界,以及我们人类的互动方式。」

「我们很快就会意识到,视觉并非一系列任务的罗列 ------ 它是一种视角。这种视角关乎对连续感官数据进行建模,构建世界的分层表征,并逐步迈向类人智能。说实话,在所有炒作的背后,我们每天都在见证着这一切的发生,所有这些不同的『任务』正慢慢地开始融合。」

概述

Depth Anything 3 (DA3) 是一种能够根据任意数量的视觉输入预测空间一致几何形状的模型,无论是否已知相机位姿。为了实现最小化建模,DA3 带来了两个关键发现:仅需一个简单的 Transformer 架构(例如,原始的 DINOv2 编码器)即可作为骨干网络,无需进行架构上的特殊设计;单一的深度光线预测目标也能避免复杂的多任务学习。

Depth Anything 3 目前已发布三个系列:主 DA3 系列、单目测量估计系列和单目深度估计系列。

在方法上,Depth Anything 3 将几何重建目标建模为一个密集预测任务。对于给定的 N 张输入图像,该模型经过训练,可以输出 N 个对应的深度图和光线图,每个深度图和光线图都与其对应的输入图像像素对齐。实现这一目标的架构以标准的预训练视觉 Transformer 作为骨干网络,充分利用其特征提取能力。

为了处理任意数量的视图,作者引入了一个关键的改进:输入自适应的跨视图自注意力机制。该模块在前向传播过程中,会在选定的层中动态地重新排列 token,从而实现跨视图的高效信息交换。对于最终的预测,作者提出了一种新的双 DPT 头,它通过处理同一组具有不同融合参数的特征,联合输出深度值和光线值。为了增强灵活性,该模型可以通过一个简单的相机编码器选择性地整合已知的相机姿态,使其能够适应各种实际场景。这种整体设计形成了一个简洁且可扩展的架构,并直接继承了其预训练骨干网络的扩展特性。

在训练上,Depth Anything 3 模型采用了师生范式,以统一各种不同的训练数据。数据源包括多种格式,例如真实世界的深度相机捕获数据、3D 重建数据以及合成数据。

其中真实世界的深度数据质量可能较差。为了解决这个问题,作者采用了一种受先前工作启发的伪标注策略,使用合成数据训练一个强大的单目深度模型,从而为所有真实世界数据生成密集、高质量的伪深度图。事实证明,这种方法非常有效,在不牺牲几何精度的前提下,显著提高了标签的细节和完整性。

为了更好地评估模型并跟踪该领域的进展,作者还建立了一个新的视觉几何基准,涵盖相机姿态估计、任意视图几何(TSDF 重建)和视觉渲染。

DA3 在所有 10 项任务中都取得了新的 SOTA 成绩,在相机姿态精度方面比之前的 SOTA VGGT 平均提高了 35.7%,在几何精度方面提高了 23.6%。它在单目深度估计方面优于 Deepth Anything V2,同时在细节和鲁棒性方面与之相当。

所有模型均完全基于公开的学术数据集进行训练。

此外,Depth Anything 3 具备多种强大功能,进一步展示了其广泛的应用潜力:

- 视频重建:DA3 能够从任意数量的视图中恢复视觉空间,涵盖从单视图到多视图的范围。这个演示展示了 DA3 从一段复杂视频中恢复视觉空间的能力。

- 大规模场景的 SLAM:精确的视觉几何估计能够提升 SLAM 的性能。定量结果表明,在大规模环境下,仅用 DA3 替换 VGGT-Long 中的 VGGT(DA3-Long)就能显著降低漂移,其效果甚至优于需要 48 小时以上才能完成的 COLMAP。

,时长01:24

- 前馈 3D 高斯估计:通过冻结整个主干网络,并在多个数据集上训练 DPT 头部来预测 3DGS 参数,该模型实现了非常强大且具有很强泛化能力的新颖视图合成能力。

,时长00:34

- 基于多摄像头的空间感知:DA3 能够从车辆的不同视角获取多张图像,并估计出稳定且可融合的深度图,从而增强自动驾驶车辆对环境的理解,研究团队认为这在机器人领域也是可以实现的。

,时长00:28

Depth Anything 3 发布后,已有不少开发者表示要把这个新方法引入自己的项目中,可见这种简单高效的设计,是人们所需要的落地方向。

更多内容,可参考原技术报告。

参考链接:

https://x.com/bingyikang/status/1989358278346977486

https://x.com/sainingxie/status/1989423686882136498?s=20

...

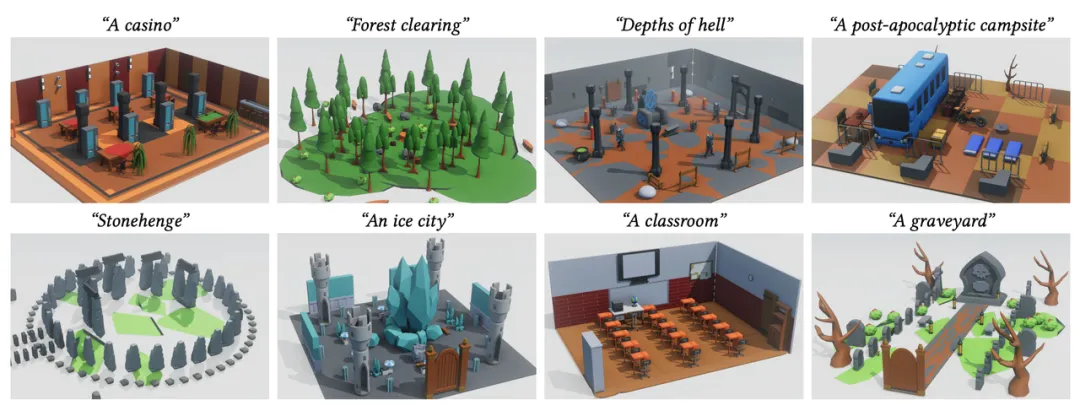

#Procedural Scene Programs for Open-Universe Scene Generation: LLM-Free Error Correction via Program Search

让3D场景生成像「写代码」一样灵活可控

随着生成式 AI 的快速发展,从文本生成图像、视频,到构建完整的三维世界,AI "创造空间" 的能力正以前所未有的速度突破边界。然而,现有 3D 场景生成方法仍存在明显局限:模型往往直接输出每个物体的几何参数(位置、大小、方向等),结果容易出现漂浮、重叠、穿模等问题;场景结构缺乏逻辑一致性,难以编辑或复用,更无法像程序那样精确控制空间关系与生成逻辑。

想象这样一个画面:你输入一句话 ------

"在黄昏的码头上,一位渔夫坐在木椅上,旁边是一盏摇曳的灯。"

AI 不再只是 "摆放" 这些元素,而是生成一段可执行的三维构建脚本:从灯光的照射角度到渔夫与木椅的相对位置,都由程序逻辑自动推导与控制。

这种 "从语言到程序再到场景" 的新范式,正是由布朗大学(Brown University)与加州大学圣地亚哥分校(UC San Diego)的研究团队提出的 Procedural Scene Programs(PSP) 框架。

与传统的几何直接生成方法不同,PSP 让 AI 不再是 "画" 出一个世界,而是像程序员一样 "写" 出世界的生成逻辑。模型输出的不是静态的三维网格,而是一段可运行的场景脚本,具备高度的可编辑性、可复用性与结构可控性 ------ 为 AI 世界构建带来了新的语言与思维方式。

该研究已被计算机图形学顶会 SIGGRAPH Asia 2025 接收。

- 论文题目:Procedural Scene Programs for Open-Universe Scene Generation: LLM-Free Error Correction via Program Search

- 作者:Maxim Gumin, Do Heon Han, Seung Jean Yoo, Aditya Ganeshan, R. Kenny Jones, Kailiang Fu(傅楷量), Rio Aguina-Kang, Stewart Morris, Daniel Ritchie

- 论文链接:https://arxiv.org/abs/2510.16147

方法

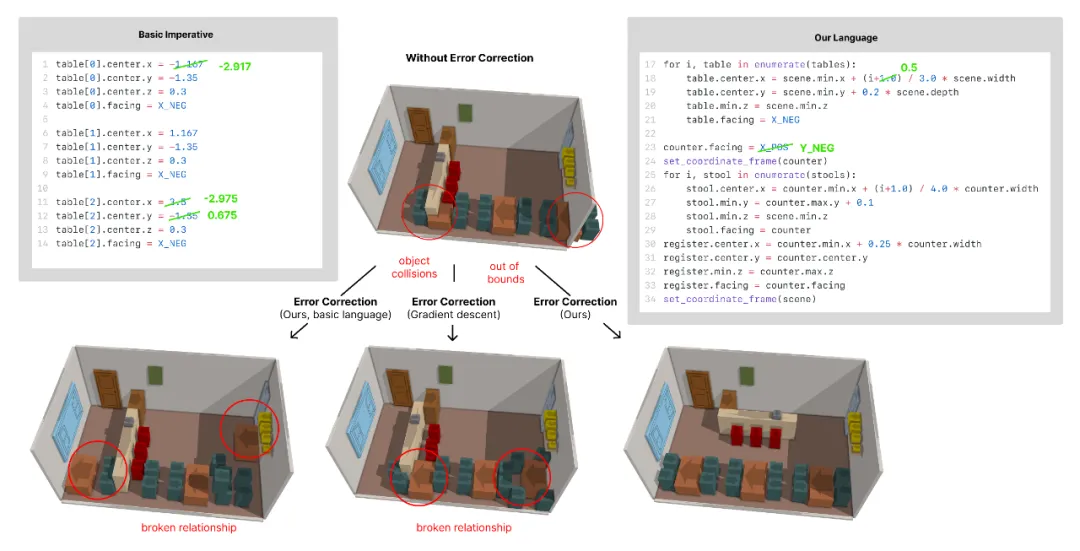

研究团队提出的 Procedural Scene Programs(PSP) 是一个两阶段的程序化场景生成系统。它的核心思想是:让 AI 不再直接输出三维几何,而是先生成可执行的构建脚本,再通过程序执行构建出完整场景。

整个系统由两大关键组件组成:

-

Procedural Scene Description Language(PSDL) ------ 用来 "写" 出生成世界的程序语言;

-

Program Search 纠错模块 ------ 在程序执行后自动检测并修复几何错误。

PSDL 负责 "生成逻辑",Program Search 负责 "结果修正"。这种 "先生成、再调试" 的机制,使得 AI 不仅能自动搭建三维场景,还能在程序层面自我修复错误,从而生成结构合理、物理一致的世界。

- 程序化生成语言 PSDL:让 AI 写出世界的规则

传统的三维场景生成模型通常直接预测每个物体的位置、大小和方向。然而,由于 AI 并不具备完善的空间想象与物理推理能力,这种方法往往会导致物体漂浮、重叠等问题。为此,PSP 引入了 Procedural Scene Description Language(PSDL),让模型不再 "直接想象空间",而是以程序逻辑来表达空间关系。PSDL 嵌入在 Python 中,支持函数、循环、条件与变量绑定,使模型能够通过编写规则的方式来定义场景的结构与布局。

例如:

for i in range (3):

place ('chair', around='table', angle=i*120)这样的语句不仅表达了 "放三把椅子" 的结果,也清晰地定义了 "围绕桌子等角放置" 的空间关系。这种形式让生成过程具备了可编辑、可扩展、可复用的特性,使模型真正具备了 "程序化建模" 的能力。

- 纠错模块 Program Search:自动修复几何错误

在生成完成后,PSP 会通过 Program Search 模块对场景进行结构与几何一致性检测。与传统需要反复调用大模型修正错误的方式不同,PSP 直接在程序空间中搜索修复方案,无需再次推理。

研究团队定义了多种几何一致性指标,如物体重叠率、支撑关系和遮挡情况。当检测到异常时,系统会自动替换变量或微调表达式,从程序层修复问题。

实验结果显示,PSP 平均只需 约 7 次程序修改 即可修复大多数错误,且完全无需重新调用 LLM。这种符号级修正机制让生成过程更稳定、更具可解释性,并显著提升了三维场景的物理合理性。

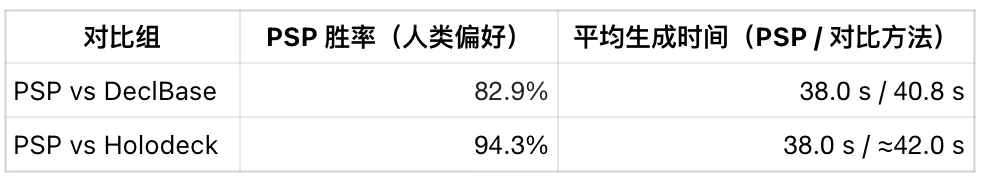

效果与对比

在 70 个开放世界场景提示(涵盖自然、建筑、幻想等多样主题)上,研究团队对比了三种代表性方法:声明式布局系统 DeclBase、约束驱动的 Holodeck,以及本文提出的 Procedural Scene Programs(PSP)。

结果显示,PSP 在人类主观评测中显著领先 ------ 在与 DeclBase 的对比中获得 82.9% 的偏好率,与 Holodeck 的对比中则达到 94.3%。同时,PSP 的生成速度也更快:从文本到完整场景平均仅需约 38 秒,而 DeclBase 与 Holodeck 分别需要 40.8 秒 与 约 42 秒。

除了人类主观评测外,研究团队还提出了一种基于多模态 LLM 的自动化评估方法,用于衡量生成场景在语义一致性与视觉合理性上的表现。在 PSP 与 DeclBase、Holodeck 的对比中,该自动评测方法分别给出 77.1% 与 90.0% 的 PSP 偏好选择率,与人类主观偏好(82.9% 与 94.3%)趋势一致,证明了其在未来三维场景生成质量评测中的可靠性与参考价值。

意义与展望

这项研究揭示了一个重要趋势:未来的 3D 场景生成,可以不再只是从文本到几何的单向映射,而是一个 "程序写世界(Program the World)" 的过程。

通过 Procedural Scene Programs(PSP),AI 的 "想象力" 可以与 "编程逻辑" 深度融合:它既继承了命令式生成的灵活性与层次表达能力,又以符号化修正机制弥补了大模型在空间推理与逻辑一致性上的脆弱。这一范式转变,让模型不只是理解世界的观察者,而成为主动构建世界的开发者。

正如论文作者所言:

"Our approach re-establishes the strengths of imperative scene layout programs while overcoming their fragility to LLM errors."

PSP 通过程序语言与自动纠错机制的结合,为 3D 内容生成带来了前所未有的可控性与自解释性。无论是虚拟城市、游戏关卡,还是zzz智能的视觉环境,这一框架都为 AI 世界的构建提供了新的逻辑与基础。

...

#一句话,就能创造出随便乱逛的3D世界!

【导读】只用一张图,一句话,就能创造出随便乱逛的3D世界------李飞飞这次不是在讲故事,而是真的给你「造梦神器」。今天起,全球上线,人人可用。

李飞飞的「创世神器」今天终于正式上线了!人人可用。

这个由WorldLabs推出,名为Marble的网站,用世界模型可以生成瑰丽梦幻的「想象世界」~

体验网址:https://marble.worldlabs.ai/

这波属实是李飞飞自己联动自己了,前两天她的一篇万字长文火爆硅谷,定义AI的下一个十年是「空间智能」。

文章中,她为真正具备空间智能的「世界模型」所需达成的目标勾勒了一个框架。

而今天这个「世界」正式面向全世界发布。

看一下官方视频的效果。

,时长00:48

我们也实测了一番,效果非常惊艳!这是一个真正的世界体验器。

所有生成内容都像3A大作游戏一样,可以任意的旋转镜头,放大缩小,关键是效果非常逼真。

现在可以上传2D图片、或者3D模型(需充值)来配合提示词生成世界。

比如,用下面这种机器人叠衣服的图片。

然后你就能得到一个真实的3D世界。

当然,瑕疵也是有的,比如机器人的形象看起来还是有些「幻觉」。

但整体瑕不掩瑜,效果整体还是非常棒的,尤其是官方列出的几个例子。

比如未来的太空舱卧室。

或者深秋的校园。

这款世界模型两个月前首次以限量测试版亮相,今天是正式上线,所有人都可以体验。

Marble与其他世界模型产品------甚至与WorldLabs自家的实时模型RTFM------的不同之处在于,它能创建持久化、可下载的3D环境,而非在用户探索时实时生成世界。

目前需要充值才能下载作品。

Marble还是同类模型中首个提供AI原生编辑工具和混合3D编辑器的产品,用户可先构建空间结构框架,再由AI填充视觉细节。

去年十二月,WorldLabs曾展示其早期模型如何通过单张图像生成交互式3D场景。

,时长01:18

World Labs早期宣传视频

虽然效果令人印象深刻,但略带卡通风格的场景无法完全自由探索------移动范围受限在较小区域,且偶尔会出现渲染错误。

但今天实测的效果让我们意识到,可以说AI的下一个十年,已经开启了!

,时长01:16

World Labs最新官方宣传视频

Marble:世界模型

人类对世界的感知本质上是多模态的:我们调动所有感官来理解周遭环境。

通过整合视觉、听觉、触觉与语言,我们构建起对外部世界的心理模型;这些不同表征方式相互协作、彼此增强,使我们能够理解世界并在其中采取行动。

世界模型应当以类似方式运作。它们需要具备大规模多模态能力,能够将各种可用输入信号提升为完整的三维世界,并随着新信息的出现持续迭代更新对世界的认知。

Marble是开创先河的新一代世界模型,正朝着这一愿景大步迈进。

文本与图像世界

首先,Marble能够仅凭一张图片或简短文字提示创建完整的3D世界。这是最简单便捷的造物方式。

Marble可生成涵盖多种场景类型与艺术风格的世界。

图像提示使得将Marble与其他AI工具结合变得轻而易举。可以使用喜爱的图像生成模型创建图像,随后将其导入Marble,即可将其提升为完整的3D世界。

文本和图像提示直观且强大,但在创意控制方面存在局限:Marble必须自行构建输入文本或图像提示中未包含的世界细节。

多图像和视频到世界模型

实现更具创意控制的世界构建,一种简便方法是采用多图像提示技术。

Marble能够接收针对世界不同部分的多样化提示图像,并将它们无缝融合成统一的3D世界。

多图像提示能以更高精度创造世界。

这带来了一种全新的世界生成工作流程。可以使用喜爱的图像生成工具分别迭代输入视角,而Marble会将其提升为完整的三维世界,同时为输入视角之间添加无缝过渡效果。

Marble可以输入几张照片或一段从不同角度描绘现实世界位置的短视频,它会将这些素材组合起来,生成包含现实空间元素的3D世界。

世界编辑

对许多用户而言,创作过程具有高度迭代性。生成世界往往只是创意旅程的起点。当看到生成的 3D 世界时,通常会激发更多修改或完善它的灵感。

Marble内置了AI原生世界编辑工具。编辑可以细微而局部:移除物体、修饰区域;也可以更加彻底:替换

物体、改变视觉风格,或重构世界的大部分结构。这为世界创建过程带来了全新层次的精细控制。

Chisel:在三维世界中雕琢天地

Chisel和世界编辑还不太一样,有点像一根魔法棒。

Marble的多模态输入与编辑功能赋予对生成世界的强大掌控力。

但有时,要将脑海中的构想精确呈现,仍需对场景布局或物体的精确尺寸位置进行更精细的调控。

针对这些场景,推出Chisel------一款原生AI工具,可直接在三维空间中雕琢Marble世界。

将世界导出为3D或者视频格式

使用Marble创建世界后,有多种导出选项以便将其整合到下游项目中。

高斯溅射点是Marble世界最高保真度的呈现方式。它将3D场景表示为大量半透明粒子集合。

可以通过与THREE.js集成的开源跨平台渲染器Spark,在浏览器中实时渲染高斯溅射点。

Marble世界亦可导出为三角网格模型。

系统能够同时生成用于粗略物理模拟的低精度碰撞体网格,以及尽可能匹配高斯溅射点视觉精度的高质量网格。

通过网格格式导出世界,可使其与众多行业标准工具实现无缝协作。

Marble世界以完整3D形式存在,但有时视频才是分享世界的最佳方式。

可以使用Marble将生成的世界渲染成视频,通过像素级精准的相机控制,让每个镜头都如您想象般完美构图。

Marble是一款先进的生成式世界模型。

但只是我们迈向空间智能征途中的一步。

未来,交互性将成为一个关键机遇。

未来的世界模型将让人类与智能体都能以全新方式与生成世界互动,从而在仿真、机器人技术及其他领域解锁更多应用场景。

空间智能是AI的下一个前沿

李飞飞在她的万字长文中结尾写下的感慨是对这波AI浪潮、智能、人类和机器命运最好的总结:

过去十年见证了AI成为一种全球现象,以及技术、经济乃至地缘政治的转折点。

但作为一名研究者、教育者,如今又是一名创业者,最能激励我的,仍然是图灵75年前提出的那个问题背后的精神。

我依然怀有他那份好奇与惊叹。

正是这种感觉,每天都激励着我迎接空间智能的挑战。

历史上第一次,我们有望构建出与物理世界如此协调的机器,以至于在我们面临的最严峻挑战中,可以将它们视为真正的伙伴。

无论是加速我们对实验室中疾病的理解,彻底改变我们讲述故事的方式,还是在我们因疾病、受伤或年老而最脆弱的时刻给予支持,我们都正处在一项新技术的风口浪尖,这项技术将提升我们最珍视的生活的方方面面。

这是一个更深刻、更丰富、更强大的生活愿景。

在大自然与远古动物身上释放出第一缕空间智能的近五亿年后,我们有幸成为可能很快就能赋予机器同样能力的这一代技术专家中的一员------并有幸利用这些能力为世界各地的人们谋福祉。

我们关于真正智能机器的梦想,没有空间智能是不完整的。

这项探索,就是指引我的北极星。

我邀请你与我同行。

One More Thing

Marble定价方面,目前共有3个档位,最高一个月95美元,可以最多生成75个世界。

免费版本只能上传图片,可以生成4个世界。

现在Pro版本,首月只需1美元!标准版本依然还是业界最普遍的一个月20美元。

你认为这个价格合理吗?

参考资料:

https://www.worldlabs.ai/blog/marble-world-model

...