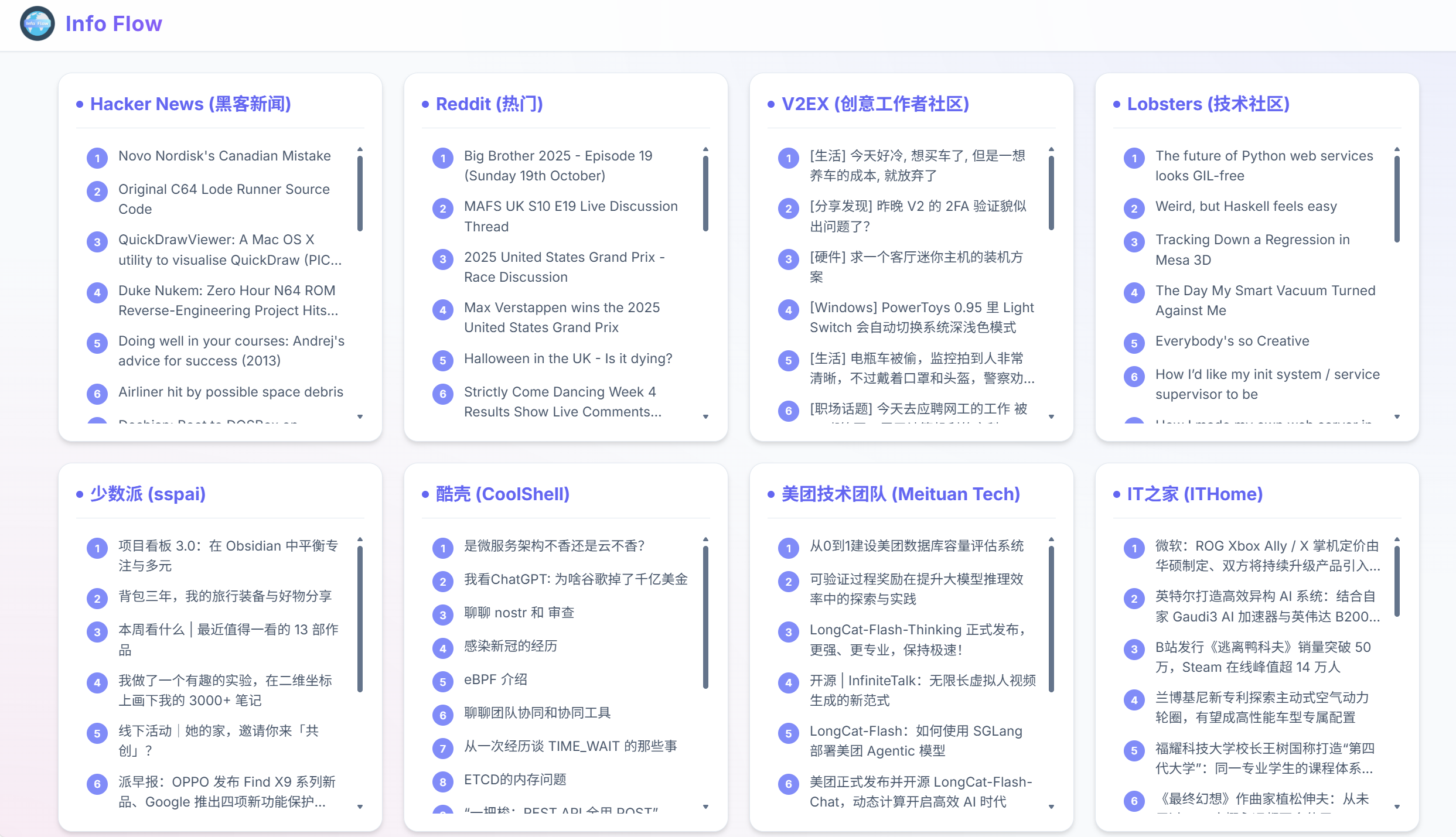

技术实践观察地址: Info Flow 信息聚合仪表板

摘要: 高质量的信息聚合系统必须解决数据的分布式采集、海量数据的实时去重 以及信源的差异化内容分级 三大核心挑战。本文将探讨如何通过构建一个支持多协议(RSS/API)的分布式采集网络,应用高效的文本指纹算法进行数据去重,并设计一套基于社区共识和算法的混合分级机制,从而实现对全球技术信息流的结构化、高信噪比管理。

一、信息聚合的工程挑战:数据清洗与信源的异构性

构建一个跨越 Hacker News、V2EX、酷壳等高质量社区的信息流,本质上是一个分布式数据采集与清洗的工程项目。核心挑战在于:

- 数据采集的异构性: 不同的信息源采用不同的数据交换协议(RSS、JSON API、或需要爬取的HTML)。后端需要一个多协议适配器来统一采集。

- 内容冗余与去重难题: 很多新闻和技术文章会被多个社区转载或引用,导致信息流中存在大量的冗余数据。实现高效、精确的跨信源去重是保证信噪比的关键。

- 内容分级的非标化: 各社区的评分/热度算法不同,如何将它们统一到一个可比较的"热度"尺度上,是内容分级的核心难题。

二、技术深潜:去重、分级与结构化采集

高效的信息聚合系统,其后端需要一套复杂的流水线来处理上述挑战。

-

分布式采集与多协议适配:

系统需部署一个支持并发和故障转移的分布式爬虫/采集器网络。该网络的关键技术是多协议适配:

- RSS解析器: 负责处理传统的 RSS/Atom Feed。

- API/JSON适配器: 负责调用如 Reddit、V2EX 等社区的开放 API。

- HTML爬虫与解析: 针对如美团技术团队博客等没有标准API的信源,使用无头浏览器(如 Puppeteer)进行渲染和 DOM 解析。

-

内容去重的指纹算法(Text Fingerprinting):

去重是提升信噪比的关键步骤。系统采用高效的文本指纹算法:

- SimHash或MinHash: 提取文章标题和摘要的核心特征,生成一个低维度的哈希值(Fingerprint)。

- 相似度比较: 通过比较不同文章指纹之间的汉明距离(Hamming Distance)或雅卡尔相似度(Jaccard Similarity),判断内容是否高度相似。相似度超过阈值的冗余内容将被过滤,确保信息流的简洁。

-

混合内容分级与统一热度模型:

为了在Dashboard上并列展示不同社区的热度,系统需要构建一个混合分级模型:

- 标准化: 将各个社区的评分/点赞/Upvote数据**归一化(Normalization)**到统一的0-100的热度尺度上。

- 共识权重: 对于被多个高质量社区(如Hacker News和Lobsters)同时引用的内容,应给予额外的**"共识权重"**,提升其在总信息流中的优先级。

三、前端架构:无干扰渲染与认知效率的提升

前端Dashboard的设计目标是最大化信息密度 和消除认知摩擦。

- 极简的卡片式架构:

Dashboard采用固定数量的并列式卡片(Card Layout) ,每个卡片对应一个信源。这种设计强制用户进行水平扫描,打破了传统的垂直阅读习惯,引导用户跨领域获取信息。 - 纯文本与去噪:

前端渲染仅显示标题、链接和热度分数 。所有图片、广告、冗余链接都被移除。这种高密度纯文本视图极大地提升了信息获取的效率。

一个名为 Info Flow 的Web应用,将上述数据采集、去重和分级技术集成在一个简洁的界面中。它通过并列展示多个技术社区的实时热点,体现了对跨领域信息流的高效管理。

四、总结与展望

构建一个高质量的信息聚合系统,是对分布式采集、数据清洗和内容分级算法的综合考验。通过引入高效的去重指纹算法和混合分级模型,我们可以有效地管理高信息熵的数据流,并消除算法推荐带来的信息茧房。这类工具的实现,展示了数据工程在提升个人信息获取效率方面的巨大潜力。