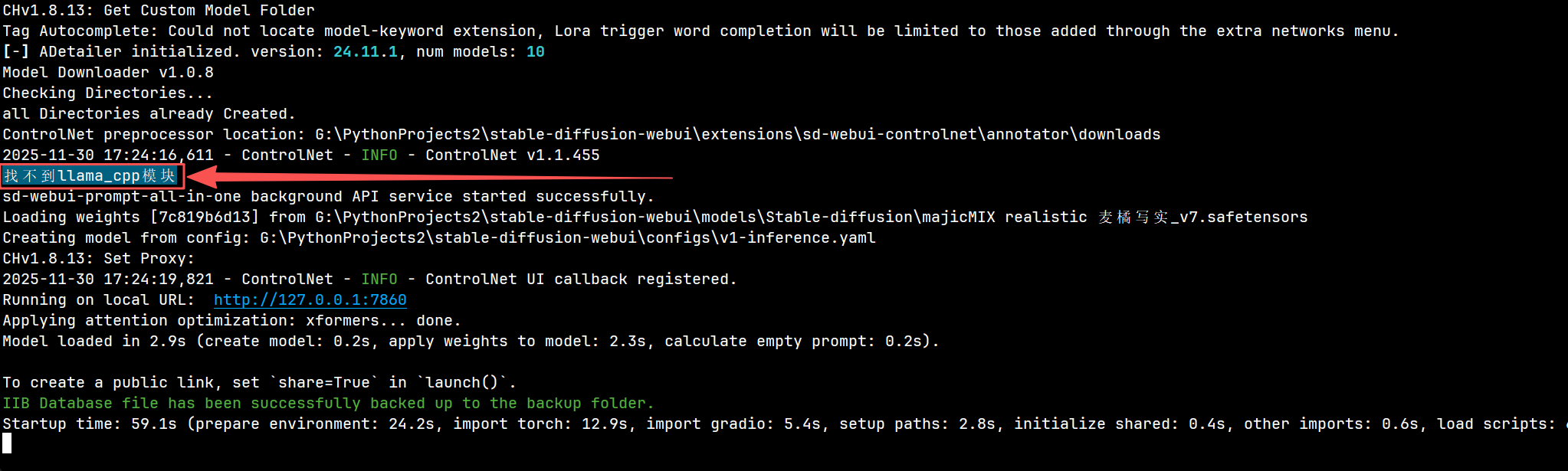

【笔记】解决 Stable Diffusion WebUI 启动 "找不到llama_cpp模块"

找不到llama_cpp模块

"找不到 llama_cpp 模块" 并不是 SD-WebUI 本身缺失,而是我们在用 GGUF 模型或装了需要它的扩展(如 llama_cpp_python 推理插件),但 Python 环境里 没装 llama-cpp-python 或其编译失败 导致的运行时 ImportError。

按 Windows 常见踩坑顺序,下面给出"先快速后根治"的两套方案。

一、1 分钟先救急(直接用现成 wheel)

- 激活 webui 用的同一解释器(你已经是

.venv环境,确认命令行前面有(.venv)即可)。 - 针对 CPU 版(无显卡也能跑)执行:

cmd

pip uninstall -y llama-cpp-python llama_cpp_python_cuda

pip install --upgrade pip

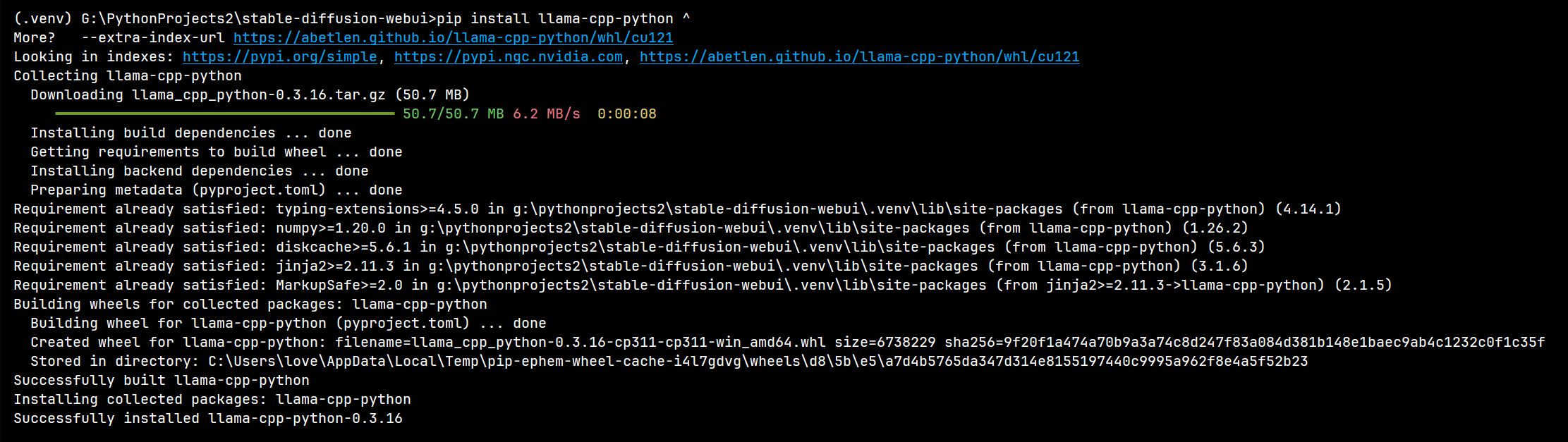

pip install llama-cpp-python ^

--extra-index-url https://abetlen.github.io/llama-cpp-python/whl/cpu如果 CUDA 12 想跑 GPU:

cmd

pip install llama-cpp-python ^

--extra-index-url https://abetlen.github.io/llama-cpp-python/whl/cu121

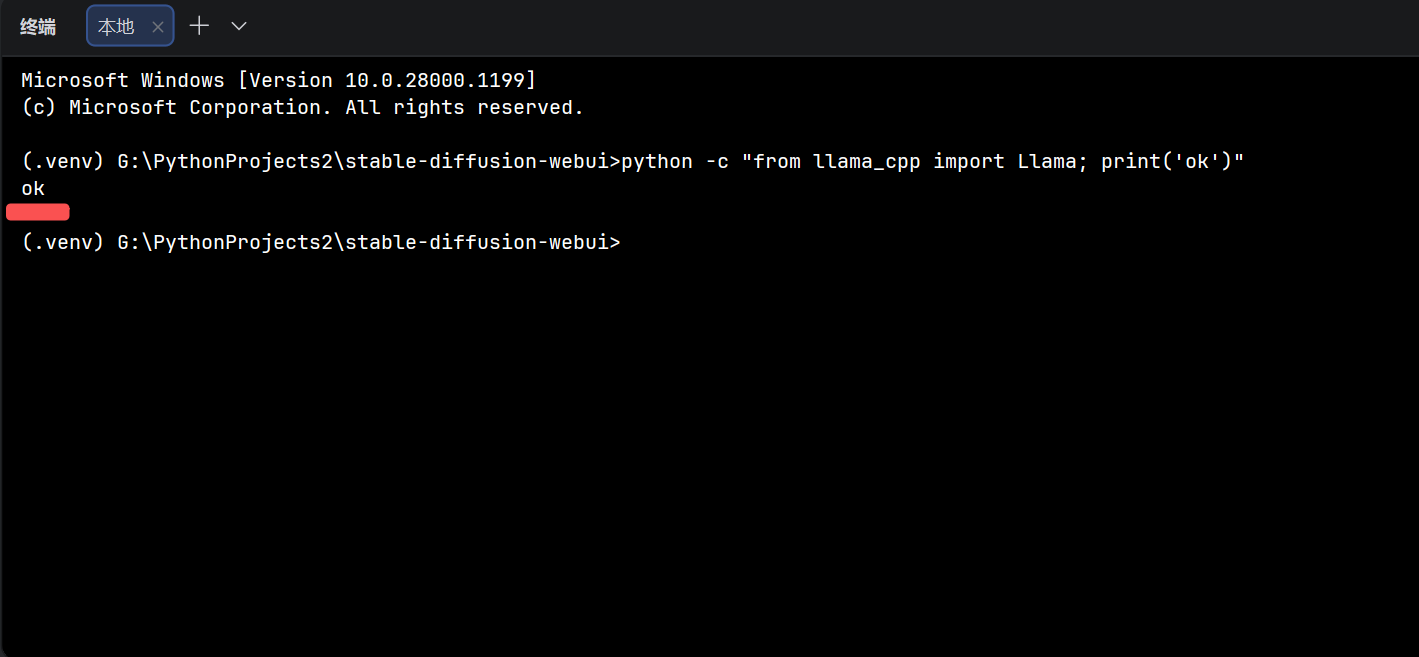

装完验证:

python

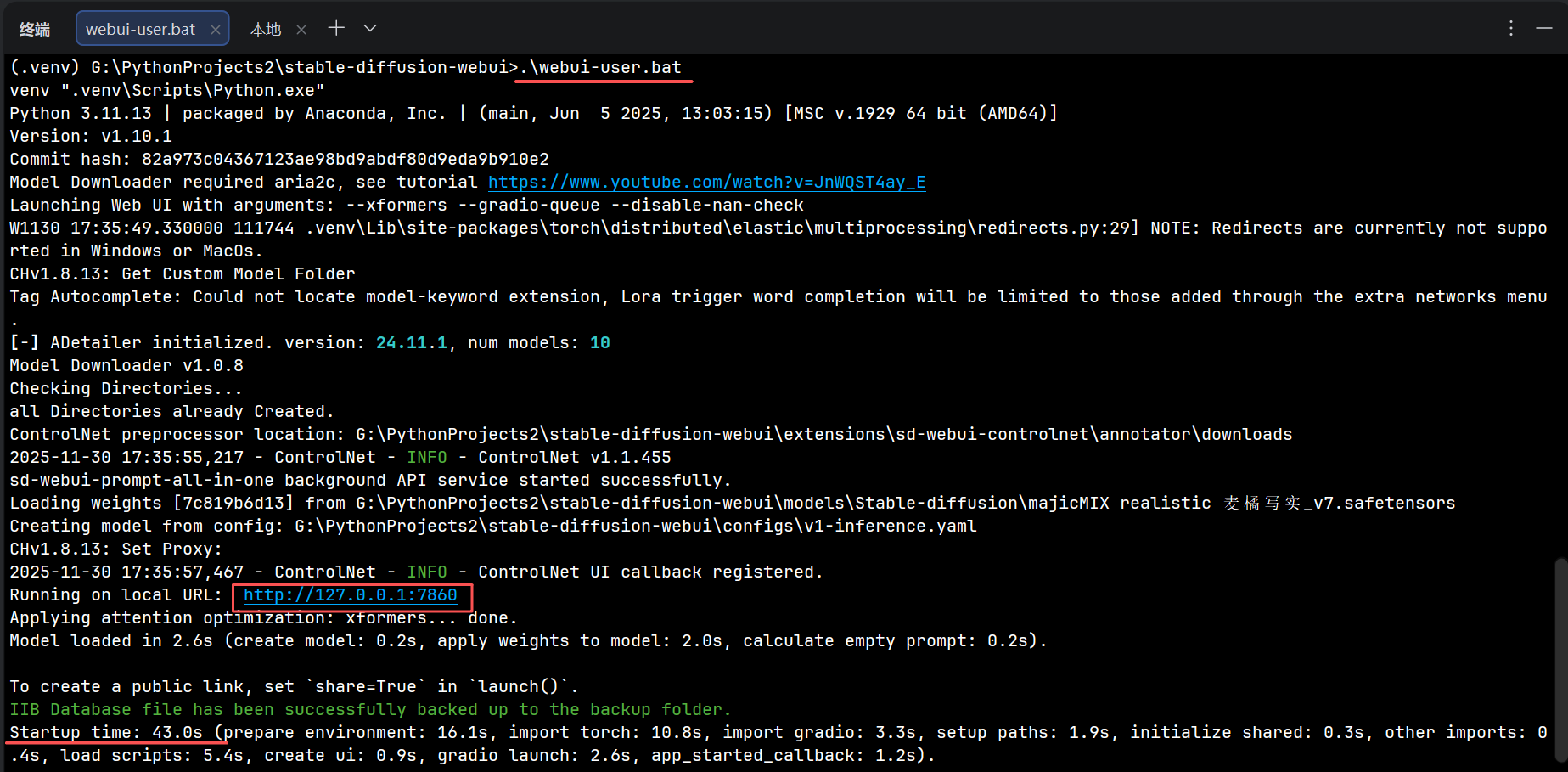

python -c "from llama_cpp import Llama; print('ok')"能打印 ok 说明模块已识别,可重新运行 webui-user.bat。

二、彻底编译安装(wheel 不可用或你想自己编)

-

装 VS2022 生成工具

打开 [Visual Studio Installer] → 勾选

- "使用 C++ 的桌面开发"

- "Windows 10/11 SDK"

- "CMake 工具"(可选)

安装后重启命令行让环境变量生效。

-

激活 venv,重新编译安装:

cmd

set CMAKE_GENERATOR=Visual Studio 17 2022

set CMAKE_ARGS=-DLLAMA_BLAS=ON -DLLAMA_OPENBLAS=OFF -DLLAMA_CUBLAS=ON

pip install --upgrade pip setuptools wheel

pip install llama-cpp-python --no-cache-dir --force-reinstall纯 CPU 把 -DLLAMA_CUBLAS=ON 去掉即可。

成功后同样 python -c "from llama_cpp import Llama; print('ok')" 验证。

三、常见还踩的坑

- Git 没进 PATH → 编译脚本会找

git.exe写版本号,找不到就崩;把D:\Program Files\Git\cmd加进系统 PATH 并重启 CMD/PyCharm。 - 已有旧版冲突 → 先

pip uninstall llama-cpp-python llama_cpp_python_cuda再装。 - 运行时报找不到 llama.dll → 装的是 GPU 版却给 CPU 模型,或 CUDA 与 wheel 版本不一致;对照上述

--extra-index-url选对应版本即可。

一句话总结

救急就用官方预编译 wheel(CPU/GPU 两条命令);想彻底或版本最新,就装 VS 生成工具后 pip install llama-cpp-python --no-cache-dir 本地编译。装完确认 from llama_cpp import Llama 不报错,再回 SD-WebUI 启动就不会再提示"找不到 llama_cpp 模块"。

https://zhuanlan.zhihu.com/p/1896696606679626606

https://blog.csdn.net/xrinosvip/article/details/146769607

https://blog.gitcode.com/e8ee833ff177992be800e1b49dc03ab2.html

https://dev.to/jirenmaa/failed-to-load-shared-library-llamadll-could-not-find-llama-cpp-python-5e4l