在短短一年里,AI 视频生成已经从「炫技几秒」进化到「真的能讲故事」。而真正能撑起国内开源长视频创作的一员猛将,也终于登场了------来自美团的 LongCat-Video。

它的能力很好概括:

一句话?给你拍成一段剧情;

一张图?它能让画面自己动起来;

视频断在一半?它立刻替你续拍下去。

LongCat-Video 基于 136 亿参数的视频生成大模型,同时支持文字转视频、图片转视频和视频续写,让创意能够持续往前推进。它不是只会做几秒炫酷短片,而是从训练阶段就融入了长时序逻辑,让光影不飘、角色不丢、剧情不突兀,几分钟的视频也能顺畅连贯。

效率方面也非常能打:720p、30fps 的长视频几分钟即可生成,再配合强化学习不断提升文本对齐、画质与动作一致性,让开源模型也能拥有行业级竞争力。

教程链接:https://go.openbayes.com/rqq43

使用云平台: OpenBayes

http://openbayes.com/console/signup?r=sony_0m6v

首先点击「公共教程」,找到「LongCat-Video:美团开源的AI视频生成模型」,单击打开。

页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

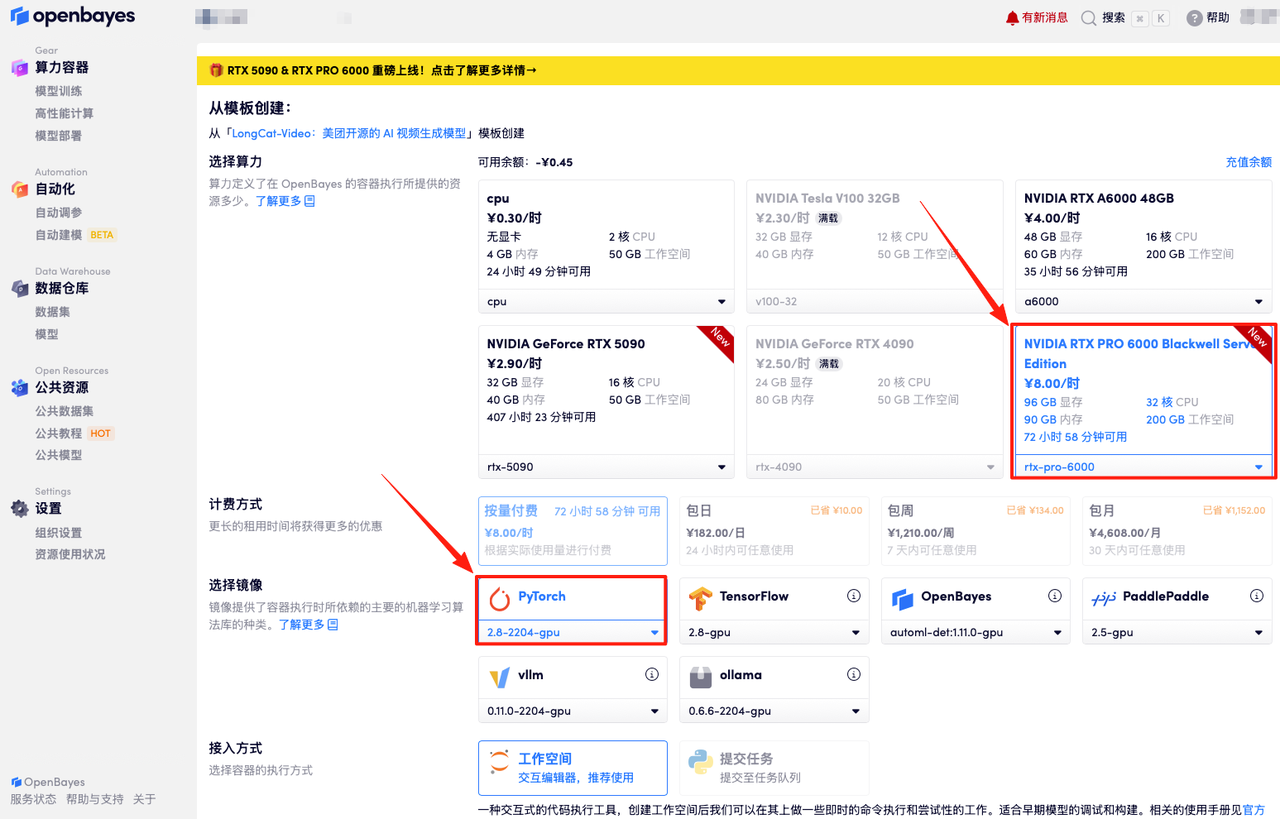

在当前页面中看到的算力资源均可以在平台一键选择使用。平台会默认选配好原教程所使用的算力资源、镜像版本,不需要再进行手动选择。点击「继续执行」,等待分配资源。

数据和代码都已经同步完成了。容器状态显示为「运行中」后,点击「 API 地址」,即可进入模型界面。

若显示「Bad Gateway」,这表示代码正在后台执行,请等待约 5-6 分钟后刷新页面。

以下分别是 4 种视频生成方式的使用步骤和效果展示:

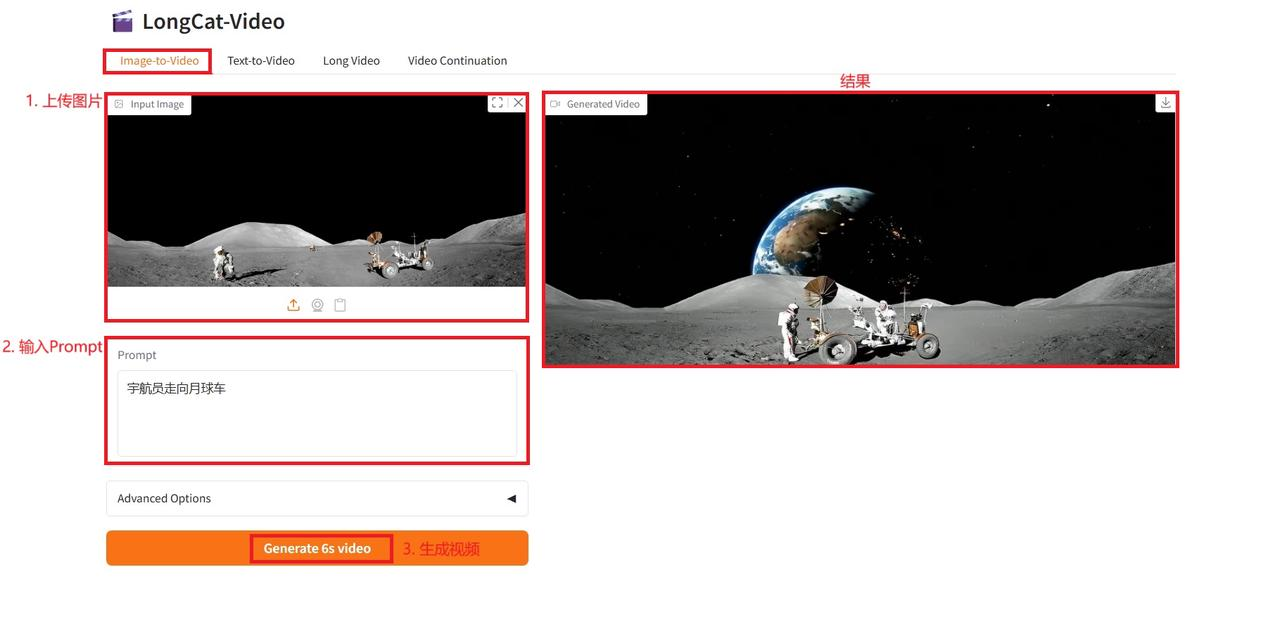

1.图像到视频(Image-to-Video)

使用步骤:

参数说明:

- Negative Prompt:通过输入不希望出现的元素,引导模型避开这些特征,从而提升生成质量。

- Resolution:指定生成图像的宽 × 高像素尺寸。

- Seed:控制生成过程的随机性起点。固定 Seed 值可实现结果可复现。

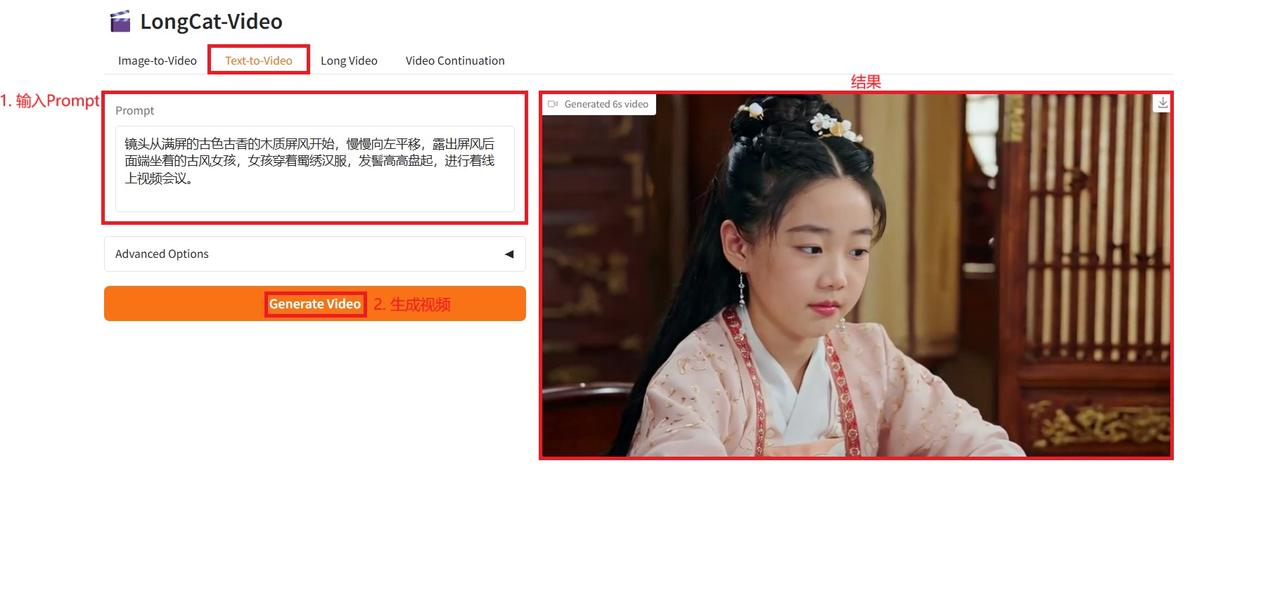

2.文本到视频(Text-to-Video)

使用步骤:

参数说明:

- Negative Prompt:通过输入不希望出现的元素,引导模型避开这些特征,从而提升生成质量。

- Height:指定生成图像的高。

- Width:指定生成图像的宽。

- Seed:控制生成过程的随机性起点。固定 Seed 值可实现结果可复现。

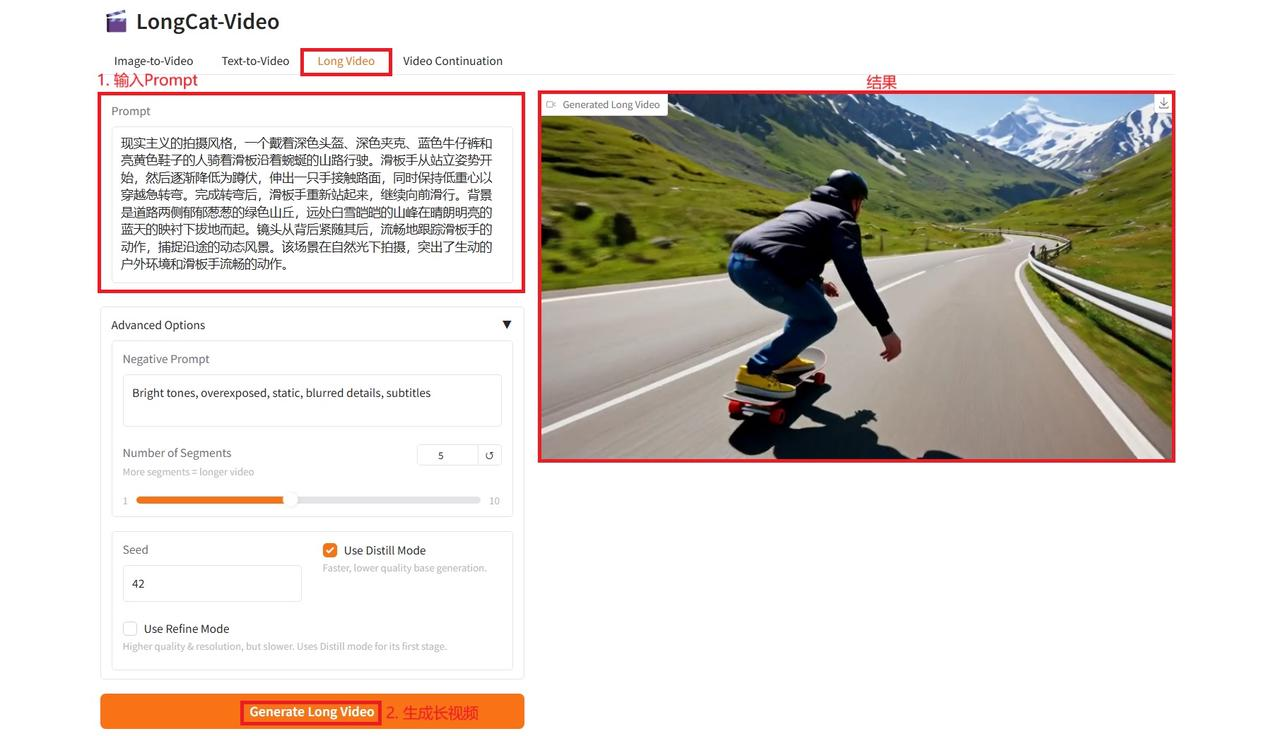

3.长视频生成(Long-Video Generation)

使用步骤:

参数说明:

- Negative Prompt:通过输入不希望出现的元素,引导模型避开这些特征,从而提升生成质量。

- Number of Segments:段落数量,数量越大,视频越长。

- Seed:控制生成过程的随机性起点。固定 Seed 值可实现结果可复现。

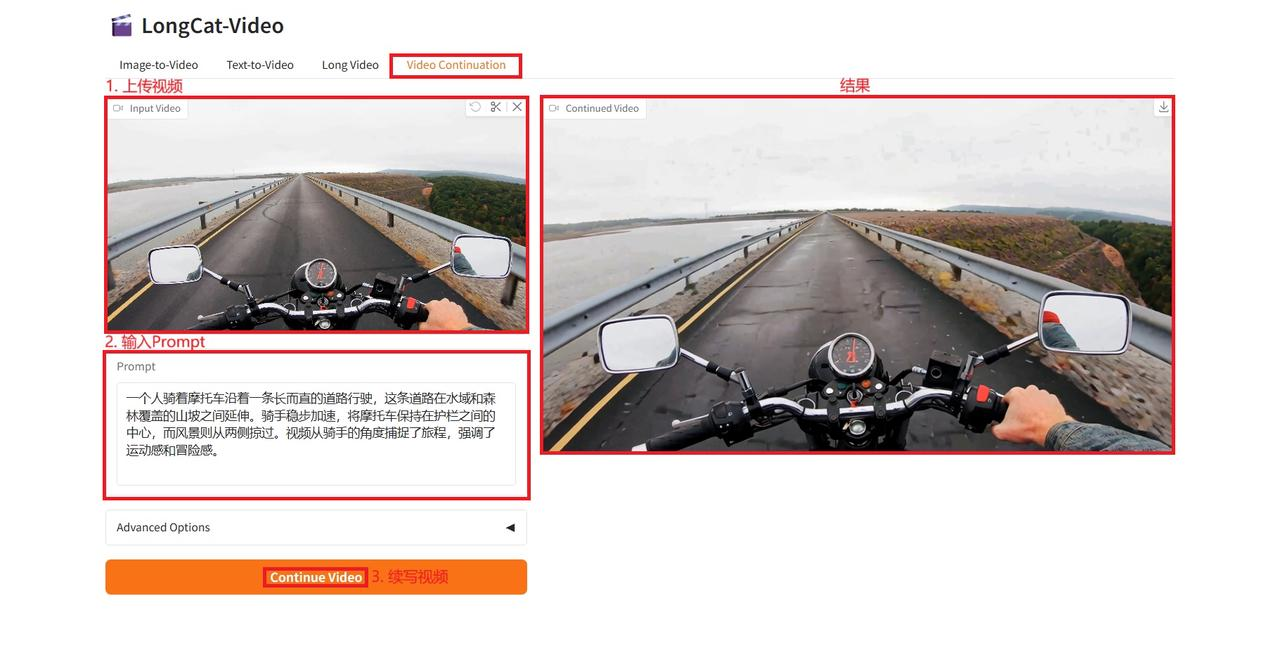

4.视频续写(Video-Continuation)

使用步骤:

参数说明:

- Negative Prompt:通过输入不希望出现的元素,引导模型避开这些特征,从而提升生成质量。

- Resolution:指定生成图像的宽 × 高像素尺寸。

- Seed:控制生成过程的随机性起点。固定 Seed 值可实现结果可复现。