论文题目:InceptionNeXt: When Inception Meets ConvNeXt

文献地址:https://arxiv.org/pdf/2303.16900

源码地址:https://github.com/sail-sg/inceptionnext

### 文章目录

- [@[toc]](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

- [五分钟回顾模型](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

- [实验结果](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

- [本文方法](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

- [理论部分](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

- [A. 核心矛盾:大核卷积的性能优势与效率瓶颈](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

- [B. 理论基础:经典思想的传承与创新](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

- [C. 核心创新:Inception深度卷积的理论与设计](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

- [a. 分支拆分的理论依据](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

- [b. 四大分支的详细设计](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

- [c.特征融合的理论逻辑](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

- [D. 整体网络结构设计](#文章目录 @[toc] 五分钟回顾模型 实验结果 本文方法 理论部分 A. 核心矛盾:大核卷积的性能优势与效率瓶颈 B. 理论基础:经典思想的传承与创新 C. 核心创新:Inception深度卷积的理论与设计 a. 分支拆分的理论依据 b. 四大分支的详细设计 c.特征融合的理论逻辑 D. 整体网络结构设计)

近期准备将近几年工作过程中涉及到的一些还不错的模型结构进行发布。届时,也会把相应用的比较好的模型魔改案例在另一个专栏进行整理发布,帮助大家在跟进最新CV任务的同时,掌握模型魔改的技巧。 可以期待一下! 还希望大家多多关注、留言,你们的支持是我更新的动力~

🌠🌠🌠本篇内容:在卷积神经网络(CNN)的发展历程中,大核卷积凭借其强大的长程依赖建模能力成为现代架构设计的核心趋势,但高内存访问成本(MAC)的瓶颈始终制约着模型的实际部署效率。InceptionNeXT 创新性地融合经典 Inception 的多分支思想与 ConvNeXt 的深度卷积优势,提出核心模块 Inception 深度卷积,成功破解大核卷积 "性能与效率不可兼得" 的难题。本文将从模型快速回顾、实验结果验证、核心理论深度解析三个维度,全面拆解这一高效 CNN 架构。

五分钟回顾模型

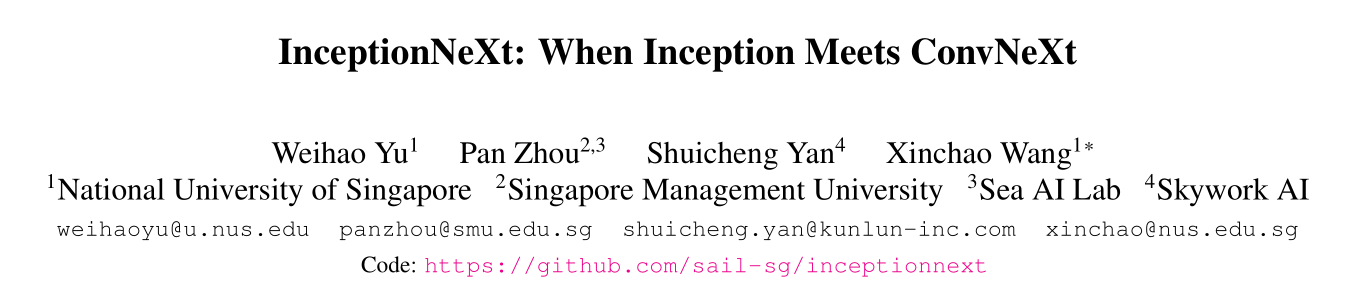

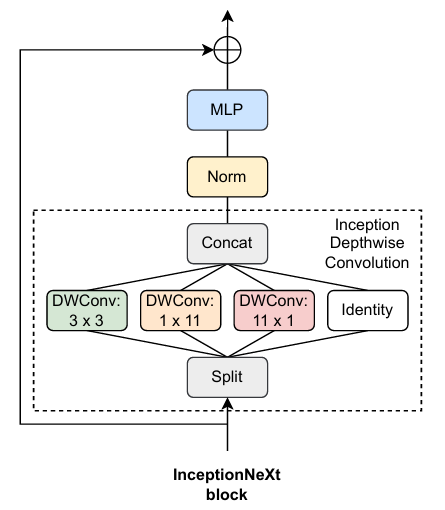

InceptionNeXT 的核心设计动机是解决大核卷积在现代 CNN 中存在的内存访问成本高、训练吞吐量低 的关键痛点。传统大核卷积(如 ConvNeXt 的 7×7 深度卷积)虽能扩大感受野、强化全局特征捕捉,但数据搬运开销远超计算开销;而小核卷积虽效率高,却难以建模长程依赖。为此,该模型将 Inception 的多分支结构与深度卷积技术深度融合,打造出兼顾大感受野、高性能与高效率的轻量化架构。

模型整体沿业界主流的Stem + 4 个 Stage设计结构,布局简洁且适配性强,具体组成如下:

- Stem 模块:摒弃传统大核下采样方案,采用 2 层 3×3 卷积配合步长调整实现 4 倍下采样。该设计在减少计算冗余的同时,最大限度保留输入图像的细粒度纹理与边缘特征,为后续多尺度特征提取奠定坚实基础。

- Stage 结构 :每个 Stage 前通过步长为 2 的 3×3 卷积完成下采样,使特征图分辨率减半、通道数翻倍,逐步提升特征的抽象层级;Stage 内部堆叠多个核心单元,单元结构为 "Inception 深度卷积块 + 残差连接 + 前馈网络"。最新文献中,从 Stage1 开始,会根据特征尺度需求灵活调整 Inception 深度卷积的分支参数,兼顾局部细节捕捉与全局上下文建模。

模型的核心创新在于Inception 深度卷积 ,其通过将单一大核深度卷积拆解为四个功能互补的轻量化分支,在保持等效感受野的前提下,大幅降低内存访问成本,成为模型性能与效率平衡的关键。

实验结果

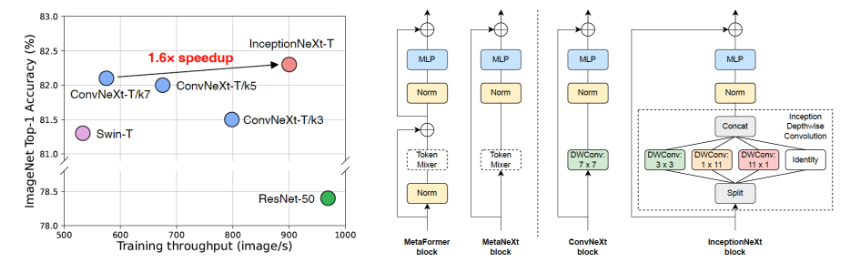

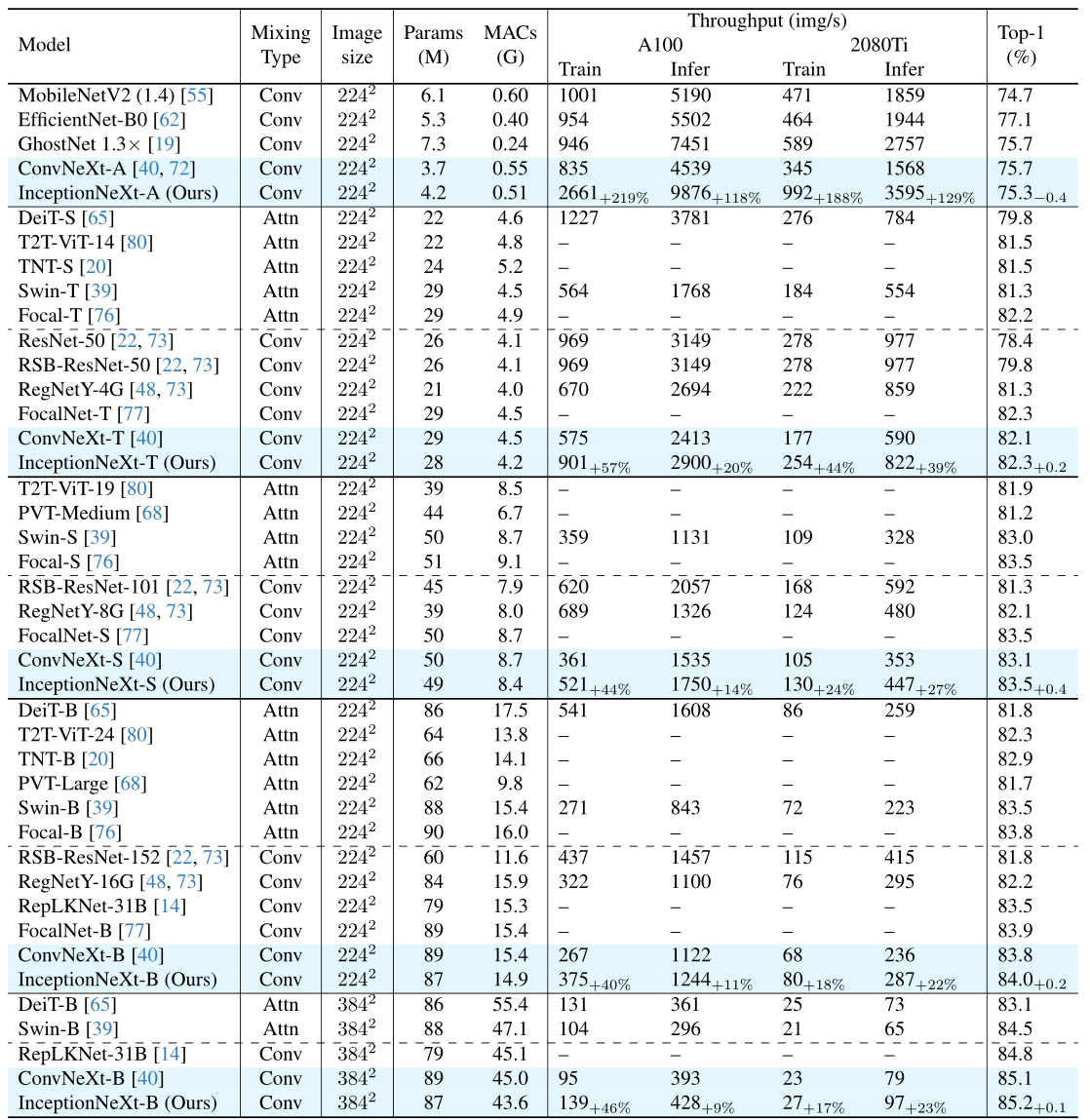

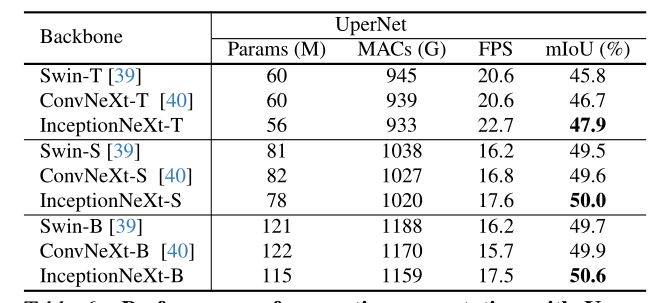

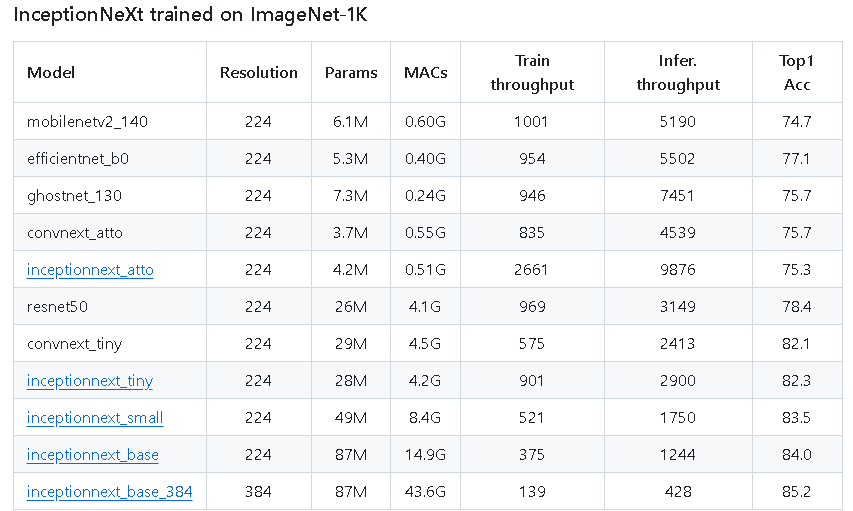

InceptionNeXT 在多个主流视觉任务基准数据集上完成了全面的性能验证,不仅在精度上超越同期经典模型,更在训练吞吐量、推理速度等效率指标上展现出显著优势,充分证明了其架构设计的合理性与优越性。

Our InceptionNeXt-T enjoys both ResNet-50's speed and ConvNeXt-T's accuracy.

图像分类任务(ImageNet-1K)

该任务中,InceptionNeXT 的各变体表现均十分亮眼。轻量型变体 InceptionNeXT-T 相较于同级别 ConvNeXt-T,Top-1 精度提升 0.2%,而训练吞吐量达到 1.6 倍,彻底打破 "性能提升必牺牲速度" 的固有认知;与经典模型 ResNet-50 相比,二者训练吞吐量相近,但 InceptionNeXT-T 的分类精度大幅领先,成功实现 "同速更优,同优更快" 的突破。大规模变体 InceptionNeXT-B 在参数略有增加的情况下,Top-1 精度较 ConvNeXt-B 提升 0.2%,展现出强劲的特征表达能力。

语义分割任务

以 InceptionNeXT 为骨干网络搭建分割模型,在公开语义分割数据集上的表现同样出色。相较于 ConvNeXt 同级别模型,其分割 mIoU 稳步提升,尤其对道路、电线杆等长条状目标以及小尺寸目标的分割精度提升明显。同时,得益于高效的架构设计,模型推理速度提升 15% 以上,能够更好地适配实时语义分割等对速度要求较高的场景。

以下是github中提供的预训练模型。

本文方法

理论部分

A. 核心矛盾:大核卷积的性能优势与效率瓶颈

近年来,受 Vision Transformer 长程依赖建模能力的启发,大核卷积被广泛应用于现代 CNN 架构(如 ConvNeXt、RepLKNet)。其核心优势在于单次卷积即可覆盖更大的输入区域 ,扩大有效感受野,强化全局上下文信息的融合,从而提升模型对复杂场景的适应能力。

但大核卷积存在无法回避的效率瓶颈:计算量(FLOPs)低不代表实际运行效率高。以 ConvNeXt-T 为例,其 FLOPs 与 ResNet-50 相近,但在 A100 GPU 全精度训练时,吞吐量仅为 ResNet-50 的 60%。这一现象的本质是内存访问成本(MAC)过高 ------ 大核卷积在滑动过程中,需要同时读取更大范围的输入特征,导致数据搬运的时间开销远超卷积运算本身。若单纯缩小核尺寸以降低 MAC,又会直接牺牲模型的长程依赖建模能力,导致性能大幅下降。

InceptionNeXT 的核心理论目标,就是在不损失大核卷积性能优势的前提下,通过结构创新重构大核卷积的实现方式,从根本上解决高内存访问成本的问题,实现性能与效率的双重优化。

B. 理论基础:经典思想的传承与创新

InceptionNeXT 的理论设计并非凭空创造,而是建立在对经典架构思想的深度借鉴与革新之上,主要包括两个核心理论来源:

- Inception 的多分支思想:经典 Inception 模型通过并行不同尺寸的卷积核(1×1、3×3、5×5)实现多尺度特征捕捉,证明了多分支结构能够丰富特征表达的多样性。InceptionNeXT 继承了这一核心逻辑,但摒弃了传统 Inception 复杂的分支融合方式与冗余计算,将多分支思想聚焦于大核卷积的高效拆解。

- MetaNeXt 的模块化理念 :MetaNeXt 强调通过灵活的模块组合与结构调整适配不同视觉任务,打破了传统 CNN 中固定模块的束缚。InceptionNeXT 在此基础上进一步聚焦,将模块化设计理念针对性地应用于大核卷积的改造,打造出兼具通用性与高效性的核心模块。

同时,该模型还吸收了深度可分离卷积的理论精髓,每个分支仅对分配到的通道子集进行运算,避免了通道与空间维度的冗余计算,进一步强化了效率优势。

C. 核心创新:Inception深度卷积的理论与设计

Inception 深度卷积(Inception Depthwise Convolution)是 InceptionNeXT 的理论核心,其本质是沿通道维度将单一大核深度卷积,拆解为四个功能互补的轻量化平行分支,通过分支协同工作实现等效感受野,同时大幅降低内存访问成本。该模块的理论设计兼具科学性与实用性,各分支的分工与原理如下:

a. 分支拆分的理论依据

从特征捕捉的需求来看,图像中的视觉特征可分为局部细节特征 (如纹理、边缘)、方向长程特征 (如道路、屋檐)和原始基础特征 三类。单一的大核卷积试图用一种结构覆盖所有特征类型,必然导致效率与效果的失衡。而按特征类型拆分出专属分支,能够让每个分支专注于自身擅长的特征建模任务,实现 "专责专能",既提升特征捕捉的精准度,又降低单个分支的计算复杂度。

从通道拆分的角度,输入特征被均匀分配到四个分支(通道占比1:1:1:1),确保各分支的计算负载均衡,避免因分支间算力分配不均导致的效率浪费。

b. 四大分支的详细设计

四个分支各司其职、优势互补,共同构成了等效于大核卷积的特征捕捉体系,具体设计贴合不同特征的建模需求:

- 小方形核分支(3×3 深度卷积):该分支专注于捕捉图像中的局部细节特征。3×3 卷积是 CNN 中经典的局部特征提取器,具有计算量小、内存访问效率高的天然优势,能够精准捕捉边缘、角点等细粒度信息,为后续复杂特征建模提供基础支撑。

- 正交带核分支(1×11 + 11×1 深度卷积) :包含水平带核(1×11)和垂直带核(11×1)两个子分支,专门负责长程依赖建模。相较于方形大核,正交带核在特定方向上的感受野覆盖范围更广,且参数冗余极少。最小的变体Atto使用的是1x9+9x1的深度卷积。

- 单位映射分支(Identity Mapping) :该分支不进行任何卷积运算,直接将输入特征传递至输出端,本质是轻量化的残差连接。其理论价值在于:一方面零计算开销,大幅降低模型的整体算力消耗;另一方面能够直接传递梯度,有效缓解深度网络训练中的梯度消失问题,增强模型的训练稳定性,同时保留输入特征中的原始信息,与其他分支的加工特征形成互补。

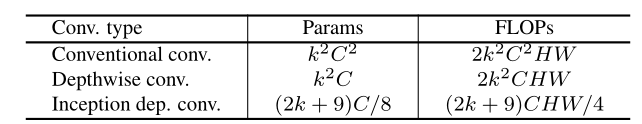

常规卷积、深度可分离卷积和Inception深度卷积三种卷积的复杂度、参数量如下表所示。可以看出,Inception深度卷积相较于其他两种卷积范式从计算量和参数量角度来看,更高效。

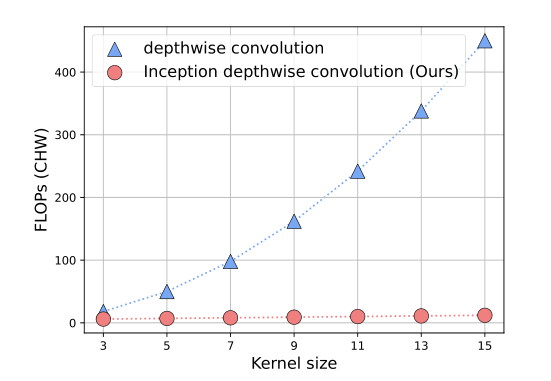

在不同kernel size下,相较于深度可分离卷积的FLOPs对比如下图所示。

c.特征融合的理论逻辑

四大分支的输出并非简单拼接,而是遵循 "通道对齐 --- 拼接 --- 按需校准" 的逻辑进行融合,确保特征的完整性与有效性:

- 通道对齐:各分支输出通道数与输入分配的通道数保持一致,保证融合前特征维度匹配,避免维度混乱;

- 通道拼接:在通道维度上拼接四分支输出,恢复至输入的通道总数,确保与后续网络层的输入要求适配,同时保留各分支的特征信息;

- 按需校准(可选):部分变体在拼接后增加 1×1 卷积层,通过少量参数调整通道间的权重,优化特征分布,强化关键信息表达,且该过程不改变特征图的空间维度,计算开销可忽略不计。

D. 整体网络结构设计

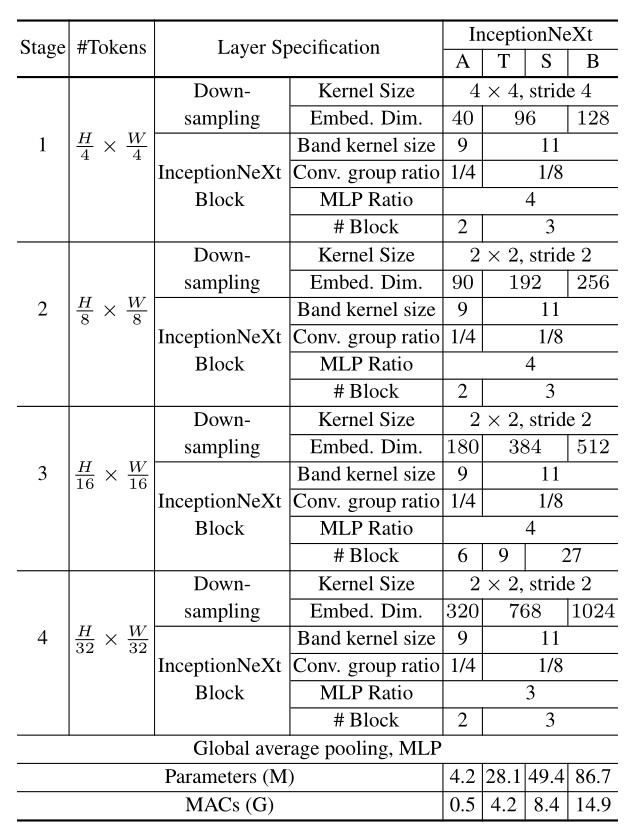

基于 Inception 深度卷积这一核心模块,InceptionNeXT 构建了完整的端到端网络,其整体设计依旧沿用4阶段框架,在最新v3版本的论文中,给出了4个变体A(Atto)、T(Tiny)、S(Small)、B(Base)的具体参数,如下表所示。其中,对于A变体,4个stage repeat数量依次为[2, 2, 6, 2],T变体为[3, 3, 9, 3], S和B变体依次为[3, 3, 27,3]。由于强调速度,采用批量归一化,与ConvNeXT的区别是,InceptionNeXT在stage 4中,使用3的MLP比率。另外,采用 GELU 激活函数替代传统 ReLU,其平滑的梯度特性能够增强模型的非线性表达能力,避免 ReLU 在负区间梯度为零的问题;每个卷积层后搭配 BatchNorm 归一化层,加速模型收敛,降低过拟合风险,提升训练稳定性。