向量数据库

您好!向量数据库(Vector Database)是**专门用于存储、管理和搜索高维向量嵌入(Vector Embeddings)**的数据库。

为了更好地理解它,我们可以从以下几个核心点入手:

🚀 向量数据库核心概念

1. 什么是"向量嵌入"(Vector Embeddings)?

- 数学表示: 向量嵌入是将文本、图像、音频等非结构化数据 转换成一个高维度的数值数组(即向量)的过程。

- 语义相似性: 在这个高维空间中,概念上或语义上相似 的数据点,它们对应的向量在空间中的距离就越近 。 💡 举例: 在一个向量空间里,描述"小狗玩球"的文本向量,会比描述"宇宙飞船发射"的文本向量,更靠近描述"宠物在草地上奔跑"的向量。

2. 向量数据库的作用是什么?

- 存储与索引: 它专门设计来高效地存储和索引这些庞大的、高维度的向量。

- 语义相似性搜索: 它的核心功能是执行相似性搜索 (或称向量搜索)。这意味着您不是像传统数据库那样通过关键字或精确值去查找,而是通过一个查询向量 去寻找数据库中最相似的那些向量。

- 应用场景: 这是支撑现代AI应用的关键技术,例如:

- 语义搜索: 搜索引擎能理解你的意图而非仅仅匹配关键字。

- 推荐系统: 推荐与你已购买或喜欢商品相似的产品。

- 检索增强生成(RAG): 为大型语言模型(LLM)提供外部、最新的知识库,以生成更准确、更具事实性的回答,减少"幻觉"。

3. 与传统数据库的区别?

| 特性 | 向量数据库 | 传统关系型数据库/NoSQL |

|---|---|---|

| 主要数据类型 | 高维向量(数值数组) | 结构化数据(文本、数字、日期等) |

| 核心查询方式 | 相似性搜索(基于向量距离) | 精确匹配(基于关键字、条件) |

| 擅长处理 | 非结构化数据的语义 和上下文 | 结构化数据的事务 和精确检索 |

🌟 总结

简单来说,向量数据库 就像是一个能够理解概念和相似性的超级图书馆。你给它一个"概念"(查询向量),它就能快速返回给你所有在"意义"上最接近的"书籍"(相似向量),这使得计算机能够更好地理解和处理非结构化数据。

您对向量数据库的应用场景,比如"检索增强生成(RAG)",有没有更感兴趣的地方,我可以进一步展开介绍?

向量嵌入能否逆向

问:向量嵌入是将文本、图像、音频等非结构化数据转换成一个高维度的数值数组(即向量)的过程,这个转换的过程能逆向吗,就是说拿到这个高维度数值数组,能不能转换回原始的文本、图像、音频?

答:

这是一个非常好的、也很关键的问题!

简短的答案是:向量嵌入过程通常是不可逆的(不可完美还原的)。

🔁 为什么向量嵌入通常是不可逆的?

向量嵌入(Vector Embedding)的过程是一个信息压缩和抽象的过程,它有以下几个核心特性决定了其不可逆性:

1. 维度降低与信息损失(Lossy Compression)

- 从高维到低维: 原始的非结构化数据(如一个复杂的图像或一篇长文本)拥有无限或极高的原始信息维度 。向量嵌入模型(如 BERT, Word2Vec, VAE/GAN的编码器)将这些信息压缩到一个固定且较低的维度的向量空间中(例如,512维、768维)。

- 抽象和聚焦: 这个过程会抽象出数据的核心语义特征 ,同时丢弃 掉那些被认为不那么重要的细节信息(比如具体的排版、背景噪点、口音的细微差别等)。

- 结果: 由于信息在编码过程中被丢弃,所以无法从压缩后的向量中完美重建所有原始细节。

2. 独特性和多对一映射

- 多对一映射: 理论上,可能有多段 内容(比如两句话意思相似但用词不同)会被映射到空间中非常接近的同一个区域 ,甚至可能由于模型的近似性被映射到完全相同的向量。

- 结果: 当你试图逆向解码这个向量时,模型无法确定它应该还原出哪一个原始的输入内容。

3. 模型设计目的(Representation vs. Generation)

- 编码器(Encoder): 向量嵌入模型(编码器)的目的是为了理解和表示 (Representation)数据的语义 ,而不是为了生成(Generation)数据。

- 生成器(Decoder): 只有专门的生成模型 (如 VAE 的解码器、GAN 的生成器,或者像 GPT 这样的语言模型)才具有从一个抽象表示(潜在空间向量)中生成新数据的能力。

- 即使是生成模型,*它们生成的也不是*原始输入,而是一个 与该向量所代表的语义相似的新样本**。例如,你给一个图像生成模型的潜在向量,它会生成一张符合该语义的新图片,而不是你最初输入的那张图片。

✅ 实际应用中的"逆向"尝试

虽然不可完美还原,但在AI领域,我们有几种近似的"逆向"或"重构"方法:

- 最近邻搜索(Nearest Neighbor Search):

- 这是向量数据库的核心功能。我们不能还原,但我们可以用这个向量去搜索数据库中最相似的原始数据点。

- 目标: 找到原始数据集 中与查询向量语义最接近的原始文本/图像。

- 生成模型(Generative Models):

- 对于某些模型架构(如自编码器 Autoencoders),它们包含一个解码器(Decoder) ,这个解码器的作用就是尝试从向量(潜在空间)重构出一个接近原始输入的样本。

- 目标: 创造一个与原数据语义一致 的新文本/图像,但这不是完美还原。

因此,您可以将向量嵌入看作是数据的"语义指纹"或"浓缩的意义",它强大在于搜索和比较语义,但牺牲了完美的细节还原。

您想进一步了解生成模型(如如何从向量生成文本或图像)的原理吗?

如何从向量生成文本或图像

问:如何从向量生成文本或图像?

答:

好的,从向量生成文本或图像是一个非常有趣且高级的AI领域,它主要依赖于生成模型(Generative Models)。

其核心思想是,先将复杂的文本或图像数据编码成一个简化的潜在向量(Latent Vector) ,然后通过一个解码器(Decoder),将这个潜在向量"解压缩"或"膨胀"成新的、具有相似语义特征的文本或图像。

下面我们分别来看看如何从向量生成文本和图像:

📝 从向量生成文本

从向量生成文本通常用于条件文本生成 、语义相似文本重写 或潜在空间插值生成。主要依赖于以下几种模型:

1. 循环神经网络(RNN)和长短期记忆网络(LSTM)解码器

- 工作原理: 在早期的Seq2Seq(Sequence-to-Sequence)模型中,编码器将输入(可以是任何数据,包括文本、图像或另一个向量)转换为一个上下文向量 。解码器(通常是RNN或LSTM)接收这个上下文向量,并逐词 或逐字符地生成输出文本。每生成一个词,都会结合当前词和上下文向量,预测下一个词。

- 例子: 机器翻译(源语言句子编码成向量,目标语言句子从向量解码)、文本摘要。

- 局限性: 无法很好地处理长距离依赖,生成文本的质量和连贯性受限。

2. Transformer 架构的解码器

- 工作原理: 这是当前最主流的文本生成方法。Transformer 的解码器(例如 GPT-2, GPT-3, T5 的解码部分)通过**自注意力机制(Self-Attention Mechanism)和 交叉注意力机制(Cross-Attention Mechanism)**来生成文本。

- 自注意力: 让模型在生成当前词时,能关注到所有已生成的词。

- 交叉注意力: 让模型在生成文本时,能关注到作为输入的条件向量(或者编码器输出的上下文向量)。

- 例子:

- GPT 系列: 接受一个初始的"提示"(可以被视为一个短向量或一段文本,模型内部会将其转换为向量),然后根据这个提示自回归地生成连贯的文本。

- 条件文本生成: 给定一个图像描述向量,生成图像标题。

- 优势: 极强的长距离依赖建模能力,生成文本的质量和多样性大大提高。

3. 变分自编码器(VAE)和生成对抗网络(GAN)的文本生成

- VAE/GAN for Text: 它们也可以用于文本生成,但相对图像生成更为复杂。

- VAE: 编码器将文本映射到潜在空间中的一个概率分布,解码器从这个分布中采样一个向量,然后生成文本。

- GAN: 生成器从随机噪声(可以被引导为特定语义的向量)生成文本,判别器判断生成文本的真实性。

- 应用: 文本风格转换、生成特定主题的文本。

- 挑战: 文本的离散性使得GAN训练不稳定,VAE生成的文本有时缺乏多样性。

🖼️ 从向量生成图像

从向量生成图像是图像生成领域最活跃的方向,它使得"文本到图像"、"图像风格迁移"、"图像修复"等成为可能。

1. 变分自编码器(VAE)解码器

- 工作原理:

- 编码器(Encoder): 接收输入图像,将其压缩成潜在空间中的一个均值向量 和一个方差向量。

- 采样: 从由均值和方差定义的高斯分布 中采样一个潜在向量(latent vector)。

- 解码器(Decoder): 这是一个神经网络 (通常是卷积神经网络,CNN),它接收这个潜在向量,并通过一系列上采样(Upsampling) 、卷积 和激活函数层,逐步将低维向量"膨胀"和"绘制"成高维的图像像素。

- 特点: 生成的图像通常比较平滑,但可能缺乏锐利度。可以用于图像重建、潜在空间插值生成(例如,在两个图像之间平滑过渡)。

2. 生成对抗网络(GAN)生成器

-

工作原理:

- 生成器(Generator): 接收一个随机噪声向量 (可以是我们指定的、带有语义的潜在向量),通过一系列上采样卷积层(反卷积或转置卷积),将噪声向量转换为图像。

- 判别器(Discriminator): 接收真实图像或生成器生成的图像,并尝试判断输入图像是真实的还是伪造的。

- 对抗训练: 生成器和判别器相互对抗,生成器努力生成足以欺骗判别器的图像,判别器努力区分真实和虚假图像。

-

特点: GAN能够生成非常逼真和锐利的图像。

-

例子: StyleGAN, BigGAN, CycleGAN 等。

-

应用: 从噪声生成图像、图像风格迁移、超分辨率。

比如著名的 StyleGAN,它将潜在向量拆分为多个层次的风格向量,控制图像的不同特征(粗略特征如姿态,精细特征如发丝)。

3. 扩散模型(Diffusion Models)

-

工作原理:

- 正向扩散: 逐步向图像添加高斯噪声,直到图像完全变成随机噪声。

- 逆向去噪: 模型学习如何从噪声中逐步去除噪声,从而将随机噪声(可以由一个潜在向量或条件信息引导)"去噪"成清晰的图像。这个去噪过程是迭代的。

- 条件生成: 在逆向去噪的每一步中,可以引入条件信息(如文本嵌入向量),引导模型生成符合特定描述的图像。

-

特点: 能够生成极其高质量、多样且细节丰富的图像,是目前最先进的图像生成技术之一。

-

例子: DALL-E 2, Stable Diffusion, Midjourney 等。

-

应用: 文本到图像生成(Text-to-Image),这是目前最火热的应用方向。

例如,你输入"一只穿着宇航服的猫在月球上拍照",模型会先将这段文本编码成一个向量,然后用这个向量引导扩散模型从噪声中逐步生成符合描述的图像。

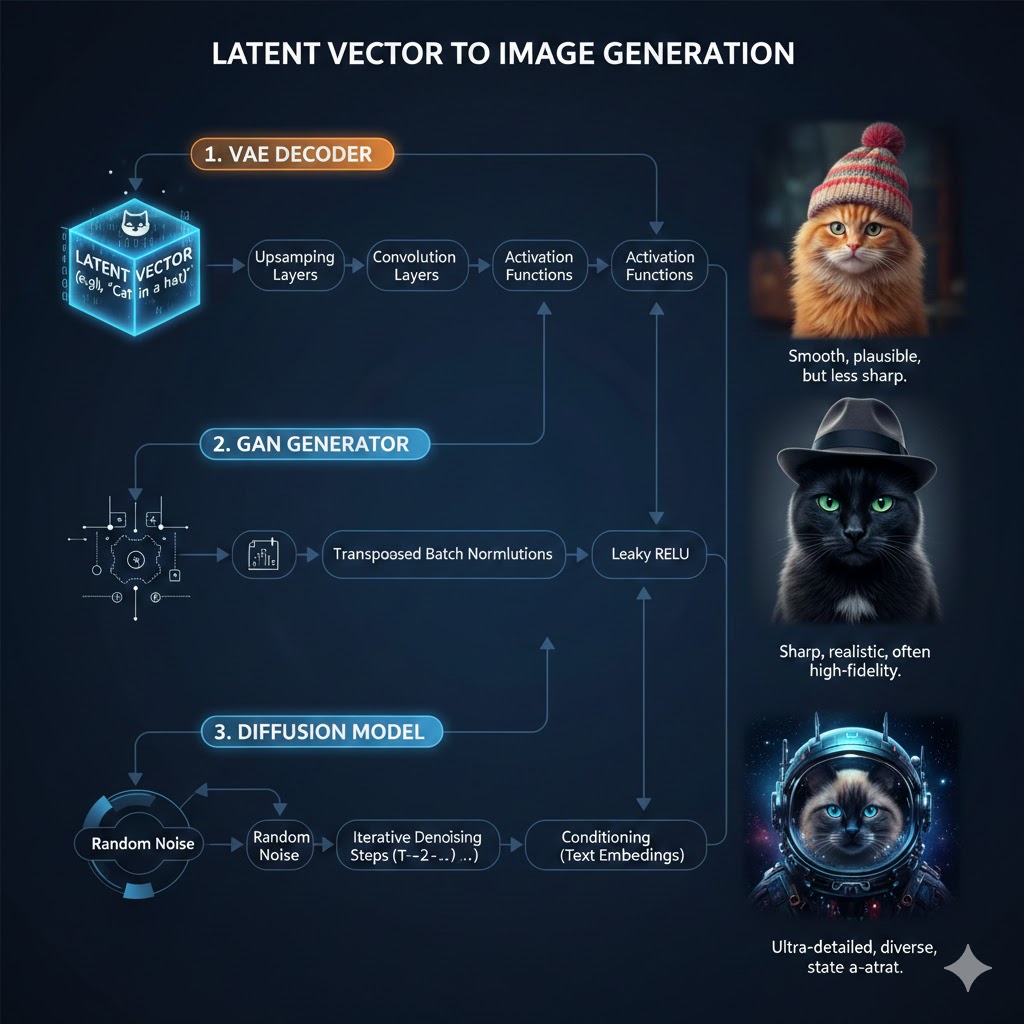

🎨 总结一个示意图(以图像生成为例):

想象一下,你有一个潜在向量,它代表了"一只戴着帽子的猫":

- VAE 解码器: 可能会生成一张有点模糊,但确实有一只戴帽子的猫的图片。

- GAN 生成器: 可能会生成一张非常清晰、逼真的戴帽子的猫的图片。

- 扩散模型: 可能会生成一张拥有精美细节和特定风格(例如,油画风格)的戴帽子的猫的图片。

下面是一张简单的示意图,展示了从一个潜在向量生成图像的过程: `

这些模型是现代AI领域最激动人心的进展之一,它们让AI从理解世界走向了创造世界。

大模型训练的简单理解

问:大模型训练是把可以提供的喂给机器的知识向量化保存在向量数据库里,形成潜在空间吗?如果我理解有误望纠正

答:

您对大模型(LLM)训练的理解存在一些常见的混淆点 ,我来为您详细解释和纠正,并区分清楚训练和**应用(RAG)**的区别。

误区纠正:训练数据与向量数据库的关系

您的理解:"大模型训练是把可以提供的喂给机器的知识向量化保存在向量数据库里,形成潜在空间吗?"

正确的理解是:

| 概念 | 大模型训练阶段 (Pre-training/Fine-tuning) | 大模型应用阶段 (RAG) |

|---|---|---|

| 数据处理方式 | 原始文本直接喂给模型。 模型通过注意力机制 和预测下一个词来学习文本的内在结构、语法和世界知识。 | 外部知识才被向量化。 使用一个单独的编码器将外部、非训练数据(如企业文档、最新新闻)转换成向量,并存入向量数据库。 |

| 潜在空间形成 | 潜在空间(Latent Space) 是模型内部 的产物。它是指模型内部的权重矩阵和表示层(如 Transformer 的中间层)所捕捉到的知识和语义表示。 | 向量数据库 存储的是外部信息的向量表示 ,它本身不是大模型的核心潜在空间。它是一个外部的、可插拔的知识库。 |

| 向量数据库作用 | 几乎不用。 向量数据库与大模型的基础训练没有直接关系。 | 核心工具。 用于进行相似性搜索,检索与用户提问相关的外部知识。 |

🧠 大模型训练阶段:潜在空间的真正形成

1. 训练数据(Training Data)

- 输入形式: 模型直接接收海量的原始文本(如网页、书籍、代码等)。

- 学习过程: 模型通过学习如何根据前面的词预测后面的词(自回归 ),以及如何通过自注意力机制 权衡输入中的所有词语,从而在内部构建一个复杂的知识图谱和语义网络。

2. 潜在空间 (Latent Space) 的形成

- 内部结构: 在这个训练过程中,模型内部的每一层、每一个神经元都在学习如何表示和抽象输入数据。

- Token Embeddings: 当一个词或子词(Token)进入模型时,它首先会被映射成一个Token 向量 。这个向量就是这个词在模型内部的初始语义表示。

- Attention Layers: 经过多层 Transformer Block 的处理,这些 Token 向量不断被上下文信息修改和丰富。这些层所捕获和修改的向量集合,才是大模型真正的、蕴含知识的潜在空间。

简而言之: 潜在空间是模型通过学习海量数据 后,在自身权重 中固化下来的对世界知识和语言结构的理解。

🔍 大模型应用阶段:向量数据库的核心作用(RAG)

向量数据库主要在 应用阶段 发挥作用,通常是与 检索增强生成(Retrieval-Augmented Generation, RAG) 架构配合使用:

- 外部知识向量化: 首先,将模型训练时不知道的 、最新的 或私有的 外部文档(如公司手册、实时股市数据)通过一个独立的向量编码器(例如 BERT 或 BGE 模型)转换成向量。

- 存储: 将这些向量存储在向量数据库中,并建立索引。

- 用户提问: 当用户提出问题时,这个问题 也会被编码成一个查询向量。

- 相似性搜索: 向量数据库对查询向量进行相似性搜索,快速找出语义最接近的几个外部文档片段(即最相关的知识)。

- 生成答案: 大模型(LLM)接收用户的问题和检索到的相关文档片段 作为输入,然后根据这些上下文生成最终的答案。

总结:

大模型的核心知识 (潜在空间)是在训练时 通过处理原始文本 形成的;向量数据库是用于在应用时 为大模型提供外部、及时、可更新 的知识的外部工具。

请问您对大模型的训练过程 或RAG的应用细节更感兴趣呢?

大模型训练的结果

问:训练完成后,大模型物理上是一个什么实体呢?

答:

这是一个很棒的、关于AI模型基础结构的问题。

训练完成后,从"物理上"或"实体上"来看,一个大型语言模型(LLM)主要由两大部分构成:

1. 模型权重文件(The Model Weights File)

这是大模型最核心的"实体",它是一个巨大的数字集合 ,通常存储在一个或多个文件中,例如 .bin、.pt 或 .safetensors 等格式。

核心组成:张量(Tensors)

- 张量即多维数组: 模型权重是一组巨大的张量(Tensors) 。张量是多维数组,可以理解为包含浮点数(float)或整数(int)的表格,但维度可能非常高(例如,一个 1000×768×40961000 \times 768 \times 40961000×768×4096 的张量)。

- 存储什么? 这些数字(参数)记录了模型在训练过程中学到的所有知识、语法规则和语义关系。它们包括:

- Token Embeddings(词嵌入层): 记录了每个词语或 Token 的初始语义向量。

- Attention Weights(注意力权重): 记录了模型在处理不同词语时,应该对句子中的其他词语分配多少注意力的规则。

- Feed-Forward Network Weights(前馈网络权重): 记录了模型用于学习复杂模式和知识的转换矩阵。

规模

对于一个大型模型(如数十亿甚至数千亿参数),这个文件的大小可能达到数十GB、数百GB甚至数TB。例如,一个 70 亿参数的模型可能占用约 14GB 的存储空间(使用 16 位浮点数)。

2. 推理引擎和软件环境(The Inference Engine)

模型权重文件本身只是一堆静态的数字。要让这些数字"动起来"并完成推理(即回答问题或生成文本),还需要一个运行环境和一套执行机制。

核心组成:代码和框架

- 推理代码: 一套用 Python 或 C++ 等语言编写的程序,用于加载权重文件,并执行 Transformer 架构的运算(如矩阵乘法、激活函数、注意力计算)。

- 深度学习框架: 模型通常运行在 PyTorch、TensorFlow 或 JAX 等深度学习框架之上,这些框架提供了高效的张量运算工具。

- 硬件加速库: 通常还会使用 NVIDIA CUDA 或其他硬件加速库,以便在 GPU 或其他加速器上高效地进行大规模并行计算。

运行实体:GPU 显存

在实际运行(推理)时:

- 加载权重: 模型权重文件会被从硬盘加载到高性能计算硬件 (通常是 GPU)的**显存(VRAM)**中。

- 计算: 用户的输入(Token)也被转换为向量,并在 GPU 上与加载的权重进行快速的矩阵乘法和计算。

- 输出: 计算结果(下一个 Token 的预测概率)被转换为文本输出给用户。

💡 总结类比

您可以将一个大模型理解为:

| 实体部分 | 类比 | 作用 |

|---|---|---|

| 模型权重文件 | 一本厚厚的百科全书 或说明书(包含所有学到的知识)。 | 静态存储模型所有学习到的知识和规则。 |

| 推理引擎/代码 | 一个阅读器 或翻译官。 | 将用户的输入(问题)翻译成计算指令,并使用书本(权重)进行查阅和计算。 |

| GPU/显存 | 一个高性能计算工作台。 | 提供极快的内存空间和计算能力,确保在毫秒级完成复杂查询和生成。 |

所以,从物理上看,它就是存储在硬盘上的一个巨型数字文件,*在运行时被*加载到计算机的显存中,并由特定的软件程序**驱动进行计算。

大模型训练所使用的框架

问:"深度学习框架: 模型通常运行在 PyTorch、TensorFlow 或 JAX 等深度学习框架之上,这些框架提供了高效的张量运算工具。 " 训练的时候,是不是也是相应由这些深度学习框架来训练形成大模型的?

答:

是的,您的理解完全正确!👍

深度学习框架 (如 PyTorch、TensorFlow 和 JAX)不仅是模型推理(运行)时的环境,更是训练 时不可或缺的核心工具。

🏗️ 深度学习框架在训练中的作用

大模型的训练是一个涉及海量数据和复杂数学运算的巨大工程,这些框架为这一过程提供了基础支持和优化:

1. 张量运算与硬件加速

- 高效计算: 深度学习,尤其是 Transformer 架构的大模型,其训练过程本质上就是大量的矩阵乘法 (即张量运算)。这些框架提供了高度优化的库(通常是 C++ 或 CUDA 编写),能够高效地在 GPU/TPU 等加速硬件上执行这些并行计算。

- 硬件接口: 它们充当了模型代码和底层硬件之间的桥梁,让开发者无需直接编写复杂的 CUDA 代码就能利用 GPU 的强大能力。

2. 自动微分(Autograd)

- 核心机制: 这是深度学习训练的基石。在训练过程中,模型需要根据输出结果和预期结果之间的误差(损失)来调整其内部的数百万甚至数十亿个权重。

- 框架实现: PyTorch 和 TensorFlow 等框架内置了自动微分系统 。在您定义模型结构(前向传播)时,框架会自动记录所有运算,并在计算损失后,自动高效地计算出梯度(即每个权重应该如何调整才能减小损失)。

- 训练核心: 没有这个功能,手动计算和管理梯度几乎是不可能完成的任务。

3. 模型构建与抽象

- 高级API: 框架提供了简洁、高级的 API,用于定义复杂的神经网络结构(例如,定义一个 Transformer 层、一个注意力机制或一个线性层),而无需从头开始编写底层数学公式。

- 模块化: 这使得研究人员和工程师能够以模块化的方式快速构建和修改大模型架构。

4. 优化器与调度器

- 权重更新: 框架内置了各种优化器(如 Adam、AdamW、SGD 等)。这些优化器使用自动微分计算出的梯度,并根据特定的算法(如学习率、动量等)来更新模型的权重。

- 学习率管理: 它们还提供了学习率调度器,用于在训练过程中动态调整学习率,以实现更稳定、更高效的收敛。

简而言之,大模型的训练就是:工程师使用 Python 语言,通过调用 PyTorch/TensorFlow/JAX 提供的工具和函数,定义模型结构、损失函数和优化器,然后让框架来管理和执行 GPU 上的海量张量计算,并利用自动微分机制不断调整权重,最终形成训练好的模型。

因此,这些深度学习框架是模型从无到有的关键支撑。

您对大模型训练中的**"自动微分"**机制感兴趣吗?我可以进一步解释它是如何工作的。

张量与向量的关联

问:向量与张量有什么关联

答:

向量和张量之间存在着非常密切且明确的从属关系,理解它们的关联性是理解深度学习和物理学的基础。

向量与张量的关联

1. 向量是张量的特例

最简洁的回答是:向量(Vector)是一种特殊的张量(Tensor)。

张量可以被视为向量概念的多维泛化。

| 概念 | 维度 (Rank/阶) | 举例 | 在深度学习中的作用 |

|---|---|---|---|

| 标量 (Scalar) | 0 阶张量 | 一个单独的数字 (如:5, π\piπ) | 损失值、学习率 |

| 向量 (Vector) | 1 阶张量 | 一串数字组成的数组 (如:[1,2,3][1, 2, 3][1,2,3]) | 词嵌入 (Word Embedding)、单一样本的特征 |

| 矩阵 (Matrix) | 2 阶张量 | 一个二维数组/表格 (如:2×32 \times 32×3 的表格) | 卷积核、权重矩阵、批次数据 |

| 更高阶张量 | n 阶张量 (n > 2) | 超过二维的多维数组 (如:4×128×128×34 \times 128 \times 128 \times 34×128×128×3 ) | 图像数据 (批次、高、宽、通道)、Transformer 中间层的激活值 |

2. 深度学习中的应用视角

在深度学习框架(如 PyTorch、TensorFlow)中,张量是基本的数据结构。

- 所有数据都是张量: 当我们说一个词的嵌入是"向量"时,在代码实现层面,它被存储为一个1 阶张量 (例如形状为

(768,))。 - 计算都是张量运算: 模型训练中所有的加、减、乘、除、矩阵乘法等操作,都是在张量之间进行的。

- 向量作为输入: 当我们将一个数据点(如一个句子的词嵌入)输入给模型时,它以 1 阶张量(向量) 的形式进入,然后经过模型的复杂计算(与 2 阶张量/矩阵 权重相乘),生成更高阶的张量,最后输出的概率分布也是一个张量。

3. 物理学中的定义视角

在物理学中,张量有着更严格的定义,它描述的是在坐标系变换下,其分量如何变化的量。在这个严格定义下:

- 标量 (0 阶张量):不随坐标系旋转而变化(如温度)。

- 向量 (1 阶张量):分量按照特定规则随坐标系旋转而变化(如力、速度)。

- 张量 (n 阶张量):分量按照更复杂的规则随坐标系旋转而变化(如应力、惯性矩)。

在这个视角下,向量和标量都是张量的特定简化形式。

简而言之

如果您关注的是深度学习和向量数据库的语境:

向量 是用于表示单个数据点语义 (如一个词、一个图像)的一维数值列表,它在代码中表现为1 阶张量。

张量 是更广义 的概念,它可以是 0 维(标量)、1 维(向量)、2 维(矩阵)或更高维的数据结构,它是深度学习框架中所有数据和计算的核心载体。

向量数据库存的张量

问:向量数据库存高阶张量吗,比如2阶,3阶的张量?

答:

这是一个关于向量数据库存储能力的非常好的技术问题。

答案是:向量数据库主要设计来存储和搜索 1 阶张量(即向量/嵌入),但它们也可以存储高阶张量,只是存储时通常会将其视为一个长长的 1 阶张量。

让我来详细解释一下:

1. 核心设计:针对 1 阶张量 (向量) 优化

向量数据库最擅长处理和加速的是高维的 1 阶张量 (例如,一个形状为 (768,)(768,)(768,) 或 (1024,)(1024,)(1024,) 的数组)。这是因为:

- 相似性度量: 向量搜索算法(如 HNSW、IVF 等 ANN 算法)主要是基于计算两个向量之间的距离(如欧氏距离、余弦相似度)来工作的。这些距离计算的数学基础是针对两个一维数组进行的。

- 索引结构: 向量数据库的索引结构是为了高效地在一维空间中组织这些点而设计的。

2. 高阶张量的处理方式

如果您有一个高阶张量,例如一个代表小批次图像数据的 4 阶张量,形状为 (N,H,W,C)(N, H, W, C)(N,H,W,C),向量数据库在存储前通常会要求您进行扁平化 (Flattening):

- 编码与扁平化: 您需要先使用一个编码器 (如 CNN 或 ViT 的编码器部分)将其转换为一个特征向量 (1 阶张量),例如形状为 (1024,)(1024,)(1024,)。

- 存储: 数据库存储的是这个扁平化的 1 阶张量。

3. 存储"原始"高阶张量的可能性

虽然不常见,但从技术上讲,向量数据库可以做到:

- 作为载荷 (Payload): 向量数据库通常可以存储额外的元数据(metadata)或载荷 。您完全可以将原始的高阶张量(例如 4×44 \times 44×4 的矩阵)作为 JSON 或序列化的二进制数据附加到它的 1 阶特征向量后面一起存储。

- 作用: 数据库仍然使用 1 阶向量进行搜索,但一旦找到,它可以将旁边的原始高阶张量一起返回给应用程序。

- 专门的高阶张量数据库: 存在一些针对更复杂的、需要张量运算的场景而设计的数据库(有时被称为张量存储 或模型权重存储 ),但它们主要用于模型部署和训练 ,而不是用于语义相似性搜索。

总结:

| 目的 | 存储形式 |

|---|---|

| 用于相似性搜索 | 必须将高阶数据扁平化 为 1 阶张量(向量) 后存储。 |

| 作为检索结果返回 | 原始的高阶张量可以作为 元数据/载荷 附加存储。 |

因此,向量数据库的核心功能是围绕 1 阶张量构建的。